Semua kejayaan boleh dikesan, dan ChatGPT tidak terkecuali.

Tidak lama dahulu, pemenang Anugerah Turing Yann LeCun telah diletakkan dalam senarai carian hangat kerana penilaiannya yang keras terhadap ChatGPT.

Pada pandangan beliau, "Mengenai teknologi asas, ChatGPT tidak mempunyai inovasi khas," dan bukan juga "apa-apa revolusioner." Banyak makmal penyelidikan menggunakan teknologi yang sama dan melakukan kerja yang sama. Lebih-lebih lagi, ChatGPT dan GPT-3 di belakangnya dalam banyak cara terdiri daripada pelbagai teknologi yang dibangunkan selama bertahun-tahun oleh pelbagai pihak dan merupakan hasil sumbangan berdekad-dekad oleh orang yang berbeza. Oleh itu, LeCun percaya bahawa ChatGPT bukanlah satu kejayaan saintifik kerana ia adalah contoh kejuruteraan yang baik.

"Sama ada ChatGPT adalah revolusioner" ialah topik kontroversi. Tetapi tidak ada keraguan bahawa ia dibina berdasarkan banyak teknologi yang terkumpul sebelum ini. Contohnya, Transformer teras telah dicadangkan oleh Google beberapa tahun lalu, dan Transformer telah diilhamkan oleh kerja Bengio mengenai konsep perhatian. Jika kita kembali lebih jauh, kita juga boleh memautkan kepada penyelidikan dari dekad yang lebih awal.

Sudah tentu orang ramai mungkin tidak menghargai perasaan langkah demi langkah ini Lagipun, tidak semua orang akan membaca kertas satu persatu. Tetapi bagi juruteknik, masih sangat membantu untuk memahami evolusi teknologi ini.

Dalam artikel ulasan baru-baru ini, penyelidik dari Michigan State University, Beijing Universiti Aeronautik, Universiti Lehigh dan institusi lain menyisir bidang ini dengan teliti Terdapat ratusan kertas kerja, terutamanya memberi tumpuan kepada model asas pra-latihan dalam bidang teks, imej dan pembelajaran graf, yang sangat berbaloi untuk dibaca. Profesor di Universiti Duke, Ahli Akademik Akademi Kejuruteraan KanadaPei Jian, Profesor Terhormat Jabatan Sains Komputer, Universiti Illinois di ChicagoYu Shilun(Philip S. Yu ), Naib Presiden Salesforce AI ResearchXiong Caiming semuanya salah seorang pengarang kertas itu.

Pautan kertas: https://arxiv.org/pdf/2302.09419.pdf

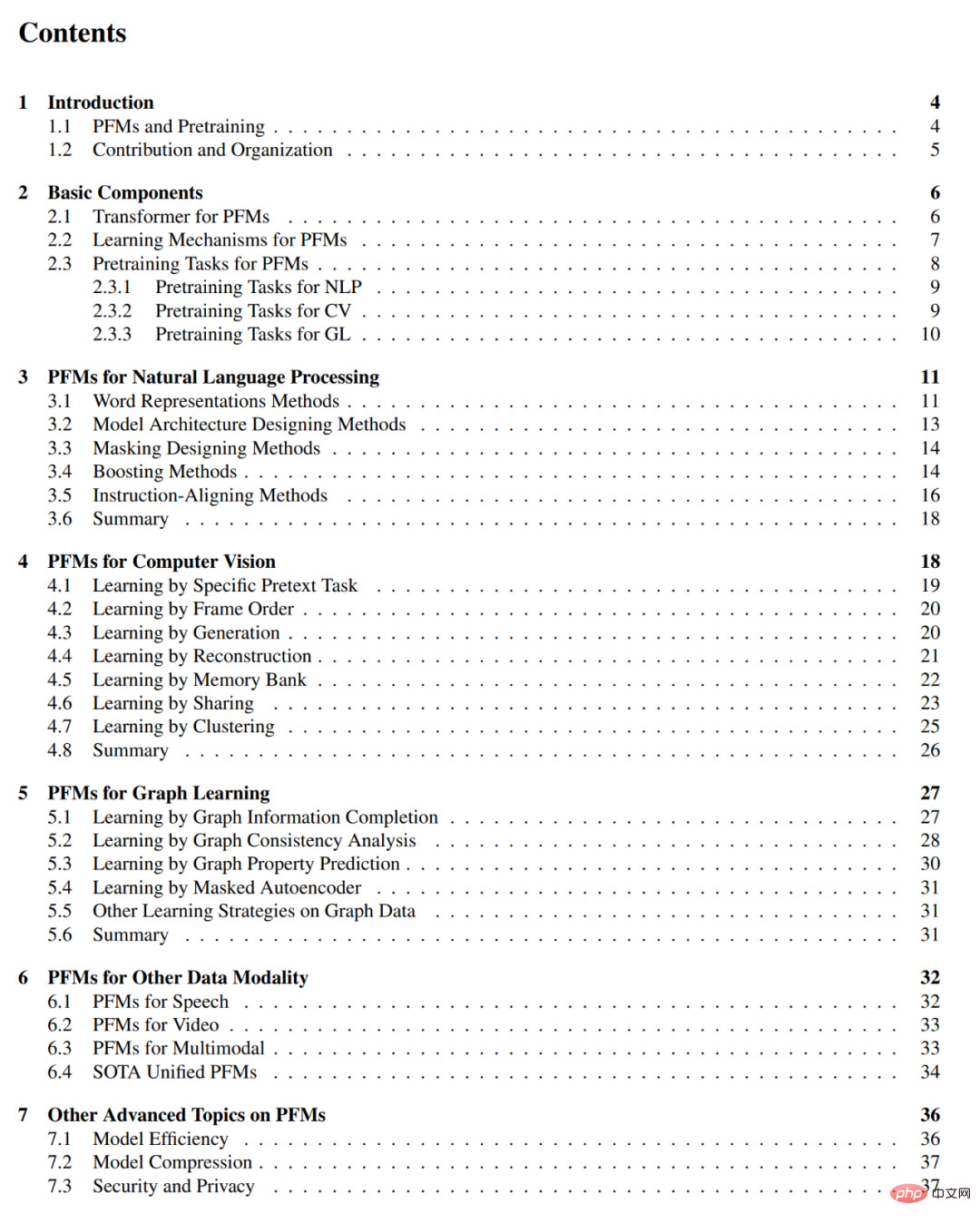

Jadual kandungan kertas adalah seperti berikut:

Di platform sosial luar negara, pengasas bersama DAIR.AI Elvis S. mengesyorkan ulasan ini dan menerima Lebih daripada seribu suka.

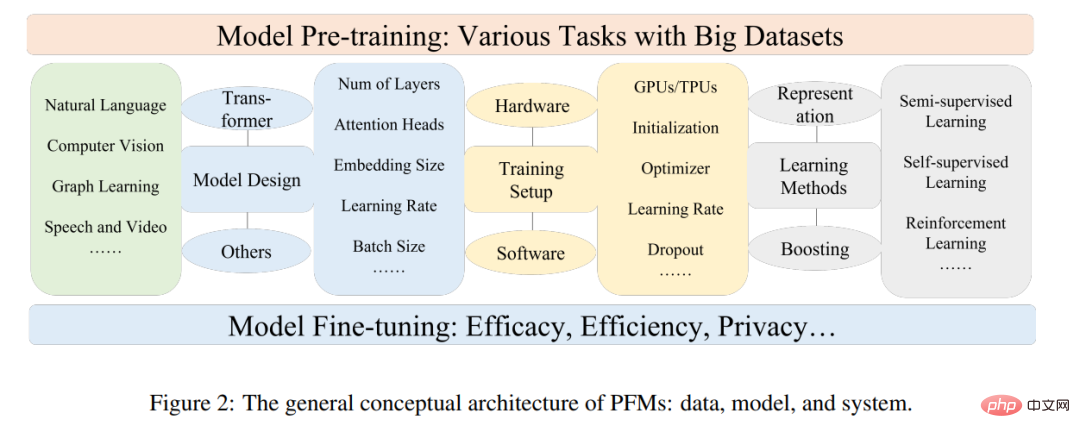

Model asas pra-latihan (PFM) ialah bahagian penting kecerdasan buatan dalam era data besar. Nama "Model Asas" berasal daripada ulasan yang diterbitkan oleh Percy Liang, Li Feifei dan lain-lain - "Mengenai Peluang dan Risiko Model Asas", yang merupakan istilah umum untuk jenis model dan fungsinya. PFM telah dikaji secara meluas dalam bidang NLP, CV, dan pembelajaran graf. Mereka menunjukkan potensi yang kuat untuk pembelajaran perwakilan ciri dalam pelbagai tugas pembelajaran, seperti klasifikasi teks, penjanaan teks, klasifikasi imej, pengesanan objek dan klasifikasi graf. Sama ada latihan untuk berbilang tugas dengan set data yang besar atau penalaan halus pada tugasan berskala kecil, PFM mempamerkan prestasi unggul, yang memungkinkan untuk memulakan pemprosesan data dengan cepat.

PFM dan pra-latihan

PFM adalah berdasarkan teknologi pra-latihan, yang bertujuan untuk menggunakan jumlah data dan tugas untuk Melatih model umum yang boleh diperhalusi dengan mudah dalam aplikasi hiliran yang berbeza.

Idea pra-latihan berasal daripada pembelajaran pemindahan dalam tugas CV. Tetapi setelah melihat keberkesanan teknologi ini dalam bidang CV, orang ramai mula menggunakan teknologi ini untuk meningkatkan prestasi model dalam bidang lain.

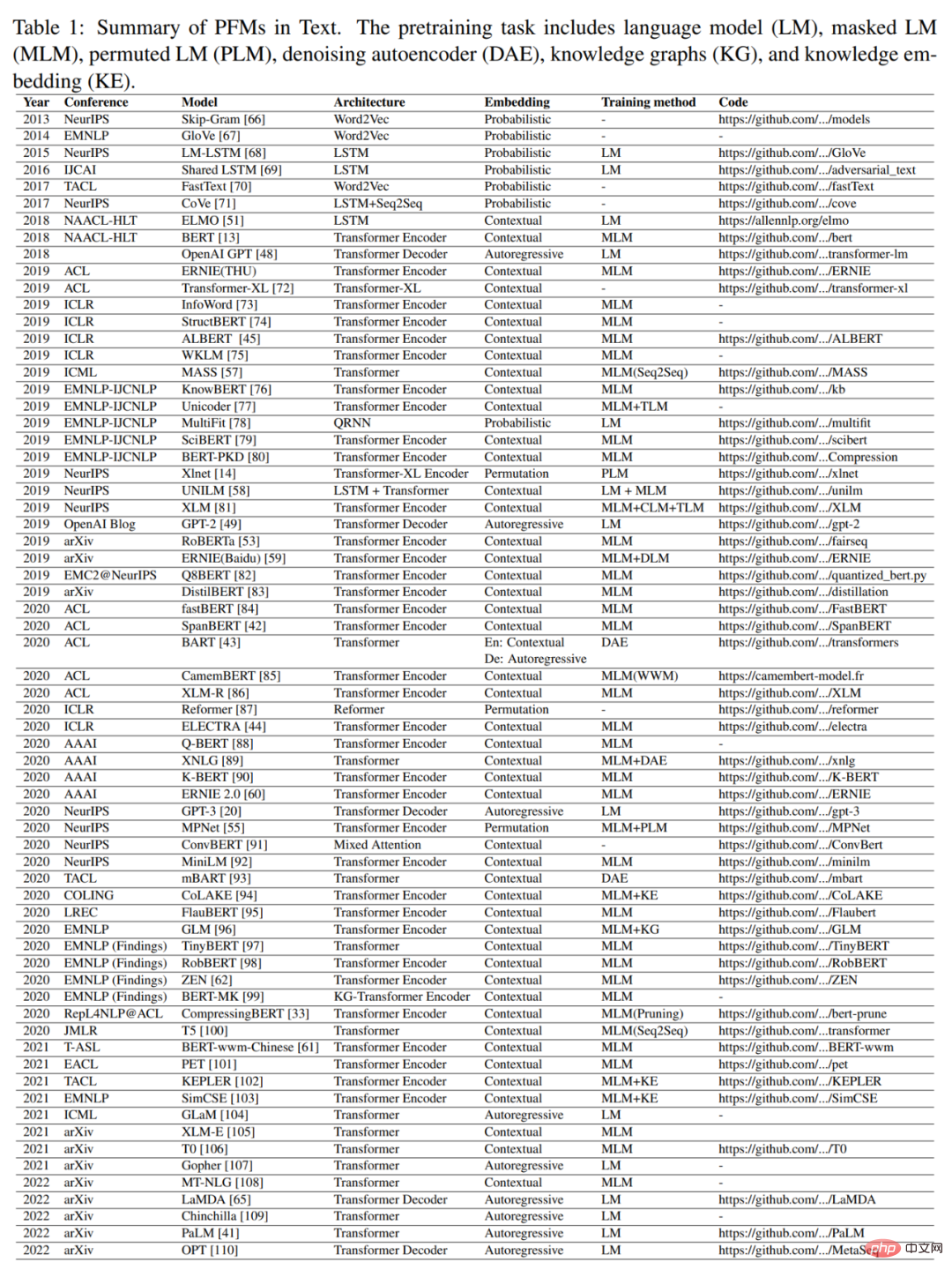

Apabila teknologi pra-latihan digunakan dalam bidang NLP, model bahasa yang terlatih boleh menangkap pengetahuan yang kaya yang bermanfaat untuk tugas hiliran, seperti kebergantungan jangka panjang, hubungan hierarki , dsb. Di samping itu, kelebihan ketara pra-latihan dalam bidang NLP ialah data latihan boleh datang daripada mana-mana korpus teks yang tidak berlabel, iaitu, terdapat jumlah data latihan yang hampir tidak terhad yang boleh digunakan untuk proses pra-latihan. . Pra-latihan awal ialah teknik statik, seperti NNLM dan Word2vec, tetapi kaedah statik sukar untuk disesuaikan dengan persekitaran semantik yang berbeza. Oleh itu, teknik pra-latihan dinamik telah dicadangkan, seperti BERT, XLNet, dll. Rajah 1 menggambarkan sejarah dan evolusi PFM dalam bidang NLP, CV, dan GL. PFM berdasarkan teknik pra-latihan menggunakan korpora besar untuk mempelajari perwakilan semantik biasa. Berikutan pengenalan kerja perintis ini, pelbagai PFM telah muncul dan digunakan untuk tugas dan aplikasi hiliran.

ChatGPT yang popular baru-baru ini ialah kes tipikal aplikasi PFM. Ia diperhalusi daripada model pengubah pra-latihan generatif GPT-3.5, yang dilatih menggunakan sejumlah besar kertas dan kod ini. Selain itu, ChatGPT menggunakan pembelajaran pengukuhan daripada maklum balas manusia (RLHF), yang telah muncul sebagai cara yang menjanjikan untuk menyelaraskan LM berskala besar dengan niat manusia. Prestasi cemerlang ChatGPT mungkin membawa perubahan dalam paradigma latihan setiap jenis PFM, seperti aplikasi teknologi penjajaran arahan, pembelajaran pengukuhan, penalaan segera dan rantaian pemikiran, sekali gus menuju ke arah kecerdasan buatan am.

Artikel ini akan memberi tumpuan kepada PFM dalam bidang teks, imej dan graf, iaitu kaedah klasifikasi penyelidikan yang agak matang. Untuk teks, ia adalah LM tujuan umum yang digunakan untuk meramal perkataan atau aksara seterusnya dalam urutan. Contohnya, PFM boleh digunakan dalam terjemahan mesin, sistem menjawab soalan, pemodelan topik, analisis sentimen, dsb. Untuk imej, ia serupa dengan PFM pada teks, menggunakan set data yang besar untuk melatih model besar yang sesuai untuk banyak tugas CV. Untuk graf, idea pra-latihan yang serupa digunakan untuk mendapatkan PFM yang digunakan dalam banyak tugas hiliran. Selain PFM untuk domain data tertentu, artikel ini juga menyemak dan menghuraikan beberapa PFM lanjutan lain, seperti PFM untuk suara, video dan data merentas domain dan PFM berbilang mod. Di samping itu, satu penumpuan hebat PFM yang mampu mengendalikan tugas berbilang modal sedang muncul, iaitu apa yang dipanggil PFM bersatu. Mula-mula penulis mentakrifkan konsep PFM bersatu dan kemudian menyemak penyelidikan terkini tentang PFM bersatu yang telah mencapai SOTA (seperti OFA, UNIFIED-IO, FLAVA, BEiT-3, dll.).

Berdasarkan ciri-ciri PFM sedia ada dalam tiga bidang di atas, penulis membuat kesimpulan bahawa PFM mempunyai dua kelebihan utama berikut. Pertama, untuk meningkatkan prestasi pada tugas hiliran, model hanya memerlukan penalaan halus kecil. Kedua, PFM telah diteliti dari segi kualiti. Daripada membina model dari awal untuk menyelesaikan masalah yang sama, kami boleh menggunakan PFM pada set data yang berkaitan dengan tugas. Prospek luas PFM telah memberi inspirasi kepada sejumlah besar kerja berkaitan untuk memfokuskan pada isu seperti kecekapan model, keselamatan dan pemampatan.

Sumbangan dan struktur kertas kerja

Sebelum penerbitan artikel ini, terdapat beberapa ulasan yang mengkaji beberapa model pra-latihan khusus dalam bidang seperti penjanaan teks, pengubah visual dan pengesanan sasaran.

"Mengenai Peluang dan Risiko Model Asas" meringkaskan peluang dan risiko model asas. Walau bagaimanapun, kerja sedia ada tidak mencapai semakan menyeluruh terhadap aspek PFM yang berbeza dalam domain yang berbeza (cth., CV, NLP, GL, Ucapan, Video), seperti tugas pra-latihan, kecekapan, keberkesanan dan privasi. Dalam ulasan ini, penulis menghuraikan evolusi PFM dalam bidang NLP dan cara pra-latihan telah dipindahkan dan diterima pakai dalam bidang CV dan GL.

Berbanding dengan ulasan lain, artikel ini tidak memberikan pengenalan dan analisis menyeluruh tentang PFM sedia ada dalam ketiga-tiga bidang. Berbeza daripada semakan model pra-latihan sebelumnya, penulis meringkaskan model sedia ada, daripada model tradisional hingga PFM, serta karya terkini dalam tiga bidang. Model tradisional menekankan pembelajaran ciri statik. PFM Dinamik menyediakan pengenalan kepada struktur, iaitu penyelidikan arus perdana.

Pengarang memperkenalkan beberapa penyelidikan lain tentang PFM, termasuk PFM lanjutan dan bersatu lain, kecekapan dan pemampatan model, keselamatan dan privasi. Akhir sekali, penulis merumuskan cabaran penyelidikan masa depan dan isu terbuka dalam pelbagai bidang. Mereka juga menyediakan pengenalan menyeluruh kepada metrik penilaian dan set data yang berkaitan dalam Lampiran F dan G.

Ringkasnya, sumbangan utama artikel ini adalah seperti berikut:

Kandungan utama setiap bab adalah seperti berikut:

Bab 2 kertas kerja memperkenalkan konsep umum seni bina PFM.

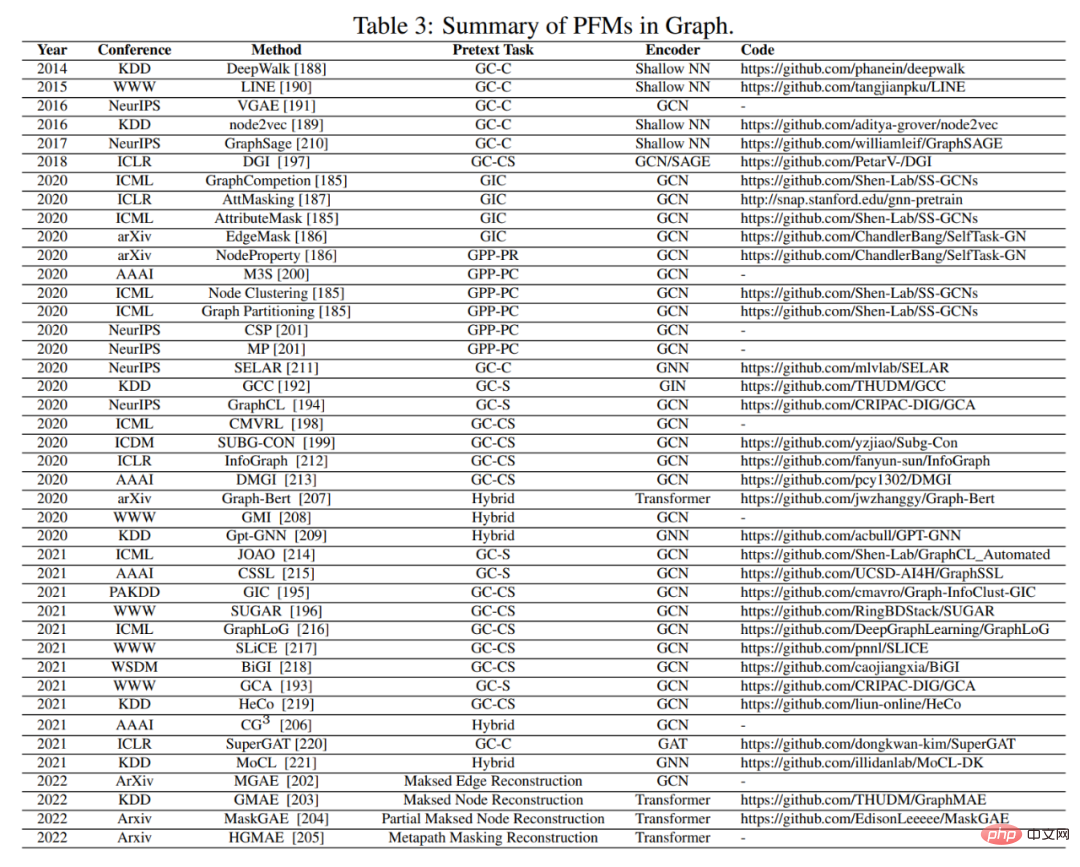

Bab 3, 4 dan 5 masing-masing meringkaskan PFM sedia ada dalam bidang NLP, CV dan GL.

Bab 6 dan 7 memperkenalkan penyelidikan termaju lain dalam PFM, termasuk PFM termaju dan bersatu, kecekapan dan pemampatan model, serta keselamatan dan privasi.

Bab 8 meringkaskan cabaran utama PFM. Bab 9 meringkaskan teks penuh.

Atas ialah kandungan terperinci Daripada BERT ke ChatGPT, semakan seratus halaman meringkaskan sejarah evolusi model besar yang telah dilatih. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Apakah yang perlu saya lakukan jika lesen windows saya hampir tamat tempoh?

Apakah yang perlu saya lakukan jika lesen windows saya hampir tamat tempoh?

Apakah definisi tatasusunan?

Apakah definisi tatasusunan?

Apakah kaedah pemindahan fail java?

Apakah kaedah pemindahan fail java?

Pengenalan kepada pemalam yang diperlukan untuk vscode menjalankan java

Pengenalan kepada pemalam yang diperlukan untuk vscode menjalankan java

Penyelesaian kod kacau Cina Ajax

Penyelesaian kod kacau Cina Ajax

Bagaimana untuk menghantar nilai kepada komponen vue

Bagaimana untuk menghantar nilai kepada komponen vue

xrp Ripple Berita Terkini

xrp Ripple Berita Terkini

Proses pembelian riak

Proses pembelian riak