Peranti teknologi

Peranti teknologi

AI

AI

Panduan Membeli GPU Pembelajaran Dalam: Kad grafik manakah yang layak untuk relau alkimia saya?

Panduan Membeli GPU Pembelajaran Dalam: Kad grafik manakah yang layak untuk relau alkimia saya?

Panduan Membeli GPU Pembelajaran Dalam: Kad grafik manakah yang layak untuk relau alkimia saya?

Seperti yang kita sedia maklum, apabila menangani pembelajaran mendalam dan tugasan rangkaian saraf, adalah lebih baik untuk menggunakan GPU berbanding CPU, kerana apabila ia berkaitan dengan rangkaian saraf, GPU yang agak rendah sekalipun akan mengatasi prestasi CPU.

Pembelajaran mendalam ialah bidang yang memerlukan banyak pengkomputeran Pada tahap tertentu, pilihan GPU pada asasnya akan menentukan pengalaman pembelajaran yang mendalam.

Tetapi inilah masalahnya, cara memilih GPU yang betul juga adalah perkara yang memeningkan kepala dan memeningkan otak.

Bagaimana untuk mengelak daripada ditipu dan bagaimana untuk membuat pilihan yang menjimatkan kos?

Tim Dettmers, penulis blog ulasan terkenal yang telah menerima tawaran PhD daripada Stanford, UCL, CMU, NYU dan UW dan sedang belajar untuk PhD di University of Washington, membincangkan jenis GPU yang diperlukan dalam bidang pembelajaran mendalam , digabungkan dengan pengalamannya sendiri, menulis artikel panjang 10,000 perkataan, dan akhirnya memberikan GPU yang disyorkan dalam bidang DL.

Arah penyelidikan Tim Dettmers ialah pembelajaran mendalam tentang pembelajaran perwakilan dan pengoptimuman perkakasan laman web juga terkenal dalam bidang pembelajaran mendalam dan perkakasan komputer.

GPU yang disyorkan oleh Tim Dettmers dalam artikel ini semuanya daripada N Factory ia datang kepada pembelajaran mesin.

Editor juga telah menyiarkan pautan asal di bawah.

Pautan asal: https://timdettmers.com/2023/01/16/which-gpu-for-deep-learning /#GPU_Deep_Learning_Prestasi_per_Dollar

Kebaikan dan Kelemahan Siri RTX 40 dan 30

Berbanding dengan NVIDIA Turing Architecture RTX 20 Series Architecture Siri RTX 20, NVIDIA yang baharu Mempunyai lebih banyak kelebihan seperti latihan rangkaian jarang dan inferens. Ciri lain, seperti jenis data baharu, harus dilihat lebih sebagai ciri yang mudah digunakan, kerana ia memberikan peningkatan prestasi yang sama seperti seni bina Turing tetapi tidak memerlukan sebarang keperluan pengaturcaraan tambahan.

Siri Ada RTX 40 mempunyai lebih banyak kemajuan, seperti Tensor Memory Accelerator (TMA) dan operasi titik terapung 8-bit (FP8) yang diperkenalkan di atas. Siri RTX 40 mempunyai isu kuasa dan suhu yang serupa berbanding dengan RTX 30. Isu dengan kabel penyambung kuasa cair RTX 40 boleh dielakkan dengan mudah dengan menyambungkan kabel kuasa dengan betul.

Latihan rangkaian jarang

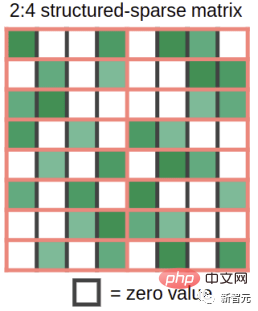

Ampere membolehkan pendaraban matriks jarang automatik bagi struktur berbutir halus pada kelajuan padat. Bagaimana ini dilakukan? Ambil matriks berat sebagai contoh dan potong kepada kepingan 4 elemen. Sekarang bayangkan bahawa 2 daripada 4 elemen ini adalah sifar. Rajah 1 menunjukkan keadaan ini.

Rajah 1: Struktur yang disokong oleh fungsi pendaraban matriks jarang dalam GPU seni bina Ampere

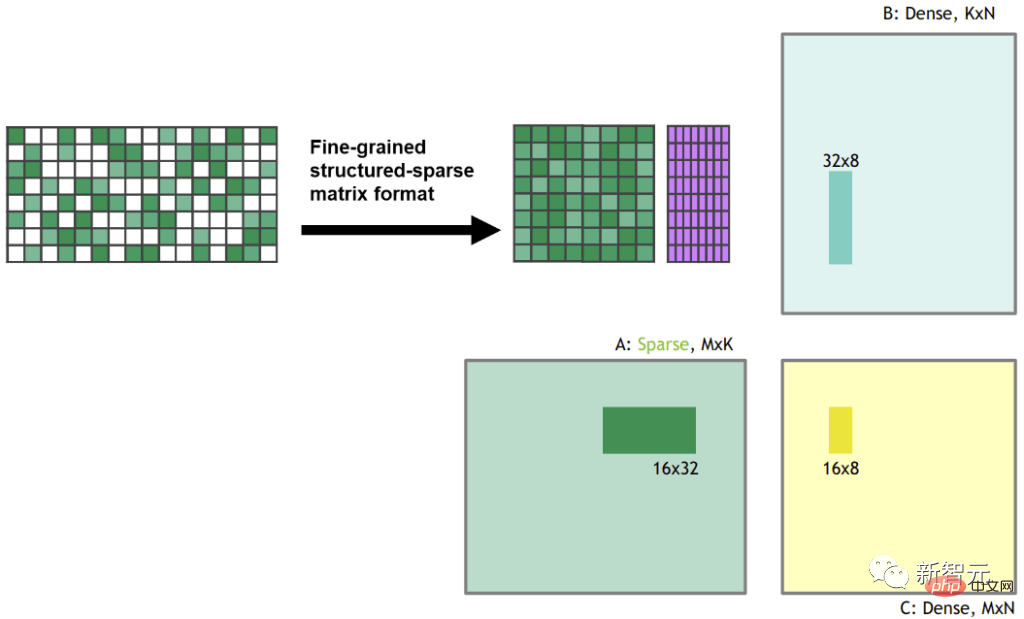

Apabila anda mendarabkan matriks berat jarang ini dengan beberapa input padat, kefungsian teras Tensor Matriks Jarang Ampere secara automatik memampatkan matriks jarang menjadi perwakilan padat iaitu separuh saiz yang ditunjukkan dalam Rajah 2.

Selepas mampatan, jubin matriks yang dimampatkan padat dimasukkan ke dalam teras tensor, yang mengira pendaraban matriks dua kali ganda saiz biasa. Ini berkesan menghasilkan kelajuan 2x kerana keperluan lebar jalur dikurangkan separuh semasa pendaraban matriks dalam memori kongsi.

Rajah 2: Matriks jarang dimampatkan menjadi perwakilan padat sebelum pendaraban matriks.

Saya bekerja pada latihan rangkaian jarang dalam penyelidikan saya, dan saya juga menulis catatan blog tentang latihan jarang. Satu kritikan terhadap kerja saya ialah: "Anda mengurangkan FLOPS yang diperlukan oleh rangkaian, tetapi tidak menghasilkan kelajuan kerana GPU tidak boleh melakukan pendaraban matriks jarang yang pantas".

Dengan penambahan keupayaan pendaraban matriks jarang dalam Teras Tensor, algoritma saya atau algoritma latihan jarang lain, kini sebenarnya menyediakan sehingga 2x kelajuan semasa latihan.

Algoritma latihan jarang yang dibangunkan mempunyai tiga peringkat: (1) Tentukan kepentingan setiap lapisan. (2) Keluarkan pemberat yang paling tidak penting. (3) Menggalakkan pemberat baharu berkadar dengan kepentingan setiap lapisan.

Walaupun ciri ini masih dalam percubaan dan melatih rangkaian jarang masih belum biasa, mempunyai ciri ini pada GPU anda bermakna anda sudah berlatih untuk jarang Bersedia untuk masa hadapan.

Pengiraan ketepatan rendah

Dalam kerja saya, sebelum ini saya telah menunjukkan bahawa jenis data baharu boleh meningkatkan ketepatan rendah semasa kestabilan perambatan belakang.

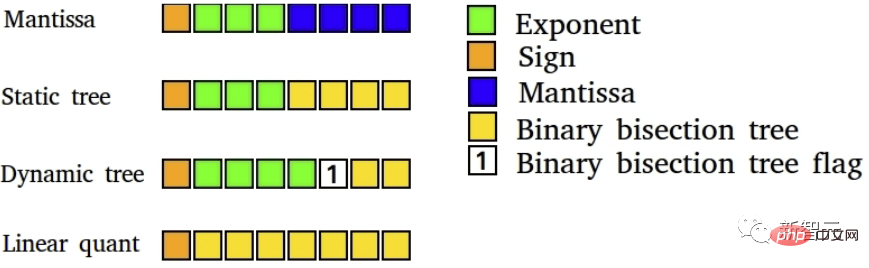

Rajah 4: Jenis data 8-bit pembelajaran mendalam berketepatan rendah. Latihan pembelajaran mendalam mendapat manfaat daripada jenis data yang sangat khusus

Pada masa ini, masalah terbesar ialah jika anda ingin melakukan perambatan belakang yang stabil dengan titik terapung 16-bit (FP16) Data FP16 biasa jenis hanya menyokong nombor dalam julat [-65,504, 65,504]. Jika kecerunan anda melepasi julat ini, kecerunan anda akan meletup ke dalam nilai NaN.

Untuk mengelakkan situasi ini dalam latihan FP16, kami biasanya melakukan penskalaan kerugian, iaitu, mendarabkan kerugian dengan nombor yang kecil sebelum perambatan belakang untuk mengelakkan letupan kecerunan ini.

Format Brain Float 16 (BF16) menggunakan lebih banyak bit untuk eksponen supaya julat nombor yang mungkin adalah sama dengan FP32, BF16 kurang ketepatan, iaitu digit bererti, tetapi kecerunan Ketepatan tidak begitu penting untuk pembelajaran.

Jadi apa yang BF16 lakukan ialah anda tidak perlu lagi melakukan sebarang penskalaan kerugian, dan anda tidak perlu risau tentang kecerunan meletup dengan cepat. Oleh itu, kita harus melihat peningkatan dalam kestabilan latihan dengan menggunakan format BF16, kerana terdapat sedikit kehilangan dalam ketepatan.

Apakah maknanya kepada anda. Menggunakan ketepatan BF16, latihan mungkin lebih stabil daripada menggunakan ketepatan FP16 sambil memberikan peningkatan kelajuan yang sama. Dengan ketepatan TF32, anda mendapat kestabilan hampir dengan FP32 sambil memberikan peningkatan kelajuan hampir kepada FP16.

Perkara yang menarik ialah untuk menggunakan jenis data ini, anda hanya menggantikan FP32 dengan TF32 dan FP16 dengan BF16 - tiada perubahan kod diperlukan.

Walau bagaimanapun, secara umum, jenis data baharu ini boleh dianggap sebagai jenis data malas kerana anda boleh melarikan diri dengan beberapa usaha pengaturcaraan tambahan (penskalaan kerugian yang betul, permulaan, Normalize, gunakan Apex) untuk mendapatkan semua faedah jenis data lama.

Oleh itu, jenis data ini tidak memberikan kelajuan, sebaliknya meningkatkan kemudahan penggunaan ketepatan rendah dalam latihan.

Reka Bentuk Kipas dan Suhu GPU

Walaupun reka bentuk kipas baharu siri RTX 30 melakukan kerja yang sangat baik untuk menyejukkan GPU, bukan -GPU Edisi Pengasas Isu tambahan mungkin timbul dengan reka bentuk kipas yang berbeza.

Jika GPU anda dipanaskan melebihi 80C, ia akan pendikit sendiri, memperlahankan kelajuan/kuasa pengkomputerannya. Penyelesaian kepada masalah ini ialah menggunakan pemanjang PCIe untuk mencipta ruang antara GPU.

Menyebarkan GPU dengan pemanjang PCIe sangat berkesan untuk menyejukkan, pelajar PhD yang lain di University of Washington dan saya telah menggunakan persediaan ini dengan berjaya. Ia tidak kelihatan cantik, tetapi ia mengekalkan GPU anda

Sistem di bawah telah berjalan selama 4 tahun tanpa sebarang masalah. Ini juga boleh digunakan jika anda tidak mempunyai ruang yang mencukupi untuk memuatkan semua GPU dalam slot PCIe.

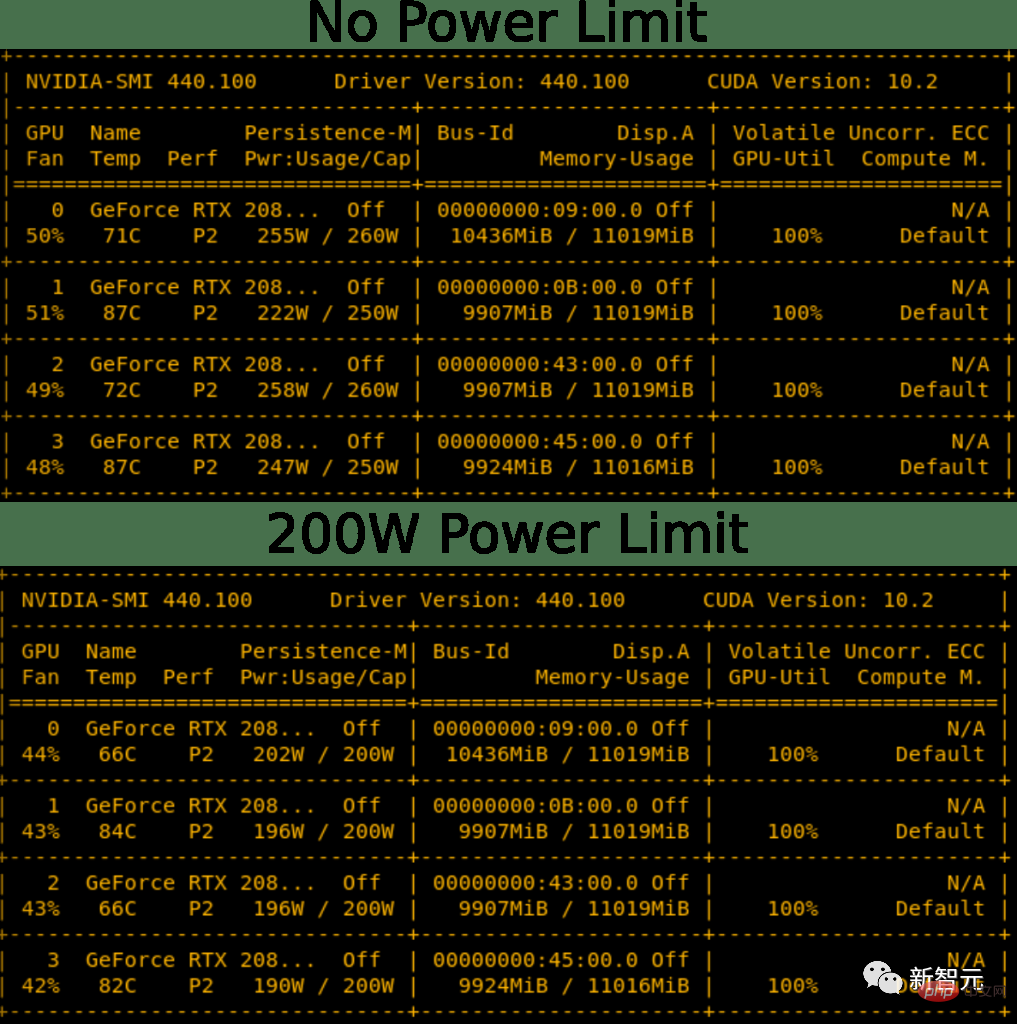

Rajah 5: Sistem 4 kad grafik dengan port pengembangan PCIE, ia kelihatan seperti kucar-kacir, tetapi kecekapan penyejukan sangat tinggi . Anda boleh menetapkan had kuasa pada GPU anda. Hasilnya, anda akan dapat menetapkan had kuasa RTX 3090 secara pemrograman kepada 300W dan bukannya 350W standardnya. Dalam sistem 4-GPU, ini bersamaan dengan penjimatan 200W, yang mungkin cukup untuk menjadikan sistem 4x RTX 3090 boleh dilaksanakan dengan PSU 1600W.

Ini juga membantu mengekalkan GPU sejuk. Oleh itu, menetapkan had kuasa menyelesaikan kedua-dua masalah utama persediaan, penyejukan dan kuasa 4x RTX 3080 atau 4x RTX 3090. Untuk persediaan 4x, anda masih memerlukan kipas penyejuk yang cekap untuk GPU, tetapi ini menyelesaikan isu kuasa.

Rajah 6: Mengurangkan had kuasa mempunyai sedikit kesan penyejukan. Menurunkan had kuasa RTX 2080 Ti sebanyak 50-60W menghasilkan suhu yang lebih rendah sedikit dan operasi kipas yang lebih senyap

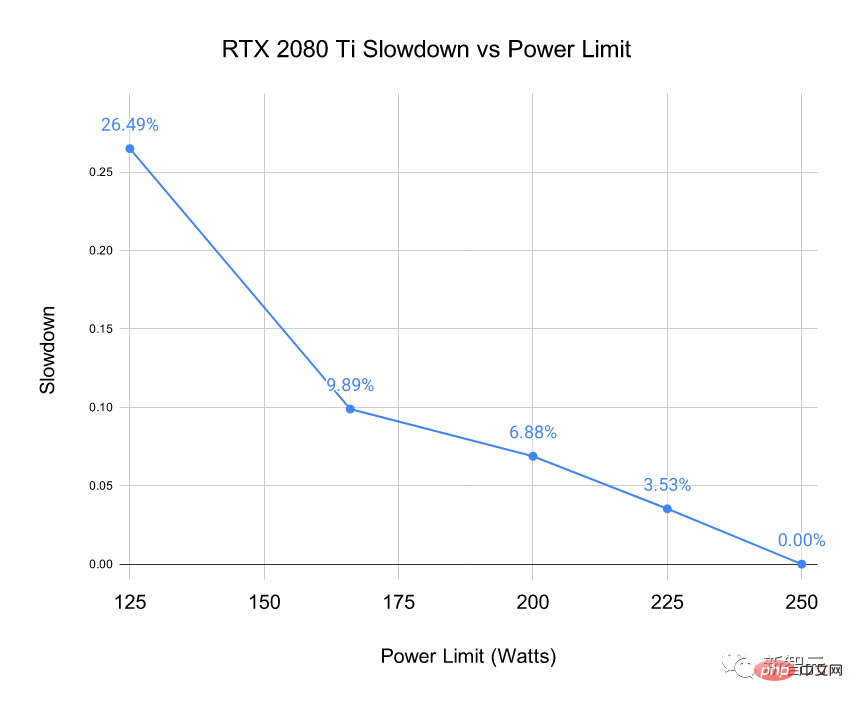

Anda mungkin bertanya, "Tidakkah ini akan memperlahankan GPU? ?" Ya, ia memang akan jatuh, tetapi persoalannya ialah berapa banyak.

Anda mungkin bertanya, "Tidakkah ini akan memperlahankan GPU? ?" Ya, ia memang akan jatuh, tetapi persoalannya ialah berapa banyak.

Saya menanda aras sistem 4x RTX 2080 Ti yang ditunjukkan dalam Rajah 5 pada had kuasa yang berbeza. Saya menanda aras masa untuk 500 kelompok mini BERT Large semasa inferens (tidak termasuk lapisan softmax). Memilih BERT Inferens besar memberikan tekanan terbesar pada GPU.

Rajah 7: Kejatuhan kelajuan diukur pada had kuasa yang diberikan pada RTX 2080 Ti

Kita dapat melihat bahawa menetapkan had kuasa tidak menjejaskan prestasi secara serius. Mengehadkan kuasa kepada 50W hanya mengurangkan prestasi sebanyak 7%.

Kita dapat melihat bahawa menetapkan had kuasa tidak menjejaskan prestasi secara serius. Mengehadkan kuasa kepada 50W hanya mengurangkan prestasi sebanyak 7%.

Masalah kebakaran penyambung RTX 4090

Terdapat salah faham bahawa kord kuasa RTX 4090 terbakar kerana ia terlalu bengkok. Ini sebenarnya berlaku untuk hanya 0.1% pengguna, dan masalah utama ialah kabel tidak dipasang dengan betul.

Oleh itu, adalah selamat sepenuhnya untuk menggunakan RTX 4090 jika anda mengikut arahan pemasangan di bawah.

1. Jika anda menggunakan kabel lama atau GPU lama, pastikan kenalan bebas daripada serpihan/habuk.

2. Gunakan penyambung kuasa dan pasangkannya ke alur keluar sehingga anda mendengar bunyi klik - ini adalah bahagian yang paling penting.

3. Uji kesesuaian dengan memulas kord dari kiri ke kanan. Kabel tidak boleh bergerak.

4. Periksa sentuhan dengan soket secara visual dan tiada jurang antara kabel dan soket.

Sokongan titik terapung 8-bit dalam H100 dan RTX40

Sokongan untuk titik terapung 8-bit (FP8) tersedia dalam siri RTX 40 dan H100 Kelebihan besar untuk GPU.

Dengan input 8-bit ia membolehkan anda memuatkan data untuk pendaraban matriks dua kali lebih pantas dan anda boleh menyimpan dua kali lebih banyak elemen matriks dalam cache seperti dalam seni bina Ada dan Hopper , cache adalah sangat besar, dan kini dengan teras tensor FP8, anda boleh mendapatkan 0.66 PFLOPS pengiraan untuk RTX 4090.

Ini lebih tinggi daripada keseluruhan kuasa pengkomputeran superkomputer terpantas dunia pada tahun 2007. RTX 4090 mempunyai 4 kali pengiraan FP8 dan setanding dengan superkomputer terpantas di dunia pada tahun 2010.

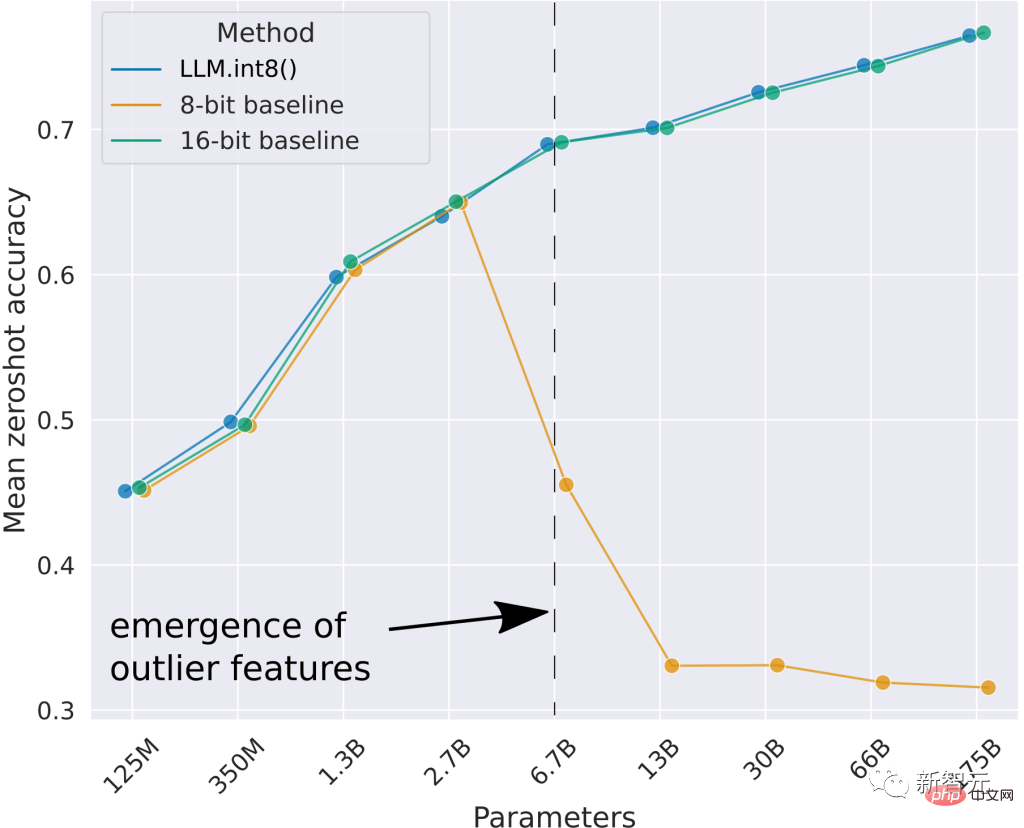

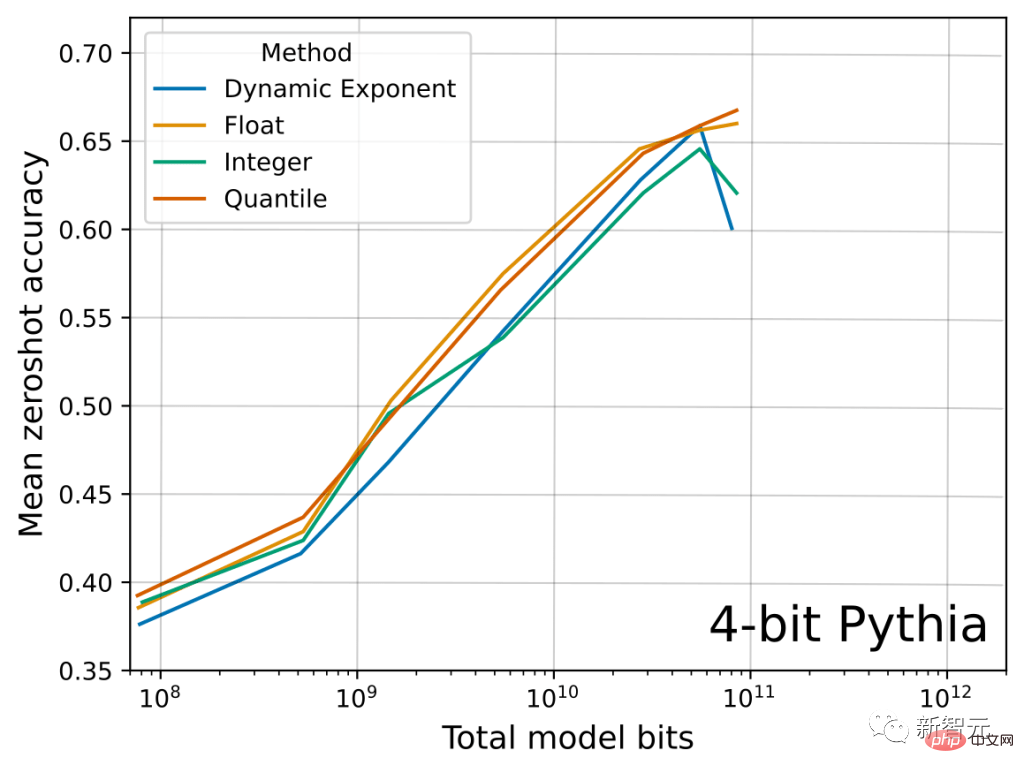

Seperti yang dapat dilihat, garis dasar 8-bit terbaik gagal memberikan prestasi titik sifar yang baik. Kaedah yang saya bangunkan, LLM.int8(), boleh melakukan pendaraban matriks Int8 dengan hasil yang sama seperti garis dasar 16-bit.

Tetapi Int8 sudah disokong oleh GPU generasi RTX 30/A100/Ampere Mengapakah FP8 satu lagi peningkatan besar dalam RTX 40? Jenis data FP8 jauh lebih stabil daripada jenis data Int8 dan mudah digunakan dalam spesifikasi lapisan atau fungsi bukan linear, yang sukar dilakukan dengan jenis data integer.

Ini akan menjadikan penggunaannya dalam latihan dan inferens sangat mudah dan mudah. Saya fikir ini akan menjadikan latihan dan inferens FP8 agak biasa dalam beberapa bulan.

Di bawah anda boleh melihat hasil utama yang berkaitan daripada kertas ini tentang jenis data Float vs Integer. Kita dapat melihat bahawa sedikit demi sedikit, jenis data FP4 mengekalkan lebih banyak maklumat daripada jenis data Int4, dengan itu meningkatkan purata ketepatan titik sifar LLM merentas 4 tugasan.

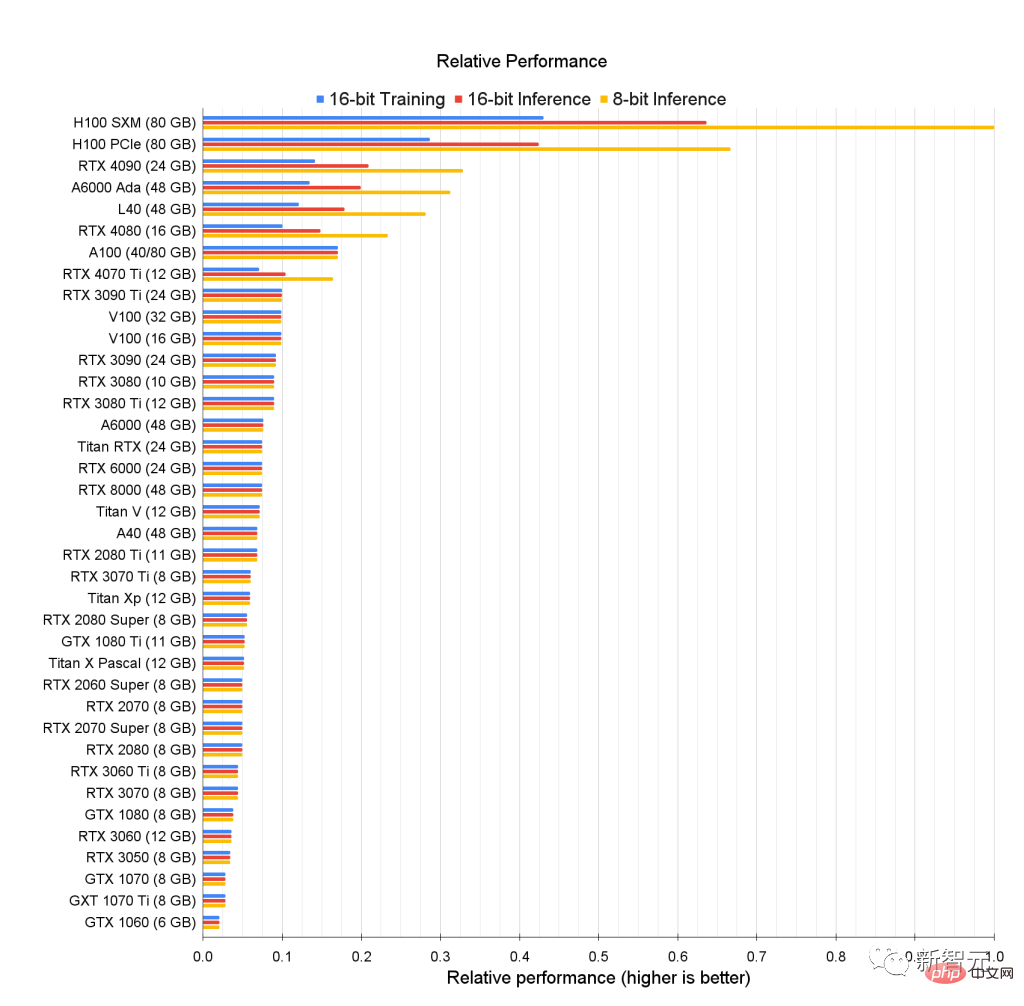

Kedudukan Prestasi Pembelajaran Dalam GPU

Mari kita lihat kedudukan prestasi asal GPU dan lihat siapa rentak terbaik .

Kita dapat melihat jurang yang besar antara prestasi 8-bit GPU H100 dan kad lama yang dioptimumkan untuk prestasi 16-bit.

Angka di atas menunjukkan prestasi relatif mentah GPU Contohnya, untuk inferens 8-bit, prestasi RTX 4090 adalah lebih kurang 0.33 kali ganda daripada H100 SMX.

Dengan kata lain, H100 SMX adalah tiga kali lebih pantas pada inferens 8-bit berbanding RTX 4090.

Untuk data ini, dia tidak memodelkan pengiraan 8-bit untuk GPU lama.

Oleh kerana inferens dan latihan 8-bit lebih cekap pada GPU Ada/Hopper, dan Tensor Memory Accelerator (TMA) menjimatkan banyak daftar yang sangat tepat dalam matriks 8-bit pendaraban .

Ada/Hopper juga mempunyai sokongan FP8, yang menjadikan latihan 8-bit lebih cekap pada Hopper/Ada, prestasi latihan 8-bit mungkin 3-4 kali ganda Latihan 16-bit.

Untuk GPU lama, prestasi inferens Int8 GPU lama adalah hampir dengan prestasi inferens 16-bit.

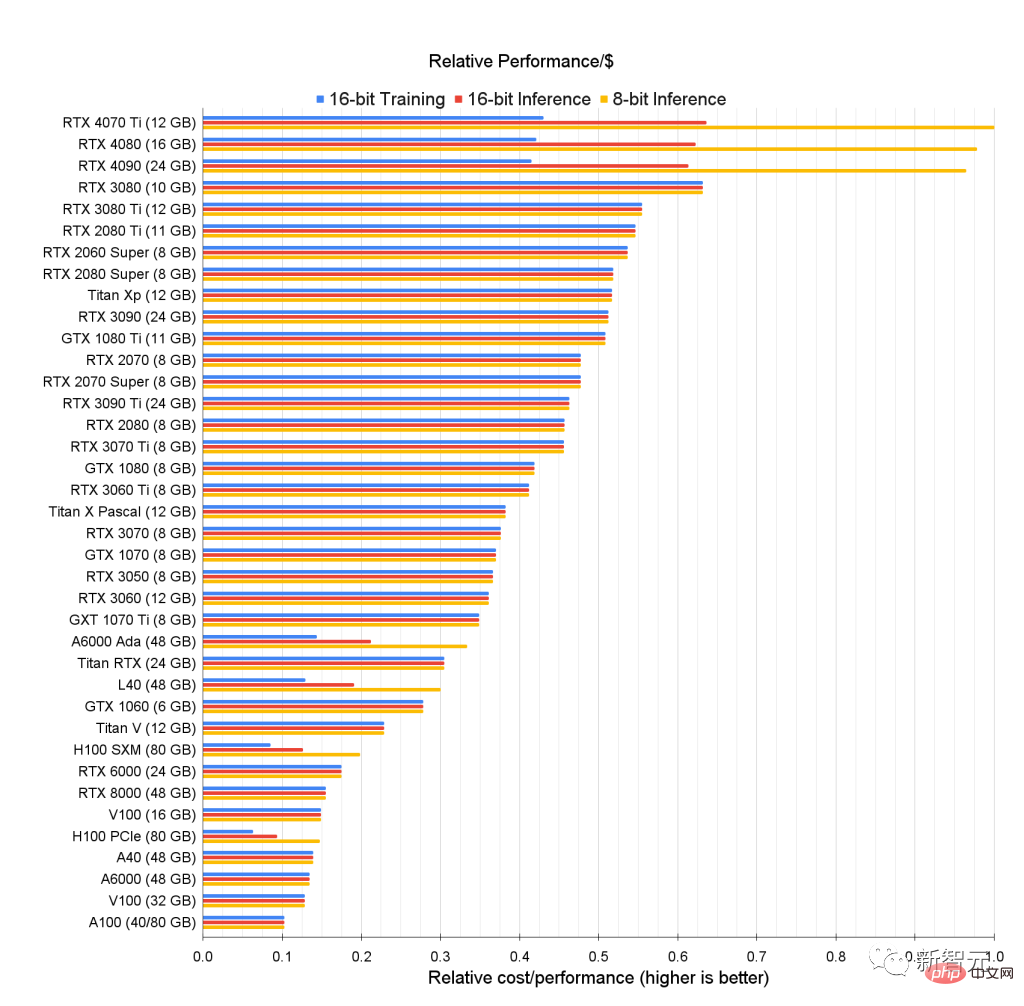

Berapa banyak kuasa pengkomputeran yang boleh anda beli setiap dolar?

Masalahnya ialah, GPU berkuasa tetapi saya tidak mampu...

Bagi mereka yang tidak mempunyai belanjawan yang mencukupi, carta berikut ialah kedudukan prestasi setiap dolarnya (Prestasi setiap Dolar) berdasarkan harga dan statistik prestasi setiap GPU, yang menggambarkan keberkesanan kos daripada GPU.

Memilih GPU yang menyelesaikan tugas pembelajaran mendalam dan sesuai dengan bajet boleh dibahagikan kepada langkah berikut:

- Tentukan dahulu jumlah memori video yang anda perlukan (sekurang-kurangnya 12GB untuk penjanaan imej, sekurang-kurangnya 24GB untuk pemprosesan Transformer); > Mengenai sama ada untuk memilih 8-bit atau 16-bit, adalah disyorkan untuk menggunakan 16-bit jika anda boleh masih menghadapi kesukaran dalam mengendalikan tugas pengekodan yang kompleks; Cari GPU dengan prestasi/kos relatif tertinggi berdasarkan metrik dalam imej di atas.

- Kita dapat melihat bahawa RTX4070Ti adalah yang paling kos efektif untuk inferens 8-bit dan 16-bit, manakala RTX3080 adalah yang paling kos efektif untuk Latihan 16-bit.

-

Walaupun GPU ini adalah yang paling menjimatkan kos, memori mereka juga mempunyai kekurangan, dan memori 10GB dan 12GB mungkin tidak memenuhi semua keperluan.

Tetapi ia mungkin GPU yang ideal untuk pemula yang baru mempelajari pembelajaran mendalam.

Sesetengah GPU ini bagus untuk pertandingan Kaggle untuk berjaya dalam pertandingan Kaggle, kaedah kerja adalah lebih penting daripada saiz model, jadi banyak GPU yang lebih kecil sangat sesuai.

Kaggle dikenali sebagai platform pengumpulan terbesar di dunia untuk saintis data, dengan pakar berkumpul di sini, dan ia juga mesra kepada pemula.

GPU terbaik jika digunakan untuk penyelidikan akademik dan operasi pelayan nampaknya GPU A6000 Ada.

Pada masa yang sama, H100 SXM juga sangat menjimatkan kos, dengan memori yang besar dan prestasi yang kukuh.

Dari pengalaman peribadi, jika saya membina gugusan kecil untuk makmal korporat/akademik, saya akan mengesyorkan 66-80% GPU A6000 dan 20-33% GPU H100 SXM.

Syor komprehensif

Setelah berkata begitu banyak, akhirnya kami sampai ke peringkat keselesaan GPU.

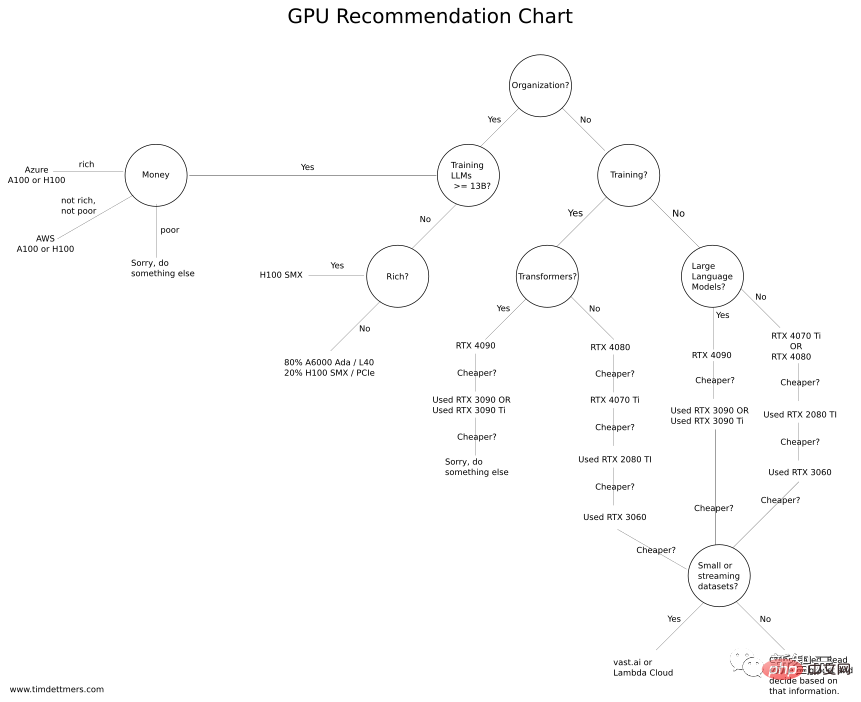

Tim Dettmers mencipta "carta aliran pembelian GPU" jika anda mempunyai belanjawan yang mencukupi, anda boleh menggunakan konfigurasi yang lebih tinggi Jika anda tidak mempunyai belanjawan yang mencukupi, sila rujuk pilihan kos efektif.

Pertama sekali, izinkan saya menekankan satu perkara: tidak kira GPU yang anda pilih, pastikan dahulu memorinya dapat memenuhi keperluan anda. Untuk melakukan ini, anda perlu bertanya kepada diri sendiri beberapa soalan:

Apa yang saya mahu lakukan dengan GPU? Patutkah saya menggunakannya untuk menyertai pertandingan Kaggle, mempelajari pembelajaran mendalam, melakukan penyelidikan CV/NLP, atau bermain projek kecil?

Jika anda mempunyai belanjawan yang mencukupi, anda boleh menyemak penanda aras di atas dan memilih GPU yang terbaik untuk anda.

Anda juga boleh menganggarkan memori GPU yang diperlukan dengan menjalankan masalah anda dalam vast.ai atau Lambda Cloud untuk satu tempoh masa untuk melihat sama ada ia memenuhi keperluan anda.

Jika anda hanya memerlukan GPU sekali-sekala (selama beberapa jam setiap beberapa hari) dan tidak perlu memuat turun dan memproses set data yang besar, vast.ai atau Lambda Cloud juga akan berfungsi dengan baik Kerja.

Walau bagaimanapun, jika GPU digunakan setiap hari selama sebulan dan kekerapan penggunaan adalah tinggi (12 jam sehari), GPU awan biasanya bukan pilihan yang baik.

Atas ialah kandungan terperinci Panduan Membeli GPU Pembelajaran Dalam: Kad grafik manakah yang layak untuk relau alkimia saya?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1378

1378

52

52

Adakah saya perlu mendayakan pecutan perkakasan GPU?

Feb 26, 2024 pm 08:45 PM

Adakah saya perlu mendayakan pecutan perkakasan GPU?

Feb 26, 2024 pm 08:45 PM

Adakah perlu untuk mendayakan GPU dipercepatkan perkakasan? Dengan pembangunan dan kemajuan teknologi yang berterusan, GPU (Unit Pemprosesan Grafik), sebagai komponen teras pemprosesan grafik komputer, memainkan peranan penting. Walau bagaimanapun, sesetengah pengguna mungkin mempunyai soalan tentang sama ada pecutan perkakasan perlu dihidupkan. Artikel ini akan membincangkan keperluan pecutan perkakasan untuk GPU dan kesan menghidupkan pecutan perkakasan pada prestasi komputer dan pengalaman pengguna. Pertama, kita perlu memahami cara GPU dipercepatkan perkakasan berfungsi. GPU adalah khusus

Dok pengembangan kad grafik Beelink EX menjanjikan kehilangan prestasi GPU sifar

Aug 11, 2024 pm 09:55 PM

Dok pengembangan kad grafik Beelink EX menjanjikan kehilangan prestasi GPU sifar

Aug 11, 2024 pm 09:55 PM

Salah satu ciri menonjol Beelink GTi 14 yang dilancarkan baru-baru ini ialah PC mini mempunyai slot PCIe x8 tersembunyi di bawahnya. Pada pelancaran, syarikat itu berkata bahawa ini akan memudahkan untuk menyambungkan kad grafik luaran ke sistem. Beelink mempunyai n

Di luar ORB-SLAM3! SL-SLAM: Adegan bertekstur lemah ringan, kegelisahan teruk dan lemah semuanya dikendalikan

May 30, 2024 am 09:35 AM

Di luar ORB-SLAM3! SL-SLAM: Adegan bertekstur lemah ringan, kegelisahan teruk dan lemah semuanya dikendalikan

May 30, 2024 am 09:35 AM

Ditulis sebelum ini, hari ini kita membincangkan bagaimana teknologi pembelajaran mendalam boleh meningkatkan prestasi SLAM berasaskan penglihatan (penyetempatan dan pemetaan serentak) dalam persekitaran yang kompleks. Dengan menggabungkan kaedah pengekstrakan ciri dalam dan pemadanan kedalaman, di sini kami memperkenalkan sistem SLAM visual hibrid serba boleh yang direka untuk meningkatkan penyesuaian dalam senario yang mencabar seperti keadaan cahaya malap, pencahayaan dinamik, kawasan bertekstur lemah dan seks yang teruk. Sistem kami menyokong berbilang mod, termasuk konfigurasi monokular, stereo, monokular-inersia dan stereo-inersia lanjutan. Selain itu, ia juga menganalisis cara menggabungkan SLAM visual dengan kaedah pembelajaran mendalam untuk memberi inspirasi kepada penyelidikan lain. Melalui percubaan yang meluas pada set data awam dan data sampel sendiri, kami menunjukkan keunggulan SL-SLAM dari segi ketepatan kedudukan dan keteguhan penjejakan.

Pembenaman ruang terpendam: penjelasan dan demonstrasi

Jan 22, 2024 pm 05:30 PM

Pembenaman ruang terpendam: penjelasan dan demonstrasi

Jan 22, 2024 pm 05:30 PM

Pembenaman Ruang Terpendam (LatentSpaceEmbedding) ialah proses memetakan data berdimensi tinggi kepada ruang berdimensi rendah. Dalam bidang pembelajaran mesin dan pembelajaran mendalam, pembenaman ruang terpendam biasanya merupakan model rangkaian saraf yang memetakan data input berdimensi tinggi ke dalam set perwakilan vektor berdimensi rendah ini sering dipanggil "vektor terpendam" atau "terpendam pengekodan". Tujuan pembenaman ruang terpendam adalah untuk menangkap ciri penting dalam data dan mewakilinya ke dalam bentuk yang lebih ringkas dan mudah difahami. Melalui pembenaman ruang terpendam, kami boleh melakukan operasi seperti memvisualisasikan, mengelaskan dan mengelompokkan data dalam ruang dimensi rendah untuk memahami dan menggunakan data dengan lebih baik. Pembenaman ruang terpendam mempunyai aplikasi yang luas dalam banyak bidang, seperti penjanaan imej, pengekstrakan ciri, pengurangan dimensi, dsb. Pembenaman ruang terpendam adalah yang utama

AMD FSR 3.1 dilancarkan: ciri penjanaan bingkai juga berfungsi pada GPU Nvidia GeForce RTX dan Intel Arc

Jun 29, 2024 am 06:57 AM

AMD FSR 3.1 dilancarkan: ciri penjanaan bingkai juga berfungsi pada GPU Nvidia GeForce RTX dan Intel Arc

Jun 29, 2024 am 06:57 AM

AMD menunaikan janji awalnya pada 24 Mac untuk melancarkan FSR 3.1 pada Q2 tahun ini. Apa yang benar-benar membezakan keluaran 3.1 ialah penyahgandingan bahagian penjanaan bingkai daripada bahagian peningkatan. Ini membolehkan pemilik GPU Nvidia dan Intel menggunakan FSR 3.

Fahami dalam satu artikel: kaitan dan perbezaan antara AI, pembelajaran mesin dan pembelajaran mendalam

Mar 02, 2024 am 11:19 AM

Fahami dalam satu artikel: kaitan dan perbezaan antara AI, pembelajaran mesin dan pembelajaran mendalam

Mar 02, 2024 am 11:19 AM

Dalam gelombang perubahan teknologi yang pesat hari ini, Kecerdasan Buatan (AI), Pembelajaran Mesin (ML) dan Pembelajaran Dalam (DL) adalah seperti bintang terang, menerajui gelombang baharu teknologi maklumat. Ketiga-tiga perkataan ini sering muncul dalam pelbagai perbincangan dan aplikasi praktikal yang canggih, tetapi bagi kebanyakan peneroka yang baru dalam bidang ini, makna khusus dan hubungan dalaman mereka mungkin masih diselubungi misteri. Jadi mari kita lihat gambar ini dahulu. Dapat dilihat bahawa terdapat korelasi rapat dan hubungan progresif antara pembelajaran mendalam, pembelajaran mesin dan kecerdasan buatan. Pembelajaran mendalam ialah bidang khusus pembelajaran mesin dan pembelajaran mesin

Super kuat! 10 algoritma pembelajaran mendalam teratas!

Mar 15, 2024 pm 03:46 PM

Super kuat! 10 algoritma pembelajaran mendalam teratas!

Mar 15, 2024 pm 03:46 PM

Hampir 20 tahun telah berlalu sejak konsep pembelajaran mendalam dicadangkan pada tahun 2006. Pembelajaran mendalam, sebagai revolusi dalam bidang kecerdasan buatan, telah melahirkan banyak algoritma yang berpengaruh. Jadi, pada pendapat anda, apakah 10 algoritma teratas untuk pembelajaran mendalam? Berikut adalah algoritma teratas untuk pembelajaran mendalam pada pendapat saya Mereka semua menduduki kedudukan penting dari segi inovasi, nilai aplikasi dan pengaruh. 1. Latar belakang rangkaian saraf dalam (DNN): Rangkaian saraf dalam (DNN), juga dipanggil perceptron berbilang lapisan, adalah algoritma pembelajaran mendalam yang paling biasa Apabila ia mula-mula dicipta, ia dipersoalkan kerana kesesakan kuasa pengkomputeran tahun, kuasa pengkomputeran, Kejayaan datang dengan letupan data. DNN ialah model rangkaian saraf yang mengandungi berbilang lapisan tersembunyi. Dalam model ini, setiap lapisan menghantar input ke lapisan seterusnya dan

Honor X7b 5G dikeluarkan secara rasmi dengan bateri 6000mAh + 100 juta piksel!

Apr 03, 2024 am 08:20 AM

Honor X7b 5G dikeluarkan secara rasmi dengan bateri 6000mAh + 100 juta piksel!

Apr 03, 2024 am 08:20 AM

Baru-baru ini, CNMO menyedari bahawa Honor X7b5G telah dikeluarkan secara rasmi di pasaran luar negara. Banyak konfigurasi model ini serupa dengan Honor Play 50Plus di pasaran China, tetapi terdapat perubahan dalam sistem pengimejan dan sebahagian daripada reka bentuk. Honor X7b5G dilengkapi dengan pemproses Dimensity 700 MediaTek. Dimensity 700 dibina menggunakan proses 7nm TSMC dan mempunyai reka bentuk CPU 8 teras, terdiri daripada 2 teras besar A76 + 6 teras kecil A55. Antaranya, frekuensi teras A76 adalah setinggi 2.2GHz, dan frekuensi teras A55 ialah 2.0GHz. Dari segi GPU, Dimensity 700 mempunyai Mali-G57MC2 terbina dalam dengan frekuensi sehingga 950MHz. Pemproses telah dioptimumkan untuk mempunyai prestasi cemerlang dan penggunaan tenaga yang rendah, dan boleh membawa Honor X7b5G