Peranti teknologi

Peranti teknologi

AI

AI

Model LLaMA telah dibocorkan, dan versi Meta ChatGPT terpaksa menjadi 'sumber terbuka'! GitHub memperoleh 8k bintang dan sejumlah besar ulasan dikeluarkan

Model LLaMA telah dibocorkan, dan versi Meta ChatGPT terpaksa menjadi 'sumber terbuka'! GitHub memperoleh 8k bintang dan sejumlah besar ulasan dikeluarkan

Model LLaMA telah dibocorkan, dan versi Meta ChatGPT terpaksa menjadi 'sumber terbuka'! GitHub memperoleh 8k bintang dan sejumlah besar ulasan dikeluarkan

Pertempuran untuk ChatGPT semakin sengit.

Beberapa minggu lalu, Meta mengeluarkan model bahasa berskala besarnya sendiri LLaMA, dengan parameter antara 7 bilion hingga 65 bilion.

Dalam kertas itu, LLaMA (13 bilion) dengan hanya 1/10 parameter mengatasi GPT-3 pada kebanyakan penanda aras.

Untuk LLaMA dengan 65 bilion parameter, ia setanding dengan DeepMind’s Chinchilla (70 bilion parameter) dan Google PaLM (540 bilion parameter).

Walaupun Meta mendakwa bahawa LLaMA adalah sumber terbuka, penyelidik masih perlu memohon dan menyemaknya.

Walau bagaimanapun, perkara yang tidak pernah saya jangkakan ialah hanya beberapa hari selepas dikeluarkan, fail model LLaMA telah bocor lebih awal.

Lalu, timbul persoalan, adakah ini disengajakan atau tidak sengaja?

LLaMA adalah "sumber terbuka" ?

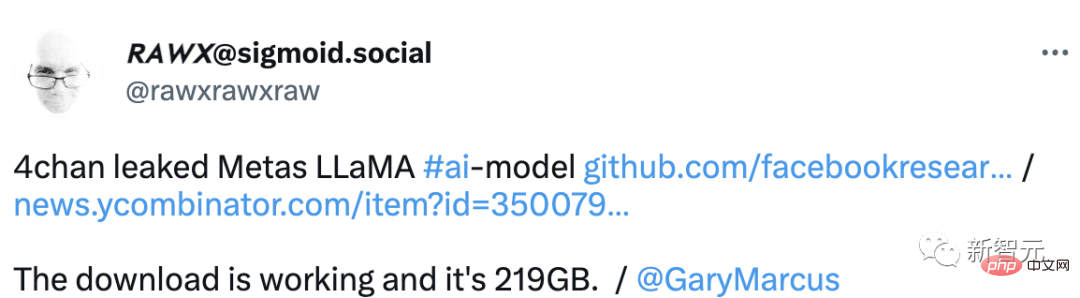

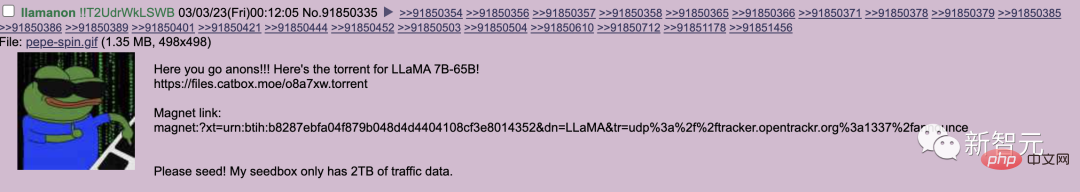

Baru-baru ini, perpustakaan produk siap LLaMA telah bocor di forum asing 4chan.

Khamis lalu, llamanon pengguna menyiarkan pada papan teknologi 4chan melalui Keluaran torrent (torrent) daripada model LLaMA 7B dan 65B.

Pautan torrent ini pada masa ini disekat Digabungkan ke dalam halaman GitHub LLaMA.

Dia juga menyerahkan permintaan tarik kedua kepada projek itu, yang memberikan pautan benih kepada set pemberat lain untuk model itu.

Pada masa ini, projek itu telah menerima 8k bintang di GitHub.

Walau bagaimanapun, salah satu kesilapan terbesar pembocor ialah memasukkan kod pengecam unik mereka dalam model yang bocor.

Kod ini direka khusus untuk mengesan pembocor, meletakkan maklumat peribadi pengguna llamanon pada risiko.

Bak kata pepatah, LLaMA bukan sumber terbuka dan tidak sopan, tetapi netizen membantu untuk menjadi sopan.

Selain itu, pengguna di 4chan telah mencipta sumber yang berguna untuk mereka yang ingin menggunakan model pada stesen kerja mereka sendiri.

dan menyediakan panduan kepada tutorial pengedaran tentang cara mendapatkan model dan menambah pemberat yang diubah suai padanya untuk inferens yang lebih cekap.

Apatah lagi, sumber ini juga menyediakan cara untuk menyepadukan LLaMA ke dalam platform penulisan dalam talian KoboldAI.

Sama ada Meta melakukan ini secara sengaja atau tidak sengaja membocorkannya. Netizen meluahkan pendapat mereka satu demi satu.

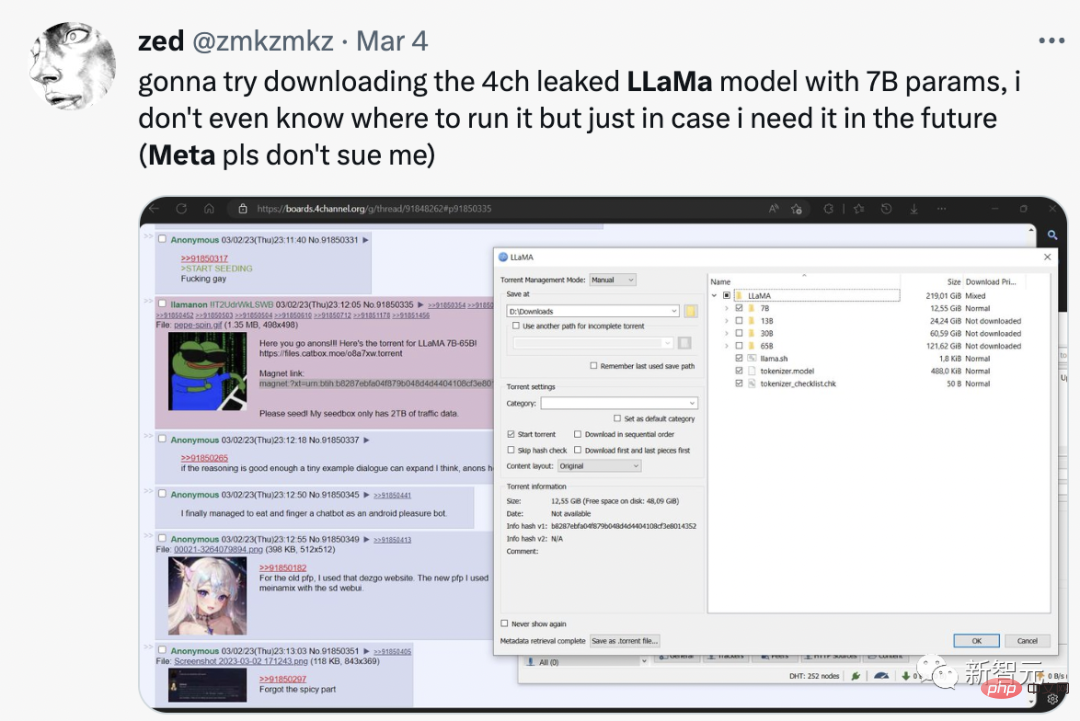

Analisis netizen sangat jelas, "Mungkin Meta sengaja membocorkannya untuk melawan OpenAI." Sesetengah pelanggan berpendapat ini adalah model yang lebih baik dan ia sesuai di tengah-tengah rancangan perniagaan mereka untuk menjual akses pada harga $250,000 setahun. Sebulan akses kepada perkhidmatan mereka membeli mesin yang mampu menjalankan model yang bocor ini. Meta mengurangkan pesaing baru yang berpotensi untuk memastikan kartel teknologi besar semasa stabil. Mungkin ini adalah sedikit teori konspirasi, tetapi kita hidup dalam zaman teknologi besar dan konspirasi besar. Pada hari Isnin, Meta berkata ia akan terus mengeluarkan alatan kecerdasan buatannya kepada penyelidik bertauliah walaupun LLaMA telah dibocorkan kepada pengguna yang tidak dibenarkan. Sesetengah netizen secara langsung mengatakan bahawa mereka memuat turun LLaMA dengan 7 bilion parameter Walaupun mereka tidak tahu cara menjalankannya, mereka boleh mendapatkannya sekiranya mereka memerlukannya pada masa hadapan.

Kebocoran dan sumber terbuka LLaMA ialah acara besar:

Resapan Stabil ialah sumber terbuka. Lapan bulan kemudian, kita kini boleh membaca fikiran orang lain dan menyahkod semua yang mereka lihat.

Dengan pembukaan LLM, kami akan mendapat beberapa barangan yang sangat gila.

Penilaian model awal

Tidak lama selepas LLaMA dikeluarkan, netizen mendapati ini Model parameter terkecil juga memerlukan hampir 30GB GPU untuk dijalankan.

Walau bagaimanapun, dengan pengoptimuman titik terapung menggunakan perpustakaan Bit dan Byte, mereka dapat menjalankan model pada NVIDIA RTX 3060 tunggal.

Tambahan pula, seorang penyelidik di GitHub malah dapat menjalankan versi 7B LLM pada CPU Ryzen 7900X dan membuat kesimpulan beberapa perkataan sesaat.

Jadi apakah sebenarnya model LLaMA itu? Lelaki asing menyemaknya.

LLaMA menunjukkan prestasi yang baik dalam banyak ujian.

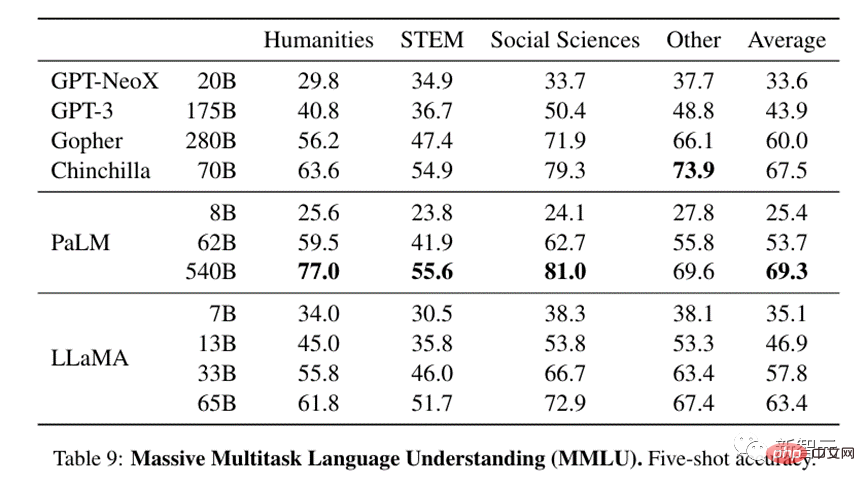

Dari segi pemahaman bahasa pelbagai tugas berskala besar, model 13B yang agak kecil pun setanding dengan GPT-3 iaitu saiz 13 kali.

Versi 33B jauh lebih baik daripada GPT-3, dan versi 65B boleh bersaing dengan model LLM sedia ada yang paling berkuasa - PaLM parameter 540B Google.

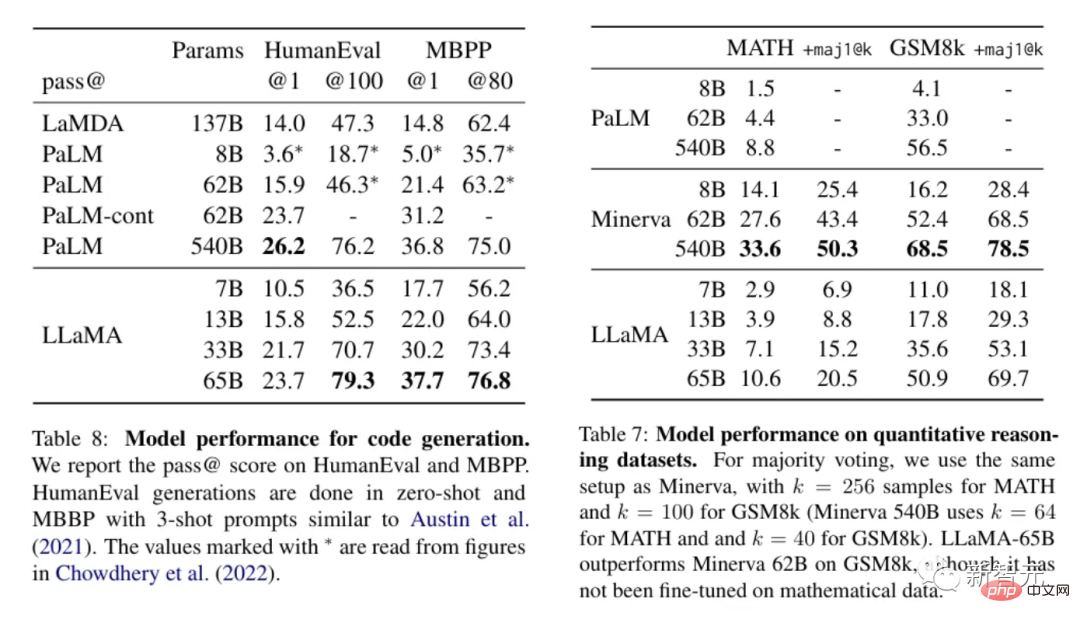

Untuk teks yang memerlukan penggunaan logik atau pengiraan untuk pemprosesan, LLaMA berprestasi baik dan boleh bersaing dengan PaLM dalam penaakulan kuantitatif Berbanding dengan, atau lebih baik daripada keupayaan penjanaan kod yang terakhir.

Memandangkan keputusan ini, LLaMA nampaknya merupakan salah satu model tercanggih yang tersedia pada masa ini, dan, Ia cukup kecil sehingga ia tidak memerlukan banyak sumber untuk dijalankan. Ini menjadikan LLaMA sangat menggoda untuk orang ramai mahu bermain dengannya dan melihat apa yang boleh dilakukannya.

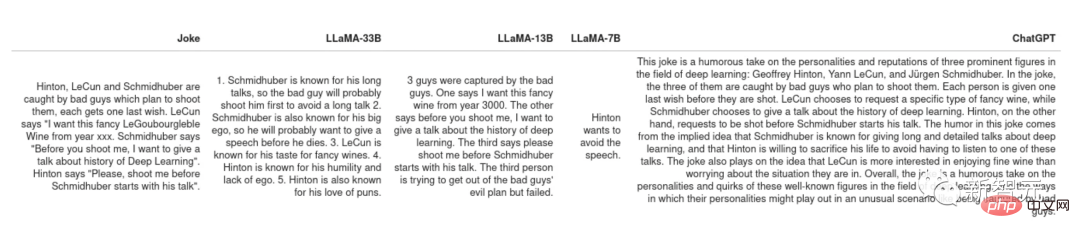

Menjelaskan jenaka

Kertas asal PaLM menunjukkan kes penggunaan yang sangat keren: diberi jenaka, biarkan model menerangkan sebab ia lucu. Tugas ini memerlukan gabungan percubaan dan logik, yang tidak dapat dicapai oleh semua model PaLM sebelumnya.

Serahkan beberapa jenaka kepada LLaMA dan ChatGPT untuk tafsiran Sesetengah model bahasa jenaka boleh mendapatkannya, seperti ucapan Schimidhuber yang panjang dan membosankan.

Tetapi secara keseluruhan, kedua-dua LLaMA dan ChatGPT tidak mempunyai rasa jenaka.

Walau bagaimanapun, kedua-duanya mempunyai strategi yang berbeza untuk menangani jenaka yang mereka tidak fahami ChatGPT akan menghasilkan "dinding teks", dengan harapan sekurang-kurangnya beberapa ayat adalah jawapan yang betul, tingkah laku ini seperti pelajar yang tidak tahu jawapan, dengan harapan guru dapat mencari jawapan dari karut mereka.

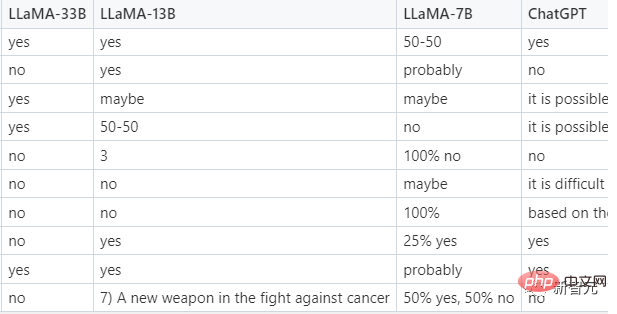

Pengkelasan sampel sifar

Ini adalah fungsi yang sangat praktikal yang membolehkan orang ramai menggunakan LLM dan bukannya menjaringkan menjana set latihan dan kemudian melatih model yang boleh diservis yang lebih kecil pada set latihan tersebut.

Tugas yang lebih mencabar ialah mengklasifikasikan iklan yang diklik, kerana manusia pun tidak boleh bersetuju tentang maksud iklan yang diklik, model itu disediakan dalam gesaan Beberapa contoh, jadi sebenarnya ini adalah beberapa sampel dan bukannya klasifikasi sifar sampel. Berikut ialah petua daripada LLaMA.

Dalam ujian, hanya LLaMA-33B berjaya mengikut format yang diperlukan dan memberikan jawapan, dan ramalannya adalah munasabah ChatGPT dilakukan kedua, dan boleh memberikan a perbandingan Jawapan yang munasabah, tetapi selalunya tidak dalam format yang ditetapkan, dan model 7B dan 13B yang lebih kecil tidak sesuai dengan tugas itu.

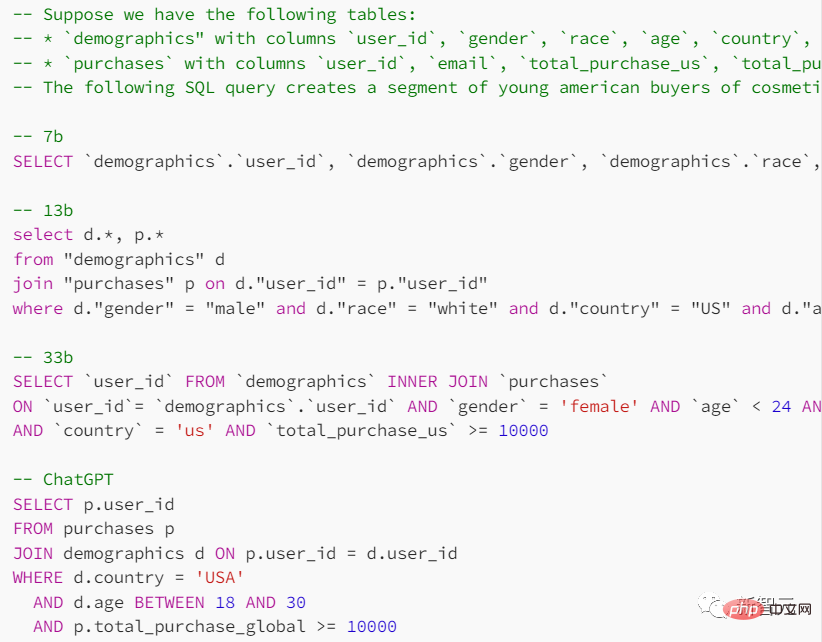

Penjanaan kod

Walaupun LLM Cemerlang dalam bidang kemanusiaan tetapi tidak dalam subjek STEM, jadi bagaimana prestasi LLaMA dalam bidang ini?

Dalam gesaan, berikan bentuk jadual carian dan tujuan yang anda ingin capai, dan minta model menyediakan pernyataan pertanyaan SQL.

ChatGPT berprestasi lebih baik dalam tugasan ini, tetapi hasil yang diberikan oleh model bahasa umumnya tidak boleh dipercayai.

Dalam pelbagai ujian berbanding ChatGPT, LLaMA tidak menunjukkan prestasi seperti yang diharapkan Sama seperti berjaya. Sudah tentu, jika jurang itu hanya disebabkan oleh RLHF (pembelajaran pengukuhan dengan maklum balas manusia), maka masa depan model kecil mungkin lebih cerah.

Atas ialah kandungan terperinci Model LLaMA telah dibocorkan, dan versi Meta ChatGPT terpaksa menjadi 'sumber terbuka'! GitHub memperoleh 8k bintang dan sejumlah besar ulasan dikeluarkan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1384

1384

52

52

Saya cuba pengekodan getaran dengan kursor AI dan ia menakjubkan!

Mar 20, 2025 pm 03:34 PM

Saya cuba pengekodan getaran dengan kursor AI dan ia menakjubkan!

Mar 20, 2025 pm 03:34 PM

Pengekodan Vibe membentuk semula dunia pembangunan perisian dengan membiarkan kami membuat aplikasi menggunakan bahasa semulajadi dan bukannya kod yang tidak berkesudahan. Diilhamkan oleh penglihatan seperti Andrej Karpathy, pendekatan inovatif ini membolehkan Dev

Top 5 Genai dilancarkan pada Februari 2025: GPT-4.5, Grok-3 & More!

Mar 22, 2025 am 10:58 AM

Top 5 Genai dilancarkan pada Februari 2025: GPT-4.5, Grok-3 & More!

Mar 22, 2025 am 10:58 AM

Februari 2025 telah menjadi satu lagi bulan yang berubah-ubah untuk AI generatif, membawa kita beberapa peningkatan model yang paling dinanti-nantikan dan ciri-ciri baru yang hebat. Dari Xai's Grok 3 dan Anthropic's Claude 3.7 Sonnet, ke Openai's G

Bagaimana cara menggunakan Yolo V12 untuk pengesanan objek?

Mar 22, 2025 am 11:07 AM

Bagaimana cara menggunakan Yolo V12 untuk pengesanan objek?

Mar 22, 2025 am 11:07 AM

Yolo (anda hanya melihat sekali) telah menjadi kerangka pengesanan objek masa nyata yang terkemuka, dengan setiap lelaran bertambah baik pada versi sebelumnya. Versi terbaru Yolo V12 memperkenalkan kemajuan yang meningkatkan ketepatan

Penjana Seni AI Terbaik (Percuma & amp; Dibayar) untuk projek kreatif

Apr 02, 2025 pm 06:10 PM

Penjana Seni AI Terbaik (Percuma & amp; Dibayar) untuk projek kreatif

Apr 02, 2025 pm 06:10 PM

Artikel ini mengkaji semula penjana seni AI atas, membincangkan ciri -ciri mereka, kesesuaian untuk projek kreatif, dan nilai. Ia menyerlahkan Midjourney sebagai nilai terbaik untuk profesional dan mengesyorkan Dall-E 2 untuk seni berkualiti tinggi dan disesuaikan.

Adakah chatgpt 4 o tersedia?

Mar 28, 2025 pm 05:29 PM

Adakah chatgpt 4 o tersedia?

Mar 28, 2025 pm 05:29 PM

CHATGPT 4 kini tersedia dan digunakan secara meluas, menunjukkan penambahbaikan yang ketara dalam memahami konteks dan menjana tindak balas yang koheren berbanding dengan pendahulunya seperti ChATGPT 3.5. Perkembangan masa depan mungkin merangkumi lebih banyak Inter yang diperibadikan

AI mana yang lebih baik daripada chatgpt?

Mar 18, 2025 pm 06:05 PM

AI mana yang lebih baik daripada chatgpt?

Mar 18, 2025 pm 06:05 PM

Artikel ini membincangkan model AI yang melampaui chatgpt, seperti Lamda, Llama, dan Grok, menonjolkan kelebihan mereka dalam ketepatan, pemahaman, dan kesan industri. (159 aksara)

Cara Menggunakan Mistral OCR untuk Model RAG Seterusnya

Mar 21, 2025 am 11:11 AM

Cara Menggunakan Mistral OCR untuk Model RAG Seterusnya

Mar 21, 2025 am 11:11 AM

Mistral OCR: Merevolusi Generasi Pengambilan Pengambilan semula dengan Pemahaman Dokumen Multimodal Sistem Generasi Pengambilan Retrieval (RAG) mempunyai keupayaan AI yang ketara, membolehkan akses ke kedai data yang luas untuk mendapatkan respons yang lebih tepat

CHATBOTS AI terbaik berbanding (Chatgpt, Gemini, Claude & amp; Lagi)

Apr 02, 2025 pm 06:09 PM

CHATBOTS AI terbaik berbanding (Chatgpt, Gemini, Claude & amp; Lagi)

Apr 02, 2025 pm 06:09 PM

Artikel ini membandingkan chatbots AI seperti Chatgpt, Gemini, dan Claude, yang memberi tumpuan kepada ciri -ciri unik mereka, pilihan penyesuaian, dan prestasi dalam pemprosesan bahasa semula jadi dan kebolehpercayaan.