Peranti teknologi

Peranti teknologi

AI

AI

Yann LeCun membuka tentang Penyelidikan Google: Komunikasi yang disasarkan telah wujud sejak sekian lama, di manakah inovasi anda?

Yann LeCun membuka tentang Penyelidikan Google: Komunikasi yang disasarkan telah wujud sejak sekian lama, di manakah inovasi anda?

Yann LeCun membuka tentang Penyelidikan Google: Komunikasi yang disasarkan telah wujud sejak sekian lama, di manakah inovasi anda?

Beberapa hari lalu, pemenang Anugerah Turing akademik Yann LeCun mempersoalkan kajian Google.

Beberapa masa lalu, Google AI mencadangkan struktur kehilangan hierarki am untuk rangkaian saraf berbilang lapisan dalam penyelidikan baharunya "LocoProp: Meningkatkan BackProp melalui Pengoptimuman Kehilangan Setempat" Rangka Kerja LocoProp, yang mencapai prestasi hampir dengan kaedah tertib kedua sambil menggunakan pengoptimum tertib pertama sahaja.

Secara lebih khusus, rangka kerja itu membayangkan semula rangkaian saraf sebagai komposisi modular berbilang lapisan, di mana setiap lapisan menggunakan penyelaras berat, output sasaran dan fungsi kehilangannya sendiri, akhirnya mencapai Prestasi dan kecekapan secara serentak.

Google secara eksperimen mengesahkan keberkesanan pendekatannya pada model penanda aras dan set data, merapatkan jurang antara pengoptimum tertib pertama dan kedua. Di samping itu, penyelidik Google menyatakan bahawa kaedah pembinaan kerugian tempatan mereka adalah kali pertama kerugian kuasa dua digunakan sebagai kerugian tempatan.

Sumber imej: @Google AI

Untuk penyelidikan oleh Google ini, sesetengah orang telah mengulas bahawa ia hebat dan menarik. Walau bagaimanapun, sesetengah orang menyatakan pandangan berbeza, termasuk pemenang Anugerah Turing Yann LeCun.

Beliau percaya bahawa terdapat banyak versi apa yang kini kita panggil prop sasaran, beberapa telah wujud sejak tahun 1986. Jadi, apakah perbezaan antara LocoProp Google dan mereka?

Sumber foto: @Yann LeCun

Haohan Wang, yang bakal menjadi penolong profesor di UIUC, bersetuju dengan soalan LeCun. Beliau berkata kadangkala menghairankan mengapa sesetengah pengarang menganggap idea mudah seperti itu adalah yang pertama seumpamanya. Mungkin mereka melakukan sesuatu yang berbeza, tetapi pasukan publisiti tidak sabar untuk keluar dan menuntut segala-galanya...

Sumber foto: @HaohanWang

Namun , sesetengah orang "tidak dingin" kepada LeCun, memikirkan bahawa dia menimbulkan persoalan daripada pertimbangan persaingan atau bahkan "memulakan perang." LeCun menjawab, mendakwa bahawa soalannya tidak ada kaitan dengan persaingan, dan memberikan contoh bekas ahli makmalnya seperti Marc'Aurelio Ranzato, Karol Gregor, koray kavukcuoglu, dll., yang semuanya telah menggunakan beberapa versi penyebaran sasaran, dan kini mereka semua bekerja di Google DeepMind .

Sumber gambar: @Gabriel Jimenez@Yann LeCun

Sesetengah orang mengejek Yann LeCun, "Apabila anda tidak dapat mengalahkan Jürgen Schmidhuber, jadilah dia. ”

Betul ke Yann LeCun? Mari kita lihat dahulu tentang kajian Google ini. Adakah terdapat sebarang inovasi yang cemerlang?

Google LocoProp: Penyebaran balik yang dipertingkatkan dengan pengoptimuman kerugian tempatan

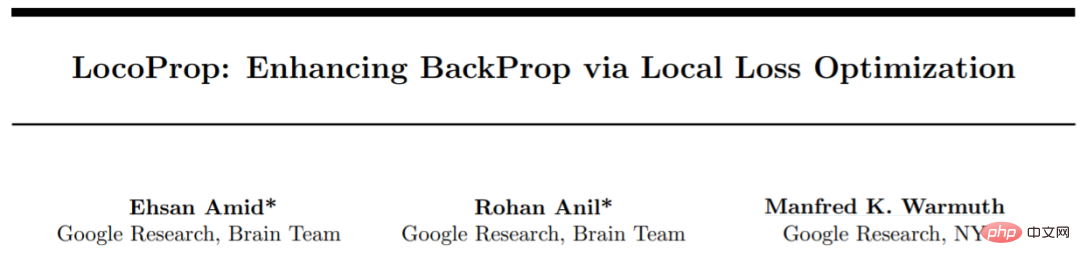

Penyelidikan ini telah disiapkan oleh tiga penyelidik dari Google: Ehsan Amid, Rohan Anil dan Manfred K. Warmuth.

Alamat kertas: https://proceedings.mlr.press/v151/amid22a/amid22a.pdf

Artikel ini percaya bahawa rangkaian saraf dalam (DNN ) Terdapat dua faktor utama untuk berjaya: reka bentuk model dan data latihan, tetapi beberapa penyelidik membincangkan kaedah pengoptimuman untuk mengemas kini parameter model. Latihan DNN kami melibatkan meminimumkan fungsi kehilangan, yang digunakan untuk meramalkan perbezaan antara nilai sebenar dan nilai ramalan model, dan menggunakan perambatan belakang untuk mengemas kini parameter.

Kaedah kemas kini berat yang paling mudah ialah keturunan kecerunan stokastik, iaitu, dalam setiap langkah, berat bergerak secara relatif kepada arah negatif kecerunan. Selain itu, terdapat kaedah pengoptimuman lanjutan, seperti pengoptimum momentum, AdaGrad, dsb. Pengoptimum ini sering dipanggil kaedah tertib pertama kerana mereka biasanya hanya menggunakan maklumat daripada derivatif tertib pertama untuk mengubah suai arah kemas kini.

Terdapat juga kaedah pengoptimuman yang lebih maju seperti Syampu, K-FAC, dsb., yang telah terbukti meningkatkan penumpuan dan mengurangkan bilangan lelaran. Menggunakan maklumat tambahan ini, pengoptimum tertib tinggi boleh menemui arah kemas kini yang lebih cekap untuk model terlatih dengan mengambil kira korelasi antara kumpulan parameter yang berbeza. Kelemahannya ialah pengiraan arah kemas kini tertib lebih tinggi secara pengiraan lebih mahal daripada kemas kini pesanan pertama.

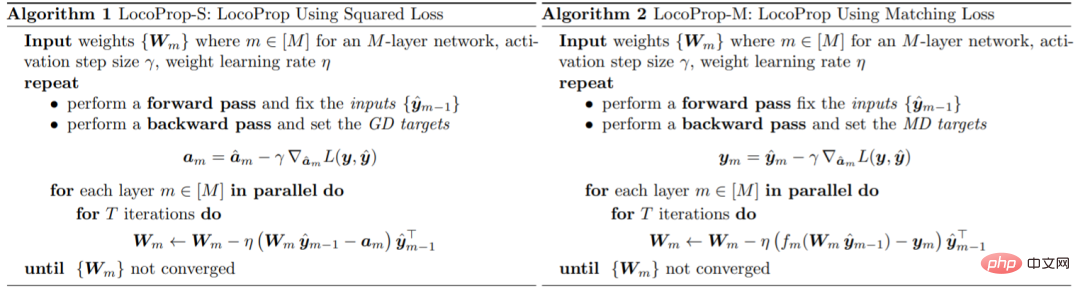

Google memperkenalkan rangka kerja untuk melatih model DNN dalam kertas kerja: LocoProp, yang menganggap rangkaian saraf sebagai gabungan modular lapisan. Secara umumnya, setiap lapisan rangkaian saraf melakukan transformasi linear pada input, diikuti dengan fungsi pengaktifan bukan linear. Dalam kajian ini, setiap lapisan rangkaian diberikan penyelaras berat, sasaran keluaran dan fungsi kehilangannya sendiri. Fungsi kehilangan setiap lapisan direka untuk memadankan fungsi pengaktifan lapisan tersebut. Menggunakan borang ini, melatih sekumpulan kecil kerugian tempatan yang diberikan boleh diminimumkan, berulang antara lapisan secara selari.

Google menggunakan pengoptimum tertib pertama ini untuk kemas kini parameter, sekali gus mengelakkan kos pengiraan yang diperlukan oleh pengoptimum tertib lebih tinggi.

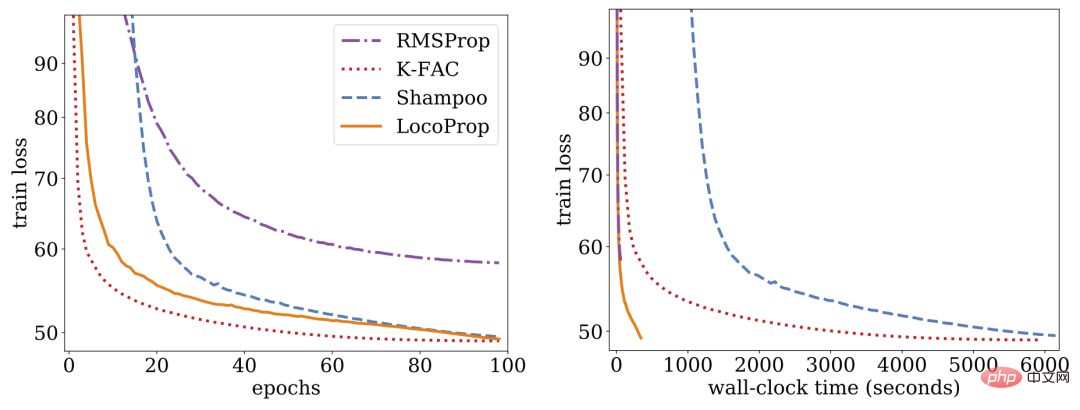

Penyelidikan menunjukkan bahawa LocoProp mengatasi kaedah tertib pertama pada penanda aras autoenkoder mendalam dan berprestasi setanding dengan pengoptimum tertib tinggi seperti Syampu dan K-FAC tanpa keperluan memori dan pengiraan yang tinggi.

LocoProp: Penyebaran balik yang dipertingkatkan melalui pengoptimuman kehilangan setempat

Biasanya rangkaian saraf dilihat sebagai fungsi komposit yang menukar input setiap lapisan kepada ekspres keluaran. LocoProp mengguna pakai perspektif ini apabila menguraikan rangkaian menjadi lapisan. Khususnya, bukannya mengemas kini pemberat lapisan untuk meminimumkan fungsi kehilangan pada output, LocoProp menggunakan fungsi kehilangan setempat yang dipratentukan khusus untuk setiap lapisan. Untuk lapisan tertentu, fungsi kehilangan dipilih untuk memadankan fungsi pengaktifan, contohnya, kehilangan tanh akan dipilih untuk lapisan dengan pengaktifan tanh. Selain itu, istilah penyelarasan memastikan bahawa pemberat yang dikemas kini tidak menyimpang terlalu jauh daripada nilai semasanya.

Sama seperti perambatan belakang, LocoProp menggunakan pas hadapan untuk mengira pengaktifan. Dalam hantaran ke belakang, LocoProp menetapkan sasaran untuk neuron dalam setiap lapisan. Akhir sekali, LocoProp menguraikan latihan model kepada masalah bebas merentas lapisan, di mana pelbagai kemas kini tempatan boleh digunakan pada pemberat setiap lapisan secara selari.

Google menjalankan eksperimen pada model autoenkoder dalam, penanda aras biasa untuk menilai prestasi algoritma pengoptimuman. Mereka melakukan pengoptimuman yang meluas pada berbilang pengoptimum tertib pertama yang biasa digunakan, termasuk SGD, SGD dengan momentum, AdaGrad, RMSProp, Adam dan pengoptimum tertib tinggi termasuk Syampu, K-FAC dan membandingkan hasilnya dengan LocoProp. Hasilnya menunjukkan bahawa kaedah LocoProp menunjukkan prestasi yang lebih baik daripada pengoptimum tertib pertama dan setanding dengan pengoptimum tertib tinggi, sambil jauh lebih pantas apabila dijalankan pada satu GPU.

Atas ialah kandungan terperinci Yann LeCun membuka tentang Penyelidikan Google: Komunikasi yang disasarkan telah wujud sejak sekian lama, di manakah inovasi anda?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1377

1377

52

52

Cara menyelesaikan MySQL tidak dapat dimulakan

Apr 08, 2025 pm 02:21 PM

Cara menyelesaikan MySQL tidak dapat dimulakan

Apr 08, 2025 pm 02:21 PM

Terdapat banyak sebab mengapa permulaan MySQL gagal, dan ia boleh didiagnosis dengan memeriksa log ralat. Penyebab umum termasuk konflik pelabuhan (periksa penghunian pelabuhan dan ubah suai konfigurasi), isu kebenaran (periksa keizinan pengguna yang menjalankan perkhidmatan), ralat fail konfigurasi (periksa tetapan parameter), rasuah direktori data (memulihkan data atau membina semula ruang meja), isu ruang jadual InnoDB (semak fail ibdata1) Apabila menyelesaikan masalah, anda harus menganalisisnya berdasarkan log ralat, cari punca utama masalah, dan mengembangkan tabiat sandaran data secara teratur untuk mencegah dan menyelesaikan masalah.

Bolehkah mysql kembali json

Apr 08, 2025 pm 03:09 PM

Bolehkah mysql kembali json

Apr 08, 2025 pm 03:09 PM

MySQL boleh mengembalikan data JSON. Fungsi JSON_EXTRACT mengekstrak nilai medan. Untuk pertanyaan yang kompleks, pertimbangkan untuk menggunakan klausa WHERE untuk menapis data JSON, tetapi perhatikan kesan prestasinya. Sokongan MySQL untuk JSON sentiasa meningkat, dan disyorkan untuk memberi perhatian kepada versi dan ciri terkini.

Memahami sifat asid: tiang pangkalan data yang boleh dipercayai

Apr 08, 2025 pm 06:33 PM

Memahami sifat asid: tiang pangkalan data yang boleh dipercayai

Apr 08, 2025 pm 06:33 PM

Penjelasan terperinci mengenai atribut asid asid pangkalan data adalah satu set peraturan untuk memastikan kebolehpercayaan dan konsistensi urus niaga pangkalan data. Mereka menentukan bagaimana sistem pangkalan data mengendalikan urus niaga, dan memastikan integriti dan ketepatan data walaupun dalam hal kemalangan sistem, gangguan kuasa, atau pelbagai pengguna akses serentak. Gambaran keseluruhan atribut asid Atomicity: Transaksi dianggap sebagai unit yang tidak dapat dipisahkan. Mana -mana bahagian gagal, keseluruhan transaksi dilancarkan kembali, dan pangkalan data tidak mengekalkan sebarang perubahan. Sebagai contoh, jika pemindahan bank ditolak dari satu akaun tetapi tidak meningkat kepada yang lain, keseluruhan operasi dibatalkan. Begintransaction; UpdateAcCountSsetBalance = Balance-100Wh

Klausa had SQL Master: Kawal bilangan baris dalam pertanyaan

Apr 08, 2025 pm 07:00 PM

Klausa had SQL Master: Kawal bilangan baris dalam pertanyaan

Apr 08, 2025 pm 07:00 PM

Klausa SQLLIMIT: Kawal bilangan baris dalam hasil pertanyaan. Klausa had dalam SQL digunakan untuk mengehadkan bilangan baris yang dikembalikan oleh pertanyaan. Ini sangat berguna apabila memproses set data yang besar, paparan paginat dan data ujian, dan dapat meningkatkan kecekapan pertanyaan dengan berkesan. Sintaks Asas Sintaks: SelectColumn1, Column2, ... FROMTABLE_NAMELIMITNUMBER_OF_ROWS; Number_of_rows: Tentukan bilangan baris yang dikembalikan. Sintaks dengan Offset: SelectColumn1, Column2, ... Fromtable_namelimitoffset, Number_of_rows; Offset: Langkau

Bagaimana untuk mengoptimumkan prestasi MySQL untuk aplikasi beban tinggi?

Apr 08, 2025 pm 06:03 PM

Bagaimana untuk mengoptimumkan prestasi MySQL untuk aplikasi beban tinggi?

Apr 08, 2025 pm 06:03 PM

Panduan Pengoptimuman Prestasi Pangkalan Data MySQL Dalam aplikasi yang berintensifkan sumber, pangkalan data MySQL memainkan peranan penting dan bertanggungjawab untuk menguruskan urus niaga besar-besaran. Walau bagaimanapun, apabila skala aplikasi berkembang, kemunculan prestasi pangkalan data sering menjadi kekangan. Artikel ini akan meneroka satu siri strategi pengoptimuman prestasi MySQL yang berkesan untuk memastikan aplikasi anda tetap cekap dan responsif di bawah beban tinggi. Kami akan menggabungkan kes-kes sebenar untuk menerangkan teknologi utama yang mendalam seperti pengindeksan, pengoptimuman pertanyaan, reka bentuk pangkalan data dan caching. 1. Reka bentuk seni bina pangkalan data dan seni bina pangkalan data yang dioptimumkan adalah asas pengoptimuman prestasi MySQL. Berikut adalah beberapa prinsip teras: Memilih jenis data yang betul dan memilih jenis data terkecil yang memenuhi keperluan bukan sahaja dapat menjimatkan ruang penyimpanan, tetapi juga meningkatkan kelajuan pemprosesan data.

Kunci utama MySQL boleh menjadi batal

Apr 08, 2025 pm 03:03 PM

Kunci utama MySQL boleh menjadi batal

Apr 08, 2025 pm 03:03 PM

Kunci utama MySQL tidak boleh kosong kerana kunci utama adalah atribut utama yang secara unik mengenal pasti setiap baris dalam pangkalan data. Jika kunci utama boleh kosong, rekod tidak dapat dikenal pasti secara unik, yang akan membawa kepada kekeliruan data. Apabila menggunakan lajur integer sendiri atau UUIDs sebagai kunci utama, anda harus mempertimbangkan faktor-faktor seperti kecekapan dan penghunian ruang dan memilih penyelesaian yang sesuai.

Kaedah Navicat untuk melihat kata laluan pangkalan data MongoDB

Apr 08, 2025 pm 09:39 PM

Kaedah Navicat untuk melihat kata laluan pangkalan data MongoDB

Apr 08, 2025 pm 09:39 PM

Tidak mustahil untuk melihat kata laluan MongoDB secara langsung melalui Navicat kerana ia disimpan sebagai nilai hash. Cara mendapatkan kata laluan yang hilang: 1. Tetapkan semula kata laluan; 2. Periksa fail konfigurasi (mungkin mengandungi nilai hash); 3. Semak Kod (boleh kata laluan Hardcode).

Pantau titisan mysql dan Mariadb dengan pengeksport prometheus mysql

Apr 08, 2025 pm 02:42 PM

Pantau titisan mysql dan Mariadb dengan pengeksport prometheus mysql

Apr 08, 2025 pm 02:42 PM

Pemantauan yang berkesan terhadap pangkalan data MySQL dan MariaDB adalah penting untuk mengekalkan prestasi yang optimum, mengenal pasti kemungkinan kesesakan, dan memastikan kebolehpercayaan sistem keseluruhan. Pengeksport Prometheus MySQL adalah alat yang berkuasa yang memberikan pandangan terperinci ke dalam metrik pangkalan data yang penting untuk pengurusan proaktif dan penyelesaian masalah.