Dalam dua hari lalu, pemenang Anugerah Turing Yann LeCun mengalami sedikit gangguan mental.

Sejak ChatGPT menjadi popular, Microsoft telah meluruskan punggungnya dengan OpenAI.

Google, yang ditampar di muka, tidak mengatakan apa-apa tentang "risiko reputasi".

Semua model bahasanya, sama ada LaMDA, atau DeepMind’s Sparrow, dan Apprentice Bard, boleh dipercepatkan. Kemudian melabur hampir 400 juta dolar AS dalam Anthropic, dengan harapan dapat menyokong OpenAInya sendiri dengan cepat. (Saya mahukan apa yang Microsoft ada)

Walau bagaimanapun, ada seorang yang melihat Microsoft dan Google memimpin, tetapi hanya boleh melompat di tempat dengan cemas.

Orang ini ialah ketua saintis AI Meta—Yann LeCun.

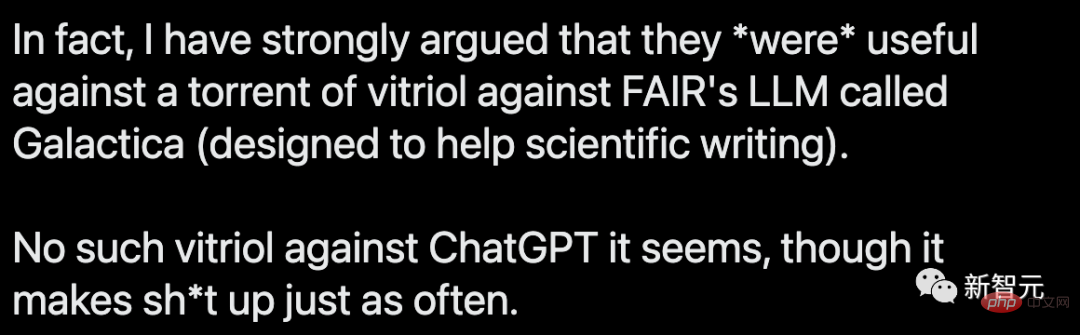

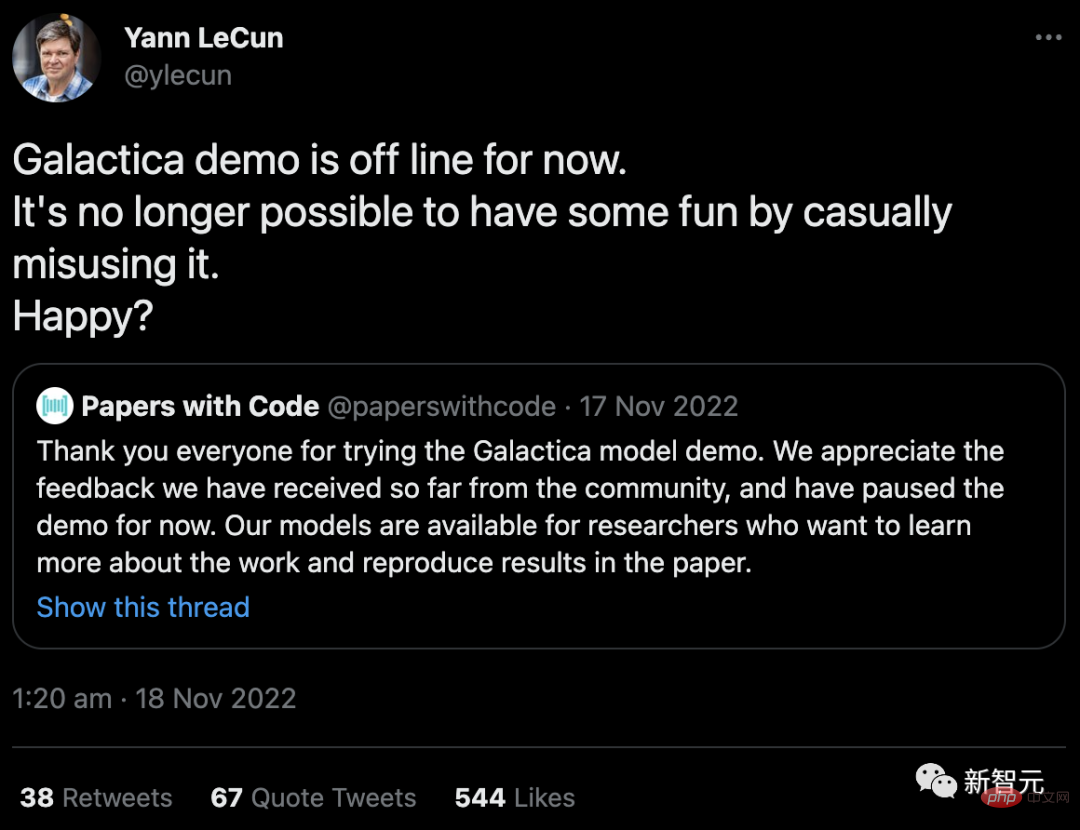

Dia sangat kecewa di Twitter: "ChatGPT penuh dengan perkara karut, tetapi anda sangat bertolak ansur dengannya, tetapi Galactica saya baru tiga hari keluar, dan anda memarahinya. ke bawah "

Sebagai tiga gergasi pembelajaran mendalam 1. Pemenang Anugerah Turing, setiap gerakan LeCun sangat menarik perhatian.

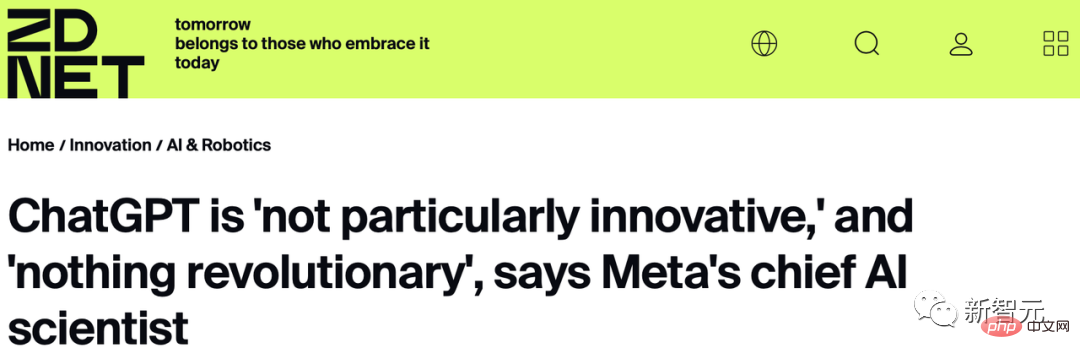

Pada 27 Januari, pada satu perhimpunan kecil media dan eksekutif di Zoom, LeCun membuat ulasan yang mengejutkan tentang ChatGPT: “Setakat teknologi asas, ChatGPT bukan. inovasi yang begitu hebat walaupun di mata orang ramai, ia adalah revolusioner, tetapi kita tahu bahawa ia adalah produk yang disusun dengan baik, tidak lebih daripada 🎜>

"Selain itu. Google dan Meta, terdapat enam syarikat permulaan, pada asasnya semuanya dengan teknologi yang hampir sama."

Selain itu, beliau juga berkata bahawa seni bina Transformer yang digunakan oleh ChatGPT dicadangkan oleh Google, dan diri sendiri -kaedah penyeliaan yang digunakannya adalah apa yang beliau anjurkan OpenAI masih belum lahir pada masa itu.

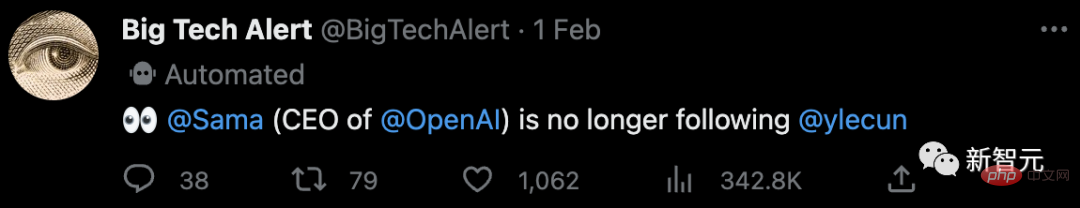

Sebaik sahaja kenyataan ini keluar, orang ramai gempar. Sam Altman, Ketua Pegawai Eksekutif Open AI, nampaknya secara langsung menolak LeCun kerana kenyataan ini.

Selepas itu, LeCun terus terlibat dalam pertempuran lisan dengan peminat.

Selepas itu, LeCun terus terlibat dalam pertempuran lisan dengan peminat.

Pada 28 Januari, LeCun menulis tweet, “Model bahasa yang besar tidak mempunyai intuisi fizikal, mereka dilatih berdasarkan teks Jika mereka boleh mendapatkan maklumat yang serupa daripada kenangan bersekutu yang besar, Jawapan kepada soalan mungkin betul, tetapi jawapan mereka mungkin salah sama sekali 🎜>Pada 4 Februari, LeCun tweet sekali lagi, menyatakan dengan lebih terang bahawa "di jalan menuju AI peringkat manusia, model bahasa besar adalah jalan yang bengkok."

Sejurus berkata demikian, netizen teruja dan meluru ke ruangan komen untuk meninggalkan mesej.

LeCun kemudian menambah: "LLM yang bergantung pada regresi automatik dan ramalan tindak balas perkataan seterusnya adalah cara yang salah, kerana mereka tidak boleh merancang mahupun membuat alasan." 🎜>

"Tetapi Transformer terlatih SSL adalah penyelesaian kerana sistem dunia sebenar yang ada di dalamnya mempunyai keupayaan untuk menaakul, merancang dan belajar." >

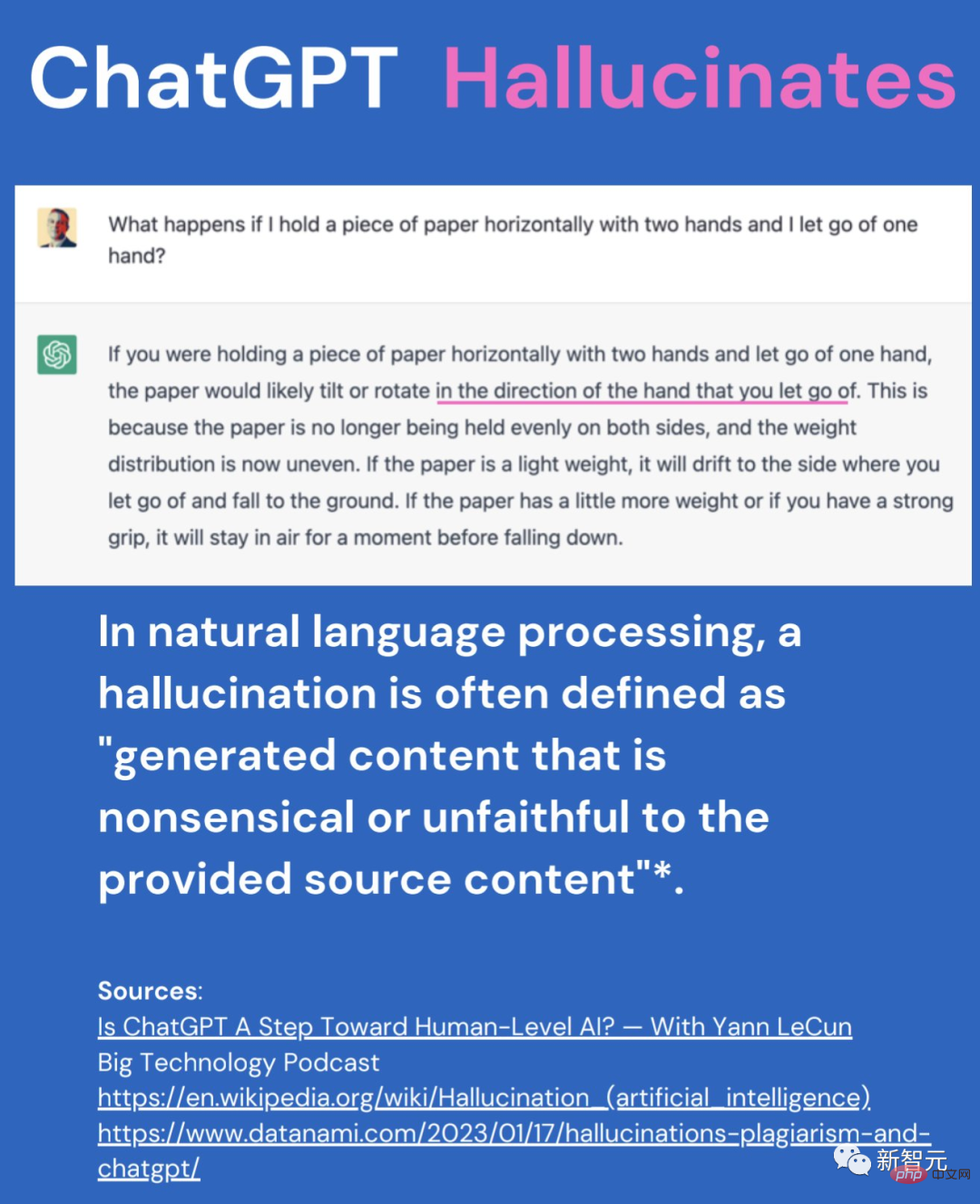

LeCun memberikan contoh yang menarik: Apabila dia mengambil bahagian dalam podcast, dia menunjukkan jawapan ChatGPT Nampaknya munasabah, tetapi ia benar-benar salah. Bagaimanapun, selepas moderator membaca jawapan ChatGPT, dia langsung tidak menyedari ia salah.

LeCun menjelaskan: "Cara pemikiran dan persepsi kita tentang dunia membolehkan kita menjangka apa yang akan berlaku. Ini adalah asas untuk akal kita, dan LLM tidak mempunyai ini. "

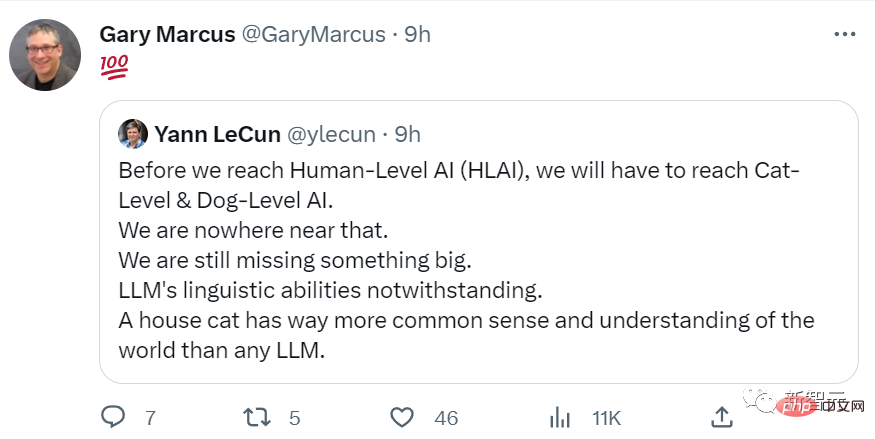

Dia tweet sekali lagi: "Sebelum kita boleh membuat AI peringkat manusia, kita perlu membuat AI peringkat kucing/anjing sangat penting: kucing peliharaan pun mempunyai akal dan pemahaman yang lebih waras tentang dunia daripada mana-mana model bahasa besar."

Dalam ruangan komen, beberapa netizen mengkritik LeCun secara tidak sengaja: "Anda tidak betul, saya sendiri telah mengujinya dan mendapati kadar ralat Galactica hampir 100%, manakala kadar ralat ChatGPT hampir 15%. "

Sebagai tindak balas terhadap kritikan netizen, LeCun sekali lagi menyiarkan Tweet untuk menyatakan sikap: "Saya tidak pernah mengatakan bahawa model bahasa besar tidak berguna Malah, kami di Meta juga melancarkan model Galactica, tetapi ia tidak berjaya seperti ChatGPT yang penuh dengan karut, tetapi anda sangat bertolak ansur dengannya, tetapi Glacatica saya, saya baru keluar selama tiga hari. Saya telah dimarahi oleh anda sehingga saya berada di luar talian. ini. Berkata: "Anda sangat hebat. Mengapa anda tidak kembali ke makmal dan membuat apa yang anda katakan." Ia adalah hobi hujung minggu kegemaran saya.”

Model saya hanya hidup selama 3 hari

Adalah difahami bahawa LeCun sangat kecewa.

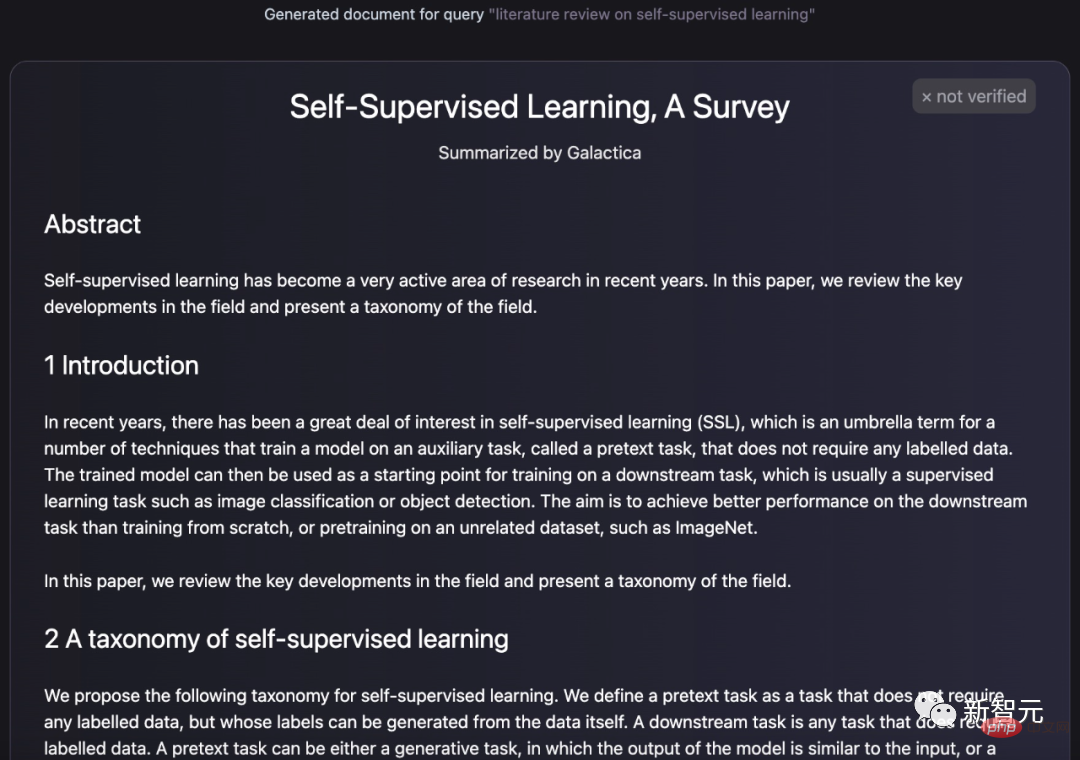

Pada pertengahan November tahun lalu, makmal FAIR Meta mencadangkan model Galactica, yang boleh menjana kertas, menjana entri ensiklopedia, menjawab soalan dan melengkapkan pelbagai model formula kimia dan urutan protein tugas status, dsb.

LeCun Dia juga dengan gembira menulis tweet dan memuji, mengatakan bahawa ini adalah model yang dilatih berdasarkan kesusasteraan akademik Jika anda memberikannya satu perenggan, ia boleh menghasilkan kertas dengan struktur yang lengkap.

LeCun memajukan Kertas dengan notis Kod dan berkata seperti "dendam besar": "Sekarang kami tidak boleh lagi bermain gembira dengan Galactica, adakah anda gembira?"

Walaupun demo Galactica hanya dalam talian selama beberapa hari, pengguna pada masa itu merasakan mereka sedang berhadapan dengan musuh yang hebat.

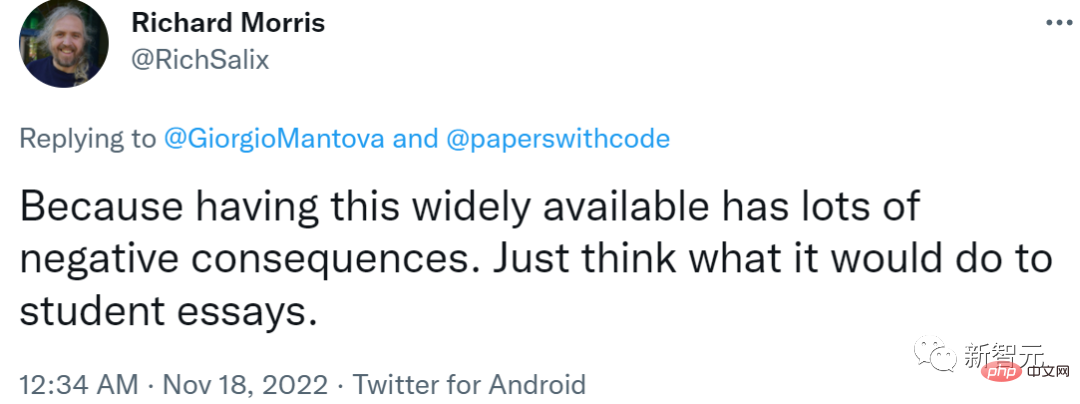

Sesetengah netizen memberi amaran: Fikirkan tentang apa yang pelajar akan gunakan artifak "tulisan kertas" ini.

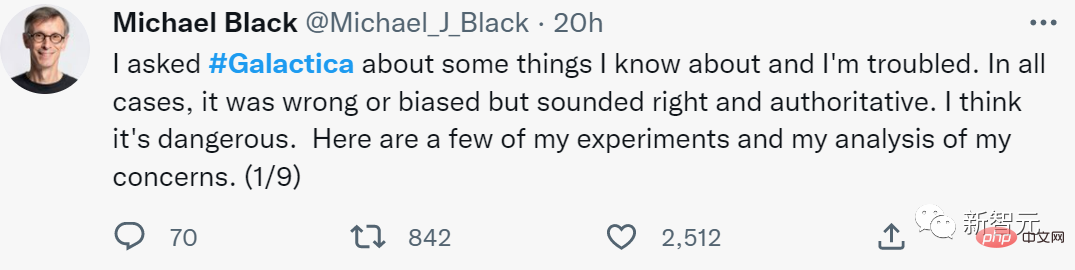

Sesetengah netizen berkata, "Jawapan model Galactica penuh dengan kesilapan dan berat sebelah, tetapi nadanya sangat yakin. Berwibawa. Ini menakutkan." Marcus juga mengatakan bahawa model bahasa besar seperti ini mungkin digunakan oleh pelajar. Digunakan untuk menipu guru, sangat membimbangkan.

Formula biasa dan rasa biasa ini benar-benar menyentuh perasaan: bukankah panik dan keraguan yang disebabkan oleh Galactica sebenarnya adalah apa yang ChatGPT alami kemudian?

Melihat sejarah ini berulang, tetapi dengan pengakhiran yang sama sekali berbeza, tidak boleh dikatakan bahawa LeCun begitu pahit tanpa sebab.

Lalu mengapa ChatGPT boleh menjadi lebih dan lebih popular di tengah-tengah keraguan, tetapi Galactica hanya boleh dimarahi dan dibawa ke luar talian?

Pertama sekali, Galactica telah dicadangkan oleh Meta bahawa syarikat besar menghadapi lebih banyak "risiko reputasi" berbanding syarikat permulaan kecil seperti OpenAI.

Selain itu, strategi penentududukan produk OpenAI sangat pintar Seperti yang dapat dilihat daripada nama ChatGTP, konsep utamanya ialah berbual.

Anda boleh berbual dengannya tentang pengetahuan dan kertas kerja, tetapi memandangkan ia adalah "sembang", anda secara semula jadi boleh melepaskannya. Siapa yang menetapkan bahawa sembang mestilah mengenai "tepat" dan "ketat "perkara?

Tetapi takrifan rasminya ialah: "Ini adalah model yang digunakan untuk penyelidikan saintifik." kecerdasan buatan yang dilatih mengenai pengetahuan saintifik manusia Anda boleh menggunakannya sebagai antara muka baharu untuk mengakses dan memanipulasi pengetahuan kita tentang alam semesta.

Walaupun dari perspektif teknikal, ChatGPT tidak mempunyai banyak inovasi, dari perspektif operasi produk, OpenAI telah melakukan kerja yang sangat baik.

Jadi, kenapa model bahasa besar bercakap bukan-bukan?

Dalam artikel yang disukai oleh LeCun, penulis menjelaskan: "Saya telah cuba menggunakan ChatGPT untuk membantu menulis catatan blog, tetapi semuanya berakhir dengan kegagalan. Sebabnya mudah: ChatGPT sering menghasilkan banyak "fakta" palsu.

Bahasa semula jadi tidak sama dengan pengetahuan

Anda tahu, LLM adalah untuk Bunyi seperti manusia dalam perbualan dengan manusia lain, dan mereka mencapai matlamat ini dengan baik. Tetapi masalahnya, bunyi semula jadi dan menilai ketepatan maklumat adalah dua perkara yang sama sekali berbeza.

Jadi, bagaimana untuk menyelesaikan masalah ini?

Sebagai contoh, kita boleh menggunakan mesin yang telah mengodkan pemahaman fizik - enjin fizik:

Bagi "masalah kertas palsu", kita juga boleh menggunakan pembetulan yang serupa.

Iaitu untuk menjadikan ChatGPT menyedari bahawa ia telah ditanya soalan tentang kertas saintifik, atau bahawa ia sedang menulis sesuatu tentang kertas, dan memaksanya untuk merujuk pangkalan data yang dipercayai sebelum meneruskan .

Tetapi sila ambil perhatian bahawa jika anda melakukan ini, ini bermakna anda telah mencantumkan "pemikiran" tambahan khusus pada LLM. Dan terdapat sejumlah besar keadaan istimewa yang perlu diambil kira. Pada ketika ini, jurutera manusia tahu dari mana kebenaran datang, tetapi LLM tidak tahu.

Tambahan pula, apabila jurutera menggabungkan semakin banyak pembaikan ini, semakin jelas bahawa LLM bukanlah satu bentuk kecerdasan am buatan.

Walau apa pun kecerdasan manusia, kita semua tahu bahawa ia lebih daripada sekadar kebolehan mengomel.

Mengapa manusia bercakap antara satu sama lain, atau menulis perkara untuk satu sama lain?

Salah satu tujuannya adalah untuk menyampaikan maklumat fakta secara langsung, seperti "Saya berada di kedai", "Ia tidak dipalamkan", dsb., tetapi ini jauh dari satu-satunya sebab mengapa kita menggunakan bahasa:

…

Anda boleh tahu, Tujuan komunikasi manusia sangat pelbagai. Selain itu, kami biasanya tidak menunjukkan tujuan apa yang kami tulis, dan pengarang dan pembaca mempunyai persepsi yang berbeza tentang peranan kandungan ini.

Jika ChatGPT ingin menjadi penyebar fakta yang boleh dipercayai, ia mungkin perlu belajar cara membezakan antara pelbagai tujuan penulisan manusia yang telah dilatih untuk dilakukan.

Iaitu, ia perlu belajar untuk tidak mengambil serius tentang omong kosong, untuk membezakan pujukan dan propaganda daripada analisis objektif, untuk menilai secara bebas kredibiliti sumber berbanding popularitinya, dsb. tunggu.

Ini adalah helah yang sangat sukar walaupun untuk manusia. Kajian telah menunjukkan bahawa maklumat palsu tersebar di Twitter berkali-kali lebih pantas daripada maklumat yang tepat - selalunya lebih menghasut, menghiburkan atau kelihatan seperti novel.

Jadi persoalannya, mengapa AI generatif berfungsi dengan baik pada kod komputer? Mengapakah ketepatan dalam menulis kod berfungsi tidak diterjemahkan kepada ketepatan dalam menyampaikan fakta?

Jawapan yang mungkin untuk ini ialah kod komputer berfungsi, bukan komunikatif. Menulis sekeping kod dengan tatabahasa yang betul akan melaksanakan beberapa tugas secara automatik, manakala menulis ayat dengan tatabahasa yang betul tidak semestinya akan mencapai apa-apa.

Selain itu, adalah mudah untuk mengehadkan korpus latihan kod komputer kepada kod "baik", iaitu kod yang melaksanakan tujuan yang dimaksudkan dengan sempurna. Sebaliknya, hampir mustahil untuk menghasilkan korpus teks yang berjaya memenuhi tujuannya.

Oleh itu, untuk melatih dirinya menjadi penyebar fakta yang boleh dipercayai, LLLM mesti menyelesaikan tugas yang jauh lebih sukar daripada melatih dirinya untuk menghasilkan kod komputer yang berfungsi.

Walaupun saya tidak tahu betapa sukarnya jurutera membina LLM yang boleh membezakan fakta daripada karut, ia adalah tugas yang sukar walaupun untuk manusia.

Marcus: Rekonsiliasi Abad Ini

Siri kenyataan LeCun membuatkan semua orang tertanya-tanya: Bukankah ini yang akan dikatakan oleh Marcus?

Hangat (chi) kasih sayang (gua) netizen mempunyai @Marcus, menantikan jawapan tajamnya terhadap perkara ini Komen .

Marcus, yang telah lama menderita GPT, sememangnya sangat gembira dan segera memajukan siaran LeCun dan mengulas "100 pengsan" ".

Marcus juga menyiarkan di blognya, menyemak "hubungan cinta-benci"nya dengan LeCun.

Marcus berkata bahawa dia dan LeCun telah berkawan selama bertahun-tahun, dan mereka menjadi tertarik antara satu sama lain kerana beberapa perkataan tentang Galactica.

Sebenarnya, Marcus dan LeCun telah berperang antara satu sama lain selama beberapa tahun, dan ia bukan hanya kerana Galactica pergi ke luar talian.

Berbeza dengan profil rendah dua pemenang Anugerah Turing yang lain, Bengio dan Hinton, sejak beberapa tahun kebelakangan ini, LeCun juga terkenal dalam kalangan AI kerana aktif di media sosial . Banyak pekerjaan telah dipromosikan di Twitter sebaik sahaja mereka gagal Arxiv.

Marcus, yang juga berprofil tinggi, sentiasa menganggap Twitter sebagai gelanggang rumahnya Apabila publisiti LeCun bercanggah dengan pandangan Marcus, tidak ada pihak yang berhasrat untuk menahan diri.

Di media sosial, boleh dikatakan mereka berdua sudah sampai ke tahap bergaduh setiap kali bergaduh Mereka bercakap kasar antara satu sama lain hingga boleh mula untuk bergaduh sesama sendiri apabila bertemu.

Dan bercakap tentang Liang Zi, selepas LeCun, Hinton dan Bengio memenangi Anugerah Turing pada 2019, terdapat foto berkumpulan di mana Marcus pada asalnya berdiri di sebelah LeCun, tetapi selepas LeCun berkongsi Dalam foto itu, Marcus telah dipotong dengan kejam.

Namun, kelahiran ChatGPT mengubah segala-galanya.

CtGPT menjadi viral, dan Galactica telah dikeluarkan dari pasaran tiga hari kemudian. Marcus sememangnya gembira melihat hasil gila LeCun menentang LLM.

Bak kata pepatah, musuh musuh saya adalah kawan saya sama ada teguran LeCun adalah pendedahan selepas kegagalan produknya sendiri, atau dia cemburu dengan keadaan semasa atasan. -produk berdaya saing, Marcus bersedia untuk menambahnya.

Marcus percaya dia dan LeCun bersetuju dengan lebih daripada gembar-gembur dan batasan LLM. Mereka berdua berpendapat Cicero patut diberi perhatian lebih.

Akhir sekali, Marcus @ orang yang memahami segala-galanya dan berkata, "Sudah tiba masanya untuk memberi kebajikan kepada keluarga."

Boleh dikatakan perang memarahi yang dimulakan oleh LeCun di Twitter bukan sahaja menjadikan tentera Marcus anti-GPT lebih Dia mendapat seorang jeneral yang kuat dan memberi peluang kepada dua orang itu untuk berjabat tangan dan berdamai.

Melihat dengan cara ini, mungkin Marcus adalah pemenang utama.

Atas ialah kandungan terperinci ChatGPT menjadi viral, mentaliti LeCun runtuh! Menyebut model bahasa besar sebagai jalan jahat, model Meta telah dibawa ke luar talian dalam masa 3 hari. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Perbezaan antara vue2 dan vue3 pengikatan dua hala

Perbezaan antara vue2 dan vue3 pengikatan dua hala

Terdapat beberapa cara untuk meletakkan kedudukan CSS

Terdapat beberapa cara untuk meletakkan kedudukan CSS

Apakah perbezaan antara mesin demo dan mesin sebenar?

Apakah perbezaan antara mesin demo dan mesin sebenar?

Apakah perisian sandaran data?

Apakah perisian sandaran data?

Apakah masalah yang boleh diselesaikan oleh acara js yang menggelegak?

Apakah masalah yang boleh diselesaikan oleh acara js yang menggelegak?

menukar penggunaan arahan

menukar penggunaan arahan

Bagaimana untuk menetapkan status luar talian pada Douyin

Bagaimana untuk menetapkan status luar talian pada Douyin

Bagaimana untuk menyelesaikan ralat parameter cakera

Bagaimana untuk menyelesaikan ralat parameter cakera