Peranti teknologi

Peranti teknologi

AI

AI

Model sumber terbuka, latihan kad tunggal, membawa anda memahami teknologi penjanaan audio berpandukan teks yang popular, AudioLDM

Model sumber terbuka, latihan kad tunggal, membawa anda memahami teknologi penjanaan audio berpandukan teks yang popular, AudioLDM

Model sumber terbuka, latihan kad tunggal, membawa anda memahami teknologi penjanaan audio berpandukan teks yang popular, AudioLDM

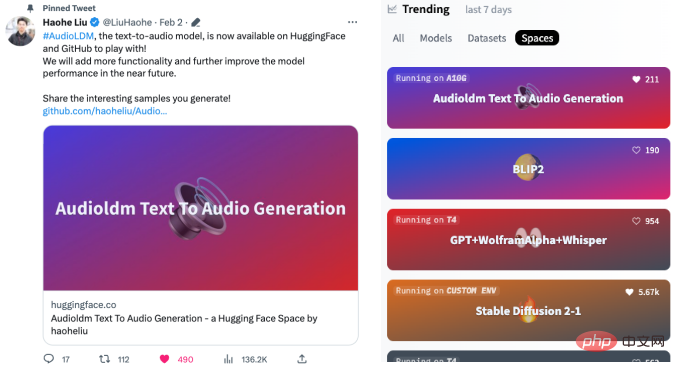

Memandangkan sekeping teks, kecerdasan buatan boleh menjana muzik, suara, pelbagai kesan bunyi, dan juga bunyi khayalan, seperti lubang hitam dan senjata laser. AudioLDM, baru-baru ini dilancarkan secara bersama oleh University of Surrey dan Imperial College London, dengan cepat menjadi popular di luar negara selepas dikeluarkan Ia menerima hampir 300 tweet semula dan 1,500 suka di Twitter dalam masa seminggu. Pada hari kedua selepas model sumber terbuka, AudioLDM bergegas ke bahagian atas senarai carian hangat Memeluk Wajah, dan dalam masa seminggu memasuki senarai 40 aplikasi paling popular Memeluk Wajah (kira-kira 25,000 kesemuanya), dan dengan cepat muncul dalam banyak Kerja terbitan berdasarkan AudioLDM.

Model AudioLDM mempunyai sorotan berikut:

- Model sumber terbuka pertama yang boleh menjana muzik, pertuturan dan kesan bunyi daripada teks pada masa yang sama.

- Dibangunkan oleh ahli akademik, ia menggunakan kurang data, GPU tunggal dan model yang lebih kecil untuk mencapai hasil terbaik pada masa ini.

- Mencadangkan untuk melatih model generatif dengan cara yang diselia sendiri, supaya penjanaan audio berpandukan teks tidak lagi dihadkan oleh masalah kehilangan data (teks-audio) berpasangan.

- Model boleh mencapai pemindahan gaya audio, pengisian audio yang tiada dan resolusi super audio tanpa latihan tambahan (sifar tangkapan).

- Laman utama projek: https://audioldm.github.io/

- Kertas: https://arxiv.org/abs/2301.12503

- Sumber terbuka kod dan model: https://github.com/haoheliu/AudioLDM

- Ruang Muka Memeluk: https://huggingface.co/spaces/haoheliu/audioldm - text-to-audio-generation

Pengarang mula-mula mengeluarkan pratonton model pada 27 Januari, menunjukkan teks yang sangat ringkas: " Muzik yang dibuat oleh []” (sekeping muzik yang dihasilkan oleh []) untuk menghasilkan kesan bunyi yang berbeza. Video itu, yang menunjukkan muzik yang dibuat dengan instrumen berbeza dan juga seekor nyamuk, dengan cepat mendapat tarikan di Twitter, dimainkan lebih 35.4K kali dan ditweet semula lebih 130 kali.

Pengarang kemudian mengeluarkan kertas kerja dan video baharu. Dalam video ini, pengarang menunjukkan kebanyakan keupayaan model, serta kesan bekerja dengan ChatGPT untuk menjana bunyi. AudioLDM malah boleh menjana bunyi dari angkasa lepas.

Kemudian pengarang mengeluarkan kertas, model pra-latihan, dan antara muka yang boleh dimainkan, yang mencetuskan semangat netizen Twitter dan dengan cepat muncul di Hugging Face pada hari berikutnya Tempat pertama di senarai carian hangat:

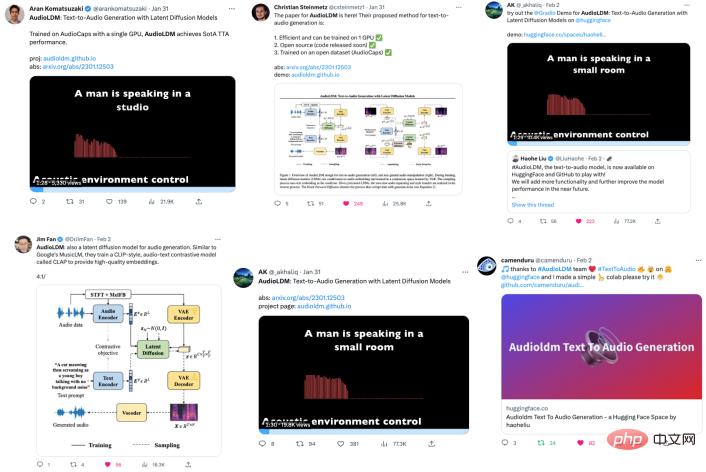

Karya ini telah mendapat perhatian meluas di Twitter, dan cendekiawan dalam industri Mentweet semula dan mengulas:

Netizen menggunakan AudioLDM untuk menjana pelbagai bunyi.

Sebagai contoh, bunyi dengkuran gadis kucing dua dimensi dijana:

Dan suara hantu:

Sesetengah netizen mensintesis: "Suara mummy, frekuensi rendah, dengan erangan yang menyakitkan."

Malah ada netizen yang mensintesis: "bunyi kentut melodi".

Saya terpaksa meratapi khayalan netizen yang kaya.

Sesetengah netizen menggunakan AudioLDM secara langsung untuk menjana satu siri album muzik dalam pelbagai gaya, termasuk jazz, funk, elektronik dan klasik. Sesetengah muzik agak inventif.

Contohnya, "Buat muzik ambien dengan tema alam semesta dan bulan":

Dan "Buat muzik menggunakan bunyi masa hadapan":

Pembaca yang berminat boleh melayari laman web album muzik ini: https://www.latent.store/albums

Sesetengah netizen juga menggunakan imaginasi mereka untuk mencipta gambar dengan menggabungkan imej -model teks yang dihasilkan dan Aplikasi AudioLDM yang membimbing penjanaan kesan bunyi.

Contohnya, jika anda memberikan AudioLDM teks ini: "Anjing berlari di dalam air dengan frisbee" (anjing berlari di dalam air dengan frisbee di mulutnya):

boleh menjana bunyi berikut seperti anjing menampar air.

Anda juga boleh memulihkan bunyi dalam foto lama, seperti gambar di bawah:

Selepas memperoleh teks "Seorang lelaki dan seorang wanita duduk di bar" (seorang lelaki dan seorang wanita duduk di bar), model boleh menjana bunyi berikut, di mana anda boleh mendengar suara samar-samar dan perlanggaran gelas wain dalam bunyi latar belakang.

Sesetengah netizen menggunakan AudioLDM untuk menjana bunyi anjing yang menyala, yang sangat menarik.

Pengarang juga menghasilkan video untuk menunjukkan keupayaan model menjana kesan bunyi, menunjukkan betapa hampirnya sampel yang dijana AudioLDM dengan perpustakaan kesan bunyi.

Malah, penjanaan audio teks hanyalah sebahagian daripada keupayaan AudioLDM AudioLDM juga boleh mencapai penukaran timbre, tiada pengisian dan resolusi super.

Dua gambar di bawah menunjukkan penukaran timbre daripada (1) perkusi kepada muzik ambien dan (2) trompet kepada nyanyian kanak-kanak.

Di bawah ialah perkusi kepada muzik ambien ( Berperingkat intensiti peralihan) kesan.

Kesan menukar bunyi trompet kepada bunyi kanak-kanak menyanyi (intensiti penukaran beransur-ansur).

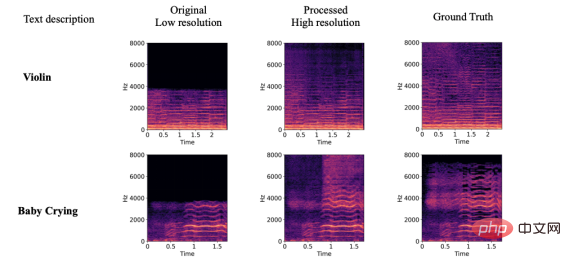

Di bawah ini kami akan menunjukkan kesan model pada resolusi super audio, pengisian hilang audio dan kawalan bahan bunyi. Oleh kerana panjang artikel yang terhad, audio dipaparkan terutamanya dalam bentuk spektrogram Pembaca yang berminat sila pergi ke laman utama projek AudioLDM: https://audioldm.github.io/

Dari segi resolusi super audio, AudioLDM juga sangat berkesan Berbanding dengan model resolusi super sebelumnya, AudioLDM ialah model resolusi super universal dan tidak terhad kepada pemprosesan muzik dan pertuturan.

Pada pengisian audio yang tiada, AudioLDM boleh mengisi kandungan audio yang berbeza mengikut teks yang diberikan, dan dalam Peralihan di sempadannya agak semula jadi.

Selain itu, AudioLDM juga menunjukkan keupayaan kawalan yang kuat, seperti persekitaran akustik, mood dan kelajuan muzik, bahan objek, pic dan jujukan pic, dll. Untuk keupayaan kawalan, pembaca yang berminat boleh menyemak keluar kertas atau halaman utama projek AudioLDM.

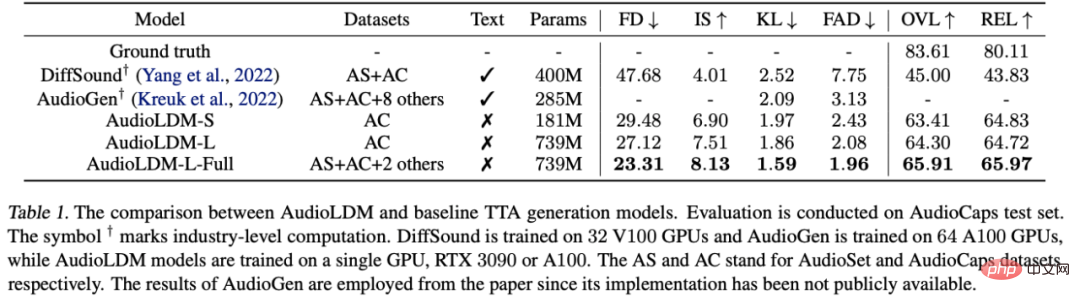

Dalam artikel itu, penulis membuat penilaian skor subjektif dan indeks objektif model AudioLDM, dan keputusan menunjukkan bahawa ia boleh melebihi model optimum sebelumnya dengan ketara:

Antaranya, AudioGen ialah model yang dicadangkan oleh Facebook pada Oktober 2022, menggunakan sepuluh set data, 64 GPU dan 285 MB parameter. Sebagai perbandingan, AudioLDM-S boleh mencapai hasil yang lebih baik dengan set data tunggal, 1 GPU dan 181 MB parameter.

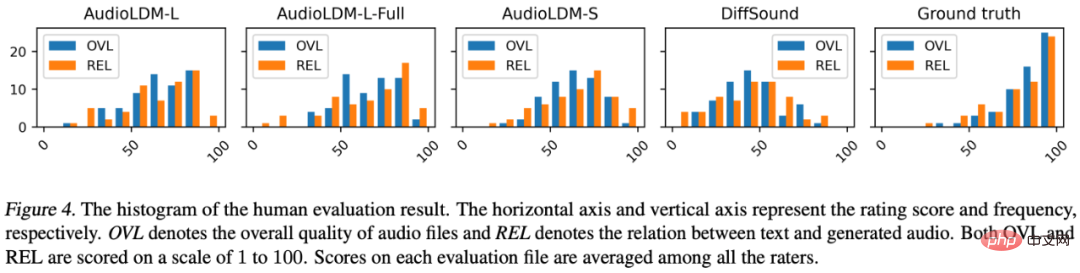

Pemarkahan subjektif juga menunjukkan bahawa AudioLDM jauh lebih baik daripada penyelesaian sebelumnya DiffSound. Jadi, apakah penambahbaikan yang telah dilakukan oleh AudioLDM untuk menjadikan model tersebut mempunyai prestasi yang begitu cemerlang?

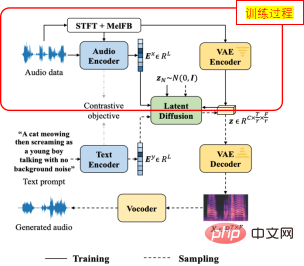

Pertama sekali, untuk menyelesaikan masalah pasangan data teks-audio yang terlalu sedikit, penulis mencadangkan kaedah penyeliaan sendiri untuk melatih AudioLDM.

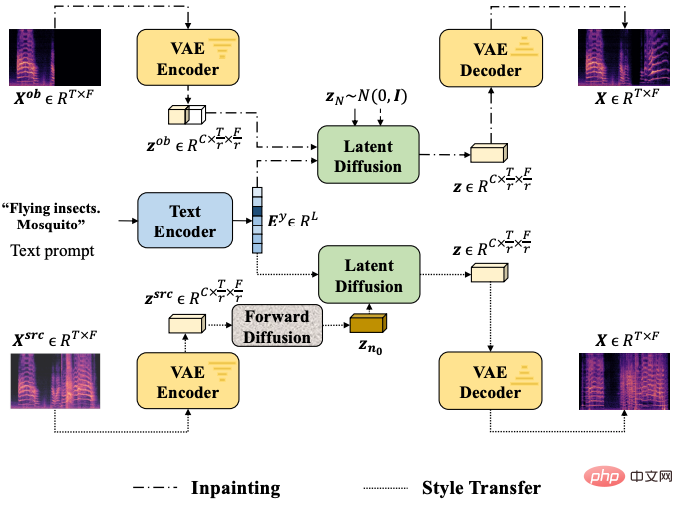

Khususnya, apabila melatih modul teras LDM, penulis menggunakan pembenaman audio itu sendiri sebagai syarat LDMs, keseluruhan proses tidak melibatkan penggunaan teks (seperti yang ditunjukkan dalam imej di atas). Skim ini adalah berdasarkan sepasang pengekod pembelajaran kontrastif teks audio yang telah dilatih (CLAP), yang telah menunjukkan keupayaan generalisasi yang baik dalam teks CLAP asal. AudioLDM mengambil kesempatan daripada keupayaan generalisasi yang sangat baik CLAP untuk mencapai latihan model pada data audio berskala besar tanpa memerlukan label teks.

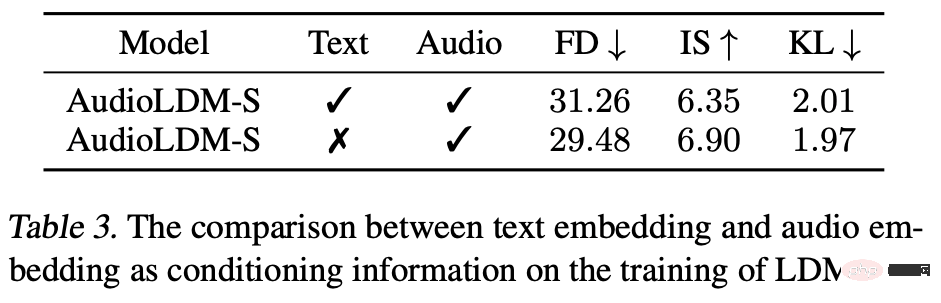

Malah, pengarang mendapati bahawa latihan dengan audio sahaja adalah lebih baik daripada menggunakan pasangan data teks audio:

Pengarang menganalisis dua sebab: (1) Anotasi teks itu sendiri sukar untuk memasukkan semua maklumat audio, seperti persekitaran akustik, taburan frekuensi, dll., mengakibatkan pembenaman teks tidak dapat mewakili audio dengan baik, ( 2) Kualiti teks itu sendiri tidak sempurna Contohnya, anotasi seperti "Boats: Battleships-5.25 conveyor space" adalah sukar bagi manusia untuk membayangkan bunyi tertentu. adalah, yang akan menyebabkan masalah dalam latihan model. Sebaliknya, menggunakan audio itu sendiri sebagai keadaan LDM boleh memastikan korelasi yang kukuh antara audio sasaran dan keadaan, dengan itu mencapai hasil penjanaan yang lebih baik.

Selain itu, penyelesaian Latent Diffusion yang diterima pakai oleh pengarang membolehkan model Diffusion dikira dalam ruang yang lebih kecil, sekali gus mengurangkan keperluan kuasa pengiraan model.

Banyak penerokaan terperinci dalam latihan dan struktur model turut membantu AudioLDM mencapai prestasi cemerlang.

Pengarang juga melukis gambar rajah struktur ringkas untuk memperkenalkan dua tugas hiliran utama:

Pengarang juga menjalankan eksperimen terperinci dengan struktur model yang berbeza, saiz model, langkah pensampelan DDIM dan Skala Bimbingan tanpa Pengelas yang berbeza.

Semasa mendedahkan model, penulis juga mendedahkan asas kod sistem penilaian model generatif mereka untuk menyatukan kaedah penilaian komuniti akademik mengenai isu tersebut pada masa hadapan, dengan itu memudahkan penerbitan daripada kertas kerja. Pasukan pengarang berkata ia akan Hadkan penggunaan model, terutamanya penggunaan komersial, untuk memastikan model hanya digunakan untuk komunikasi akademik, dan menggunakan LESEN dan perlindungan tera air yang sesuai untuk mengelakkan masalah etika.

Maklumat pengarang

Kertas ini mempunyai dua pengarang bersama: Liu Haohe (University of Surrey, UK) dan Chen Zehua (Imperial College London, UK).

Chen Zehua ialah pelajar kedoktoran di Imperial College London, belajar di bawah Profesor Danilo Mandic Beliau telah berkhidmat di Microsoft Speech Synthesis Research Group dan JD Artificial Intelligence Laboratory. Minat penyelidikannya termasuk model Generatif, sintesis pertuturan, penjanaan isyarat bioelektrik.

Atas ialah kandungan terperinci Model sumber terbuka, latihan kad tunggal, membawa anda memahami teknologi penjanaan audio berpandukan teks yang popular, AudioLDM. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1376

1376

52

52

Model MoE sumber terbuka paling berkuasa di dunia ada di sini, dengan keupayaan bahasa Cina setanding dengan GPT-4, dan harganya hanya hampir satu peratus daripada GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Model MoE sumber terbuka paling berkuasa di dunia ada di sini, dengan keupayaan bahasa Cina setanding dengan GPT-4, dan harganya hanya hampir satu peratus daripada GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Bayangkan model kecerdasan buatan yang bukan sahaja mempunyai keupayaan untuk mengatasi pengkomputeran tradisional, tetapi juga mencapai prestasi yang lebih cekap pada kos yang lebih rendah. Ini bukan fiksyen sains, DeepSeek-V2[1], model MoE sumber terbuka paling berkuasa di dunia ada di sini. DeepSeek-V2 ialah gabungan model bahasa pakar (MoE) yang berkuasa dengan ciri-ciri latihan ekonomi dan inferens yang cekap. Ia terdiri daripada 236B parameter, 21B daripadanya digunakan untuk mengaktifkan setiap penanda. Berbanding dengan DeepSeek67B, DeepSeek-V2 mempunyai prestasi yang lebih kukuh, sambil menjimatkan 42.5% kos latihan, mengurangkan cache KV sebanyak 93.3% dan meningkatkan daya pemprosesan penjanaan maksimum kepada 5.76 kali. DeepSeek ialah sebuah syarikat yang meneroka kecerdasan buatan am

Hello, Atlas elektrik! Robot Boston Dynamics hidup semula, gerakan pelik 180 darjah menakutkan Musk

Apr 18, 2024 pm 07:58 PM

Hello, Atlas elektrik! Robot Boston Dynamics hidup semula, gerakan pelik 180 darjah menakutkan Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas secara rasmi memasuki era robot elektrik! Semalam, Atlas hidraulik hanya "menangis" menarik diri daripada peringkat sejarah Hari ini, Boston Dynamics mengumumkan bahawa Atlas elektrik sedang berfungsi. Nampaknya dalam bidang robot humanoid komersial, Boston Dynamics berazam untuk bersaing dengan Tesla. Selepas video baharu itu dikeluarkan, ia telah pun ditonton oleh lebih sejuta orang dalam masa sepuluh jam sahaja. Orang lama pergi dan peranan baru muncul. Ini adalah keperluan sejarah. Tidak dinafikan bahawa tahun ini adalah tahun letupan robot humanoid. Netizen mengulas: Kemajuan robot telah menjadikan majlis pembukaan tahun ini kelihatan seperti manusia, dan tahap kebebasan adalah jauh lebih besar daripada manusia Tetapi adakah ini benar-benar bukan filem seram? Pada permulaan video, Atlas berbaring dengan tenang di atas tanah, seolah-olah terlentang. Apa yang berikut adalah rahang-jatuh

KAN, yang menggantikan MLP, telah diperluaskan kepada konvolusi oleh projek sumber terbuka

Jun 01, 2024 pm 10:03 PM

KAN, yang menggantikan MLP, telah diperluaskan kepada konvolusi oleh projek sumber terbuka

Jun 01, 2024 pm 10:03 PM

Awal bulan ini, penyelidik dari MIT dan institusi lain mencadangkan alternatif yang sangat menjanjikan kepada MLP - KAN. KAN mengatasi MLP dari segi ketepatan dan kebolehtafsiran. Dan ia boleh mengatasi prestasi MLP berjalan dengan bilangan parameter yang lebih besar dengan bilangan parameter yang sangat kecil. Sebagai contoh, penulis menyatakan bahawa mereka menggunakan KAN untuk menghasilkan semula keputusan DeepMind dengan rangkaian yang lebih kecil dan tahap automasi yang lebih tinggi. Khususnya, MLP DeepMind mempunyai kira-kira 300,000 parameter, manakala KAN hanya mempunyai kira-kira 200 parameter. KAN mempunyai asas matematik yang kukuh seperti MLP berdasarkan teorem penghampiran universal, manakala KAN berdasarkan teorem perwakilan Kolmogorov-Arnold. Seperti yang ditunjukkan dalam rajah di bawah, KAN telah

Apr 09, 2024 am 11:52 AM

Apr 09, 2024 am 11:52 AM

AI memang mengubah matematik. Baru-baru ini, Tao Zhexuan, yang telah mengambil perhatian terhadap isu ini, telah memajukan keluaran terbaru "Buletin Persatuan Matematik Amerika" (Buletin Persatuan Matematik Amerika). Memfokuskan pada topik "Adakah mesin akan mengubah matematik?", ramai ahli matematik menyatakan pendapat mereka Seluruh proses itu penuh dengan percikan api, tegar dan menarik. Penulis mempunyai barisan yang kuat, termasuk pemenang Fields Medal Akshay Venkatesh, ahli matematik China Zheng Lejun, saintis komputer NYU Ernest Davis dan ramai lagi sarjana terkenal dalam industri. Dunia AI telah berubah secara mendadak Anda tahu, banyak artikel ini telah dihantar setahun yang lalu.

Google gembira: prestasi JAX mengatasi Pytorch dan TensorFlow! Ia mungkin menjadi pilihan terpantas untuk latihan inferens GPU

Apr 01, 2024 pm 07:46 PM

Google gembira: prestasi JAX mengatasi Pytorch dan TensorFlow! Ia mungkin menjadi pilihan terpantas untuk latihan inferens GPU

Apr 01, 2024 pm 07:46 PM

Prestasi JAX, yang dipromosikan oleh Google, telah mengatasi Pytorch dan TensorFlow dalam ujian penanda aras baru-baru ini, menduduki tempat pertama dalam 7 penunjuk. Dan ujian tidak dilakukan pada TPU dengan prestasi JAX terbaik. Walaupun dalam kalangan pembangun, Pytorch masih lebih popular daripada Tensorflow. Tetapi pada masa hadapan, mungkin lebih banyak model besar akan dilatih dan dijalankan berdasarkan platform JAX. Model Baru-baru ini, pasukan Keras menanda aras tiga hujung belakang (TensorFlow, JAX, PyTorch) dengan pelaksanaan PyTorch asli dan Keras2 dengan TensorFlow. Pertama, mereka memilih satu set arus perdana

Disyorkan: Projek pengesanan dan pengecaman muka sumber terbuka JS yang sangat baik

Apr 03, 2024 am 11:55 AM

Disyorkan: Projek pengesanan dan pengecaman muka sumber terbuka JS yang sangat baik

Apr 03, 2024 am 11:55 AM

Teknologi pengesanan dan pengecaman muka adalah teknologi yang agak matang dan digunakan secara meluas. Pada masa ini, bahasa aplikasi Internet yang paling banyak digunakan ialah JS Melaksanakan pengesanan muka dan pengecaman pada bahagian hadapan Web mempunyai kelebihan dan kekurangan berbanding dengan pengecaman muka bahagian belakang. Kelebihan termasuk mengurangkan interaksi rangkaian dan pengecaman masa nyata, yang sangat memendekkan masa menunggu pengguna dan meningkatkan pengalaman pengguna termasuk: terhad oleh saiz model, ketepatannya juga terhad. Bagaimana untuk menggunakan js untuk melaksanakan pengesanan muka di web? Untuk melaksanakan pengecaman muka di Web, anda perlu biasa dengan bahasa dan teknologi pengaturcaraan yang berkaitan, seperti JavaScript, HTML, CSS, WebRTC, dll. Pada masa yang sama, anda juga perlu menguasai visi komputer yang berkaitan dan teknologi kecerdasan buatan. Perlu diingat bahawa kerana reka bentuk bahagian Web

Dokumen berbilang modal Alibaba 7B memahami model besar memenangi SOTA baharu

Apr 02, 2024 am 11:31 AM

Dokumen berbilang modal Alibaba 7B memahami model besar memenangi SOTA baharu

Apr 02, 2024 am 11:31 AM

SOTA baharu untuk keupayaan memahami dokumen multimodal! Pasukan Alibaba mPLUG mengeluarkan kerja sumber terbuka terkini mPLUG-DocOwl1.5, yang mencadangkan satu siri penyelesaian untuk menangani empat cabaran utama pengecaman teks imej resolusi tinggi, pemahaman struktur dokumen am, arahan mengikut dan pengenalan pengetahuan luaran. Tanpa berlengah lagi, mari kita lihat kesannya dahulu. Pengecaman satu klik dan penukaran carta dengan struktur kompleks ke dalam format Markdown: Carta gaya berbeza tersedia: Pengecaman dan kedudukan teks yang lebih terperinci juga boleh dikendalikan dengan mudah: Penjelasan terperinci tentang pemahaman dokumen juga boleh diberikan: Anda tahu, "Pemahaman Dokumen " pada masa ini Senario penting untuk pelaksanaan model bahasa yang besar. Terdapat banyak produk di pasaran untuk membantu pembacaan dokumen. Sesetengah daripada mereka menggunakan sistem OCR untuk pengecaman teks dan bekerjasama dengan LLM untuk pemprosesan teks.

Robot Tesla bekerja di kilang, Musk: Tahap kebebasan tangan akan mencapai 22 tahun ini!

May 06, 2024 pm 04:13 PM

Robot Tesla bekerja di kilang, Musk: Tahap kebebasan tangan akan mencapai 22 tahun ini!

May 06, 2024 pm 04:13 PM

Video terbaru robot Tesla Optimus dikeluarkan, dan ia sudah boleh berfungsi di kilang. Pada kelajuan biasa, ia mengisih bateri (bateri 4680 Tesla) seperti ini: Pegawai itu juga mengeluarkan rupanya pada kelajuan 20x - pada "stesen kerja" kecil, memilih dan memilih dan memilih: Kali ini ia dikeluarkan Salah satu sorotan video itu ialah Optimus menyelesaikan kerja ini di kilang, sepenuhnya secara autonomi, tanpa campur tangan manusia sepanjang proses. Dan dari perspektif Optimus, ia juga boleh mengambil dan meletakkan bateri yang bengkok, memfokuskan pada pembetulan ralat automatik: Berkenaan tangan Optimus, saintis NVIDIA Jim Fan memberikan penilaian yang tinggi: Tangan Optimus adalah robot lima jari di dunia paling cerdik. Tangannya bukan sahaja boleh disentuh