Peranti teknologi

Peranti teknologi

AI

AI

Berapakah potensi model parameter tetap? Cina Hong Kong, Shanghai AI Lab dan lain-lain mencadangkan rangka kerja pemahaman video yang cekap EVL

Berapakah potensi model parameter tetap? Cina Hong Kong, Shanghai AI Lab dan lain-lain mencadangkan rangka kerja pemahaman video yang cekap EVL

Berapakah potensi model parameter tetap? Cina Hong Kong, Shanghai AI Lab dan lain-lain mencadangkan rangka kerja pemahaman video yang cekap EVL

Model asas visual telah mencapai perkembangan yang luar biasa dalam tempoh dua tahun yang lalu. Di satu pihak, pra-latihan berdasarkan data Internet berskala besar telah menetapkan sejumlah besar konsep semantik untuk model, dengan itu mempunyai prestasi generalisasi yang baik tetapi sebaliknya, untuk menggunakan sepenuhnya saiz model yang dibawa; oleh set data berskala besar Pertumbuhan menjadikan model berkaitan menghadapi masalah ketidakcekapan apabila berhijrah ke tugas hiliran, terutamanya untuk model pemahaman video yang perlu memproses berbilang bingkai.

- Pautan kertas: https://arxiv.org/abs/2208.03550

- Pautan kod: https://github.com/OpenGVLab/efficient-video-recognition

Berdasarkan dua di atas ciri , penyelidik dari Universiti China Hong Kong, Makmal Kepintaran Buatan Shanghai dan institusi lain mencadangkan rangka kerja pembelajaran pemindahan pemahaman video yang cekap Dengan menetapkan berat model asas tulang belakang, ia menjimatkan pengiraan latihan dan penggunaan memori pada masa yang sama , dengan menggunakan ciri perantaraan berbilang peringkat, berbutir halus mengekalkan fleksibiliti penalaan halus hujung ke hujung tradisional sebanyak mungkin.

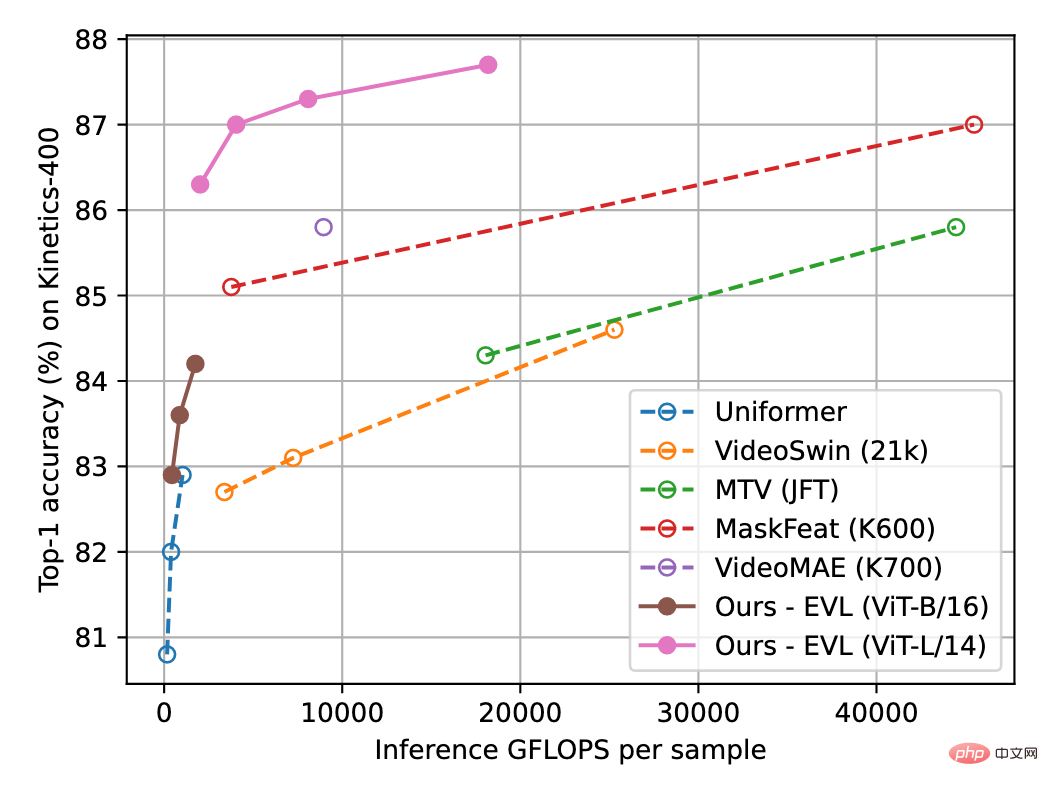

Rajah 1 di bawah menunjukkan keputusan kaedah EVL pada set data pemahaman video Kinetics-400. Eksperimen menunjukkan bahawa semasa menjimatkan overhed latihan, kaedah ini masih meneroka sepenuhnya potensi model visual asas dalam tugas pemahaman video.

Rajah 1: Perbandingan ketepatan pengecaman Kinetik-400 Paksi mendatar ialah jumlah pengiraan inferens dan paksi menegak ialah ketepatan.

Kaedah

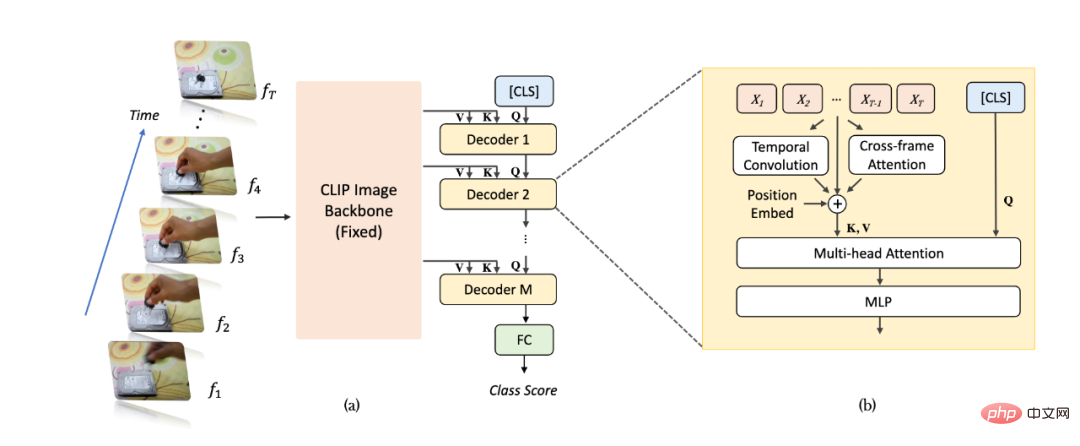

Rajah skematik keseluruhan algoritma ditunjukkan dalam Rajah 2(a). Untuk sampel video, kami mengambil bingkai T dan memasukkannya ke dalam rangkaian pengecaman imej (mengambil CLIP sebagai contoh) dan mengekstrak ciri. Berbanding dengan kaedah tradisional, kami mengekstrak ciri berbilang lapisan yang tidak disatukan daripada beberapa lapisan terakhir rangkaian pengecaman imej untuk mendapatkan maklumat imej yang lebih kaya dan lebih halus dan berat parameter rangkaian pengecaman imej sentiasa konsisten dalam pembelajaran video tetap. Selepas itu, peta ciri berbilang lapisan dimasukkan secara berurutan ke dalam penyahkod Transformer untuk pengagregatan maklumat peringkat video. Ciri [CLS] penyahkod berbilang lapisan digunakan untuk menjana ramalan pengelasan akhir.

Seperti yang ditunjukkan dalam Rajah 2(b), disebabkan gangguan apabila penyahkod Transformer mengagregat ciri, kami menambah modul pemodelan maklumat temporal tambahan pada rangkaian untuk mengekstrak halus berkaitan lokasi dengan lebih baik- maklumat masa berbutir. Khususnya, kami menambah tiga jenis maklumat pemasaan berkaitan kedudukan tambahan: yang pertama ialah benam kedudukan temporal (Pembenaman Kedudukan), yang kedua ialah lilitan boleh dipisahkan dalam dimensi temporal (Depthwise Convolution), dan yang ketiga ialah perhatian antara bingkai bersebelahan memaksa maklumat. Untuk maklumat perhatian antara bingkai, kami mengekstrak ciri Pertanyaan dan Utama lapisan yang sepadan daripada rangkaian pengecaman imej, dan mengira peta perhatian antara bingkai bersebelahan (berbeza daripada rangkaian pengecaman imej, peta perhatian terdiri daripada Pertanyaan daripada bingkai yang sama dan ciri utama diperolehi). Peta perhatian yang terhasil boleh menggambarkan secara eksplisit perubahan kedudukan objek antara bingkai bersebelahan. Selepas unjuran linear, peta perhatian memperoleh kumpulan vektor yang mencerminkan ciri anjakan objek, dan disepadukan ke dalam ciri imej dalam bentuk penambahan unsur demi unsur.

Rajah 2: Gambar rajah struktur algoritma EVL. (a) Struktur keseluruhan, (b) Modul pemodelan maklumat berjujukan. Rajah 3: Perhatian antara bingkai menampilkan ungkapan matematik.

Eksperimen

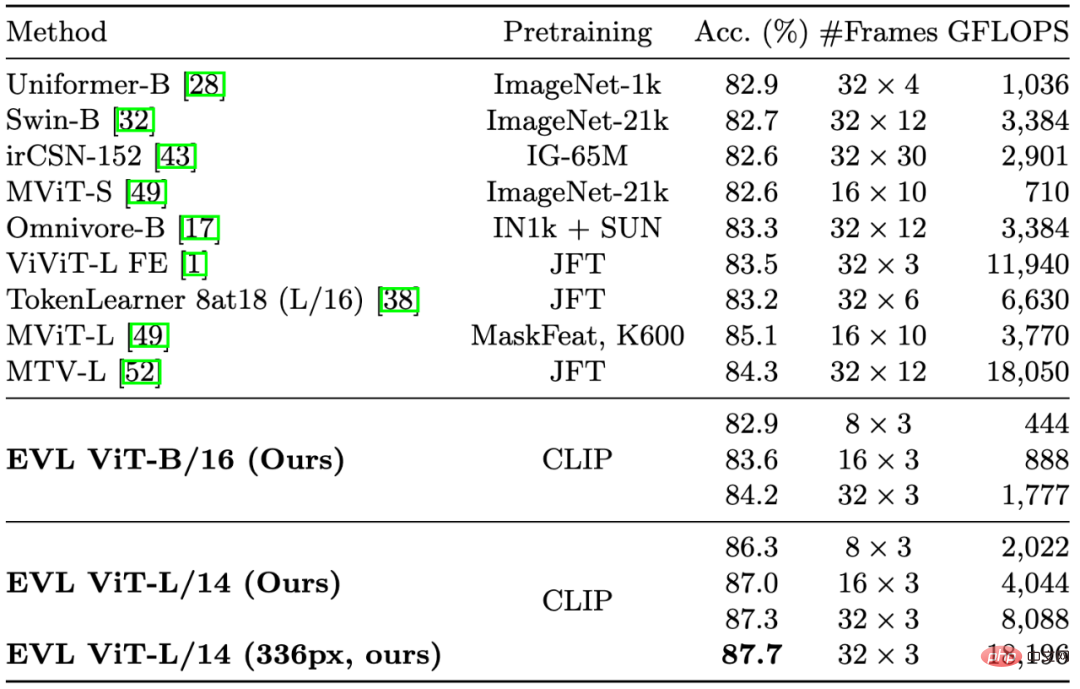

Dalam Rajah 1 dan Jadual 1, kami memetik beberapa kaedah penting dalam pemahaman video sebelumnya. Walaupun memberi tumpuan kepada mengurangkan overhed latihan, kaedah kami masih mengatasi kaedah sedia ada dari segi ketepatan (dengan jumlah pengiraan yang sama).

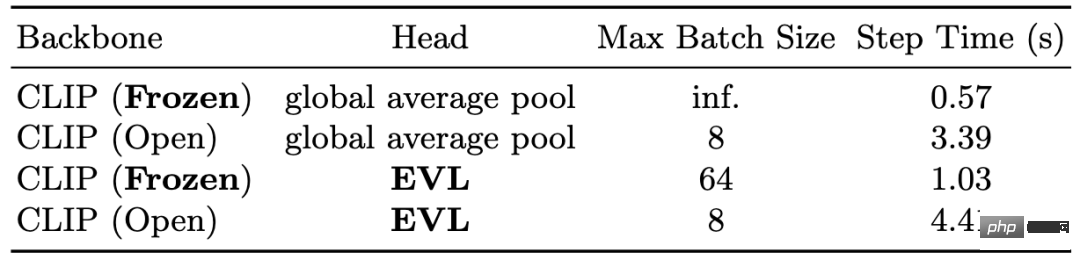

Dalam Jadual 2 kami menunjukkan pengurangan overhed latihan yang dibawa oleh rangkaian tulang belakang tetap. Dari segi memori, pada GPU V100 16GB, rangkaian tulang belakang tetap boleh membolehkan saiz kumpulan kad tunggal mencapai maksimum 64, manakala latihan hujung ke hujung hanya boleh mencapai 8 dari segi masa, tulang belakang tetap rangkaian boleh menjimatkan 3 hingga 4 kali masa latihan.

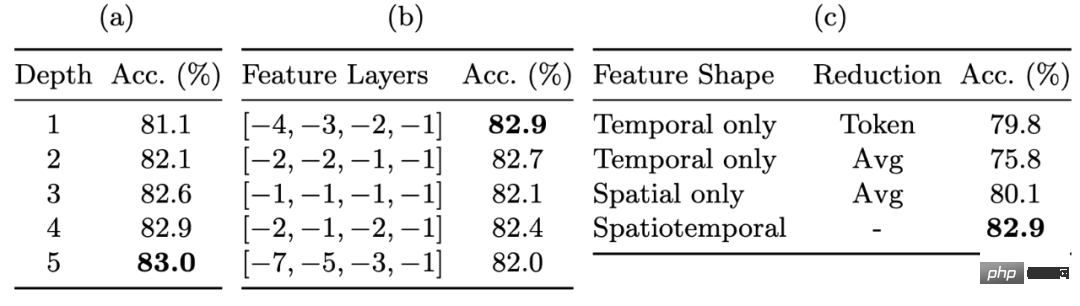

Dalam Jadual 3 kami menunjukkan peningkatan prestasi pengecaman oleh peta ciri berbutir halus. Ciri-ciri tidak terkumpul berbilang lapisan membolehkan kami mengekalkan tahap fleksibiliti yang cukup apabila membetulkan berat rangkaian tulang belakang. Menggunakan ciri yang tidak disatukan membawa peningkatan yang paling ketara (kira-kira 3%), diikuti dengan menggunakan penyahkod berbilang lapisan dan ciri lapisan pertengahan, yang juga membawa kira-kira 1% peningkatan prestasi setiap satu.

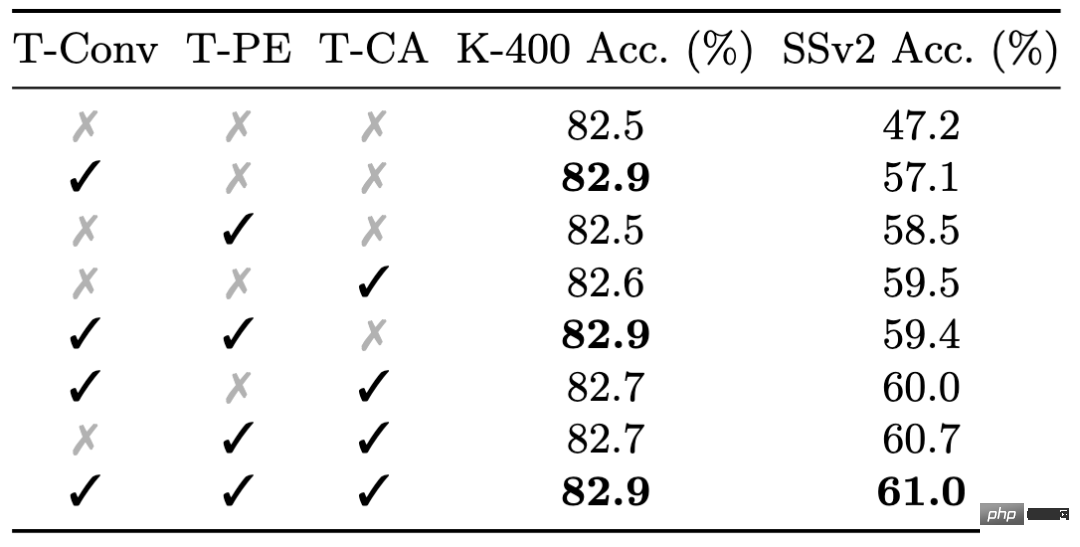

Akhir sekali kami menunjukkan kesan modul maklumat pemasaan yang terperinci dalam Jadual 4. Walaupun maklumat pemasaan yang terperinci mempunyai kesan terhad pada prestasi Kinetics-400, ia sangat penting untuk prestasi Something-Something-v2: tiga modul maklumat pemasaan yang terperinci membawa jumlah kira-kira 0.5% dan kira-kira 14 % peningkatan prestasi.

Jadual 1: Hasil perbandingan dengan kaedah sedia ada pada Kinetics-400

Jadual 2: Mengurangkan overhed latihan yang disebabkan oleh berat rangkaian tulang belakang tetap

Jadual 3: Kesan peta ciri berbutir halus pada ketepatan

Jadual 4: Kesan pemodelan maklumat siri masa yang terperinci pada set data yang berbeza

Ringkasan

Kertas kerja ini mencadangkan rangka kerja pembelajaran pemahaman video EVL, yang buat pertama kalinya menunjukkan potensi besar rangkaian tulang belakang imej tetap dalam masalah pemahaman video, dan juga menjadikan pemahaman video berprestasi tinggi lebih mesra kepada kumpulan penyelidik dengan pengkomputeran terhad sumber. Kami juga percaya bahawa apabila kualiti dan skala model visual asas bertambah baik, kaedah kami boleh memberikan rujukan untuk penyelidikan seterusnya tentang algoritma pembelajaran pemindahan ringan.

Atas ialah kandungan terperinci Berapakah potensi model parameter tetap? Cina Hong Kong, Shanghai AI Lab dan lain-lain mencadangkan rangka kerja pemahaman video yang cekap EVL. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1382

1382

52

52

Tiada data OpenAI diperlukan, sertai senarai model kod besar! UIUC mengeluarkan StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

Tiada data OpenAI diperlukan, sertai senarai model kod besar! UIUC mengeluarkan StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

Di barisan hadapan teknologi perisian, kumpulan UIUC Zhang Lingming, bersama penyelidik dari organisasi BigCode, baru-baru ini mengumumkan model kod besar StarCoder2-15B-Instruct. Pencapaian inovatif ini mencapai kejayaan ketara dalam tugas penjanaan kod, berjaya mengatasi CodeLlama-70B-Instruct dan mencapai bahagian atas senarai prestasi penjanaan kod. Keunikan StarCoder2-15B-Instruct terletak pada strategi penjajaran diri yang tulen Keseluruhan proses latihan adalah terbuka, telus, dan sepenuhnya autonomi dan boleh dikawal. Model ini menjana beribu-ribu arahan melalui StarCoder2-15B sebagai tindak balas kepada penalaan halus model asas StarCoder-15B tanpa bergantung pada anotasi manual yang mahal.

Yolov10: Penjelasan terperinci, penggunaan dan aplikasi semuanya di satu tempat!

Jun 07, 2024 pm 12:05 PM

Yolov10: Penjelasan terperinci, penggunaan dan aplikasi semuanya di satu tempat!

Jun 07, 2024 pm 12:05 PM

1. Pengenalan Sejak beberapa tahun kebelakangan ini, YOLO telah menjadi paradigma dominan dalam bidang pengesanan objek masa nyata kerana keseimbangannya yang berkesan antara kos pengiraan dan prestasi pengesanan. Penyelidik telah meneroka reka bentuk seni bina YOLO, matlamat pengoptimuman, strategi pengembangan data, dsb., dan telah mencapai kemajuan yang ketara. Pada masa yang sama, bergantung pada penindasan bukan maksimum (NMS) untuk pemprosesan pasca menghalang penggunaan YOLO dari hujung ke hujung dan memberi kesan buruk kepada kependaman inferens. Dalam YOLO, reka bentuk pelbagai komponen tidak mempunyai pemeriksaan yang komprehensif dan teliti, mengakibatkan lebihan pengiraan yang ketara dan mengehadkan keupayaan model. Ia menawarkan kecekapan suboptimum, dan potensi yang agak besar untuk peningkatan prestasi. Dalam kerja ini, matlamatnya adalah untuk meningkatkan lagi sempadan kecekapan prestasi YOLO daripada kedua-dua pasca pemprosesan dan seni bina model. sampai habis

Universiti Tsinghua mengambil alih dan YOLOv10 keluar: prestasi telah bertambah baik dan ia berada dalam senarai panas GitHub

Jun 06, 2024 pm 12:20 PM

Universiti Tsinghua mengambil alih dan YOLOv10 keluar: prestasi telah bertambah baik dan ia berada dalam senarai panas GitHub

Jun 06, 2024 pm 12:20 PM

Siri penanda aras YOLO sistem pengesanan sasaran sekali lagi menerima peningkatan besar. Sejak pengeluaran YOLOv9 pada Februari tahun ini, baton siri YOLO (YouOnlyLookOnce) telah diserahkan kepada penyelidik di Universiti Tsinghua. Hujung minggu lalu, berita pelancaran YOLOv10 menarik perhatian komuniti AI. Ia dianggap sebagai rangka kerja terobosan dalam bidang penglihatan komputer dan terkenal dengan keupayaan pengesanan objek hujung ke hujung masa nyata, meneruskan legasi siri YOLO dengan menyediakan penyelesaian berkuasa yang menggabungkan kecekapan dan ketepatan. Alamat kertas: https://arxiv.org/pdf/2405.14458 Alamat projek: https://github.com/THU-MIG/yo

Bagaimana untuk menilai keberkesanan kos sokongan komersial untuk rangka kerja Java

Jun 05, 2024 pm 05:25 PM

Bagaimana untuk menilai keberkesanan kos sokongan komersial untuk rangka kerja Java

Jun 05, 2024 pm 05:25 PM

Menilai kos/prestasi sokongan komersial untuk rangka kerja Java melibatkan langkah-langkah berikut: Tentukan tahap jaminan yang diperlukan dan jaminan perjanjian tahap perkhidmatan (SLA). Pengalaman dan kepakaran pasukan sokongan penyelidikan. Pertimbangkan perkhidmatan tambahan seperti peningkatan, penyelesaian masalah dan pengoptimuman prestasi. Timbang kos sokongan perniagaan terhadap pengurangan risiko dan peningkatan kecekapan.

Laporan teknikal Google Gemini 1.5: Buktikan soalan Olimpik Matematik dengan mudah, versi Flash adalah 5 kali lebih pantas daripada GPT-4 Turbo

Jun 13, 2024 pm 01:52 PM

Laporan teknikal Google Gemini 1.5: Buktikan soalan Olimpik Matematik dengan mudah, versi Flash adalah 5 kali lebih pantas daripada GPT-4 Turbo

Jun 13, 2024 pm 01:52 PM

Pada bulan Februari tahun ini, Google melancarkan model besar berbilang modal Gemini 1.5, yang telah meningkatkan prestasi dan kelajuan dengan sangat baik melalui pengoptimuman kejuruteraan dan infrastruktur, seni bina MoE dan strategi lain. Dengan konteks yang lebih panjang, keupayaan penaakulan yang lebih kukuh dan pengendalian kandungan merentas modal yang lebih baik. Jumaat ini, Google DeepMind secara rasmi mengeluarkan laporan teknikal Gemini 1.5, yang merangkumi versi Flash dan peningkatan terkini yang lain Dokumen itu sepanjang 153 halaman. Pautan laporan teknikal: https://storage.googleapis.com/deepmind-media/gemini/gemini_v1_5_report.pdf Dalam laporan ini, Google memperkenalkan Gemini1

Semakan! Ringkaskan secara menyeluruh peranan penting model asas dalam mempromosikan pemanduan autonomi

Jun 11, 2024 pm 05:29 PM

Semakan! Ringkaskan secara menyeluruh peranan penting model asas dalam mempromosikan pemanduan autonomi

Jun 11, 2024 pm 05:29 PM

Ditulis di atas & pemahaman peribadi pengarang: Baru-baru ini, dengan perkembangan dan penemuan teknologi pembelajaran mendalam, model asas berskala besar (Model Asas) telah mencapai hasil yang ketara dalam bidang pemprosesan bahasa semula jadi dan penglihatan komputer. Aplikasi model asas dalam pemanduan autonomi juga mempunyai prospek pembangunan yang hebat, yang boleh meningkatkan pemahaman dan penaakulan senario. Melalui pra-latihan tentang bahasa yang kaya dan data visual, model asas boleh memahami dan mentafsir pelbagai elemen dalam senario pemanduan autonomi dan melakukan penaakulan, menyediakan arahan bahasa dan tindakan untuk memacu membuat keputusan dan perancangan. Model asas boleh ditambah data dengan pemahaman senario pemanduan untuk menyediakan ciri-ciri yang jarang berlaku dalam pengedaran ekor panjang yang tidak mungkin ditemui semasa pemanduan rutin dan pengumpulan data.

Bagaimanakah keluk pembelajaran rangka kerja PHP berbanding rangka kerja bahasa lain?

Jun 06, 2024 pm 12:41 PM

Bagaimanakah keluk pembelajaran rangka kerja PHP berbanding rangka kerja bahasa lain?

Jun 06, 2024 pm 12:41 PM

Keluk pembelajaran rangka kerja PHP bergantung pada kecekapan bahasa, kerumitan rangka kerja, kualiti dokumentasi dan sokongan komuniti. Keluk pembelajaran rangka kerja PHP adalah lebih tinggi jika dibandingkan dengan rangka kerja Python dan lebih rendah jika dibandingkan dengan rangka kerja Ruby. Berbanding dengan rangka kerja Java, rangka kerja PHP mempunyai keluk pembelajaran yang sederhana tetapi masa yang lebih singkat untuk bermula.

Bagaimanakah pilihan rangka kerja PHP yang ringan mempengaruhi prestasi aplikasi?

Jun 06, 2024 am 10:53 AM

Bagaimanakah pilihan rangka kerja PHP yang ringan mempengaruhi prestasi aplikasi?

Jun 06, 2024 am 10:53 AM

Rangka kerja PHP yang ringan meningkatkan prestasi aplikasi melalui saiz kecil dan penggunaan sumber yang rendah. Ciri-cirinya termasuk: saiz kecil, permulaan pantas, penggunaan memori yang rendah, kelajuan dan daya tindak balas yang dipertingkatkan, dan penggunaan sumber yang dikurangkan: SlimFramework mencipta API REST, hanya 500KB, responsif yang tinggi dan daya pemprosesan yang tinggi.