Peranti teknologi

Peranti teknologi

AI

AI

Belajar ChatGPT, apakah yang akan berlaku jika maklum balas manusia diperkenalkan ke dalam lukisan AI?

Belajar ChatGPT, apakah yang akan berlaku jika maklum balas manusia diperkenalkan ke dalam lukisan AI?

Belajar ChatGPT, apakah yang akan berlaku jika maklum balas manusia diperkenalkan ke dalam lukisan AI?

Baru-baru ini, model generatif mendalam telah mencapai kejayaan yang luar biasa dalam menjana imej berkualiti tinggi daripada gesaan teks, sebahagiannya disebabkan oleh penskalaan model generatif dalam kepada set data web berskala besar seperti LAION. Walau bagaimanapun, beberapa cabaran penting kekal, menghalang model teks-ke-imej berskala besar daripada menjana imej yang sejajar dengan gesaan teks dengan sempurna. Sebagai contoh, model teks-ke-imej semasa sering gagal menjana teks visual yang boleh dipercayai dan menghadapi kesukaran dengan penjanaan imej gabungan.

Kembali dalam bidang pemodelan bahasa, pembelajaran daripada maklum balas manusia telah menjadi penyelesaian yang berkesan untuk "menjajarkan tingkah laku model dengan niat manusia." Kaedah jenis ini mula-mula mempelajari fungsi ganjaran yang direka bentuk untuk mencerminkan perkara yang penting bagi manusia dalam tugasan melalui maklum balas manusia pada output model, dan kemudian menggunakan fungsi ganjaran yang dipelajari melalui algoritma pembelajaran pengukuhan (seperti PPO pengoptimuman dasar proksimal) untuk Mengoptimumkan bahasa model. Pembelajaran pengukuhan dengan rangka kerja maklum balas manusia (RLHF) ini telah berjaya menggabungkan model bahasa berskala besar (seperti GPT-3) dengan penilaian kualiti manusia yang canggih.

Baru-baru ini, diilhamkan oleh kejayaan RLHF dalam bidang bahasa, penyelidik di Google Research dan Berkeley, California mencadangkan kaedah penalaan halus untuk menjajarkan teks kepada model imej menggunakan maklum balas manusia.

Alamat kertas: https://arxiv.org/pdf/2302.12192v1.pdf

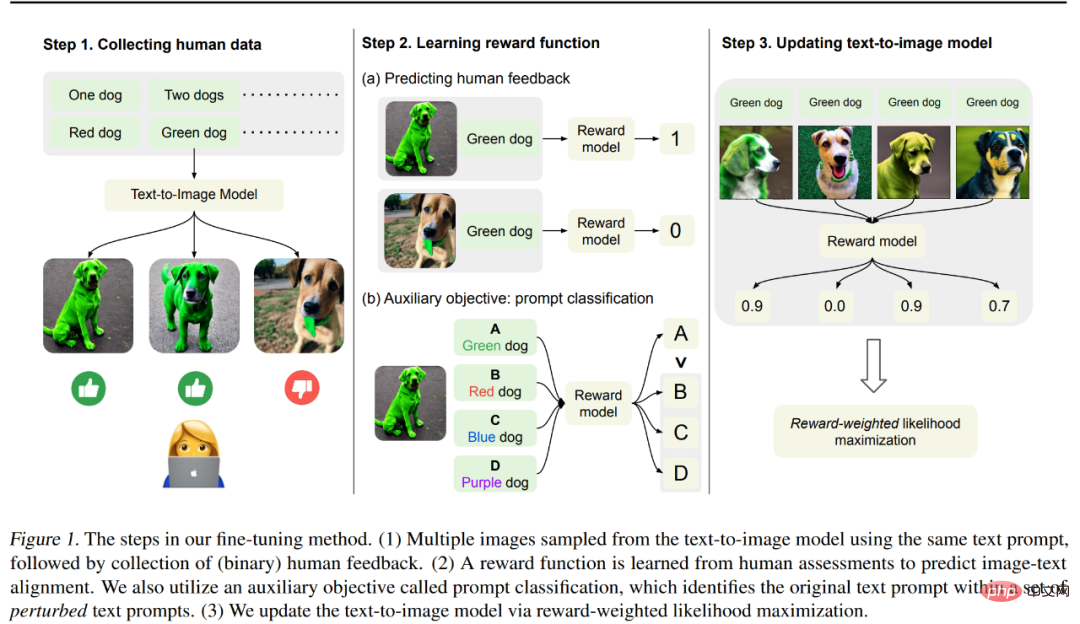

Kaedah dalam artikel ini ditunjukkan dalam Rajah 1 di bawah, yang kebanyakannya dibahagikan kepada 3 langkah.

Langkah 1: Mula-mula jana imej berbeza daripada set gesaan teks "direka untuk menguji penjajaran teks ke output model imej". Secara khusus, periksa gesaan model terlatih yang lebih terdedah kepada ralat—menjana objek dengan warna, nombor dan latar belakang tertentu, kemudian kumpulkan maklum balas manusia binari yang digunakan untuk menilai output model.

Langkah 2: Menggunakan set data berlabel manusia, latih fungsi ganjaran untuk meramalkan maklum balas manusia yang diberikan imej dan gesaan teks. Kami mencadangkan tugas tambahan untuk mengenal pasti gesaan teks asal antara satu set gesaan teks yang terganggu untuk menggunakan maklum balas manusia dengan lebih berkesan untuk pembelajaran ganjaran. Teknik ini menambah baik generalisasi fungsi ganjaran kepada imej yang tidak kelihatan dan gesaan teks.

Langkah 3: Kemas kini model teks-ke-imej melalui pemaksimuman kemungkinan wajaran ganjaran untuk menyelaraskannya dengan maklum balas manusia dengan lebih baik. Tidak seperti kerja sebelumnya yang menggunakan pembelajaran pengukuhan untuk pengoptimuman, penyelidik menggunakan pembelajaran separa penyeliaan untuk mengemas kini model untuk mengukur kualiti output model, iaitu fungsi ganjaran yang dipelajari.

Penyelidik menggunakan 27,000 pasangan teks imej dengan maklum balas manusia untuk memperhalusi model Resapan Stabil dan hasilnya menunjukkan penalaan halus Model terakhir mencapai peningkatan yang ketara dalam menghasilkan objek dengan warna, kuantiti dan latar belakang tertentu. Mencapai sehingga 47% peningkatan dalam penjajaran teks imej dengan sedikit kehilangan dalam kesetiaan imej.

Selain itu, hasil penjanaan gabungan telah dipertingkatkan untuk menjana objek ghaib dengan lebih baik memandangkan gabungan warna, kuantiti dan gesaan latar belakang yang tidak kelihatan. Mereka juga mendapati bahawa fungsi ganjaran yang dipelajari sepadan dengan penilaian penjajaran manusia lebih baik daripada skor CLIP pada gesaan teks ujian.

Walau bagaimanapun, Kimin Lee, pengarang pertama kertas kerja, juga berkata bahawa hasil kertas kerja ini tidak menyelesaikan semua model kegagalan dalam model teks-ke-imej sedia ada, dan masih banyak cabaran. Mereka berharap kerja ini akan menyerlahkan potensi pembelajaran daripada maklum balas manusia dalam menjajarkan model graf Vincent.

Pengenalan Kaedah

Untuk menjajarkan imej yang dijana dengan gesaan teks, kajian ini melakukan satu siri penalaan halus pada model pra-latihan, dan prosesnya ditunjukkan dalam Rajah 1 di atas. Pertama, imej yang sepadan dihasilkan daripada satu set gesaan teks, satu proses yang direka untuk menguji pelbagai prestasi model graf Vincentian kemudian penilai manusia memberikan maklum balas binari pada imej yang dihasilkan ini seterusnya, kajian itu melatih model ganjaran untuk meramalkan maklum balas manusia; gesaan teks dan imej sebagai input, akhirnya, kajian menggunakan kemungkinan log wajaran ganjaran untuk memperhalusi model graf Vincent untuk menambah baik penjajaran imej teks.

Pengumpulan Data Manusia

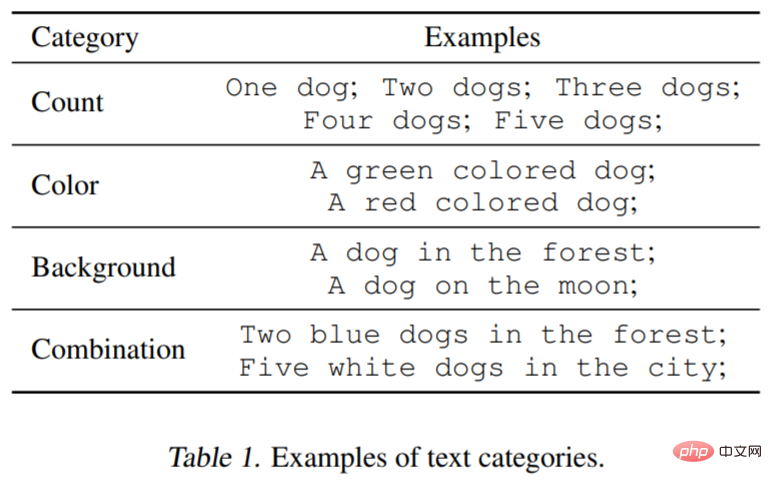

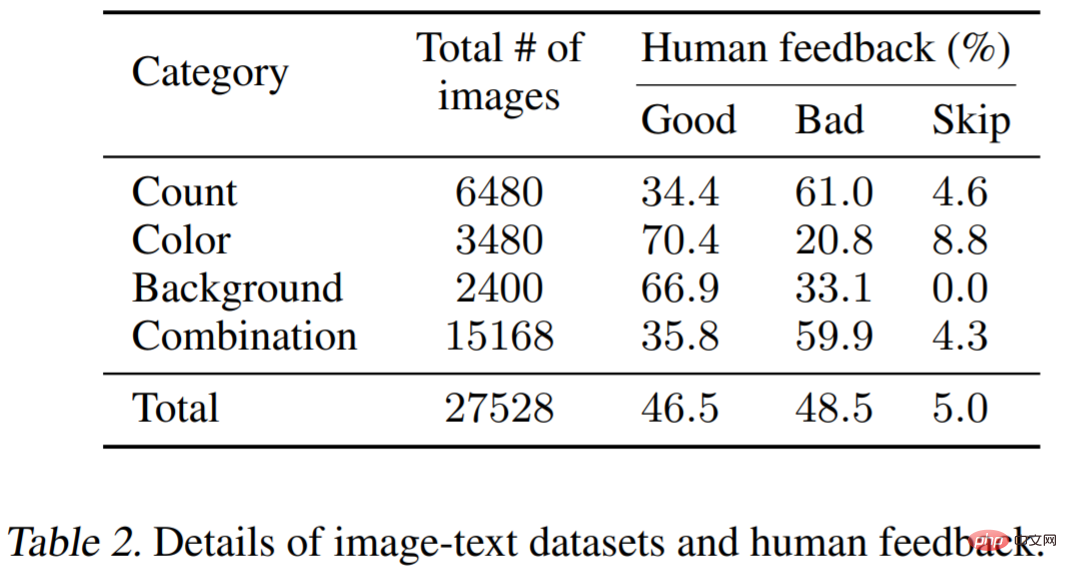

Untuk menguji kefungsian model graf Vincentian, kajian mempertimbangkan tiga kategori teks gesaan: Kiraan, warna, latar belakang yang ditentukan. Bagi setiap kategori, kajian menjana gesaan dengan memasangkan setiap perkataan atau frasa yang menerangkan objek, seperti hijau (warna) dengan anjing (kuantiti). Selain itu, kajian itu mempertimbangkan gabungan tiga kategori (cth., dua anjing yang diwarnakan hijau di sebuah bandar). Jadual 1 di bawah menggambarkan klasifikasi set data dengan lebih baik. Setiap gesaan akan digunakan untuk menjana 60 imej, dan model terutamanya Stable Diffusion v1.5.

Maklum Balas Manusia

Seterusnya Dijana imej untuk maklum balas manusia. Tiga imej yang dijana oleh gesaan yang sama akan dibentangkan kepada pelabel, dan mereka akan diminta untuk menilai sama ada setiap imej yang dijana konsisten dengan gesaan dan kriteria penilaian adalah baik atau buruk. Memandangkan tugas ini agak mudah, maklum balas binari akan mencukupi.

Pembelajaran Ganjaran

Untuk menilai penjajaran teks imej dengan lebih baik, kajian ini menggunakan fungsi ganjaran  ialah fungsi yang memetakan pembenaman CLIP imej x dan gesaan teks z kepada nilai skalar. Ia kemudiannya digunakan untuk meramalkan maklum balas manusia k_y ∈ {0, 1} (1 = baik, 0 = buruk).

ialah fungsi yang memetakan pembenaman CLIP imej x dan gesaan teks z kepada nilai skalar. Ia kemudiannya digunakan untuk meramalkan maklum balas manusia k_y ∈ {0, 1} (1 = baik, 0 = buruk).

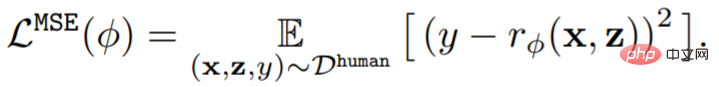

Secara formal, memandangkan set data maklum balas manusia D^manusia = {(x, z, y)}, fungsi ganjaran  Latih dengan meminimumkan ralat kuasa dua min (MSE):

Latih dengan meminimumkan ralat kuasa dua min (MSE):

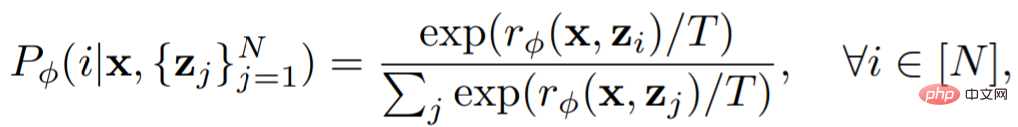

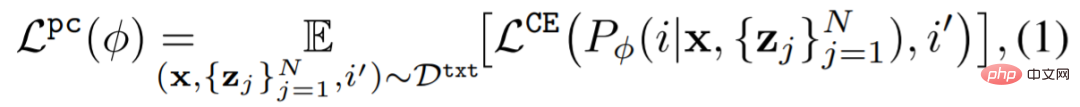

Sebelum ini, ia telah menjadi Kajian telah menunjukkan bahawa kaedah penambahan data boleh meningkatkan kecekapan data dan memodelkan prestasi pembelajaran dengan ketara Untuk menggunakan set data maklum balas dengan berkesan, kajian ini mereka bentuk skim penambahan data mudah dan kerugian tambahan (auxiliary loss) untuk pembelajaran ganjaran. Kajian ini menggunakan gesaan tambahan dalam tugasan tambahan, iaitu pembelajaran ganjaran klasifikasi dilakukan pada gesaan asal. Pengelas Prompt menggunakan fungsi ganjaran seperti berikut:

Kerugian tambahan ialah:

Langkah terakhir ialah mengemas kini model rajah Vincent. Memandangkan kepelbagaian set data yang dijana oleh model adalah terhad, ia mungkin membawa kepada overfitting. Untuk mengurangkan ini, kajian ini juga meminimumkan kerugian pra-latihan seperti berikut:

Hasil eksperimen

Bahagian percubaan direka bentuk untuk menguji keberkesanan maklum balas manusia yang mengambil bahagian dalam penalaan halus model. Model yang digunakan dalam eksperimen ialah Stable Diffusion v1.5; maklumat set data ditunjukkan dalam Jadual 1 (lihat di atas) dan Jadual 2. Jadual 2 menunjukkan taburan maklum balas yang disediakan oleh pelbagai pelabel manusia.

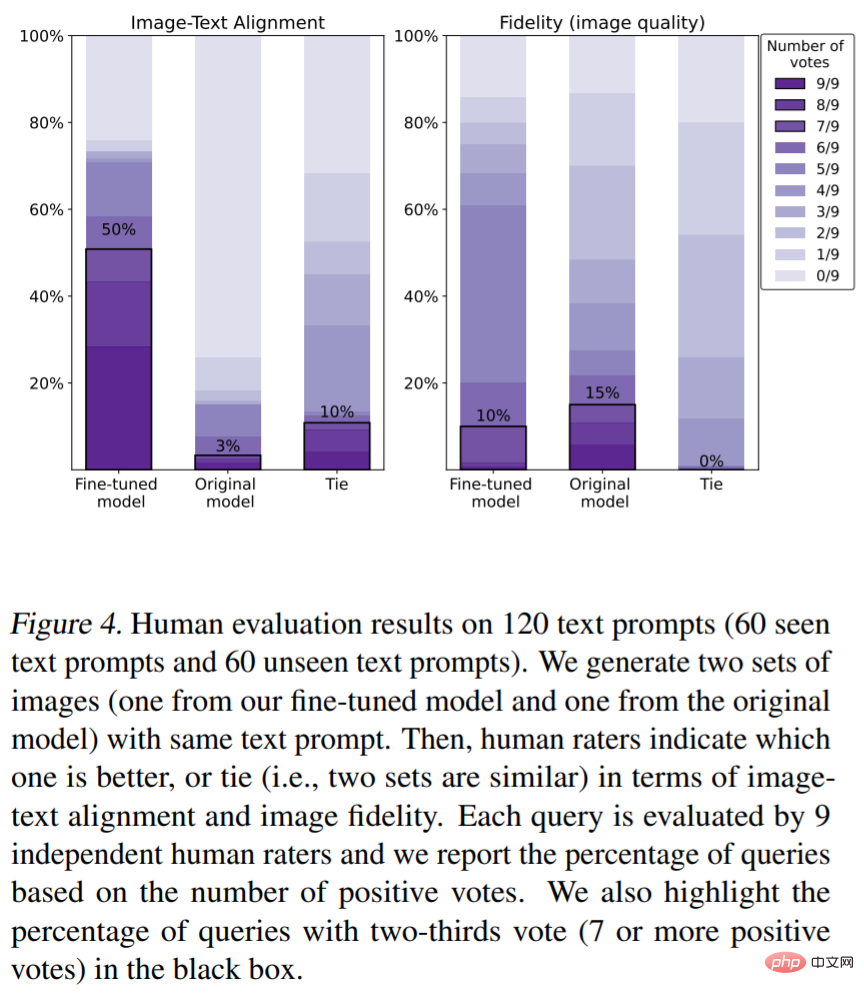

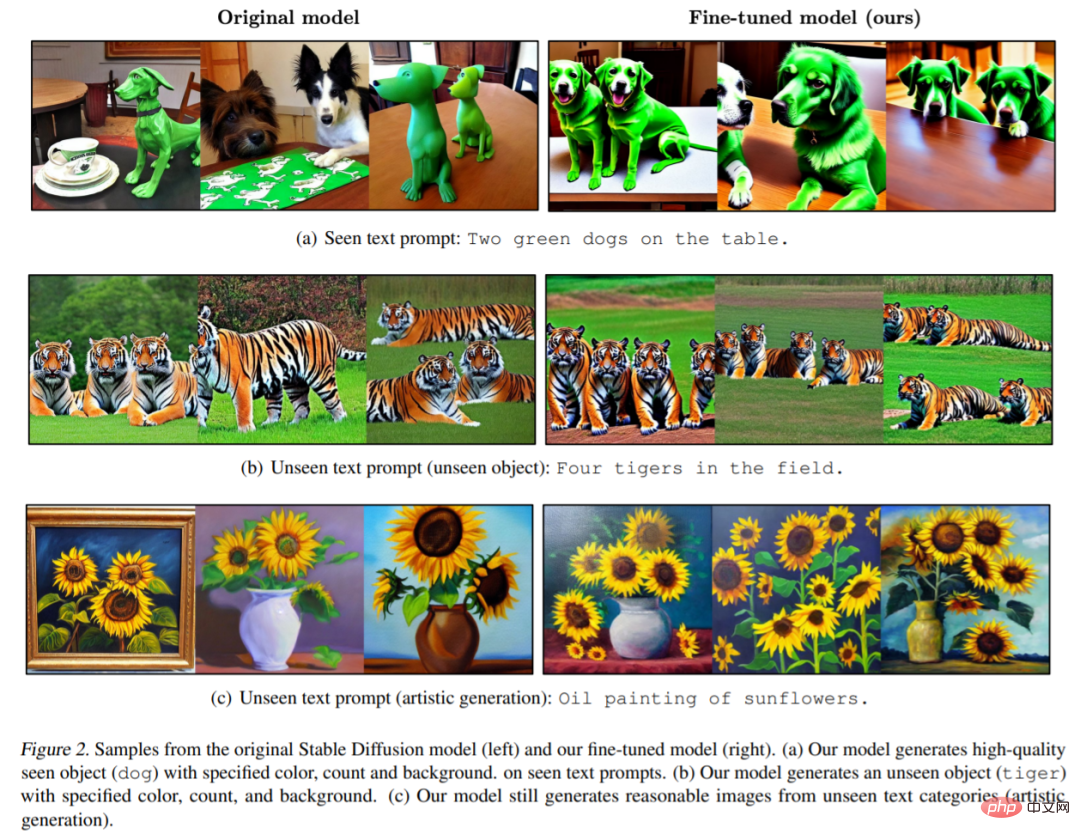

Penilaian manusia bagi penjajaran imej teks (metrik penilaian ialah warna, bilangan objek). Seperti yang ditunjukkan dalam Rajah 4, kaedah kami meningkatkan penjajaran teks imej dengan ketara Secara khusus, 50% daripada sampel dalam imej yang dijana oleh model menerima sekurang-kurangnya dua pertiga daripada undian menyokong (jumlah undian ialah 7 atau lebih undian. memihak) undian), walau bagaimanapun, penalaan halus mengurangkan kesetiaan imej (15% berbanding 10%). Rajah 2 menunjukkan contoh imej daripada model asal dan model sepadan yang diperhalusi daripada kertas ini. Dapat dilihat bahawa model asal menghasilkan imej yang tidak mempunyai butiran (seperti warna, latar belakang atau kiraan) (Rajah 2 (a)), dan imej yang dijana oleh model kami mematuhi warna, kiraan dan latar belakang yang ditentukan oleh gesaan. . Perlu diingat bahawa model kami juga boleh menghasilkan imej gesaan teks yang tidak kelihatan dengan kualiti yang sangat tinggi (Rajah 2 (b)).

Ganjaran hasil pembelajaran. Rajah 3(a) menunjukkan skor model dalam gesaan teks yang dilihat dan gesaan teks yang tidak dilihat. Mempunyai ganjaran (hijau) adalah lebih konsisten dengan niat manusia biasa daripada skor CLIP (merah).

Atas ialah kandungan terperinci Belajar ChatGPT, apakah yang akan berlaku jika maklum balas manusia diperkenalkan ke dalam lukisan AI?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1372

1372

52

52

Menyelam mendalam ke dalam model, data dan rangka kerja: tinjauan menyeluruh 54 halaman model bahasa besar yang cekap

Jan 14, 2024 pm 07:48 PM

Menyelam mendalam ke dalam model, data dan rangka kerja: tinjauan menyeluruh 54 halaman model bahasa besar yang cekap

Jan 14, 2024 pm 07:48 PM

Model bahasa berskala besar (LLM) telah menunjukkan keupayaan yang menarik dalam banyak tugas penting, termasuk pemahaman bahasa semula jadi, penjanaan bahasa dan penaakulan yang kompleks, dan telah memberi kesan yang mendalam kepada masyarakat. Walau bagaimanapun, keupayaan cemerlang ini memerlukan sumber latihan yang ketara (ditunjukkan di sebelah kiri) dan masa inferens yang panjang (ditunjukkan di sebelah kanan). Oleh itu, penyelidik perlu membangunkan cara teknikal yang berkesan untuk menyelesaikan masalah kecekapan mereka. Di samping itu, seperti yang dapat dilihat dari sebelah kanan rajah, beberapa LLM (Model Bahasa) yang cekap seperti Mistral-7B telah berjaya digunakan dalam reka bentuk dan penggunaan LLM. LLM yang cekap ini boleh mengurangkan memori inferens dengan ketara sambil mengekalkan ketepatan yang serupa dengan LLaMA1-33B

Kertas Stable Diffusion 3 akhirnya telah dikeluarkan, dan butiran seni bina didedahkan Adakah ia akan membantu untuk menghasilkan semula Sora?

Mar 06, 2024 pm 05:34 PM

Kertas Stable Diffusion 3 akhirnya telah dikeluarkan, dan butiran seni bina didedahkan Adakah ia akan membantu untuk menghasilkan semula Sora?

Mar 06, 2024 pm 05:34 PM

Kertas StableDiffusion3 akhirnya di sini! Model ini dikeluarkan dua minggu lalu dan menggunakan seni bina DiT (DiffusionTransformer) yang sama seperti Sora. Ia menimbulkan kekecohan apabila ia dikeluarkan. Berbanding dengan versi sebelumnya, kualiti imej yang dijana oleh StableDiffusion3 telah dipertingkatkan dengan ketara Ia kini menyokong gesaan berbilang tema, dan kesan penulisan teks juga telah dipertingkatkan, dan aksara bercelaru tidak lagi muncul. StabilityAI menegaskan bahawa StableDiffusion3 ialah satu siri model dengan saiz parameter antara 800M hingga 8B. Julat parameter ini bermakna model boleh dijalankan terus pada banyak peranti mudah alih, dengan ketara mengurangkan penggunaan AI

Artikel ini sudah cukup untuk anda membaca tentang pemanduan autonomi dan ramalan trajektori!

Feb 28, 2024 pm 07:20 PM

Artikel ini sudah cukup untuk anda membaca tentang pemanduan autonomi dan ramalan trajektori!

Feb 28, 2024 pm 07:20 PM

Ramalan trajektori memainkan peranan penting dalam pemanduan autonomi Ramalan trajektori pemanduan autonomi merujuk kepada meramalkan trajektori pemanduan masa hadapan kenderaan dengan menganalisis pelbagai data semasa proses pemanduan kenderaan. Sebagai modul teras pemanduan autonomi, kualiti ramalan trajektori adalah penting untuk kawalan perancangan hiliran. Tugas ramalan trajektori mempunyai timbunan teknologi yang kaya dan memerlukan kebiasaan dengan persepsi dinamik/statik pemanduan autonomi, peta ketepatan tinggi, garisan lorong, kemahiran seni bina rangkaian saraf (CNN&GNN&Transformer), dll. Sangat sukar untuk bermula! Ramai peminat berharap untuk memulakan ramalan trajektori secepat mungkin dan mengelakkan perangkap Hari ini saya akan mengambil kira beberapa masalah biasa dan kaedah pembelajaran pengenalan untuk ramalan trajektori! Pengetahuan berkaitan pengenalan 1. Adakah kertas pratonton teratur? A: Tengok survey dulu, hlm

DualBEV: mengatasi BEVFormer dan BEVDet4D dengan ketara, buka buku!

Mar 21, 2024 pm 05:21 PM

DualBEV: mengatasi BEVFormer dan BEVDet4D dengan ketara, buka buku!

Mar 21, 2024 pm 05:21 PM

Kertas kerja ini meneroka masalah mengesan objek dengan tepat dari sudut pandangan yang berbeza (seperti perspektif dan pandangan mata burung) dalam pemanduan autonomi, terutamanya cara mengubah ciri dari perspektif (PV) kepada ruang pandangan mata burung (BEV) dengan berkesan dilaksanakan melalui modul Transformasi Visual (VT). Kaedah sedia ada secara amnya dibahagikan kepada dua strategi: penukaran 2D kepada 3D dan 3D kepada 2D. Kaedah 2D-ke-3D meningkatkan ciri 2D yang padat dengan meramalkan kebarangkalian kedalaman, tetapi ketidakpastian yang wujud dalam ramalan kedalaman, terutamanya di kawasan yang jauh, mungkin menimbulkan ketidaktepatan. Manakala kaedah 3D ke 2D biasanya menggunakan pertanyaan 3D untuk mencuba ciri 2D dan mempelajari berat perhatian bagi kesesuaian antara ciri 3D dan 2D melalui Transformer, yang meningkatkan masa pengiraan dan penggunaan.

Model dunia penjanaan video adegan pemanduan berbilang paparan autonomi |

Oct 23, 2023 am 11:13 AM

Model dunia penjanaan video adegan pemanduan berbilang paparan autonomi |

Oct 23, 2023 am 11:13 AM

Beberapa pemikiran peribadi pengarang Dalam bidang pemanduan autonomi, dengan pembangunan sub-tugas/penyelesaian hujung-ke-hujung berasaskan BEV, data latihan berbilang paparan berkualiti tinggi dan pembinaan adegan simulasi yang sepadan telah menjadi semakin penting. Sebagai tindak balas kepada titik kesakitan tugas semasa, "kualiti tinggi" boleh dipecahkan kepada tiga aspek: senario ekor panjang dalam dimensi berbeza: seperti kenderaan jarak dekat dalam data halangan dan sudut arah tepat semasa pemotongan kereta, dan data garis lorong. . Ini selalunya bergantung pada sejumlah besar pengumpulan data dan strategi perlombongan data yang kompleks, yang memerlukan kos yang tinggi. Nilai sebenar 3D - imej sangat konsisten: Pemerolehan data BEV semasa sering dipengaruhi oleh ralat dalam pemasangan/penentukuran sensor, peta berketepatan tinggi dan algoritma pembinaan semula itu sendiri. ini membawa saya kepada

'Minecraft' bertukar menjadi bandar AI, dan penduduk NPC memainkan peranan seperti orang sebenar

Jan 02, 2024 pm 06:25 PM

'Minecraft' bertukar menjadi bandar AI, dan penduduk NPC memainkan peranan seperti orang sebenar

Jan 02, 2024 pm 06:25 PM

Sila ambil perhatian bahawa lelaki persegi ini berkerut dahi, memikirkan identiti "tetamu tidak diundang" di hadapannya. Ternyata dia berada dalam situasi berbahaya, dan apabila dia menyedari perkara ini, dia segera memulakan pencarian mental untuk mencari strategi untuk menyelesaikan masalah itu. Akhirnya, dia memutuskan untuk melarikan diri dari tempat kejadian dan kemudian mendapatkan bantuan secepat mungkin dan mengambil tindakan segera. Pada masa yang sama, orang di seberang sana memikirkan perkara yang sama seperti dia... Terdapat adegan sedemikian dalam "Minecraft" di mana semua watak dikawal oleh kecerdasan buatan. Setiap daripada mereka mempunyai latar identiti yang unik Contohnya, gadis yang disebutkan sebelum ini adalah seorang kurier berusia 17 tahun tetapi bijak dan berani. Mereka mempunyai daya ingatan dan pemikiran serta hidup seperti manusia di bandar kecil yang terletak di Minecraft ini. Apa yang mendorong mereka adalah sesuatu yang baru,

Penyesuai I2V daripada komuniti SD: tiada konfigurasi diperlukan, pasang dan main, serasi sempurna dengan pemalam video Tusheng

Jan 15, 2024 pm 07:48 PM

Penyesuai I2V daripada komuniti SD: tiada konfigurasi diperlukan, pasang dan main, serasi sempurna dengan pemalam video Tusheng

Jan 15, 2024 pm 07:48 PM

Tugas penjanaan imej-ke-video (I2V) merupakan satu cabaran dalam bidang penglihatan komputer yang bertujuan untuk menukar imej statik kepada video dinamik. Kesukaran tugas ini adalah untuk mengekstrak dan menjana maklumat dinamik dalam dimensi temporal daripada imej tunggal sambil mengekalkan keaslian dan keselarasan visual kandungan imej. Kaedah I2V sedia ada selalunya memerlukan seni bina model yang kompleks dan sejumlah besar data latihan untuk mencapai matlamat ini. Baru-baru ini, hasil penyelidikan baharu "I2V-Adapter: AGeneralImage-to-VideoAdapter for VideoDiffusionModels" yang diketuai oleh Kuaishou telah dikeluarkan. Kajian ini memperkenalkan kaedah penukaran imej-ke-video yang inovatif dan mencadangkan modul penyesuai ringan, i.e.

Kertas skor sempurna VPR 2024! Meta mencadangkan EfficientSAM: cepat belah semuanya!

Mar 02, 2024 am 10:10 AM

Kertas skor sempurna VPR 2024! Meta mencadangkan EfficientSAM: cepat belah semuanya!

Mar 02, 2024 am 10:10 AM

Kerja EfficientSAM ini telah dimasukkan ke dalam CVPR2024 dengan skor sempurna 5/5/5! Penulis berkongsi hasilnya di media sosial, seperti yang ditunjukkan dalam gambar di bawah: Pemenang Anugerah LeCun Turing juga sangat mengesyorkan karya ini! Dalam penyelidikan baru-baru ini, penyelidik Meta telah mencadangkan kaedah baharu yang dipertingkatkan, iaitu pra-latihan imej topeng (SAMI) menggunakan SAM. Kaedah ini menggabungkan teknologi pra-latihan MAE dan model SAM untuk mencapai pengekod ViT pra-latihan berkualiti tinggi. Melalui SAMI, penyelidik cuba meningkatkan prestasi dan kecekapan model dan menyediakan penyelesaian yang lebih baik untuk tugas penglihatan. Cadangan kaedah ini membawa idea dan peluang baharu untuk meneroka dan mengembangkan lagi bidang visi komputer dan pembelajaran mendalam. dengan menggabungkan berbeza