Peranti teknologi

Peranti teknologi

AI

AI

NVIDIA menggunakan AI untuk mereka bentuk litar aritmetik GPU, yang mengurangkan kawasan sebanyak 25% berbanding EDA paling canggih, menjadikannya lebih pantas dan lebih cekap

NVIDIA menggunakan AI untuk mereka bentuk litar aritmetik GPU, yang mengurangkan kawasan sebanyak 25% berbanding EDA paling canggih, menjadikannya lebih pantas dan lebih cekap

NVIDIA menggunakan AI untuk mereka bentuk litar aritmetik GPU, yang mengurangkan kawasan sebanyak 25% berbanding EDA paling canggih, menjadikannya lebih pantas dan lebih cekap

Serangkaian besar litar aritmetik menguatkan GPU NVIDIA untuk membolehkan pecutan AI, pengkomputeran berprestasi tinggi dan grafik komputer yang belum pernah terjadi sebelumnya. Oleh itu, menambah baik reka bentuk litar aritmetik ini adalah penting untuk meningkatkan prestasi dan kecekapan GPU. Bagaimana jika AI belajar untuk mereka bentuk litar ini? Dalam kertas kerja NVIDIA baru-baru ini, "PrefixRL: Pengoptimuman Litar Awalan Selari menggunakan Pembelajaran Pengukuhan Dalam," penyelidik menunjukkan bahawa AI bukan sahaja boleh mereka bentuk litar ini dari awal, tetapi juga litar yang direka oleh AI adalah lebih baik daripada yang direka oleh negara-of- alat automasi reka bentuk elektronik (EDA) yang paling canggih adalah lebih kecil dan lebih pantas.

Alamat kertas: https://arxiv.org/pdf/2205.07000.pdf

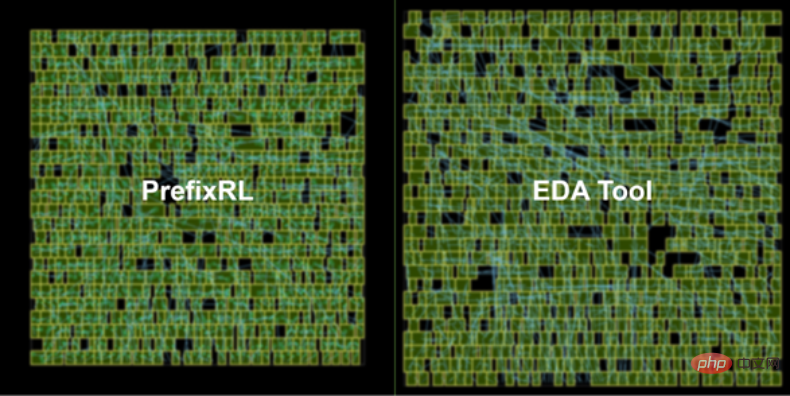

Seni bina GPU NVIDIA Hopper terkini mempunyai hampir 13,000 contoh litar rekaan AI. Rajah 1 di bawah: Litar penambah 64b yang direka oleh PrefixRL AI di sebelah kiri adalah 25% lebih kecil daripada litar yang direka oleh alat EDA paling canggih di sebelah kanan Rajah 1.

Gambaran Keseluruhan Reka Bentuk Litar

Litar aritmetik dalam cip komputer terdiri daripada rangkaian get logik seperti sebagai NAND, NOR dan XOR) dan wayar. Litar yang ideal harus mempunyai sifat berikut:

- Kecil: kawasan yang lebih kecil, lebih banyak litar boleh dibungkus pada cip; Cepat: kependaman rendah, prestasi cip dipertingkatkan;

- penggunaan kuasa yang lebih rendah.

- Dalam kajian NVIDIA ini, penyelidik menumpukan pada kawasan litar dan kependaman. Mereka mendapati bahawa penggunaan kuasa berkait rapat dengan kawasan litar yang diminati. Kawasan litar dan kelewatan selalunya merupakan hartanah yang bersaing, jadi adalah wajar untuk mencari sempadan Pareto untuk reka bentuk yang secara berkesan menukar hartanah ini. Ringkasnya, penyelidik berharap kawasan litar untuk setiap kelewatan dapat diminimumkan.

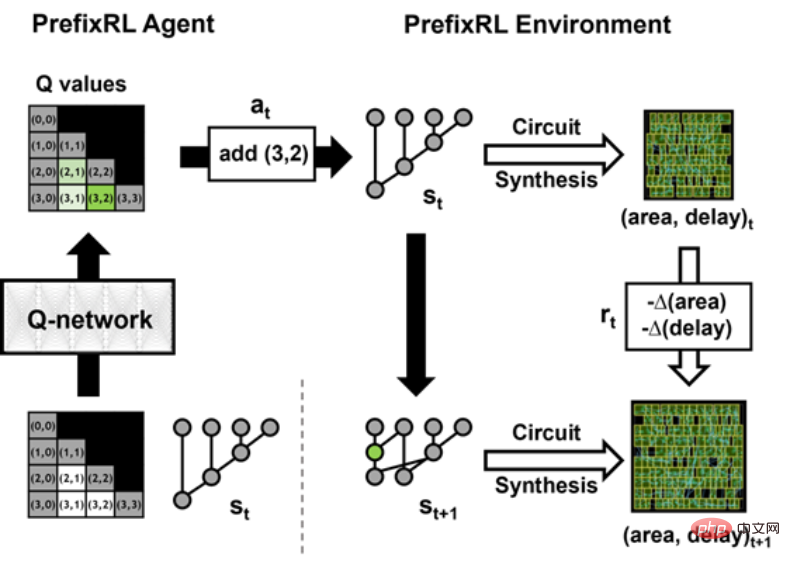

Maka persoalannya ialah: Bolehkah ejen AI mereka bentuk peta awalan yang baik? Ruang keadaan semua graf awalan adalah sangat besar O(2^n^n) dan tidak boleh diterokai menggunakan kaedah kekerasan. Rajah 2 di bawah menunjukkan lelaran PrefixRL dengan contoh litar 4b.

Para penyelidik menggunakan Penjana Litar untuk menukar rajah awalan kepada litar dengan wayar dan get logik. Seterusnya, litar yang dijana ini dioptimumkan melalui alat sintesis fizikal yang menggunakan pengoptimuman sintesis fizikal seperti saiz get, penduaan dan sisipan penimbal.

Disebabkan pengoptimuman sintesis fizik ini, sifat litar akhir (kelewatan, luas dan kuasa) tidak ditukar terus daripada sifat graf awalan asal (seperti tahap dan kiraan nod). Inilah sebabnya mengapa ejen AI belajar untuk mereka bentuk graf awalan tetapi mengoptimumkan sifat litar akhir yang dihasilkan daripada graf awalan.

Penyelidik menganggap aritmetik

reka bentuk litar sebagai tugas pembelajaran tetulang (RL), di mana ejen dilatih untuk mengoptimumkan Kawasan litararitmetik dan sifat kelewatan. Untuk litar awalan, mereka mereka bentuk persekitaran di mana ejen RL boleh menambah atau mengalih keluar nod dalam graf awalan, dan kemudian melakukan langkah berikut: Graf awalan dinormalisasi untuk sentiasa mengekalkan pengiraan jumlah awalan yang betul;

- Hasilkan litar daripada graf awalan ternormal;

- Ukur kawasan dan ciri kelewatan litar.

- Dalam animasi berikut, ejen RL membina graf awalan langkah demi langkah dengan menambah atau memadamkan nod. Pada setiap langkah, ejen diberi ganjaran dengan peningkatan dalam kawasan litar dan kependaman.

-

Imej asal ialah versi interaktif.

Ejen pembelajaran Q konvolusi penuh

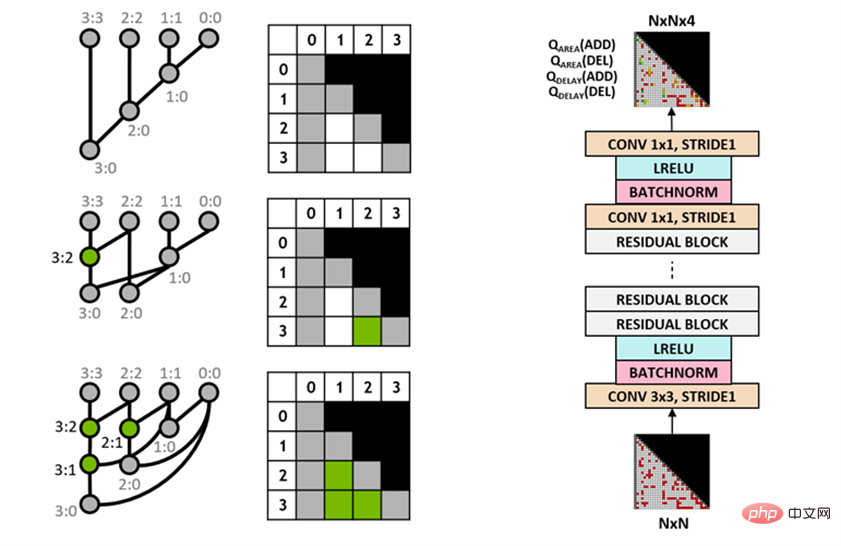

Penyelidik menggunakan algoritma Q-learning (Q-learning) untuk melatih reka bentuk litar ejen. Seperti yang ditunjukkan dalam Rajah 3 di bawah, mereka menguraikan graf awalan menjadi perwakilan grid, di mana setiap elemen dalam grid dipetakan secara unik kepada nod awalan. Grid ini mewakili input dan output yang digunakan untuk rangkaian Q. Setiap elemen dalam grid input mewakili sama ada nod itu wujud atau tidak. Setiap elemen dalam grid output mewakili nilai Q bagi nod yang ditambah atau dialih keluar.

Para penyelidik menggunakan seni bina rangkaian neural konvolusi sepenuhnya kerana input dan output ejen pembelajaran-Q ialah perwakilan grid. Ejen meramalkan nilai Q untuk kawasan dan atribut kelewatan secara berasingan kerana ganjaran untuk kawasan dan kelewatan boleh diperhatikan secara berasingan semasa latihan.

Rajah 3: Perwakilan graf awalan 4b (kiri) dan seni bina ejen pembelajaran Q konvolusi sepenuhnya (kanan).

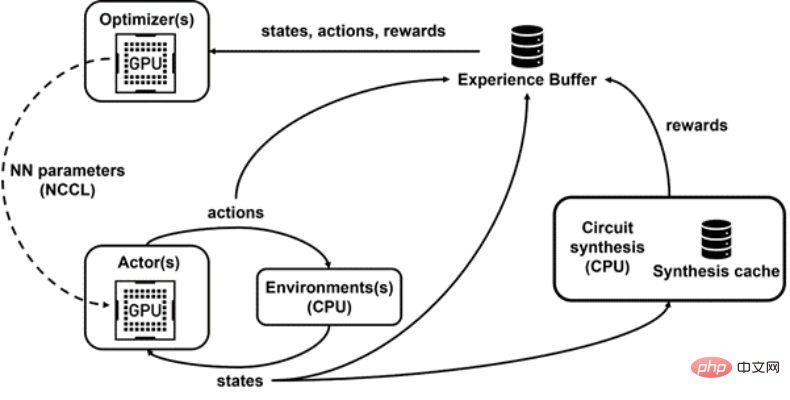

Raptor untuk latihan teragih

PrefixRL memerlukan banyak pengiraan, dalam simulasi fizik, 256 CPU setiap GPU diperlukan dan latihan 64b tugas Lebih 32,000 jam GPU. Kali ini, NVIDIA telah membangunkan platform pembelajaran tetulang teragih dalaman, Raptor, yang menggunakan sepenuhnya kelebihan perkakasan NVIDIA untuk melaksanakan pembelajaran pengukuhan peringkat industri seperti ini (Rajah 4 di bawah).

Raptor mempunyai ciri yang meningkatkan kebolehskalaan dan kelajuan model latihan, seperti penjadualan kerja, rangkaian tersuai dan struktur data sedar GPU. Dalam konteks PrefixRL, Raptor mendayakan peruntukan hibrid merentas CPU, GPU dan Instans Spot. Rangkaian dalam aplikasi pembelajaran pengukuhan ini adalah pelbagai dan mendapat manfaat daripada yang berikut:- Suis Raptor antara NCCL untuk pemindahan model peer-to-peer Parameter dipindahkan terus daripada pelajar GPU kepada GPU inferens;

- Redis untuk mesej tak segerak dan lebih kecil seperti ganjaran atau statistik; mengendalikan permintaan volum tinggi dan kependaman rendah, seperti memuat naik data pengalaman.

- Akhir sekali, Raptor menyediakan struktur data yang menyedari GPU seperti penimbal main semula dengan perkhidmatan berbilang benang untuk menerima pengalaman daripada berbilang pekerja, data kelompok secara selari dan Pramuat pada GPU .

Rajah 4: Penyelidik menggunakan Raptor untuk memisahkan latihan selari dan pengiraan ganjaran untuk mengatasi kelewatan sintesis litar.

Rajah 4: Penyelidik menggunakan Raptor untuk memisahkan latihan selari dan pengiraan ganjaran untuk mengatasi kelewatan sintesis litar. Pengiraan Ganjaran

Para penyelidik menggunakan wajaran tukar ganti w (julat [0,1]) untuk menggabungkan kawasan dan sasaran kelewatan. Mereka melatih pelbagai ejen dengan pemberat yang berbeza untuk mendapatkan sempadan Pareto, dengan itu mengimbangi pertukaran antara kawasan dan kependaman. Pengoptimuman yang disintesis secara fizikal dalam persekitaran RL boleh menjana pelbagai penyelesaian yang menukar kawasan dan kependaman. Penyelidik memacu alat sintesis fizikal menggunakan pemberat tukar ganti yang sama yang digunakan untuk melatih ejen tertentu.Melaksanakan pengoptimuman sintesis fizik dalam gelung pengiraan ganjaran mempunyai kelebihan berikut:

Ejen RL belajar untuk terus mengoptimumkan sifat litar akhir nod teknologi sasaran dan perpustakaan ;- Ejen RL termasuk logik persisian litar algoritma sasaran semasa proses sintesis fizikal, dengan itu mengoptimumkan prestasi litar algoritma sasaran dan logik persisiannya.

- Walau bagaimanapun, melakukan sintesis fizik adalah proses yang perlahan (~35 saat untuk 64b adder), yang boleh melambatkan latihan dan penerokaan RL dengan ketara.

Apabila pekerja CPU mengembalikan ganjaran, peralihan boleh dibenamkan dalam penimbal main semula. Ganjaran komprehensif dicache untuk mengelakkan pengiraan berlebihan apabila keadaan ditemui semula.

Keputusan dan Pandangan

Rajah 5 di bawah menunjukkan kawasan dan kelewatan litar penambah 64b yang direka bentuk menggunakan PrefixRL dan litar penambah yang dikuasai Pareto daripada alatan EDA yang paling canggih.

Penambah PrefixRL terbaik mencapai 25% kurang kawasan daripada penambah alat EDA pada kependaman yang sama. Graf awalan ini dipetakan kepada litar penambah optimum Pareto selepas pengoptimuman sintesis fizikal mempunyai struktur yang tidak teratur. Rajah 5: Litar aritmetik yang direka oleh PrefixRL adalah lebih kecil daripada litar yang direka oleh alat EDA yang canggih dan lebih pantas.

(kiri) seni bina litar; (kanan) sepadan rajah ciri litar penambah 64b Setakat ini seperti yang kita ketahui, ini adalah kaedah pertama untuk menggunakan agen pembelajaran tetulang dalam untuk mereka bentuk litar aritmetik. NVIDIA membayangkan pelan tindakan untuk menggunakan AI kepada masalah reka bentuk litar dunia sebenar, membina ruang tindakan, perwakilan negeri, model ejen RL, mengoptimumkan untuk berbilang matlamat bersaing dan mengatasi pengiraan ganjaran yang perlahan.

Atas ialah kandungan terperinci NVIDIA menggunakan AI untuk mereka bentuk litar aritmetik GPU, yang mengurangkan kawasan sebanyak 25% berbanding EDA paling canggih, menjadikannya lebih pantas dan lebih cekap. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1393

1393

52

52

1209

1209

24

24

Platform Perdagangan Web3 Ranking_Web3 Global Exchanges Top Ten Ringkasan

Apr 21, 2025 am 10:45 AM

Platform Perdagangan Web3 Ranking_Web3 Global Exchanges Top Ten Ringkasan

Apr 21, 2025 am 10:45 AM

Binance adalah tuan rumah ekosistem perdagangan aset digital global, dan ciri -cirinya termasuk: 1. Jumlah dagangan harian purata melebihi $ 150 bilion, menyokong 500 pasangan perdagangan, yang meliputi 98% mata wang arus perdana; 2. Matriks inovasi meliputi pasaran Derivatif, susun atur Web3 dan sistem pendidikan; 3. Kelebihan teknikal adalah enjin yang sepadan dengan milisaat, dengan jumlah pemprosesan puncak sebanyak 1.4 juta transaksi sesaat; 4. Kemajuan pematuhan memegang lesen 15 negara dan menetapkan entiti yang mematuhi di Eropah dan Amerika Syarikat.

Ramalan Harga Worldcoin (WLD) 2025-2031: Adakah WLD akan mencapai $ 4 menjelang 2031?

Apr 21, 2025 pm 02:42 PM

Ramalan Harga Worldcoin (WLD) 2025-2031: Adakah WLD akan mencapai $ 4 menjelang 2031?

Apr 21, 2025 pm 02:42 PM

Worldcoin (WLD) menonjol dalam pasaran cryptocurrency dengan mekanisme pengesahan biometrik dan perlindungan privasi yang unik, menarik perhatian banyak pelabur. WLD telah melakukan yang luar biasa di kalangan altcoin dengan teknologi inovatifnya, terutamanya dalam kombinasi dengan teknologi kecerdasan buatan terbuka. Tetapi bagaimanakah aset digital akan berkelakuan dalam beberapa tahun akan datang? Mari kita meramalkan harga masa depan WLD bersama -sama. Ramalan harga WLD 2025 dijangka mencapai pertumbuhan yang signifikan di WLD pada tahun 2025. Analisis pasaran menunjukkan bahawa harga WLD purata boleh mencapai $ 1.31, dengan maksimum $ 1.36. Walau bagaimanapun, dalam pasaran beruang, harga mungkin jatuh ke sekitar $ 0.55. Harapan pertumbuhan ini disebabkan terutamanya oleh WorldCoin2.

Kedudukan pertukaran leverage dalam lingkaran mata wang Cadangan terkini sepuluh pertukaran leverage dalam lingkaran mata wang

Apr 21, 2025 pm 11:24 PM

Kedudukan pertukaran leverage dalam lingkaran mata wang Cadangan terkini sepuluh pertukaran leverage dalam lingkaran mata wang

Apr 21, 2025 pm 11:24 PM

Platform yang mempunyai prestasi cemerlang dalam perdagangan, keselamatan dan pengalaman pengguna yang dimanfaatkan pada tahun 2025 adalah: 1. Okx, sesuai untuk peniaga frekuensi tinggi, menyediakan sehingga 100 kali leverage; 2. Binance, sesuai untuk peniaga berbilang mata wang di seluruh dunia, memberikan 125 kali leverage tinggi; 3. Gate.io, sesuai untuk pemain derivatif profesional, menyediakan 100 kali leverage; 4. Bitget, sesuai untuk orang baru dan peniaga sosial, menyediakan sehingga 100 kali leverage; 5. Kraken, sesuai untuk pelabur mantap, menyediakan 5 kali leverage; 6. Bybit, sesuai untuk penjelajah altcoin, menyediakan 20 kali leverage; 7. Kucoin, sesuai untuk peniaga kos rendah, menyediakan 10 kali leverage; 8. Bitfinex, sesuai untuk bermain senior

Apakah yang dimaksudkan dengan transaksi rantaian rantaian? Apakah urus niaga salib?

Apr 21, 2025 pm 11:39 PM

Apakah yang dimaksudkan dengan transaksi rantaian rantaian? Apakah urus niaga salib?

Apr 21, 2025 pm 11:39 PM

Pertukaran yang menyokong urus niaga rantaian: 1. Binance, 2. Uniswap, 3 Sushiswap, 4. Kewangan Curve, 5. Thorchain, 6. 1 inci Pertukaran, 7.

Mengapa kenaikan atau kejatuhan harga mata wang maya? Mengapa kenaikan atau kejatuhan harga mata wang maya?

Apr 21, 2025 am 08:57 AM

Mengapa kenaikan atau kejatuhan harga mata wang maya? Mengapa kenaikan atau kejatuhan harga mata wang maya?

Apr 21, 2025 am 08:57 AM

Faktor kenaikan harga mata wang maya termasuk: 1. Peningkatan permintaan pasaran, 2. Menurunkan bekalan, 3. Berita positif yang dirangsang, 4. Sentimen pasaran optimis, 5. Persekitaran makroekonomi; Faktor penurunan termasuk: 1. Mengurangkan permintaan pasaran, 2. Peningkatan bekalan, 3.

Platform Pertukaran Cryptocurrency Top 10 senarai pertukaran mata wang digital terbesar di dunia

Apr 21, 2025 pm 07:15 PM

Platform Pertukaran Cryptocurrency Top 10 senarai pertukaran mata wang digital terbesar di dunia

Apr 21, 2025 pm 07:15 PM

Pertukaran memainkan peranan penting dalam pasaran cryptocurrency hari ini. Mereka bukan sahaja platform untuk pelabur untuk berdagang, tetapi juga sumber kecairan pasaran dan penemuan harga. Pertukaran mata wang maya terbesar di dunia di kalangan sepuluh teratas, dan pertukaran ini bukan sahaja jauh ke hadapan dalam jumlah dagangan, tetapi juga mempunyai kelebihan mereka sendiri dalam pengalaman pengguna, perkhidmatan keselamatan dan inovatif. Pertukaran yang atas senarai biasanya mempunyai pangkalan pengguna yang besar dan pengaruh pasaran yang luas, dan jumlah dagangan dan jenis aset mereka sering sukar dicapai oleh bursa lain.

Apakah sepuluh platform teratas dalam bulatan pertukaran mata wang?

Apr 21, 2025 pm 12:21 PM

Apakah sepuluh platform teratas dalam bulatan pertukaran mata wang?

Apr 21, 2025 pm 12:21 PM

Pertukaran teratas termasuk: 1. Binance, jumlah dagangan terbesar di dunia, menyokong 600 mata wang, dan yuran pengendalian tempat adalah 0.1%; 2. Okx, platform seimbang, menyokong 708 pasangan dagangan, dan yuran pengendalian kontrak kekal adalah 0.05%; 3. Gate.io, meliputi 2700 mata wang kecil, dan yuran pengendalian tempat ialah 0.1%-0.3%; 4. Coinbase, penanda aras pematuhan AS, yuran pengendalian tempat adalah 0.5%; 5. Kraken, keselamatan tertinggi, dan audit rizab tetap.

Cara Memenangi Ganjaran Airdrop Kernel pada Strategi Proses Penuh Binance

Apr 21, 2025 pm 01:03 PM

Cara Memenangi Ganjaran Airdrop Kernel pada Strategi Proses Penuh Binance

Apr 21, 2025 pm 01:03 PM

Dalam dunia kriptografi yang ramai, peluang baru selalu muncul. Pada masa ini, aktiviti udara Kerneldao (kernel) menarik banyak perhatian dan menarik perhatian banyak pelabur. Jadi, apakah asalnya projek ini? Apakah faedah yang boleh diperoleh oleh pemegang BNB? Jangan risau, perkara berikut akan mendedahkannya satu demi satu untuk anda.

Rajah 4: Penyelidik menggunakan Raptor untuk memisahkan latihan selari dan pengiraan ganjaran untuk mengatasi kelewatan sintesis litar.

Rajah 4: Penyelidik menggunakan Raptor untuk memisahkan latihan selari dan pengiraan ganjaran untuk mengatasi kelewatan sintesis litar.