Peranti teknologi

Peranti teknologi

AI

AI

Jangan fikir langkah demi langkah! Algoritma penaakulan bahasa semula jadi terbaru Google LAMBADA: 'Penalaran rantaian terbalik' adalah jawapannya

Jangan fikir langkah demi langkah! Algoritma penaakulan bahasa semula jadi terbaru Google LAMBADA: 'Penalaran rantaian terbalik' adalah jawapannya

Jangan fikir langkah demi langkah! Algoritma penaakulan bahasa semula jadi terbaru Google LAMBADA: 'Penalaran rantaian terbalik' adalah jawapannya

Penaakulan automatik pastinya merupakan masalah besar dalam bidang pemprosesan bahasa semula jadi Model ini perlu membuat kesimpulan yang berkesan dan betul berdasarkan premis dan pengetahuan yang diberikan.

Walaupun bidang NLP telah mencapai prestasi yang sangat tinggi dalam pelbagai tugasan "pemahaman bahasa semula jadi" seperti pemahaman membaca dan menjawab soalan melalui model bahasa pra-latihan berskala besar dalam beberapa tahun kebelakangan ini, ini Prestasi model dalam penaakulan logik masih ketinggalan.

Pada bulan Mei tahun lalu, "Chain of Thought (CoT)" telah dikeluarkan Sesetengah penyelidik mendapati bahawa hanya menambah "Mari kita fikir langkah demi langkah" pada gesaan boleh Prestasi inferens GPT. -3 telah banyak dipertingkatkan. Contohnya, dalam MultiArith, ketepatan inferens telah ditingkatkan daripada 17.7% sebelumnya kepada 78.7%

Tetapi kaedah seperti CoT dan Inferens Pemilihan mempunyai carian It proses pembuktian (bukti) dari aksiom (aksiom) ke arah hadapan untuk mendapatkan kesimpulan akhir (kesimpulan) Terdapat masalah letupan kombinatorial ruang carian, jadi untuk rantaian penaakulan yang lebih panjang, kadar kegagalan adalah lebih tinggi.

Baru-baru ini, Google Research telah membangunkan algoritma Backward Chaining LAMBADA (Language Model augmented BAckwarD chaining), yang menggabungkan "kecekapan penaakulan ke belakang" yang diperoleh daripada literatur penaakulan klasik "Secara ketara lebih tinggi daripada ke hadapan penaakulan." Kesimpulan ini digunakan untuk model bahasa (LM).

Pautan kertas: https://arxiv.org/abs/2212.13894

LAMBADA akan membuat alasan Proses ini diuraikan kepada empat sub-modul, setiap satunya dilaksanakan oleh penaakulan model bahasa yang digesa beberapa kali.

Akhirnya, LAMBADA mencapai peningkatan prestasi yang ketara pada dua set data penaakulan logik berbanding kaedah penaakulan hadapan semasa sota, terutamanya apabila masalah memerlukan rantaian bukti yang mendalam dan tepat. peningkatan prestasi LAMBADA lebih ketara.

"Reverse reasoning" menjadi jawapannya?

Penaakulan logik, terutamanya penaakulan logik pada teks semula jadi yang tidak berstruktur, adalah blok binaan asas untuk penemuan pengetahuan automatik dan kunci kepada kemajuan masa depan dalam pelbagai bidang saintifik.

Walaupun pembangunan banyak tugas NLP telah mendapat manfaat daripada peningkatan skala model bahasa pra-latihan, telah diperhatikan bahawa peningkatan saiz model mempunyai peningkatan yang sangat terhad dalam menyelesaikan kompleks masalah penaakulan.

Dalam kesusasteraan klasik, terdapat dua kaedah penaakulan logik utama:

1 Rantaian Hadapan (FC) ), iaitu bermula dari fakta dan peraturan, berulang antara membuat inferens baru dan menambahnya pada teori sehingga pernyataan sasaran boleh dibuktikan atau disangkal; menguraikannya secara rekursif kepada submatlamat sehingga submatlamat dapat dibuktikan atau diterbalikkan berdasarkan fakta.

Kaedah penaakulan menggunakan model bahasa sebelum ini kebanyakannya menggunakan idea penaakulan rantaian hadapan, yang memerlukan pemilihan subset fakta dan peraturan daripada keseluruhan set, yang mungkin untuk LM sukar kerana ia memerlukan carian gabungan dalam ruang yang besar.

Tambahan pula, memutuskan masa untuk menghentikan carian dan mengisytiharkan bukti gagal juga sangat sukar dalam FC, malah kadangkala memerlukan modul yang dilatih khusus pada label perantaraan.

Malah, kesusasteraan penaakulan automatik klasik sebahagian besarnya menumpukan pada penaakulan rantaian ke belakang atau strategi pengesahan berorientasikan matlamat.

LAMBADALAMBADA bermaksud "Model bahasa yang dipertingkatkan oleh teknologi rantaian terbalik Ia terbukti bahawa BC lebih sesuai untuk penaakulan logik deduktif berasaskan teks.

BC tidak memerlukan sejumlah besar carian gabungan untuk memilih subset dan mempunyai lebih banyak kriteria penghentian semula jadi.

LAMBADA terutamanya menumpukan pada penaakulan automatik tentang fakta, iaitu, pernyataan bahasa semula jadi, seperti "Orang baik adalah merah".

Peraturan ditulis dengan pernyataan bahasa semula jadi, yang boleh ditulis semula dalam bentuk sebagai "jika P maka Q", contohnya "Kasar, orang baik merah" (Kasar, bagus orang merah) boleh Ditulis semula sebagai "Jika seseorang itu kasar dan baik, maka mereka merah" (Jika seseorang itu kasar dan baik, maka mereka merah).

di mana P dipanggil anteseden peraturan, dan Q dipanggil akibat peraturan.

Teori C terdiri daripada fakta F={f1, f2, , fn} dan peraturan R={r1, r2, Matlamat untuk membuktikan atau menyangkal berdasarkan fakta dan peraturan.

Contoh 1, contoh teori dengan watak dan peraturan fiksyen C

F={"Fiona seorang yang baik", Fiona ialah kasar"}

R={"Jika seseorang itu pandai, maka dia adalah orang yang baik", "Orang yang kasar dan baik itu merah", "Menjadi baik dan merah bermakna dia bulat "}.

Berdasarkan teori di atas, seseorang mungkin mahu membuktikan atau menyangkal matlamat, seperti "Fiona merah?"

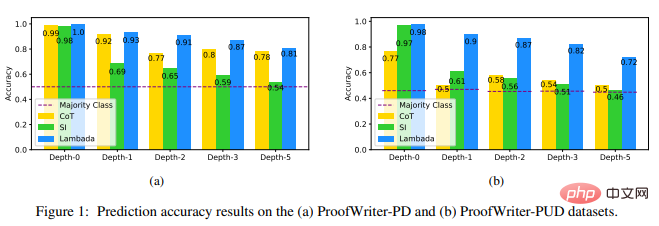

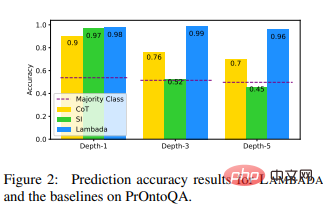

Taakulan rantaian belakangSama ada peraturan digunakan pada matlamat ditentukan melalui operasi yang dipanggil penyatuan dalam logik. Contohnya, untuk matlamat "Fiona merah dalam Contoh 1, akibat peraturan kedua adalah sama dengan matlamat, jadi ia boleh digunakan; daripada dua peraturan lain adalah berbeza , jadi tidak berkenaan. Memandangkan teori dan matlamat dalam Contoh 1, BC mula membuat alasan dari matlamat "Fiona merah?" Pertama, BC mengesahkan sama ada matlamat itu boleh dibuktikan atau dinafikan daripada sebarang fakta. Memandangkan tiada fakta untuk membuktikan atau menafikan matlamat ini, kami seterusnya menyemak sama ada matlamat ini konsisten dengan keputusan mana-mana peraturan, dan didapati ia konsisten dengan peraturan kedua "Orang kasar dan baik merah". Oleh itu, matlamat ini boleh dipecahkan kepada dua sub-matlamat: 1) Adakah Fiona kasar? dan 2) Adakah Fiona seorang yang baik? . Memandangkan kedua-dua submatlamat boleh dibuktikan daripada fakta, BC membuat kesimpulan bahawa matlamat asal boleh dibuktikan. Untuk matlamat, keputusan BC adalah sama ada bukti, penafian atau tidak diketahui (contohnya, matlamat "Fiona bijak?"). Untuk menggunakan BC bagi penaakulan berasaskan teks, penyelidik memperkenalkan empat modul berasaskan LM: Semakan Fakta , Pemilihan Peraturan, Penguraian Matlamat dan Tanda Perjanjian. Semakan fakta Memberi teori Memandangkan satu set fakta F dan matlamat G dalam , matlamat itu dinafikan). Jika fakta sedemikian tidak dapat ditemui, maka kebenaran G tetap tidak diketahui. Pelaksanaan semakan fakta merangkumi dua sub-modul: sub-modul pertama memilih fakta daripada set fakta yang paling relevan dengan sasaran, dan sub-modul kedua mengesahkan sama ada sasaran boleh berdasarkan fakta ini dibuktikan atau disangkal. Memandangkan sub-modul pemilihan fakta mungkin tidak menentukan fakta terbaik pada percubaan pertama, jika kebenaran sasaran masih tidak diketahui selepas satu pusingan memanggil sub-modul, yang dipilih boleh dipadam fakta, dan kemudian memanggil submodul semula proses ini boleh diulang beberapa kali. Pemilihan peraturan Memandangkan satu set peraturan R dan matlamat G dalam teori, modul pemilihan peraturan menentukan Peraturan r∈R menjadikan keputusan r konsisten dengan G, dan kemudian peraturan ini digunakan untuk menguraikan matlamat kepada sub-matlamat. Jika peraturan sedemikian tidak dapat ditentukan, maka kebenaran G tetap tidak diketahui. Pemilihan peraturan juga termasuk dua sub-modul: sub-modul pertama menentukan keputusan setiap peraturan (bebas daripada matlamat), dan sub-modul kedua mengambil keputusan dan matlamat peraturan sebagai input, dan tentukan yang mana satu sejajar dengan matlamat. Perlu diingatkan bahawa disebabkan sifat rekursif BC, modul pemilihan peraturan boleh dipanggil beberapa kali dalam proses membuktikan matlamat. Memandangkan hasil mengenal pasti setiap peraturan adalah bebas daripada sasaran, submodul ini hanya perlu dipanggil sekali. Penguraian Matlamat Memandangkan peraturan r dan matlamat G, jadikan hasil r bersatu dengan G, Modul penguraian matlamat menentukan submatlamat yang perlu dibuktikan supaya G boleh dibuktikan atau disangkal. Dalam kes berjaya membuktikan anteseden r, sama ada sasaran dibuktikan atau tidak dibuktikan bergantung kepada sama ada tanda sasaran adalah konsisten dengan tanda keputusan r. Contohnya, untuk matlamat "Fiona merah?", kerana tanda gol adalah konsisten dengan tanda keputusan peraturan kedua, dan anteseden peraturan itu terbukti , boleh disimpulkan bahawa, Matlamat terbukti. Konsistensi simbolik Memandangkan peraturan r dan matlamat G, modul konsistensi simbolik mengesahkan keputusan r Sama ada simbol itu konsisten atau tidak konsisten dengan simbol sasaran. Bahagian eksperimen Para penyelidik memilih Chain of Thought (CoT), kaedah penaakulan saraf sota berdasarkan penaakulan eksplisit, dan kaedah penaakulan modul sota Inferens Pemilihan (SI) sebagai Bandingkan dengan model garis dasar. Set data percubaan menggunakan ProofWriter dan ProOntoQA Set data ini mencabar untuk inferens LM, mengandungi contoh yang perlu membuktikan panjang rantai sehingga 5 lompatan, dan sasaran tidak boleh diperoleh daripada. teori yang disediakan. Keputusan eksperimen menunjukkan bahawa LAMBADA dengan ketara mengatasi dua garis dasar yang lain, terutamanya pada set data ProofWriter-PUD yang mengandungi label UNKNOWN (44% peningkatan relatif berbanding CoT dan 44% peningkatan relatif berbanding SI pada depth-5 56% peningkatan), dan pada kedalaman PrOntoQA yang lebih tinggi (37% peningkatan relatif berbanding CoT dan peningkatan 113% berbanding SI pada kedalaman -5). Keputusan ini menunjukkan kelebihan LAMBADA dalam penaakulan logik dan juga menunjukkan rantaian ke belakang (dalam LAMBADA ia adalah tulang belakang Inferens ) mungkin pilihan yang lebih baik daripada rantaian hadapan (tulang belakang dalam SI). Keputusan ini juga mendedahkan kecacatan dalam kaedah CoT apabila berurusan dengan label TIDAK DIKENALI: tidak seperti contoh yang dilabelkan sebagai TERBUKTI atau TIDAK TERBUKTI, contohnya yang dilabel TIDAK DIKETAHUI , tidak ada rantaian pemikiran semula jadi. Untuk masalah rantaian bukti yang lebih mendalam (3+), SI menghasilkan ramalan yang hampir dengan ramalan kelas majoriti pada tiga set data. Ia boleh didapati bahawa dalam kes binari, ia cenderung untuk meramalkan terlebih DISPROVED; dalam kes klasifikasi ternary, ia cenderung untuk meramalkan UNKNOWN, yang menjadikannya pada kedalaman PrOntoQA -5 Prestasi dalam adalah lebih teruk daripada kelas majoriti kerana terdapat lebih banyak label TERBUKTI daripada DISPROVED pada kedalaman itu. Walau bagaimanapun, para penyelidik juga terkejut apabila mendapati prestasi CoT pada set data ProofWriterPD masih agak tinggi, dan ketepatannya tidak berkurangan. Ringkasnya, LAMBADA mempunyai ketepatan inferens yang lebih tinggi pada set data ini dan lebih berkemungkinan menghasilkan kesimpulan yang sah berbanding teknik lain yang mencari kesimpulan yang betul dengan jejak bukti palsu, dan juga lebih pertanyaan cekap daripada kaedah penaakulan modular berasaskan LM yang lain. Keputusan eksperimen ini amat mencadangkan bahawa kerja masa hadapan tentang penaakulan dengan LM harus merangkumi rantaian ke belakang atau strategi terarah matlamat, kata para penyelidik. Rujukan: https://arxiv.org/abs/2212.13894Model Bahasa dalam LAMBADA

Atas ialah kandungan terperinci Jangan fikir langkah demi langkah! Algoritma penaakulan bahasa semula jadi terbaru Google LAMBADA: 'Penalaran rantaian terbalik' adalah jawapannya. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1382

1382

52

52

Pengenalan kepada lima kaedah pensampelan dalam tugas penjanaan bahasa semula jadi dan pelaksanaan kod Pytorch

Feb 20, 2024 am 08:50 AM

Pengenalan kepada lima kaedah pensampelan dalam tugas penjanaan bahasa semula jadi dan pelaksanaan kod Pytorch

Feb 20, 2024 am 08:50 AM

Dalam tugas penjanaan bahasa semula jadi, kaedah pensampelan ialah teknik untuk mendapatkan output teks daripada model generatif. Artikel ini akan membincangkan 5 kaedah biasa dan melaksanakannya menggunakan PyTorch. 1. GreedyDecoding Dalam penyahkodan tamak, model generatif meramalkan perkataan urutan keluaran berdasarkan urutan input masa langkah demi masa. Pada setiap langkah masa, model mengira taburan kebarangkalian bersyarat bagi setiap perkataan, dan kemudian memilih perkataan dengan kebarangkalian bersyarat tertinggi sebagai output langkah masa semasa. Perkataan ini menjadi input kepada langkah masa seterusnya, dan proses penjanaan diteruskan sehingga beberapa syarat penamatan dipenuhi, seperti urutan panjang tertentu atau penanda akhir khas. Ciri GreedyDecoding ialah setiap kali kebarangkalian bersyarat semasa adalah yang terbaik

CLIP-BEVFormer: Selia secara eksplisit struktur BEVFormer untuk meningkatkan prestasi pengesanan ekor panjang

Mar 26, 2024 pm 12:41 PM

CLIP-BEVFormer: Selia secara eksplisit struktur BEVFormer untuk meningkatkan prestasi pengesanan ekor panjang

Mar 26, 2024 pm 12:41 PM

Ditulis di atas & pemahaman peribadi penulis: Pada masa ini, dalam keseluruhan sistem pemanduan autonomi, modul persepsi memainkan peranan penting Hanya selepas kenderaan pemanduan autonomi yang memandu di jalan raya memperoleh keputusan persepsi yang tepat melalui modul persepsi boleh Peraturan hiliran dan. modul kawalan dalam sistem pemanduan autonomi membuat pertimbangan dan keputusan tingkah laku yang tepat pada masanya dan betul. Pada masa ini, kereta dengan fungsi pemanduan autonomi biasanya dilengkapi dengan pelbagai penderia maklumat data termasuk penderia kamera pandangan sekeliling, penderia lidar dan penderia radar gelombang milimeter untuk mengumpul maklumat dalam modaliti yang berbeza untuk mencapai tugas persepsi yang tepat. Algoritma persepsi BEV berdasarkan penglihatan tulen digemari oleh industri kerana kos perkakasannya yang rendah dan penggunaan mudah, dan hasil keluarannya boleh digunakan dengan mudah untuk pelbagai tugas hiliran.

Melaksanakan Algoritma Pembelajaran Mesin dalam C++: Cabaran dan Penyelesaian Biasa

Jun 03, 2024 pm 01:25 PM

Melaksanakan Algoritma Pembelajaran Mesin dalam C++: Cabaran dan Penyelesaian Biasa

Jun 03, 2024 pm 01:25 PM

Cabaran biasa yang dihadapi oleh algoritma pembelajaran mesin dalam C++ termasuk pengurusan memori, multi-threading, pengoptimuman prestasi dan kebolehselenggaraan. Penyelesaian termasuk menggunakan penunjuk pintar, perpustakaan benang moden, arahan SIMD dan perpustakaan pihak ketiga, serta mengikuti garis panduan gaya pengekodan dan menggunakan alat automasi. Kes praktikal menunjukkan cara menggunakan perpustakaan Eigen untuk melaksanakan algoritma regresi linear, mengurus memori dengan berkesan dan menggunakan operasi matriks berprestasi tinggi.

Terokai prinsip asas dan pemilihan algoritma bagi fungsi isihan C++

Apr 02, 2024 pm 05:36 PM

Terokai prinsip asas dan pemilihan algoritma bagi fungsi isihan C++

Apr 02, 2024 pm 05:36 PM

Lapisan bawah fungsi C++ sort menggunakan isihan gabungan, kerumitannya ialah O(nlogn), dan menyediakan pilihan algoritma pengisihan yang berbeza, termasuk isihan pantas, isihan timbunan dan isihan stabil.

Bolehkah kecerdasan buatan meramalkan jenayah? Terokai keupayaan CrimeGPT

Mar 22, 2024 pm 10:10 PM

Bolehkah kecerdasan buatan meramalkan jenayah? Terokai keupayaan CrimeGPT

Mar 22, 2024 pm 10:10 PM

Konvergensi kecerdasan buatan (AI) dan penguatkuasaan undang-undang membuka kemungkinan baharu untuk pencegahan dan pengesanan jenayah. Keupayaan ramalan kecerdasan buatan digunakan secara meluas dalam sistem seperti CrimeGPT (Teknologi Ramalan Jenayah) untuk meramal aktiviti jenayah. Artikel ini meneroka potensi kecerdasan buatan dalam ramalan jenayah, aplikasi semasanya, cabaran yang dihadapinya dan kemungkinan implikasi etika teknologi tersebut. Kecerdasan Buatan dan Ramalan Jenayah: Asas CrimeGPT menggunakan algoritma pembelajaran mesin untuk menganalisis set data yang besar, mengenal pasti corak yang boleh meramalkan di mana dan bila jenayah mungkin berlaku. Set data ini termasuk statistik jenayah sejarah, maklumat demografi, penunjuk ekonomi, corak cuaca dan banyak lagi. Dengan mengenal pasti trend yang mungkin terlepas oleh penganalisis manusia, kecerdasan buatan boleh memperkasakan agensi penguatkuasaan undang-undang

Algoritma pengesanan yang dipertingkatkan: untuk pengesanan sasaran dalam imej penderiaan jauh optik resolusi tinggi

Jun 06, 2024 pm 12:33 PM

Algoritma pengesanan yang dipertingkatkan: untuk pengesanan sasaran dalam imej penderiaan jauh optik resolusi tinggi

Jun 06, 2024 pm 12:33 PM

01Garis prospek Pada masa ini, sukar untuk mencapai keseimbangan yang sesuai antara kecekapan pengesanan dan hasil pengesanan. Kami telah membangunkan algoritma YOLOv5 yang dipertingkatkan untuk pengesanan sasaran dalam imej penderiaan jauh optik resolusi tinggi, menggunakan piramid ciri berbilang lapisan, strategi kepala pengesanan berbilang dan modul perhatian hibrid untuk meningkatkan kesan rangkaian pengesanan sasaran dalam imej penderiaan jauh optik. Menurut set data SIMD, peta algoritma baharu adalah 2.2% lebih baik daripada YOLOv5 dan 8.48% lebih baik daripada YOLOX, mencapai keseimbangan yang lebih baik antara hasil pengesanan dan kelajuan. 02 Latar Belakang & Motivasi Dengan perkembangan pesat teknologi penderiaan jauh, imej penderiaan jauh optik resolusi tinggi telah digunakan untuk menggambarkan banyak objek di permukaan bumi, termasuk pesawat, kereta, bangunan, dll. Pengesanan objek dalam tafsiran imej penderiaan jauh

Amalkan dan fikirkan platform model besar berbilang modal Jiuzhang Yunji DataCanvas

Oct 20, 2023 am 08:45 AM

Amalkan dan fikirkan platform model besar berbilang modal Jiuzhang Yunji DataCanvas

Oct 20, 2023 am 08:45 AM

1. Perkembangan sejarah model besar pelbagai mod Gambar di atas adalah bengkel kecerdasan buatan pertama yang diadakan di Kolej Dartmouth di Amerika Syarikat pada tahun 1956. Persidangan ini juga dianggap telah memulakan pembangunan kecerdasan buatan perintis logik simbolik (kecuali ahli neurobiologi Peter Milner di tengah-tengah barisan hadapan). Walau bagaimanapun, teori logik simbolik ini tidak dapat direalisasikan untuk masa yang lama, malah memulakan musim sejuk AI pertama pada 1980-an dan 1990-an. Sehingga pelaksanaan model bahasa besar baru-baru ini, kami mendapati bahawa rangkaian saraf benar-benar membawa pemikiran logik ini. Kerja ahli neurobiologi Peter Milner memberi inspirasi kepada pembangunan rangkaian saraf tiruan yang seterusnya, dan atas sebab inilah dia dijemput untuk mengambil bahagian. dalam projek ini.

Kejuruteraan Trafik menggandakan ketepatan penjanaan kod: daripada 19% kepada 44%

Feb 05, 2024 am 09:15 AM

Kejuruteraan Trafik menggandakan ketepatan penjanaan kod: daripada 19% kepada 44%

Feb 05, 2024 am 09:15 AM

Pengarang kertas baharu mencadangkan cara untuk "meningkatkan" penjanaan kod. Penjanaan kod ialah keupayaan yang semakin penting dalam kecerdasan buatan. Ia secara automatik menjana kod komputer berdasarkan penerangan bahasa semula jadi dengan melatih model pembelajaran mesin. Teknologi ini mempunyai prospek aplikasi yang luas dan boleh mengubah spesifikasi perisian kepada kod yang boleh digunakan, mengautomasikan pembangunan bahagian belakang dan membantu pengaturcara manusia untuk meningkatkan kecekapan kerja. Walau bagaimanapun, menjana kod berkualiti tinggi masih mencabar untuk sistem AI, berbanding dengan tugas bahasa seperti terjemahan atau ringkasan. Kod mesti mematuhi sintaks bahasa pengaturcaraan sasaran dengan tepat, mengendalikan kes tepi dan input yang tidak dijangka dengan anggun, dan mengendalikan banyak butiran kecil perihalan masalah dengan tepat. Malah pepijat kecil yang mungkin kelihatan tidak berbahaya di kawasan lain boleh mengganggu sepenuhnya kefungsian program, menyebabkan