Peranti teknologi

Peranti teknologi

AI

AI

NeurIPS 2022 |. DetCLIP, kaedah pengesanan domain terbuka baharu, meningkatkan kecekapan penaakulan sebanyak 20 kali ganda

NeurIPS 2022 |. DetCLIP, kaedah pengesanan domain terbuka baharu, meningkatkan kecekapan penaakulan sebanyak 20 kali ganda

NeurIPS 2022 |. DetCLIP, kaedah pengesanan domain terbuka baharu, meningkatkan kecekapan penaakulan sebanyak 20 kali ganda

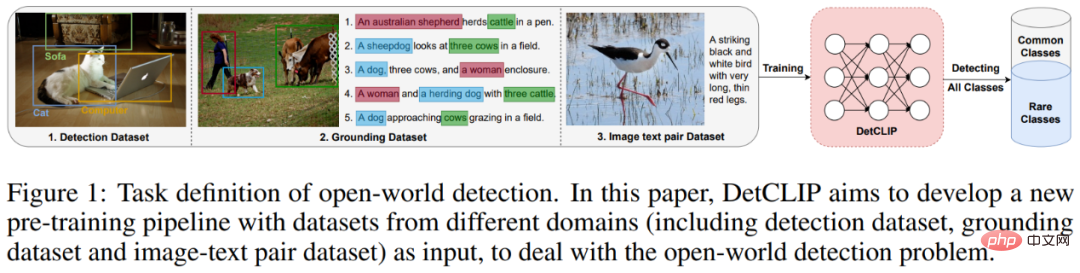

Masalah pengesanan domain terbuka merujuk kepada masalah bagaimana untuk melaksanakan pengesanan kategori sewenang-wenang dalam senario hiliran dengan menggunakan sebilangan besar pasangan teks imej yang dirangkak dari Internet atau kategori tertentu data berlabel manual untuk latihan dalam ke hulu. Aplikasi kaedah pengesanan domain terbuka dalam industri terutamanya termasuk pengesanan objek jalan dalam sistem pemanduan autonomi, pengesanan pemandangan penuh awan, dsb.

Alamat kertas: https://arxiv.org/abs/2209.09407

Artikel ini berkongsi kertas pilihan NeurIPS 2022 "DetCLIP: Dictionary-Enriched Visual-Concept Paralleled Pra-latihan untuk Pengesanan Dunia Terbuka". Rangka kerja latihan selari, sambil membina pangkalan pengetahuan tambahan untuk menyediakan hubungan tersirat antara kategori. Pada masa yang sama, DetCLIP memenangi tempat pertama dalam trek pengesanan sifar pukulan dengan indeks pengesanan purata 24.9% dalam pertandingan ECCV2022 OdinW (Pengesanan Objek di Alam Liar[1]) yang dianjurkan oleh Microsoft.

Pengenalan Masalah

Dengan populariti model pra-latihan berbilang modal (seperti CLIP) yang dilatih berdasarkan pasangan imej dan teks yang dirangkak dari Internet, dan penggunaan dalam zero -shot telah menunjukkan prestasi cemerlang dalam bidang pengelasan, dan semakin banyak kaedah cuba memindahkan keupayaan ini kepada ramalan padat domain terbuka (seperti pengesanan kategori arbitrari, segmentasi, dll.). Kaedah sedia ada sering menggunakan model klasifikasi besar yang telah dilatih untuk penyulingan tahap ciri [1] atau belajar dengan kapsyen pelabelan pseudo dan latihan kendiri [2], tetapi ini sering dihadkan oleh prestasi model pengelasan yang besar anotasi kapsyen tidak lengkap.

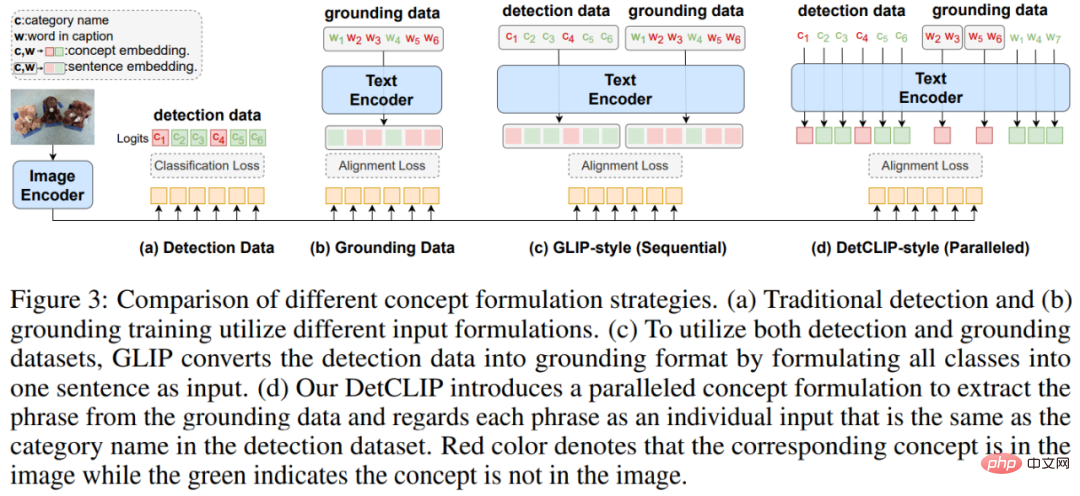

Model pengesanan domain terbuka SOTA sedia ada GLIP[3] melaksanakan latihan bersama berbilang sumber data dengan menukar format data pengesanan kepada format data Pembumian, memanfaatkan sepenuhnya kelebihan sumber data yang berbeza (Set data pengesanan mempunyai anotasi yang agak lengkap untuk kategori biasa, manakala set data Pembumian mempunyai julat selang liputan kategori yang lebih luas). Walau bagaimanapun, kami mendapati bahawa cara menggabungkan kata nama kategori membawa kepada pengurangan kecekapan pembelajaran keseluruhan model, manakala secara langsung menggunakan kata kategori sebagai input teks tidak dapat memberikan perhubungan a priori yang halus antara kategori.

Rajah 1: Rangkaian model pengesanan domain terbuka pra-latihan bersama sumber berbilang data

Rangka kerja model

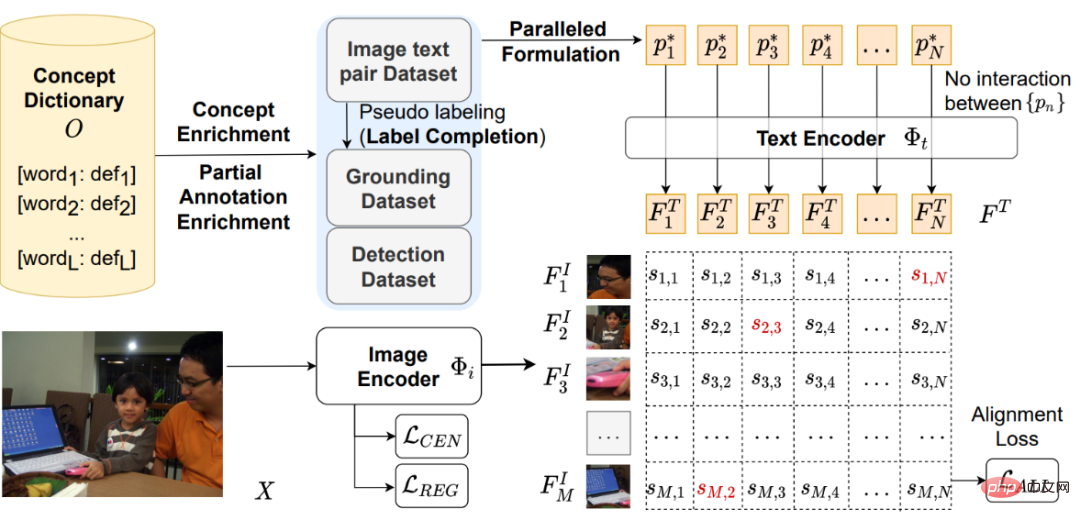

Seperti yang ditunjukkan dalam rajah di bawah, berdasarkan model pengesanan satu peringkat ATSS[4], DetCLIP menyertakan pengekod imej untuk mendapatkan ciri imej kotak pengesanan, dan pengekod teks untuk mendapatkan ciri teks kategori. Kemudian berdasarkan ciri imej dan ciri teks di atas, kehilangan penjajaran klasifikasi yang sepadan , kehilangan titik tengah dan kehilangan regresi .

Rajah 2: Rangka kerja model DetCLIP

Seperti yang ditunjukkan di bahagian atas kanan dan kiri atas Rajah 2, inovasi utama artikel ini ialah 1) mencadangkan rangka kerja untuk memproses latihan bersama objek-teks berbilang data dengan input selari untuk mengoptimumkan kecekapan latihan; pangkalan pengetahuan objek untuk membantu latihan Pengesanan domain terbuka.

Berbilang sumber data rangka kerja pra-latihan input selari

Berbanding dengan GLIP, yang menukar data pengesanan kepada bentuk pembumian (siri) dengan menyambung kata nama kategori, kami menggunakan Extract frasa nama yang sepadan dalam data asas dan kategori dalam pengesanan sebagai input bebas dan masukkannya ke dalam pengekod teks (sejajar) untuk mengelakkan pengiraan perhatian yang tidak perlu dan mencapai kecekapan latihan yang lebih tinggi.

Rajah 3: Perbandingan antara rangka kerja pra-latihan input selari DetCLIP dan GLIP

Perpustakaan pengetahuan objek

Untuk menyelesaikan masalah ruang kategori tidak seragam dalam sumber data yang berbeza (nama kategori yang sama adalah berbeza, atau kategori disertakan, dsb.) dan untuk menyediakan maklumat priori untuk perhubungan antara kategori, kami membina pangkalan pengetahuan objek untuk mencapai latihan yang lebih cekap.

Pembinaan: Kami serentak mensintesis kategori dalam data pengesanan, frasa nama dalam pasangan teks imej dan takrifan yang sepadan untuk membina pangkalan pengetahuan objek.

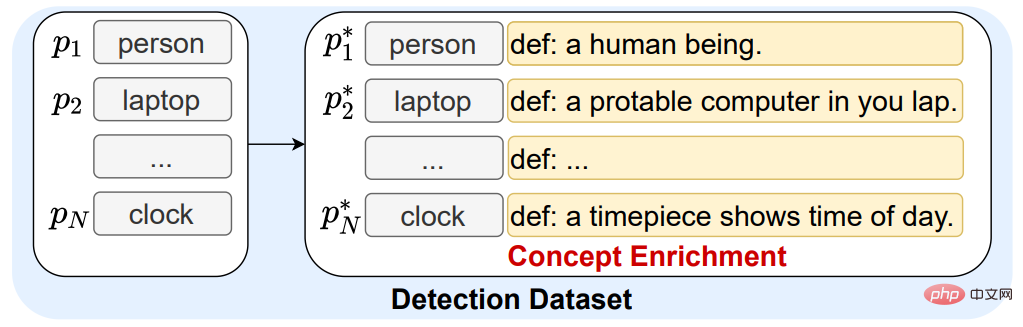

Penggunaan: 1. Kami menggunakan definisi pangkalan pengetahuan objek untuk mengembangkan perkataan kategori dalam data pengesanan sedia ada untuk memberikan maklumat priori tentang hubungan antara kategori (Pengayaan Konsep) .

Rajah 4: Contoh mengembangkan definisi kata kategori menggunakan pangkalan pengetahuan objek

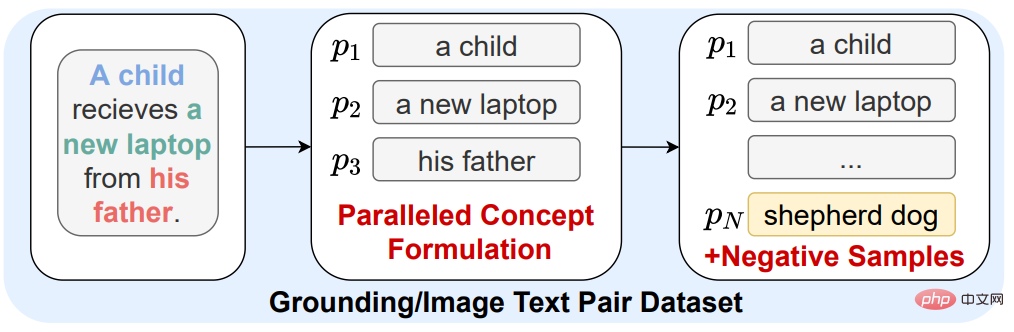

2. Disebabkan masalah anotasi kapsyen yang tidak lengkap dalam data pembumian dan data kapsyen imej (kategori yang muncul pada imej tidak muncul dalam kapsyen), imej ini boleh digunakan sebagai negatif sampel semasa latihan Bilangan kategori adalah sangat kecil, yang menjadikan model kurang dapat dibezakan untuk beberapa kategori yang tidak biasa. Oleh itu, kami secara rawak memilih kata nama objek daripada pangkalan pengetahuan objek sebagai kategori sampel negatif untuk meningkatkan diskriminasi model ciri kategori jarang (+Sampel Negatif).

Rajah 5: Memperkenalkan kategori dalam pangkalan pengetahuan objek sebagai kategori sampel negatif

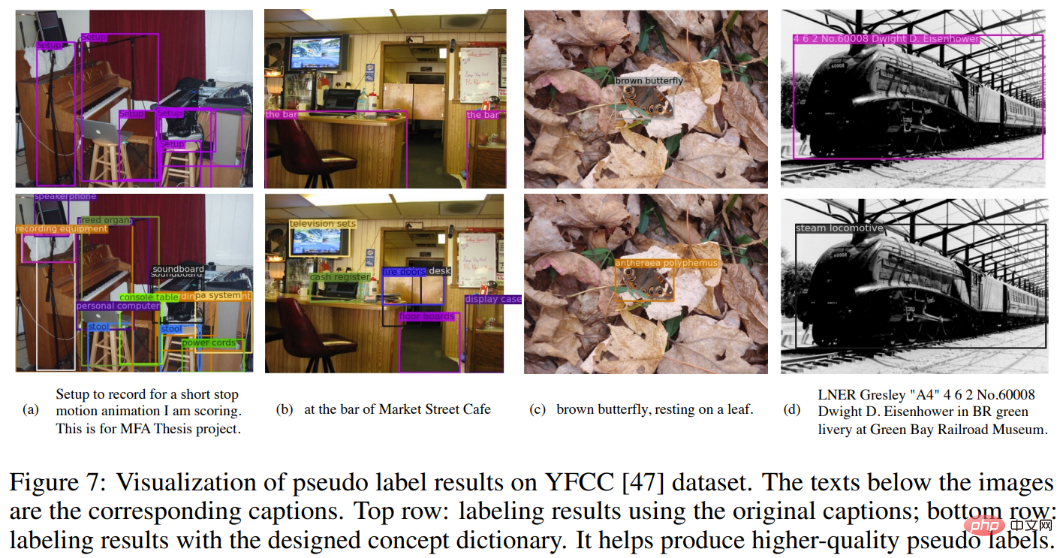

3 Untuk data pasangan imej-teks beranotasi tanpa bingkai, kami menggunakan model besar FILIP [5] yang dibangunkan sendiri oleh Huawei Noah dan RPN yang telah dilatih untuk menganotasinya supaya ia boleh diubah Latih pada normal. data pembumian. Pada masa yang sama, untuk mengurangkan masalah anotasi objek yang tidak lengkap dalam gambar dalam kapsyen, kami menggunakan semua frasa kategori dalam pangkalan pengetahuan objek sebagai kategori calon untuk pelabelan pseudo (baris kedua), dan hanya menggunakan kategori kesan anotasi dalam kapsyen (baris pertama) Perbandingannya adalah seperti berikut:

Rajah 6: Memperkenalkan kategori dalam pangkalan pengetahuan objek sebagai kategori calon untuk pelabelan palsu

Hasil eksperimen

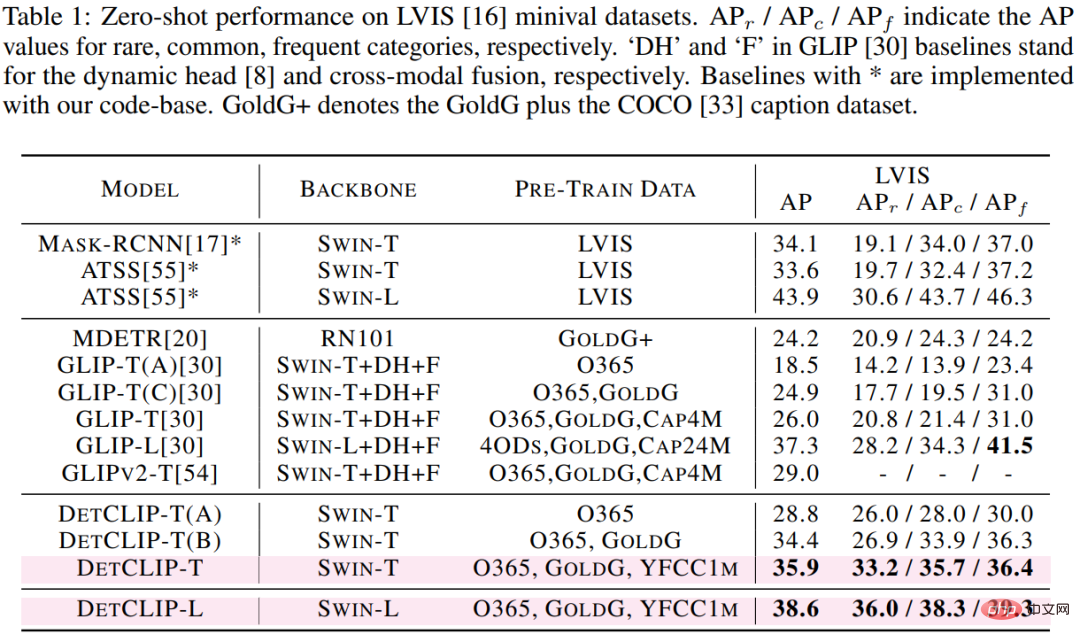

Kami mengesahkan prestasi pengesanan domain terbuka bagi kaedah yang dicadangkan pada set data pengesanan LVIS hiliran (1203 kategori), seperti yang dapat dilihat Berdasarkan seni bina berasaskan tulang belakang swin-t, DetCLIP telah mencapai peningkatan AP sebanyak 9.9% berbanding model GLIP SOTA sedia ada, dan peningkatan AP sebanyak 12.4% dalam Rare. kategori, walaupun kami hanya menggunakan kurang daripada separuh daripada AP berbanding volum Data GLIP, sila ambil perhatian bahawa set latihan tidak mengandungi sebarang imej dalam LVIS.

Jadual 1: Perbandingan prestasi pemindahan Zero-shot bagi kaedah berbeza pada LVIS

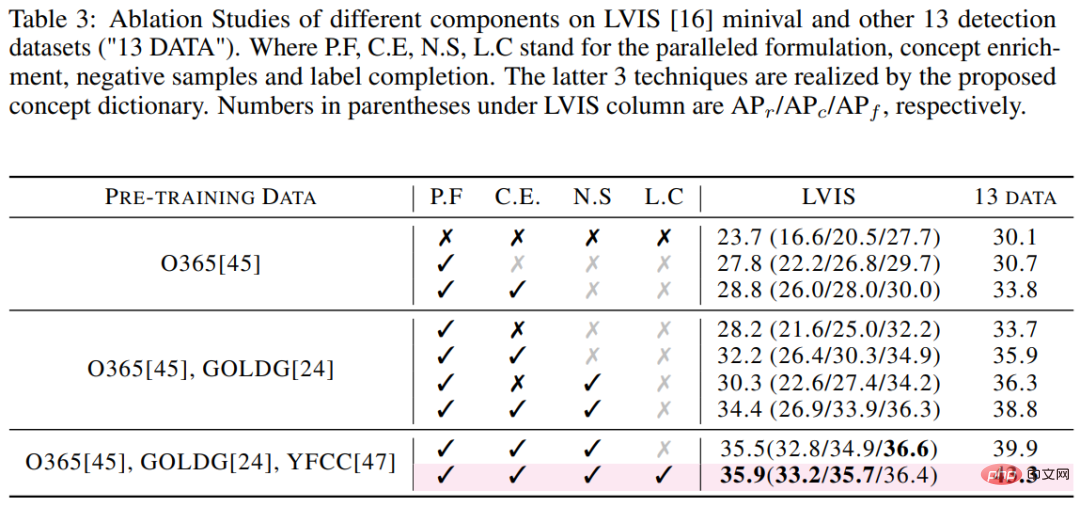

Dari segi kecekapan latihan, berdasarkan keadaan perkakasan yang sama iaitu 32 V100s, masa latihan GLIP-T ialah 5 kali ganda daripada DetCLIP-T (10.7K GPU jam lwn. 2.0K jam GPU). Dari segi kecekapan ujian, berdasarkan V100 tunggal, kecekapan inferens DetCLIP-T sebanyak 2.3 FPS (0.4 saat setiap imej) adalah 20 kali lebih tinggi daripada 0.12 FPS GLIP-T (8.6 saat setiap imej). Kami juga mengkaji secara berasingan kesan inovasi utama DetCLIP (rangka kerja selari dan pangkalan pengetahuan objek) terhadap ketepatan.

Jadual 3: Keputusan kajian ablasi DetCLIP pada dataset LVIS

Visualisasi Hasilnya

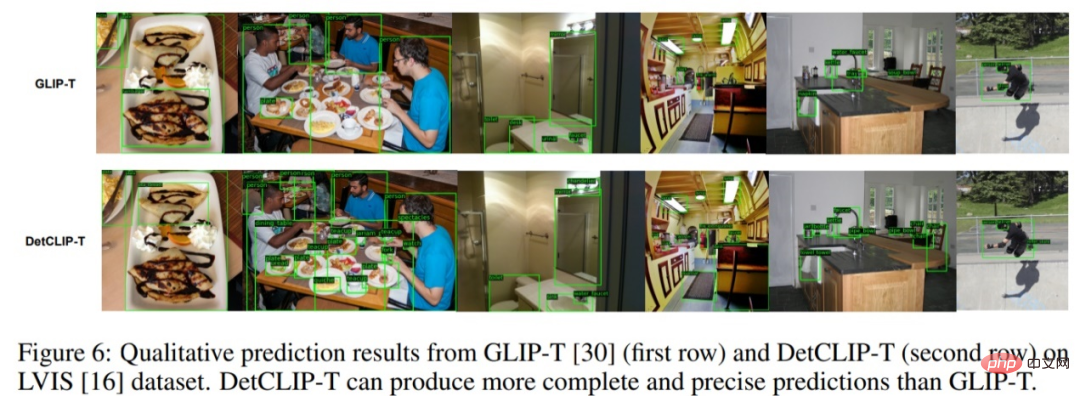

Seperti yang ditunjukkan dalam rajah di bawah, berdasarkan tulang belakang swin-t yang sama, kesan visualisasi pada set data LVIS telah dipertingkatkan dengan ketara berbanding GLIP, terutamanya dalam anotasi kategori jarang dan Kesempurnaan daripada anotasi.

Rajah 7: Perbandingan visual hasil ramalan DetCLIP dan GLIP pada set data LVIS

Atas ialah kandungan terperinci NeurIPS 2022 |. DetCLIP, kaedah pengesanan domain terbuka baharu, meningkatkan kecekapan penaakulan sebanyak 20 kali ganda. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1393

1393

52

52

1207

1207

24

24

Gunakan ddrescue untuk memulihkan data pada Linux

Mar 20, 2024 pm 01:37 PM

Gunakan ddrescue untuk memulihkan data pada Linux

Mar 20, 2024 pm 01:37 PM

DDREASE ialah alat untuk memulihkan data daripada fail atau peranti sekat seperti cakera keras, SSD, cakera RAM, CD, DVD dan peranti storan USB. Ia menyalin data dari satu peranti blok ke peranti lain, meninggalkan blok data yang rosak dan hanya memindahkan blok data yang baik. ddreasue ialah alat pemulihan yang berkuasa yang automatik sepenuhnya kerana ia tidak memerlukan sebarang gangguan semasa operasi pemulihan. Selain itu, terima kasih kepada fail peta ddasue, ia boleh dihentikan dan disambung semula pada bila-bila masa. Ciri-ciri utama lain DDREASE adalah seperti berikut: Ia tidak menimpa data yang dipulihkan tetapi mengisi jurang sekiranya pemulihan berulang. Walau bagaimanapun, ia boleh dipotong jika alat itu diarahkan untuk melakukannya secara eksplisit. Pulihkan data daripada berbilang fail atau blok kepada satu

Sumber terbuka! Di luar ZoeDepth! DepthFM: Anggaran kedalaman monokular yang cepat dan tepat!

Apr 03, 2024 pm 12:04 PM

Sumber terbuka! Di luar ZoeDepth! DepthFM: Anggaran kedalaman monokular yang cepat dan tepat!

Apr 03, 2024 pm 12:04 PM

0. Apakah fungsi artikel ini? Kami mencadangkan DepthFM: model anggaran kedalaman monokular generatif yang serba boleh dan pantas. Sebagai tambahan kepada tugas anggaran kedalaman tradisional, DepthFM juga menunjukkan keupayaan terkini dalam tugas hiliran seperti mengecat kedalaman. DepthFM cekap dan boleh mensintesis peta kedalaman dalam beberapa langkah inferens. Mari kita baca karya ini bersama-sama ~ 1. Tajuk maklumat kertas: DepthFM: FastMonocularDepthEstimationwithFlowMatching Pengarang: MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Cara menggunakan fungsi penapis Excel dengan berbilang syarat

Feb 26, 2024 am 10:19 AM

Cara menggunakan fungsi penapis Excel dengan berbilang syarat

Feb 26, 2024 am 10:19 AM

Jika anda perlu tahu cara menggunakan penapisan dengan berbilang kriteria dalam Excel, tutorial berikut akan membimbing anda melalui langkah-langkah untuk memastikan anda boleh menapis dan mengisih data anda dengan berkesan. Fungsi penapisan Excel sangat berkuasa dan boleh membantu anda mengekstrak maklumat yang anda perlukan daripada sejumlah besar data. Fungsi ini boleh menapis data mengikut syarat yang anda tetapkan dan memaparkan hanya bahagian yang memenuhi syarat, menjadikan pengurusan data lebih cekap. Dengan menggunakan fungsi penapis, anda boleh mencari data sasaran dengan cepat, menjimatkan masa dalam mencari dan menyusun data. Fungsi ini bukan sahaja boleh digunakan pada senarai data ringkas, tetapi juga boleh ditapis berdasarkan berbilang syarat untuk membantu anda mencari maklumat yang anda perlukan dengan lebih tepat. Secara keseluruhan, fungsi penapisan Excel adalah sangat berguna

Google gembira: prestasi JAX mengatasi Pytorch dan TensorFlow! Ia mungkin menjadi pilihan terpantas untuk latihan inferens GPU

Apr 01, 2024 pm 07:46 PM

Google gembira: prestasi JAX mengatasi Pytorch dan TensorFlow! Ia mungkin menjadi pilihan terpantas untuk latihan inferens GPU

Apr 01, 2024 pm 07:46 PM

Prestasi JAX, yang dipromosikan oleh Google, telah mengatasi Pytorch dan TensorFlow dalam ujian penanda aras baru-baru ini, menduduki tempat pertama dalam 7 penunjuk. Dan ujian tidak dilakukan pada TPU dengan prestasi JAX terbaik. Walaupun dalam kalangan pembangun, Pytorch masih lebih popular daripada Tensorflow. Tetapi pada masa hadapan, mungkin lebih banyak model besar akan dilatih dan dijalankan berdasarkan platform JAX. Model Baru-baru ini, pasukan Keras menanda aras tiga hujung belakang (TensorFlow, JAX, PyTorch) dengan pelaksanaan PyTorch asli dan Keras2 dengan TensorFlow. Pertama, mereka memilih satu set arus perdana

Kelajuan Internet Data Selular Perlahan pada iPhone: Pembetulan

May 03, 2024 pm 09:01 PM

Kelajuan Internet Data Selular Perlahan pada iPhone: Pembetulan

May 03, 2024 pm 09:01 PM

Menghadapi ketinggalan, sambungan data mudah alih perlahan pada iPhone? Biasanya, kekuatan internet selular pada telefon anda bergantung pada beberapa faktor seperti rantau, jenis rangkaian selular, jenis perayauan, dsb. Terdapat beberapa perkara yang boleh anda lakukan untuk mendapatkan sambungan Internet selular yang lebih pantas dan boleh dipercayai. Betulkan 1 – Paksa Mulakan Semula iPhone Kadangkala, paksa memulakan semula peranti anda hanya menetapkan semula banyak perkara, termasuk sambungan selular. Langkah 1 – Hanya tekan kekunci naikkan kelantangan sekali dan lepaskan. Seterusnya, tekan kekunci Turun Kelantangan dan lepaskannya semula. Langkah 2 - Bahagian seterusnya proses adalah untuk menahan butang di sebelah kanan. Biarkan iPhone selesai dimulakan semula. Dayakan data selular dan semak kelajuan rangkaian. Semak semula Betulkan 2 – Tukar mod data Walaupun 5G menawarkan kelajuan rangkaian yang lebih baik, ia berfungsi lebih baik apabila isyarat lemah

Daya hidup kecerdasan super membangkitkan! Tetapi dengan kedatangan AI yang mengemas kini sendiri, ibu tidak perlu lagi bimbang tentang kesesakan data

Apr 29, 2024 pm 06:55 PM

Daya hidup kecerdasan super membangkitkan! Tetapi dengan kedatangan AI yang mengemas kini sendiri, ibu tidak perlu lagi bimbang tentang kesesakan data

Apr 29, 2024 pm 06:55 PM

Saya menangis hingga mati. Dunia sedang membina model besar. Data di Internet tidak mencukupi. Model latihan kelihatan seperti "The Hunger Games", dan penyelidik AI di seluruh dunia bimbang tentang cara memberi makan data ini kepada pemakan yang rakus. Masalah ini amat ketara dalam tugas berbilang modal. Pada masa mereka mengalami kerugian, pasukan pemula dari Jabatan Universiti Renmin China menggunakan model baharu mereka sendiri untuk menjadi yang pertama di China untuk menjadikan "suapan data yang dijana model itu sendiri" menjadi kenyataan. Selain itu, ia merupakan pendekatan serampang dua mata dari segi pemahaman dan sisi penjanaan Kedua-dua pihak boleh menjana data baharu berbilang modal yang berkualiti tinggi dan memberikan maklum balas data kepada model itu sendiri. Apakah model? Awaker 1.0, model berbilang modal besar yang baru sahaja muncul di Forum Zhongguancun. Siapa pasukan itu? Enjin Sophon. Diasaskan oleh Gao Yizhao, pelajar kedoktoran di Sekolah Kecerdasan Buatan Hillhouse Universiti Renmin.

Robot Tesla bekerja di kilang, Musk: Tahap kebebasan tangan akan mencapai 22 tahun ini!

May 06, 2024 pm 04:13 PM

Robot Tesla bekerja di kilang, Musk: Tahap kebebasan tangan akan mencapai 22 tahun ini!

May 06, 2024 pm 04:13 PM

Video terbaru robot Tesla Optimus dikeluarkan, dan ia sudah boleh berfungsi di kilang. Pada kelajuan biasa, ia mengisih bateri (bateri 4680 Tesla) seperti ini: Pegawai itu juga mengeluarkan rupanya pada kelajuan 20x - pada "stesen kerja" kecil, memilih dan memilih dan memilih: Kali ini ia dikeluarkan Salah satu sorotan video itu ialah Optimus menyelesaikan kerja ini di kilang, sepenuhnya secara autonomi, tanpa campur tangan manusia sepanjang proses. Dan dari perspektif Optimus, ia juga boleh mengambil dan meletakkan bateri yang bengkok, memfokuskan pada pembetulan ralat automatik: Berkenaan tangan Optimus, saintis NVIDIA Jim Fan memberikan penilaian yang tinggi: Tangan Optimus adalah robot lima jari di dunia paling cerdik. Tangannya bukan sahaja boleh disentuh

Robot pertama yang menyelesaikan tugas manusia secara autonomi muncul, dengan lima jari fleksibel dan kelajuan manusia luar biasa, dan model besar menyokong latihan angkasa maya

Mar 11, 2024 pm 12:10 PM

Robot pertama yang menyelesaikan tugas manusia secara autonomi muncul, dengan lima jari fleksibel dan kelajuan manusia luar biasa, dan model besar menyokong latihan angkasa maya

Mar 11, 2024 pm 12:10 PM

Minggu ini, FigureAI, sebuah syarikat robotik yang dilaburkan oleh OpenAI, Microsoft, Bezos, dan Nvidia, mengumumkan bahawa ia telah menerima hampir $700 juta dalam pembiayaan dan merancang untuk membangunkan robot humanoid yang boleh berjalan secara bebas dalam tahun hadapan. Dan Optimus Prime Tesla telah berulang kali menerima berita baik. Tiada siapa yang meragui bahawa tahun ini akan menjadi tahun apabila robot humanoid meletup. SanctuaryAI, sebuah syarikat robotik yang berpangkalan di Kanada, baru-baru ini mengeluarkan robot humanoid baharu, Phoenix. Pegawai mendakwa bahawa ia boleh menyelesaikan banyak tugas secara autonomi pada kelajuan yang sama seperti manusia. Pheonix, robot pertama di dunia yang boleh menyelesaikan tugas secara autonomi pada kelajuan manusia, boleh mencengkam, menggerakkan dan meletakkan setiap objek secara elegan di sisi kiri dan kanannya dengan perlahan. Ia boleh mengenal pasti objek secara autonomi