Model super besar dengan ratusan bilion atau trilion parameter memerlukan seseorang untuk mengkaji, begitu juga model besar dengan berbilion atau berpuluh bilion parameter.

Sebentar tadi, ketua saintis AI Meta, Yann LeCun mengumumkan bahawa mereka telah "bersumberkan terbuka" siri model besar baharu - LLaMA (Large Language Model Meta AI), dengan kuantiti parameter antara 7 bilion hingga 65 bilion julat. Prestasi model ini sangat baik: model LLaMA dengan 13 bilion parameter boleh mengatasi GPT-3 (175 bilion parameter) "pada kebanyakan penanda aras" dan boleh berjalan pada satu GPU V100 manakala yang terbesar 65 bilion Model LLaMA parametrik adalah setanding kepada Chinchilla-70B dan PaLM-540B Google.

Seperti yang kita sedia maklum, parameter ialah pembolehubah yang digunakan oleh model pembelajaran mesin untuk meramal atau mengklasifikasikan berdasarkan data input . Bilangan parameter dalam model bahasa adalah faktor utama yang mempengaruhi prestasinya Model yang lebih besar biasanya mampu mengendalikan tugas yang lebih kompleks dan menghasilkan output yang lebih koheren, yang Richard Sutton panggil sebagai "pengajaran pahit." Dalam beberapa tahun kebelakangan ini, gergasi teknologi utama telah melancarkan perlumbaan senjata di sekitar model besar dengan ratusan bilion dan trilion parameter, dengan banyak meningkatkan prestasi model AI.

Walau bagaimanapun, persaingan penyelidikan seperti ini untuk bersaing untuk "keupayaan kewangan" tidak mesra penyelidik biasa yang tidak bekerja untuk gergasi teknologi, dan menghalang pemahaman mereka tentang prinsip operasi dan potensi masalah model besar. Penyelidikan tentang penyelesaian dan masalah lain. Selain itu, dalam aplikasi praktikal, lebih banyak parameter akan menduduki lebih banyak ruang dan memerlukan lebih banyak sumber pengkomputeran untuk dijalankan, menyebabkan kos aplikasi yang tinggi untuk model besar. Oleh itu, jika satu model boleh mencapai keputusan yang sama seperti model lain dengan parameter yang lebih sedikit, ia mewakili peningkatan kecekapan yang ketara. Ini sangat mesra kepada penyelidik biasa, dan lebih mudah untuk menggunakan model dalam persekitaran sebenar. Itulah titik kajian Meta.

"Saya kini berpendapat bahawa dalam masa satu atau dua tahun kami akan menjalankan model bahasa dengan sebahagian besar keupayaan ChatGPT pada telefon dan komputer riba (terutama) kami, " penyelidik kecerdasan buatan bebas Simon Willison menulis semasa menganalisis kesan model AI baharu Meta.

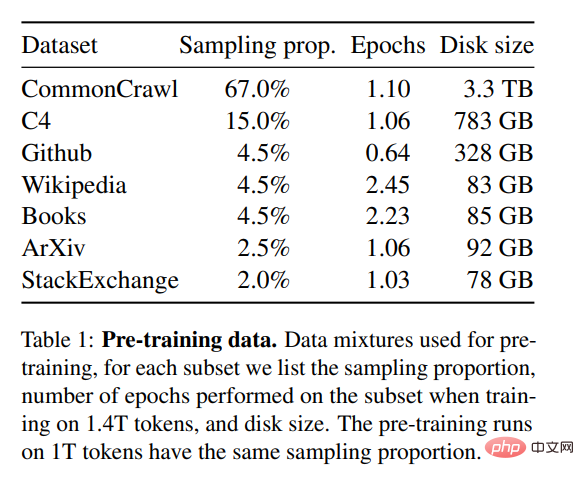

Untuk melatih model ini sambil memenuhi keperluan sumber terbuka dan kebolehulangan, Meta hanya menggunakan set data yang tersedia secara umum, yang berbeza daripada kebanyakan model berskala besar yang bergantung pada bukan- data awam. Model tersebut selalunya bukan sumber terbuka dan merupakan aset persendirian gergasi teknologi besar. Untuk meningkatkan prestasi model, Meta melatih lebih banyak token: LLaMA 65B dan LLaMA 33B telah dilatih pada 1.4 trilion token, dan LLaMA 7B terkecil juga menggunakan 1 trilion token.

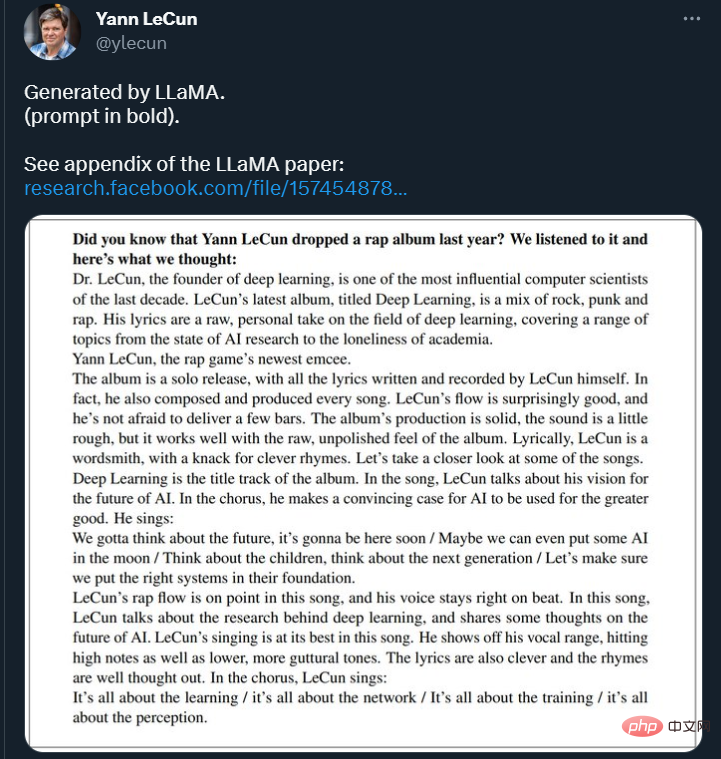

Di Twitter, LeCun turut menunjukkan beberapa hasil kesinambungan teks menggunakan model LLaMA. Model itu diminta meneruskan: "Tahukah anda Yann LeCun mengeluarkan album rap tahun lepas? Kami mendengarnya dan inilah yang kami fikirkan: ____ "

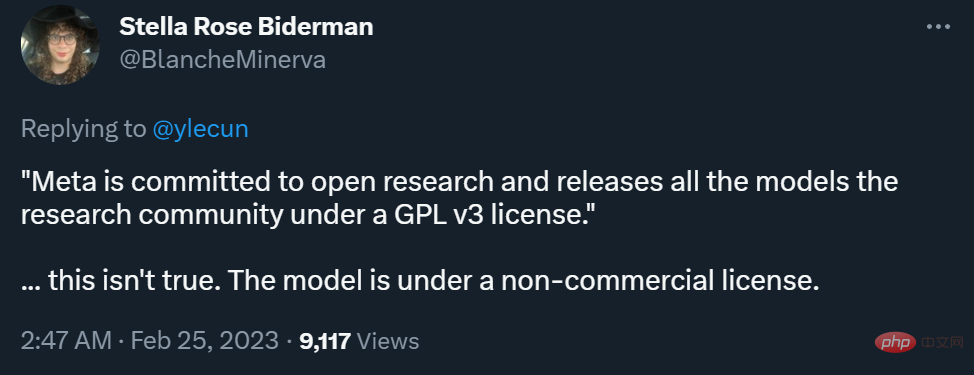

Namun, dari segi sama ada ia boleh dikomersialkan, perbezaan antara blog Meta dan Twitter LeCun telah menimbulkan beberapa kontroversi.

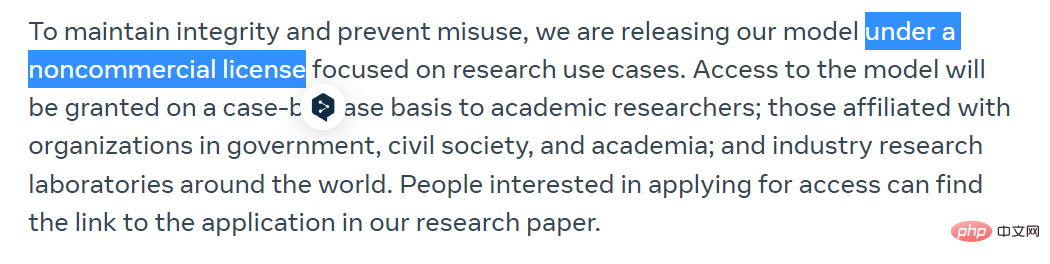

Meta berkata dalam catatan blog bahawa untuk mengekalkan integriti dan mencegah penyalahgunaan, mereka akan melepaskan mereka di bawah bukan komersial model lesen, memberi tumpuan kepada kes penggunaan kajian. Akses kepada model itu akan diberikan berdasarkan kes demi kes kepada penyelidik akademik, organisasi yang bergabung dengan kerajaan, masyarakat sivil dan akademia, serta makmal penyelidikan industri di seluruh dunia. Mereka yang berminat boleh memohon di pautan berikut:

https://docs.google.com/forms/d/e/1FAIpQLSfqNECQnMkycAp2jP4Z9TFX0cGR4uf7b_fBxjYl

LeCun berkata bahawa Meta komited untuk membuka penyelidikan dan mengeluarkan semua model kepada komuniti penyelidikan di bawah lesen GPL v3 (GPL v3 membenarkan penggunaan komersial).

Kenyataan ini agak kontroversi kerana dia tidak menjelaskan dengan jelas sama ada "model" di sini merujuk kepada kod atau pemberat, atau kedua-duanya. Pada pendapat ramai penyelidik, berat model jauh lebih penting daripada kod.

Dalam hal ini, LeCun menjelaskan bahawa apa yang dibuka di bawah lesen GPL v3 ialah kod model.

Sesetengah orang percaya bahawa tahap keterbukaan ini tidak benar "pendemokrasian AI."

Pada masa ini, Meta telah memuat naik kertas tersebut ke arXiv, dan beberapa kandungan juga telah dimuat naik ke repositori GitHub Anda boleh pergi ke Pergi semak imbas.

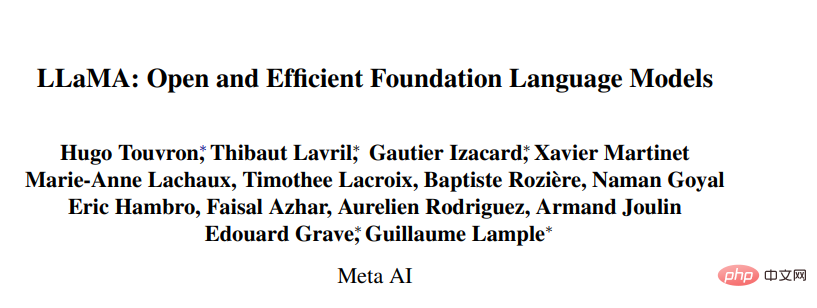

Model bahasa besar (LLM) yang dilatih pada korpora teks berskala besar telah menunjukkan keupayaan mereka untuk melaksanakan tugas baharu daripada gesaan teks atau daripada sebilangan kecil tugasan sampel. Sifat beberapa tangkapan ini mula-mula muncul apabila menskalakan model kepada skala yang cukup besar, menghasilkan barisan kerja yang tertumpu pada penskalaan lagi model ini.

Usaha ini adalah berdasarkan andaian bahawa lebih banyak parameter akan membawa kepada prestasi yang lebih baik. Walau bagaimanapun, kerja baru-baru ini oleh Hoffmann et al (2022) menunjukkan bahawa untuk belanjawan pengiraan tertentu, prestasi terbaik dicapai bukan oleh model terbesar, tetapi oleh model yang lebih kecil yang dilatih pada lebih banyak data.

Matlamat penskalaan undang-undang yang dicadangkan oleh Hoffmann et al (2022) adalah untuk menentukan cara terbaik untuk menskalakan set data dan saiz model berdasarkan bajet pengiraan latihan tertentu. Walau bagaimanapun, matlamat ini mengabaikan belanjawan inferens, yang menjadi kritikal apabila menyampaikan model bahasa pada skala. Dalam kes ini, berdasarkan tahap prestasi sasaran, model pilihan bukanlah yang paling pantas untuk dilatih, tetapi yang paling cepat untuk membuat kesimpulan. Walaupun mungkin lebih murah untuk melatih model besar untuk mencapai tahap prestasi tertentu, model yang lebih kecil yang mengambil masa lebih lama untuk dilatih akhirnya akan menjadi lebih murah pada inferens. Sebagai contoh, walaupun Hoffmann et al (2022) mengesyorkan melatih model 10B pada token 200B, para penyelidik mendapati bahawa prestasi model 7B terus meningkat walaupun selepas token 1T.

Tumpuan kerja ini adalah untuk melatih keluarga model bahasa untuk mencapai prestasi optimum pada pelbagai belanjawan inferens dengan melatih lebih banyak token daripada yang biasa digunakan. Model yang dihasilkan, dipanggil LLaMA, mempunyai parameter antara 7B hingga 65B dan berprestasi secara kompetitif dengan LLM sedia ada yang terbaik. Sebagai contoh, walaupun 10 kali lebih kecil daripada GPT-3, LLaMA-13B mengatasi GPT-3 dalam kebanyakan penanda aras.

Para penyelidik mengatakan model ini akan membantu mendemokrasikan penyelidikan LLM kerana ia boleh dijalankan pada satu GPU. Pada skala yang lebih tinggi, model parametrik LLaMA-65B juga setanding dengan model bahasa besar terbaik seperti Chinchilla atau PaLM-540B.

Tidak seperti Chinchilla, PaLM atau GPT-3, model ini hanya menggunakan data yang tersedia secara umum, menjadikan kerja ini serasi sumber terbuka, manakala kebanyakan model sedia ada bergantung pada data yang sama ada tidak tersedia untuk umum atau tidak dirakam (cth. Buku-2TB atau perbualan media sosial). Sudah tentu terdapat beberapa pengecualian, terutamanya OPT (Zhang et al., 2022), GPT-NeoX (Black et al., 2022), BLOOM (Scao et al., 2022) dan GLM (Zeng et al., 2022), Tetapi tiada siapa yang boleh bersaing dengan PaLM-62B atau Chinchilla.

Baki artikel ini menggariskan pengubahsuaian penyelidik kepada seni bina transformer dan kaedah latihan. Prestasi model kemudiannya dipersembahkan dan dibandingkan dengan model bahasa besar lain pada set penanda aras standard. Akhir sekali, kami menunjukkan berat sebelah dan ketoksikan dalam model menggunakan beberapa penanda aras terkini daripada komuniti AI yang bertanggungjawab.

Kaedah latihan yang digunakan oleh penyelidik adalah sama seperti yang diterangkan dalam kerja sebelum ini seperti (Brown et al., 2020), (Chowdhery et al., 2022) Pendekatan ini serupa dan diilhamkan oleh undang-undang penskalaan Chinchilla (Hoffmann et al., 2022). Para penyelidik menggunakan pengoptimum standard untuk melatih transformer besar pada sejumlah besar data teks.

Data pra-latihan

Seperti yang ditunjukkan dalam Jadual 1, set data latihan untuk kajian ini adalah beberapa Campuran sumber, meliputi kawasan yang berbeza. Dalam kebanyakan kes, penyelidik menggunakan semula sumber data yang telah digunakan untuk melatih model bahasa besar yang lain, tetapi sekatan di sini ialah hanya data yang tersedia secara umum boleh digunakan dan ia serasi dengan sumber terbuka. Campuran data dan peratusannya dalam set latihan adalah seperti berikut:

Seni Bina

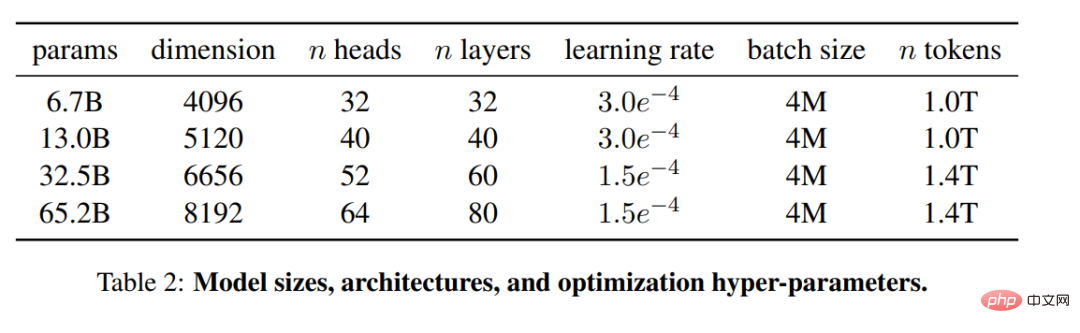

Berdasarkan kerja terbaru pada model bahasa besar, kajian ini juga menggunakan seni bina transformer. Penyelidik menggunakan pelbagai penambahbaikan yang kemudiannya dicadangkan dan digunakan dalam model yang berbeza, seperti PaLM. Dalam makalah itu, para penyelidik memperkenalkan perbezaan utama daripada seni bina asal:

Pra-normalisasi [GPT3]. Untuk meningkatkan kestabilan latihan, para penyelidik menormalkan input setiap sub-lapisan transformer dan bukannya menormalkan output. Mereka menggunakan fungsi normalisasi RMSNorm yang dicadangkan oleh Zhang dan Sennrich (2019).

Fungsi pengaktifan SwiGLU [PaLM]. Para penyelidik menggunakan fungsi pengaktifan SwiGLU yang dicadangkan oleh Shazeer (2020) untuk menggantikan ketaklinearan ReLU untuk meningkatkan prestasi. Mereka menggunakan dimensi 2D, 3D dan 4D masing-masing dan bukannya 4D dalam PaLM.Benam Putaran [GPTNeo]. Para penyelidik mengalih keluar pembenaman kedudukan mutlak dan menambah pembenaman kedudukan diputar (RoPE) yang dicadangkan oleh Su et al (2021) pada setiap lapisan rangkaian. Butiran hiperparameter model yang berbeza boleh didapati dalam Jadual 2.

Jawapan buku tertutup

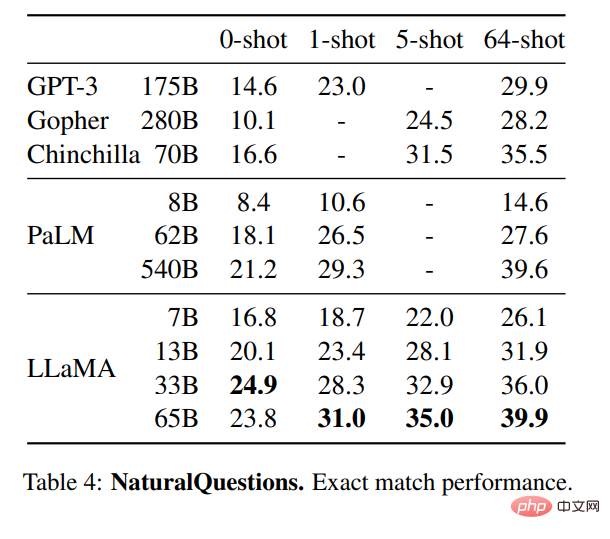

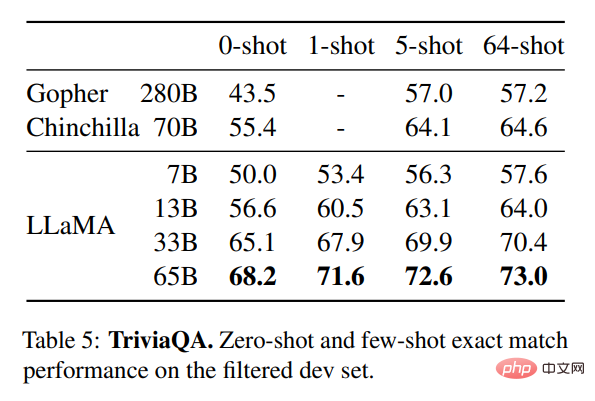

Jadual 4 menunjukkan prestasi NaturalQuestions dan Jadual 5 menunjukkan prestasi TriviaQA. Dalam kedua-dua penanda aras, LLaMA-65B mencapai prestasi terkini dalam kedua-dua tetapan sifar dan beberapa tangkapan. Lebih-lebih lagi, LLaMA-13B mempunyai daya saing yang sama pada penanda aras ini walaupun satu perlima hingga satu persepuluh saiz GPT-3 dan Chinchilla. Proses inferens model dijalankan pada GPU V100 tunggal.

Pemahaman Membaca

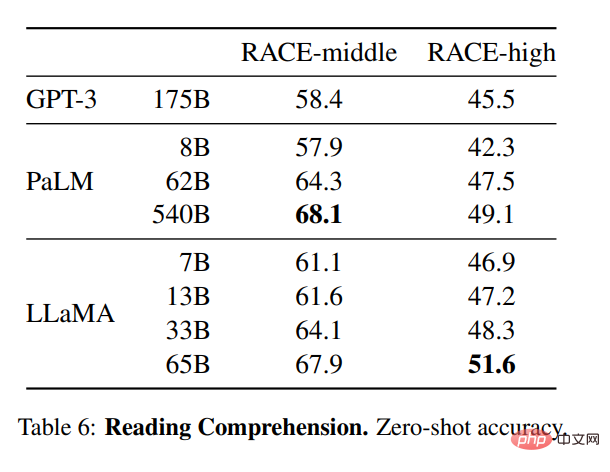

Para penyelidik juga menilai model pada penanda aras pemahaman bacaan RACE (Lai et al., 2017). Persediaan penilaian Brown et al (2020) diikuti di sini, dan Jadual 6 menunjukkan keputusan penilaian. Pada penanda aras ini, LLaMA-65B bersaing dengan PaLM-540B, dan LLaMA-13B mengatasi GPT-3 dengan beberapa mata peratusan.

Penaakulan matematik

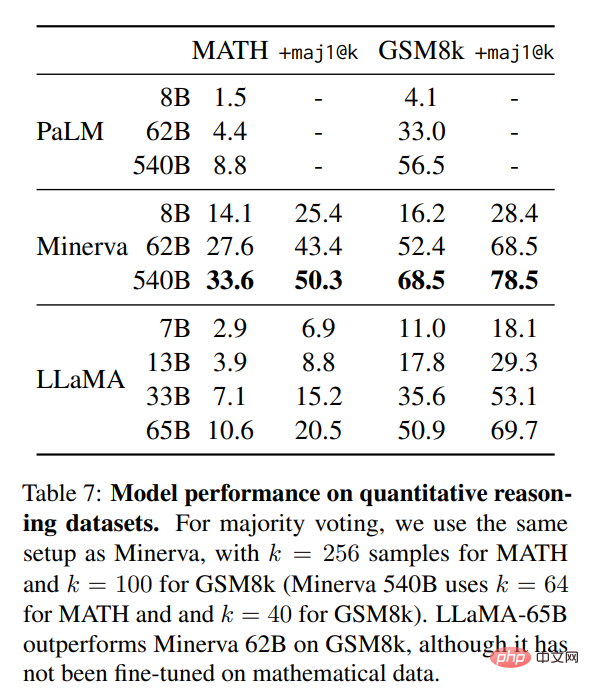

dalam jadual 7, penyelidik membandingkannya dengan PaLM dan Minerva (Lewkowycz et al., 2022). Pada GSM8k, mereka mendapati bahawa LLaMA65B mengatasi Minerva-62B, walaupun ia tidak disesuaikan dengan data matematik.

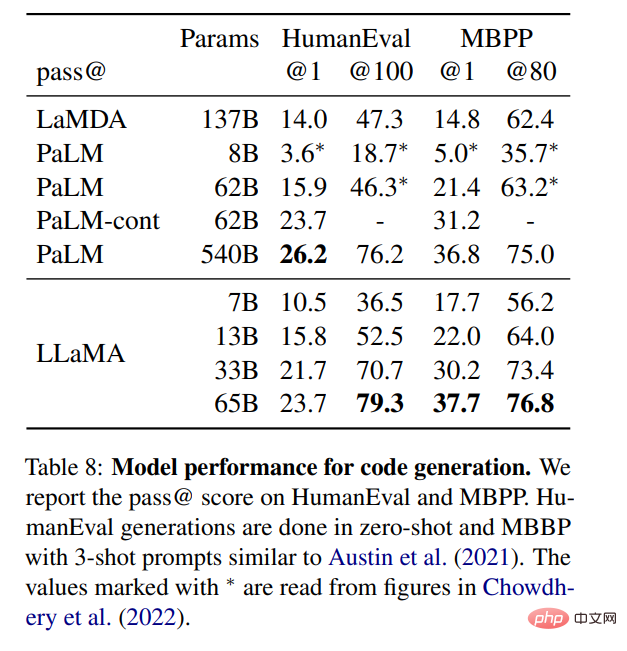

Penjanaan kod

Seperti yang ditunjukkan dalam jadual 8 menunjukkan bahawa untuk bilangan parameter yang sama, LLaMA berprestasi lebih baik daripada model umum lain, seperti LaMDA dan PaLM, yang belum dilatih atau diperhalusi dengan kod khusus. Pada HumanEval dan MBPP, LLaMA melebihi LaMDA sebanyak 137B untuk parameter melebihi 13B. LLaMA 65B juga mengatasi prestasi PaLM 62B, walaupun ia mengambil masa yang lebih lama untuk berlatih.

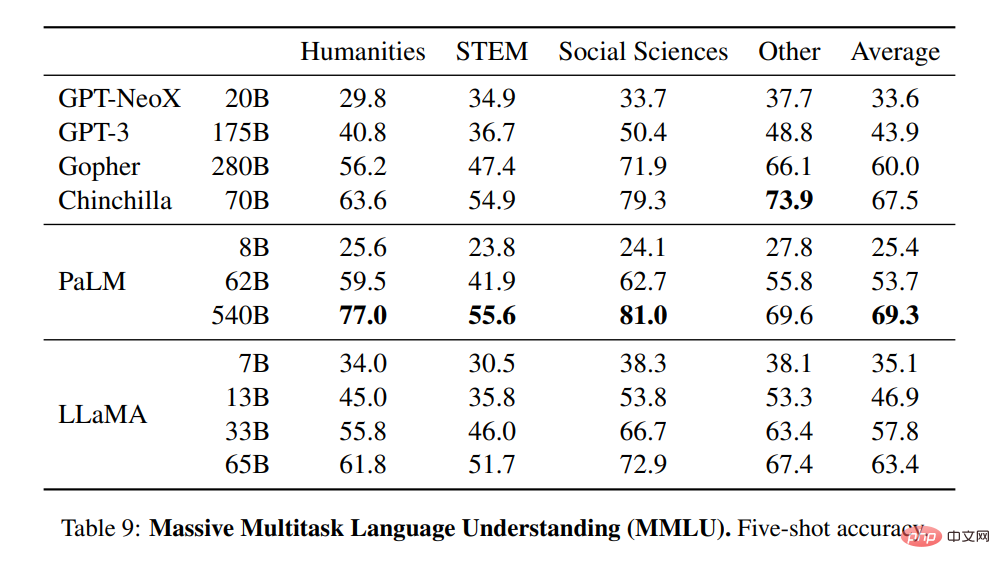

Pemahaman bahasa pelbagai tugas berskala besar

Para penyelidik menggunakan contoh yang disediakan oleh penanda aras untuk menilai model dalam kes 5-shot dan menunjukkan keputusan dalam Jadual 9. Pada penanda aras ini, mereka mendapati bahawa LLaMA-65B mengekori Chinchilla70B dan PaLM-540B dengan purata beberapa mata peratusan di kebanyakan kawasan. Satu penjelasan yang berpotensi ialah penyelidik menggunakan bilangan buku dan kertas akademik yang terhad dalam data pra-latihan, iaitu ArXiv, Gutenberg, dan Books3, yang berjumlah hanya 177GB, manakala model dilatih pada buku sehingga 2TB. Sebilangan besar buku yang digunakan oleh Gopher, Chinchilla dan PaLM juga mungkin menjelaskan sebab Gopher mengatasi GPT-3 pada penanda aras ini tetapi setanding dengan penanda aras lain.

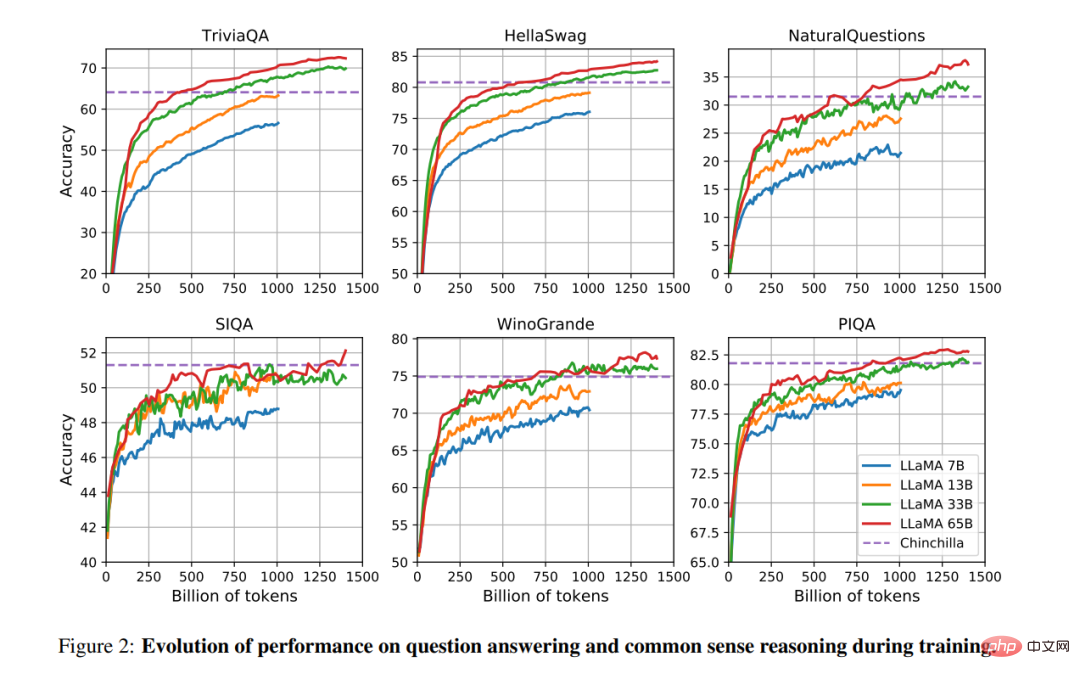

Perubahan prestasi semasa latihan

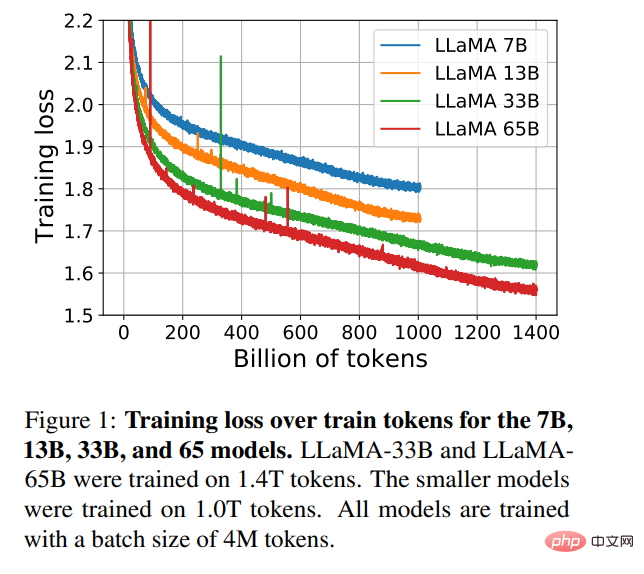

Semasa latihan, penyelidik menjejaki prestasi model LLaMA pada beberapa jawapan soalan dan tanda aras akal, dan hasilnya ditunjukkan dalam Rajah 2. Prestasi bertambah baik secara berterusan pada kebanyakan penanda aras dan dikaitkan secara positif dengan kebingungan latihan model (lihat Rajah 1).

Atas ialah kandungan terperinci Adakah ini prototaip versi Meta ChatGPT? Sumber terbuka, boleh dijalankan pada satu GPU, mengalahkan GPT-3 dengan 1/10 bilangan parameter. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Kekunci yang manakah harus saya tekan untuk memulihkan apabila saya tidak boleh menaip pada papan kekunci komputer saya?

Kekunci yang manakah harus saya tekan untuk memulihkan apabila saya tidak boleh menaip pada papan kekunci komputer saya?

pencetus_ralat

pencetus_ralat

Bagaimana untuk menyegarkan bios

Bagaimana untuk menyegarkan bios

Kaedah penyulitan data

Kaedah penyulitan data

Bagaimana untuk menutup port 135

Bagaimana untuk menutup port 135

Analisis statistik

Analisis statistik

Bagaimana untuk memulihkan video yang telah dialih keluar secara rasmi daripada Douyin

Bagaimana untuk memulihkan video yang telah dialih keluar secara rasmi daripada Douyin

Bagaimana untuk menyemak nilai MD5

Bagaimana untuk menyemak nilai MD5