Peranti teknologi

Peranti teknologi

AI

AI

Menambah kesan khas hanya memerlukan satu ayat atau gambar Syarikat Stable Diffusion telah menggunakan AIGC untuk memainkan helah baharu.

Menambah kesan khas hanya memerlukan satu ayat atau gambar Syarikat Stable Diffusion telah menggunakan AIGC untuk memainkan helah baharu.

Menambah kesan khas hanya memerlukan satu ayat atau gambar Syarikat Stable Diffusion telah menggunakan AIGC untuk memainkan helah baharu.

Saya percaya ramai orang telah memahami daya tarikan teknologi AI generatif, terutamanya selepas mengalami wabak AIGC pada tahun 2022. Teknologi penjanaan teks-ke-imej yang diwakili oleh Stable Diffusion pernah popular di seluruh dunia, dan tidak terkira banyaknya pengguna datang untuk meluahkan imaginasi artistik mereka dengan bantuan AI...

Berbanding dengan penyuntingan imej, Penyuntingan video ialah topik yang lebih mencabar, memerlukan mensintesis tindakan baharu dan bukannya mengubah suai rupa visual, sambil mengekalkan ketekalan temporal.

Terdapat banyak syarikat yang meneroka trek ini. Beberapa ketika dahulu, Google mengeluarkan Dreamix untuk menggunakan model penyebaran video bersyarat (VDM) teks pada penyuntingan video.

Baru-baru ini, Runway, sebuah syarikat yang mengambil bahagian dalam penciptaan Stable Diffusion, melancarkan model kecerdasan buatan baharu "Gen-1", yang menggunakan sebarang gaya yang ditentukan dengan menggunakan gesaan teks atau rujukan imej. Boleh menukar video sedia ada kepada video baharu.

Pautan kertas: https://arxiv.org/pdf/2302.03011.pdf

Laman utama projek: https://research.runwayml.com/gen1

Pada 2021, Runway dan Universiti Penyelidik Munich bekerjasama untuk mencipta versi pertama Stable Diffusion. Kemudian Stability AI, syarikat permulaan UK, melangkah masuk untuk membiayai perbelanjaan pengiraan yang diperlukan untuk melatih model pada lebih banyak data. Pada 2022, Stability AI membawa Stable Diffusion ke dalam arus perdana, mengubahnya daripada projek penyelidikan kepada fenomena global.

Runway berkata ia berharap Gen-1 akan lakukan untuk video seperti yang dilakukan Stable Diffusion untuk grafik.

"Kami telah melihat ledakan model penjanaan imej," kata Cristóbal Valenzuela, Ketua Pegawai Eksekutif dan pengasas bersama Runway. "Saya benar-benar percaya bahawa 2023 akan menjadi tahun video." Penggayaan. Pindahkan gaya mana-mana imej atau gesaan ke setiap bingkai video anda.

2. Papan cerita. Ubah model anda menjadi rendering yang bergaya dan animasi sepenuhnya.

3. Topeng. Asingkan topik dalam video dan ubah suainya menggunakan gesaan teks mudah.

4. Tukar pemaparan tanpa tekstur kepada output fotorealistik dengan menggunakan imej input atau gesaan.

5. Lepaskan kuasa penuh Gen-1 dengan menyesuaikan model anda untuk hasil ketepatan yang lebih tinggi.

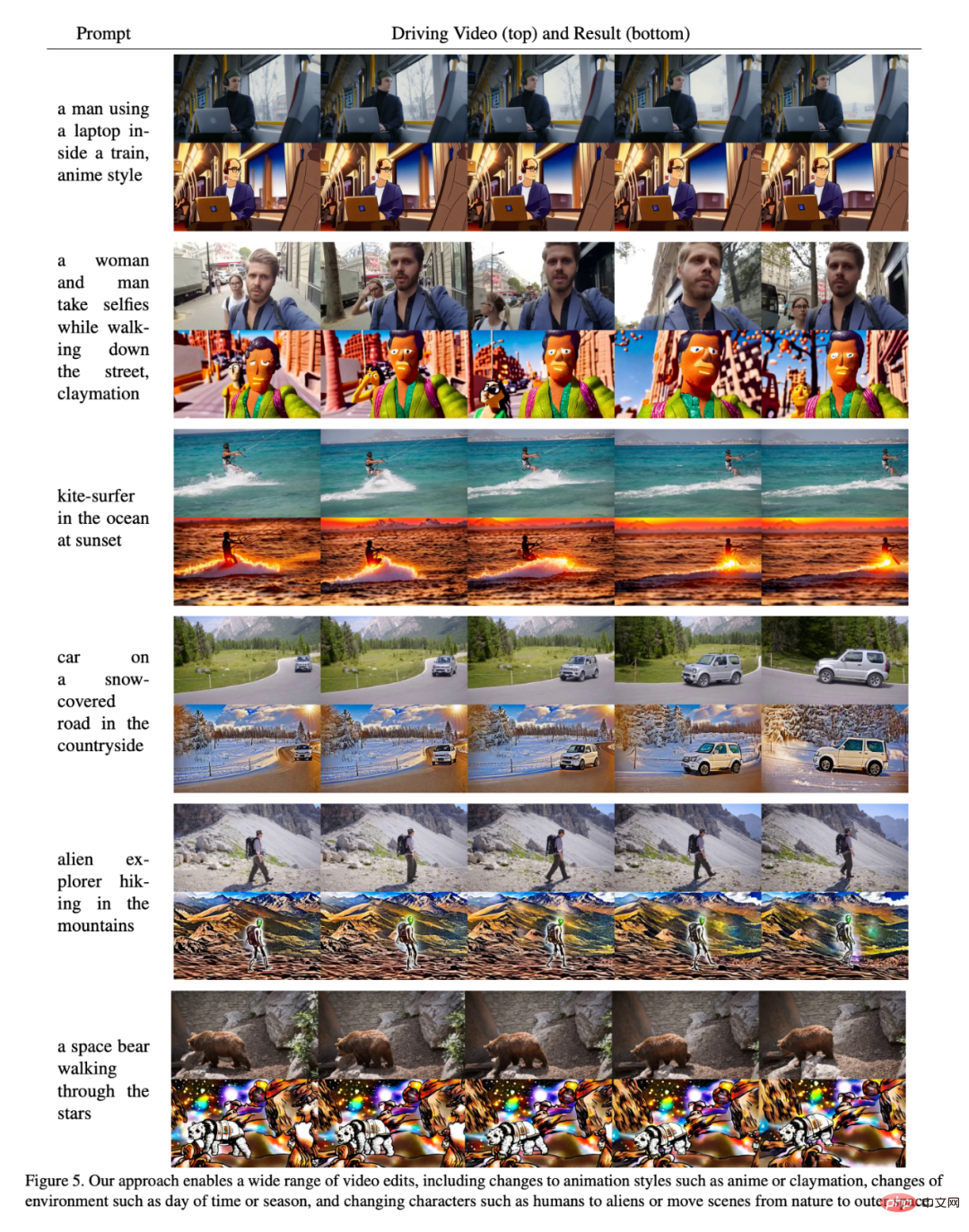

Dalam demo yang disiarkan di tapak web rasmi syarikat, ia menunjukkan cara Gen-1 boleh menukar gaya video dengan lancar, mari kita lihat beberapa contoh.

Sebagai contoh, untuk menukar "orang di jalanan" menjadi "boneka tanah liat", anda hanya memerlukan satu baris gesaan:

Daripada "berlari di atas salji" kepada "berjalan di bulan":

Butiran Kertas

Kesan visual dan penyuntingan video terdapat di mana-mana dalam media kontemporari. Apabila platform bertumpu video semakin popular, keperluan untuk alat penyuntingan video yang lebih intuitif dan berkuasa meningkat. Walau bagaimanapun, disebabkan sifat temporal data video, penyuntingan dalam format ini masih rumit dan memakan masa. Model pembelajaran mesin tercanggih menunjukkan janji yang baik dalam meningkatkan proses penyuntingan, tetapi banyak kaedah perlu mencapai keseimbangan antara ketekalan temporal dan perincian spatial.

Kaedah generatif untuk sintesis imej baru-baru ini mengalami fasa pertumbuhan pesat dalam kualiti dan populariti disebabkan oleh pengenalan model resapan yang dilatih pada set data berskala besar. Sesetengah model bersyarat teks, seperti DALL-E 2 dan Stable Diffusion, membolehkan pengguna baru menjana imej terperinci dengan hanya gesaan teks. Model resapan terpendam menyediakan kaedah yang cekap untuk menjana imej dengan menggubah dalam ruang yang dimampatkan secara persepsi.

Dalam kertas kerja ini, penyelidik mencadangkan model penyebaran video struktur dan sedar kandungan yang boleh dikawal pada video tanpa sari kata dan data imej teks yang dilatih pada set data berskala besar. Para penyelidik memilih untuk menggunakan anggaran kedalaman monokular untuk mewakili struktur dan benam yang diramalkan oleh rangkaian saraf pra-terlatih untuk mewakili kandungan.

Kaedah ini menyediakan beberapa mod kawalan berkuasa semasa proses penjanaannya: Pertama, sama dengan model sintesis imej, penyelidik melatih model untuk membuat kandungan video yang disimpulkan, seperti penampilannya atau gaya, sepadan dengan imej atau gesaan teks yang dibekalkan pengguna (Rajah 1). Kedua, diilhamkan oleh proses penyebaran, para penyelidik menggunakan proses penyamaran maklumat kepada perwakilan struktur untuk dapat memilih sejauh mana model itu menyokong struktur tertentu. Akhir sekali, kami menyesuaikan proses inferens melalui kaedah panduan tersuai yang diilhamkan oleh panduan bebas klasifikasi untuk mencapai kawalan ke atas ketekalan temporal segmen yang dijana.

Secara keseluruhannya, sorotan kajian ini adalah seperti berikut:

- Dengan memperkenalkan lapisan temporal dalam model imej pra-latihan , dan Latihan bersama tentang imej dan video memanjangkan model resapan terpendam ke bidang penjanaan video

- mencadangkan model struktur dan sedar kandungan yang mengubah suai video di bawah bimbingan imej sampel; atau teks. Penyuntingan dilakukan sepenuhnya dalam masa inferens, tidak memerlukan latihan tambahan atau prapemprosesan untuk setiap video; Kajian ini adalah yang pertama menunjukkan bahawa latihan bersama pada data imej dan video membolehkan masa inferens untuk mengawal ketekalan temporal. Untuk ketekalan struktur, latihan pada tahap perincian yang berbeza dalam perwakilan membolehkan pemilihan tetapan yang diingini semasa inferens; Dalam kajian pengguna, kaedah kami Lebih popular daripada beberapa kaedah lain; model terlatih boleh diperibadikan lagi dengan menala halus pada subset kecil imej untuk menghasilkan video khusus subjek yang lebih tepat.

- Kaedah

- Untuk tujuan penyelidikan, adalah berguna untuk mempertimbangkan video dari kedua-dua perspektif kandungan dan struktur. Dengan struktur, di sini kami maksudkan ciri yang menerangkan geometri dan dinamiknya, seperti bentuk dan kedudukan badannya, dan perubahan temporalnya. Untuk kandungan, ia ditakrifkan di sini sebagai ciri yang menerangkan penampilan dan semantik video, seperti warna dan gaya objek dan pencahayaan tempat kejadian. Matlamat model Gen-1 adalah untuk mengedit kandungan video sambil mengekalkan strukturnya.

- Untuk mencapai matlamat ini, penyelidik mempelajari model generatif p (x|s, c) untuk video x, yang syaratnya ialah perwakilan struktur (diwakili oleh s) dan perwakilan kandungan ( Diwakili oleh c). Mereka menyimpulkan perwakilan bentuk daripada video input dan mengubah suainya berdasarkan gesaan teks c yang menerangkan suntingan. Pertama, pelaksanaan model generatif sebagai model penyebaran video terpendam bersyarat diterangkan, dan kemudian, pilihan bentuk dan perwakilan kandungan diterangkan. Akhir sekali, proses pengoptimuman model dibincangkan.

Eksperimen

Untuk menilai kaedah, penyelidik menggunakan video DAVIS dan pelbagai bahan. Untuk membuat gesaan pengeditan secara automatik, para penyelidik mula-mula menjalankan model sari kata untuk mendapatkan perihalan kandungan video asal, dan kemudian menggunakan GPT-3 untuk menjana gesaan pengeditan.

Penyelidikan kualitatif

Seperti yang ditunjukkan dalam Rajah 5, keputusan membuktikan bahawa kaedah artikel ini berkesan pada beberapa input berbeza Berprestasi dengan baik.

Penyelidikan Pengguna

Penyelidik juga A kajian pengguna telah dijalankan menggunakan Amazon Mechanical Turk (AMT) pada set penilaian 35 gesaan pengeditan video yang mewakili. Untuk setiap sampel, 5 anotor diminta untuk membandingkan ketepatan gesaan pengeditan video antara kaedah garis dasar dan kaedah kami ("Video manakah yang lebih baik mewakili sari kata yang disunting yang disediakan?"), dan kemudian Dipersembahkan secara rawak secara berurutan, dengan undian majoriti digunakan untuk menentukan muktamad hasil.

Keputusan ditunjukkan dalam Rajah 7:

Penilaian Kuantitatif

Rajah 6 menunjukkan keputusan setiap model menggunakan petunjuk ketekalan dan ketekalan segera rangka kerja artikel ini. Prestasi model dalam kertas kerja ini cenderung untuk mengatasi model garis dasar dalam kedua-dua aspek (iaitu, ia lebih tinggi di sudut kanan atas rajah). Para penyelidik juga menyedari bahawa terdapat sedikit pertukaran untuk meningkatkan parameter keamatan dalam model garis dasar: penskalaan intensiti yang lebih besar bermakna konsistensi segera yang lebih tinggi pada kos ketekalan bingkai yang lebih rendah. Mereka juga mendapati bahawa penskalaan struktur yang meningkat membawa kepada konsistensi segera yang lebih tinggi kerana kandungan tidak lagi ditentukan oleh struktur input.

Penyesuaian

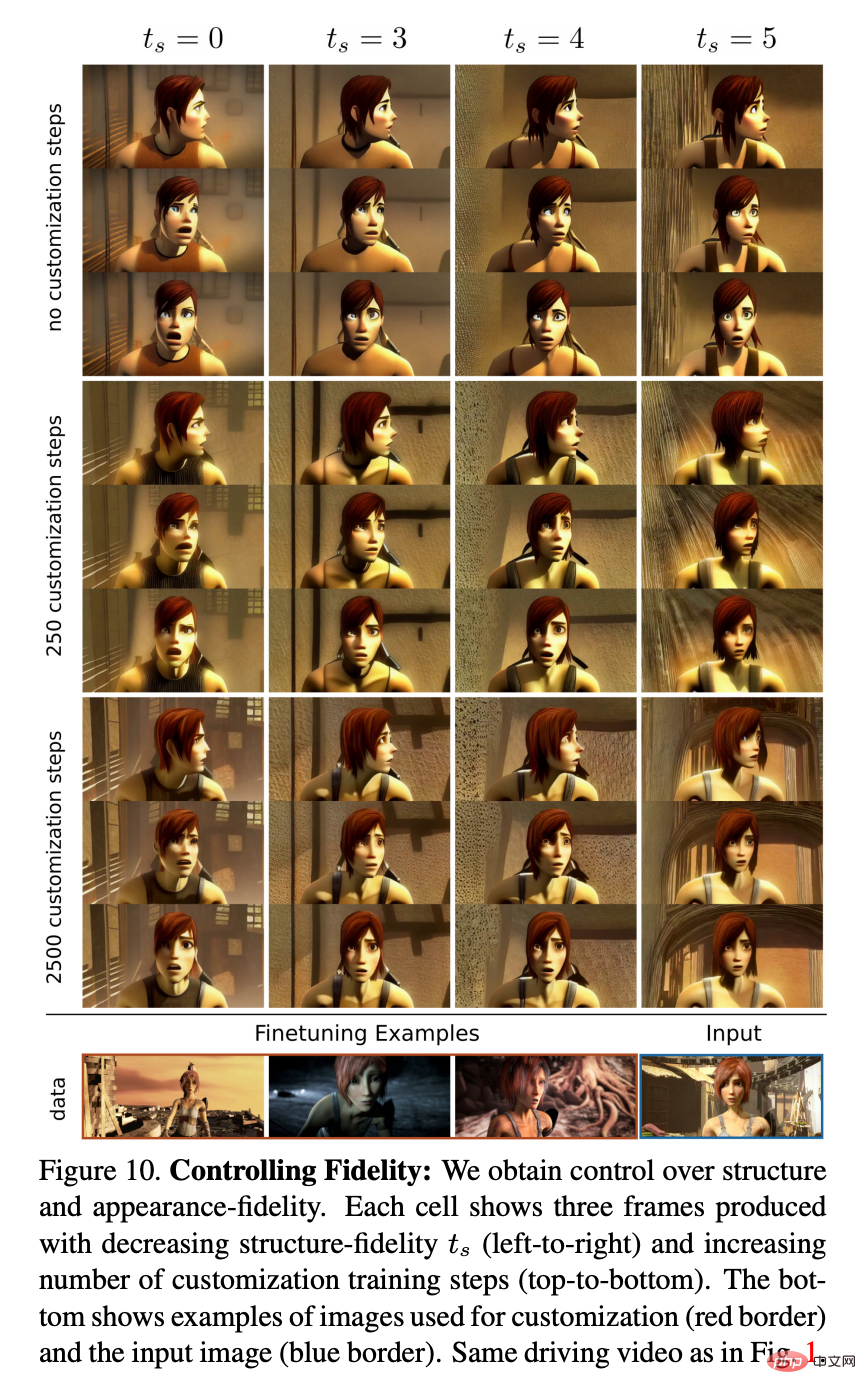

Rajah 10 menunjukkan model dengan bilangan langkah penyesuaian yang berbeza dan contoh kebergantungan struktur yang berbeza . Para penyelidik memerhatikan bahawa penyesuaian meningkatkan kesetiaan kepada gaya dan penampilan watak, supaya, walaupun menggunakan video didorong watak dengan ciri berbeza, digabungkan dengan nilai ts yang lebih tinggi, kesan animasi yang tepat boleh dicapai.

Atas ialah kandungan terperinci Menambah kesan khas hanya memerlukan satu ayat atau gambar Syarikat Stable Diffusion telah menggunakan AIGC untuk memainkan helah baharu.. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1382

1382

52

52

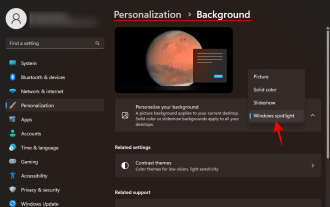

Bagaimana untuk mengosongkan latar belakang desktop sejarah imej terkini dalam Windows 11

Apr 14, 2023 pm 01:37 PM

Bagaimana untuk mengosongkan latar belakang desktop sejarah imej terkini dalam Windows 11

Apr 14, 2023 pm 01:37 PM

<p>Windows 11 menambah baik pemperibadian dalam sistem, membenarkan pengguna melihat sejarah terkini perubahan latar belakang desktop yang dibuat sebelum ini. Apabila anda memasuki bahagian pemperibadian dalam aplikasi Tetapan Sistem Windows, anda boleh melihat pelbagai pilihan, menukar kertas dinding latar belakang adalah salah satu daripadanya. Tetapi kini anda boleh melihat sejarah terkini kertas dinding latar belakang yang ditetapkan pada sistem anda. Jika anda tidak suka melihat ini dan ingin mengosongkan atau memadamkan sejarah terbaharu ini, teruskan membaca artikel ini, yang akan membantu anda mengetahui lebih lanjut tentang cara melakukannya menggunakan Editor Pendaftaran. </p><h2>Cara menggunakan penyuntingan pendaftaran

Bagaimana untuk Muat Turun Imej Kertas Dinding Spotlight Windows pada PC

Aug 23, 2023 pm 02:06 PM

Bagaimana untuk Muat Turun Imej Kertas Dinding Spotlight Windows pada PC

Aug 23, 2023 pm 02:06 PM

Windows tidak pernah mengabaikan estetika. Daripada bidang hijau bucolic XP kepada reka bentuk berputar biru Windows 11, kertas dinding desktop lalai telah menjadi sumber kegembiraan pengguna selama bertahun-tahun. Dengan Windows Spotlight, anda kini mempunyai akses terus kepada imej yang cantik dan mengagumkan untuk skrin kunci dan kertas dinding desktop anda setiap hari. Malangnya, imej ini tidak melepak. Jika anda telah jatuh cinta dengan salah satu imej sorotan Windows, maka anda pasti ingin tahu cara memuat turunnya supaya anda boleh mengekalkannya sebagai latar belakang anda buat seketika. Ini semua yang anda perlu tahu. Apakah WindowsSpotlight? Sorotan Tetingkap ialah pengemas kini kertas dinding automatik yang tersedia daripada Pemperibadian > dalam apl Tetapan

Bagaimana untuk menggunakan teknologi segmentasi semantik imej dalam Python?

Jun 06, 2023 am 08:03 AM

Bagaimana untuk menggunakan teknologi segmentasi semantik imej dalam Python?

Jun 06, 2023 am 08:03 AM

Dengan pembangunan berterusan teknologi kecerdasan buatan, teknologi segmentasi semantik imej telah menjadi hala tuju penyelidikan yang popular dalam bidang analisis imej. Dalam segmentasi semantik imej, kami membahagikan kawasan yang berbeza dalam imej dan mengelaskan setiap kawasan untuk mencapai pemahaman yang menyeluruh tentang imej. Python ialah bahasa pengaturcaraan yang terkenal dengan keupayaan analisis data dan visualisasi datanya yang hebat menjadikannya pilihan pertama dalam bidang penyelidikan teknologi kecerdasan buatan. Artikel ini akan memperkenalkan cara menggunakan teknologi segmentasi semantik imej dalam Python. 1. Pengetahuan prasyarat semakin mendalam

iOS 17: Cara menggunakan pemangkasan satu klik dalam foto

Sep 20, 2023 pm 08:45 PM

iOS 17: Cara menggunakan pemangkasan satu klik dalam foto

Sep 20, 2023 pm 08:45 PM

Dengan apl iOS 17 Photos, Apple memudahkan untuk memangkas foto mengikut spesifikasi anda. Baca terus untuk mengetahui caranya. Sebelum ini dalam iOS 16, memangkas imej dalam apl Foto melibatkan beberapa langkah: Ketik antara muka pengeditan, pilih alat pangkas dan kemudian laraskan pemangkasan menggunakan gerak isyarat picit untuk zum atau seret penjuru alat pangkas. Dalam iOS 17, Apple bersyukur telah memudahkan proses ini supaya apabila anda mengezum masuk pada mana-mana foto yang dipilih dalam pustaka Foto anda, butang Pangkas baharu muncul secara automatik di penjuru kanan sebelah atas skrin. Mengklik padanya akan memaparkan antara muka pemangkasan penuh dengan tahap zum pilihan anda, jadi anda boleh memangkas ke bahagian imej yang anda suka, memutar imej, menyongsangkan imej atau menggunakan nisbah skrin atau menggunakan penanda

Gunakan imej 2D untuk mencipta tubuh manusia 3D Anda boleh memakai sebarang pakaian dan menukar pergerakan anda.

Apr 11, 2023 pm 02:31 PM

Gunakan imej 2D untuk mencipta tubuh manusia 3D Anda boleh memakai sebarang pakaian dan menukar pergerakan anda.

Apr 11, 2023 pm 02:31 PM

Terima kasih kepada pemaparan boleh beza yang disediakan oleh NeRF, model generatif 3D terkini telah mencapai hasil yang menakjubkan pada objek pegun. Walau bagaimanapun, dalam kategori yang lebih kompleks dan boleh berubah bentuk seperti tubuh manusia, generasi 3D masih menimbulkan cabaran yang hebat. Makalah ini mencadangkan perwakilan NeRF gabungan yang cekap bagi tubuh manusia, membolehkan penjanaan badan manusia 3D resolusi tinggi (512x256) tanpa menggunakan model resolusi super. EVA3D telah dengan ketara mengatasi penyelesaian sedia ada pada empat set data badan manusia berskala besar, dan kod tersebut adalah sumber terbuka. Nama kertas: EVA3D: Penjanaan Manusia 3D Komposisi daripada Koleksi imej 2D Alamat kertas: http

Perspektif baharu tentang penjanaan imej: membincangkan kaedah generalisasi berasaskan NeRF

Apr 09, 2023 pm 05:31 PM

Perspektif baharu tentang penjanaan imej: membincangkan kaedah generalisasi berasaskan NeRF

Apr 09, 2023 pm 05:31 PM

Penjanaan imej perspektif baharu (NVS) adalah bidang aplikasi penglihatan komputer Dalam permainan SuperBowl 1998, RI CMU menunjukkan NVS diberikan penglihatan stereo berbilang kamera (MVS) Pada masa itu, teknologi ini dipindahkan ke stesen TV sukan di Amerika Syarikat, tetapi ia tidak dikomersialkan pada akhirnya; British BBC Broadcasting Company melabur dalam penyelidikan dan pembangunan untuk ini, tetapi ia tidak benar-benar dikomersialkan. Dalam bidang rendering berasaskan imej (IBR), terdapat satu cabang aplikasi NVS iaitu depth image-based rendering (DBIR). Di samping itu, TV 3D, yang sangat popular pada tahun 2010, juga perlu mendapatkan kesan stereoskopik binokular daripada video monokular, tetapi disebabkan ketidakmatangan teknologi, ia tidak menjadi popular pada akhirnya. Pada masa itu, kaedah berasaskan pembelajaran mesin telah pun mula dipelajari, seperti

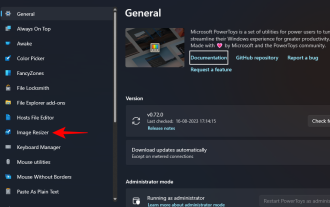

Bagaimana untuk mengubah saiz kumpulan imej menggunakan PowerToys pada Windows

Aug 23, 2023 pm 07:49 PM

Bagaimana untuk mengubah saiz kumpulan imej menggunakan PowerToys pada Windows

Aug 23, 2023 pm 07:49 PM

Mereka yang perlu bekerja dengan fail imej setiap hari selalunya perlu mengubah saiznya agar sesuai dengan keperluan projek dan pekerjaan mereka. Walau bagaimanapun, jika anda mempunyai terlalu banyak imej untuk diproses, saiz semula imej secara individu boleh mengambil banyak masa dan usaha. Dalam kes ini, alat seperti PowerToys boleh berguna untuk, antara lain, mengubah saiz fail kumpulan menggunakan utiliti pengubah semula imejnya. Begini cara untuk menyediakan tetapan Image Resizer anda dan mulakan saiz semula kumpulan imej dengan PowerToys. Cara Mengubah Saiz Imej Secara Berkelompok dengan PowerToys PowerToys ialah program semua-dalam-satu dengan pelbagai utiliti dan ciri untuk membantu anda mempercepatkan tugas harian anda. Salah satu utilitinya ialah imej

Padamkan cela dan kedutan dengan satu klik: tafsiran mendalam model kecantikan kulit potret definisi tinggi DAMO Academy ABPN

Apr 12, 2023 pm 12:25 PM

Padamkan cela dan kedutan dengan satu klik: tafsiran mendalam model kecantikan kulit potret definisi tinggi DAMO Academy ABPN

Apr 12, 2023 pm 12:25 PM

Dengan perkembangan pesat industri budaya digital, teknologi kecerdasan buatan telah mula digunakan secara meluas dalam bidang penyuntingan dan pengindahan imej. Antaranya, mencantikkan kulit potret tidak diragukan lagi merupakan salah satu teknologi yang paling banyak digunakan dan paling dituntut. Algoritma kecantikan tradisional menggunakan teknologi penyuntingan imej berasaskan penapis untuk mencapai kesan penurapan semula kulit dan penyingkiran noda secara automatik, dan telah digunakan secara meluas dalam rangkaian sosial, siaran langsung dan senario lain. Walau bagaimanapun, dalam industri fotografi profesional dengan ambang yang tinggi, disebabkan oleh keperluan yang tinggi untuk resolusi imej dan standard kualiti, retoucher manual masih menjadi kuasa produktif utama dalam ubah suai kecantikan potret, menyelesaikan tugas termasuk melicinkan kulit, menghilangkan cela, pemutihan, dll. Siri kerja. Biasanya, masa pemprosesan purata untuk penyesuai profesional untuk melakukan operasi mencantikkan kulit pada potret definisi tinggi adalah 1-2 minit Dalam bidang seperti pengiklanan, filem dan televisyen, yang memerlukan ketepatan yang lebih tinggi, ini