Peranti teknologi

Peranti teknologi

AI

AI

300 tahun kecerdasan buatan! Bapa LSTM menulis artikel panjang 10,000 perkataan: Penjelasan terperinci tentang sejarah pembangunan AI moden dan pembelajaran mendalam

300 tahun kecerdasan buatan! Bapa LSTM menulis artikel panjang 10,000 perkataan: Penjelasan terperinci tentang sejarah pembangunan AI moden dan pembelajaran mendalam

300 tahun kecerdasan buatan! Bapa LSTM menulis artikel panjang 10,000 perkataan: Penjelasan terperinci tentang sejarah pembangunan AI moden dan pembelajaran mendalam

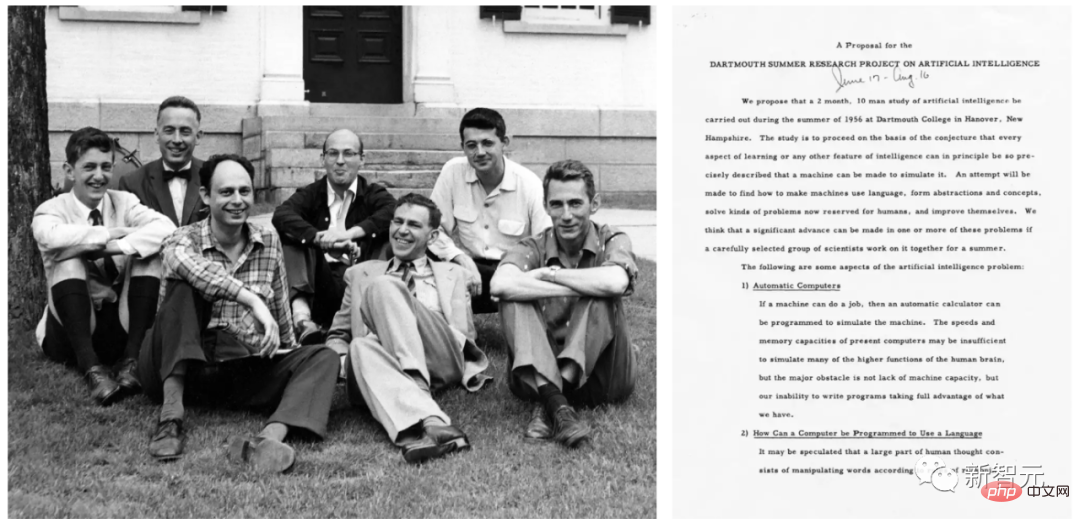

Istilah "kecerdasan buatan" pertama kali dicadangkan secara rasmi di Persidangan Dartmouth pada tahun 1956 oleh John McCarthy dan lain-lain.

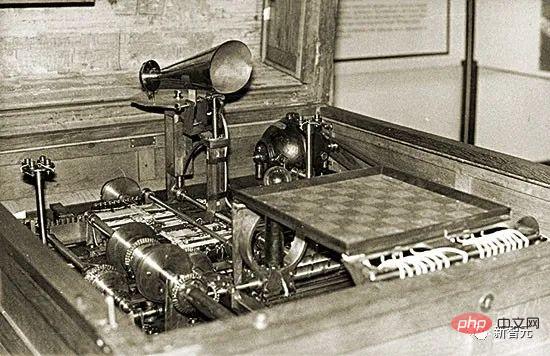

AI praktikal telah dicadangkan seawal tahun 1914. Pada masa itu Leonardo Torres y Quevedo membina pemain terminal mesin catur pertama yang berfungsi. Pada masa itu, catur dianggap sebagai aktiviti yang terhad kepada alam makhluk yang bijak.

Bagi teori kecerdasan buatan pula, ia boleh dikesan sejak 1931-34. Pada masa itu Kurt Gödel mengenal pasti had asas sebarang jenis kecerdasan buatan berasaskan pengiraan.

Apabila tiba masanya pada tahun 1980-an, sejarah AI pada masa ini akan menekankan topik seperti pembuktian teorem, pengaturcaraan logik, sistem pakar dan carian heuristik.

Sejarah AI pada awal 2000-an akan memberi penekanan yang lebih besar pada topik seperti mesin vektor sokongan dan kaedah kernel. Penaakulan Bayesian dan konsep kebarangkalian dan statistik lain, pokok keputusan, kaedah ensemble, kecerdasan kawanan dan pengiraan evolusi ialah teknik yang memacu banyak aplikasi AI yang berjaya.

Penyelidikan AI pada tahun 2020-an adalah lebih "retro", seperti menekankan peraturan rantai dan rangkaian saraf tiruan tak linear dalam yang dilatih melalui keturunan kecerunan, terutamanya berdasarkan Konsep maklum balas seperti rangkaian berulang.

Schmidhuber berkata bahawa artikel ini membetulkan "sejarah pembelajaran mendalam" yang mengelirukan sebelum ini. Pada pandangannya, sejarah pembelajaran mendalam terdahulu telah mengabaikan banyak kerja mani yang disebutkan dalam artikel itu.

Selain itu, Schmidhuber menafikan salah tanggapan umum bahawa rangkaian saraf "diperkenalkan pada tahun 1980-an sebagai alat untuk membantu komputer mengenali corak dan mensimulasikan kecerdasan manusia." Kerana sebenarnya, rangkaian saraf telah muncul sebelum tahun 1980-an.

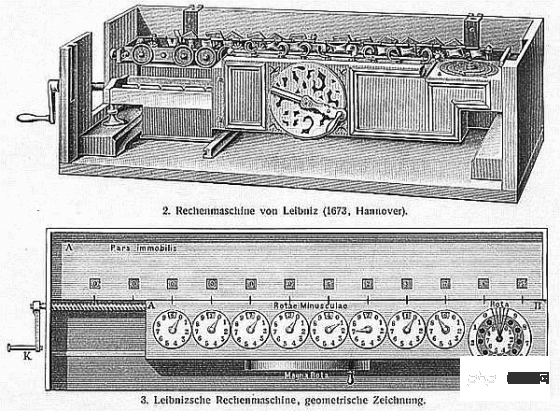

1. 1676: Peraturan rantaian peruntukan kredit terbalik

Pada tahun 1676, Gottfried Wilhelm Leibniz ) menerbitkan peraturan rantaian kalkulus dalam memoirnya. Hari ini, peraturan ini menjadi teras penugasan kredit dalam rangkaian saraf dalam dan merupakan asas pembelajaran mendalam moden.

Gottfried Wilhelm Leibniz

Rangkaian saraf mempunyai nod atau neuron yang mengira fungsi input yang boleh dibezakan daripada neuron lain, yang seterusnya mengira fungsi input yang boleh dibezakan daripada neuron lain. Jika anda ingin mengetahui perubahan dalam output fungsi akhir selepas mengubah suai parameter atau pemberat fungsi terdahulu, anda perlu menggunakan peraturan rantai.

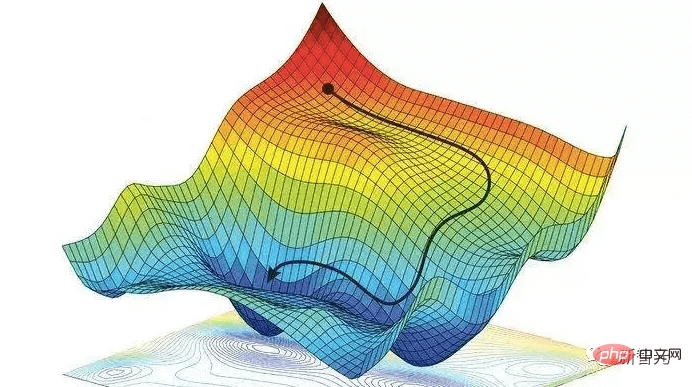

Jawapan ini juga digunakan untuk teknik penurunan kecerunan. Untuk mengajar rangkaian saraf untuk mengubah corak input daripada set latihan kepada corak output yang diingini, semua pemberat rangkaian saraf secara lelaran diubah sedikit ke arah peningkatan tempatan maksimum untuk mencipta rangkaian saraf yang lebih baik sedikit, dan seterusnya, secara beransur-ansur Dekat dengan gabungan pemberat dan berat sebelah yang optimum untuk meminimumkan fungsi kehilangan.

Perlu diperhatikan bahawa Leibniz juga merupakan ahli matematik pertama yang menemui kalkulus. Dia dan Isaac Newton secara bebas menemui kalkulus, dan simbol matematik kalkulus yang digunakannya lebih meluas Simbol yang dicipta oleh Leibniz secara amnya dianggap lebih komprehensif dan mempunyai rangkaian aplikasi yang lebih luas.

Selain itu, Leibniz ialah "saintis komputer pertama di dunia." Dia mereka bentuk mesin pertama pada tahun 1673 yang boleh melakukan semua empat operasi aritmetik, meletakkan asas untuk sains komputer moden.

2. Awal abad ke-19: rangkaian saraf, regresi linear dan pembelajaran cetek

1805, diterbitkan oleh Adrien-Marie Legendre kepada apa yang kini biasanya dirujuk sebagai rangkaian saraf linear.

Adrien Marie É Legendre

Kemudian, Johann Carl Friedrich Gauss telah juga dikreditkan dengan penyelidikan yang serupa.

Rangkaian saraf ini sejak lebih 2 abad yang lalu mempunyai dua lapisan: lapisan input dengan berbilang unit input dan lapisan output. Setiap sel input boleh memegang nilai nilai sebenar dan disambungkan kepada output melalui sambungan dengan pemberat nilai sebenar.

Keluaran rangkaian saraf ialah jumlah produk input dan beratnya. Memandangkan set latihan vektor input dan nilai sasaran yang dijangkakan untuk setiap vektor, laraskan pemberat untuk meminimumkan jumlah ralat kuasa dua antara output rangkaian saraf dan sasaran yang sepadan.

Sudah tentu, ini tidak dipanggil rangkaian saraf pada masa itu. Ia dipanggil kuasa dua terkecil, juga dikenali secara meluas sebagai regresi linear. Tetapi secara matematiknya sama dengan rangkaian neural linear hari ini: algoritma asas yang sama, fungsi ralat yang sama, parameter/berat penyesuaian yang sama.

Johann Carl Friedrich Gauss

Rangkaian saraf ringkas ini melakukan " pembelajaran cetek" berbanding "pembelajaran mendalam" yang mempunyai banyak lapisan bukan linear. Malah, banyak kursus rangkaian saraf bermula dengan pengenalan kepada pendekatan ini dan kemudian beralih kepada rangkaian saraf yang lebih kompleks dan mendalam.

Kini, kelas matematik diwajibkan kepada pelajar semua mata pelajaran teknikal, terutamanya analisis, algebra linear dan statistik. Dalam semua bidang ini, banyak keputusan dan kaedah penting dikaitkan dengan Gauss: teorem asas algebra, kaedah penghapusan Gauss, taburan statistik Gauss, dsb.

Lelaki yang dikenali sebagai "ahli matematik terhebat sejak zaman purba" juga mempelopori geometri pembezaan, teori nombor (subjek kegemarannya) dan geometri bukan Euclidean. Tanpa pencapaiannya, kejuruteraan moden, termasuk AI, tidak dapat difikirkan.

3. 1920-1925: Rangkaian saraf berulang pertama

Sama seperti otak manusia, rangkaian saraf berulang (RNN) mempunyai sambungan maklum balas, jadi ia boleh mengikuti Sambungan terarah dari nod dalaman tertentu ke nod lain, akhirnya berakhir pada titik permulaan. Ini penting untuk membolehkan ingatan untuk peristiwa lalu semasa pemprosesan jujukan.

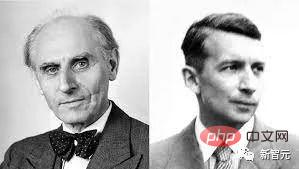

Wilhelm Lentz (kiri); Fizik Ernst Ising dan Wilhelm Lenz memperkenalkan dan menganalisis seni bina RNN bukan pembelajaran pertama pada tahun 1920-an: model Ising. Ia memasuki keadaan keseimbangan berdasarkan keadaan input dan merupakan asas kepada model pembelajaran RNN yang pertama.

Pada tahun 1972, Shun-Ichi Amari menjadikan seni bina gelung model Ising adaptif, belajar untuk mengaitkan corak input kepada corak output dengan menukar berat sambungannya Union. Ini adalah RNN pembelajaran pertama di dunia.

Shunichi Amari

Pada masa ini, RNN paling popular dicadangkan oleh Schmidhuber Rangkaian ingatan jangka pendek panjang LSTM. Ia telah menjadi rangkaian neural yang paling banyak disebut pada abad ke-20.

4. 1958: Rangkaian saraf suapan hadapan berbilang lapisan

Pada tahun 1958, Frank Rosenblatt menggabungkan rangkaian saraf linear dan fungsi ambang untuk mereka bentuk perceptron berbilang lapisan Hierarki (MLP) yang lebih mendalam.

Frank Rosenblatt

Perceptron Berbilang Lapisan Ikut prinsip saraf manusia sistem untuk belajar dan membuat ramalan data. Ia mula-mula belajar, kemudian menyimpan data menggunakan pemberat, dan menggunakan algoritma untuk melaraskan pemberat dan mengurangkan berat sebelah semasa latihan, iaitu ralat antara nilai sebenar dan nilai ramalan.

Memandangkan latihan rangkaian suapan hadapan berbilang lapisan sering menggunakan algoritma perambatan balik ralat, ia dianggap sebagai algoritma pembelajaran diselia standard dalam bidang pengecaman corak dan digunakan dalam neurologi pengiraan dan bidang pemprosesan teragih selari, terus menjadi subjek penyelidikan.

5. 1965: Pembelajaran mendalam pertama

Kejayaan pembelajaran seni bina rangkaian suapan mendalam bermula di Ukraine pada tahun 1965, apabila Alexey Ivakhnenko dan Valentin Lapa Deep MLP dengan sewenang-wenangnya banyak lapisan tersembunyi memperkenalkan algoritma pembelajaran berasaskan kerja am yang pertama.

Alexey Ivakhnenko

Diberikan satu set vektor output dengan sasaran yang sepadan Dengan set latihan vektor input, lapisan ditanam dan dilatih secara beransur-ansur melalui analisis regresi, dan kemudian dipangkas dengan bantuan set pengesahan berasingan, di mana regularisasi digunakan untuk mengalih keluar unit berlebihan. Bilangan lapisan dan unit setiap lapisan dipelajari dalam cara yang bergantung kepada masalah.

Seperti rangkaian saraf dalam kemudiannya, rangkaian Ivakhnenko belajar untuk mencipta perwakilan dalaman data masuk berlapis, teragih.

Dia tidak memanggil mereka rangkaian neural pembelajaran mendalam, tetapi itulah hakikatnya. Malah, istilah "pembelajaran mendalam" pertama kali diperkenalkan kepada pembelajaran mesin oleh Dechter pada tahun 1986, dan Aizenberg et al memperkenalkan konsep "rangkaian saraf" pada tahun 2000.

6. 1967-68: Stochastic Gradient Descent

Pada tahun 1967, Junichi Amari mula-mula mencadangkan latihan rangkaian neural melalui stochastic gradient descent (SGD).

Shunichi Amari dan pelajarnya Saito mempelajari perwakilan dalaman dalam MLP lima lapisan dengan dua lapisan boleh diubah suai, yang dilatih untuk melaksanakan pengelasan pada kelas corak boleh dipisahkan bukan linear.

Rumelhart dan Hinton et al melakukan kerja serupa pada tahun 1986 dan menamakannya sebagai algoritma perambatan belakang.

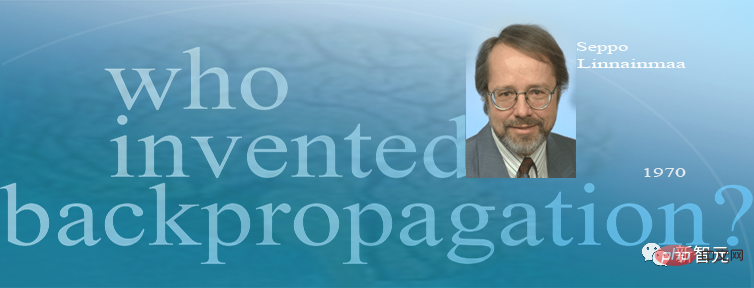

7. 1970: Algoritma perambatan balik

Pada tahun 1970, Seppo Linnainmaa menerajui dalam menerbitkan algoritma perambatan balik, yang merupakan algoritma peruntukan kredit rangkaian nod boleh dibezakan yang terkenal, juga dikenali sebagai "mod terbalik pembezaan automatik". Seppo Linnainmaa Kaedah perambatan balik ralat yang cekap untuk rangkaian saraf dengan sambungan yang jarang. Ia kini menjadi asas untuk pakej perisian rangkaian saraf yang digunakan secara meluas seperti PyTorch dan Tensorflow Google.

Backpropagation pada asasnya ialah cara yang cekap untuk melaksanakan peraturan rantaian Leibniz untuk rangkaian dalam. Penurunan kecerunan, yang dicadangkan oleh Cauchy, digunakan sepanjang banyak eksperimen untuk melemahkan sambungan rangkaian saraf tertentu secara beransur-ansur dan menguatkan yang lain.

Backpropagation pada asasnya ialah cara yang cekap untuk melaksanakan peraturan rantaian Leibniz untuk rangkaian dalam. Penurunan kecerunan, yang dicadangkan oleh Cauchy, digunakan sepanjang banyak eksperimen untuk melemahkan sambungan rangkaian saraf tertentu secara beransur-ansur dan menguatkan yang lain.

Pada tahun 1985, apabila kos pengkomputeran adalah kira-kira 1,000 kali lebih rendah daripada pada tahun 1970, apabila komputer meja hanya menjadi perkara biasa di makmal akademik yang kaya, David Rumelhart dan yang lain bereksperimen dengan kaedah yang diketahui menganalisis.

David Rumelhart

Melalui eksperimen, Rumelhart et al membuktikan bahawa perambatan belakang boleh Perwakilan dalaman yang berguna adalah dihasilkan dalam lapisan tersembunyi rangkaian saraf. Sekurang-kurangnya untuk pembelajaran terselia, penyebaran balik selalunya lebih berkesan daripada pembelajaran mendalam yang dinyatakan di atas oleh Amari Shunichi melalui kaedah SGD.

Sebelum 2010, ramai orang percaya bahawa melatih rangkaian saraf berbilang lapisan memerlukan pra-latihan tanpa pengawasan. Pada tahun 2010, pasukan Schmidhuber bersama Dan Ciresan menunjukkan bahawa FNN yang mendalam boleh dilatih dengan penyebaran belakang yang mudah dan tidak memerlukan latihan pra tanpa pengawasan sama sekali untuk aplikasi penting.

8. 1979: Rangkaian saraf konvolusi yang pertama

Pada tahun 1979, Kunihiko Fukushima membangunkan rangkaian saraf konvolusi untuk pengecaman corak di STRL model: Neocognitron.

Kunihiko Fukushima

Tetapi Neocognitron ini dalam istilah hari ini, dipanggil convolutional rangkaian saraf (CNN), adalah salah satu ciptaan terhebat dalam struktur asas rangkaian saraf dalam dan juga merupakan teknologi teras kecerdasan buatan semasa.

Neocognitron yang diperkenalkan oleh Dr. Fukushima ialah rangkaian saraf pertama yang menggunakan konvolusi dan pensampelan bawah, dan juga merupakan prototaip rangkaian saraf konvolusi.

Rangkaian saraf tiruan berbilang lapisan dengan keupayaan pembelajaran yang direka oleh Fukushima Kunihiko boleh meniru rangkaian visual otak "wawasan" ini telah menjadi asas kepada teknologi kecerdasan buatan moden. Kerja Dr. Fukushima telah membawa kepada pelbagai aplikasi praktikal, daripada kereta pandu sendiri kepada pengecaman muka, daripada pengesanan kanser kepada ramalan banjir, dan banyak lagi yang akan datang.

Pada tahun 1987, Alex Waibel menggabungkan rangkaian saraf dengan konvolusi dengan perkongsian berat dan perambatan belakang, dan mencadangkan konsep rangkaian neural tertunda (TDNN).

Sejak 1989, pasukan Yann LeCun telah menyumbang kepada penambahbaikan CNN, terutamanya dalam imej.

Yann LeCun

Pada akhir 2011, pasukan Schmidhuber mempercepatkan dengan ketara. kelajuan latihan CNN yang mendalam telah menjadikannya lebih popular dalam komuniti pembelajaran mesin. Pasukan itu melancarkan CNN berasaskan GPU: DanNet, yang lebih mendalam dan lebih pantas daripada CNN awal. Pada tahun yang sama, DanNet menjadi CNN murni pertama yang memenangi pertandingan penglihatan komputer.

Rangkaian neural sisa (ResNet) yang dicadangkan oleh empat sarjana daripada Microsoft Research memenangi tempat pertama dalam pertandingan pengecaman visual berskala besar ImageNet 2015.

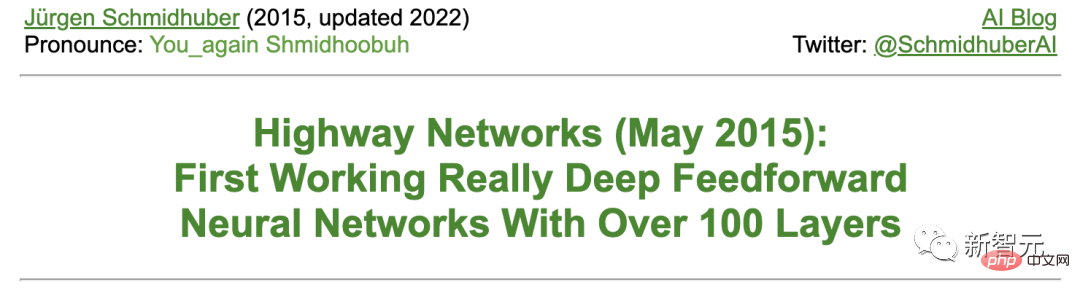

Schmidhuber berkata bahawa ResNet ialah versi awal rangkaian neural berkelajuan tinggi (Highway Net) yang dibangunkan oleh pasukannya. Ini adalah rangkaian neural suapan hadapan dalam pertama yang benar-benar berkesan dengan beratus-ratus lapisan, berbanding rangkaian saraf sebelumnya yang paling banyak hanya mempunyai berpuluh-puluh lapisan.

9. 1987-1990s: Graph Neural Network and Stochastic Delta Rule

Sebuah seni bina pembelajaran mendalam yang boleh memanipulasi data berstruktur (seperti grafik) telah dibangunkan oleh Pollack dalam 1987 dicadangkan dan diperluas dan ditambah baik oleh Sperduti, Goller dan Küchler pada awal 1990-an. Rangkaian saraf graf digunakan dalam banyak aplikasi hari ini.

Paul Werbos dan R. J. Williams et al menganalisis kaedah melaksanakan turunan kecerunan dalam RNN. Peta Penyusunan Sendiri Teuvo Kohonen juga telah menjadi popular.

Teuvo Kohonen

Pada tahun 1990, Stephen Hanson memperkenalkan peraturan delta stokastik, kaedah stokastik melatih rangkaian saraf melalui perambatan balik. Beberapa dekad kemudian, kaedah ini menjadi popular di bawah nama "keciciran".

10 Februari 1990: Generative Adversarial Network/Curiosity

Generative Adversarial Network (GAN) mula digunakan pada tahun 1990 sebagai "Artificial Intelligence Curiosity" Diterbitkan atas nama .

Dua NN lawan (penjana kebarangkalian dan peramal) cuba memaksimumkan kekalahan satu sama lain dalam permainan had minimum. Di mana:

- Penjana (dipanggil pengawal) menjana keluaran kebarangkalian (menggunakan unit stokastik, seperti StyleGAN kemudiannya).

- Peramal (dipanggil model dunia) melihat output pengawal dan meramalkan cara persekitaran akan bertindak balas terhadapnya. Menggunakan keturunan kecerunan, peramal NN meminimumkan ralatnya, manakala penjana NN cuba memaksimumkan ralat ini - satu kerugian rangkaian ialah keuntungan rangkaian yang lain.

Empat tahun sebelum kertas kerja 2014 mengenai GAN, Schmidhuber meringkaskan NN musuh generatif 1990 dalam tinjauan terkenal 2010 seperti berikut: "Sebagai model dunia ramalan Rangkaian saraf digunakan untuk memaksimumkan ganjaran intrinsik, yang berkadar dengan ralat ramalan model."

GAN yang dikeluarkan kemudian hanyalah contoh. Apabila eksperimen adalah sangat singkat, persekitaran hanya mengembalikan 1 atau 0 bergantung pada sama ada output pengawal (atau penjana) berada dalam set tertentu.

Prinsip 1990 digunakan secara meluas dalam penerokaan pembelajaran pengukuhan dan sintesis imej realistik, walaupun bidang yang kedua baru-baru ini telah diambil alih oleh Latent Diffusion oleh Rombach et al.

Pada tahun 1991, Schmidhuber menerbitkan satu lagi kaedah ML berdasarkan dua NN lawan, dipanggil pengecilan kebolehramalan, untuk mencipta perwakilan berasingan bagi data yang sebahagiannya berlebihan, Tahun 1996 digunakan pada imej.

November, April 1990: Hasilkan sub-matlamat/kerja mengikut arahan

Dalam abad kebelakangan ini, kebanyakan NN telah didedikasikan untuk pengecaman corak mudah, bukannya penaakulan lanjutan .

Walau bagaimanapun, pada awal 1990-an, pengecualian mula-mula muncul. Kerja ini menyuntik konsep kecerdasan buatan hierarki tradisional "simbolik" ke dalam NN "sub-simbolik" hujung ke hujung yang boleh dibezakan.

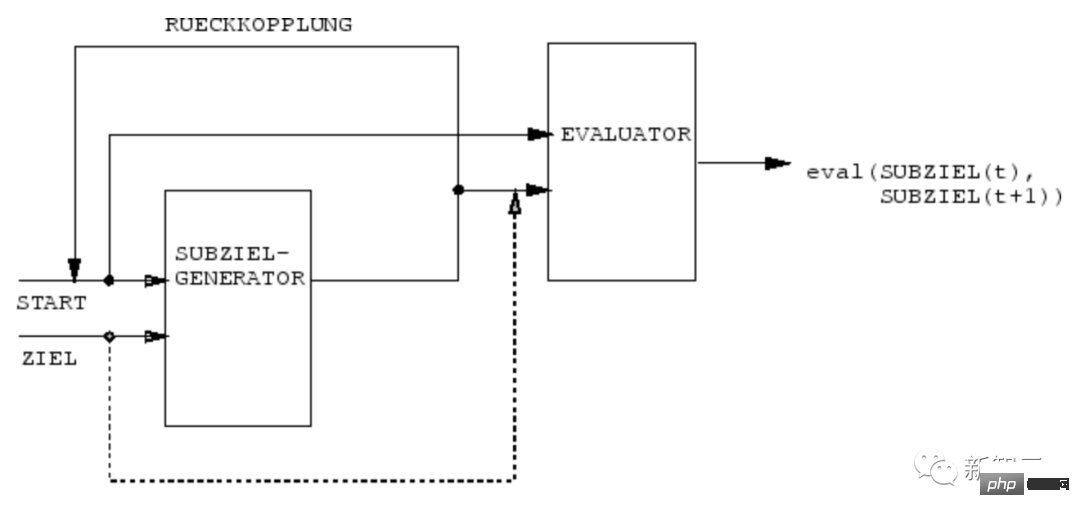

Pada tahun 1990, NN pasukan Schmidhuber belajar menggunakan penjana submatlamat NN boleh dibezakan hujung ke hujung untuk menjana pelan tindakan hierarki untuk pembelajaran pengukuhan hierarki (HRL) .

Mesin RL mendapat input arahan tambahan dalam borang (mula, sasaran). Penganggar NN belajar meramal ganjaran/kos semasa dari awal hingga matlamat. Penjana submatlamat berasaskan (R)NN juga melihat (permulaan, matlamat) dan mempelajari urutan submatlamat perantaraan kos terendah melalui keturunan kecerunan menggunakan (salinan) penilai NN. Mesin RL cuba menggunakan jujukan submatlamat ini untuk mencapai matlamat akhir.

Sistem mempelajari pelan tindakan pada pelbagai peringkat abstraksi dan skala masa berbilang, dan pada dasarnya menyelesaikan perkara yang baru-baru ini dipanggil "masalah terbuka."

Twelve, March 1991: Transformer with linear self-attention

Transformer with "linear self-attention" pertama kali diterbitkan pada Mac 1991.

Ini yang dipanggil "Fast Weight Programmer" atau "Fast Weight Controllers" mengasingkan storan dan kawalan sama seperti komputer tradisional, tetapi Dalam satu hujung ke hujung dibezakan, penyesuaian dan saraf cara rangkaian.

Selain itu, Transformers hari ini menggunakan meluas pra-latihan tanpa pengawasan, kaedah pembelajaran mendalam yang pertama kali diterbitkan oleh Schmidhuber pada 1990-1991.

13. April 1991: Pembelajaran Mendalam melalui Pra-latihan Penyeliaan Sendiri

NN yang paling berkuasa hari ini cenderung sangat mendalam, iaitu, ia mempunyai banyak lapisan neuron atau banyak peringkat pengiraan seterusnya.

Walau bagaimanapun, sebelum 1990-an, latihan berasaskan kecerunan tidak berfungsi untuk NN dalam (hanya untuk NN cetek).

Berbeza daripada feedforward NN (FNN), RNN mempunyai sambungan maklum balas. Ini menjadikan RNN sebuah komputer jujukan selari yang berkuasa, tujuan umum, yang boleh memproses jujukan input dalam sebarang panjang (seperti pertuturan atau video).

Walau bagaimanapun, sebelum 1990-an, RNN gagal mempelajari masalah mendalam dalam amalan.

Untuk tujuan ini, Schmidhuber menubuhkan hierarki RNN yang diselia sendiri untuk cuba mencapai "pembelajaran mendalam universal".

April 1991: Menyuling satu NN ke dalam NN lain

Dengan menggunakan prosedur penyulingan NN yang dicadangkan oleh Schmidhuber pada tahun 1991, di atas Perwakilan dalaman hierarki Pemampat Sejarah Neural boleh dimampatkan menjadi satu NN Rekursif (RNN).

Di sini, ilmu guru NN di "distill" kepada murid NN dengan melatih murid NN meniru tingkah laku guru NN (sambil melatih semula murid NN untuk memastikan bahawa Kemahiran yang dipelajari sebelum ini tidak akan dilupakan). Kaedah penyulingan NN juga telah diterbitkan semula bertahun-tahun kemudian dan digunakan secara meluas hari ini.

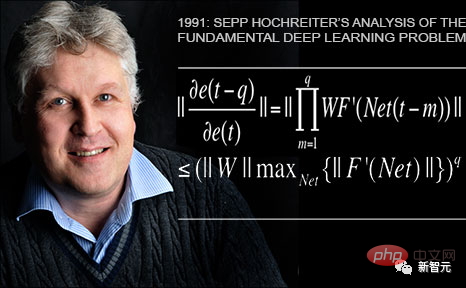

Keempat Belas, Jun 1991: Masalah asas - kecerunan yang hilang

Pelajar pertama Schmidhuber, Sepp Hochreiter menemui dan menganalisisnya dalam tesis tamat pengajian 1991 Masalah pembelajaran mendalam asas.

Deep NN mengalami masalah kecerunan lenyap yang kini terkenal: dalam rangkaian dalam atau berulang biasa, isyarat ralat rambat belakang sama ada mengecut dengan cepat atau berkembang di luar batas. Dalam kedua-dua kes, pembelajaran gagal.

Kelima Belas, Jun 1991: Asas LSTM/Highway Net/ResNet

Rekursi ingatan jangka pendek panjang (LSTM) Rangkaian saraf mengatasi masalah pembelajaran mendalam asas yang ditunjukkan oleh Sepp Hochreiter dalam tesis 1991 yang disebutkan di atas.

Selepas menerbitkan kertas semakan rakan sebaya pada tahun 1997 (kini artikel NN yang paling banyak disebut pada abad ke-20), pelajar Schmidhuber Felix Gers dan Alex Graves, antara lain, menambah baik LSTM dan prosedur latihan.

Varian LSTM yang diterbitkan pada 1999-2000, "seni bina LSTM vanila" dengan gerbang lupa, masih digunakan dalam Tensorflow Google hari ini.

Pada tahun 2005, Schmidhuber mula-mula menerbitkan artikel mengenai perambatan belakang lengkap dan perambatan dua hala LSTM dalam masa (juga digunakan secara meluas).

Kaedah latihan penting pada tahun 2006 ialah "Pengkelasan Temporal Penghubung" (CTC), yang digunakan untuk menjajarkan dan mengenal pasti jujukan secara serentak.

Pasukan Schmidhuber berjaya menggunakan LSTM terlatih CTC pada pertuturan pada tahun 2007 (terdapat juga susunan LSTM berlapis), mencapai pengecaman pertuturan saraf hujung-ke-hujung yang unggul buat kali pertama Effect.

Pada tahun 2009, melalui usaha Alex, LSTM yang dilatih oleh CTC menjadi RNN pertama memenangi pertandingan antarabangsa, iaitu tiga pertandingan tulisan tangan ICDAR 2009 (Perancis, Parsi, Arab ). Ini telah menimbulkan minat yang besar dalam industri. LSTM telah digunakan dengan pantas dalam semua situasi yang melibatkan data jujukan, seperti pertuturan dan video.

Pada tahun 2015, gabungan CTC-LSTM telah meningkatkan prestasi pengecaman pertuturan Google pada telefon pintar Android. Sehingga 2019, pengecaman pertuturan Google pada terminal mudah alih masih berdasarkan LSTM.

1995: Model Bahasa Kebarangkalian Neural

Pada tahun 1995, Schmidhuber mencadangkan model teks kebarangkalian saraf yang sangat baik, konsep asasnya telah diperkenalkan dalam 2003 Tahun telah digunakan semula.

Pada tahun 2001, Schmidhuber menunjukkan bahawa LSTM boleh mempelajari bahasa yang tidak boleh dipelajari oleh model tradisional seperti HMM.

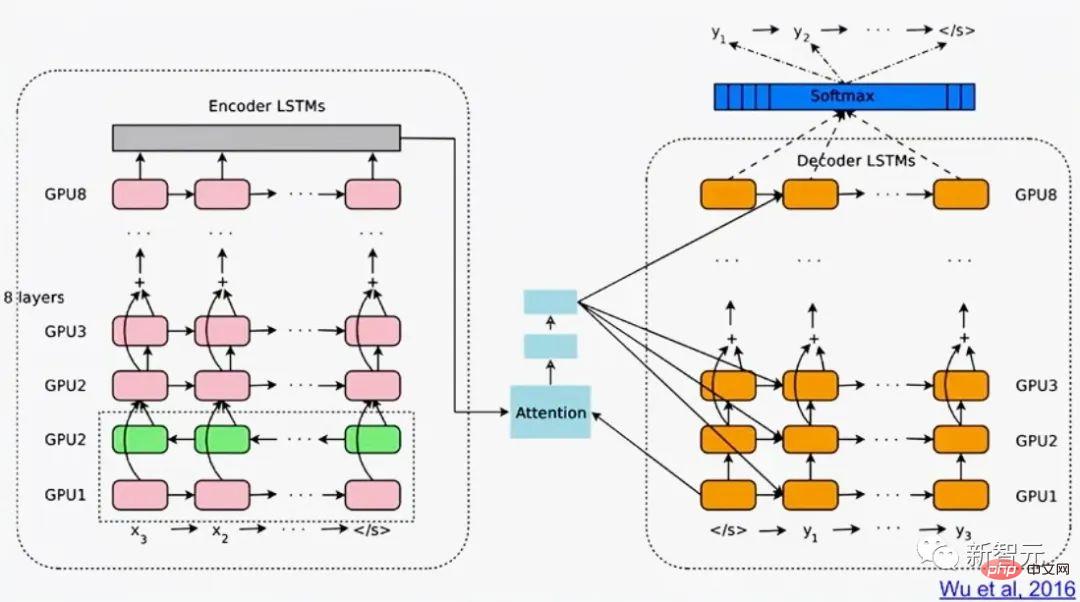

Terjemahan Google pada 2016 adalah berdasarkan dua LSTM yang disambungkan (kertas putih menyebut LSTM lebih daripada 50 kali), satu untuk teks masuk dan satu untuk terjemahan keluar.

Pada tahun yang sama, lebih suku daripada kuasa pengkomputeran besar yang digunakan untuk inferens dalam pusat data Google telah digunakan untuk LSTM (dan 5% digunakan untuk satu lagi teknologi pembelajaran mendalam yang popular, iaitu CNN).

Menjelang 2017, LSTM juga menjana terjemahan mesin untuk Facebook (lebih 30 bilion terjemahan seminggu), Apple pada kira-kira 1 bilion iPhone Ia menyediakan sokongan untuk Quicktype, Amazon Alexa Voice, Penjanaan Kapsyen Imej Google dan jawapan e-mel automatik.

Sudah tentu, LSTM Schmidhuber juga banyak digunakan dalam penjagaan kesihatan dan diagnosis perubatan - carian Google Scholar yang mudah akan menemui banyak artikel perubatan dengan "LSTM" dalam tajuk.

Pada Mei 2015, pasukan Schmidhuber mencadangkan Rangkaian Lebuhraya berdasarkan prinsip LSTM, FNN pertama yang sangat dalam dengan ratusan lapisan (sebelum ini The NN mempunyai hanya beberapa dozen lapisan paling banyak). ResNet Microsoft (yang memenangi pertandingan ImageNet 2015) adalah versinya.

Prestasi Highway Net awal pada ImageNet adalah lebih kurang sama dengan ResNet. Varian Highway Net juga digunakan untuk tugas algoritma tertentu di mana lapisan sisa tulen tidak berfungsi dengan baik.

Prinsip LSTM/Highway Net ialah teras pembelajaran mendalam moden

Teras pembelajaran mendalam ialah kedalaman NN.

Pada tahun 1990-an, LSTM membawa kedalaman tidak terhingga kepada NN rekursif yang diawasi pada tahun 2000, Jaringan Lebuhraya yang diinspirasikan oleh LSTM dibawa ke kedalaman NN ke hadapan.

Kini, LSTM telah menjadi NN yang paling banyak disebut dalam abad ke-20, dan ResNet, salah satu versi Lebuhraya Net, Ia adalah NN yang paling banyak disebut dalam abad ke-21.

Enam belas, 1980 hingga sekarang: Tindakan pembelajaran NNN tanpa guru

Selain itu, NN juga berkaitan dengan pembelajaran pengukuhan (RL).

Walaupun beberapa masalah boleh diselesaikan dengan teknologi bukan saraf yang dicipta seawal tahun 1980-an. Contohnya, carian pokok Monte Carlo (MC), pengaturcaraan dinamik (DP), evolusi buatan, pemangkasan α-β, teori kawalan dan pengenalan sistem, keturunan kecerunan stokastik dan teknik carian umum. Tetapi FNN dan RNN mendalam boleh membawa hasil yang lebih baik untuk jenis tugasan RL tertentu.

Secara amnya, agen pembelajaran pengukuhan mesti belajar bagaimana untuk berinteraksi dengan persekitaran yang dinamik, pada mulanya tidak diketahui, separa boleh diperhatikan tanpa bantuan guru, supaya yang diharapkan Memaksimumkan isyarat ganjaran terkumpul . Mungkin terdapat kelewatan yang sewenang-wenangnya, a priori tidak diketahui antara tindakan dan akibat yang dirasakan.

Berdasarkan pengaturcaraan dinamik (DP)/masa apabila persekitaran mempunyai antara muka Markov supaya input kepada ejen RL boleh menyampaikan semua maklumat yang diperlukan untuk menentukan tindakan terbaik seterusnya Differential ( TD)/Monte Carlo tree search (MC) RL boleh menjadi sangat berjaya.

Untuk kes yang lebih kompleks tanpa antara muka Markov, ejen mesti mempertimbangkan bukan sahaja input semasa, tetapi juga sejarah input sebelumnya. Dalam hal ini, gabungan algoritma RL dan LSTM telah menjadi penyelesaian standard, terutamanya LSTM yang dilatih melalui kecerunan dasar.

Contohnya, pada tahun 2018, LSTM terlatih PG di tengah-tengah Dactyl terkenal OpenAI belajar mengawal tangan robotik yang cekap tanpa guru.

Begitu juga dengan permainan video.

Pada 2019, DeepMind (diasaskan bersama oleh pelajar dari Schmidhuber Lab) mengalahkan pemain profesional dalam permainan "StarCraft" yang digunakan di dalamnya terdiri daripada teras Deep LSTM yang dilatih oleh PG.

Pada masa yang sama, RL LSTM (mengambil kira 84% daripada jumlah parameter dalam model) juga merupakan teras kepada OpenAI Five yang terkenal, yang mengalahkan pemain manusia profesional dalam Dota 2.

Masa depan RL adalah tentang pembelajaran/penggabungjalinan/perancangan dengan abstraksi spatio-temporal padat aliran input yang kompleks, iaitu tentang penaakulan akal dan pembelajaran untuk berfikir.

Schmidhuber mencadangkan dalam kertas kerja yang diterbitkan pada tahun 1990-91 bahawa pemampat sejarah saraf yang diselia sendiri boleh mempelajari konsep perwakilan pada pelbagai peringkat abstraksi dan skala masa berbilang dan berdasarkan terminal Dengan penjana sub-matlamat NN hujung ke hujung yang boleh dibezakan, pelan tindakan hierarki boleh dipelajari melalui keturunan kecerunan.

Seterusnya pada tahun 1997 dan 2015-18, kaedah yang lebih canggih untuk mempelajari pemikiran abstrak telah diterbitkan.

17 Ini adalah masalah perkakasan, bodoh! mampu Mungkin ada kejayaan besar.

Peranti pengkomputeran bergilir pertama kami yang diketahui ialah mekanisme Antikythera dari Greece purba lebih 2,000 tahun yang lalu. Ia adalah komputer saintifik kompleks tertua yang dikenali hari ini dan komputer analog pertama di dunia.

Dan yang pertama di dunia Ini boleh diprogramkan praktikal mesin telah dicipta oleh mekanik Yunani kuno Helen pada abad ke-1 Masihi.

Mesin pada abad ke-17 menjadi lebih fleksibel dan boleh mengira jawapan berdasarkan data input.

Kalkulator mekanikal pertama untuk aritmetik ringkas telah dicipta dan dihasilkan oleh Wilhelm Schickard pada tahun 1623.

Pada tahun 1673, Leibniz mereka bentuk mesin pertama yang boleh melakukan keempat-empat operasi aritmetik dan mempunyai ingatan. Beliau juga menerangkan prinsip komputer binari yang dikawal oleh kad tebuk dan mencadangkan peraturan rantaian, yang membentuk bahagian penting dalam pembelajaran mendalam dan kecerdasan buatan moden.

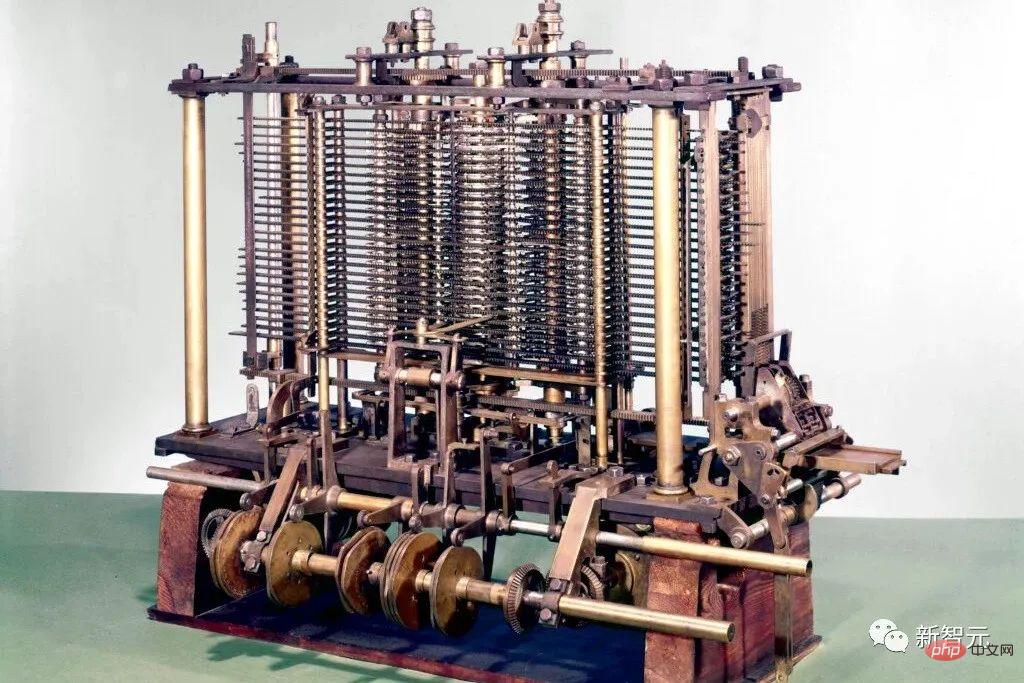

Sekitar tahun 1800, Joseph ·Joseph Marie Jacquard dan yang lain membina mesin tenun yang boleh direka bentuk pertama di Perancis - mesin Jacquard. Ciptaan ini memainkan peranan penting dalam pembangunan masa depan mesin boleh atur cara lain, seperti komputer.

Mereka memberi inspirasi kepada Ada Low Ada Lovelace dan mentornya Charles Babbage mencipta pendahulu kepada komputer elektronik moden: Enjin Perbezaan Babbage.

Pada tahun 1843 berikut, Lovelace menerbitkan set pertama algoritma komputer di dunia.

Pada tahun 1914, Leonardo Torres dari Sepanyol y Quevedo menjadi perintis kecerdasan buatan pertama pada abad ke-20 apabila dia mencipta pemain mesin terminal catur pertama.

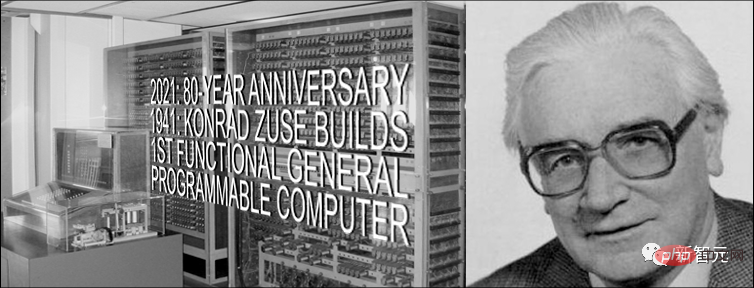

Antara 1935 dan 1941, Konrad Zuse mencipta komputer tujuan am boleh atur cara beroperasi pertama di dunia: Z3.

Conrad Zuse

Tidak seperti Enjin Analitik Babbage, Zuse menggunakan prinsip pengiraan binari Leibniz, bukannya pengiraan perpuluhan tradisional. Ini sangat memudahkan beban pada perkakasan.

Pada tahun 1944, Howard Aiken mengetuai pasukan untuk mencipta komputer digital automatik berskala besar pertama di dunia, Mark I (Mark I).

Dicipta pada tahun 1948 oleh Frederic Williams, Tom Kilburn dan Geoff Tootill Komputer atur cara tersimpan elektronik pertama di dunia: Small Experimental Machine (SSEM), juga dikenali sebagai "Manchester Baby".

Replika "Manchester Baby"

Sejak itu, operasi Komputer telah menjadi lebih pantas dengan bantuan litar bersepadu (IC). Pada tahun 1949, Werner Jacobi dari Siemens memohon paten untuk semikonduktor litar bersepadu yang membolehkan berbilang transistor pada substrat biasa.

Pada tahun 1958, Jack Kilby menunjukkan litar bersepadu dengan wayar luaran. Pada tahun 1959, Robert Noyce mencadangkan litar bersepadu monolitik. Sejak tahun 1970-an, unit pemprosesan grafik (GPU) telah digunakan untuk mempercepatkan pengkomputeran melalui pemprosesan selari. Hari ini, GPU komputer mengandungi berbilion transistor.

Di manakah had fizikal?

Menurut had Bremermann yang dicadangkan oleh Hans Joachim Bremermann, komputer dengan jisim 1 kilogram dan isipadu 1 liter paling banyak Boleh melakukan sehingga 10 hingga kuasa ke-51 operasi sesaat dalam kedudukan sehingga 10 hingga kuasa ke-32.

Hans Joachim Bremermann

Walau bagaimanapun, jisim sistem suria hanya 2x10^30 kilogram, dan trend ini pasti akan pecah dalam beberapa abad, kerana kelajuan cahaya akan sangat mengehadkan pemerolehan jisim tambahan dalam bentuk sistem suria yang lain.

Oleh itu, kekangan fizik memerlukan perkakasan pengkomputeran yang cekap masa hadapan mestilah seperti otak, dengan banyak pemproses diletakkan padat dalam ruang tiga dimensi untuk meminimumkan jumlah kos sambungan, seni bina asasnya Pada asasnya RNN tiga dimensi yang dalam dan jarang disambungkan.

Schmidhuber membuat spekulasi bahawa kaedah pembelajaran mendalam untuk RNN tersebut akan menjadi lebih penting.

18. Teori Kecerdasan Buatan sejak 1931

Teras kecerdasan buatan moden dan pembelajaran mendalam terutamanya berdasarkan matematik dalam abad kebelakangan ini: kalkulus, Algebra linear dan statistik.

Pada awal 1930-an, Gödel mengasaskan sains komputer teori moden. Beliau memperkenalkan bahasa pengekodan universal berdasarkan integer yang membenarkan operasi mana-mana komputer digital diformalkan dalam bentuk aksiomatik.

Pada masa yang sama, Gödel juga membina pernyataan rasmi yang terkenal, yang secara sistematik menyenaraikan semua teorem yang mungkin daripada set aksiom yang diberi penguji teorem pengiraan. Oleh itu, beliau mengenal pasti batasan asas pembuktian teorem algoritma, pengiraan, dan sebarang jenis kecerdasan buatan berasaskan pengiraan.

Selain itu, Gödel mengenal pasti masalah terbuka yang paling terkenal dalam sains komputer "P=NP?" dalam suratnya yang terkenal kepada John von Neumann.

Pada tahun 1935, Gereja Alonzo memperoleh akibat daripada keputusan Gödel dengan membuktikan bahawa tiada penyelesaian umum untuk masalah membuat keputusan Hilbert dan Ackermann. Untuk melakukan ini, dia menggunakan satu lagi bahasa pengekodan tujuan amnya yang dipanggil Untyped Lambda Calculus, yang membentuk asas bahasa pengaturcaraan LISP yang sangat berpengaruh.

Pada tahun 1936, Alan Turing memperkenalkan model umum lain: mesin Turing, dan memperoleh semula keputusan di atas. Pada tahun yang sama, Emil Post menerbitkan satu lagi model umum pengkomputeran bebas.

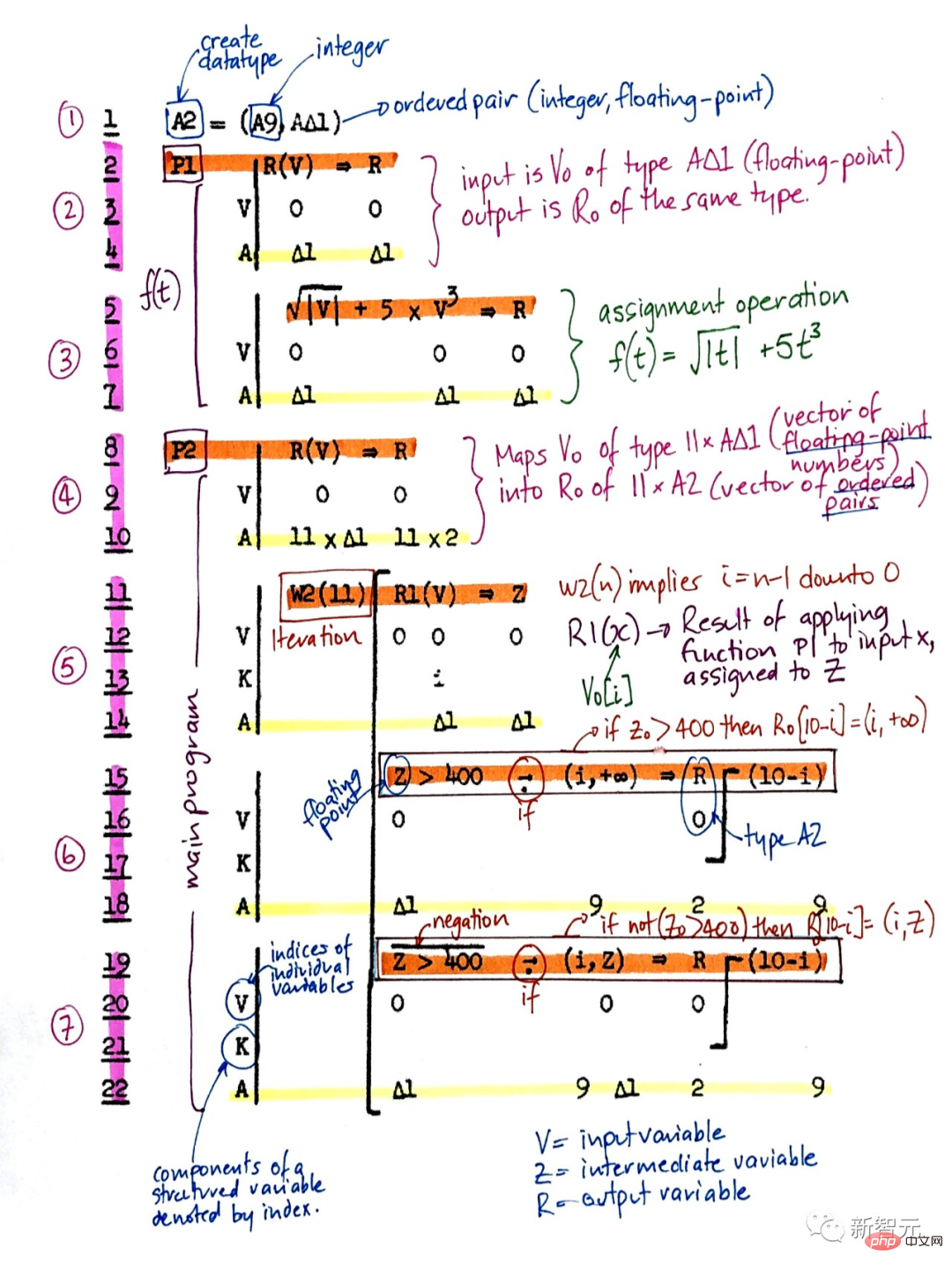

Konrad Zuse bukan sahaja mencipta komputer tujuan am boleh atur cara yang pertama di dunia, tetapi juga mereka bentuk bahasa pengaturcaraan peringkat tinggi pertama, Plankalkül. Dia menggunakannya untuk catur pada tahun 1945 dan teorem pembuktian pada tahun 1948.

Plankalkül

Kebanyakan awal 1940-an-70an Kecerdasan buatan adalah benar-benar tentang pembuktian teorem dan terbitan Gödelian melalui sistem pakar dan pengaturcaraan logik.

Pada tahun 1964, Ray Solomonoff menggabungkan penaakulan probabilistik Bayesian (sebenarnya Laplacian) dan sains komputer teori untuk mencapai kaedah pembelajaran matematik yang optimum (tetapi tidak boleh dilaksanakan secara pengiraan) untuk meramalkan data masa depan daripada pemerhatian lepas.

Bersama Andrej Kolmogorov beliau mengasaskan teori Korotkoff Complexity atau Algoritmic Information Theory (AIT), memformalkan konsep pisau cukur Occam melalui konsep program terpendek untuk mengira data, sekali gus mengatasi teori maklumat tradisional.

Kerumitan Coriolis

Mesin Gödel yang merujuk sendiri adalah lebih umum. optimum tidak terhad kepada optimum asimptotik.

Walau bagaimanapun, AI yang optimum secara matematik masih belum boleh dilaksanakan dalam amalan atas pelbagai sebab. Sebaliknya, kecerdasan buatan moden yang praktikal adalah berdasarkan teknologi suboptimum, terhad, tetapi tidak begitu difahami, seperti NN dan pembelajaran mendalam menjadi tumpuan.

Tetapi siapa tahu bagaimana rupa sejarah kecerdasan buatan dalam masa 20 tahun?

Atas ialah kandungan terperinci 300 tahun kecerdasan buatan! Bapa LSTM menulis artikel panjang 10,000 perkataan: Penjelasan terperinci tentang sejarah pembangunan AI moden dan pembelajaran mendalam. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1377

1377

52

52

Bytedance Cutting melancarkan keahlian super SVIP: 499 yuan untuk langganan tahunan berterusan, menyediakan pelbagai fungsi AI

Jun 28, 2024 am 03:51 AM

Bytedance Cutting melancarkan keahlian super SVIP: 499 yuan untuk langganan tahunan berterusan, menyediakan pelbagai fungsi AI

Jun 28, 2024 am 03:51 AM

Laman web ini melaporkan pada 27 Jun bahawa Jianying ialah perisian penyuntingan video yang dibangunkan oleh FaceMeng Technology, anak syarikat ByteDance Ia bergantung pada platform Douyin dan pada asasnya menghasilkan kandungan video pendek untuk pengguna platform tersebut Windows , MacOS dan sistem pengendalian lain. Jianying secara rasmi mengumumkan peningkatan sistem keahliannya dan melancarkan SVIP baharu, yang merangkumi pelbagai teknologi hitam AI, seperti terjemahan pintar, penonjolan pintar, pembungkusan pintar, sintesis manusia digital, dsb. Dari segi harga, yuran bulanan untuk keratan SVIP ialah 79 yuan, yuran tahunan ialah 599 yuan (nota di laman web ini: bersamaan dengan 49.9 yuan sebulan), langganan bulanan berterusan ialah 59 yuan sebulan, dan langganan tahunan berterusan ialah 499 yuan setahun (bersamaan dengan 41.6 yuan sebulan) . Di samping itu, pegawai yang dipotong juga menyatakan bahawa untuk meningkatkan pengalaman pengguna, mereka yang telah melanggan VIP asal

Pembantu pengekodan AI yang ditambah konteks menggunakan Rag dan Sem-Rag

Jun 10, 2024 am 11:08 AM

Pembantu pengekodan AI yang ditambah konteks menggunakan Rag dan Sem-Rag

Jun 10, 2024 am 11:08 AM

Tingkatkan produktiviti, kecekapan dan ketepatan pembangun dengan menggabungkan penjanaan dipertingkatkan semula dan memori semantik ke dalam pembantu pengekodan AI. Diterjemah daripada EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG, pengarang JanakiramMSV. Walaupun pembantu pengaturcaraan AI asas secara semulajadi membantu, mereka sering gagal memberikan cadangan kod yang paling relevan dan betul kerana mereka bergantung pada pemahaman umum bahasa perisian dan corak penulisan perisian yang paling biasa. Kod yang dijana oleh pembantu pengekodan ini sesuai untuk menyelesaikan masalah yang mereka bertanggungjawab untuk menyelesaikannya, tetapi selalunya tidak mematuhi piawaian pengekodan, konvensyen dan gaya pasukan individu. Ini selalunya menghasilkan cadangan yang perlu diubah suai atau diperhalusi agar kod itu diterima ke dalam aplikasi

Bolehkah penalaan halus benar-benar membolehkan LLM mempelajari perkara baharu: memperkenalkan pengetahuan baharu boleh menjadikan model menghasilkan lebih banyak halusinasi

Jun 11, 2024 pm 03:57 PM

Bolehkah penalaan halus benar-benar membolehkan LLM mempelajari perkara baharu: memperkenalkan pengetahuan baharu boleh menjadikan model menghasilkan lebih banyak halusinasi

Jun 11, 2024 pm 03:57 PM

Model Bahasa Besar (LLM) dilatih pada pangkalan data teks yang besar, di mana mereka memperoleh sejumlah besar pengetahuan dunia sebenar. Pengetahuan ini dibenamkan ke dalam parameter mereka dan kemudiannya boleh digunakan apabila diperlukan. Pengetahuan tentang model ini "diperbaharui" pada akhir latihan. Pada akhir pra-latihan, model sebenarnya berhenti belajar. Selaraskan atau perhalusi model untuk mempelajari cara memanfaatkan pengetahuan ini dan bertindak balas dengan lebih semula jadi kepada soalan pengguna. Tetapi kadangkala pengetahuan model tidak mencukupi, dan walaupun model boleh mengakses kandungan luaran melalui RAG, ia dianggap berfaedah untuk menyesuaikan model kepada domain baharu melalui penalaan halus. Penalaan halus ini dilakukan menggunakan input daripada anotasi manusia atau ciptaan LLM lain, di mana model menemui pengetahuan dunia sebenar tambahan dan menyepadukannya

Tujuh Soalan Temuduga Teknikal GenAI & LLM yang Cool

Jun 07, 2024 am 10:06 AM

Tujuh Soalan Temuduga Teknikal GenAI & LLM yang Cool

Jun 07, 2024 am 10:06 AM

Untuk mengetahui lebih lanjut tentang AIGC, sila layari: 51CTOAI.x Komuniti https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou berbeza daripada bank soalan tradisional yang boleh dilihat di mana-mana sahaja di Internet memerlukan pemikiran di luar kotak. Model Bahasa Besar (LLM) semakin penting dalam bidang sains data, kecerdasan buatan generatif (GenAI) dan kecerdasan buatan. Algoritma kompleks ini meningkatkan kemahiran manusia dan memacu kecekapan dan inovasi dalam banyak industri, menjadi kunci kepada syarikat untuk kekal berdaya saing. LLM mempunyai pelbagai aplikasi Ia boleh digunakan dalam bidang seperti pemprosesan bahasa semula jadi, penjanaan teks, pengecaman pertuturan dan sistem pengesyoran. Dengan belajar daripada sejumlah besar data, LLM dapat menjana teks

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Editor |ScienceAI Question Answering (QA) set data memainkan peranan penting dalam mempromosikan penyelidikan pemprosesan bahasa semula jadi (NLP). Set data QA berkualiti tinggi bukan sahaja boleh digunakan untuk memperhalusi model, tetapi juga menilai dengan berkesan keupayaan model bahasa besar (LLM), terutamanya keupayaan untuk memahami dan menaakul tentang pengetahuan saintifik. Walaupun pada masa ini terdapat banyak set data QA saintifik yang meliputi bidang perubatan, kimia, biologi dan bidang lain, set data ini masih mempunyai beberapa kekurangan. Pertama, borang data adalah agak mudah, kebanyakannya adalah soalan aneka pilihan. Ia mudah dinilai, tetapi mengehadkan julat pemilihan jawapan model dan tidak dapat menguji sepenuhnya keupayaan model untuk menjawab soalan saintifik. Sebaliknya, Soal Jawab terbuka

Lima sekolah pembelajaran mesin yang anda tidak tahu

Jun 05, 2024 pm 08:51 PM

Lima sekolah pembelajaran mesin yang anda tidak tahu

Jun 05, 2024 pm 08:51 PM

Pembelajaran mesin ialah cabang penting kecerdasan buatan yang memberikan komputer keupayaan untuk belajar daripada data dan meningkatkan keupayaan mereka tanpa diprogramkan secara eksplisit. Pembelajaran mesin mempunyai pelbagai aplikasi dalam pelbagai bidang, daripada pengecaman imej dan pemprosesan bahasa semula jadi kepada sistem pengesyoran dan pengesanan penipuan, dan ia mengubah cara hidup kita. Terdapat banyak kaedah dan teori yang berbeza dalam bidang pembelajaran mesin, antaranya lima kaedah yang paling berpengaruh dipanggil "Lima Sekolah Pembelajaran Mesin". Lima sekolah utama ialah sekolah simbolik, sekolah sambungan, sekolah evolusi, sekolah Bayesian dan sekolah analogi. 1. Simbolisme, juga dikenali sebagai simbolisme, menekankan penggunaan simbol untuk penaakulan logik dan ekspresi pengetahuan. Aliran pemikiran ini percaya bahawa pembelajaran adalah proses penolakan terbalik, melalui sedia ada

Prestasi SOTA, kaedah AI ramalan pertalian protein-ligan pelbagai mod Xiamen, menggabungkan maklumat permukaan molekul buat kali pertama

Jul 17, 2024 pm 06:37 PM

Prestasi SOTA, kaedah AI ramalan pertalian protein-ligan pelbagai mod Xiamen, menggabungkan maklumat permukaan molekul buat kali pertama

Jul 17, 2024 pm 06:37 PM

Editor |. KX Dalam bidang penyelidikan dan pembangunan ubat, meramalkan pertalian pengikatan protein dan ligan dengan tepat dan berkesan adalah penting untuk pemeriksaan dan pengoptimuman ubat. Walau bagaimanapun, kajian semasa tidak mengambil kira peranan penting maklumat permukaan molekul dalam interaksi protein-ligan. Berdasarkan ini, penyelidik dari Universiti Xiamen mencadangkan rangka kerja pengekstrakan ciri berbilang mod (MFE) novel, yang buat pertama kalinya menggabungkan maklumat mengenai permukaan protein, struktur dan jujukan 3D, dan menggunakan mekanisme perhatian silang untuk membandingkan ciri modaliti yang berbeza penjajaran. Keputusan eksperimen menunjukkan bahawa kaedah ini mencapai prestasi terkini dalam meramalkan pertalian mengikat protein-ligan. Tambahan pula, kajian ablasi menunjukkan keberkesanan dan keperluan maklumat permukaan protein dan penjajaran ciri multimodal dalam rangka kerja ini. Penyelidikan berkaitan bermula dengan "S

Meletakkan pasaran seperti AI, GlobalFoundries memperoleh teknologi gallium nitrida Tagore Technology dan pasukan berkaitan

Jul 15, 2024 pm 12:21 PM

Meletakkan pasaran seperti AI, GlobalFoundries memperoleh teknologi gallium nitrida Tagore Technology dan pasukan berkaitan

Jul 15, 2024 pm 12:21 PM

Menurut berita dari laman web ini pada 5 Julai, GlobalFoundries mengeluarkan kenyataan akhbar pada 1 Julai tahun ini, mengumumkan pemerolehan teknologi power gallium nitride (GaN) Tagore Technology dan portfolio harta intelek, dengan harapan dapat mengembangkan bahagian pasarannya dalam kereta dan Internet of Things dan kawasan aplikasi pusat data kecerdasan buatan untuk meneroka kecekapan yang lebih tinggi dan prestasi yang lebih baik. Memandangkan teknologi seperti AI generatif terus berkembang dalam dunia digital, galium nitrida (GaN) telah menjadi penyelesaian utama untuk pengurusan kuasa yang mampan dan cekap, terutamanya dalam pusat data. Laman web ini memetik pengumuman rasmi bahawa semasa pengambilalihan ini, pasukan kejuruteraan Tagore Technology akan menyertai GLOBALFOUNDRIES untuk membangunkan lagi teknologi gallium nitride. G