Peranti teknologi

Peranti teknologi

AI

AI

Versi rasmi PyTorch 2.0 dikeluarkan! Satu baris kod dipercepatkan 2 kali ganda, 100% serasi ke belakang

Versi rasmi PyTorch 2.0 dikeluarkan! Satu baris kod dipercepatkan 2 kali ganda, 100% serasi ke belakang

Versi rasmi PyTorch 2.0 dikeluarkan! Satu baris kod dipercepatkan 2 kali ganda, 100% serasi ke belakang

Versi rasmi PyTorch 2.0 akhirnya di sini!

Disember lalu, Yayasan PyTorch mengeluarkan versi pratonton pertama PyTorch 2.0 pada Persidangan PyTorch 2022.

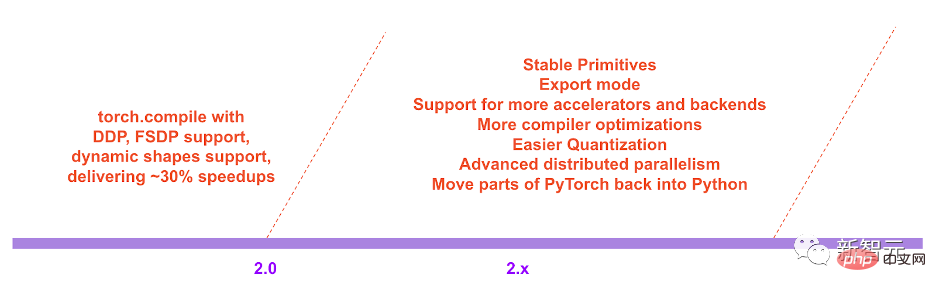

Berbanding dengan versi 1.0 sebelumnya, 2.0 telah mengalami perubahan subversif. Dalam PyTorch 2.0, peningkatan terbesar ialah torch.compile.

Pengkompil baharu boleh menjana kod secara on-the-fly jauh lebih pantas daripada "mod bersemangat" lalai dalam PyTorch 1.0, meningkatkan lagi prestasi PyTorch .

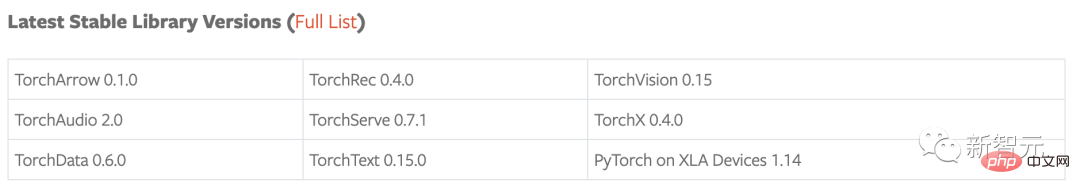

Sebagai tambahan kepada 2.0, satu siri kemas kini beta untuk perpustakaan domain PyTorch telah dikeluarkan, termasuk yang terdapat dalam perpustakaan pokok, serta perpustakaan kendiri termasuk TorchAudio, TorchVision dan TorchText. Kemas kini kepada TorchX juga dikeluarkan pada masa yang sama untuk menyediakan mod sokongan komuniti.

Ringkasan Sorotan

- torch.compile ialah API utama PyTorch 2.0, ia membungkus dan returns Untuk model yang disusun, torch.compile ialah ciri tambahan (dan pilihan) sepenuhnya, jadi versi 2.0 adalah 100% serasi ke belakang.

- Sebagai teknologi asas torch.compile, TorchInductor dengan GPU Nvidia dan AMD akan bergantung pada pengkompil pembelajaran mendalam OpenAI Triton untuk menjana kod berprestasi tinggi dan Sembunyikan butiran perkakasan peringkat rendah. Prestasi pelaksanaan kernel yang dijana oleh OpenAI Triton adalah setanding dengan kernel tulisan tangan dan perpustakaan CUDA khusus seperti cublas.

- Accelerated Transformers memperkenalkan sokongan berprestasi tinggi untuk latihan dan inferens, menggunakan seni bina kernel tersuai untuk melaksanakan Scaled Dot Product Attention (SPDA). API disepadukan dengan torch.compile(), dan pembangun model juga boleh menggunakan kernel perhatian produk titik berskala secara langsung dengan memanggil pengendali skala_dot_product_attention() baharu.

- Bahagian belakang Metal Performance Shaders (MPS) menyediakan latihan PyTorch dipercepatkan GPU pada platform Mac dan menambah sokongan untuk 60 operasi teratas yang paling biasa digunakan, meliputi lebih banyak lagi daripada 300 operator.

- Amazon AWS mengoptimumkan inferens CPU PyTorch pada tika C7g berdasarkan AWS Graviton3. PyTorch 2.0 meningkatkan prestasi inferens Graviton berbanding versi sebelumnya, termasuk penambahbaikan pada Resnet50 dan Bert.

- Ciri dan teknik prototaip baharu merentas TensorParallel, DTensor, selari 2D, TorchDynamo, AOTautograd, PrimTorch dan TorchInductor.

Kompil, masih susun!

Teknologi pengkompil terkini PyTorch 2.0 termasuk: TorchDynamo, AOTautograd, PrimTorch dan TorchInductor. Semua ini dibangunkan dalam Python, bukan C++ (yang serasi dengan Python).

Ia juga menyokong bentuk dinamik, yang boleh menghantar vektor dengan saiz yang berbeza tanpa menyusun semula. Ia fleksibel dan mudah dipelajari.

- TorchDynamo

Ia boleh mendapatkan program PyTorch dengan selamat dengan bantuan Python Frame Evaluation Hooks Inovasi utama ini ialah tangkapan struktur graf keselamatan PyTorch (selamat Ringkasan penyelidikan dan hasil pembangunan dalam tangkapan graf).

- AOTautograd

Bebankan enjin autograd PyTorch sebagai autodiff pengesanan untuk menjana jejak ke belakang lanjutan.

- PrimTorch

Ringkasan 2000+ pengendali PyTorch kepada kira-kira 250 set tertutup pengendali primitif, pembangun boleh membina bahagian belakang PyTorch yang lengkap. PrimTorch sangat memudahkan proses menulis fungsi atau bahagian belakang PyTorch.

- TorchInductor

TorchInductor ialah penyusun pembelajaran mendalam yang boleh menjana kod pantas untuk berbilang pemecut dan hujung belakang. Untuk GPU NVIDIA, ia menggunakan OpenAI Triton sebagai blok binaan utama.

Yayasan PyTorch berkata bahawa pelancaran 2.0 akan mempromosikan "pulangan daripada C++ kepada Python", sambil menambah bahawa ini adalah hala tuju baharu yang besar untuk PyTorch.

"Kami tahu had prestasi pelaksanaan yang bersemangat sejak hari pertama. Pada Julai 2017, kami memulakan projek penyelidikan pertama kami, membangunkan pengkompil untuk PyTorch. Pengkompil perlu menjadikan program PyTorch berjalan dengan cepat, tetapi tidak mengorbankan pengalaman PyTorch, sambil mengekalkan fleksibiliti dan kemudahan penggunaan, supaya penyelidik boleh menggunakan model dan program dinamik pada peringkat penerokaan yang berbeza. 》

Sudah tentu, "mod bersemangat" yang tidak disusun menggunakan penjana kod masa nyata dinamik dan masih tersedia dalam 2.0. Pembangun boleh menggunakan arahan porch.compile untuk menaik taraf dengan pantas kepada mod tersusun dengan menambahkan hanya satu baris kod.

Pengguna dapat melihat bahawa masa penyusunan 2.0 dipertingkatkan sebanyak 43% berbanding 1.0.

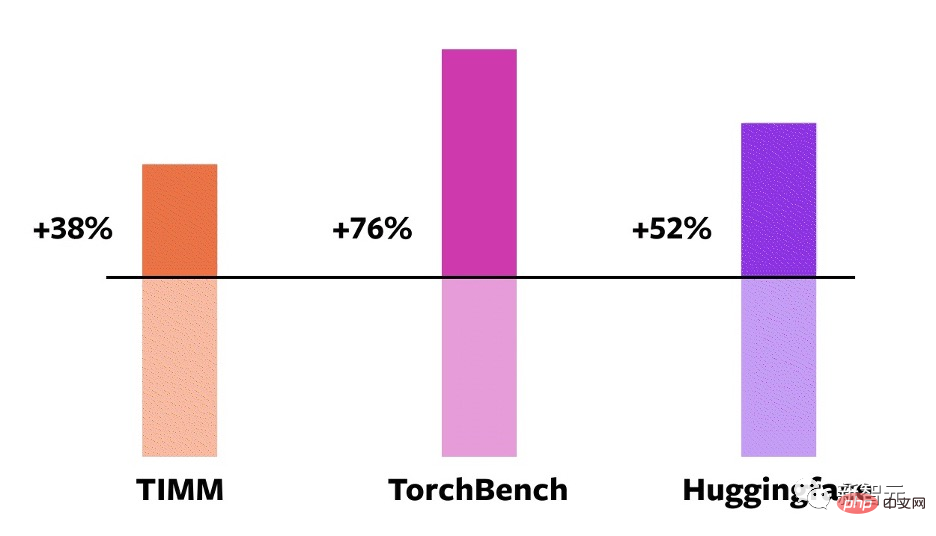

Data ini datang daripada ujian penanda aras Yayasan PyTorch terhadap 163 model sumber terbuka menggunakan PyTorch 2.0 pada GPU Nvidia A100, termasuk pengelasan imej, pengesanan sasaran, penjanaan imej dan tugas lain, serta pelbagai tugas NLP.

Tanda Aras ini dibahagikan kepada tiga kategori: HuggingFace Transformers, TIMM dan TorchBench.

NVIDIA A100 GPU eager mode torch.compile prestasi kelajuan untuk model yang berbeza

Menurut PyTorch Foundation, pengkompil baharu berjalan 21% lebih pantas apabila menggunakan mod ketepatan Float32 dan 51% lebih pantas apabila menggunakan mod ketepatan campuran automatik (AMP).

Antara 163 model ini, torch.compile boleh dijalankan secara normal pada 93% model.

"Dalam pelan hala tuju PyTorch 2.x, kami berharap untuk mengambil mod yang disusun lebih jauh dari segi prestasi dan kebolehskalaan. Terdapat beberapa kerja yang masih perlu selesai Tidak dimulakan. Beberapa tugas tidak dilaksanakan kerana jalur lebar tidak mencukupi 》

Latihan LLM dipercepatkan sebanyak 2 kali

Selain itu, prestasi ialah satu lagi fokus utama PyTorch 2.0, dan satu lagi yang telah dipromosikan oleh pembangun.

Malah, salah satu sorotan ciri baharu itu ialah Accelerated Transformers, sebelum ini dikenali sebagai Better Transformers.

Selain itu, versi rasmi PyTorch 2.0 termasuk pelaksanaan PyTorch TransformAPI berprestasi tinggi baharu.

Salah satu matlamat projek PyTorch adalah untuk menjadikan latihan dan penggunaan model transformer tercanggih lebih mudah dan pantas.

Transformer ialah teknologi asas yang membantu merealisasikan era moden kecerdasan buatan generatif, termasuk model OpenAI seperti GPT-3 dan GPT-4.

Dalam PyTorch 2.0 Accelerated Transformers, kaedah seni bina isirong tersuai (juga dikenali sebagai produk titik berskala Attention SDPA), menyediakan sokongan berprestasi tinggi untuk latihan dan inferens.

Memandangkan terdapat banyak jenis perkakasan yang boleh menyokong Transformers, PyTorch 2.0 boleh menyokong berbilang kernel tersuai SDPA. Melangkah lebih jauh, PyTorch menyepadukan logik pemilihan kernel tersuai yang akan memilih kernel berprestasi tertinggi untuk model dan jenis perkakasan tertentu.

Impak pecutan adalah ketara, kerana ia membantu membolehkan pembangun melatih model lebih pantas daripada lelaran PyTorch sebelumnya.

Versi baharu membolehkan sokongan berprestasi tinggi untuk latihan dan inferens, menggunakan seni bina kernel tersuai untuk mengendalikan Scaled Dot Product Attention (SPDA), memanjangkan laluan pantas inferens seni bina.

Serupa dengan seni bina fastpath, kernel tersuai disepadukan sepenuhnya ke dalam API Transformer PyTorch - oleh itu, menggunakan Transformer asli dan API MultiHeadAttention akan membolehkan pengguna untuk:

- lihat peningkatan kelajuan yang ketara; model cross-attention, penyahkod Transformer dan model latihan; untuk mekanisme daya.

Untuk memanfaatkan sepenuhnya model perkakasan yang berbeza dan kes penggunaan Transformer, berbilang teras tersuai SDPA disokong, logik pemilihan teras tersuai akan memilih model dan jenis perkakasan tertentu Teras prestasi tertinggi.

Selain API Transformer sedia ada, pembangun juga boleh terus menggunakan kernel perhatian perhatian produk titik berskala untuk mempercepatkan PyTorch dengan memanggil pengendali skala_dot_product_attention() baharu. 2 Transformer disepadukan dengan torch.compile().

Untuk mendapatkan pecutan tambahan kompilasi PT2 (untuk inferens atau latihan) semasa menggunakan model, anda boleh menggunakan model = torch.compile(model ) untuk praproses model.

Pada masa ini, gabungan kernel tersuai dan torch.compile() telah digunakan untuk melatih model Transformer, terutamanya bahasa besar menggunakan Transformer PyTorch 2 yang dipercepatkan Pecutan yang ketara telah dicapai dalam model.

Menggunakan kernel tersuai dan torch.compile untuk memberikan pecutan yang ketara bagi latihan model bahasa besar

Sylvain Gugger, penyelenggara utama HuggingFace Transformers, menulis dalam satu kenyataan yang dikeluarkan oleh projek PyTorch, "Dengan hanya satu baris kod, PyTorch 2.0 boleh memberikan prestasi 1.5x lebih baik semasa latihan Model Transformers kepada 2.0x lebih pantas Ini adalah perkara yang paling menarik sejak pengenalan latihan ketepatan campuran 》

PyTorch dan TensorFlow Google adalah dua yang paling popular! . Beribu-ribu institusi di seluruh dunia menggunakan PyTorch untuk membangunkan aplikasi pembelajaran mendalam, dan penggunaannya semakin berkembang.

Pelancaran PyTorch 2.0 akan membantu mempercepatkan pembangunan pembelajaran mendalam dan aplikasi kecerdasan buatan, kata Ketua Pegawai Teknologi Lightning AI dan salah seorang penyelenggara utama PyTorch Lightning Luca Antiga berkata:

"PyTorch 2.0 merangkumi masa depan rangka kerja pembelajaran mendalam. Tiada campur tangan pengguna diperlukan untuk menangkap program PyTorch dan program itu berjaya Penjanaan kotak, bersama-sama dengan pecutan peranti yang besar, kemungkinan ini membuka dimensi baharu untuk pembangun AI 》

Rujukan: 🎜> https://www.php.cn/link/d6f84c02e2a54908d96f410083beb6e0 https://www.php.cn/link/89b9e0a6f6d1505fe13dea0f18a2dcfa https://🎜 www.php.cn/link/3b2acfe2e38102074656ed938abf4ac3

Atas ialah kandungan terperinci Versi rasmi PyTorch 2.0 dikeluarkan! Satu baris kod dipercepatkan 2 kali ganda, 100% serasi ke belakang. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1377

1377

52

52

Bytedance Cutting melancarkan keahlian super SVIP: 499 yuan untuk langganan tahunan berterusan, menyediakan pelbagai fungsi AI

Jun 28, 2024 am 03:51 AM

Bytedance Cutting melancarkan keahlian super SVIP: 499 yuan untuk langganan tahunan berterusan, menyediakan pelbagai fungsi AI

Jun 28, 2024 am 03:51 AM

Laman web ini melaporkan pada 27 Jun bahawa Jianying ialah perisian penyuntingan video yang dibangunkan oleh FaceMeng Technology, anak syarikat ByteDance Ia bergantung pada platform Douyin dan pada asasnya menghasilkan kandungan video pendek untuk pengguna platform tersebut Windows , MacOS dan sistem pengendalian lain. Jianying secara rasmi mengumumkan peningkatan sistem keahliannya dan melancarkan SVIP baharu, yang merangkumi pelbagai teknologi hitam AI, seperti terjemahan pintar, penonjolan pintar, pembungkusan pintar, sintesis manusia digital, dsb. Dari segi harga, yuran bulanan untuk keratan SVIP ialah 79 yuan, yuran tahunan ialah 599 yuan (nota di laman web ini: bersamaan dengan 49.9 yuan sebulan), langganan bulanan berterusan ialah 59 yuan sebulan, dan langganan tahunan berterusan ialah 499 yuan setahun (bersamaan dengan 41.6 yuan sebulan) . Di samping itu, pegawai yang dipotong juga menyatakan bahawa untuk meningkatkan pengalaman pengguna, mereka yang telah melanggan VIP asal

Pembantu pengekodan AI yang ditambah konteks menggunakan Rag dan Sem-Rag

Jun 10, 2024 am 11:08 AM

Pembantu pengekodan AI yang ditambah konteks menggunakan Rag dan Sem-Rag

Jun 10, 2024 am 11:08 AM

Tingkatkan produktiviti, kecekapan dan ketepatan pembangun dengan menggabungkan penjanaan dipertingkatkan semula dan memori semantik ke dalam pembantu pengekodan AI. Diterjemah daripada EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG, pengarang JanakiramMSV. Walaupun pembantu pengaturcaraan AI asas secara semulajadi membantu, mereka sering gagal memberikan cadangan kod yang paling relevan dan betul kerana mereka bergantung pada pemahaman umum bahasa perisian dan corak penulisan perisian yang paling biasa. Kod yang dijana oleh pembantu pengekodan ini sesuai untuk menyelesaikan masalah yang mereka bertanggungjawab untuk menyelesaikannya, tetapi selalunya tidak mematuhi piawaian pengekodan, konvensyen dan gaya pasukan individu. Ini selalunya menghasilkan cadangan yang perlu diubah suai atau diperhalusi agar kod itu diterima ke dalam aplikasi

Bolehkah penalaan halus benar-benar membolehkan LLM mempelajari perkara baharu: memperkenalkan pengetahuan baharu boleh menjadikan model menghasilkan lebih banyak halusinasi

Jun 11, 2024 pm 03:57 PM

Bolehkah penalaan halus benar-benar membolehkan LLM mempelajari perkara baharu: memperkenalkan pengetahuan baharu boleh menjadikan model menghasilkan lebih banyak halusinasi

Jun 11, 2024 pm 03:57 PM

Model Bahasa Besar (LLM) dilatih pada pangkalan data teks yang besar, di mana mereka memperoleh sejumlah besar pengetahuan dunia sebenar. Pengetahuan ini dibenamkan ke dalam parameter mereka dan kemudiannya boleh digunakan apabila diperlukan. Pengetahuan tentang model ini "diperbaharui" pada akhir latihan. Pada akhir pra-latihan, model sebenarnya berhenti belajar. Selaraskan atau perhalusi model untuk mempelajari cara memanfaatkan pengetahuan ini dan bertindak balas dengan lebih semula jadi kepada soalan pengguna. Tetapi kadangkala pengetahuan model tidak mencukupi, dan walaupun model boleh mengakses kandungan luaran melalui RAG, ia dianggap berfaedah untuk menyesuaikan model kepada domain baharu melalui penalaan halus. Penalaan halus ini dilakukan menggunakan input daripada anotasi manusia atau ciptaan LLM lain, di mana model menemui pengetahuan dunia sebenar tambahan dan menyepadukannya

Tujuh Soalan Temuduga Teknikal GenAI & LLM yang Cool

Jun 07, 2024 am 10:06 AM

Tujuh Soalan Temuduga Teknikal GenAI & LLM yang Cool

Jun 07, 2024 am 10:06 AM

Untuk mengetahui lebih lanjut tentang AIGC, sila layari: 51CTOAI.x Komuniti https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou berbeza daripada bank soalan tradisional yang boleh dilihat di mana-mana sahaja di Internet memerlukan pemikiran di luar kotak. Model Bahasa Besar (LLM) semakin penting dalam bidang sains data, kecerdasan buatan generatif (GenAI) dan kecerdasan buatan. Algoritma kompleks ini meningkatkan kemahiran manusia dan memacu kecekapan dan inovasi dalam banyak industri, menjadi kunci kepada syarikat untuk kekal berdaya saing. LLM mempunyai pelbagai aplikasi Ia boleh digunakan dalam bidang seperti pemprosesan bahasa semula jadi, penjanaan teks, pengecaman pertuturan dan sistem pengesyoran. Dengan belajar daripada sejumlah besar data, LLM dapat menjana teks

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Editor |ScienceAI Question Answering (QA) set data memainkan peranan penting dalam mempromosikan penyelidikan pemprosesan bahasa semula jadi (NLP). Set data QA berkualiti tinggi bukan sahaja boleh digunakan untuk memperhalusi model, tetapi juga menilai dengan berkesan keupayaan model bahasa besar (LLM), terutamanya keupayaan untuk memahami dan menaakul tentang pengetahuan saintifik. Walaupun pada masa ini terdapat banyak set data QA saintifik yang meliputi bidang perubatan, kimia, biologi dan bidang lain, set data ini masih mempunyai beberapa kekurangan. Pertama, borang data adalah agak mudah, kebanyakannya adalah soalan aneka pilihan. Ia mudah dinilai, tetapi mengehadkan julat pemilihan jawapan model dan tidak dapat menguji sepenuhnya keupayaan model untuk menjawab soalan saintifik. Sebaliknya, Soal Jawab terbuka

Lima sekolah pembelajaran mesin yang anda tidak tahu

Jun 05, 2024 pm 08:51 PM

Lima sekolah pembelajaran mesin yang anda tidak tahu

Jun 05, 2024 pm 08:51 PM

Pembelajaran mesin ialah cabang penting kecerdasan buatan yang memberikan komputer keupayaan untuk belajar daripada data dan meningkatkan keupayaan mereka tanpa diprogramkan secara eksplisit. Pembelajaran mesin mempunyai pelbagai aplikasi dalam pelbagai bidang, daripada pengecaman imej dan pemprosesan bahasa semula jadi kepada sistem pengesyoran dan pengesanan penipuan, dan ia mengubah cara hidup kita. Terdapat banyak kaedah dan teori yang berbeza dalam bidang pembelajaran mesin, antaranya lima kaedah yang paling berpengaruh dipanggil "Lima Sekolah Pembelajaran Mesin". Lima sekolah utama ialah sekolah simbolik, sekolah sambungan, sekolah evolusi, sekolah Bayesian dan sekolah analogi. 1. Simbolisme, juga dikenali sebagai simbolisme, menekankan penggunaan simbol untuk penaakulan logik dan ekspresi pengetahuan. Aliran pemikiran ini percaya bahawa pembelajaran adalah proses penolakan terbalik, melalui sedia ada

Prestasi SOTA, kaedah AI ramalan pertalian protein-ligan pelbagai mod Xiamen, menggabungkan maklumat permukaan molekul buat kali pertama

Jul 17, 2024 pm 06:37 PM

Prestasi SOTA, kaedah AI ramalan pertalian protein-ligan pelbagai mod Xiamen, menggabungkan maklumat permukaan molekul buat kali pertama

Jul 17, 2024 pm 06:37 PM

Editor |. KX Dalam bidang penyelidikan dan pembangunan ubat, meramalkan pertalian pengikatan protein dan ligan dengan tepat dan berkesan adalah penting untuk pemeriksaan dan pengoptimuman ubat. Walau bagaimanapun, kajian semasa tidak mengambil kira peranan penting maklumat permukaan molekul dalam interaksi protein-ligan. Berdasarkan ini, penyelidik dari Universiti Xiamen mencadangkan rangka kerja pengekstrakan ciri berbilang mod (MFE) novel, yang buat pertama kalinya menggabungkan maklumat mengenai permukaan protein, struktur dan jujukan 3D, dan menggunakan mekanisme perhatian silang untuk membandingkan ciri modaliti yang berbeza penjajaran. Keputusan eksperimen menunjukkan bahawa kaedah ini mencapai prestasi terkini dalam meramalkan pertalian mengikat protein-ligan. Tambahan pula, kajian ablasi menunjukkan keberkesanan dan keperluan maklumat permukaan protein dan penjajaran ciri multimodal dalam rangka kerja ini. Penyelidikan berkaitan bermula dengan "S

Meletakkan pasaran seperti AI, GlobalFoundries memperoleh teknologi gallium nitrida Tagore Technology dan pasukan berkaitan

Jul 15, 2024 pm 12:21 PM

Meletakkan pasaran seperti AI, GlobalFoundries memperoleh teknologi gallium nitrida Tagore Technology dan pasukan berkaitan

Jul 15, 2024 pm 12:21 PM

Menurut berita dari laman web ini pada 5 Julai, GlobalFoundries mengeluarkan kenyataan akhbar pada 1 Julai tahun ini, mengumumkan pemerolehan teknologi power gallium nitride (GaN) Tagore Technology dan portfolio harta intelek, dengan harapan dapat mengembangkan bahagian pasarannya dalam kereta dan Internet of Things dan kawasan aplikasi pusat data kecerdasan buatan untuk meneroka kecekapan yang lebih tinggi dan prestasi yang lebih baik. Memandangkan teknologi seperti AI generatif terus berkembang dalam dunia digital, galium nitrida (GaN) telah menjadi penyelesaian utama untuk pengurusan kuasa yang mampan dan cekap, terutamanya dalam pusat data. Laman web ini memetik pengumuman rasmi bahawa semasa pengambilalihan ini, pasukan kejuruteraan Tagore Technology akan menyertai GLOBALFOUNDRIES untuk membangunkan lagi teknologi gallium nitride. G