Peranti teknologi

Peranti teknologi

AI

AI

Model Bahasa CoRL 2022 Menghasilkan Protein yang Tidak Ditemui dalam Alam Semula Jadi

Model Bahasa CoRL 2022 Menghasilkan Protein yang Tidak Ditemui dalam Alam Semula Jadi

Model Bahasa CoRL 2022 Menghasilkan Protein yang Tidak Ditemui dalam Alam Semula Jadi

目录

- Model bahasa digeneralisasikan di luar protein semula jadi

- Bahasa pengaturcaraan peringkat tinggi untuk reka bentuk protein generatif

- DOC: Meningkatkan Keselarasan Cerita Panjang Dengan Kawalan Garis Terperinci

- Model Resapan Boleh Skala dengan Transformer

- Point-E: Sistem untuk Menjana Awan Titik 3D daripada Gesaan Kompleks

- Pemrograman semula untuk memulihkan maklumat epigenetik muda dan memulihkan penglihatan

- Melatih Robot untuk Menilai Robot: Fungsi Ganjaran Interaktif Berasaskan Contoh untuk Pembelajaran Dasar

- ArXiv Weekly Radiostation:NLP、CV、ML更多精选论文(附音频)

论文 1:Model bahasa digeneralisasikan melangkaui protein semula jadi>

- 作者:Robert Verkuil 、 Ori Kabeli 等

- 论文:地址www.biorxiv.org/content/10.1101/2022.12.21.521521v1.full.pdf

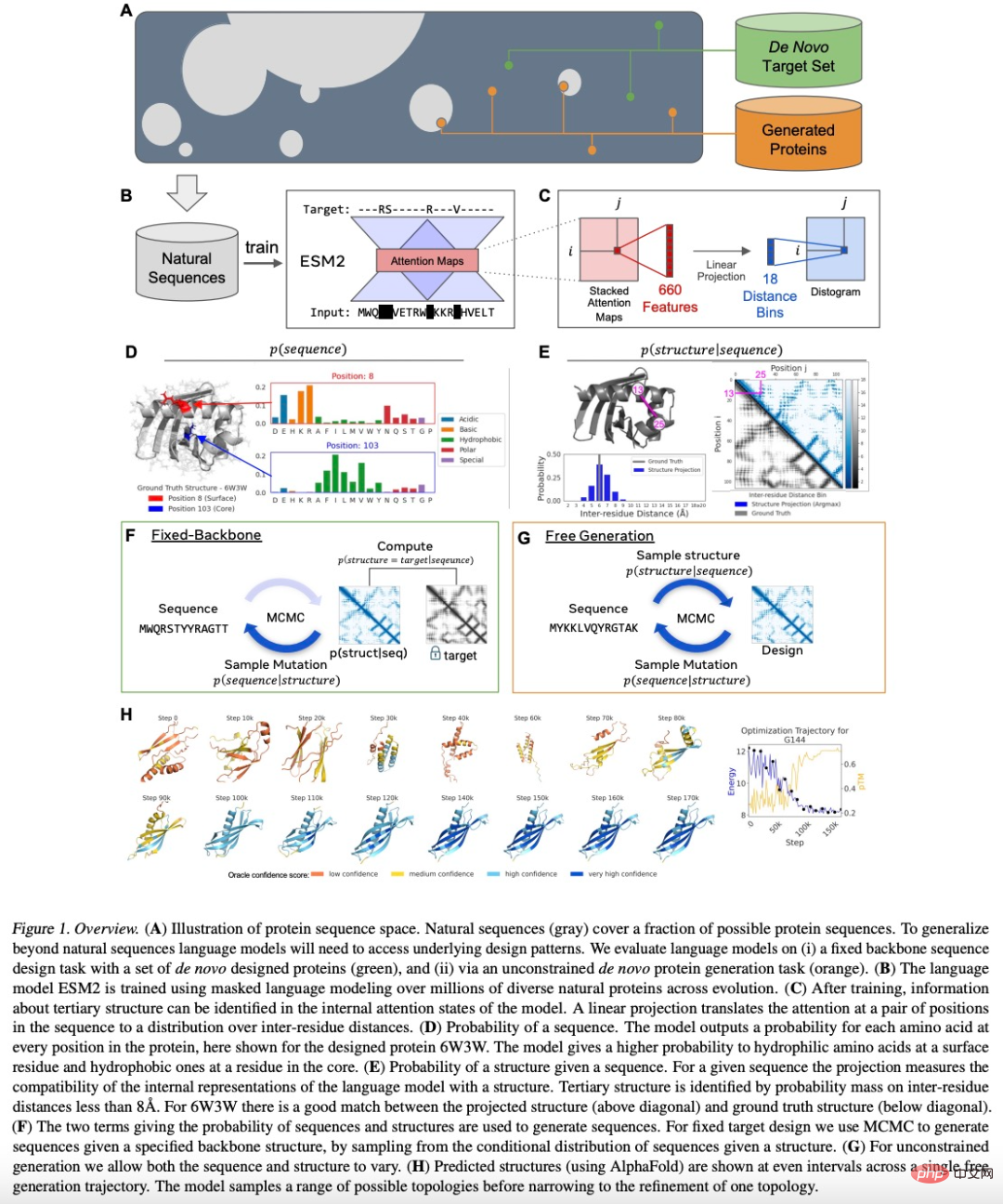

摘覶摘覶:耶且空蛋白质设计任务:指定结构的固定骨架设计;从模型中采样结构的无约束生成。对序列进行训练,但该研究发现它们能够设计结构。在该研究的实验结果中,中了228 种蛋白质,设计成功的比率是 152/228(67%)。

在 152 个吞验的家与已知的天然蛋白质没有明显的序列匹配。

对于固定主干设计,语言模型成功为 对于固定主干设计,语言模型成功为 8主干目标生成了蛋白质设计。

对于不受约束生成的情况,采样的蛋白质涵盖了不同的拓扑结构和二结构和二级结林的实验成功率 71/129(55%)。

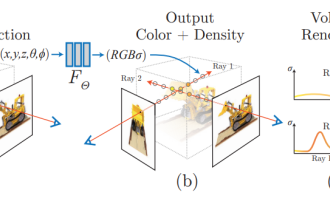

下图 1 是 ESM2 模型设计蛋白质的总体流程:

:该研究发现 ESM2 语言模型通过学习深层语法,就能生成天然蛋白质以外白质以外的白质以外的白>

论文 2:Bahasa pengaturcaraan peringkat tinggi untuk reka bentuk protein generatif

- 作者:Brian Hie 、 Salvatore Candido 等

- 地来:https://www.biorxiv.org/content/10.1101/2022.12.21.521526v1.full.pdf

- 摘要

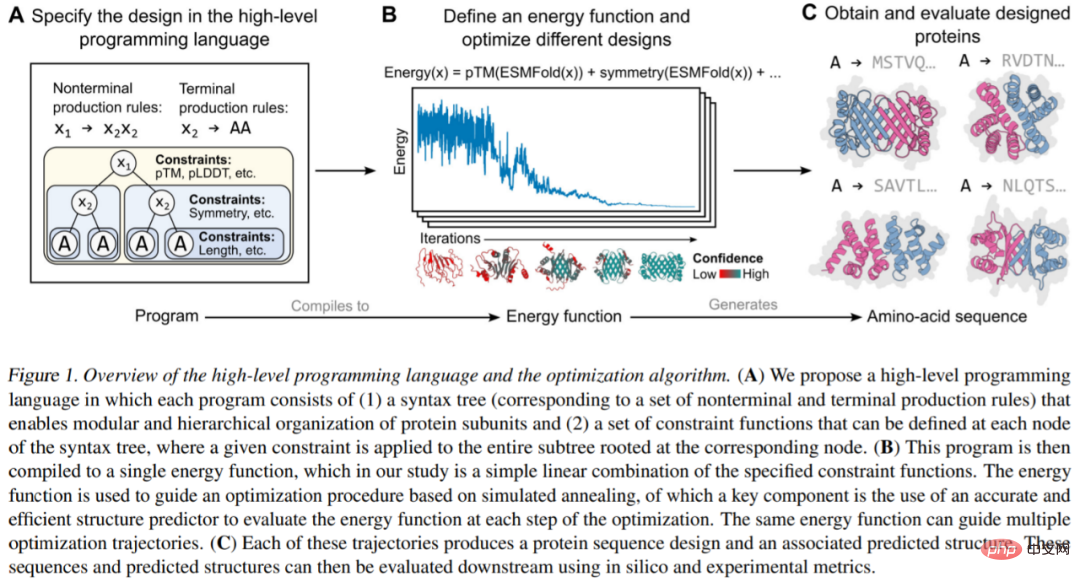

他们提出的生成蛋白质设计的编程语言,允许设计人员指定直观、模块化化受。语言首先需要一个语法树 (图 1A),由末端符号 (即树的叶子)和非末端符号 (即树的内部节点) 组成,前者对应一个独特的蛋白质序列 (在蛋作)者支持分层组织。

Model penjanaan berasaskan tenaga juga diperlukan. Pertama, Pereka Protein menentukan program peringkat tinggi yang terdiri daripada satu set kekangan yang disusun secara hierarki (Rajah 1A). Program ini kemudiannya disusun menjadi fungsi tenaga yang digunakan untuk menilai keserasian dengan kekangan, yang sewenang-wenangnya dan tidak boleh dibezakan (Rajah 1B). Akhirnya dengan memasukkan ramalan struktur peringkat atom (disokong oleh model bahasa) ke dalam fungsi tenaga, sejumlah besar reka bentuk protein kompleks boleh dihasilkan (Rajah 1C).

Cadangan: Menjana struktur protein kompleks dan modular secara pemrograman.

Kertas 3: DOC: Meningkatkan Keselarasan Cerita Panjang Dengan Kontro Rangka Terperinci

- Pengarang: Kevin Yang, Dan Klein, dll.

- Alamat kertas: https://arxiv.org/pdf/2212.10077 .pdf

Abstrak: Beberapa ketika dahulu, Re^3, model bahasa yang meniru proses penulisan manusia, telah dikeluarkan model tidak memerlukan penalaan halus model besar, tetapi Ia melalui reka bentuk gesaan untuk menjana cerita yang konsisten.

Kini, pasukan penyelidik telah mencadangkan DOC model baharu untuk menjana cerita. Pengarang kertas kerja, Kevin Yang dan Tian Yuandong, juga menyiarkan di Twitter untuk mempromosikan model DOC, mengatakan bahawa cerita yang dihasilkan oleh DOC lebih koheren dan menarik daripada yang dihasilkan oleh Re^3.

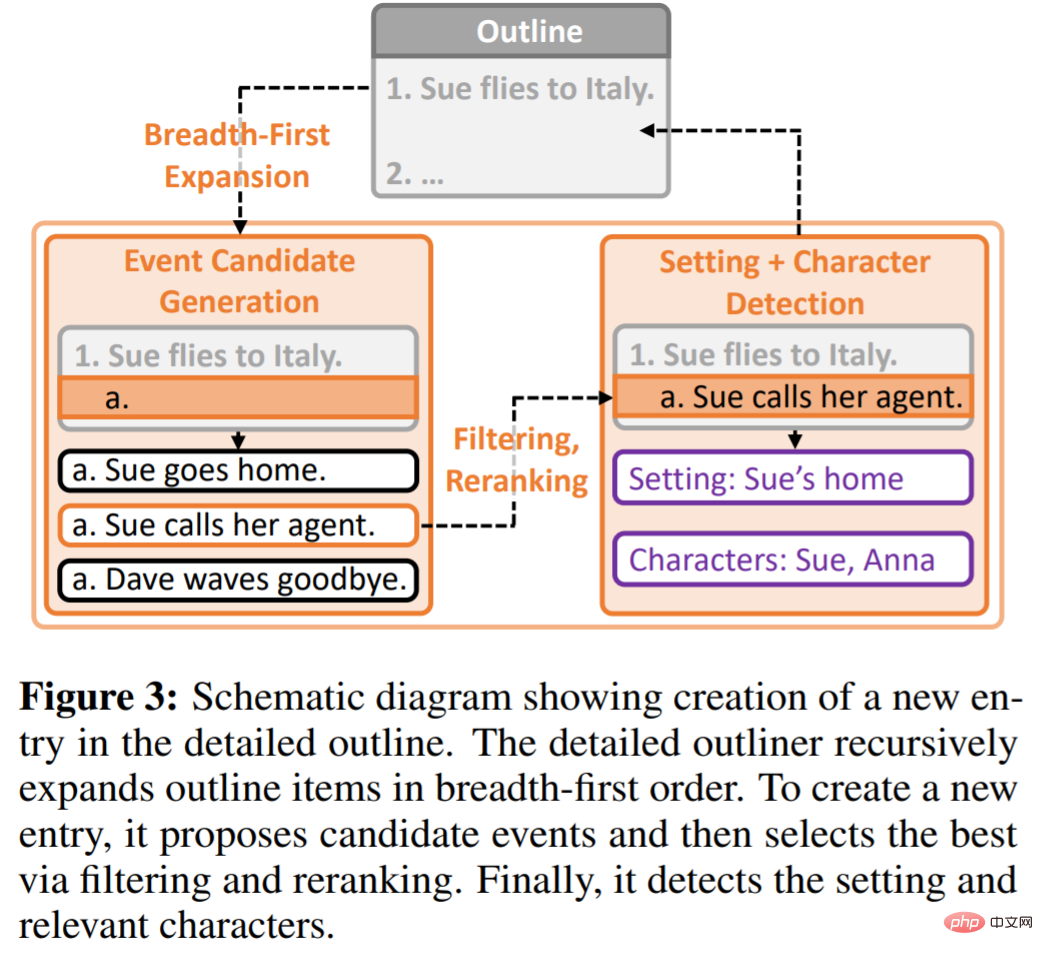

Rangka kerja DOC bermaksud Kawalan Rangka Terperinci, yang digunakan untuk meningkatkan keselarasan plot apabila menjana beribu-ribu perkataan cerita panjang secara automatik. DOC terdiri daripada dua komponen pelengkap: Outliner Terperinci dan Pengawal Terperinci.

Penjelasan Terperinci bertanggungjawab untuk mencipta garis besar yang terperinci dan tersusun secara hierarki yang menggerakkan idea penulisan daripada penggubalan kepada peringkat perancangan. Pengawal Terperinci memastikan bahawa hasil yang dijana mengikut garis besar terperinci dengan mengawal penjajaran perenggan cerita dengan butiran garis besar.

Kajian ini menjalankan penilaian manual terhadap keupayaan model untuk menjana cerita secara automatik, dan DOC mencapai keuntungan yang besar dalam pelbagai petunjuk: koheren plot (22.5%), perkaitan garis besar (28.2%) dan menyeronokkan (20.7%), yang jauh lebih baik daripada model Re^3. Selain itu, DOC lebih mudah dikawal dalam persekitaran binaan interaktif.

Disyorkan : Satu lagi karya baharu oleh Tian Yuandong dan ahli pelakon asal yang lain: AI menjana panjang cerita, mengira Malah artikel seribu perkataan boleh menjadi koheren dan menarik.

Kertas 4: Model Resapan Boleh Skala dengan Transformer

- Pengarang: William Peebles, Xie Saining

- Alamat kertas: https://arxiv.org/pdf/2212.09748.pdf

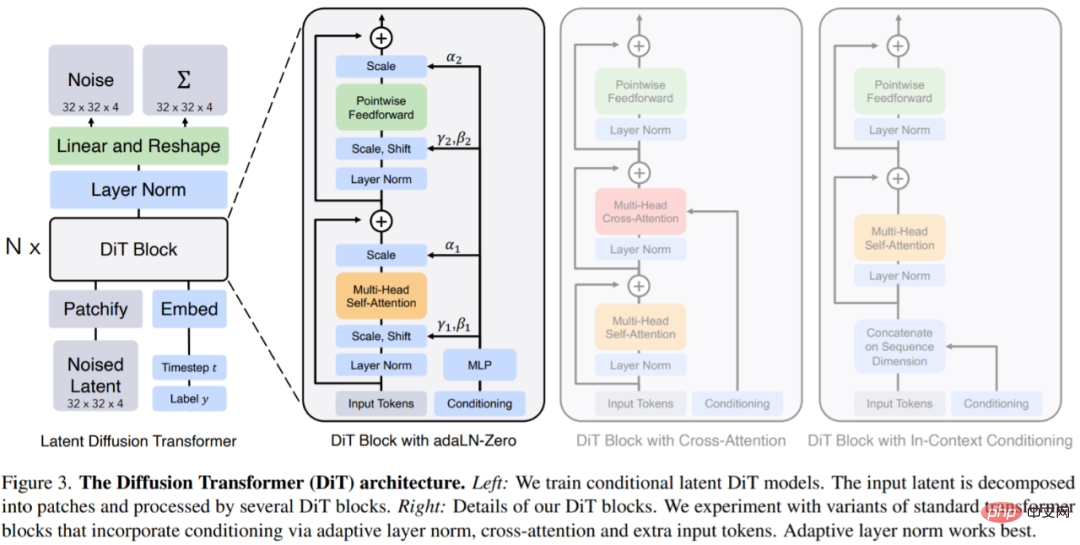

Abstrak: Dalam artikel ini, William Peebles dari UC Berkeley dan Xie Saining dari Universiti New York menulis "Model Resapan Boleh Skala dengan Transformer". menyediakan panduan untuk model generatif masa depan Penyelidikan menyediakan garis dasar empirikal. Kajian ini menunjukkan bahawa bias induktif U-Net tidak kritikal kepada prestasi model resapan dan boleh digantikan dengan mudah dengan reka bentuk standard seperti transformer.

Penyelidikan ini memfokuskan pada kelas baharu model resapan berasaskan Transformer: Diffusion Transformers (pendek kata DiT). DiT mengikuti amalan terbaik Pengubah Penglihatan (ViT), dengan beberapa tweak kecil tetapi penting. DiT telah ditunjukkan untuk berskala lebih cekap daripada rangkaian konvolusi tradisional seperti ResNet.

Secara khusus, artikel ini mengkaji gelagat penskalaan Transformer dari segi kerumitan rangkaian dan kualiti sampel. Kajian menunjukkan bahawa dengan membina dan menanda aras ruang reka bentuk DiT di bawah rangka kerja model resapan terpendam (LDM), di mana model resapan dilatih dalam ruang terpendam VAE, adalah mungkin untuk berjaya menggantikan tulang belakang U-Net dengan pengubah. Makalah ini selanjutnya menunjukkan bahawa DiT ialah seni bina berskala untuk model penyebaran: terdapat korelasi yang kuat antara kerumitan rangkaian (diukur oleh Gflops) dan kualiti sampel (diukur oleh FID). Dengan hanya memperluaskan DiT dan melatih LDM dengan tulang belakang berkapasiti tinggi (118.6 Gflops), hasil terkini 2.27 FID dicapai pada penanda aras penjanaan ImageNet 256 × 256 bersyarat kelas.

Cadangan: U-Net yang mendominasi model penyebaran akan diganti, diperkenalkan oleh Xie Senin et al. Transformer mencadangkan DiT.

Kertas 5: Point-E: Sistem untuk Menjana Awan Titik 3D daripada Gesaan Kompleks

- Pengarang: Alex Nichol, Heewoo Jun, dll.

- Alamat kertas: https://arxiv.org/abs/2212.08751

Abstrak: Penjana model 3D sumber terbuka OpenAI Point-E telah mencetuskan gelombang kegilaan baharu dalam bulatan AI. Point-E boleh menjana model 3D dalam satu hingga dua minit pada satu GPU Nvidia V100, menurut kertas yang diterbitkan dengan kandungan sumber terbuka. Sebagai perbandingan, sistem sedia ada seperti DreamFusion Google biasanya memerlukan jam dan berbilang GPU.

Point-E tidak mengeluarkan imej 3D dalam erti kata tradisional, ia menghasilkan awan titik atau set diskret titik data dalam ruang yang mewakili bentuk 3D. E dalam Point-E bermaksud "kecekapan", bermakna ia lebih pantas daripada kaedah penjanaan objek 3D sebelumnya. Walaupun awan titik lebih mudah untuk disintesis dari perspektif pengiraan, ia tidak dapat menangkap bentuk atau tekstur objek yang berbutir halus — had utama Point-E pada masa ini.

Untuk menyelesaikan masalah ini, pasukan OpenAI melatih sistem kecerdasan buatan tambahan untuk menukar awan titik Point-E menjadi jaringan.

Disyorkan: AI teks-ke-imej tiga dimensi kini tersedia: GPU tunggal dihantar dalam masa kurang daripada satu minit , dihasilkan oleh OpenAI .

Kertas 6: Pengaturcaraan semula untuk memulihkan maklumat epigenetik muda dan memulihkan penglihatan

- Pengarang : Yuancheng Lu, Benedikt Brommer

- Alamat kertas: https://www.nature.com/articles/s41586-020-2975-4

Abstrak: Pada 2 Disember 2020, beberapa perkataan yang mengejutkan muncul pada kulit jurnal saintifik teratas "Nature": " Turning Back Time".

Penyelidikan pada kulit muka depan datang daripada pasukan David Sinclair, seorang profesor yang berkhidmat di Harvard Medical School. Walaupun artikel itu hanya beberapa halaman panjang, ia menunjukkan prospek baharu - menggunakan terapi gen untuk mendorong pemrograman semula sel ganglion dan memulihkan maklumat epigenetik muda, membolehkan saraf optik menjana semula selepas kerosakan dan membalikkan penglihatan yang disebabkan oleh glaukoma dan penuaan .

David Sinclair berkata bahawa matlamat penyelidikan pasukan sentiasa adalah untuk melambatkan dan membalikkan penuaan manusia serta merawat penyakit dengan menangani punca dan bukannya gejala.

Berdasarkan kajian 2020 ini, pasukan David Sinclair menggunakan teknologi pembalikan umur yang dipanggil "REVIVER" untuk mengujinya pada primat bukan manusia untuk diperhatikan Untuk melihat sama ada ia selamat dan merawat kebutaan seperti ia berlaku pada tikus.

Penyelidikan terbaru datang dari David Sinclair dan sepasukan 60 orang yang diketuainya Dia berkata bahawa penuaan adalah seperti calar pada CD yang boleh dipadam, atau perisian yang rosak dalam sistem, yang boleh dicapai dengan. hanya memasang semula Pembalikan, seperti yang mereka katakan dalam buku Jangka Hayat.

Dalam kertas pracetak, penulis menyatakan bahawa semua benda hidup kehilangan maklumat genetik dari semasa ke semasa dan secara beransur-ansur kehilangan fungsi selular. Menggunakan sistem tetikus yang diubah suai secara genetik dikenali sebagai ICE (untuk Perubahan Boleh Didorong dalam Epigenome), penyelidik menunjukkan bahawa proses pembaikan pecahan DNA bukan mutagen mempercepatkan perubahan fisiologi, kognitif dan molekul yang berkaitan dengan usia, termasuk ekspresi Perhatikan hakisan genetik, kehilangan sel keupayaan, penuaan sel, dsb.

Penyelidik mengatakan pengaturcaraan semula epigenetik melalui ekspresi ektopik boleh memulihkan corak ekspresi gen yang muda.

Cadangan: Penyelidikan tentang membalikkan penuaan.

Kertas 7: Melatih Robot untuk Menilai Robot: Fungsi Ganjaran Interaktif Berasaskan Contoh untuk Pembelajaran Dasar

- Pengarang: Kun Huang, Edward Hu, Dinesh Jayaraman

- Alamat kertas: https://openreview.net/pdf?id=sK2aWU7X9b8

Ringkasan: Selalunya, interaksi fizikal membantu mendedahkan maklumat yang kurang jelas, seperti apabila kita mungkin menarik kaki meja Untuk menilai sama ada ia stabil , atau terbalikkan botol air untuk memeriksa sama ada ia bocor, kajian itu mencadangkan tingkah laku interaktif ini boleh diperoleh secara automatik dengan melatih robot untuk menilai hasil percubaan robot untuk melakukan sesuatu kemahiran. Penilaian ini, seterusnya, berfungsi sebagai IRF (fungsi ganjaran interaktif) yang digunakan untuk melatih dasar pembelajaran pengukuhan untuk melaksanakan kemahiran sasaran, seperti mengetatkan kaki meja. Selain itu, IRF boleh berfungsi sebagai mekanisme pengesahan untuk meningkatkan pelaksanaan tugas dalam talian walaupun selepas latihan penuh selesai. Untuk sebarang tugasan yang diberikan, latihan IRF adalah sangat mudah dan tidak memerlukan spesifikasi lanjut.

Keputusan penilaian menunjukkan bahawa IRF boleh mencapai peningkatan prestasi yang ketara dan malah melepasi garis dasar dengan akses kepada tunjuk cara atau ganjaran yang dibuat dengan teliti. Sebagai contoh, dalam gambar di bawah, robot mesti menutup pintu terlebih dahulu, dan kemudian memutarkan pemegang pintu simetri untuk mengunci pintu sepenuhnya.

Atas ialah kandungan terperinci Model Bahasa CoRL 2022 Menghasilkan Protein yang Tidak Ditemui dalam Alam Semula Jadi. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1376

1376

52

52

Kertas Stable Diffusion 3 akhirnya telah dikeluarkan, dan butiran seni bina didedahkan Adakah ia akan membantu untuk menghasilkan semula Sora?

Mar 06, 2024 pm 05:34 PM

Kertas Stable Diffusion 3 akhirnya telah dikeluarkan, dan butiran seni bina didedahkan Adakah ia akan membantu untuk menghasilkan semula Sora?

Mar 06, 2024 pm 05:34 PM

Kertas StableDiffusion3 akhirnya di sini! Model ini dikeluarkan dua minggu lalu dan menggunakan seni bina DiT (DiffusionTransformer) yang sama seperti Sora. Ia menimbulkan kekecohan apabila ia dikeluarkan. Berbanding dengan versi sebelumnya, kualiti imej yang dijana oleh StableDiffusion3 telah dipertingkatkan dengan ketara Ia kini menyokong gesaan berbilang tema, dan kesan penulisan teks juga telah dipertingkatkan, dan aksara bercelaru tidak lagi muncul. StabilityAI menegaskan bahawa StableDiffusion3 ialah satu siri model dengan saiz parameter antara 800M hingga 8B. Julat parameter ini bermakna model boleh dijalankan terus pada banyak peranti mudah alih, dengan ketara mengurangkan penggunaan AI

Anugerah kertas ICCV'23 'Fighting of Gods'! Meta Divide Everything dan ControlNet telah dipilih secara bersama, dan terdapat satu lagi artikel yang mengejutkan para hakim

Oct 04, 2023 pm 08:37 PM

Anugerah kertas ICCV'23 'Fighting of Gods'! Meta Divide Everything dan ControlNet telah dipilih secara bersama, dan terdapat satu lagi artikel yang mengejutkan para hakim

Oct 04, 2023 pm 08:37 PM

ICCV2023, persidangan penglihatan komputer teratas yang diadakan di Paris, Perancis, baru sahaja tamat! Anugerah kertas terbaik tahun ini hanyalah "pergaduhan antara tuhan". Sebagai contoh, dua kertas kerja yang memenangi Anugerah Kertas Terbaik termasuk ControlNet, sebuah karya yang menumbangkan bidang AI graf Vincentian. Sejak menjadi sumber terbuka, ControlNet telah menerima 24k bintang di GitHub. Sama ada untuk model resapan atau keseluruhan bidang penglihatan komputer, anugerah kertas ini sememangnya wajar diberi penghormatan untuk anugerah kertas terbaik telah dianugerahkan kepada satu lagi kertas kerja yang sama terkenal, Meta "Separate Everything" ”Model SAM. Sejak pelancarannya, "Segment Everything" telah menjadi "penanda aras" untuk pelbagai model AI segmentasi imej, termasuk yang datang dari belakang.

NeRF dan pemanduan autonomi masa lalu dan sekarang, ringkasan hampir 10 kertas kerja!

Nov 14, 2023 pm 03:09 PM

NeRF dan pemanduan autonomi masa lalu dan sekarang, ringkasan hampir 10 kertas kerja!

Nov 14, 2023 pm 03:09 PM

Sejak Medan Sinaran Neural dicadangkan pada tahun 2020, bilangan kertas kerja yang berkaitan telah meningkat secara eksponen. Ia bukan sahaja menjadi hala tuju cabang penting pembinaan semula tiga dimensi, tetapi juga secara beransur-ansur menjadi aktif di sempadan penyelidikan sebagai alat penting untuk pemanduan autonomi. . NeRF telah muncul secara tiba-tiba dalam tempoh dua tahun yang lalu, terutamanya kerana ia melangkau pengekstrakan dan pemadanan titik ciri, geometri dan triangulasi epipolar, PnP serta Pelarasan Bundle dan langkah lain dalam saluran paip pembinaan semula CV tradisional, malah melangkau pembinaan semula jaringan, pemetaan dan pengesanan cahaya , terus daripada 2D Imej input digunakan untuk mempelajari medan sinaran, dan kemudian imej yang dihasilkan yang menghampiri foto sebenar adalah output daripada medan sinaran. Dengan kata lain, biarkan model tiga dimensi tersirat berdasarkan rangkaian saraf sesuai dengan perspektif yang ditentukan

Ilustrasi kertas juga boleh dijana secara automatik, menggunakan model resapan, dan juga diterima oleh ICLR.

Jun 27, 2023 pm 05:46 PM

Ilustrasi kertas juga boleh dijana secara automatik, menggunakan model resapan, dan juga diterima oleh ICLR.

Jun 27, 2023 pm 05:46 PM

Generatif AI telah menarik perhatian komuniti kecerdasan buatan Kedua-dua individu dan perusahaan telah mula berminat untuk mencipta aplikasi penukaran modal yang berkaitan, seperti gambar Vincent, video Vincent, muzik Vincent, dll. Baru-baru ini, beberapa penyelidik dari institusi penyelidikan saintifik seperti ServiceNow Research dan LIVIA telah cuba menjana carta dalam kertas kerja berdasarkan penerangan teks. Untuk tujuan ini, mereka mencadangkan kaedah baru FigGen, dan kertas berkaitan juga dimasukkan dalam ICLR2023 sebagai TinyPaper. Alamat kertas bergambar: https://arxiv.org/pdf/2306.00800.pdf Sesetengah orang mungkin bertanya, apakah yang sukar untuk menjana carta dalam kertas itu? Bagaimanakah ini membantu penyelidikan saintifik?

Tangkapan skrin sembang mendedahkan peraturan tersembunyi semakan AI! AAAAI 3000 yuan kuat terima?

Apr 12, 2023 am 08:34 AM

Tangkapan skrin sembang mendedahkan peraturan tersembunyi semakan AI! AAAAI 3000 yuan kuat terima?

Apr 12, 2023 am 08:34 AM

Ketika tarikh akhir penyerahan kertas AAI 2023 semakin hampir, tangkapan skrin sembang tanpa nama dalam kumpulan penyerahan AI tiba-tiba muncul di Zhihu. Salah seorang daripada mereka mendakwa bahawa dia boleh menyediakan perkhidmatan "3,000 yuan terima kuat". Sejurus berita itu keluar, ia segera membangkitkan kemarahan orang ramai di kalangan netizen. Namun, jangan tergesa-gesa lagi. Bos Zhihu "Fine Tuning" berkata bahawa ini kemungkinan besar hanya "keseronokan lisan". Menurut "Fine Tuning", salam dan jenayah geng adalah masalah yang tidak dapat dielakkan dalam apa jua bidang. Dengan kebangkitan openreview, pelbagai kelemahan cmt telah menjadi lebih jelas Pada masa hadapan, ruang yang ditinggalkan untuk bulatan kecil untuk beroperasi akan menjadi lebih kecil, tetapi akan sentiasa ada ruang. Kerana ini adalah masalah peribadi, bukan masalah dengan sistem dan mekanisme penyerahan. Memperkenalkan open r

Kedudukan CVPR 2023 dikeluarkan, kadar penerimaan ialah 25.78%! 2,360 kertas telah diterima, dan bilangan penyerahan meningkat kepada 9,155

Apr 13, 2023 am 09:37 AM

Kedudukan CVPR 2023 dikeluarkan, kadar penerimaan ialah 25.78%! 2,360 kertas telah diterima, dan bilangan penyerahan meningkat kepada 9,155

Apr 13, 2023 am 09:37 AM

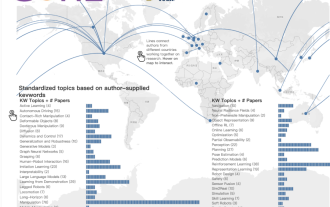

Sebentar tadi, CVPR 2023 mengeluarkan kenyataan yang mengatakan: Tahun ini, kami menerima rekod 9,155 kertas (peningkatan 12% daripada CVPR 2022), dan menerima 2,360 kertas, dengan kadar penerimaan 25.78%. Mengikut statistik, bilangan penyerahan kepada CVPR hanya meningkat daripada 1,724 kepada 2,145 dalam tempoh 7 tahun dari 2010 hingga 2016. Selepas 2017, ia melonjak dengan pesat dan memasuki tempoh pertumbuhan pesat Pada 2019, ia melebihi 5,000 buat kali pertama, dan menjelang 2022, jumlah penyerahan telah mencapai 8,161. Seperti yang anda lihat, sebanyak 9,155 kertas telah diserahkan pada tahun ini, sememangnya mencatat rekod. Selepas wabak itu dilonggarkan, sidang kemuncak CVPR tahun ini akan diadakan di Kanada. Tahun ini ia akan menjadi persidangan trek tunggal dan pemilihan Lisan tradisional akan dibatalkan. penyelidikan google

Pasukan China memenangi anugerah kertas terbaik dan kertas sistem terbaik, dan keputusan penyelidikan CoRL diumumkan.

Nov 10, 2023 pm 02:21 PM

Pasukan China memenangi anugerah kertas terbaik dan kertas sistem terbaik, dan keputusan penyelidikan CoRL diumumkan.

Nov 10, 2023 pm 02:21 PM

Sejak pertama kali diadakan pada 2017, CoRL telah menjadi salah satu persidangan akademik terbaik dunia dalam persimpangan robotik dan pembelajaran mesin. CoRL ialah persidangan tema tunggal untuk penyelidikan pembelajaran robot, meliputi pelbagai topik seperti robotik, pembelajaran mesin dan kawalan, termasuk teori dan aplikasi Persidangan CoRL 2023 akan diadakan di Atlanta, Amerika Syarikat, dari 6 hingga 9 November. Menurut data rasmi, 199 kertas kerja dari 25 negara telah dipilih untuk CoRL tahun ini. Topik popular termasuk operasi, pembelajaran pengukuhan dan banyak lagi. Walaupun CoRL berskala lebih kecil daripada persidangan akademik AI yang besar seperti AAAI dan CVPR, memandangkan populariti konsep seperti model besar, kecerdasan terkandung dan robot humanoid meningkat tahun ini, penyelidikan berkaitan yang patut diberi perhatian juga akan

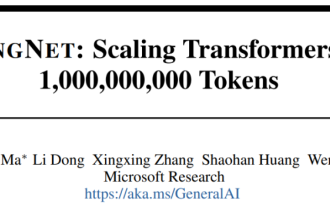

Kertas hangat baharu Microsoft: Transformer berkembang kepada 1 bilion token

Jul 22, 2023 pm 03:34 PM

Kertas hangat baharu Microsoft: Transformer berkembang kepada 1 bilion token

Jul 22, 2023 pm 03:34 PM

Memandangkan semua orang terus menaik taraf dan mengulang model besar mereka sendiri, keupayaan LLM (model bahasa besar) untuk memproses tetingkap konteks juga telah menjadi penunjuk penilaian yang penting. Sebagai contoh, model bintang GPT-4 menyokong 32k token, yang bersamaan dengan 50 halaman teks, Anthropic, yang diasaskan oleh bekas ahli OpenAI, telah meningkatkan keupayaan pemprosesan token Claude kepada 100k, iaitu kira-kira 75,000 perkataan, iaitu secara kasarnya bersamaan dengan meringkaskan "Harry Potter" dengan satu klik 》Bahagian Pertama. Dalam penyelidikan terbaru Microsoft, mereka terus mengembangkan Transformer kepada 1 bilion token kali ini. Ini membuka kemungkinan baharu untuk memodelkan jujukan yang sangat panjang, seperti menganggap keseluruhan korpus atau malah keseluruhan Internet sebagai satu jujukan. Sebagai perbandingan, biasa