Peranti teknologi

Peranti teknologi

AI

AI

Model pra-latihan Teks-ke-SQL dua peringkat berbilang tugas MIGA berdasarkan T5

Model pra-latihan Teks-ke-SQL dua peringkat berbilang tugas MIGA berdasarkan T5

Model pra-latihan Teks-ke-SQL dua peringkat berbilang tugas MIGA berdasarkan T5

Semakin banyak kerja telah membuktikan bahawa model bahasa pra-latihan (PLM) mengandungi pengetahuan yang kaya Untuk tugasan yang berbeza, menggunakan kaedah latihan yang sesuai untuk memanfaatkan PLM boleh meningkatkan prestasi model. Dalam tugas Text-to-SQL, penjana arus perdana semasa adalah berdasarkan pepohon sintaks dan perlu direka bentuk untuk sintaks SQL.

Baru-baru ini, NetEase Interactive Entertainment AI Lab bekerjasama dengan Guangdong University of Foreign Studies dan Columbia University untuk mencadangkan model pra-latihan berbilang tugas dua peringkat MIGA berdasarkan pra-latihan kaedah model bahasa pra-latihan T5. MIGA memperkenalkan tiga tugas tambahan dalam peringkat pra-latihan dan menyusunnya ke dalam paradigma tugas penjanaan bersatu, yang boleh melatih secara seragam semua set data Teks-ke-SQL pada masa yang sama, dalam peringkat penalaan halus, MIGA menyasarkan ralat; berbilang pusingan dialog Masalah pemindahan digunakan untuk gangguan SQL, yang meningkatkan keteguhan penjanaan model.

Pada masa ini untuk penyelidikan Teks-ke-SQL, kaedah arus perdana adalah terutamanya model penyahkod pengekod berdasarkan pepohon sintaks SQL, yang boleh memastikan bahawa hasil yang dihasilkan mesti mematuhi sintaks SQL , tetapi ia perlu disasarkan sintaks SQL direka khas. Terdapat juga beberapa penyelidikan terkini mengenai Text-to-SQL berdasarkan model bahasa generatif, yang boleh mewarisi pengetahuan dan keupayaan model bahasa pra-latihan dengan mudah.

Untuk mengurangkan pergantungan pada pokok sintaks dan memanfaatkan kebolehan model bahasa pra-latihan dengan lebih baik, kajian ini mencadangkan model berbilang bahasa dua peringkat di bawah rangka kerja pra- model T5 terlatih. Model pra-latihan Teks-ke-SQL Tugasan MIGA (MultI-tugas Ggenerasi frAmework ).

MIGA dibahagikan kepada dua peringkat proses latihan:

- Dalam peringkat pra-latihan, MIGA menggunakan pra-latihan yang sama paradigma latihan sebagai T5 , tiga tugas tambahan tambahan yang berkaitan dengan Text-to-SQL dicadangkan untuk merangsang pengetahuan dengan lebih baik dalam model bahasa pra-latihan. Kaedah latihan ini boleh menyatukan semua set data Text-to-SQL dan mengembangkan skala data latihan juga boleh mereka bentuk tugas tambahan yang lebih berkesan untuk meneroka lebih lanjut potensi pengetahuan model bahasa yang telah dilatih.

- Dalam fasa penalaan halus, MIGA menyasarkan masalah penghantaran ralat yang cenderung berlaku dalam perbualan berbilang pusingan dan SQL Ia mengganggu sejarah SQL semasa proses latihan, menjadikan penjanaan pusingan semasa SQL lebih berkesan.

Model MIGA mengatasi model berasaskan pepohon sintaks terbaik semasa pada dua set data awam Teks-ke-SQL dialog berbilang pusingan Penyelidikan berkaitan telah dijalankan oleh AAAI 2023 Diterima.

Alamat kertas: https://arxiv.org/abs/2212.09278

Butiran model MIGA

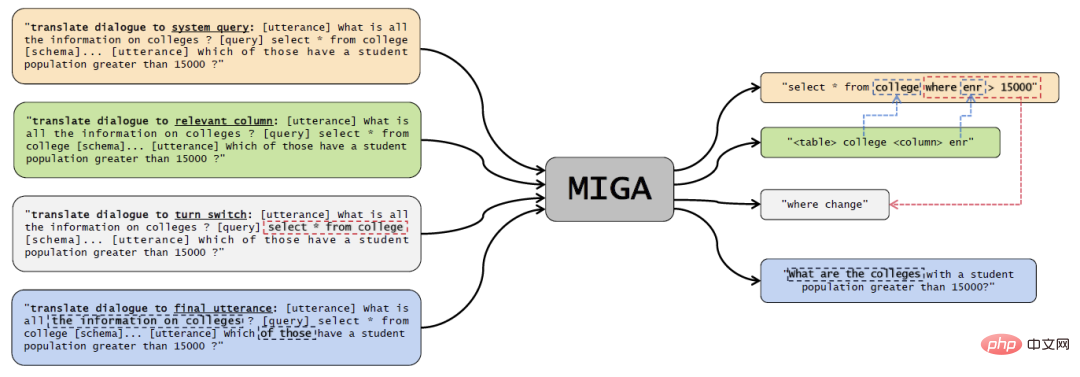

Rajah 1 rajah model MIGA.

Fasa pra-latihan pelbagai tugas

Kajian ini terutamanya merujuk kepada kaedah pra-latihan daripada T5, berdasarkan model T5 terlatih direka dengan empat tugas pra-latihan:

- Teks-ke-SQL Tugas utama: Untuk bahagian kuning dalam gambar di atas, reka bentuk Prompt sebagai "terjemah dialog kepada pertanyaan sistem", dan kemudian gunakan beberapa token khas untuk menterjemah perbualan sejarah, pangkalan data maklumat dan SQL Pernyataan disambungkan dan dimasukkan ke dalam pengekod T5, dan penyahkod terus mengeluarkan pernyataan SQL yang sepadan dengannya; , gesaan reka bentuk ialah "terjemah dialog ke lajur yang berkaitan", input pengekod T5 juga konsisten dengan tugas utama, dan penyahkod perlu mengeluarkan jadual dan lajur data yang berkaitan dengan masalah semasa, untuk meningkatkan pemahaman model of Text-to-SQL;

- Ramalan operasi pusingan semasa: Bahagian kelabu dalam gambar di atas direka sebagai "terjemah dialog untuk menukar suis". pemahaman konteks dalam berbilang pusingan dialog, membandingkan dialog dan SQL pusingan sebelumnya, penyahkod perlu mengeluarkan perubahan yang telah dibuat kepada tujuan perbualan semasa Sebagai contoh, dalam contoh dalam gambar, keadaan di mana telah diubah;

- Ramalan perbualan akhir: bahagian biru dalam gambar di atas, reka bentuk Prompt Tujuan "terjemahkan dialog kepada ujaran akhir" adalah untuk membolehkan model memahami kontekstual dengan lebih baik dialog. Penyahkod perlu mengeluarkan keseluruhan dialog berbilang pusingan dan penerangan masalah lengkap yang sepadan dengan SQL pada saat terakhir.

- Melalui reka bentuk kaedah latihan yang bersatu, MIGA boleh menjadi serba boleh dan fleksibel untuk mengendalikan lebih banyak tugasan tambahan yang berkaitan dengan tugas, dan ia juga mempunyai kelebihan berikut:

Merujuk kepada langkah-langkah manusia menulis SQL, teks perbualan kepada tugasan SQL diuraikan kepada beberapa sub-tugas, membolehkan tugas utama belajar daripadanya; 🎜>

Format pembinaan sampel latihan adalah konsisten dengan T5, yang boleh memaksimumkan potensi model T5 pra-latihan untuk tugasan sasaran; daripada pelbagai tugas tambahan. Apabila digunakan pada tugas tertentu, model pra-latihan di atas hanya perlu diperhalusi menggunakan objektif latihan yang sama dalam data berlabel tugas khusus.- Dalam peringkat pra-latihan, kajian menyepadukan data daripada dataset Text-to-SQL Spider dan dataset Text-to-SQL perbualan SparC dan CoSQL untuk melatih model T5.

- Fasa penalaan halus

Selepas fasa pra-latihan, kajian ini hanya menggunakan Text-to- Tugasan SQL untuk memperhalusi model. Apabila meramalkan pusingan semasa SQL, kajian ini akan menggabungkan SQL yang diramalkan pada pusingan sebelumnya Dalam proses ini, untuk cuba mengatasi masalah penghantaran ralat yang disebabkan oleh beberapa pusingan dialog dan penjanaan, kajian ini mencadangkan skema gangguan SQL. . , mengganggu pusingan sejarah SQL dalam data input dengan kebarangkalian α. Gangguan penyataan SQL terutamanya mencontohkan token yang sepadan dengan kebarangkalian β, dan kemudian melakukan salah satu gangguan berikut:

Gunakan lajur dalam jadual data yang sama untuk secara rawak ubah suai atau baharu Tambah lajur dalam bahagian PILIH;

Ubah suai struktur dalam keadaan JOIN, seperti menukar kedudukan kedua-dua jadual;Ubah suai"* ” Semua lajur ialah beberapa lajur lain;

- Tukar “asc” dan “desc”.

- Gangguan di atas ialah ralat penjanaan SQL yang paling biasa disebabkan oleh penghantaran ralat yang didapati secara statistik dalam eksperimen Oleh itu, gangguan dilakukan untuk situasi ini untuk mengurangkan pergantungan model aspek ini. Penilaian eksperimen

- Dataset penilaian ialah perbualan berbilang pusingan Text-to-SQL: SparC dan CoSQL.

- Petunjuk penilaian ialah:

QM: Padanan Soalan, yang bermaksud bahawa SQL yang dihasilkan dalam satu pusingan soalan tepat sepadan dengan Proportion output anotasi;

IM: Padanan Interaksi, menunjukkan perkadaran semua SQL yang dijana dalam keseluruhan pusingan lengkap dialog berbilang pusingan yang sepadan sepenuhnya dengan output anotasi.

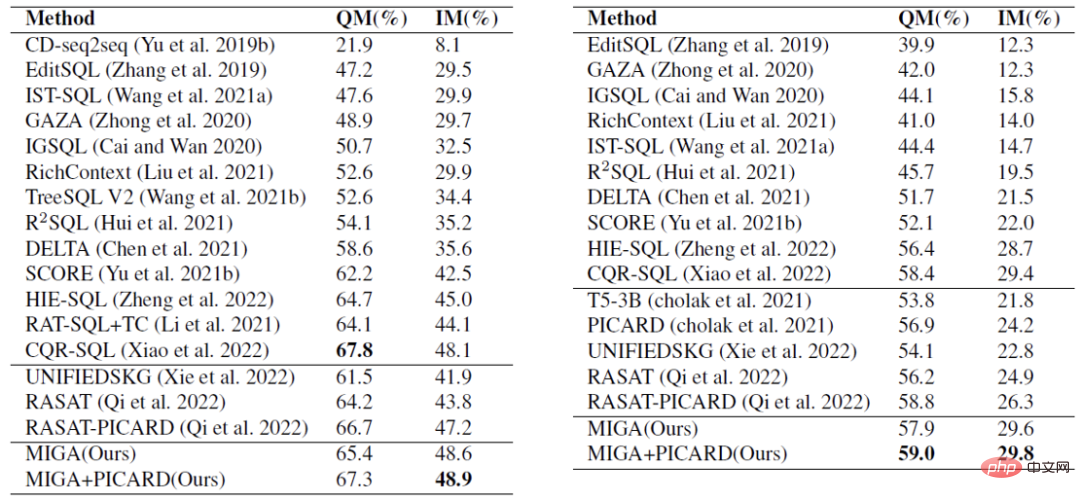

Dalam percubaan perbandingan dalam Jadual 1, MIGA mengatasi dialog berbilang pusingan terbaik semasa dari segi skor IM pada dua set data dan skor QM CoSQL -Model SQL. Dan berbanding dengan jenis penyelesaian berasaskan T5 yang sama, MIGA meningkatkan IM sebanyak 7.0% dan QM masing-masing sebanyak 5.8%.

Jadual 1 Analisis eksperimen perbandingan, bahagian pertama ialah model pokok, dan bahagian kedua ialah model generatif berdasarkan pra-latihan.

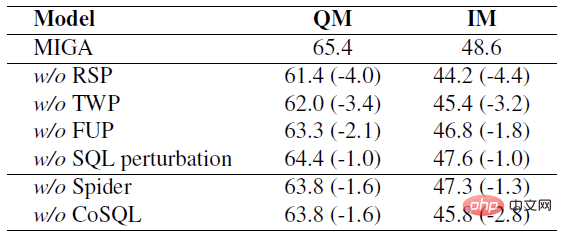

Dalam eksperimen ablasi dalam Jadual 2, kajian ini meneroka beberapa tugasan dalam proses latihan dua peringkat MIGA, dan juga membuktikan bahawa tugasan ini masing-masing akan memberi kesan kepada Tugasan sasaran telah dipertingkatkan kepada pelbagai peringkat.

Jadual 2 Untuk tugas SparC, mengalih keluar setiap tugas atau data masing-masing mengakibatkan penurunan dalam penunjuk.

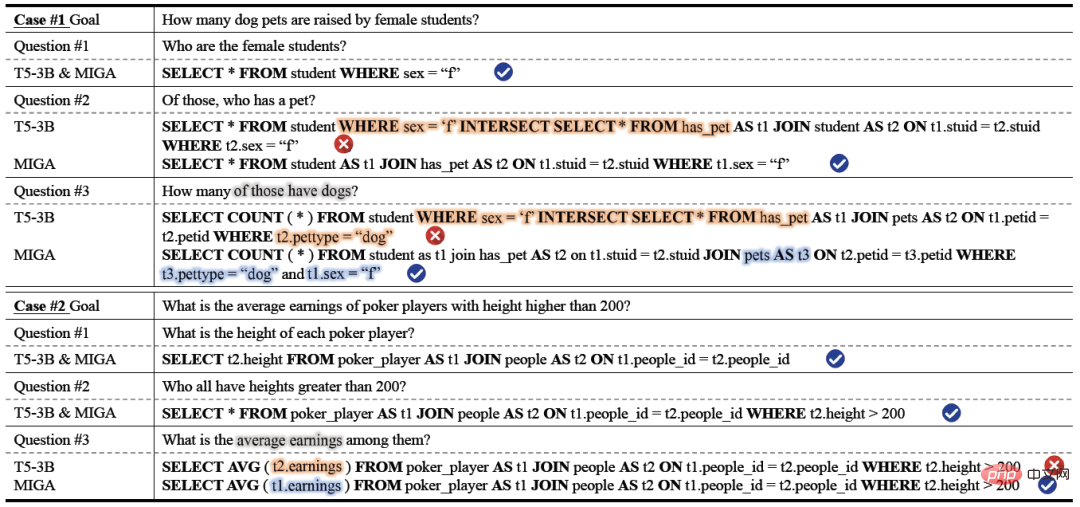

Dalam keputusan analisis kes sebenar, kestabilan dan ketepatan penjanaan MIGA adalah lebih baik daripada yang berdasarkan model latihan T5-3B itu adalah lebih baik dalam penjanaan Ia lebih baik daripada model lain dalam operasi gabungan berbilang jadual dan pemetaan lajur dan jadual. Dalam Soalan#2 Kes#1, model T5-3B tidak boleh menjana SQL yang sah untuk struktur JOIN yang agak kompleks (sambungan dua jadual), yang membawa kepada ramalan yang salah untuk struktur JOIN yang lebih kompleks (sambungan tiga jadual) dalam Soalan #3. MIGA meramalkan struktur JOIN dengan tepat dan mengekalkan keadaan sebelumnya t1.sex="f" dengan baik. Dalam Kes #2, T5-3B mengelirukan berbilang lajur dalam jadual berbeza dan kesilapan pendapatan untuk lajur jadual orang, manakala MIGA mengenal pasti lajur itu dengan betul sebagai milik jadual poker_player dan memautkannya kepada t1.

Jadual 3 Analisis kes.

Kesimpulan

NetEase Interactive Entertainment AI Lab mencadangkan model pra-latihan berbilang tugas dua peringkat berasaskan T5 untuk Text-to-SQL: MIGA . Dalam peringkat pra-latihan, MIGA menguraikan tugasan Text-to-SQL kepada tiga subtugas tambahan dan menyatukannya ke dalam paradigma penjanaan urutan-ke-jujukan untuk memotivasikan model T5 pra-terlatih dengan lebih baik. Dan mekanisme gangguan SQL diperkenalkan dalam peringkat penalaan halus untuk mengurangkan kesan penghantaran ralat dalam berbilang pusingan senario penjanaan Teks-ke-SQL.

Pada masa hadapan, pasukan penyelidik akan meneroka lagi strategi yang lebih berkesan untuk memanfaatkan kuasa model bahasa yang sangat besar, dan meneroka cara yang lebih elegan dan berkesan untuk terus mengatasi masalah yang disebabkan oleh penyampaian yang salah Masalah pengurangan kesan.

Atas ialah kandungan terperinci Model pra-latihan Teks-ke-SQL dua peringkat berbilang tugas MIGA berdasarkan T5. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1659

1659

14

14

1416

1416

52

52

1310

1310

25

25

1258

1258

29

29

1232

1232

24

24

Sumber terbuka! Di luar ZoeDepth! DepthFM: Anggaran kedalaman monokular yang cepat dan tepat!

Apr 03, 2024 pm 12:04 PM

Sumber terbuka! Di luar ZoeDepth! DepthFM: Anggaran kedalaman monokular yang cepat dan tepat!

Apr 03, 2024 pm 12:04 PM

0. Apakah fungsi artikel ini? Kami mencadangkan DepthFM: model anggaran kedalaman monokular generatif yang serba boleh dan pantas. Sebagai tambahan kepada tugas anggaran kedalaman tradisional, DepthFM juga menunjukkan keupayaan terkini dalam tugas hiliran seperti mengecat kedalaman. DepthFM cekap dan boleh mensintesis peta kedalaman dalam beberapa langkah inferens. Mari kita baca karya ini bersama-sama ~ 1. Tajuk maklumat kertas: DepthFM: FastMonocularDepthEstimationwithFlowMatching Pengarang: MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Model MoE sumber terbuka paling berkuasa di dunia ada di sini, dengan keupayaan bahasa Cina setanding dengan GPT-4, dan harganya hanya hampir satu peratus daripada GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Model MoE sumber terbuka paling berkuasa di dunia ada di sini, dengan keupayaan bahasa Cina setanding dengan GPT-4, dan harganya hanya hampir satu peratus daripada GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Bayangkan model kecerdasan buatan yang bukan sahaja mempunyai keupayaan untuk mengatasi pengkomputeran tradisional, tetapi juga mencapai prestasi yang lebih cekap pada kos yang lebih rendah. Ini bukan fiksyen sains, DeepSeek-V2[1], model MoE sumber terbuka paling berkuasa di dunia ada di sini. DeepSeek-V2 ialah gabungan model bahasa pakar (MoE) yang berkuasa dengan ciri-ciri latihan ekonomi dan inferens yang cekap. Ia terdiri daripada 236B parameter, 21B daripadanya digunakan untuk mengaktifkan setiap penanda. Berbanding dengan DeepSeek67B, DeepSeek-V2 mempunyai prestasi yang lebih kukuh, sambil menjimatkan 42.5% kos latihan, mengurangkan cache KV sebanyak 93.3% dan meningkatkan daya pemprosesan penjanaan maksimum kepada 5.76 kali. DeepSeek ialah sebuah syarikat yang meneroka kecerdasan buatan am

Apr 09, 2024 am 11:52 AM

Apr 09, 2024 am 11:52 AM

AI memang mengubah matematik. Baru-baru ini, Tao Zhexuan, yang telah mengambil perhatian terhadap isu ini, telah memajukan keluaran terbaru "Buletin Persatuan Matematik Amerika" (Buletin Persatuan Matematik Amerika). Memfokuskan pada topik "Adakah mesin akan mengubah matematik?", ramai ahli matematik menyatakan pendapat mereka Seluruh proses itu penuh dengan percikan api, tegar dan menarik. Penulis mempunyai barisan yang kuat, termasuk pemenang Fields Medal Akshay Venkatesh, ahli matematik China Zheng Lejun, saintis komputer NYU Ernest Davis dan ramai lagi sarjana terkenal dalam industri. Dunia AI telah berubah secara mendadak Anda tahu, banyak artikel ini telah dihantar setahun yang lalu.

KAN, yang menggantikan MLP, telah diperluaskan kepada konvolusi oleh projek sumber terbuka

Jun 01, 2024 pm 10:03 PM

KAN, yang menggantikan MLP, telah diperluaskan kepada konvolusi oleh projek sumber terbuka

Jun 01, 2024 pm 10:03 PM

Awal bulan ini, penyelidik dari MIT dan institusi lain mencadangkan alternatif yang sangat menjanjikan kepada MLP - KAN. KAN mengatasi MLP dari segi ketepatan dan kebolehtafsiran. Dan ia boleh mengatasi prestasi MLP berjalan dengan bilangan parameter yang lebih besar dengan bilangan parameter yang sangat kecil. Sebagai contoh, penulis menyatakan bahawa mereka menggunakan KAN untuk menghasilkan semula keputusan DeepMind dengan rangkaian yang lebih kecil dan tahap automasi yang lebih tinggi. Khususnya, MLP DeepMind mempunyai kira-kira 300,000 parameter, manakala KAN hanya mempunyai kira-kira 200 parameter. KAN mempunyai asas matematik yang kukuh seperti MLP berdasarkan teorem penghampiran universal, manakala KAN berdasarkan teorem perwakilan Kolmogorov-Arnold. Seperti yang ditunjukkan dalam rajah di bawah, KAN telah

Hello, Atlas elektrik! Robot Boston Dynamics hidup semula, gerakan pelik 180 darjah menakutkan Musk

Apr 18, 2024 pm 07:58 PM

Hello, Atlas elektrik! Robot Boston Dynamics hidup semula, gerakan pelik 180 darjah menakutkan Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas secara rasmi memasuki era robot elektrik! Semalam, Atlas hidraulik hanya "menangis" menarik diri daripada peringkat sejarah Hari ini, Boston Dynamics mengumumkan bahawa Atlas elektrik sedang berfungsi. Nampaknya dalam bidang robot humanoid komersial, Boston Dynamics berazam untuk bersaing dengan Tesla. Selepas video baharu itu dikeluarkan, ia telah pun ditonton oleh lebih sejuta orang dalam masa sepuluh jam sahaja. Orang lama pergi dan peranan baru muncul. Ini adalah keperluan sejarah. Tidak dinafikan bahawa tahun ini adalah tahun letupan robot humanoid. Netizen mengulas: Kemajuan robot telah menjadikan majlis pembukaan tahun ini kelihatan seperti manusia, dan tahap kebebasan adalah jauh lebih besar daripada manusia Tetapi adakah ini benar-benar bukan filem seram? Pada permulaan video, Atlas berbaring dengan tenang di atas tanah, seolah-olah terlentang. Apa yang berikut adalah rahang-jatuh

Robot Tesla bekerja di kilang, Musk: Tahap kebebasan tangan akan mencapai 22 tahun ini!

May 06, 2024 pm 04:13 PM

Robot Tesla bekerja di kilang, Musk: Tahap kebebasan tangan akan mencapai 22 tahun ini!

May 06, 2024 pm 04:13 PM

Video terbaru robot Tesla Optimus dikeluarkan, dan ia sudah boleh berfungsi di kilang. Pada kelajuan biasa, ia mengisih bateri (bateri 4680 Tesla) seperti ini: Pegawai itu juga mengeluarkan rupanya pada kelajuan 20x - pada "stesen kerja" kecil, memilih dan memilih dan memilih: Kali ini ia dikeluarkan Salah satu sorotan video itu ialah Optimus menyelesaikan kerja ini di kilang, sepenuhnya secara autonomi, tanpa campur tangan manusia sepanjang proses. Dan dari perspektif Optimus, ia juga boleh mengambil dan meletakkan bateri yang bengkok, memfokuskan pada pembetulan ralat automatik: Berkenaan tangan Optimus, saintis NVIDIA Jim Fan memberikan penilaian yang tinggi: Tangan Optimus adalah robot lima jari di dunia paling cerdik. Tangannya bukan sahaja boleh disentuh

Yang terbaru dari Universiti Oxford! Mickey: Padanan imej 2D dalam SOTA 3D! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Yang terbaru dari Universiti Oxford! Mickey: Padanan imej 2D dalam SOTA 3D! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Pautan projek ditulis di hadapan: https://nianticlabs.github.io/mickey/ Memandangkan dua gambar, pose kamera di antara mereka boleh dianggarkan dengan mewujudkan kesesuaian antara gambar. Biasanya, surat-menyurat ini adalah 2D hingga 2D, dan anggaran pose kami adalah skala-tak tentu. Sesetengah aplikasi, seperti realiti tambahan segera pada bila-bila masa, di mana-mana sahaja, memerlukan anggaran pose metrik skala, jadi mereka bergantung pada penganggar kedalaman luaran untuk memulihkan skala. Makalah ini mencadangkan MicKey, proses pemadanan titik utama yang mampu meramalkan korespondensi metrik dalam ruang kamera 3D. Dengan mempelajari padanan koordinat 3D merentas imej, kami dapat membuat kesimpulan relatif metrik

Versi Kuaishou Sora 'Ke Ling' dibuka untuk ujian: menghasilkan video lebih 120-an, memahami fizik dengan lebih baik dan boleh memodelkan pergerakan kompleks dengan tepat

Jun 11, 2024 am 09:51 AM

Versi Kuaishou Sora 'Ke Ling' dibuka untuk ujian: menghasilkan video lebih 120-an, memahami fizik dengan lebih baik dan boleh memodelkan pergerakan kompleks dengan tepat

Jun 11, 2024 am 09:51 AM

Apa? Adakah Zootopia dibawa menjadi realiti oleh AI domestik? Didedahkan bersama-sama dengan video itu ialah model penjanaan video domestik berskala besar baharu yang dipanggil "Keling". Sora menggunakan laluan teknikal yang serupa dan menggabungkan beberapa inovasi teknologi yang dibangunkan sendiri untuk menghasilkan video yang bukan sahaja mempunyai pergerakan yang besar dan munasabah, tetapi juga mensimulasikan ciri-ciri dunia fizikal dan mempunyai keupayaan gabungan konsep dan imaginasi yang kuat. Mengikut data, Keling menyokong penjanaan video ultra panjang sehingga 2 minit pada 30fps, dengan resolusi sehingga 1080p dan menyokong berbilang nisbah aspek. Satu lagi perkara penting ialah Keling bukanlah demo atau demonstrasi hasil video yang dikeluarkan oleh makmal, tetapi aplikasi peringkat produk yang dilancarkan oleh Kuaishou, pemain terkemuka dalam bidang video pendek. Selain itu, tumpuan utama adalah untuk menjadi pragmatik, bukan untuk menulis cek kosong, dan pergi ke dalam talian sebaik sahaja ia dikeluarkan Model besar Ke Ling telah pun dikeluarkan di Kuaiying.