Peranti teknologi

Peranti teknologi

AI

AI

Lao Huang memegang 'bom nuklear' khas untuk ChatGPT untuk meletupkan tempat kejadian, dan NVIDIA H100 Extreme Edition adalah 10 kali lebih pantas!

Lao Huang memegang 'bom nuklear' khas untuk ChatGPT untuk meletupkan tempat kejadian, dan NVIDIA H100 Extreme Edition adalah 10 kali lebih pantas!

Lao Huang memegang 'bom nuklear' khas untuk ChatGPT untuk meletupkan tempat kejadian, dan NVIDIA H100 Extreme Edition adalah 10 kali lebih pantas!

NVIDIA, anda menang!

Pada persidangan GTC yang baru sahaja tamat, bergantung pada "AI generatif" yang memenuhi skrin, memegang cip H100 NVLINK yang menyokong kuasa pengkomputeran ChatGPT dan meningkatkan kelajuan sebanyak 10 kali ganda, Lao Huang hilang Tulis perkataan ini di muka anda - "Saya seorang pemenang".

ChatGPT, Microsoft 365, Azure, Stable Diffusion, DALL-E, Midjourney... semua ini adalah paling popular pada masa kini. Nvidia boleh mendapatkan bahagian produk AI yang meletup.

Kepopularan global ChatGPT pada awal tahun ini menyebabkan harga saham Nvidia melambung tinggi, dan nilai pasarannya secara langsung meningkat lebih daripada 70 bilion dolar AS. Pada masa ini, permodalan pasaran Nvidia ialah AS$640 bilion.

Kini, detik iPhone AI telah tiba, revolusi teknologi keempat akan bermula, dan Nvidia, dengan A100 dan H100 di tangan, atau Menjadi pemenang terbesar.

Pada persidangan GTC, Huang mengumumkan kemajuan luar biasa NVIDIA dalam GPU, perpustakaan pecutan, litografi pengiraan dan platform awan, malah membuat dakwaan berani-NVIDIA akan menjadi TSMC dalam industri AI!

Sesetengah orang telah membuat spekulasi bahawa ucapan hari ini semuanya dijana menggunakan model AIGC pada H100.

GPU khusus ChatGPT telah tiba

Pengumuman terbesar pada persidangan ini ialah NVIDIA H100 NVLINK yang dibina untuk ChatGPT.

Disebabkan permintaan yang besar untuk kuasa pengkomputeran, NVIDIA telah melancarkan GPU Hopper baharu untuk inferens LLM seperti ChatGPT, PCIE H100 dilengkapi dengan dwi GPU NVLINK, dengan memori 94B.

Malah, sejarah pembelajaran mendalam berkait rapat dengan NVIDIA sejak 2012.

Lao Huang berkata pada 2012, veteran pembelajaran mendalam Hinton dan pelajar Alex Kerchevsky dan Ilya Suskever menggunakan GeForce GTX 580 semasa melatih AlexNet.

Selepas itu, AlexNet memenangi pertandingan klasifikasi imej ImageNet dalam satu kejadian, menjadi titik tunggal ledakan pembelajaran mendalam.

Sepuluh tahun kemudian, Ilya Suskever di OpenAI turut menggunakan DGX NVIDIA untuk melatih GPT3 dan GPT3.5 di belakang ChatGPT.

Lao Huang dengan bangganya berkata bahawa satu-satunya GPU pada awan yang sebenarnya boleh mengendalikan ChatGPT ialah HGX A100.

Tetapi berbanding dengan A100, pelayan yang dilengkapi dengan empat pasang H100 dan dwi GPU NVLINK adalah 10 kali lebih pantas! Kerana H100 boleh mengurangkan kos pemprosesan LLM mengikut susunan magnitud.

AI berada pada titik infleksi kerana AI generatif mencipta gelombang peluang, menyebabkan beban kerja inferens berkembang dalam fesyen fungsi langkah.

Pada masa lalu, mereka bentuk pusat data awan untuk mengendalikan AI generatif merupakan satu cabaran yang besar.

Di satu pihak, adalah sesuai untuk menggunakan pemecut untuk menjadikan pusat data anjal, tetapi sebaliknya, tiada pemecut yang dapat menangani masalah dalam algoritma dan model secara optimum cara , kepelbagaian dalam jenis dan saiz data. Platform One Architecture NVIDIA mempunyai kedua-dua keupayaan pecutan dan fleksibiliti.

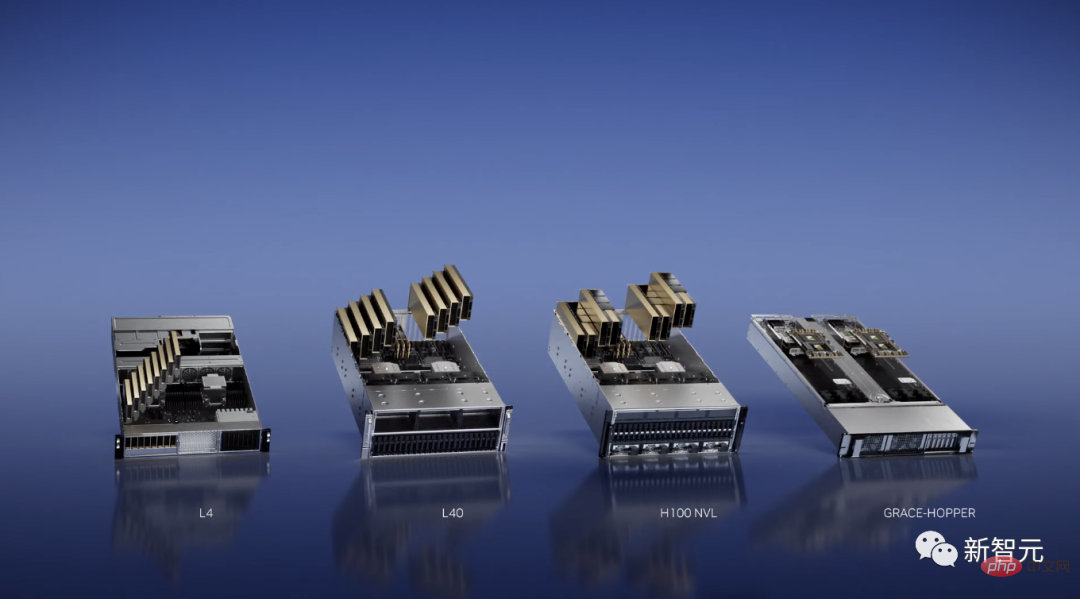

Dan hari ini, NVIDIA mengumumkan pelancaran platform inferens baharu. Setiap konfigurasi dioptimumkan untuk jenis beban kerja tertentu.

Sebagai contoh, untuk beban kerja video AI, NVIDIA telah melancarkan L4, yang telah mengoptimumkan penyahkodan dan transkod video, semakan kandungan video dan fungsi panggilan video.

Dan pelayan 8-GPU L4 akan menggantikan lebih daripada seratus pelayan CPU dwi-soket yang digunakan untuk memproses video AI.

Pada masa yang sama, NVIDIA turut melancarkan L40 untuk AI generatif seperti Omniverse, pemaparan grafik dan teks kepada imej/video. Prestasinya adalah 10 kali ganda daripada GPU T4 inferens awan Nvidia yang paling popular.

Pada masa ini, keupayaan berkuasa model AI generatif Gen-1 dan Gen-2 yang dilancarkan oleh Runway bergantung pada GPU NVIDIA.

Selain itu, NVIDIA turut melancarkan cip super baharu Grace-Hopper, yang sesuai untuk sistem pengesyoran dan pangkalan data vektor.

Mencabar had cip, mempercepatkan litografi pengiraan sebanyak 40 kali ganda

Dalam bidang cip, NVIDIA bekerjasama dengan TSMC, ASML dan Synopsys untuk akhirnya melengkapkan litografi pengiraan selepas 4 tahun Satu kejayaan besar dalam teknologi - perpustakaan litografi pengiraan NVIDIA cuLitho.

Selepas mencapai had proses 2nm, fotolitografi ialah titik terobosan.

Litografi pengiraan mensimulasikan kelakuan cahaya kerana ia berinteraksi dengan photoresist selepas melalui elemen optik Dengan menggunakan algoritma fizik songsang, kita boleh meramalkan corak pada topeng supaya ia boleh menjadi Corak akhir dihasilkan pada wafer.

Litografi pengiraan ialah beban kerja pengkomputeran terbesar dalam reka bentuk dan pembuatan cip, yang menggunakan berpuluh bilion jam CPU setiap tahun. Sebaliknya, algoritma baharu yang dicipta oleh NVIDIA membolehkan aliran kerja litografi pengiraan yang semakin kompleks dilaksanakan secara selari pada GPU.

Ringkasnya, cuLitho bukan sahaja boleh meningkatkan kelajuan pengkomputeran sebanyak 40 kali, tetapi juga mengurangkan penggunaan kuasa sebanyak 9 kali.

Sebagai contoh, H100 Nvidia memerlukan 89 topeng.

Jika diproses oleh CPU, setiap topeng akan mengambil masa dua minggu. Jika anda menjalankan cuLitho pada GPU, ia hanya mengambil masa 8 jam untuk memproses topeng.

TSMC juga boleh menggunakan 4,000 GPU Hopper dalam 500 sistem DGX H100 untuk menyelesaikan kerja yang sebelum ini memerlukan sehingga 40,000 pelayan berasaskan CPU, dan kuasa juga akan meningkat 35MW.

Perlu diambil perhatian bahawa perpustakaan pecutan cuLitho juga serasi dengan GPU seni bina Ampere dan Volta, tetapi Hopper ialah penyelesaian terpantas.

Lao Huang berkata memandangkan teknologi fotolitografi sudah berada pada had fizik, kilang wafer boleh meningkatkan pengeluaran dan bersedia untuk pembangunan 2nm dan seterusnya.

Momen iPhone AI

Dalam beberapa bulan yang lalu, ChatGPT sangat menggembirakan dan bakal mencetuskan revolusi teknologi keempat. Pepatah "Kami berada dalam detik iPhone AI" juga telah diedarkan secara meluas.

Pada persidangan GTC, Huang juga teruja mengulangi ayat ini tiga kali.

Saat iPhone semakin hampir, syarikat pemula seperti OpenAI bersaing untuk membina produk dan model perniagaan yang mengganggu, manakala syarikat mantap seperti Google dan Microsoft sedang mencari cara untuk menanganinya.

Semua tindakan mereka adalah kerana rasa mendesak dalam merangka strategi AI yang dicetuskan oleh AI generatif di seluruh dunia.

Pengkomputeran dipercepatkan NVIDIA bermula dengan superkomputer AI DGX, yang juga merupakan enjin di sebalik kejayaan semasa dalam model bahasa berskala besar.

Di GTC, Lao Huang dengan bangganya berkata bahawa saya secara peribadi menyerahkan DGX pertama di dunia kepada OpenAI.

Sejak itu, separuh daripada syarikat Fortune 100 telah memasang superkomputer DGXAI.

DGX dilengkapi dengan 8 modul GPU H100, dan H100 dilengkapi dengan enjin Transformer, yang boleh mengendalikan model hebat seperti ChatGPT.

Lapan modul H100 disambungkan antara satu sama lain melalui Suis NVLINK, mencapai komunikasi tanpa sekatan yang komprehensif. Lapan H100 berfungsi bersama seperti GPU gergasi.

Apa yang membuatkan Lao Huang lebih teruja ialah Microsoft mengumumkan bahawa Azure akan membuka versi pratonton peribadi bagi superkomputer AI H100nya.

juga berkata, "Superkomputer DGX ialah kilang AI moden. Kami berada dalam detik iPhone AI."

Dalam dekad yang lalu, gabungan pecutan dan penskalaan menegak telah membolehkan pelbagai aplikasi mencapai peningkatan prestasi berjuta kali ganda.

Contoh yang paling mengagumkan ialah pengenalan rangka kerja pembelajaran mendalam AlexNet pada tahun 2012.

Pada masa itu, Alex Krizhevsky, Ilya Suskever, dan Hinton menyelesaikan latihan menggunakan 14 juta imej pada GeForce GTX 580, yang boleh mengendalikan 262 petaflop operasi titik terapung.

Sepuluh tahun kemudian, Transformer dikeluarkan.

Ilya Suskever melatih GPT-3 untuk meramalkan perkataan seterusnya, yang memerlukan operasi titik terapung sejuta kali lebih banyak daripada melatih model AlexNet.

Oleh itu, AI yang menggemparkan dunia telah dicipta - ChatGPT.

Untuk meringkaskannya dalam satu ayat Lao Huang:

Ini bermakna platform pengkomputeran baharu telah dilahirkan, dan "iPhone saat" AI telah tiba. . Pengkomputeran dipercepatkan dan teknologi AI telah memasuki realiti.

Pustaka pecutan ialah teras pengkomputeran dipercepat. Pustaka pecutan ini menyambungkan pelbagai aplikasi, dan kemudian menyambung kepada pelbagai industri, membentuk rangkaian dalam rangkaian.

Selepas 30 tahun pembangunan, beribu-ribu aplikasi telah dipercepatkan oleh perpustakaan NVIDIA, meliputi hampir setiap bidang sains dan industri.

Pada masa ini, semua GPU NVIDIA adalah serasi dengan CUDA.

300 perpustakaan pecutan sedia ada dan 400 model AI meliputi pelbagai bidang seperti pengkomputeran kuantum, pemprosesan data dan pembelajaran mesin.

Pada persidangan GTC ini, Nvidia mengumumkan bahawa ia telah mengemas kini 100 daripadanya.

Platform NVIDIA Quantum terdiri daripada perpustakaan dan sistem yang membolehkan penyelidik memajukan model pengaturcaraan kuantum, seni bina sistem dan algoritma.

cuQuantum ialah perpustakaan pecutan untuk simulasi litar kuantum Syarikat seperti IBM dan Baidu telah menyepadukan perpustakaan pecutan ini ke dalam rangka kerja simulasi mereka.

Open Quantum CUDA ialah model pengaturcaraan GPU-Kuantum hibrid NVIDIA.

Nvidia turut mengumumkan pelancaran pautan kawalan kuantum, yang dibangunkan dengan kerjasama Mesin Kuantum. Ia boleh menyambungkan GPU Nvidia ke komputer kuantum untuk melakukan pembetulan ralat pada kelajuan yang sangat pantas.

Terdapat juga perpustakaan RAFT baharu yang dilancarkan untuk mempercepatkan pengindeksan, pemuatan data dan carian jiran terdekat.

Selain itu, NVIDIA turut mengumumkan DGX Quantum, dibina dengan DGX dan memanfaatkan sumber terbuka CUDA Quantum terbaharu ini menyediakan platform mewah yang revolusioner untuk penyelidik yang terlibat dalam pengkomputeran kuantum. Prestasi dan seni bina kependaman rendah.

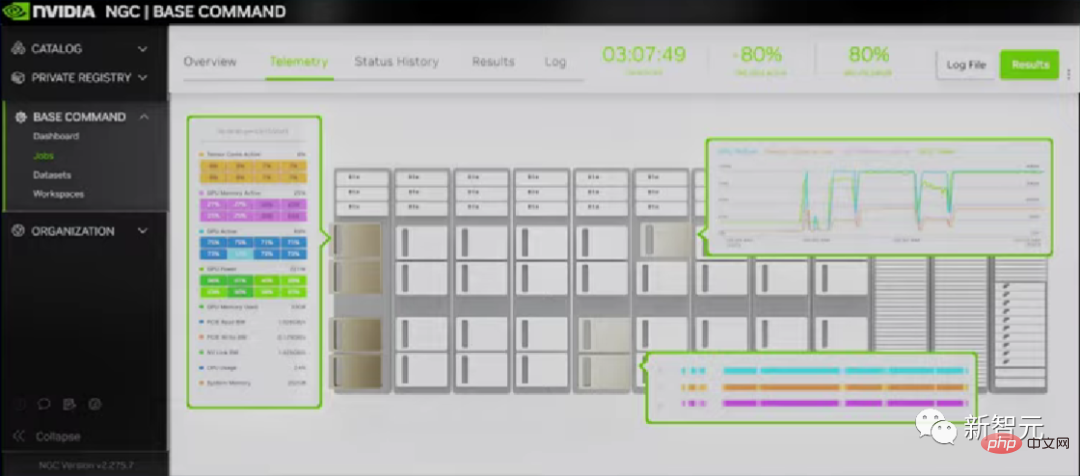

NVIDIA turut melancarkan perisian NVIDIA Triton Management Service untuk menskala dan mengatur kejadian inferens Triton secara automatik di seluruh pusat data. Sesuai untuk inferens berbilang GPU dan berbilang nod bagi model bahasa besar seperti GPT-3.

NVIDIA turut melancarkan perisian NVIDIA Triton Management Service untuk menskala dan mengatur kejadian inferens Triton secara automatik di seluruh pusat data. Sesuai untuk inferens berbilang GPU dan berbilang nod bagi model bahasa besar seperti GPT-3.

CV-CUDA untuk penglihatan komputer dan VPF untuk pemprosesan video ialah perpustakaan pecutan skala awan NVIDIA yang baharu.

Lao Huang mengumumkan bahawa CV-CUDA Beta mengoptimumkan pra-pemprosesan dan pasca-pemprosesan, mencapai daya pemprosesan awan yang lebih tinggi dan mengurangkan kos dan penggunaan tenaga sebanyak satu perempat.

Pada masa ini, Microsoft mengendalikan carian visual dan Runway menggunakan perpustakaan CV-CUDA dan VRF untuk pemprosesan video AI generatifnya.

Selain itu, pengkomputeran dipercepatkan NVIDIA juga telah membantu genomik mencapai perkembangan penting. Menggunakan instrumen berkuasa NVIDIA, mengurangkan kos keseluruhan penjujukan genom kepada $100 telah menjadi satu lagi peristiwa penting.

Pustaka pecutan Parabrics NVIDIA boleh digunakan untuk analisis genomik hujung ke hujung dalam awan atau dalam instrumen, dan sesuai untuk pelbagai awan awam dan platform genomik.

ChatGPT sedang berjalan dan NVIDIA menjana wang

Kini, ChatGPT, Stable Diffusion, DALL-E dan Midjourney telah membangkitkan kesedaran dunia tentang AI generatif .

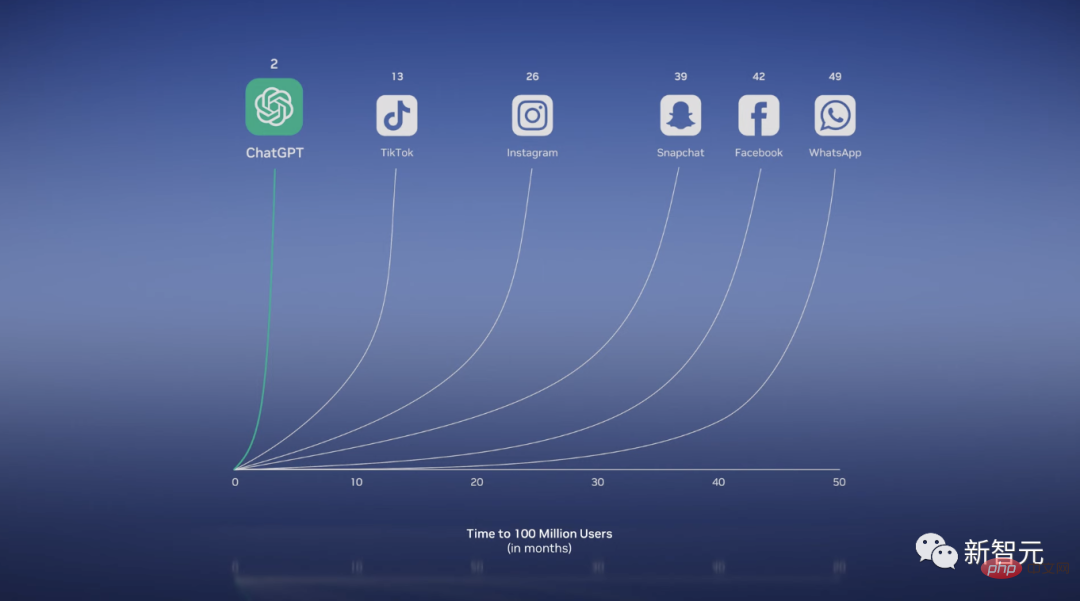

ChatGPT yang popular telah melebihi 100 juta pengguna bulanan hanya 2 bulan selepas pelancarannya, menjadi aplikasi dengan pertumbuhan pengguna terpantas dalam sejarah.

Boleh dikatakan komputer. Anda bukan sahaja boleh menjana teks, menulis puisi, menulis semula kertas penyelidikan, menyelesaikan masalah matematik, dan juga program.

Banyak hasil terobosan telah mencipta AI generatif hari ini.

Transformer dapat mempelajari konteks dan makna daripada hubungan dan kebergantungan data secara selari secara besar-besaran. Ini membolehkan LLM belajar daripada sejumlah besar data dan melaksanakan tugas hiliran tanpa latihan yang jelas.

Selain itu, model resapan yang diilhamkan oleh fizik boleh menjana imej melalui pembelajaran tanpa pengawasan.

Huang menyimpulkan bahawa dalam masa sedozen tahun sahaja, kami telah beralih daripada mengenal pasti kucing kepada menjana kucing dalam sut angkasa berjalan di bulan.

Kini boleh dikatakan AI generatif ialah sejenis komputer baharu, komputer yang boleh diprogramkan dalam bahasa manusia.

Sebelum ini, memesan komputer untuk menyelesaikan masalah merupakan keistimewaan eksklusif pengaturcara, tetapi kini, semua orang boleh menjadi pengaturcara.

Seperti Bill Gates, Huang juga memberikan definisi yang sama: Generative AI ialah platform pengkomputeran baharu, serupa dengan PC, Internet, peranti mudah alih dan awan.

Melalui Debuild, kami boleh mereka bentuk dan menggunakan aplikasi web secara langsung asalkan kami menjelaskan perkara yang kami mahukan.

Adalah jelas bahawa AI generatif akan membentuk semula hampir setiap industri.

Untuk menjadi "TSMC" dalam industri AI

Dalam konteks ini, syarikat profesional perlu menggunakan mereka sendiri data proprietari untuk membina model tersuai.

Kemudian Huang dengan bangganya mengumumkan bahawa industri memerlukan faundri yang serupa dengan TSMC untuk membina model bahasa besar yang disesuaikan, dan NVIDIA ialah "TSMC" ini!

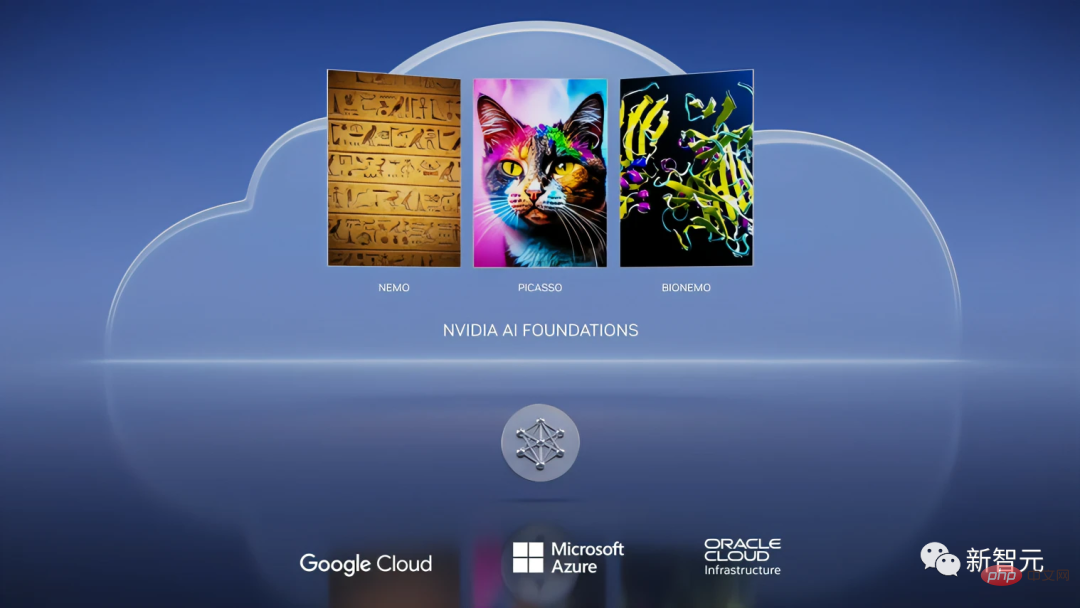

Pada persidangan itu, NVIDIA mengumumkan pelancaran perkhidmatan awan NVIDIA AI Foundations, membolehkan pelanggan menyesuaikan LLM dan AI generatif.

Perkhidmatan awan ini termasuk bahasa, penglihatan dan perkhidmatan pengeluaran model biologi.

Antaranya, Nemo digunakan untuk membina model penjanaan teks-ke-teks bahasa tersuai.

Picasso ialah pembuat model bahasa visual yang boleh digunakan untuk melatih model tersuai, termasuk imej, video dan aplikasi 3D.

Selagi anda menghantar panggilan API dengan gesaan teks dan metadata kepada Picasso, Picasso akan menghantar semula bahan yang dijana kepada aplikasi menggunakan model pada DGX Cloud.

Apa yang lebih menakjubkan ialah dengan mengimport bahan ini ke dalam NVIDIA Omniverse, anda boleh membina aplikasi metaverse yang realistik dan simulasi kembar digital.

Selain itu, NVIDIA juga bekerjasama dengan Shutterstock untuk membangunkan model generatif Edify-3D.

Pada masa yang sama, kerjasama antara NVIDIA dan Adobe terus berkembang, menyepadukan AI generatif ke dalam aliran kerja harian pemasar dan orang kreatif, dan memberi perhatian khusus kepada perlindungan artis. hak cipta.

Bidang ketiga ialah biologi.

Hari ini, nilai industri penyelidikan dan pembangunan dadah telah mencecah hampir 2 trilion yuan, dengan pelaburan R&D sehingga 250 bilion dolar AS.

NVIDIA Clara ialah rangka kerja aplikasi perubatan dan kesihatan untuk pengimejan, instrumentasi, analisis genomik dan pembangunan ubat.

Baru-baru ini, arah popular dalam biosfera ialah menggunakan AI generatif untuk menemui sasaran penyakit dan mereka bentuk molekul baharu atau ubat protein.

Sehubungan itu, BIONEMO membenarkan pengguna menggunakan data proprietari untuk mencipta, memperhalusi dan menyediakan model tersuai, termasuk model ramalan protein seperti AlphaFold, ESMFold dan OpenFold.

Akhirnya, Huang membuat kesimpulan bahawa NVIDIA AI Foundations ialah perkhidmatan awan dan faundri untuk membina model bahasa tersuai dan AI generatif.

Laohuang Cloud Service, sewa bulanan ialah AS$36,999

Nvidia turut melancarkan perkhidmatan awan kali ini.

Ia amat melihat keperluan pelanggan untuk akses yang lebih mudah dan pantas kepada NVIDIA AI, jadi ia melancarkan NVIDIA DGX Cloud.

DGX Cloud bekerjasama dengan Microsoft Azure, Google GCP dan Oracle OCI. Dengan hanya penyemak imbas dan superkomputer NVIDIA DGX AI, anda boleh mengakses setiap syarikat dengan serta-merta!

Pada awan ini, anda boleh menjalankan suite perpustakaan pecutan NVIDIA AI Enterprise untuk menyelesaikan secara langsung pembangunan dan penggunaan AI secara menyeluruh.

Selain itu, awan bukan sahaja menyediakan NVIDIA AI, tetapi juga beberapa penyedia perkhidmatan awan utama di dunia.

Dan NVIDIA DGX Cloud pertama NVIDIA ialah Oracle Cloud Infrastructure (OCI).

Dalam OCI, NVIDIA CX-7 dan BlueField-3 bergabung untuk mencipta superkomputer yang berkuasa.

Menurut laporan, perusahaan kini boleh menyewa DGX Cloud, bermula dari AS$36,999 sebulan.

Akhir sekali, sudah tentu, terdapat program khas persidangan GTC tahunan - Omniverse. Lao Huang mengumumkan kemas kini platform metaverse Omniverse.

Kini, Microsoft dan NVIDIA sedang bersedia untuk membawa Omniverse kepada ratusan juta pengguna Microsoft 365 dan Azure.

Di samping itu, terdapat berita bahawa untuk membolehkan H100 dieksport ke China dengan mematuhi peraturan, Lao Huang melaraskan khas "H800" berdasarkan pengalaman A800 sebelumnya , menggabungkan cip Kadar pemindahan data antara H100 dan H100 dikurangkan kepada kira-kira 50%.

Ringkasnya, Lao Huang telah menjelaskan pada persidangan ini bahawa NVIDIA mahu menjadi TSMC dalam bidang AI, menyediakan OEM seperti kilang wafer, dan atas dasar ini, syarikat lain dalam industri boleh algoritma kereta api.

Bolehkah model perniagaan ini berjaya?

Atas ialah kandungan terperinci Lao Huang memegang 'bom nuklear' khas untuk ChatGPT untuk meletupkan tempat kejadian, dan NVIDIA H100 Extreme Edition adalah 10 kali lebih pantas!. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1393

1393

52

52

1207

1207

24

24

Platform Perdagangan Web3 Ranking_Web3 Global Exchanges Top Ten Ringkasan

Apr 21, 2025 am 10:45 AM

Platform Perdagangan Web3 Ranking_Web3 Global Exchanges Top Ten Ringkasan

Apr 21, 2025 am 10:45 AM

Binance adalah tuan rumah ekosistem perdagangan aset digital global, dan ciri -cirinya termasuk: 1. Jumlah dagangan harian purata melebihi $ 150 bilion, menyokong 500 pasangan perdagangan, yang meliputi 98% mata wang arus perdana; 2. Matriks inovasi meliputi pasaran Derivatif, susun atur Web3 dan sistem pendidikan; 3. Kelebihan teknikal adalah enjin yang sepadan dengan milisaat, dengan jumlah pemprosesan puncak sebanyak 1.4 juta transaksi sesaat; 4. Kemajuan pematuhan memegang lesen 15 negara dan menetapkan entiti yang mematuhi di Eropah dan Amerika Syarikat.

Ramalan Harga Worldcoin (WLD) 2025-2031: Adakah WLD akan mencapai $ 4 menjelang 2031?

Apr 21, 2025 pm 02:42 PM

Ramalan Harga Worldcoin (WLD) 2025-2031: Adakah WLD akan mencapai $ 4 menjelang 2031?

Apr 21, 2025 pm 02:42 PM

Worldcoin (WLD) menonjol dalam pasaran cryptocurrency dengan mekanisme pengesahan biometrik dan perlindungan privasi yang unik, menarik perhatian banyak pelabur. WLD telah melakukan yang luar biasa di kalangan altcoin dengan teknologi inovatifnya, terutamanya dalam kombinasi dengan teknologi kecerdasan buatan terbuka. Tetapi bagaimanakah aset digital akan berkelakuan dalam beberapa tahun akan datang? Mari kita meramalkan harga masa depan WLD bersama -sama. Ramalan harga WLD 2025 dijangka mencapai pertumbuhan yang signifikan di WLD pada tahun 2025. Analisis pasaran menunjukkan bahawa harga WLD purata boleh mencapai $ 1.31, dengan maksimum $ 1.36. Walau bagaimanapun, dalam pasaran beruang, harga mungkin jatuh ke sekitar $ 0.55. Harapan pertumbuhan ini disebabkan terutamanya oleh WorldCoin2.

Kedudukan pertukaran leverage dalam lingkaran mata wang Cadangan terkini sepuluh pertukaran leverage dalam lingkaran mata wang

Apr 21, 2025 pm 11:24 PM

Kedudukan pertukaran leverage dalam lingkaran mata wang Cadangan terkini sepuluh pertukaran leverage dalam lingkaran mata wang

Apr 21, 2025 pm 11:24 PM

Platform yang mempunyai prestasi cemerlang dalam perdagangan, keselamatan dan pengalaman pengguna yang dimanfaatkan pada tahun 2025 adalah: 1. Okx, sesuai untuk peniaga frekuensi tinggi, menyediakan sehingga 100 kali leverage; 2. Binance, sesuai untuk peniaga berbilang mata wang di seluruh dunia, memberikan 125 kali leverage tinggi; 3. Gate.io, sesuai untuk pemain derivatif profesional, menyediakan 100 kali leverage; 4. Bitget, sesuai untuk orang baru dan peniaga sosial, menyediakan sehingga 100 kali leverage; 5. Kraken, sesuai untuk pelabur mantap, menyediakan 5 kali leverage; 6. Bybit, sesuai untuk penjelajah altcoin, menyediakan 20 kali leverage; 7. Kucoin, sesuai untuk peniaga kos rendah, menyediakan 10 kali leverage; 8. Bitfinex, sesuai untuk bermain senior

Apakah yang dimaksudkan dengan transaksi rantaian rantaian? Apakah urus niaga salib?

Apr 21, 2025 pm 11:39 PM

Apakah yang dimaksudkan dengan transaksi rantaian rantaian? Apakah urus niaga salib?

Apr 21, 2025 pm 11:39 PM

Pertukaran yang menyokong urus niaga rantaian: 1. Binance, 2. Uniswap, 3 Sushiswap, 4. Kewangan Curve, 5. Thorchain, 6. 1 inci Pertukaran, 7.

Mengapa kenaikan atau kejatuhan harga mata wang maya? Mengapa kenaikan atau kejatuhan harga mata wang maya?

Apr 21, 2025 am 08:57 AM

Mengapa kenaikan atau kejatuhan harga mata wang maya? Mengapa kenaikan atau kejatuhan harga mata wang maya?

Apr 21, 2025 am 08:57 AM

Faktor kenaikan harga mata wang maya termasuk: 1. Peningkatan permintaan pasaran, 2. Menurunkan bekalan, 3. Berita positif yang dirangsang, 4. Sentimen pasaran optimis, 5. Persekitaran makroekonomi; Faktor penurunan termasuk: 1. Mengurangkan permintaan pasaran, 2. Peningkatan bekalan, 3.

Cara Memenangi Ganjaran Airdrop Kernel pada Strategi Proses Penuh Binance

Apr 21, 2025 pm 01:03 PM

Cara Memenangi Ganjaran Airdrop Kernel pada Strategi Proses Penuh Binance

Apr 21, 2025 pm 01:03 PM

Dalam dunia kriptografi yang ramai, peluang baru selalu muncul. Pada masa ini, aktiviti udara Kerneldao (kernel) menarik banyak perhatian dan menarik perhatian banyak pelabur. Jadi, apakah asalnya projek ini? Apakah faedah yang boleh diperoleh oleh pemegang BNB? Jangan risau, perkara berikut akan mendedahkannya satu demi satu untuk anda.

Platform Pertukaran Cryptocurrency Top 10 senarai pertukaran mata wang digital terbesar di dunia

Apr 21, 2025 pm 07:15 PM

Platform Pertukaran Cryptocurrency Top 10 senarai pertukaran mata wang digital terbesar di dunia

Apr 21, 2025 pm 07:15 PM

Pertukaran memainkan peranan penting dalam pasaran cryptocurrency hari ini. Mereka bukan sahaja platform untuk pelabur untuk berdagang, tetapi juga sumber kecairan pasaran dan penemuan harga. Pertukaran mata wang maya terbesar di dunia di kalangan sepuluh teratas, dan pertukaran ini bukan sahaja jauh ke hadapan dalam jumlah dagangan, tetapi juga mempunyai kelebihan mereka sendiri dalam pengalaman pengguna, perkhidmatan keselamatan dan inovatif. Pertukaran yang atas senarai biasanya mempunyai pangkalan pengguna yang besar dan pengaruh pasaran yang luas, dan jumlah dagangan dan jenis aset mereka sering sukar dicapai oleh bursa lain.

Apakah platform perdagangan blockchain hibrid?

Apr 21, 2025 pm 11:36 PM

Apakah platform perdagangan blockchain hibrid?

Apr 21, 2025 pm 11:36 PM

Cadangan untuk memilih pertukaran cryptocurrency: 1. Untuk keperluan kecairan, keutamaan adalah Binance, Gate.io atau Okx, kerana kedalaman pesanannya dan rintangan volatilitas yang kuat. 2. Pematuhan dan Keselamatan, Coinbase, Kraken dan Gemini mempunyai sokongan pengawalseliaan yang ketat. 3. Fungsi inovatif, reka bentuk derivatif Kucoin yang lembut dan Bybit sesuai untuk pengguna lanjutan.