Peranti teknologi

Peranti teknologi

AI

AI

Sejauh manakah Transformer telah berkembang dalam pembelajaran pengukuhan? Universiti Tsinghua, Universiti Peking dan lain-lain bersama-sama mengeluarkan ulasan TransformRL

Sejauh manakah Transformer telah berkembang dalam pembelajaran pengukuhan? Universiti Tsinghua, Universiti Peking dan lain-lain bersama-sama mengeluarkan ulasan TransformRL

Sejauh manakah Transformer telah berkembang dalam pembelajaran pengukuhan? Universiti Tsinghua, Universiti Peking dan lain-lain bersama-sama mengeluarkan ulasan TransformRL

Pembelajaran peneguhan (RL) menyediakan bentuk matematik untuk membuat keputusan berurutan, dan pembelajaran peneguhan mendalam (DRL) juga telah mencapai kemajuan yang besar dalam beberapa tahun kebelakangan ini. Walau bagaimanapun, isu kecekapan sampel menghalang penggunaan meluas kaedah pembelajaran peneguhan mendalam dalam dunia sebenar. Untuk menyelesaikan masalah ini, mekanisme yang berkesan ialah memperkenalkan bias induktif dalam rangka kerja DRL.

Dalam pembelajaran peneguhan mendalam, penghampir fungsi adalah sangat penting. Walau bagaimanapun, berbanding dengan reka bentuk seni bina dalam pembelajaran terselia (SL), isu reka bentuk seni bina dalam DRL masih jarang dikaji. Kebanyakan kerja sedia ada pada seni bina RL telah didorong oleh komuniti pembelajaran diselia/separa penyeliaan. Sebagai contoh, apabila memproses input berdasarkan imej berdimensi tinggi dalam DRL, pendekatan biasa adalah untuk memperkenalkan rangkaian neural convolutional (CNN) [LeCun et al., 1998; 2015]; kebolehmerhatian) Pendekatan biasa untuk imej adalah memperkenalkan rangkaian saraf berulang (RNN) [Hochreiter dan Schmidhuber, 1997;

Dalam beberapa tahun kebelakangan ini, seni bina Transformer [Vaswani et al., 2017] telah menunjukkan prestasi yang lebih baik daripada CNN dan RNN dan telah menjadi paradigma pembelajaran dalam lebih banyak tugas SL [Devlin et al. ., 2018; Dosovitskiy et al., 2020; Seni bina Transformer menyokong pemodelan kebergantungan jarak jauh dan mempunyai kebolehskalaan yang sangat baik [Khan et al., 2022]. Diilhamkan oleh kejayaan SL, orang ramai telah mengembangkan minat yang kuat untuk menggunakan Transformer pada pembelajaran pengukuhan, dengan harapan dapat menerapkan kelebihan Transformer dalam bidang RL.

Penggunaan Transformer dalam RL boleh dikesan kembali kepada kajian oleh Zambaldi et al pada tahun 2018, di mana mekanisme perhatian diri digunakan untuk menstrukturkan hubungan antara perwakilan negeri. penaakulan. Selepas itu, ramai penyelidik berusaha untuk menggunakan perhatian kendiri kepada pembelajaran perwakilan untuk mengekstrak hubungan antara entiti untuk pembelajaran dasar yang lebih baik [Vinyals et al., 2019;

Selain menggunakan Transformer untuk pembelajaran perwakilan, kerja sebelumnya juga menggunakan Transformer untuk menangkap kebergantungan berbilang masa untuk menangani isu kebolehmerhatian separa [Parisotto et al., 2020; 2021 ]. RL Luar Talian [Levine et al., 2020] telah menarik perhatian kerana keupayaannya menggunakan set data berskala besar luar talian. Diilhamkan oleh RL luar talian, penyelidikan terkini menunjukkan bahawa struktur Transformer boleh digunakan secara langsung sebagai model untuk membuat keputusan berurutan [Chen et al., 2021] dan digeneralisasikan kepada pelbagai tugas dan bidang [Lee et al. ., 2022; Carroll et al., 2022].

Malah, menggunakan Transformer sebagai penghampir fungsi dalam pembelajaran pengukuhan menghadapi beberapa cabaran khas, termasuk:

- Pembelajaran pengukuhan Latihan data ejen biasanya merupakan fungsi dasar semasa, yang akan membawa kepada tidak pegun apabila mempelajari Transformer

- Algoritma RL sedia ada biasanya Sangat sensitif terhadap pilihan reka bentuk semasa latihan, termasuk seni bina model dan kapasiti model [Henderson et al., 2018];

- Seni bina berasaskan transformer selalunya dihadkan oleh kos pengkomputeran dan memori berprestasi tinggi , yang menjadikan kedua-dua latihan dan inferens dalam Proses pembelajaran RL mahal.

Sebagai contoh, dalam AI untuk permainan video, kecekapan penjanaan sampel (yang mempengaruhi prestasi latihan secara besar-besaran) bergantung pada rangkaian dasar RL dan rangkaian penilaian ( nilai rangkaian) [Ye et al., 2020a;

Untuk menggalakkan pembangunan bidang pembelajaran pengukuhan dengan lebih baik, penyelidik dari Universiti Tsinghua, Universiti Peking, Institut Penyelidikan Kepintaran Buatan Zhiyuan dan Tencent bersama-sama menerbitkan artikel mengenai pembelajaran pengukuhan Kajian ini kertas kerja Transformer (iaitu TransformRL) meringkaskan kaedah dan cabaran sedia ada, dan membincangkan hala tuju pembangunan masa hadapan. Penulis percaya bahawa TransformRL akan memainkan peranan penting dalam merangsang potensi pembelajaran pengukuhan.

Alamat kertas: https://arxiv.org/pdf/2301.03044.pdf

Struktur keseluruhan kertas adalah seperti berikut:

- Bab 2 memperkenalkan pengetahuan latar belakang RL dan Transformer, dan kemudian secara ringkas memperkenalkan cara kedua-duanya digabungkan

- Bab 3 Menghuraikan evolusi seni bina rangkaian; dalam RL dan cabaran yang telah lama menghalang penerokaan meluas seni bina Transformer dalam RL

- Bab 4 Pengarang kertas kerja mengklasifikasikan Transformer dalam RL dan membincangkan Bab 5 meringkaskan dan menunjukkan potensi masa depan; arah penyelidikan.

- Kandungan teras bermula dari Bab 3 kertas kerja.

Seni bina rangkaian dalam RL

Sebelum memperkenalkan kaedah pengelasan TransformRL, kertas kerja mengkaji kemajuan awal reka bentuk seni bina rangkaian dalam RL dan meringkaskan cabaran sedia ada . Penulis percaya bahawa Transformer adalah seni bina rangkaian neural termaju yang akan menyumbang kepada pembangunan pembelajaran tetulang mendalam (DRL).Seni bina penganggar fungsi

Sejak penciptaan Deep Q-Network [Mnih et al., 2015 ] Sejak kemunculan kerja seks, banyak usaha telah dibuat pada seni bina rangkaian ejen DRL. Penambahbaikan dalam seni bina rangkaian dalam pembelajaran pengukuhan terbahagi kepada dua kategori.

Satu jenis ialah mereka bentuk struktur baharu dan menggabungkan bias induktif RL untuk mengurangkan kesukaran strategi latihan atau fungsi nilai. Contohnya [Wang et al. 2016] mencadangkan seni bina rangkaian pertarungan, di mana satu rangkaian digunakan untuk fungsi nilai keadaan dan satu lagi digunakan untuk fungsi kelebihan tindakan berkaitan keadaan ini menggabungkan bias induktif.

Kategori lain adalah untuk mengkaji sama ada teknik rangkaian saraf yang biasa digunakan (seperti regularization, skip connection, batch normalization) boleh digunakan pada RL. Sebagai contoh, [Ota et al. 2020] mendapati bahawa meningkatkan dimensi input semasa menggunakan pengekstrak ciri dalam talian untuk meningkatkan perwakilan keadaan boleh membantu meningkatkan prestasi dan kecekapan sampel algoritma DRL. [Sinha et al. 2020] mencadangkan seni bina yang sangat padat untuk ejen DRL yang menggunakan sambungan sisa untuk pembelajaran yang cekap dan bias induktif untuk mengurangkan masalah ketidaksamaan pemprosesan data. [Ota et al. 2021] menggunakan DenseNet [Huang et al., 2017] dan memisahkan pembelajaran perwakilan untuk meningkatkan aliran maklumat dan kecerunan dalam rangkaian besar. Baru-baru ini, disebabkan prestasi Transformer yang unggul, penyelidik telah cuba menggunakan seni bina Transformer pada algoritma pengoptimuman dasar, tetapi mendapati bahawa reka bentuk Transformer biasa tidak dapat mencapai prestasi ideal dalam tugas RL [Parisotto et al., 2020].

Cabaran

Walaupun seni bina berasaskan Transformer telah membuat banyak kemajuan dalam bidang SL pada beberapa masa lalu tahun, Memohon Transformers ke RL bukanlah mudah. Malah, terdapat beberapa cabaran yang unik.

Dari perspektif RL, banyak kajian telah menunjukkan bahawa algoritma RL sedia ada sangat sensitif terhadap seni bina rangkaian saraf dalam [Henderson et al., 2018; ; Andrychowicz et al., 2020]. Pertama, pertukaran paradigma antara pengumpulan data dan pengoptimuman dasar dalam RL membawa kepada ketidakstabilan dalam latihan. Kedua, algoritma RL selalunya sangat sensitif terhadap pilihan reka bentuk yang dibuat semasa latihan. [Emmons et al. 2021] menunjukkan bahawa pilihan seni bina model dan penyelarasan adalah penting untuk prestasi ejen DRL.

Dari perspektif Transformer, seni bina berasaskan Transformer mengalami jejak memori yang besar dan kependaman tinggi, yang menghalang penggunaan dan inferens yang cekap. Baru-baru ini, banyak penyelidikan telah dijalankan mengenai peningkatan kecekapan pengiraan dan ingatan bagi seni bina Transformer asal, tetapi kebanyakan kerja ini telah tertumpu pada domain SL.

Dalam bidang RL, Parisotto dan Salakhutdinov mencadangkan untuk mengubah model pelajar berdasarkan Transformer berkapasiti besar kepada model aktor berkapasiti kecil untuk mengelakkan kependaman inferens tinggi Transformer. Walau bagaimanapun, pendekatan ini masih mahal dari segi ingatan dan pengiraan. Pada masa ini, Transformers yang cekap atau ringan belum diterokai sepenuhnya oleh komuniti RL.

Transformer dalam pembelajaran pengukuhan

Walaupun Transformer telah menjadi model asas untuk kebanyakan penyelidikan pembelajaran yang diselia, ia tidak digunakan secara meluas dalam komuniti RL sejak sekian lama kerana kepada cabaran yang disebutkan di atas. Malah, kebanyakan percubaan awal di TransformRL menggunakan Transformer untuk pembelajaran perwakilan keadaan atau menyediakan maklumat memori, sementara masih menggunakan algoritma RL standard untuk pembelajaran ejen, seperti pembelajaran perbezaan temporal dan pengoptimuman dasar.Oleh itu, walaupun Transformer diperkenalkan sebagai penghampir fungsi, kaedah ini masih dicabar oleh rangka kerja RL tradisional. Sehingga baru-baru ini, RL luar talian membolehkan anda mempelajari dasar optimum daripada data luar talian berskala besar. Diilhamkan oleh RL luar talian, kerja baru-baru ini menganggap masalah RL sebagai masalah pemodelan jujukan bersyarat dengan pengalaman tetap. Melakukannya membantu memintas cabaran ralat bootstrap dalam RL tradisional, membolehkan seni bina Transformer melancarkan keupayaan pemodelan jujukan yang berkuasa.

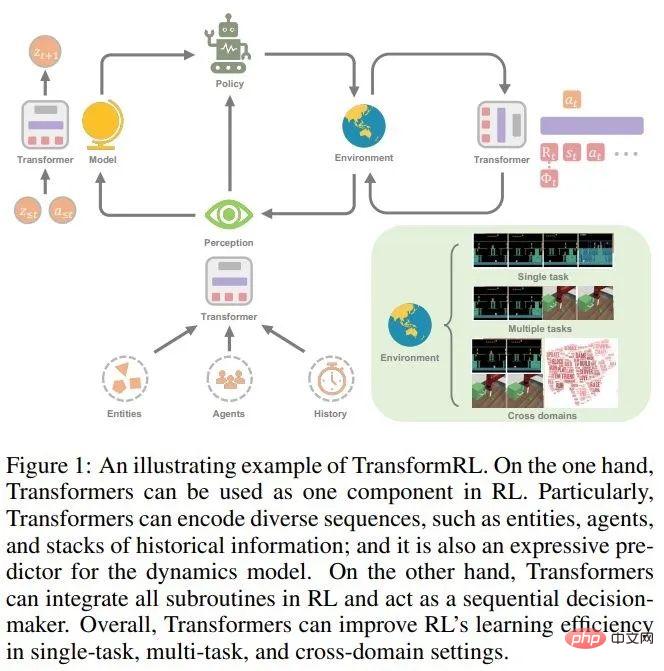

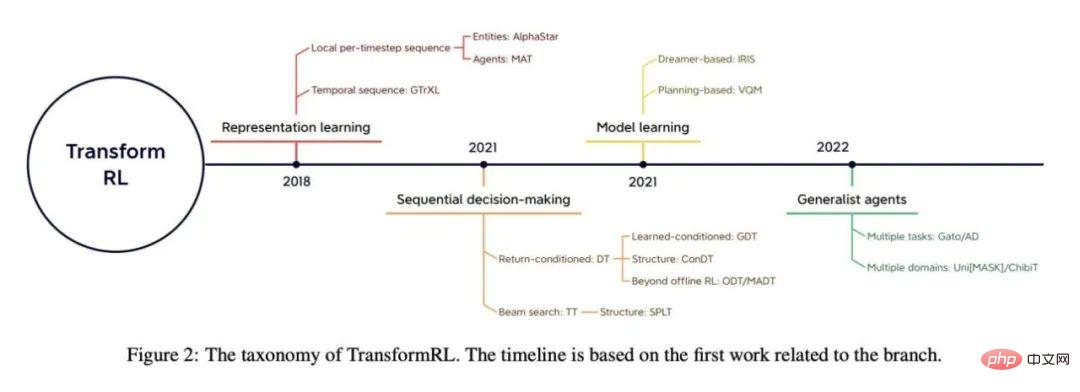

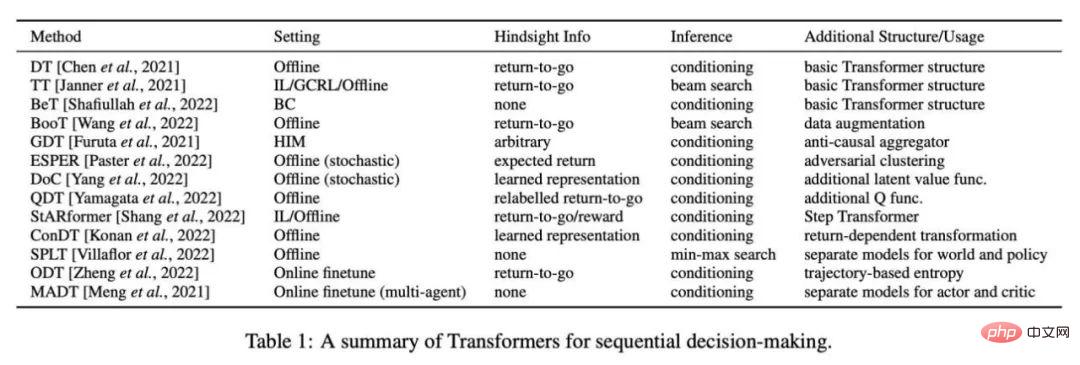

Kertas ini mengkaji kemajuan TransformRL dan membentangkan kaedah sedia ada mengikut pengelasan. Penulis mengklasifikasikan kaedah sedia ada kepada empat kategori: pembelajaran perwakilan, pembelajaran model, membuat keputusan berurutan, dan ejen tujuan umum. Rajah 2 menunjukkan gambaran keseluruhan klasifikasi yang berkaitan.

Transformer untuk pembelajaran perwakilan

Menimbang sifat urutan tugas RL, adalah munasabah untuk menggunakan modul pengekod Transformer. Malah, pelbagai jujukan dalam tugas RL perlu diproses, seperti jujukan setiap langkah masa setempat (jujukan berbilang entiti [Vinyals et al., 2019; Baker et al., 2019], jujukan berbilang ejen [Wen et al. , 2022]), siri masa ([Parisotto et al., 2020; Banino et al., 2021]), dsb.

Pengekod untuk jujukan setiap langkah masa setempat

Kaedah ini terkenal pada awal Kejayaan dicerminkan dalam penggunaan Transformers untuk memproses maklumat kompleks tentang bilangan berubah-ubah entiti yang diperhatikan oleh ejen. [Zambaldi et al., 2018a] mula-mula mencadangkan menggunakan perhatian produk titik berbilang kepala untuk menangkap penaakulan hubungan pemerhatian berstruktur, dan kemudian AlphaStar [Vinyals et al., 2019] melaksanakannya dalam persekitaran berbilang ejen yang mencabar (StarCraft II) Pengendalian pemerhatian pelbagai entiti. Dalam mekanisme yang dipanggil Pengubah Entiti ini, pemerhatian dikodkan dalam bentuk berikut:

di mana e_i mewakili pemerhatian ejen terhadap entiti i, Sama ada dihiris terus daripada keseluruhan pemerhatian, atau diberikan oleh tokenizer entiti.

Sesetengah kerja susulan memperkayakan mekanisme Transformer entiti. [Hu et al. 2020] mencadangkan strategi penyahgandingan yang serasi untuk mengaitkan tindakan secara eksplisit dengan pelbagai entiti dan memanfaatkan mekanisme perhatian untuk tafsiran dasar. Untuk mencapai tiruan visual satu pukulan yang mencabar, Dasari dan Gupta [2021] menggunakan Transformer untuk mempelajari perwakilan yang memfokuskan pada elemen khusus tugasan.

Sama seperti entiti yang tersebar dalam pemerhatian, sesetengah kajian menggunakan Transformers untuk memproses jujukan setiap langkah tempatan yang lain. Tang dan Ha [2021] mengeksploitasi mekanisme perhatian Transformer untuk memproses jujukan persepsi dan membina strategi input pilihatur-invarian. Dalam RL berbilang tugas yang tidak serasi, [Kurin et al., 2020] mencadangkan menggunakan Transformer untuk mengekstrak pengetahuan domain morfologi.

Pengekod Masa

Pada masa yang sama, ia juga munasabah untuk menggunakan Transformer untuk memproses urutan masa. Pengekod temporal digunakan sebagai seni bina storan,

di mana o_t mewakili pemerhatian ejen pada masa t, Emb_0:t Mewakili pemasukan pemerhatian sejarah daripada pemerhatian awal kepada pemerhatian semasa.

Dalam kerja terdahulu, [Mishra et al 2018] tidak dapat memproses jujukan temporal menggunakan Transformer vanila dan mendapati ia berprestasi lebih teruk daripada dasar rawak pada beberapa tugas tertentu. Gated Transformer-XL (GTrXL) [Parisotto et al., 2020] ialah penyelesaian cekap pertama untuk menggunakan Transformer sebagai seni bina storan untuk memproses trajektori. GTrXL mengubah suai seni bina Transformer-XL [Dai et al., 2019] melalui Penyusunan Semula Peta Identiti untuk menyediakan laluan "langkau" daripada input berjujukan kepada output Transformer, yang mungkin membantu membentuk proses latihan yang stabil dari awal. [Loynd et al. 2020] mencadangkan mekanisme pintasan vektor memori untuk kebergantungan jangka panjang, dan [Irie et al 2021] menggabungkan Transformer linear dengan Fast Weight Programmer untuk prestasi yang lebih baik. [Melo 2022] mencadangkan menggunakan mekanisme perhatian kendiri untuk mensimulasikan pemulihan storan untuk meta-RL berasaskan storan.

Walaupun Transformer berprestasi lebih baik daripada LSTM/RNN apabila storan berkembang dan saiz parameter bertambah, ia bukan data yang cekap pada RL. Kerja seterusnya mengeksploitasi beberapa tugas penyeliaan diri tambahan untuk memudahkan pembelajaran [Banino et al., 2021] atau menggunakan seni bina Transformer yang telah terlatih sebagai pengekod temporal [Li et al., 2022].

Transformer untuk pembelajaran model

Selain menggunakan Transformer sebagai pengekod untuk pembenaman jujukan, seni bina Transformer juga Sebagai tulang belakang model persekitaran dalam algoritma berasaskan model. Tidak seperti ramalan yang dikondisikan pada pemerhatian dan tindakan satu langkah, Transformers membolehkan model persekitaran meramalkan peralihan yang dikondisikan pada panjang tertentu maklumat sejarah.

Malah, kejayaan Dreamer dan algoritma seterusnya [Hafner et al., 2020, 2021; ingatan Kelebihan model dunia berdasarkan maklumat sejarah ditunjukkan dalam tugas mekanisme. Model dunia yang dikondisikan pada maklumat sejarah terdiri daripada pengekod pemerhatian yang menangkap maklumat abstrak dan model transformasi yang mempelajari transformasi dalam ruang terpendam.

Terdapat kajian menggunakan seni bina Transformer dan bukannya RNN untuk membina model dunia berasaskan sejarah. [Chen et al. 2022] Gantikan Model Recurrent State-Space (RSSM) berasaskan RNN dalam Dreamer dengan model berasaskan Transformer TSSM (Transformer State-Space Model). IRIS (Imagination with autoRegression over an Inner Speech) [Micheli et al., 2022] mempelajari model dunia berasaskan Transformer melalui pembelajaran autoregresif pengalaman pelancaran tanpa pengimbangan KL seperti Dreamer, dan dilaksanakan dalam Atari [Bellemare et al., 2013] dan mencapai keputusan yang baik.

Selain itu, terdapat juga kajian yang cuba menggunakan model dunia berasaskan Transformer untuk perancangan. [Ozair et al. 2021] mengesahkan keberkesanan perancangan menggunakan model transformasi Transformer untuk menyelesaikan tugasan stokastik. [Sun et al. 2022] mencadangkan model transformasi Transformer bersyarat sasaran, yang berkesan dalam perancangan tugas prosedural berasaskan visual.

Kedua-dua RNN dan Transformer sesuai untuk mempelajari model dunia berdasarkan maklumat sejarah. Walau bagaimanapun, [Micheli et al 2022] mendapati bahawa seni bina Transformer adalah model dunia yang lebih cekap data berbanding dengan Dreamer. Keputusan eksperimen pada TSSM menunjukkan bahawa seni bina Transformer berfungsi dengan baik dalam tugas yang memerlukan ingatan jangka panjang.

Transformer untuk membuat keputusan berurutan

Selain disepadukan ke dalam algoritma RL tradisional sebagai prestasi tinggi seni bina, Transformer Ia juga boleh digunakan secara langsung sebagai model membuat keputusan berurutan. Ini kerana RL boleh dilihat sebagai masalah pemodelan jujukan bersyarat: menjana urutan tindakan yang menghasilkan ganjaran yang tinggi.

Memandangkan ketepatan Transformer dalam ramalan jujukan yang sangat baik, Bootstrapped Transformer (BooT) [Wang et al., 2022 ] dicadangkan untuk menjana data melalui Bootstrap Transformer, sambil mengoptimumkan data untuk membuat keputusan berurutan. Bootstrapping Transformer untuk penambahan data boleh mengembangkan bilangan dan liputan set data luar talian, dengan itu meningkatkan prestasi. Secara khusus, BooT membandingkan skema penjanaan data dan skema bootstrap yang berbeza untuk menganalisis cara BooT memudahkan pembelajaran dasar. Keputusan menunjukkan bahawa ia boleh menjana data yang konsisten dengan MDP asas tanpa kekangan tambahan.

Transformer untuk ejen universal

Decision Transformer telah memainkan peranan yang besar dalam pelbagai tugasan pada data luar talian Sesetengah penyelidik telah mula mempertimbangkan sama ada Transformer boleh membenarkan ejen am menyelesaikan pelbagai tugas atau masalah seperti dalam medan CV dan NLP.

Generalkan kepada pelbagai tugas

Sesetengah penyelidik menggunakan CV dan NLP Ideanya ialah untuk pra-melatih set data berskala besar dan cuba mengabstrak strategi umum daripada set data berbilang tugas berskala besar. Multi-Game Decision Transformer (MGDT) [Lee et al., 2022] ialah varian DT yang mempelajari DT pada set data pelbagai yang terdiri daripada data pakar dan bukan pakar, dan menggunakan set parameter untuk Mencapai prestasi hampir manusia pada Permainan Atari. Untuk mendapatkan prestasi peringkat pakar pada set data bukan peringkat pakar, MGDT mereka bentuk mekanisme penaakulan tindakan pakar untuk mengira pengedaran posterior return-to-go peringkat pakar daripada pengedaran terdahulu return-to-go dan mengiranya mengikut kepada formula Bayesian Kebarangkalian kembali-untuk-pergi pakar lalai.

Begitu juga, Transformer Trajektori Suis (SwitchTT) [Lin et al., 2022] ialah lanjutan TT berbilang tugas, menggunakan model pengaktifan jarang untuk menggantikan lapisan FFN dengan hibrid lapisan pakar untuk Mencapai pembelajaran luar talian berbilang tugas yang cekap. Selain itu, SwitchTT menggunakan penganggar nilai trajektori teragih untuk memodelkan ketidakpastian anggaran nilai. Bergantung pada dua peningkatan ini, SwitchTT jauh lebih baik daripada TT dari segi prestasi dan kelajuan latihan. Pengalaman memanfaatkan MGDT dan SwitchTT dikumpulkan daripada pelbagai tugas dan pelbagai dasar peringkat prestasi untuk mempelajari dasar am. Walau bagaimanapun, membina set data berbilang tugas berskala besar bukanlah perkara remeh.

Tidak seperti set data berskala besar dalam CV dan NLP, yang biasanya menggunakan data besar-besaran daripada Internet dan pelabelan manual yang mudah, data membuat keputusan berurutan dalam RL sentiasa kekurangan maklumat tindakan dan tidak mudah ditanda. Oleh itu, [Baker et al. 2022] mencadangkan skim separa diselia untuk mempelajari model dinamik songsang (IDM) berasaskan Transformer menggunakan data dalam talian berskala besar tanpa maklumat tindakan. Model ini memanfaatkan pemerhatian masa lalu dan masa depan untuk meramalkan maklumat tindakan dan mampu melabelkan sejumlah besar data video dalam talian. IDM dipelajari pada set data kecil yang mengandungi tindakan berlabel manual dan cukup tepat.

Banyak karya sedia ada dalam NLP telah membuktikan keberkesanan gesaan dalam menyesuaikan diri dengan tugasan baharu, dan sesetengah kerja menggunakan teknologi segera berdasarkan kaedah DT untuk mencapai penyesuaian pantas. Transformer Keputusan berasaskan Prompt (Prompt-DT) [Xu et al., 2022] sampel siri transformasi sebagai gesaan daripada set data tunjuk cara beberapa pukulan dan umumkan strategi beberapa pukulan kepada tugas meta-RL luar talian. [Reed et al. 2022] memanfaatkan lagi seni bina berasaskan segera untuk mempelajari agen am (Gato) melalui pemodelan jujukan autoregresif pada set data berskala sangat besar yang meliputi bahasa semula jadi, imej, pembuatan keputusan temporal dan data berbilang modal. Gato mampu melaksanakan pelbagai tugas daripada domain yang berbeza, termasuk penjanaan teks dan membuat keputusan.

[Laskin et al. 2022] mencadangkan Penyulingan Algoritma (AD) untuk melatih Transformer pada urutan merentas episod proses pembelajaran algoritma RL tugasan tunggal. Oleh itu, walaupun dalam tugasan baharu, Transformer boleh belajar untuk memperbaiki dasarnya secara beransur-ansur semasa proses penjanaan autoregresif.

Generalkan kepada julat yang lebih luas bidang

Selain membuat generalisasi kepada pelbagai tugas , Transformer juga merupakan model "universal" yang berkuasa yang boleh digunakan dalam pelbagai domain yang berkaitan dengan membuat keputusan berurutan. Diilhamkan oleh teknologi pemodelan bahasa bertopeng [Devlin et al., 2018] dalam NLP, [Carroll et al 2022] mencadangkan Uni [MASK], yang menyatukan pelbagai bidang penyelidikan yang biasa digunakan ke dalam Masalah penaakulan topeng termasuk pengklonan tingkah laku, RL luar talian, GCRL. , penaakulan masa lalu/masa hadapan dan ramalan dinamik. Uni [MASK] membandingkan skema topeng yang berbeza, termasuk topeng khusus tugasan, topeng rawak dan varian diperhalusi. Keputusan menunjukkan bahawa Transformer tunggal yang dilatih dengan topeng rawak boleh menyelesaikan tugas inferens sewenang-wenangnya.

Selain itu, [Reid et al. 2022] mendapati bahawa penalaan halus menggunakan Transformer yang telah dilatih pada set data bahasa atau set data berbilang modal yang mengandungi modaliti bahasa bermanfaat. Ini menunjukkan bahawa walaupun pengetahuan daripada domain bukan RL boleh digunakan untuk latihan RL melalui transformer.

Pembaca yang berminat boleh membaca teks asal kertas untuk mengetahui lebih lanjut butiran penyelidikan.

Atas ialah kandungan terperinci Sejauh manakah Transformer telah berkembang dalam pembelajaran pengukuhan? Universiti Tsinghua, Universiti Peking dan lain-lain bersama-sama mengeluarkan ulasan TransformRL. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1376

1376

52

52

Geospatial Laravel: Pengoptimuman peta interaktif dan sejumlah besar data

Apr 08, 2025 pm 12:24 PM

Geospatial Laravel: Pengoptimuman peta interaktif dan sejumlah besar data

Apr 08, 2025 pm 12:24 PM

Cecair memproses 7 juta rekod dan membuat peta interaktif dengan teknologi geospatial. Artikel ini meneroka cara memproses lebih dari 7 juta rekod menggunakan Laravel dan MySQL dan mengubahnya menjadi visualisasi peta interaktif. Keperluan Projek Cabaran Awal: Ekstrak Wawasan berharga menggunakan 7 juta rekod dalam pangkalan data MySQL. Ramai orang mula -mula mempertimbangkan bahasa pengaturcaraan, tetapi mengabaikan pangkalan data itu sendiri: Bolehkah ia memenuhi keperluan? Adakah penghijrahan data atau pelarasan struktur diperlukan? Bolehkah MySQL menahan beban data yang besar? Analisis awal: Penapis utama dan sifat perlu dikenalpasti. Selepas analisis, didapati bahawa hanya beberapa atribut yang berkaitan dengan penyelesaiannya. Kami mengesahkan kemungkinan penapis dan menetapkan beberapa sekatan untuk mengoptimumkan carian. Carian Peta Berdasarkan Bandar

Cara menyelesaikan MySQL tidak dapat dimulakan

Apr 08, 2025 pm 02:21 PM

Cara menyelesaikan MySQL tidak dapat dimulakan

Apr 08, 2025 pm 02:21 PM

Terdapat banyak sebab mengapa permulaan MySQL gagal, dan ia boleh didiagnosis dengan memeriksa log ralat. Penyebab umum termasuk konflik pelabuhan (periksa penghunian pelabuhan dan ubah suai konfigurasi), isu kebenaran (periksa keizinan pengguna yang menjalankan perkhidmatan), ralat fail konfigurasi (periksa tetapan parameter), rasuah direktori data (memulihkan data atau membina semula ruang meja), isu ruang jadual InnoDB (semak fail ibdata1) Apabila menyelesaikan masalah, anda harus menganalisisnya berdasarkan log ralat, cari punca utama masalah, dan mengembangkan tabiat sandaran data secara teratur untuk mencegah dan menyelesaikan masalah.

Cara Menggunakan MySQL Selepas Pemasangan

Apr 08, 2025 am 11:48 AM

Cara Menggunakan MySQL Selepas Pemasangan

Apr 08, 2025 am 11:48 AM

Artikel ini memperkenalkan operasi pangkalan data MySQL. Pertama, anda perlu memasang klien MySQL, seperti MySqlworkbench atau Command Line Client. 1. Gunakan perintah MySQL-Uroot-P untuk menyambung ke pelayan dan log masuk dengan kata laluan akaun root; 2. Gunakan CreateTatabase untuk membuat pangkalan data, dan gunakan Pilih pangkalan data; 3. Gunakan createtable untuk membuat jadual, menentukan medan dan jenis data; 4. Gunakan InsertInto untuk memasukkan data, data pertanyaan, kemas kini data dengan kemas kini, dan padam data dengan padam. Hanya dengan menguasai langkah -langkah ini, belajar menangani masalah biasa dan mengoptimumkan prestasi pangkalan data anda boleh menggunakan MySQL dengan cekap.

Memahami sifat asid: tiang pangkalan data yang boleh dipercayai

Apr 08, 2025 pm 06:33 PM

Memahami sifat asid: tiang pangkalan data yang boleh dipercayai

Apr 08, 2025 pm 06:33 PM

Penjelasan terperinci mengenai atribut asid asid pangkalan data adalah satu set peraturan untuk memastikan kebolehpercayaan dan konsistensi urus niaga pangkalan data. Mereka menentukan bagaimana sistem pangkalan data mengendalikan urus niaga, dan memastikan integriti dan ketepatan data walaupun dalam hal kemalangan sistem, gangguan kuasa, atau pelbagai pengguna akses serentak. Gambaran keseluruhan atribut asid Atomicity: Transaksi dianggap sebagai unit yang tidak dapat dipisahkan. Mana -mana bahagian gagal, keseluruhan transaksi dilancarkan kembali, dan pangkalan data tidak mengekalkan sebarang perubahan. Sebagai contoh, jika pemindahan bank ditolak dari satu akaun tetapi tidak meningkat kepada yang lain, keseluruhan operasi dibatalkan. Begintransaction; UpdateAcCountSsetBalance = Balance-100Wh

Jurutera Backend Senior Remote (Platform) memerlukan kalangan

Apr 08, 2025 pm 12:27 PM

Jurutera Backend Senior Remote (Platform) memerlukan kalangan

Apr 08, 2025 pm 12:27 PM

Jurutera Backend Senior Remote Company Kekosongan Syarikat: Lokasi Lokasi: Jauh Pejabat Jauh Jenis: Gaji sepenuh masa: $ 130,000- $ 140,000 Penerangan Pekerjaan Mengambil bahagian dalam penyelidikan dan pembangunan aplikasi mudah alih Circle dan ciri-ciri berkaitan API awam yang meliputi keseluruhan kitaran hayat pembangunan perisian. Tanggungjawab utama kerja pembangunan secara bebas berdasarkan rubyonrails dan bekerjasama dengan pasukan react/redux/relay front-end. Membina fungsi teras dan penambahbaikan untuk aplikasi web dan bekerjasama rapat dengan pereka dan kepimpinan sepanjang proses reka bentuk berfungsi. Menggalakkan proses pembangunan positif dan mengutamakan kelajuan lelaran. Memerlukan lebih daripada 6 tahun backend aplikasi web kompleks

Bolehkah mysql kembali json

Apr 08, 2025 pm 03:09 PM

Bolehkah mysql kembali json

Apr 08, 2025 pm 03:09 PM

MySQL boleh mengembalikan data JSON. Fungsi JSON_EXTRACT mengekstrak nilai medan. Untuk pertanyaan yang kompleks, pertimbangkan untuk menggunakan klausa WHERE untuk menapis data JSON, tetapi perhatikan kesan prestasinya. Sokongan MySQL untuk JSON sentiasa meningkat, dan disyorkan untuk memberi perhatian kepada versi dan ciri terkini.

Mysql tidak dapat dipasang setelah memuat turun

Apr 08, 2025 am 11:24 AM

Mysql tidak dapat dipasang setelah memuat turun

Apr 08, 2025 am 11:24 AM

Sebab utama kegagalan pemasangan MySQL adalah: 1. Isu kebenaran, anda perlu menjalankan sebagai pentadbir atau menggunakan perintah sudo; 2. Ketergantungan hilang, dan anda perlu memasang pakej pembangunan yang relevan; 3. Konflik pelabuhan, anda perlu menutup program yang menduduki port 3306 atau mengubah suai fail konfigurasi; 4. Pakej pemasangan adalah korup, anda perlu memuat turun dan mengesahkan integriti; 5. Pembolehubah persekitaran dikonfigurasikan dengan salah, dan pembolehubah persekitaran mesti dikonfigurasi dengan betul mengikut sistem operasi. Selesaikan masalah ini dan periksa dengan teliti setiap langkah untuk berjaya memasang MySQL.

Klausa had SQL Master: Kawal bilangan baris dalam pertanyaan

Apr 08, 2025 pm 07:00 PM

Klausa had SQL Master: Kawal bilangan baris dalam pertanyaan

Apr 08, 2025 pm 07:00 PM

Klausa SQLLIMIT: Kawal bilangan baris dalam hasil pertanyaan. Klausa had dalam SQL digunakan untuk mengehadkan bilangan baris yang dikembalikan oleh pertanyaan. Ini sangat berguna apabila memproses set data yang besar, paparan paginat dan data ujian, dan dapat meningkatkan kecekapan pertanyaan dengan berkesan. Sintaks Asas Sintaks: SelectColumn1, Column2, ... FROMTABLE_NAMELIMITNUMBER_OF_ROWS; Number_of_rows: Tentukan bilangan baris yang dikembalikan. Sintaks dengan Offset: SelectColumn1, Column2, ... Fromtable_namelimitoffset, Number_of_rows; Offset: Langkau