Penurunan transformer untuk ramalan siri masa dan peningkatan kaedah pembenaman siri masa, serta kemajuan dalam pengesanan dan pengelasan anomali

Seluruh bidang telah mencapai kemajuan dalam beberapa aspek berbeza pada tahun 2022. Artikel ini akan Cuba merangkumi beberapa kertas kerja yang lebih menjanjikan dan penting yang telah muncul pada tahun lalu atau lebih, serta rangka kerja ramalan Ramalan Aliran [FF].

https://www.php.cn/link/bf4d73f316737b26f1e860da0ea63ec8

Penyelidikan berkaitan Transformer membandingkan Autoformer, Pyraformer, Fedformer, dsb., kesan dan masalahnya

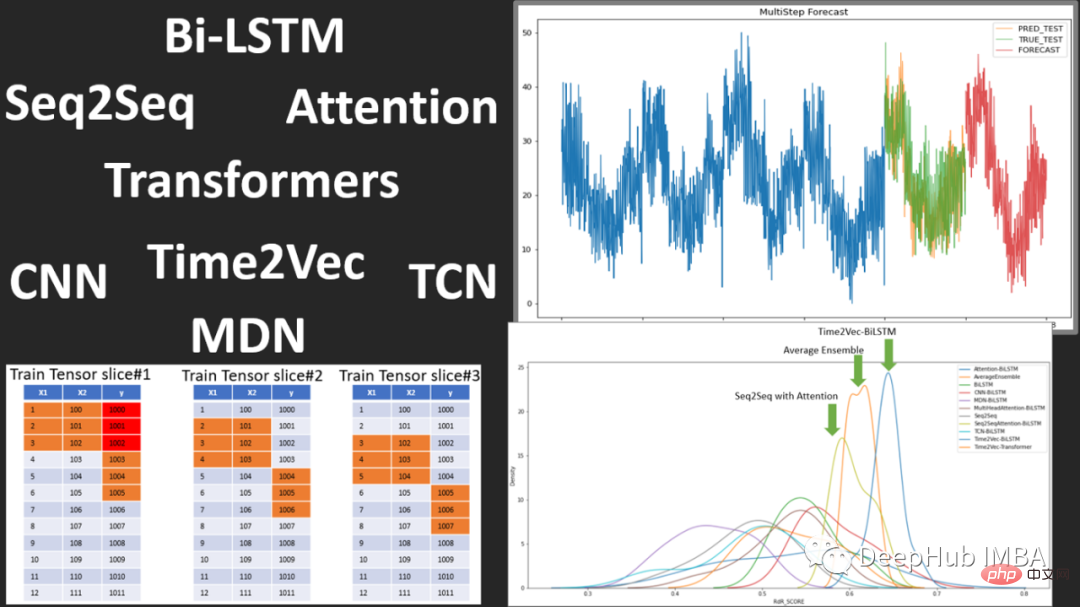

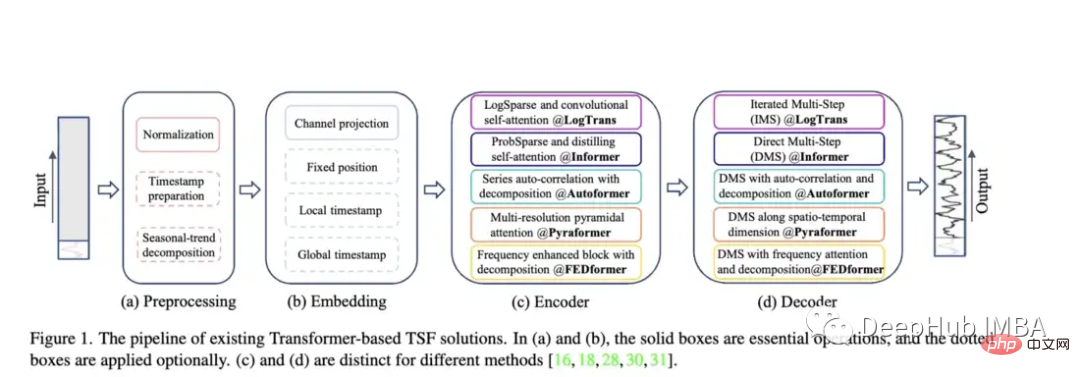

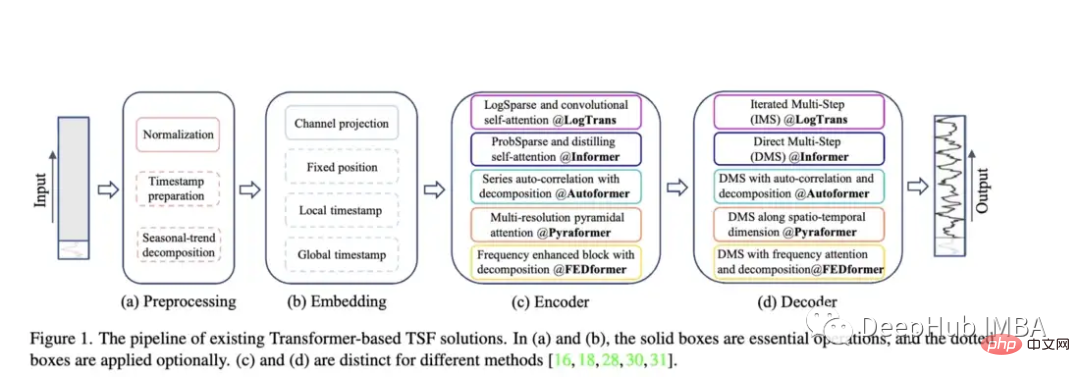

Dengan kemunculan model seperti Autoformer (Neurips 2021), Pyraformer (ICLR 2022), Fedformer (ICML 2022), EarthFormer (Neurips 2022) dan Non-Stationary Transformer (Neurips siri masa Keluarga Transformer bagi seni bina ramalan terus berkembang). Tetapi keupayaan model ini untuk meramal data dengan tepat dan mengatasi kaedah sedia ada masih menjadi persoalan, terutamanya berdasarkan penyelidikan baharu (yang akan kita bincangkan kemudian).

Dengan kemunculan model seperti Autoformer (Neurips 2021), Pyraformer (ICLR 2022), Fedformer (ICML 2022), EarthFormer (Neurips 2022) dan Non-Stationary Transformer (Neurips siri masa Keluarga Transformer bagi seni bina ramalan terus berkembang). Tetapi keupayaan model ini untuk meramal data dengan tepat dan mengatasi kaedah sedia ada masih menjadi persoalan, terutamanya berdasarkan penyelidikan baharu (yang akan kita bincangkan kemudian).

Autoformer: Dilanjutkan dan dipertingkatkan prestasi model Informer. Autoformer menampilkan mekanisme korelasi automatik yang membolehkan model mempelajari kebergantungan temporal lebih baik daripada perhatian standard. Ia bertujuan untuk menguraikan trend dan komponen bermusim data temporal dengan tepat.

Pyraformer: Pengarang memperkenalkan "Pyramid Attention Module (PAM), di mana struktur pokok antara skala meringkaskan ciri pada resolusi yang berbeza, dan intra-skala bersebelahan sambungan memasangkan julat yang berbeza Memodelkan pergantungan masa bagi ”

Pyraformer: Pengarang memperkenalkan "Pyramid Attention Module (PAM), di mana struktur pokok antara skala meringkaskan ciri pada resolusi yang berbeza, dan intra-skala bersebelahan sambungan memasangkan julat yang berbeza Memodelkan pergantungan masa bagi ”

Fedformer: Model ini memfokuskan pada menangkap arah aliran global dalam data siri masa. Penulis mencadangkan modul penguraian trend bermusim yang direka untuk menangkap ciri global siri masa.

Earthformer: Mungkin yang paling unik daripada kertas ini, ia tertumpu secara khusus pada meramal sistem Bumi seperti cuaca, iklim dan pertanian. Seni bina perhatian kuboid baharu diperkenalkan. Makalah ini sepatutnya mempunyai potensi yang besar, kerana banyak Transformer klasik telah gagal dalam penyelidikan mengenai ramalan sungai dan banjir kilat.

Pengubah Bukan Pegun: Ini adalah kertas terbaharu menggunakan pengubah untuk ramalan. Penulis bertujuan untuk menala Transformer dengan lebih baik untuk mengendalikan siri masa tidak pegun. Mereka menggunakan dua mekanisme: perhatian yang tidak stabil dan satu siri mekanisme penstabilan. Mekanisme ini boleh dipalamkan ke dalam mana-mana model Transformer sedia ada, dan penulis telah menguji memasukkannya ke dalam Informer, Autoformer dan Transformer tradisional untuk meningkatkan prestasi (dalam lampiran, ia juga menunjukkan bahawa ia boleh meningkatkan prestasi Fedformer).

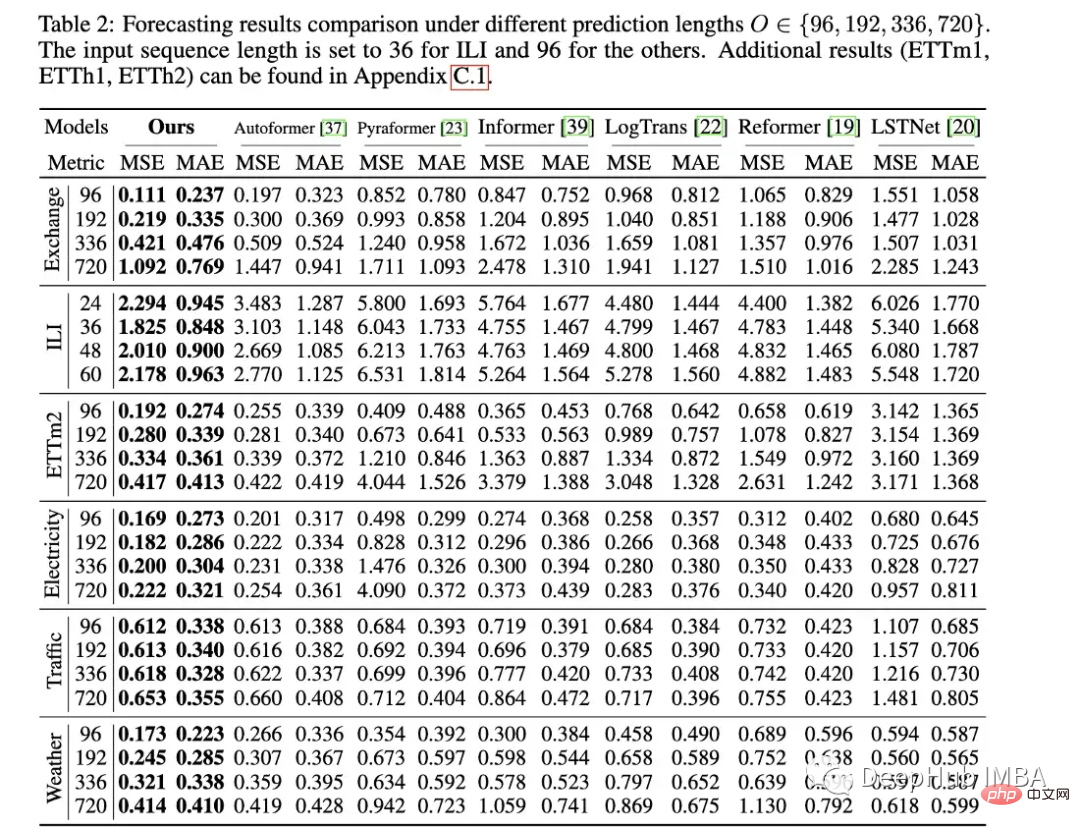

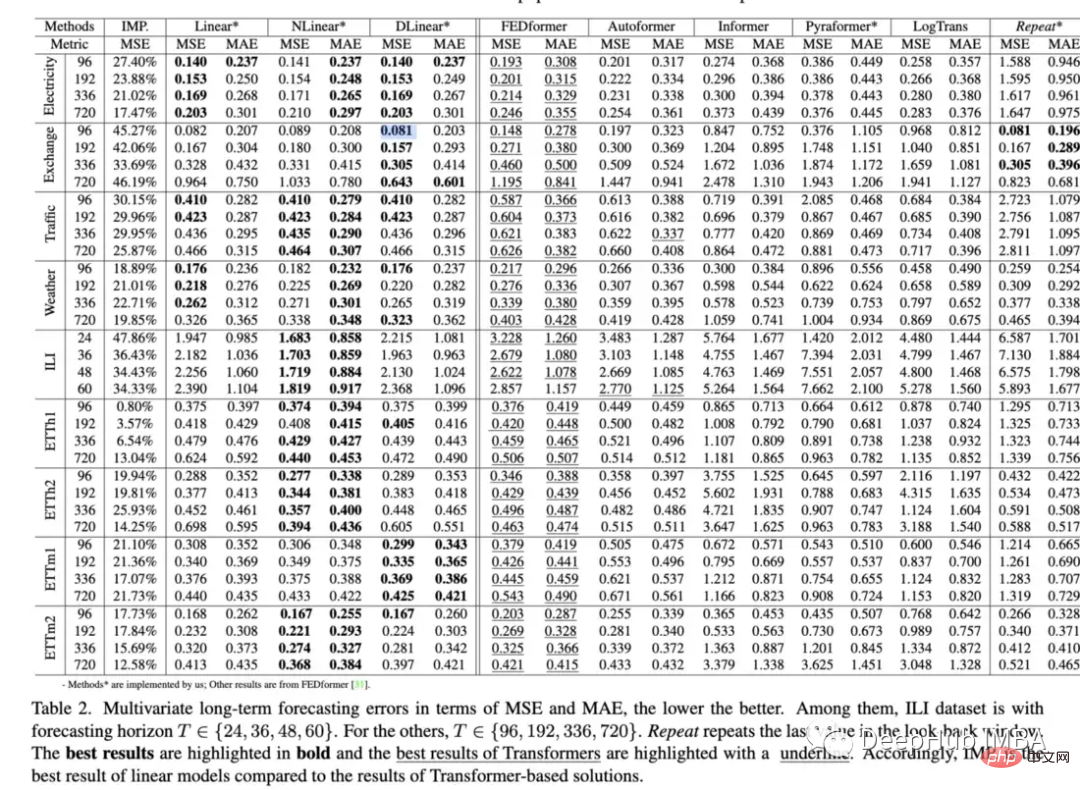

Metodologi penilaian kertas kerja: Sama seperti Informer, semua model ini (kecuali Earthformer) dinilai pada set data elektrik, pengangkutan, kewangan dan cuaca. Dinilai terutamanya berdasarkan penunjuk ralat min kuasa dua (MSE) dan ralat mutlak min (MAE):

Kertas ini sangat bagus, tetapi ia hanya membandingkan kertas berkaitan Transformer. Malah, ia harus dibandingkan dengan kaedah yang lebih mudah, seperti regresi linear mudah, LSTM/GRU, atau juga model pokok seperti XGB. Perkara lain ialah mereka tidak sepatutnya terhad kepada beberapa set data standard, kerana saya tidak melihat prestasi yang baik pada set data berkaitan siri masa yang lain. Sebagai contoh, pemberi maklumat mempunyai masalah besar dengan tepat meramalkan aliran sungai, dan prestasi mereka selalunya lemah berbanding dengan LSTM atau Transformer biasa.

Kertas ini sangat bagus, tetapi ia hanya membandingkan kertas berkaitan Transformer. Malah, ia harus dibandingkan dengan kaedah yang lebih mudah, seperti regresi linear mudah, LSTM/GRU, atau juga model pokok seperti XGB. Perkara lain ialah mereka tidak sepatutnya terhad kepada beberapa set data standard, kerana saya tidak melihat prestasi yang baik pada set data berkaitan siri masa yang lain. Sebagai contoh, pemberi maklumat mempunyai masalah besar dengan tepat meramalkan aliran sungai, dan prestasi mereka selalunya lemah berbanding dengan LSTM atau Transformer biasa.

Selain itu, kerana tidak seperti penglihatan komputer, dimensi imej kekal sekurang-kurangnya tetap, data siri masa boleh berbeza-beza dalam panjang, berkala, arah aliran dan kemusim, jadi julat set data yang lebih besar diperlukan.

Dalam semakan untuk Transformer Bukan Pegun OpenReview, seorang pengulas turut menyatakan isu ini, tetapi ia telah ditolak undian dalam semakan meta akhir:

“Memandangkan model itu tergolong dalam medan Transformer dan Transformer sebelum ini telah menunjukkan prestasi terkini dalam banyak tugas, saya rasa tidak perlu dibandingkan dengan kaedah 'keluarga' yang lain ”

Ini adalah hujah yang sangat bermasalah, dan membawa kepada itu kurang kesesuaian dengan dunia sebenar. Seperti yang kita semua tahu: Kelebihan XGB yang luar biasa dalam data jadual tidak berubah, jadi apa gunanya Transformer bekerja di belakang pintu tertutup? Melebihi setiap masa dan dipukul setiap masa.

Sebagai seseorang yang menghargai kaedah terkini dan model inovatif dalam amalan, apabila saya menghabiskan masa berbulan-bulan mencuba untuk mendapatkan model yang dipanggil "baik" untuk berfungsi, akhirnya saya mendapati bahawa ia berjaya 't berprestasi sebaik Regresi linear mudah, apa gunanya beberapa bulan ini? Apa gunanya model yang dikatakan bagus ini?

Semua kertas transformer mengalami masalah penilaian terhad yang sama Kita harus menuntut perbandingan yang lebih ketat dan penjelasan yang jelas tentang kelemahan dari awal tidak selalunya mengatasi model mudah pada mulanya, tetapi ini perlu dinyatakan secara eksplisit dalam kertas, bukannya dikilat atau hanya menganggap bahawa ini tidak berlaku

Tetapi kertas itu masih bagus, mis set data MovingMNIST dan set data MNIST N-body, dan pengarang menggunakannya untuk mengesahkan keberkesanan perhatian kuboid dan menilai ramalan serta-merta pemendakan dan ramalan kitaran El Niño, saya fikir ia adalah satu contoh yang baik, menyepadukan pengetahuan fizikal ke dalam a seni bina model dengan perhatian, dan kemudian reka ujian yang baik

https://www.php.cn /link/bf4d73f316737b26f1e860da0ea63ec8

Makalah ini meneroka keupayaan Transformer untuk meramalkan data berbanding kaedah garis dasar. Keputusan ini sering kali mengesahkan bahawa Transformer berprestasi lebih teruk daripada model Transformer dan sukar untuk ditala. modul kompleks lain tidak diperlukan, sekurang-kurangnya untuk penanda aras LTSF sedia ada"

Artikel ini menilai prestasi model pada lima set data dunia nyata, termasuk Set Data Mesin Pelayan, Metrik Pelayan Terkumpul, Pasif Aktif Kelembapan Tanah dan NeurIPS-TS (yang sendiri terdiri daripada lima set data berbeza). Walaupun seseorang mungkin ragu-ragu dengan model ini, terutamanya mengenai sudut pandangan kertas kedua, penilaian ini agak ketat. Neurips-TS ialah set data yang dibuat baru-baru ini yang direka khusus untuk memberikan penilaian yang lebih teliti terhadap model pengesanan anomali. Model ini nampaknya meningkatkan prestasi berbanding model pengesanan anomali yang lebih mudah.

Pengarang mencadangkan Transformer tanpa pengawasan unik yang berprestasi baik pada kebanyakan set data pengesanan anomali. Ini adalah salah satu kertas kerja yang paling menjanjikan dalam bidang Transformers siri masa dalam beberapa tahun kebelakangan ini. Kerana ramalan adalah lebih mencabar daripada pengelasan atau pengesanan anomali kerana anda cuba meramalkan julat besar kemungkinan nilai beberapa langkah masa ke masa hadapan. Begitu banyak penyelidikan telah menumpukan pada ramalan, sambil mengabaikan pengelasan atau pengesanan anomali Patutkah kita mula mudah untuk Transformer?

https://www.php.cn/link/ae95296e27d7f695ff491cd >

Kertas kerja memperkenalkan bentuk regularisasi baharu yang boleh meningkatkan latihan model ramalan siri masa mendalam (terutama transformer yang dinyatakan di atas). Pengarang menilai dengan memasukkannya ke dalam model pengubah + LSTNet sedia ada. Mereka mendapati bahawa ia meningkatkan prestasi dengan ketara dalam kebanyakan kes. Walaupun mereka hanya menguji model Autoformer dan bukan model yang lebih baru seperti Fedformer. Bentuk penetapan atau kehilangan fungsi baharu sentiasa berguna kerana ia biasanya boleh dipalamkan ke dalam mana-mana model siri masa sedia ada. Jika anda menggabungkan Fedformer + mekanisme tidak pegun + Wavebound, anda mungkin mengalahkan regresi linear mudah dalam prestasi :). Perwakilan Siri MasaWalaupun Transformer tidak menunjukkan prestasi yang baik dalam arah ramalan, Transformer telah membuat banyak kemajuan dalam mencipta perwakilan siri masa yang berguna. Saya fikir ini adalah bidang baharu yang mengagumkan dalam bidang pembelajaran mendalam siri masa yang harus diterokai dengan lebih mendalam. 5. TS2Vec: Ke Arah Perwakilan Sejagat bagi Siri Masa (AAAI 2022)https://www.php.cn/link/7690dd4db7a92524c684e3191919>TS2Vec ialah rangka kerja umum untuk mempelajari perwakilan/pembenaman siri masa. Kertas itu sendiri agak ketinggalan zaman, tetapi ia telah memulakan trend kertas pembelajaran perwakilan siri masa.

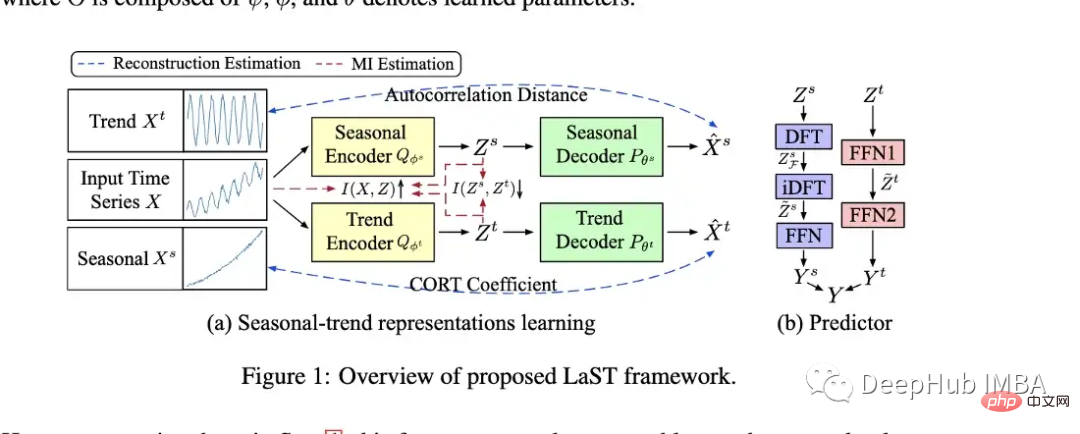

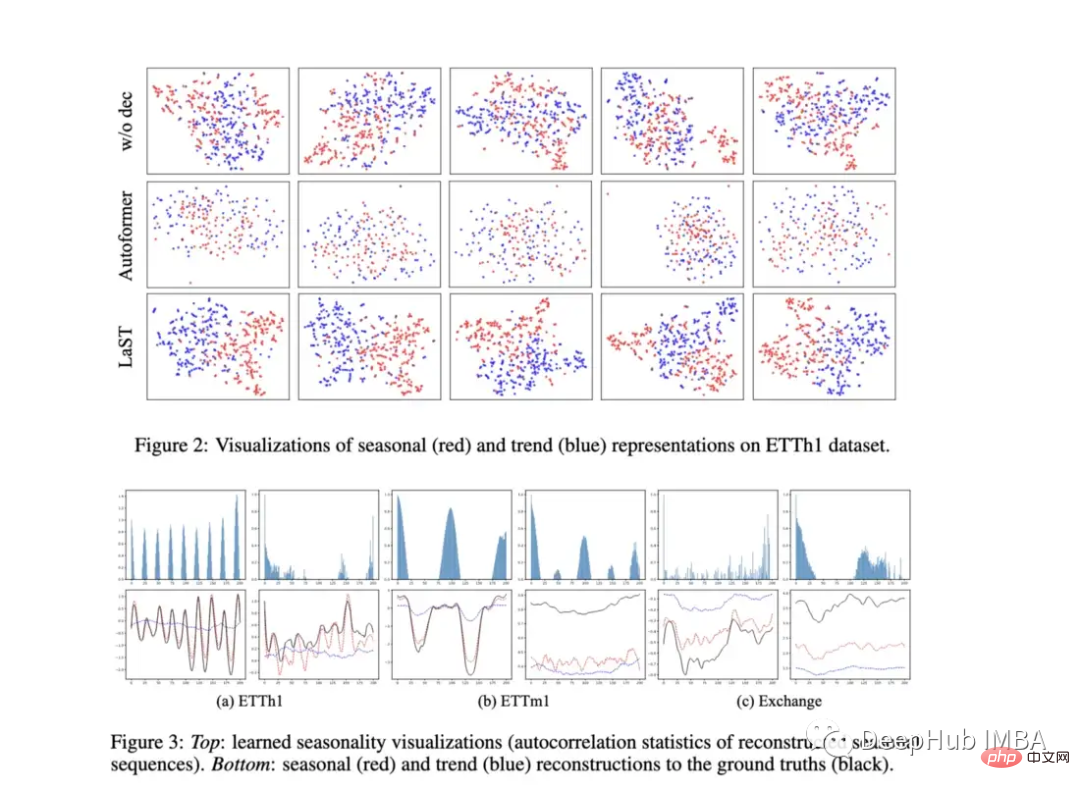

Menilai penggunaan perwakilan untuk ramalan dan pengesanan anomali, mengatasi prestasi banyak model seperti Informer dan Log Transformer. 6. Mempelajari Perwakilan Aliran Bermusim Terpendam untuk Ramalan Siri Masa(Neurips 2022) Pengarang menilai model mereka pada tugas ramalan hiliran, yang mereka lakukan dengan menambahkan peramal pada perwakilan (lihat B dalam rajah di atas). Mereka juga menyediakan plot yang menarik untuk menunjukkan visualisasi perwakilan. Model ini mengatasi Autoformer pada beberapa tugas ramalan serta TS2Vec dan kos. Ia juga kelihatan seperti ia mungkin berprestasi lebih baik daripada regresi linear mudah yang disebutkan di atas pada beberapa tugas ramalan.

Pengarang menilai model mereka pada tugas ramalan hiliran, yang mereka lakukan dengan menambahkan peramal pada perwakilan (lihat B dalam rajah di atas). Mereka juga menyediakan plot yang menarik untuk menunjukkan visualisasi perwakilan. Model ini mengatasi Autoformer pada beberapa tugas ramalan serta TS2Vec dan kos. Ia juga kelihatan seperti ia mungkin berprestasi lebih baik daripada regresi linear mudah yang disebutkan di atas pada beberapa tugas ramalan.

7. Kos: Pembelajaran Kontrastif Perwakilan Aliran Musim Bermusim untuk Ramalan Siri Masa (ICLR 2022)

7. Kos: Pembelajaran Kontrastif Perwakilan Aliran Musim Bermusim untuk Ramalan Siri Masa (ICLR 2022)

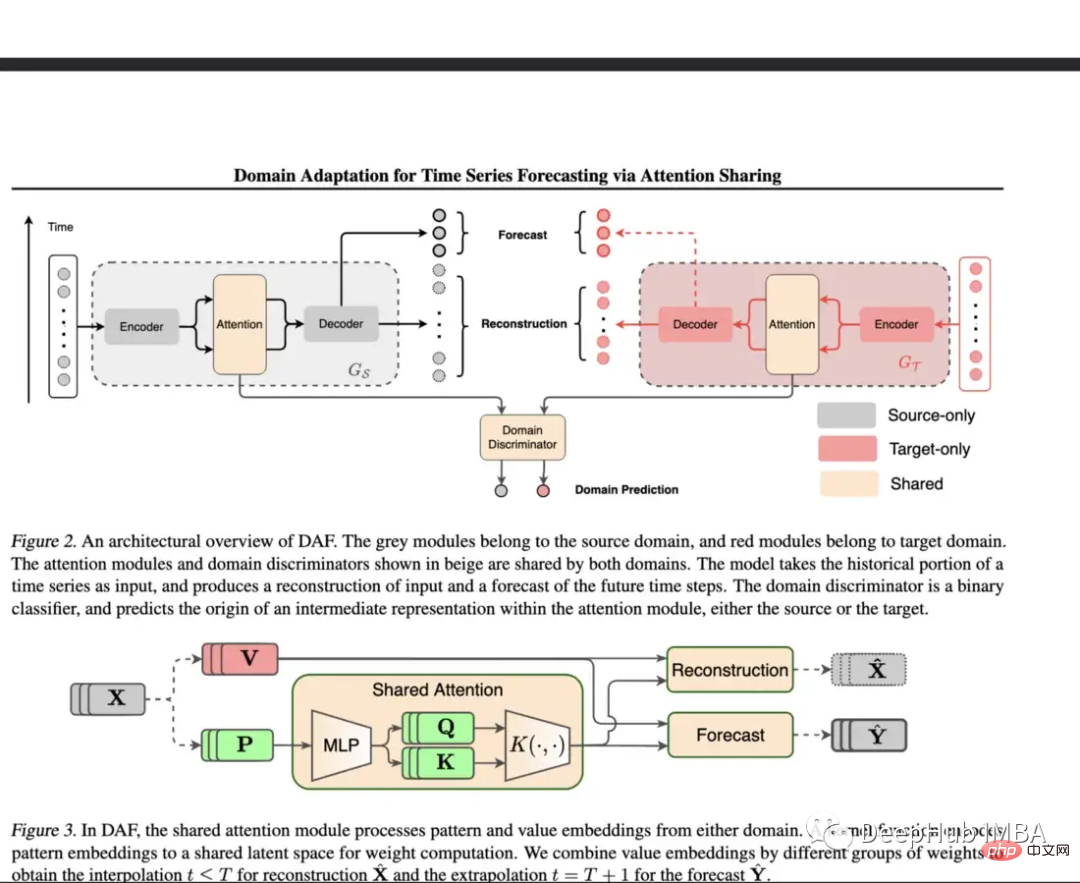

https://www.php.cn/link/791d3a0048b9c0708dced9c0708d Ini ialah kertas kerja yang diterbitkan di ICLR lebih awal pada tahun 2022, yang hampir sama dengan LaST dari segi pembelajaran perwakilan bermusim dan trend. Memandangkan LaST telah banyak menggantikan prestasinya, ia tidak akan diterangkan terlalu banyak di sini. Tetapi pautan di atas untuk mereka yang ingin membacanya. https://www.php.cn/link / d4ea5dacfff2d8a35c0952291779290d Ramalan merupakan cabaran untuk DNN apabila kekurangan data latihan. Kertas kerja ini menggunakan lapisan perhatian dikongsi untuk domain dengan data kaya, dan kemudian menggunakan modul berasingan untuk domain sasaran. Model yang dicadangkan dinilai menggunakan set data sintetik dan sebenar. Dalam persekitaran sintetik, pembelajaran permulaan dingin dan pembelajaran beberapa pukulan telah diuji dan model mereka didapati mengatasi prestasi Transformer biasa dan DeepAR. Untuk set data sebenar set data runcit Kaggle telah diterima pakai dan model tersebut mengatasi prestasi asas dengan ketara dalam eksperimen ini. Permulaan yang dingin, beberapa sampel dan pembelajaran terhingga merupakan topik yang sangat penting, tetapi beberapa kertas kerja membincangkan siri masa. Model ini menyediakan langkah penting ke arah menangani beberapa isu ini. Ini bermakna mereka boleh dinilai pada set data dunia nyata terhad yang lebih pelbagai dan dibandingkan dengan lebih banyak model garis dasar Faedah penalaan halus atau regularisasi ialah ia boleh dilaraskan untuk mana-mana seni bina. https://www.php.cn/link/f38fef4c0e4988792723d39a0b https://www.php.cn/link/5d7009220a974e94404889274d3a9553 https://www.php.cn/link/c3cbd51329ff1a0169174e9a78126ee1 https://www.php.cn/link/03793ef7d06ffd63d34ade9d091f1ced https://www.php.cn/link/fea33a31df7d05a276193d32621ecbe4 Tetapi untuk siri masa pembelajaran mendalam: kebolehtafsiran, visualisasi dan kaedah penanda aras masih kurang, kerana ia adalah sangat penting di mana model dilaksanakan dan di mana kegagalan prestasi berlaku. Selain itu, lebih banyak bentuk penyelarasan, prapemprosesan dan pemindahan pembelajaran untuk meningkatkan prestasi mungkin muncul pada masa hadapan. Mungkin Transformer bagus untuk ramalan siri masa (mungkin juga tidak seperti VIT, Transformer mungkin masih dianggap tidak berguna tanpa kemunculan Patch Kami juga akan terus memberi perhatian kepada pembangunan atau penggantian Transformer dalam siri masa. Kertas menarik lain

8 Penyesuaian Domain untuk Ramalan Siri Masa melalui Perkongsian Perhatian (ICML 2022)

9. Bila Perlu Campur Tangan: Mempelajari Dasar Intervensi Optimum untuk Peristiwa Kritikal (Neurips 2022)

Monash. Arkib Ramalan Siri Masa (Neurips 2021): Arkib ini bertujuan untuk membentuk "senarai induk" set data siri masa yang berbeza dan menyediakan penanda aras yang lebih berwibawa. Repositori mengandungi lebih 20 set data berbeza yang merangkumi pelbagai industri termasuk kesihatan, runcit, perkongsian tunggangan, demografi dan banyak lagi.

Atas ialah kandungan terperinci Semakan kemajuan penyelidikan pembelajaran mendalam dalam ramalan dan klasifikasi siri masa pada 2022. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

penggunaan fungsi pemformat

penggunaan fungsi pemformat

Bagaimana untuk menyelesaikan ralat yang tidak diketahui 11

Bagaimana untuk menyelesaikan ralat yang tidak diketahui 11

Win11 melangkau tutorial untuk log masuk ke akaun Microsoft

Win11 melangkau tutorial untuk log masuk ke akaun Microsoft

Kaedah pendaftaran akaun Google

Kaedah pendaftaran akaun Google

Perbezaan antara rantau semasa dan julat terpakai

Perbezaan antara rantau semasa dan julat terpakai

Bagaimana untuk menyelesaikan masalah bahawa pengurus peranti tidak boleh dibuka

Bagaimana untuk menyelesaikan masalah bahawa pengurus peranti tidak boleh dibuka

Bagaimana untuk bertukar antara sistem dwi Huawei

Bagaimana untuk bertukar antara sistem dwi Huawei

Bagaimana untuk menyelesaikan masalah skrin hitam selepas menghidupkan komputer dan tidak dapat memasuki desktop

Bagaimana untuk menyelesaikan masalah skrin hitam selepas menghidupkan komputer dan tidak dapat memasuki desktop