Peranti teknologi

Peranti teknologi

AI

AI

Dengan hanya kuasa pengkomputeran yang begitu banyak, bagaimana untuk meningkatkan prestasi model bahasa? Google mempunyai idea baharu

Dengan hanya kuasa pengkomputeran yang begitu banyak, bagaimana untuk meningkatkan prestasi model bahasa? Google mempunyai idea baharu

Dengan hanya kuasa pengkomputeran yang begitu banyak, bagaimana untuk meningkatkan prestasi model bahasa? Google mempunyai idea baharu

Dalam beberapa tahun kebelakangan ini, model bahasa (LM) telah menjadi lebih menonjol dalam penyelidikan pemprosesan bahasa semula jadi (NLP) dan menjadi semakin berpengaruh dalam amalan. Secara umum, meningkatkan saiz model telah ditunjukkan untuk meningkatkan prestasi merentas pelbagai tugasan NLP.

Walau bagaimanapun, cabaran untuk meningkatkan model juga jelas: melatih model baharu yang lebih besar memerlukan banyak sumber pengkomputeran. Di samping itu, model baru sering dilatih dari awal dan tidak boleh menggunakan berat latihan model sebelumnya.

Untuk masalah ini, penyelidik Google meneroka dua kaedah pelengkap untuk meningkatkan prestasi model bahasa sedia ada dengan ketara tanpa menggunakan banyak sumber pengkomputeran tambahan.

Pertama, dalam artikel "Melangkaui Undang-undang Penskalaan dengan 0.1% Pengiraan Tambahan", para penyelidik memperkenalkan UL2R, model pra-latihan peringkat kedua ringan yang menggunakan sasaran enoisers Campuran. UL2R meningkatkan prestasi pada pelbagai tugas, membuka kunci prestasi prestasi walaupun pada tugas yang sebelum ini mempunyai prestasi hampir rawak.

Pautan kertas: https://arxiv.org/pdf/2210.11399.pdf

Selain itu , Dalam "Menskalakan Model Bahasa Diperhalusi Arahan", kami meneroka masalah model bahasa penalaan halus pada set data yang mengandungi arahan, proses yang kami panggil "Flan". Pendekatan ini bukan sahaja meningkatkan prestasi tetapi juga meningkatkan kebolehgunaan model bahasa kepada input pengguna.

Pautan kertas: https://arxiv.org/abs/2210.11416

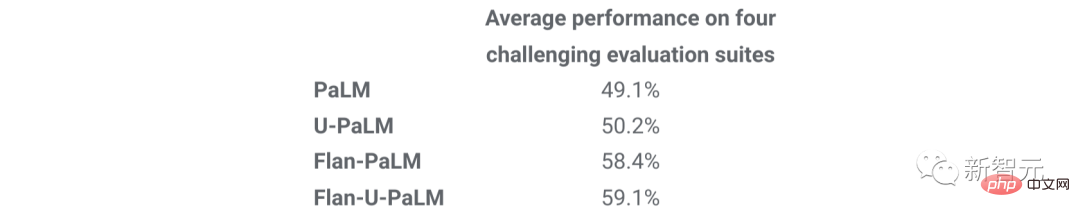

Akhir sekali, Flan dan UL2R boleh digabungkan sebagai teknologi pelengkap dalam model yang dipanggil Flan-U-PaLM 540B, yang mengatasi prestasi model PaLM 540B yang belum ditala pada julat penanda aras penilaian yang mencabar Prestasi adalah 10% lebih tinggi.

Latihan UL2R

Secara tradisinya, kebanyakan model bahasa dilatih terlebih dahulu mengenai matlamat pemodelan bahasa kausal untuk membolehkan model Meramalkan perkataan seterusnya dalam urutan (seperti GPT-3 atau PaLM) atau menolak matlamat, di mana model belajar memulihkan ayat asal daripada urutan perkataan yang rosak (seperti T5).

Walaupun terdapat beberapa pertukaran dalam objektif pemodelan bahasa, iaitu, model bahasa kausal berprestasi lebih baik pada penjanaan ayat panjang, manakala model bahasa yang dilatih pada objektif denoising berprestasi lebih baik pada denoising- aspek penalaan berprestasi lebih baik, tetapi dalam kerja sebelumnya, penyelidik menunjukkan bahawa objektif enoisers hibrid yang merangkumi kedua-dua objektif mencapai prestasi yang lebih baik dalam kedua-dua kes.

Walau bagaimanapun, pra-latihan model bahasa besar dari awal pada sasaran yang berbeza adalah sukar dari segi pengiraan. Oleh itu, kami mencadangkan pembaikan UL2 (UL2R), peringkat tambahan yang meneruskan pra-latihan dengan sasaran UL2 dan hanya memerlukan jumlah pengiraan yang agak kecil.

Kami menggunakan UL2R pada PaLM dan memanggil model bahasa baharu yang terhasil U-PaLM.

Dalam penilaian empirikal kami, kami mendapati bahawa dengan hanya sedikit latihan UL2, model itu bertambah baik dengan ketara.

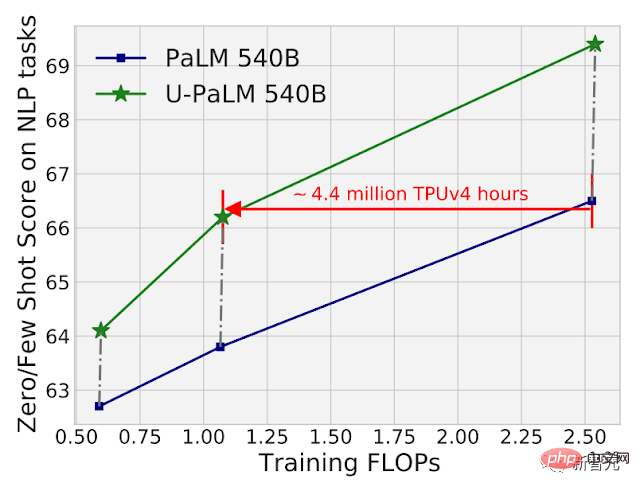

Contohnya, dengan menggunakan UL2R pada pusat pemeriksaan perantaraan PaLM 540B, prestasi PaLM 540B pada pusat pemeriksaan akhir boleh dicapai sambil menggunakan 2 kali usaha pengiraan. Sudah tentu, penggunaan UL2R pada pusat pemeriksaan PaLM 540B terakhir juga akan membawa peningkatan yang besar.

Perbandingan pengiraan dan prestasi model PaLM 540B dan U-PaLM 540B pada 26 penanda aras NLP. U-PaLM 540B terus melatih PaLM, dengan jumlah pengiraan yang sangat kecil tetapi peningkatan prestasi yang hebat.

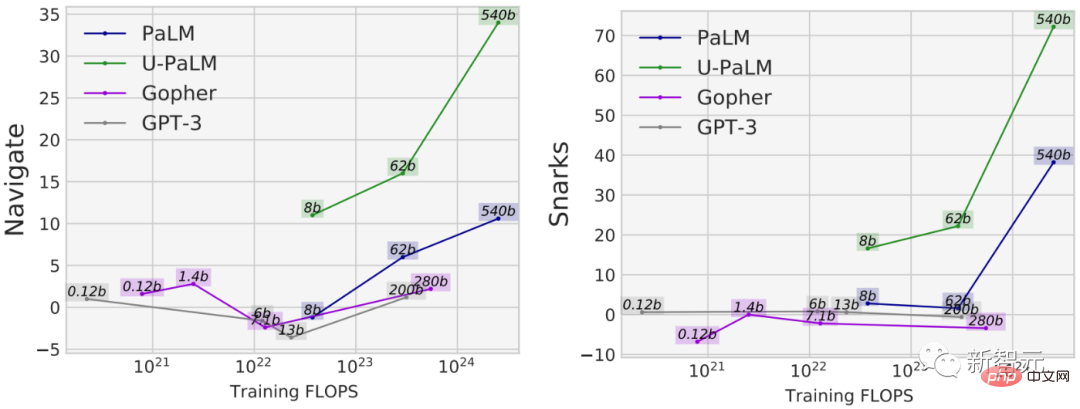

Faedah lain menggunakan UL2R ialah ia berprestasi lebih baik pada sesetengah tugas berbanding model yang dilatih semata-mata pada matlamat pemodelan bahasa sebab-akibat. Sebagai contoh, terdapat banyak tugasan BIG-Bench dengan apa yang dipanggil "keupayaan muncul", yang merupakan keupayaan yang hanya tersedia dalam model bahasa yang cukup besar.

Walaupun cara paling biasa untuk menemui keupayaan yang baru muncul ialah dengan meningkatkan model, UL2R sebenarnya boleh memberi inspirasi kepada keupayaan yang muncul tanpa meningkatkan model.

Sebagai contoh, dalam tugas navigasi BIG-Bench, yang mengukur keupayaan model untuk melaksanakan pengesanan keadaan, semua model kecuali U-PaLM mempunyai kurang latihan FLOP Pada 10^23. Contoh lain ialah tugas Snarks BIG-Bench, yang mengukur keupayaan model untuk mengesan bahasa sarkastik.

Untuk kedua-dua keupayaan daripada BIG-Bench, prestasi tugas yang muncul ditunjukkan, U-PaLM mencapai prestasi yang muncul pada saiz model yang lebih kecil disebabkan penggunaan sasaran UL2R .

Penalaan halus arahan

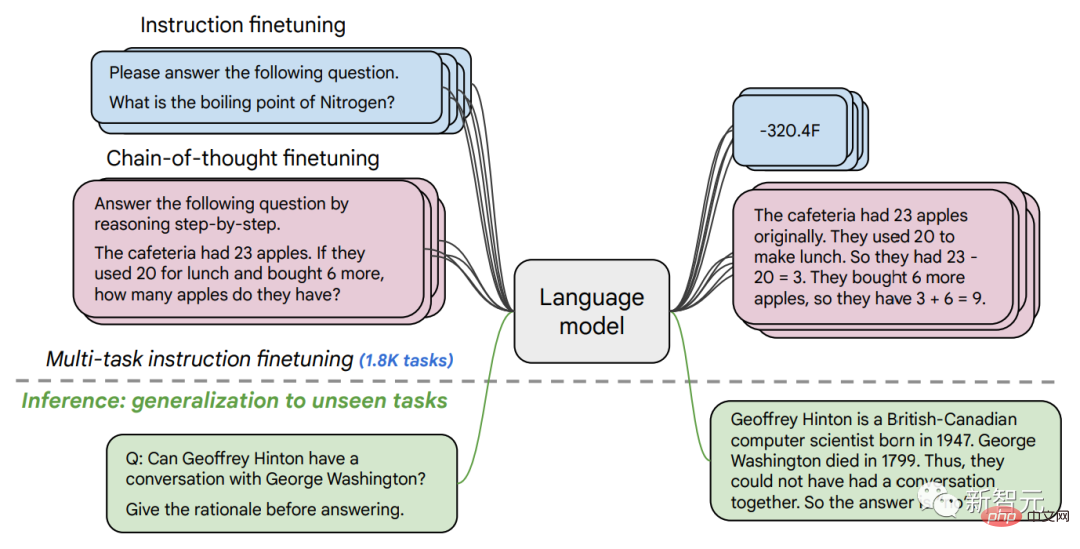

Dalam kertas kedua, kami meneroka penalaan halus arahan, yang melibatkan arahan penalaan halus dalam satu set arahan. Penalaan halus pada set data NLP.

Dalam kerja sebelumnya, kami menggunakan penalaan halus arahan pada model parameter 137B pada 62 tugasan NLP, seperti menjawab soalan pendek, mengelaskan emosi yang dinyatakan dalam filem atau mengklasifikasikan ayat Sepanyol dan banyak lagi.

Dalam kerja ini, kami memperhalusi model bahasa parameter 540B pada lebih 1.8K tugasan. Selain itu, kerja sebelumnya hanya model bahasa yang diperhalusi dengan beberapa contoh (cth., MetaICL) atau model bahasa contoh sifar tanpa contoh (cth., FLAN, T0), manakala kami memperhalusi gabungan kedua-duanya.

Kami juga menyertakan data penalaan halus rantai pemikiran, yang membolehkan model melakukan inferens berbilang langkah. Kami memanggil kaedah kami yang lebih baik "Flan" untuk model bahasa yang diperhalusi.

Perlu diambil perhatian bahawa walaupun apabila diperhalusi pada 1.8K tugasan, Flan hanya menggunakan sebahagian kecil daripada pengiraan berbanding dengan pra-latihan (untuk PaLM 540B, Flan hanya Memerlukan 0.2% pengiraan pra-latihan).

Memperhalusi model bahasa pada tugasan 1.8K yang dirumuskan sebagai arahan dan menilai model pada tugasan baharu Tidak termasuk dalam pemangkasan. Penalaan halus dilakukan dengan/tanpa contoh (iaitu, 0-shot dan few-shot), dan dengan/tanpa rantai pemikiran, membolehkan model digeneralisasikan merentas pelbagai senario penilaian.

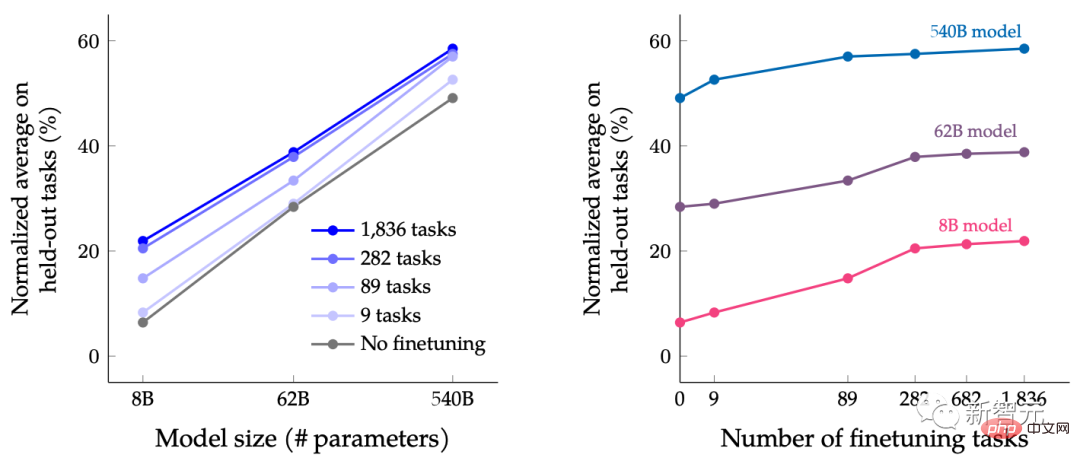

Dalam kertas ini, LM dalam julat saiz diperhalusi arahan, dengan tujuan mengkaji kesan bersama meluaskan saiz model bahasa secara serentak dan meningkatkan bilangan tugasan penalaan halus.

Sebagai contoh, untuk model bahasa kelas PaLM, termasuk spesifikasi parameter 8B, 62B dan 540B. Model kami dinilai berdasarkan empat kriteria penilaian penanda aras yang mencabar (MMLU, BBH, TyDiQA dan MGSM) dan mendapati bahawa kedua-dua memperluaskan bilangan parameter dan memperhalusi bilangan tugasan boleh meningkatkan prestasi pada tugasan baharu dan yang sebelum ini tidak kelihatan.

Memperluas model parameter kepada 540B dan menggunakan tugasan penalaan halus 1.8K boleh meningkatkan prestasi. Paksi-y bagi rajah di atas ialah purata ternormal bagi empat suite penilaian (MMLU, BBH, TyDiQA dan MGSM).

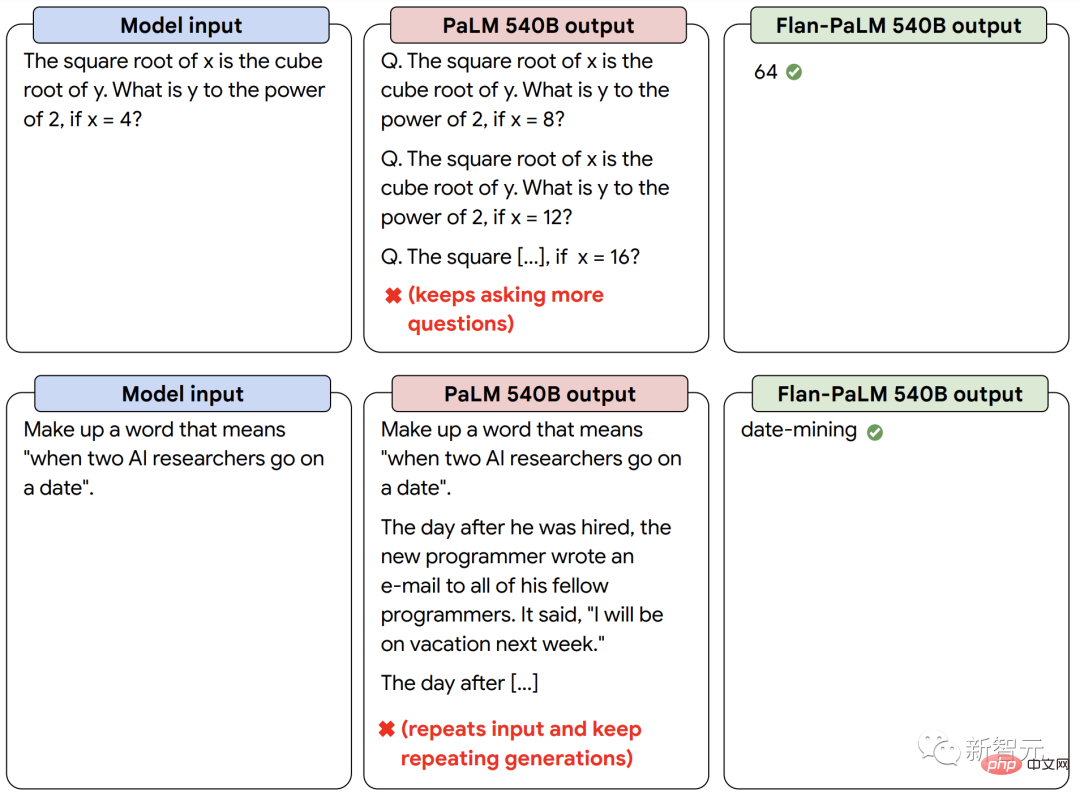

Selain prestasi yang lebih baik, LM yang diperhalusi arahan dapat bertindak balas kepada arahan pengguna pada masa inferens tanpa memerlukan sejumlah kecil contoh atau petunjuk kejuruteraan. Ini menjadikan LM lebih mesra pengguna merentas pelbagai input. Contohnya, LM tanpa penalaan halus arahan kadangkala mengulangi input atau gagal mengikut arahan, tetapi penalaan halus arahan boleh mengurangkan ralat tersebut.

Model bahasa yang diperhalusi arahan kami Flan-PaLM bertindak balas dengan lebih baik kepada arahan daripada model PaLM tanpa penalaan halus arahan.

Menggabungkan kuasa yang kuat untuk mencapai "1+1>2"

Akhir sekali, kami menunjukkan bahawa UL2R dan Flan boleh digabungkan untuk melatih model Flan-U-PaLM .

Memandangkan Flan menggunakan data baharu daripada tugasan NLP dan boleh mencapai penjejakan arahan mata sifar, kami menggunakan Flan sebagai kaedah pilihan kedua selepas UL2R.

Kami menilai sekali lagi empat suite penanda aras dan mendapati model Flan-U-PaLM mengatasi model PaLM dengan hanya UL2R (U-PaLM) atau hanya Flan (Flan-PaLM). Tambahan pula, apabila digabungkan dengan rantaian pemikiran dan ketekalan diri, Flan-U-PaLM mencapai SOTA baharu pada penanda aras MMLU dengan skor 75.4%.

Berbanding dengan hanya menggunakan UL2R (U-PaLM) atau hanya menggunakan Flan (Flan-U-PaLM), membandingkan UL2R dan Flan (Flan - U-PaLM) digabungkan membawa kepada prestasi terbaik: purata ternormal bagi empat suite penilaian (MMLU, BBH, TyDiQA dan MGSM).

Secara amnya, UL2R dan Flan ialah dua kaedah pelengkap untuk menambah baik model bahasa pra-latihan. UL2R menggunakan data yang sama untuk menyesuaikan LM kepada objektif bercampur denoisers, manakala Flan memanfaatkan data latihan daripada lebih 1.8K tugasan NLP untuk mengajar model mengikut arahan.

Apabila model bahasa semakin besar, teknik seperti UL2R dan Flan, yang meningkatkan prestasi umum tanpa memerlukan pengiraan yang berat, mungkin menjadi semakin menarik.

Atas ialah kandungan terperinci Dengan hanya kuasa pengkomputeran yang begitu banyak, bagaimana untuk meningkatkan prestasi model bahasa? Google mempunyai idea baharu. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1378

1378

52

52

Cara Mengulas DeepSeek

Feb 19, 2025 pm 05:42 PM

Cara Mengulas DeepSeek

Feb 19, 2025 pm 05:42 PM

DeepSeek adalah alat pengambilan maklumat yang kuat. .

Cara Mencari DeepSeek

Feb 19, 2025 pm 05:39 PM

Cara Mencari DeepSeek

Feb 19, 2025 pm 05:39 PM

DeepSeek adalah enjin carian proprietari yang hanya mencari dalam pangkalan data atau sistem tertentu, lebih cepat dan lebih tepat. Apabila menggunakannya, pengguna dinasihatkan untuk membaca dokumen itu, cuba strategi carian yang berbeza, dapatkan bantuan dan maklum balas mengenai pengalaman pengguna untuk memanfaatkan kelebihan mereka.

Sesame Open Door Exchange Web Pautan Pautan Gerbang Perdagangan Laman Web Pendaftaran Terkini

Feb 28, 2025 am 11:06 AM

Sesame Open Door Exchange Web Pautan Pautan Gerbang Perdagangan Laman Web Pendaftaran Terkini

Feb 28, 2025 am 11:06 AM

Artikel ini memperkenalkan proses pendaftaran versi web Web Open Exchange (GATE.IO) dan aplikasi Perdagangan Gate secara terperinci. Sama ada pendaftaran web atau pendaftaran aplikasi, anda perlu melawat laman web rasmi atau App Store untuk memuat turun aplikasi tulen, kemudian isi nama pengguna, kata laluan, e -mel, nombor telefon bimbit dan maklumat lain, dan lengkap e -mel atau pengesahan telefon bimbit.

Mengapa pautan Bybit Exchange tidak dimuat turun dan dipasang secara langsung?

Feb 21, 2025 pm 10:57 PM

Mengapa pautan Bybit Exchange tidak dimuat turun dan dipasang secara langsung?

Feb 21, 2025 pm 10:57 PM

Mengapa pautan Bybit Exchange tidak dimuat turun dan dipasang secara langsung? Bybit adalah pertukaran cryptocurrency yang menyediakan perkhidmatan perdagangan kepada pengguna. Aplikasi mudah alih Exchange tidak boleh dimuat turun terus melalui AppStore atau GooglePlay untuk sebab -sebab berikut: 1. Aplikasi pertukaran cryptocurrency sering tidak memenuhi keperluan ini kerana ia melibatkan perkhidmatan kewangan dan memerlukan peraturan dan standard keselamatan tertentu. 2. Undang -undang dan Peraturan Pematuhan di banyak negara, aktiviti yang berkaitan dengan urus niaga cryptocurrency dikawal atau terhad. Untuk mematuhi peraturan ini, aplikasi bybit hanya boleh digunakan melalui laman web rasmi atau saluran yang diberi kuasa lain

Platform Perdagangan Pintu Terbuka Sesame Muat turun Versi Mudah Alih Platform Perdagangan Platform Perdagangan Alamat Muat Turun

Feb 28, 2025 am 10:51 AM

Platform Perdagangan Pintu Terbuka Sesame Muat turun Versi Mudah Alih Platform Perdagangan Platform Perdagangan Alamat Muat Turun

Feb 28, 2025 am 10:51 AM

Adalah penting untuk memilih saluran rasmi untuk memuat turun aplikasi dan memastikan keselamatan akaun anda.

WEB OPEN DOOR EXCHANGE WEB PAGE LOGIN VERSI VERSI UNTUK GATEIO Laman Web Rasmi Pintu Masuk

Mar 04, 2025 pm 11:48 PM

WEB OPEN DOOR EXCHANGE WEB PAGE LOGIN VERSI VERSI UNTUK GATEIO Laman Web Rasmi Pintu Masuk

Mar 04, 2025 pm 11:48 PM

Pengenalan terperinci kepada operasi log masuk versi Web Open Exchange, termasuk langkah masuk dan proses pemulihan kata laluan.

Top 10 Disyorkan untuk App Perdagangan Aset Digital Crypto (2025 Global Ranking)

Mar 18, 2025 pm 12:15 PM

Top 10 Disyorkan untuk App Perdagangan Aset Digital Crypto (2025 Global Ranking)

Mar 18, 2025 pm 12:15 PM

Artikel ini mencadangkan sepuluh platform perdagangan cryptocurrency teratas yang memberi perhatian kepada, termasuk Binance, OKX, Gate.io, Bitflyer, Kucoin, Bybit, Coinbase Pro, Kraken, BYDFI dan Xbit yang desentralisasi. Platform ini mempunyai kelebihan mereka sendiri dari segi kuantiti mata wang transaksi, jenis urus niaga, keselamatan, pematuhan, dan ciri khas. Memilih platform yang sesuai memerlukan pertimbangan yang komprehensif berdasarkan pengalaman perdagangan anda sendiri, toleransi risiko dan keutamaan pelaburan. Semoga artikel ini membantu anda mencari saman terbaik untuk diri sendiri

Portal Log Masuk Versi Rasmi Binance Binance

Feb 21, 2025 pm 05:42 PM

Portal Log Masuk Versi Rasmi Binance Binance

Feb 21, 2025 pm 05:42 PM

Untuk mengakses versi Login Laman Web Binance yang terkini, ikuti langkah mudah ini. Pergi ke laman web rasmi dan klik butang "Login" di sudut kanan atas. Pilih kaedah log masuk anda yang sedia ada. Masukkan nombor mudah alih berdaftar atau e -mel dan kata laluan anda dan pengesahan lengkap (seperti kod pengesahan mudah alih atau Google Authenticator). Selepas pengesahan yang berjaya, anda boleh mengakses Portal Log masuk laman web rasmi Binance.