Peranti teknologi

Peranti teknologi

AI

AI

Bolehkah model disambungkan terus ke AGI selagi ia 'semakin besar'? Marcus membedil lagi: Tiga krisis telah muncul!

Bolehkah model disambungkan terus ke AGI selagi ia 'semakin besar'? Marcus membedil lagi: Tiga krisis telah muncul!

Bolehkah model disambungkan terus ke AGI selagi ia 'semakin besar'? Marcus membedil lagi: Tiga krisis telah muncul!

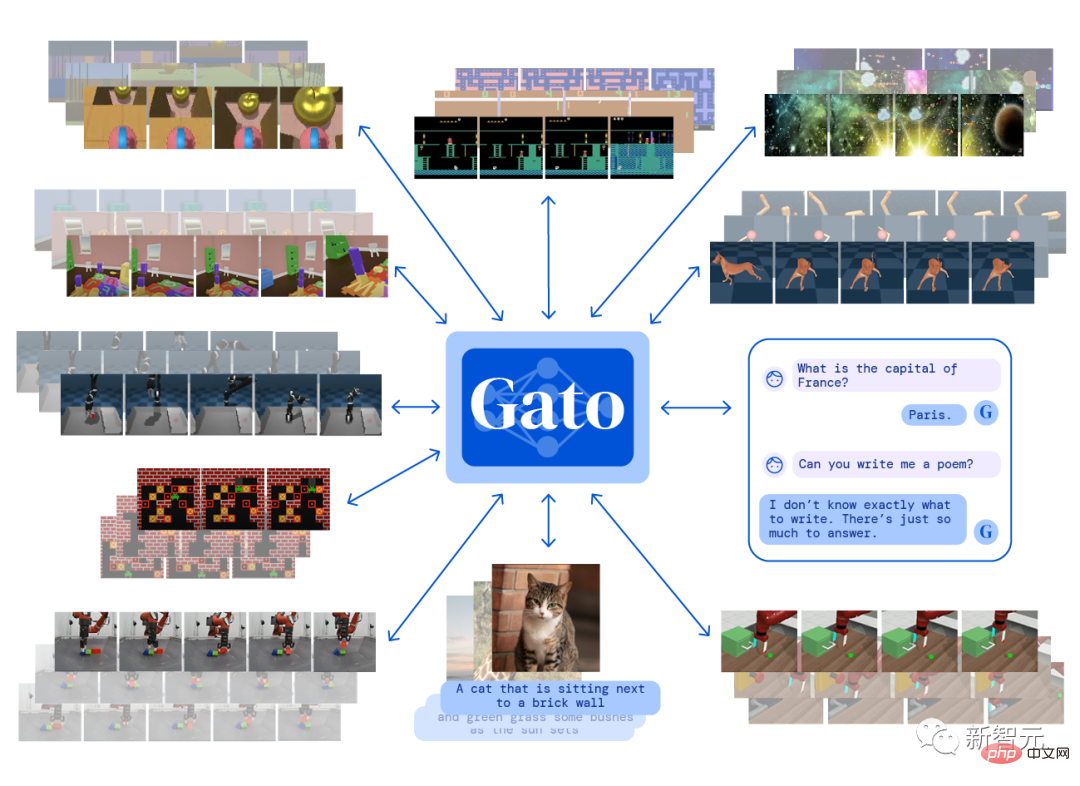

Pada bulan Mei tahun ini, DeepMind mengeluarkan Gato, sistem kecerdasan buatan pelbagai mod yang boleh melaksanakan lebih daripada 600 tugas berbeza pada masa yang sama dengan hanya satu set parameter model, yang buat sementara waktu membangkitkan perbincangan hangat tentang kecerdasan buatan am (AGI). ) dalam industri.

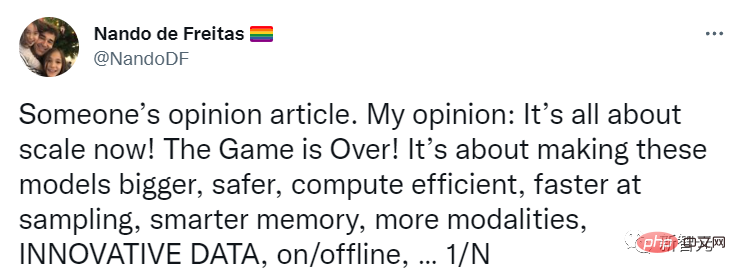

Nando de Freitas, pengarah penyelidikan di DeepMind, juga tweet pada masa bahawa AI boleh diluluskan selagi skala terus meningkat!

Apa yang perlu kita lakukan ialah menjadikan model lebih besar, lebih selamat, lebih cekap dari segi pengiraan, pensampelan lebih pantas, storan lebih bijak, lebih banyak modaliti, pada Inovasi data, dalam talian/luar talian, dll.

AGI boleh dicapai dengan menyelesaikan masalah skala Industri perlu memberi perhatian lebih kepada isu ini!

Baru-baru ini, Gary Marcus, seorang sarjana AI yang terkenal, pengasas dan Ketua Pegawai Eksekutif Robust.AI, dan profesor emeritus Universiti New York, menerbitkan blog lain, percaya bahawa kenyataan ini "terlalu awal" dan telah pun bermula Terdapat krisis!

Marcus terus memberi perhatian kepada pembangunan industri AI, tetapi mengkritik gembar-gembur AI Dia telah menyatakan bantahan seperti "pembelajaran mendalam mengenai dinding" dan "GPT-3 sepenuhnya tidak bermakna".

Apakah yang perlu saya lakukan jika saya tidak boleh bermain dengan model besar itu?

Nando percaya bahawa kecerdasan buatan tidak memerlukan anjakan paradigma, ia hanya memerlukan lebih banyak data, kecekapan yang lebih tinggi dan pelayan yang lebih besar.

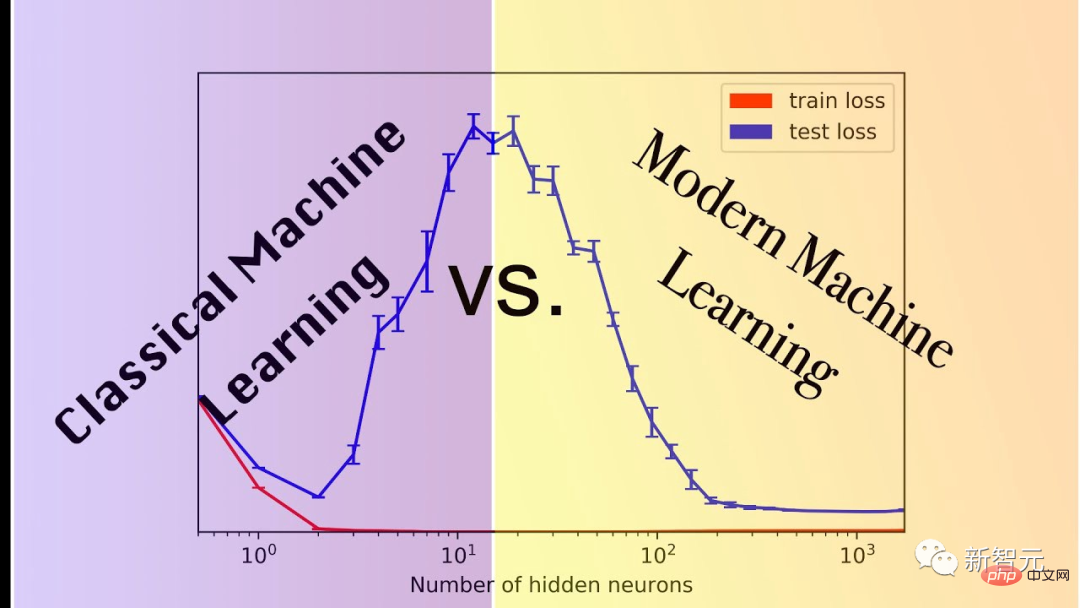

Marcus menghuraikan hipotesis ini sebagai: Tanpa inovasi baharu yang asas, AGI mungkin muncul daripada model berskala lebih besar. Andaian ini juga boleh dipanggil scaling-über-alles.

Hipotesisnya, yang kini sering dirujuk sebagai skala maksimum, kekal sangat popular, sebahagian besarnya kerana model yang lebih besar dan lebih besar sememangnya sangat berkuasa untuk tugas seperti penjanaan imej diperlukan.

Tetapi itu setakat ini sahaja.

Masalahnya ialah beberapa teknologi yang telah dipertingkatkan selama berbulan-bulan dan bertahun-tahun sebenarnya tidak mencapai skala yang kita perlukan.

Semakin banyak skim Ponzi Kelebihan prestasi yang dibawa oleh skala hanyalah hasil pemerhatian empirikal dan tidak boleh dijamin betul.

Marcus berkongsi tiga tanda terkini yang mungkin menunjukkan berakhirnya hipotesis pemaksimum skala.

1. Mungkin tidak ada data yang mencukupi di dunia untuk menyokong skala maksimum.

Ramai yang sudah risau tentang perkara ini.

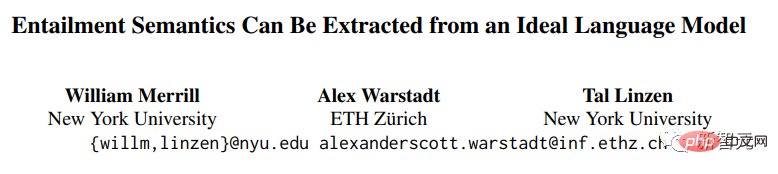

Penyelidik William Merrill, Alex Warstadt dan Tal Linzen dari Universiti New York dan ETH Zurich baru-baru ini membentangkan demonstrasi bahawa "model bahasa saraf semasa tidak sesuai untuk mengekstrak bahasa semula jadi tanpa sejumlah besar data." daripada bahasa".

Pautan kertas: https://arxiv.org/pdf/2209.12407.pdf

Walaupun bukti ini mengandungi terlalu banyak andaian, Sehinggakan ia tidak boleh dianggap sebagai bukti yang menyangkal, tetapi jika hipotesis ini hampir menjadi betul, mungkin terdapat masalah sebenar pada skala tidak lama lagi.

2. Mungkin tidak ada sumber pengkomputeran yang mencukupi di dunia untuk menyokong skala maksimum.

Miguel Solano baru-baru ini telah menghantar manuskrip pengarang bersama Marcus di mana pengarang percaya bahawa mencapai penanda aras super semasa seperti BIG-bench memerlukan penggunaan elektrik A.S. 2022 Lebih daripada satu perempat daripada itu.

Pautan gudang: https://www.php.cn/link/e21bd8ab999859f3642d2227e682e66f

>BI ialah set data penanda aras sumber ramai yang direka untuk meneroka model bahasa yang besar dan menyimpulkan keupayaan masa depan mereka, yang mengandungi lebih 200 tugasan.

3. Beberapa tugas penting mungkin tidak berskala sama sekali.

Contoh yang paling jelas ialah tugasan linguistik terbaru oleh Ruis, Khan, Biderman, Hooker, Rocktäschl dan Grefenstette, yang mengkaji makna pragmatik bahasa.

Sebagai contoh, untuk soalan "Adakah anda meninggalkan cap jari?", jawapan yang diterima mungkin "Saya memakai sarung tangan", dan makna semantiknya ialah "tidak".

Seperti yang telah lama dipertikaikan oleh Marcus, menyedarkan seorang model tentang perkara ini tanpa model kognitif dan akal adalah sangat sukar.

Skala memainkan sedikit peranan dalam jenis tugasan ini Malah model terbaik hanya mempunyai ketepatan 80.6%.

Dan, anda boleh bayangkan dengan mudah versi yang lebih kompleks bagi tugasan ini, di mana prestasi model akan semakin merosot.

Apa yang lebih melanda Marcus ialah walaupun untuk satu tugas penting seperti ini, kira-kira 80% prestasi mungkin bermakna permainan berskala besar tidak boleh terus dimainkan.

Jika model hanya mempelajari sintaks dan semantik, tetapi gagal dalam penaakulan pragmatik atau akal sehat, maka anda mungkin tidak mendapat AGI yang boleh dipercayai sama sekali

"Hukum Moore" tidak seperti Ia telah mengambil kita sejauh ini dan begitu pantas seperti yang dijangkakan pada awalnya, kerana bukan hukum sebab dan akibat di alam semesta yang akan sentiasa berlaku.

Memaksimumkan skala hanyalah satu andaian yang menarik Ia tidak akan membolehkan kita mencapai kecerdasan buatan umum Sebagai contoh, menyelesaikan tiga masalah di atas akan memaksa kita membuat anjakan paradigma.

Netizen Frank van der Velde berkata bahawa pengikut yang memaksimumkan skala cenderung menggunakan istilah yang tidak jelas seperti "besar" dan "lebih banyak".

Data latihan yang digunakan oleh model pembelajaran mendalam adalah terlalu besar berbanding dengan data latihan yang digunakan oleh manusia dalam pembelajaran bahasa.

Tetapi berbanding dengan koleksi semantik sebenar bahasa manusia, apa yang dipanggil data besar-besaran ini masih tidak penting. Ia akan mengambil kira-kira 10 bilion orang untuk menjana ayat sesaat, dan ia akan bertahan selama 300 tahun untuk mendapatkannya satu set latihan berskala besar.

Netizen Rebel Science dengan terus terang mengatakan bahawa memaksimumkan skala bukanlah hipotesis yang menarik, tetapi hipotesis bodoh Ia bukan sahaja akan kalah di landasan AI, tetapi juga mati dengan buruk.

Memaksimumkan skala adalah terlalu melampau

Raphaël Millière, pensyarah di Jabatan Falsafah di Columbia University dan Ph.D.

Skala memaksimumkan pernah dilihat sebagai tumpuan pengkritik pembelajaran mendalam (seperti Gary Marcus Apabila orang dalam industri seperti Nando de Freitas dan Alex Dimakis menyertai perdebatan, kedua-dua pihak bertelagah).

Reaksi daripada pengamal kebanyakannya bercampur-campur, tetapi tidak terlalu negatif Pada masa yang sama, tarikh ramalan untuk pelaksanaan AGI pada platform ramalan Metaculus telah meningkat kepada paras terendah dalam sejarah (Mei 2028), yang juga mungkin meningkat. skala terbesar kredibiliti.

Kepercayaan orang ramai yang semakin meningkat dalam "skala" mungkin disebabkan oleh keluaran model baharu, seperti kejayaan PaLM, DALL-E 2, Flamingo dan Gato, yang telah menambah bahan api kepada api memaksimumkan skala.

"Pelajaran Pahit" Sutton melontarkan banyak perkara dalam perbincangan tentang memaksimumkan skala, tetapi ia tidak setara sepenuhnya. Beliau percaya bahawa membina pengetahuan manusia ke dalam model kecerdasan buatan (contohnya, kejuruteraan ciri) Kecekapan adalah lebih rendah daripada menggunakan data dan pengkomputeran untuk belajar.

Pautan artikel: http://www.incompleteideas.net/IncIdeas/BitterLesson.html

Walaupun bukan tanpa kontroversi, pandangan Sutton nampaknya jelas Bukan seperti radikal sebagai skala memaksimumkan.

Ia memang menekankan kepentingan skala, tetapi ia tidak mengurangkan setiap masalah dalam penyelidikan AI kepada cabaran skala semata-mata.

Sebenarnya, sukar untuk menentukan maksud khusus skala memaksimumkan Difahamkan secara literal, "Penskalaan adalah semua yang anda perlukan" menunjukkan bahawa kita tidak memerlukan sebarang inovasi algoritma atau perubahan seni bina untuk mencapai AGI dan boleh mengembangkan sedia ada. model dan memaksa input lebih banyak data.

Penjelasan literal ini kelihatan tidak masuk akal: walaupun model seperti Palm, DALL-E 2, Flamingo atau Gato masih memerlukan perubahan seni bina daripada pendekatan sebelumnya.

Sungguh memeranjatkan jika seseorang benar-benar menyangka kami boleh memanjangkan Transformer autoregresif luar biasa kepada AGI.

Tidak jelas berapa banyak inovasi algoritmik yang dirasakan oleh orang yang percaya dalam memaksimumkan skala yang diperlukan oleh AGI, yang juga menyukarkan untuk menjana ramalan yang boleh dipalsukan daripada perspektif ini.

Penskalaan mungkin merupakan syarat yang diperlukan untuk membina mana-mana sistem yang patut diberi label "kecerdasan buatan am," tetapi kita tidak seharusnya menyalahkan keperluan sebagai keadaan yang mencukupi.

Atas ialah kandungan terperinci Bolehkah model disambungkan terus ke AGI selagi ia 'semakin besar'? Marcus membedil lagi: Tiga krisis telah muncul!. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1377

1377

52

52

Bytedance Cutting melancarkan keahlian super SVIP: 499 yuan untuk langganan tahunan berterusan, menyediakan pelbagai fungsi AI

Jun 28, 2024 am 03:51 AM

Bytedance Cutting melancarkan keahlian super SVIP: 499 yuan untuk langganan tahunan berterusan, menyediakan pelbagai fungsi AI

Jun 28, 2024 am 03:51 AM

Laman web ini melaporkan pada 27 Jun bahawa Jianying ialah perisian penyuntingan video yang dibangunkan oleh FaceMeng Technology, anak syarikat ByteDance Ia bergantung pada platform Douyin dan pada asasnya menghasilkan kandungan video pendek untuk pengguna platform tersebut Windows , MacOS dan sistem pengendalian lain. Jianying secara rasmi mengumumkan peningkatan sistem keahliannya dan melancarkan SVIP baharu, yang merangkumi pelbagai teknologi hitam AI, seperti terjemahan pintar, penonjolan pintar, pembungkusan pintar, sintesis manusia digital, dsb. Dari segi harga, yuran bulanan untuk keratan SVIP ialah 79 yuan, yuran tahunan ialah 599 yuan (nota di laman web ini: bersamaan dengan 49.9 yuan sebulan), langganan bulanan berterusan ialah 59 yuan sebulan, dan langganan tahunan berterusan ialah 499 yuan setahun (bersamaan dengan 41.6 yuan sebulan) . Di samping itu, pegawai yang dipotong juga menyatakan bahawa untuk meningkatkan pengalaman pengguna, mereka yang telah melanggan VIP asal

Pembantu pengekodan AI yang ditambah konteks menggunakan Rag dan Sem-Rag

Jun 10, 2024 am 11:08 AM

Pembantu pengekodan AI yang ditambah konteks menggunakan Rag dan Sem-Rag

Jun 10, 2024 am 11:08 AM

Tingkatkan produktiviti, kecekapan dan ketepatan pembangun dengan menggabungkan penjanaan dipertingkatkan semula dan memori semantik ke dalam pembantu pengekodan AI. Diterjemah daripada EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG, pengarang JanakiramMSV. Walaupun pembantu pengaturcaraan AI asas secara semulajadi membantu, mereka sering gagal memberikan cadangan kod yang paling relevan dan betul kerana mereka bergantung pada pemahaman umum bahasa perisian dan corak penulisan perisian yang paling biasa. Kod yang dijana oleh pembantu pengekodan ini sesuai untuk menyelesaikan masalah yang mereka bertanggungjawab untuk menyelesaikannya, tetapi selalunya tidak mematuhi piawaian pengekodan, konvensyen dan gaya pasukan individu. Ini selalunya menghasilkan cadangan yang perlu diubah suai atau diperhalusi agar kod itu diterima ke dalam aplikasi

Bolehkah penalaan halus benar-benar membolehkan LLM mempelajari perkara baharu: memperkenalkan pengetahuan baharu boleh menjadikan model menghasilkan lebih banyak halusinasi

Jun 11, 2024 pm 03:57 PM

Bolehkah penalaan halus benar-benar membolehkan LLM mempelajari perkara baharu: memperkenalkan pengetahuan baharu boleh menjadikan model menghasilkan lebih banyak halusinasi

Jun 11, 2024 pm 03:57 PM

Model Bahasa Besar (LLM) dilatih pada pangkalan data teks yang besar, di mana mereka memperoleh sejumlah besar pengetahuan dunia sebenar. Pengetahuan ini dibenamkan ke dalam parameter mereka dan kemudiannya boleh digunakan apabila diperlukan. Pengetahuan tentang model ini "diperbaharui" pada akhir latihan. Pada akhir pra-latihan, model sebenarnya berhenti belajar. Selaraskan atau perhalusi model untuk mempelajari cara memanfaatkan pengetahuan ini dan bertindak balas dengan lebih semula jadi kepada soalan pengguna. Tetapi kadangkala pengetahuan model tidak mencukupi, dan walaupun model boleh mengakses kandungan luaran melalui RAG, ia dianggap berfaedah untuk menyesuaikan model kepada domain baharu melalui penalaan halus. Penalaan halus ini dilakukan menggunakan input daripada anotasi manusia atau ciptaan LLM lain, di mana model menemui pengetahuan dunia sebenar tambahan dan menyepadukannya

Tiada data OpenAI diperlukan, sertai senarai model kod besar! UIUC mengeluarkan StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

Tiada data OpenAI diperlukan, sertai senarai model kod besar! UIUC mengeluarkan StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

Di barisan hadapan teknologi perisian, kumpulan UIUC Zhang Lingming, bersama penyelidik dari organisasi BigCode, baru-baru ini mengumumkan model kod besar StarCoder2-15B-Instruct. Pencapaian inovatif ini mencapai kejayaan ketara dalam tugas penjanaan kod, berjaya mengatasi CodeLlama-70B-Instruct dan mencapai bahagian atas senarai prestasi penjanaan kod. Keunikan StarCoder2-15B-Instruct terletak pada strategi penjajaran diri yang tulen Keseluruhan proses latihan adalah terbuka, telus, dan sepenuhnya autonomi dan boleh dikawal. Model ini menjana beribu-ribu arahan melalui StarCoder2-15B sebagai tindak balas kepada penalaan halus model asas StarCoder-15B tanpa bergantung pada anotasi manual yang mahal.

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Editor |ScienceAI Question Answering (QA) set data memainkan peranan penting dalam mempromosikan penyelidikan pemprosesan bahasa semula jadi (NLP). Set data QA berkualiti tinggi bukan sahaja boleh digunakan untuk memperhalusi model, tetapi juga menilai dengan berkesan keupayaan model bahasa besar (LLM), terutamanya keupayaan untuk memahami dan menaakul tentang pengetahuan saintifik. Walaupun pada masa ini terdapat banyak set data QA saintifik yang meliputi bidang perubatan, kimia, biologi dan bidang lain, set data ini masih mempunyai beberapa kekurangan. Pertama, borang data adalah agak mudah, kebanyakannya adalah soalan aneka pilihan. Ia mudah dinilai, tetapi mengehadkan julat pemilihan jawapan model dan tidak dapat menguji sepenuhnya keupayaan model untuk menjawab soalan saintifik. Sebaliknya, Soal Jawab terbuka

Yolov10: Penjelasan terperinci, penggunaan dan aplikasi semuanya di satu tempat!

Jun 07, 2024 pm 12:05 PM

Yolov10: Penjelasan terperinci, penggunaan dan aplikasi semuanya di satu tempat!

Jun 07, 2024 pm 12:05 PM

1. Pengenalan Sejak beberapa tahun kebelakangan ini, YOLO telah menjadi paradigma dominan dalam bidang pengesanan objek masa nyata kerana keseimbangannya yang berkesan antara kos pengiraan dan prestasi pengesanan. Penyelidik telah meneroka reka bentuk seni bina YOLO, matlamat pengoptimuman, strategi pengembangan data, dsb., dan telah mencapai kemajuan yang ketara. Pada masa yang sama, bergantung pada penindasan bukan maksimum (NMS) untuk pemprosesan pasca menghalang penggunaan YOLO dari hujung ke hujung dan memberi kesan buruk kepada kependaman inferens. Dalam YOLO, reka bentuk pelbagai komponen tidak mempunyai pemeriksaan yang komprehensif dan teliti, mengakibatkan lebihan pengiraan yang ketara dan mengehadkan keupayaan model. Ia menawarkan kecekapan suboptimum, dan potensi yang agak besar untuk peningkatan prestasi. Dalam kerja ini, matlamatnya adalah untuk meningkatkan lagi sempadan kecekapan prestasi YOLO daripada kedua-dua pasca pemprosesan dan seni bina model. sampai habis

Prestasi SOTA, kaedah AI ramalan pertalian protein-ligan pelbagai mod Xiamen, menggabungkan maklumat permukaan molekul buat kali pertama

Jul 17, 2024 pm 06:37 PM

Prestasi SOTA, kaedah AI ramalan pertalian protein-ligan pelbagai mod Xiamen, menggabungkan maklumat permukaan molekul buat kali pertama

Jul 17, 2024 pm 06:37 PM

Editor |. KX Dalam bidang penyelidikan dan pembangunan ubat, meramalkan pertalian pengikatan protein dan ligan dengan tepat dan berkesan adalah penting untuk pemeriksaan dan pengoptimuman ubat. Walau bagaimanapun, kajian semasa tidak mengambil kira peranan penting maklumat permukaan molekul dalam interaksi protein-ligan. Berdasarkan ini, penyelidik dari Universiti Xiamen mencadangkan rangka kerja pengekstrakan ciri berbilang mod (MFE) novel, yang buat pertama kalinya menggabungkan maklumat mengenai permukaan protein, struktur dan jujukan 3D, dan menggunakan mekanisme perhatian silang untuk membandingkan ciri modaliti yang berbeza penjajaran. Keputusan eksperimen menunjukkan bahawa kaedah ini mencapai prestasi terkini dalam meramalkan pertalian mengikat protein-ligan. Tambahan pula, kajian ablasi menunjukkan keberkesanan dan keperluan maklumat permukaan protein dan penjajaran ciri multimodal dalam rangka kerja ini. Penyelidikan berkaitan bermula dengan "S

Meletakkan pasaran seperti AI, GlobalFoundries memperoleh teknologi gallium nitrida Tagore Technology dan pasukan berkaitan

Jul 15, 2024 pm 12:21 PM

Meletakkan pasaran seperti AI, GlobalFoundries memperoleh teknologi gallium nitrida Tagore Technology dan pasukan berkaitan

Jul 15, 2024 pm 12:21 PM

Menurut berita dari laman web ini pada 5 Julai, GlobalFoundries mengeluarkan kenyataan akhbar pada 1 Julai tahun ini, mengumumkan pemerolehan teknologi power gallium nitride (GaN) Tagore Technology dan portfolio harta intelek, dengan harapan dapat mengembangkan bahagian pasarannya dalam kereta dan Internet of Things dan kawasan aplikasi pusat data kecerdasan buatan untuk meneroka kecekapan yang lebih tinggi dan prestasi yang lebih baik. Memandangkan teknologi seperti AI generatif terus berkembang dalam dunia digital, galium nitrida (GaN) telah menjadi penyelesaian utama untuk pengurusan kuasa yang mampan dan cekap, terutamanya dalam pusat data. Laman web ini memetik pengumuman rasmi bahawa semasa pengambilalihan ini, pasukan kejuruteraan Tagore Technology akan menyertai GLOBALFOUNDRIES untuk membangunkan lagi teknologi gallium nitride. G