Peranti teknologi

Peranti teknologi

AI

AI

Jangan panik jika anda menyemak kertas anda 100 kali! Meta mengeluarkan model bahasa penulisan baharu PEER: rujukan akan ditambah

Jangan panik jika anda menyemak kertas anda 100 kali! Meta mengeluarkan model bahasa penulisan baharu PEER: rujukan akan ditambah

Jangan panik jika anda menyemak kertas anda 100 kali! Meta mengeluarkan model bahasa penulisan baharu PEER: rujukan akan ditambah

Dalam tempoh hampir dua setengah tahun sejak dikeluarkan pada Mei 2020, GPT-3 telah dapat membantu manusia dalam menulis dengan sangat baik dengan keupayaan penjanaan teks ajaibnya.

Tetapi dalam analisis akhir, GPT-3 ialah model penjanaan teks, yang boleh dikatakan berbeza sama sekali daripada proses penulisan manusia.

Sebagai contoh, jika kita ingin menulis kertas atau gubahan, kita perlu membina kerangka dalam fikiran kita terlebih dahulu, menyemak maklumat yang berkaitan, membuat draf, dan kemudian mencari tutor untuk sentiasa menyemak dan menggilap teks Dalam tempoh ini, kami juga boleh menyemak semula idea-idea, dan akhirnya, barulah ia boleh menjadi artikel yang bagus.

Teks yang diperolehi oleh model generatif boleh memenuhi keperluan tatabahasa, tetapi tiada logik dalam susunan kandungan, dan tiada keupayaan untuk mengubah suai diri, jadi ia masih jauh daripada membiarkan AI menulis secara bebas.

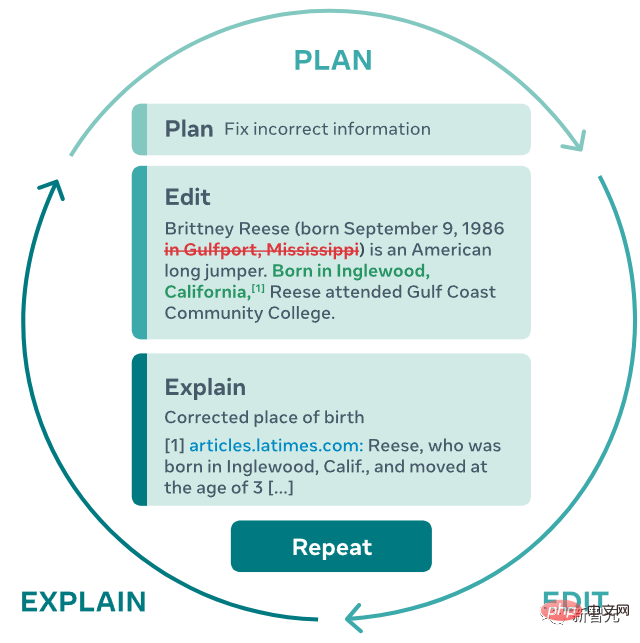

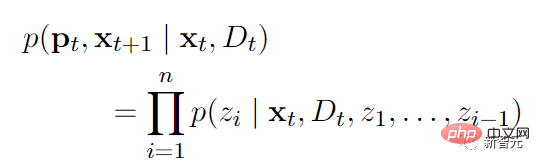

Baru-baru ini, penyelidik dari Meta AI Research dan Carnegie Mellon University mencadangkan model penjanaan teks baharu PEER (Plan, Edit, Explain, Repeat), yang mensimulasikan sepenuhnya proses penulisan manusia daripada merangka, meminta cadangan, menyunting teks, dan berulang.

Alamat kertas: https://arxiv.org/abs/2208.11663

PEER menyelesaikan masalah yang model bahasa tradisional boleh hanya menjana Hasil akhir ialah teks yang dijana tidak boleh dikawal Dengan memasukkan arahan bahasa semula jadi, PEER boleh mengubah suai teks yang dihasilkan.

Perkara yang paling penting ialah penyelidik melatih beberapa contoh PEER, yang boleh mengisi berbilang pautan dalam proses penulisan, supaya latihan kendiri boleh digunakan ) teknologi meningkatkan kualiti, kuantiti, dan kepelbagaian data latihan.

boleh menjana data latihan, yang bermaksud bahawa potensi PEER jauh melebihi menulis esei juga boleh digunakan dalam bidang lain tanpa menyunting sejarah, membolehkannya memperbaiki dirinya secara beransur-ansur dengan mengikuti arahan, menulis komen yang berguna. dan menerangkan keupayaannya untuk berkelakuan.

NLP juga datang kepada bionik

Selepas pra-latihan dengan bahasa semula jadi, kesan penjanaan teks rangkaian neural yang besar sudah sangat kuat, tetapi kaedah penjanaan model ini pada asasnya adalah dari kiri ke betul Mengeluarkan teks yang terhasil sekali gus adalah sangat berbeza daripada proses lelaran penulisan manusia.

Generasi satu masa juga mempunyai banyak kelemahan Contohnya, adalah mustahil untuk mengesan kembali ayat-ayat dalam teks untuk pengubahsuaian atau penambahbaikan, dan juga tidak dapat menjelaskan sebab ayat tertentu teks dihasilkan juga sukar untuk menguji ketepatan teks yang dihasilkan Selalunya terdapat ralat dalam hasil. Hasilkan kandungan halusinasi, iaitu teks yang tidak sesuai dengan fakta. Kelemahan ini juga mengehadkan keupayaan model untuk menulis dengan kerjasama manusia, yang memerlukan teks yang koheren dan berfakta.

Model PEER dilatih tentang "sejarah penyuntingan" teks, membolehkan model itu mensimulasikan proses penulisan manusia.

1 Apabila model PEER sedang dijalankan, pengguna atau model perlu menentukan rancangan (Pelan) dan menerangkan tindakan (tindakan) yang mereka mahu lakukan melalui bahasa semula jadi. , seperti menambah beberapa maklumat atau membetulkan ralat tatabahasa; Terangkan) Hasil suntingan ini, seperti menambah rujukan pada penghujung teks;

Pendekatan berulang ini bukan sahaja membenarkan model untuk memecahkan tugas yang kompleks untuk menulis teks yang koheren, konsisten dan berfakta kepada berbilang subtugas yang lebih mudah, tetapi juga membolehkan manusia untuk lebih terlibat dalam proses penjanaan masa untuk membimbing model ke arah yang betul, menyediakan pengguna dengan rancangan dan ulasan, atau mula mengeditnya sendiri.

Dapat dilihat daripada huraian kaedah bahawa perkara yang paling sukar dalam melaksanakan fungsi tersebut bukanlah menggunakan Transformer untuk membina model, tetapi untuk mencari data latihan, dan ingin untuk mencari data yang boleh melatih bahasa besar Jelas sekali sukar untuk mempelajari data yang diperlukan untuk proses ini pada skala yang diperlukan untuk model, kerana kebanyakan tapak web tidak menyediakan sejarah penyuntingan, jadi halaman web yang diperoleh melalui perangkak tidak boleh digunakan sebagai data latihan. Malah merangkak halaman web yang sama pada masa yang berbeza sebagai sejarah suntingan adalah tidak boleh dilaksanakan kerana tiada teks berkaitan yang merancang atau menerangkan pengeditan itu.PEER adalah serupa dengan kaedah penyuntingan berulang sebelumnya, menggunakan Wikipedia sebagai sumber data untuk penyunting utama dan ulasan yang berkaitan, kerana Wikipedia menyediakan sejarah suntingan yang lengkap, termasuk ulasan tentang pelbagai topik, dan berskala besar dalam artikel. Sebut harga sering disertakan dan membantu dalam mencari dokumen yang berkaitan.

Tetapi bergantung semata-mata pada Wikipedia sebagai satu-satunya sumber data latihan juga mempunyai pelbagai kelemahan:

1 Model yang dilatih hanya menggunakan Wikipedia mempunyai rancangan untuk meramalkan kandungan teks yang dijangkakan dan keperluan penyuntingan untuk menjadi serupa dengan Wikipedia; sebarang petikan, dan walaupun kekurangan maklumat latar belakang ini boleh dikompensasikan dengan menggunakan sistem perolehan semula, malah sistem sedemikian mungkin tidak dapat mencari maklumat latar belakang sokongan untuk banyak editor.

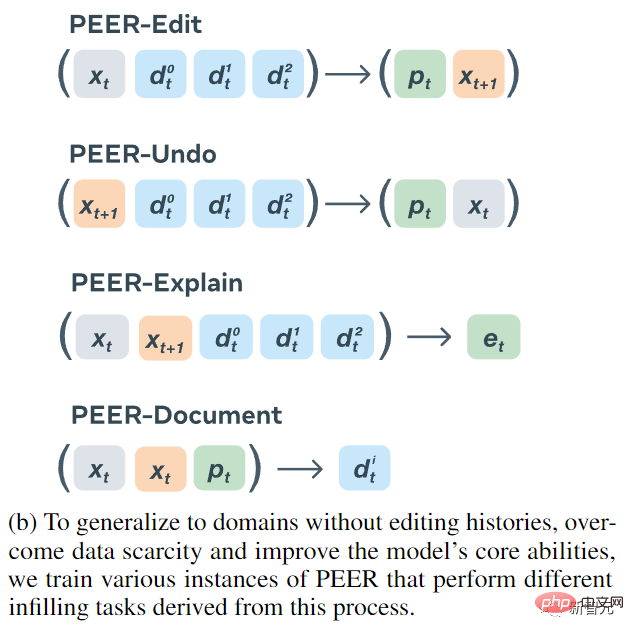

Penyelidik telah mencadangkan kaedah mudah untuk menyelesaikan semua masalah yang disebabkan oleh Wikipedia sebagai satu-satunya sumber sejarah penyuntingan ulasan: melatih berbilang kejadian PEER dan menggunakan tika ini untuk belajar mengisi pelbagai aspek proses penyuntingan. Model-model ini boleh digunakan untuk menjana data sintetik sebagai pengganti bahagian korpus latihan yang hilang.

Empat model penyahkod pengekod akhirnya dilatih:

1. Input PEER-Edit ialah teks x dan satu set dokumen serta model output ialah rancangan dan teks yang diedit, di mana p ialah teks yang dirancang.

3. PEER-Explain digunakan untuk menjana penjelasan suntingan Input ialah teks sumber, teks yang disunting dan satu set dokumen berkaitan.

3. PEER-Explain digunakan untuk menjana penjelasan suntingan Input ialah teks sumber, teks yang disunting dan satu set dokumen berkaitan.

4. PEER-Document memasukkan teks sumber, teks dan pelan yang diedit, dan output model ialah maklumat latar belakang yang paling berguna dalam suntingan ini.

Semua model varian PEER digunakan untuk menjana data sintetik, kedua-duanya untuk menjana data latihan untuk menambah bahagian yang hilang dan menggantikan bahagian "berkualiti rendah" data sedia ada.

Untuk dapat melatih data teks sewenang-wenangnya, walaupun teks itu tidak mempunyai sejarah pengeditan, PEER-Undo digunakan untuk menjana pengeditan "mundur" sintetik, iaitu, PEER-Undo berulang kali digunakan untuk teks sumber sehingga teks itu Kosong, kemudian panggil PEER-Edit untuk melatih ke arah yang bertentangan.

Apabila menjana rancangan, gunakan PEER-Explain untuk membetulkan banyak ulasan berkualiti rendah dalam korpus, atau untuk memproses teks tanpa ulasan. Sampel berbilang hasil secara rawak daripada output PEER-Explain sebagai "pelan berpotensi", kirakan kemungkinan pengeditan sebenar dan pilih yang mempunyai kebarangkalian tertinggi sebagai pelan baharu.

Jika dokumen yang berkaitan tidak dapat ditemui untuk operasi penyuntingan tertentu, Dokumen PEER digunakan untuk menjana satu set dokumen sintetik yang mengandungi maklumat untuk melaksanakan operasi penyuntingan. Paling penting, PEER-Edit hanya melakukan ini semasa latihan dan tidak menyediakan sebarang dokumen sintetik semasa fasa inferens.

Untuk meningkatkan kualiti dan kepelbagaian rancangan, suntingan dan dokumen yang dihasilkan, penyelidik juga melaksanakan mekanisme kawalan yang menetapkan penanda kawalan khusus dalam jujukan output yang dijana oleh model yang sedang dilatih, dan kemudian menggunakannya. semasa inferens Teg kawalan ini digunakan dalam proses untuk membimbing penjanaan model Teg termasuk:

1. Jenis digunakan untuk mengawal jenis teks yang dihasilkan oleh PEER-Explain. output mesti bermula dengan infinitif kepada.. ..) dan lain-lain; 2-3 perkataan), l (4- 5 perkataan) dan

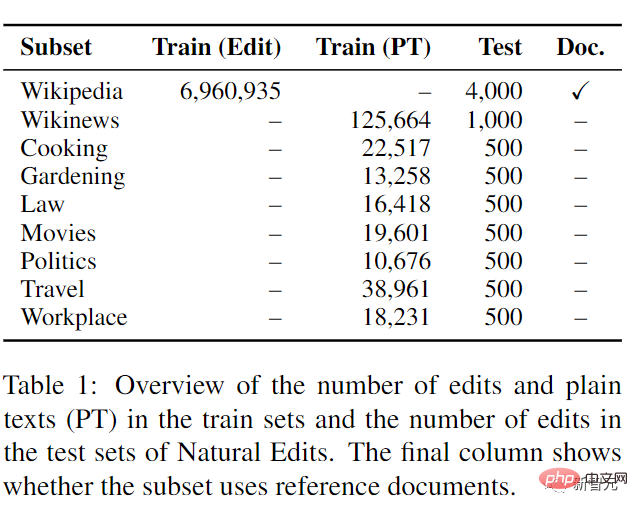

4 perkataan, digunakan untuk mengawal bilangan perkataan yang berbeza antara teks sumber dan teks yang diedit PEER-Undo Nilai pilihan adalah semua integer ; 5 mengandungi, digunakan untuk memastikan bahawa PEER-Undo Output teks oleh Document mengandungi subrentetan tertentuPEER tidak memperkenalkan aksara kawalan untuk PEER-edit, iaitu, ia tidak anggap jenis tugas penyuntingan yang pengguna boleh gunakan model untuk diselesaikan, menjadikan model lebih serba boleh. Dalam fasa perbandingan percubaan, PEER menggunakan versi parameter 3B LM-Adapted T5 untuk permulaan pralatihan. Untuk menilai keupayaan PEER mengikuti satu siri rancangan, menggunakan dokumen yang disediakan dan membuat pengeditan dalam domain yang berbeza, terutamanya dalam domain tanpa sejarah pengeditan, set data baharu diperkenalkan Natural Edits, koleksi suntingan yang berlaku secara semula jadi untuk jenis teks dan domain yang berbeza.Data dikumpulkan daripada tiga sumber web berbahasa Inggeris: halaman ensiklopedia daripada Wikipedia, artikel berita daripada Wikinews dan subforum StackExchange untuk memasak, berkebun, undang-undang, filem, politik, perjalanan dan tempat kerja, semua ini tapak menyediakan sejarah suntingan dengan ulasan yang memperincikan niat editor dan memberikannya kepada model sebagai pelan.

Dalam latihan subset Wikinews dan StackExchange, hanya data teks biasa disediakan dan bukannya pengeditan sebenar, dengan itu menguji keupayaan penyuntingan di kawasan tanpa sejarah penyuntingan.

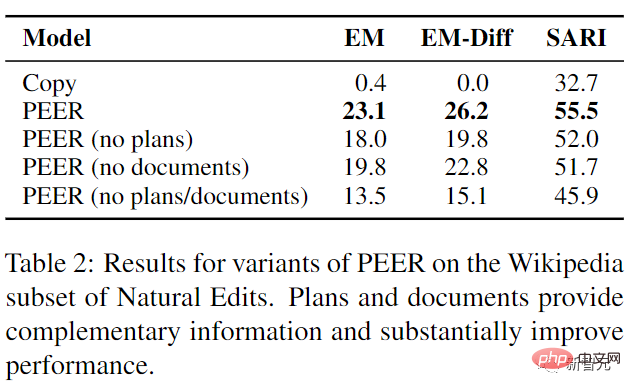

Hasil percubaan menunjukkan bahawa prestasi PEER melebihi semua garis dasar pada tahap tertentu, dan pelan serta dokumentasi menyediakan maklumat pelengkap yang boleh digunakan oleh model

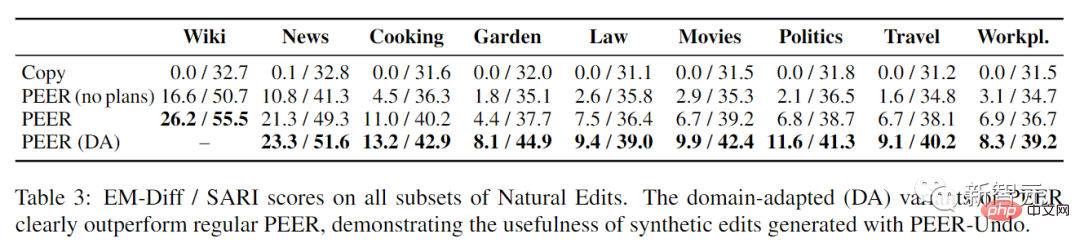

Menilai PEER pada semua subset Suntingan Semulajadi mendedahkan bahawa perancangan sangat membantu merentas domain, menunjukkan bahawa keupayaan untuk memahami perancangan dalam penyuntingan Wikipedia boleh dipindahkan terus ke domain lain. Yang penting, varian penyesuaian domain PEER dengan ketara mengatasi prestasi PEER biasa pada semua subset Suntingan Semulajadi, terutamanya dengan peningkatan besar pada subset berkebun, politik dan filem (masing-masing 84%, 71% dan 48% EM-). Diff), juga menunjukkan keberkesanan menjana suntingan sintetik apabila menggunakan PEER dalam domain yang berbeza.

Atas ialah kandungan terperinci Jangan panik jika anda menyemak kertas anda 100 kali! Meta mengeluarkan model bahasa penulisan baharu PEER: rujukan akan ditambah. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1386

1386

52

52

Cara Memeriksa Konfigurasi HDFS CentOS

Apr 14, 2025 pm 07:21 PM

Cara Memeriksa Konfigurasi HDFS CentOS

Apr 14, 2025 pm 07:21 PM

Panduan Lengkap untuk Memeriksa Konfigurasi HDFS Dalam Sistem CentOS Artikel ini akan membimbing anda bagaimana untuk memeriksa konfigurasi dan menjalankan status HDFS secara berkesan pada sistem CentOS. Langkah -langkah berikut akan membantu anda memahami sepenuhnya persediaan dan operasi HDFS. Sahkan Pembolehubah Alam Sekitar Hadoop: Pertama, pastikan pembolehubah persekitaran Hadoop ditetapkan dengan betul. Di terminal, laksanakan arahan berikut untuk mengesahkan bahawa Hadoop dipasang dan dikonfigurasi dengan betul: Hadoopversion Semak fail konfigurasi HDFS: Fail konfigurasi teras HDFS terletak di/etc/hadoop/conf/direktori, di mana core-site.xml dan hdfs-site.xml adalah kritikal. gunakan

Baris arahan shutdown centos

Apr 14, 2025 pm 09:12 PM

Baris arahan shutdown centos

Apr 14, 2025 pm 09:12 PM

Perintah shutdown CentOS adalah penutupan, dan sintaks adalah tutup [pilihan] [maklumat]. Pilihan termasuk: -h menghentikan sistem dengan segera; -P mematikan kuasa selepas penutupan; -r mulakan semula; -T Waktu Menunggu. Masa boleh ditentukan sebagai segera (sekarang), minit (minit), atau masa tertentu (HH: mm). Maklumat tambahan boleh dipaparkan dalam mesej sistem.

Apakah kaedah sandaran untuk gitlab di centos

Apr 14, 2025 pm 05:33 PM

Apakah kaedah sandaran untuk gitlab di centos

Apr 14, 2025 pm 05:33 PM

Dasar sandaran dan pemulihan Gitlab di bawah sistem CentOS untuk memastikan keselamatan data dan pemulihan, Gitlab pada CentOS menyediakan pelbagai kaedah sandaran. Artikel ini akan memperkenalkan beberapa kaedah sandaran biasa, parameter konfigurasi dan proses pemulihan secara terperinci untuk membantu anda menubuhkan strategi sandaran dan pemulihan GitLab lengkap. 1. Backup Manual Gunakan Gitlab-Rakegitlab: Backup: Buat Perintah untuk Melaksanakan Backup Manual. Perintah ini menyokong maklumat utama seperti repositori Gitlab, pangkalan data, pengguna, kumpulan pengguna, kunci, dan kebenaran. Fail sandaran lalai disimpan dalam direktori/var/opt/gitlab/sandaran. Anda boleh mengubah suai /etc /gitlab

CentOS memasang MySQL

Apr 14, 2025 pm 08:09 PM

CentOS memasang MySQL

Apr 14, 2025 pm 08:09 PM

Memasang MySQL pada CentOS melibatkan langkah -langkah berikut: Menambah sumber MySQL YUM yang sesuai. Jalankan YUM Pasang Perintah MySQL-Server untuk memasang pelayan MySQL. Gunakan perintah mysql_secure_installation untuk membuat tetapan keselamatan, seperti menetapkan kata laluan pengguna root. Sesuaikan fail konfigurasi MySQL seperti yang diperlukan. Tune parameter MySQL dan mengoptimumkan pangkalan data untuk prestasi.

Cara Mengendalikan Latihan Pittorch Diagihkan di Centos

Apr 14, 2025 pm 06:36 PM

Cara Mengendalikan Latihan Pittorch Diagihkan di Centos

Apr 14, 2025 pm 06:36 PM

Latihan yang diedarkan Pytorch pada sistem CentOS memerlukan langkah -langkah berikut: Pemasangan Pytorch: Premisnya ialah Python dan PIP dipasang dalam sistem CentOS. Bergantung pada versi CUDA anda, dapatkan arahan pemasangan yang sesuai dari laman web rasmi Pytorch. Untuk latihan CPU sahaja, anda boleh menggunakan arahan berikut: PipinstallToRchTorchVisionTorchaudio Jika anda memerlukan sokongan GPU, pastikan versi CUDA dan CUDNN yang sama dipasang dan gunakan versi pytorch yang sepadan untuk pemasangan. Konfigurasi Alam Sekitar Teragih: Latihan yang diedarkan biasanya memerlukan pelbagai mesin atau mesin berbilang mesin tunggal. Tempat

Penjelasan terperinci mengenai Prinsip Docker

Apr 14, 2025 pm 11:57 PM

Penjelasan terperinci mengenai Prinsip Docker

Apr 14, 2025 pm 11:57 PM

Docker menggunakan ciri -ciri kernel Linux untuk menyediakan persekitaran berjalan yang cekap dan terpencil. Prinsip kerjanya adalah seperti berikut: 1. Cermin digunakan sebagai templat baca sahaja, yang mengandungi semua yang anda perlukan untuk menjalankan aplikasi; 2. Sistem Fail Kesatuan (Unionfs) menyusun pelbagai sistem fail, hanya menyimpan perbezaan, menjimatkan ruang dan mempercepatkan; 3. Daemon menguruskan cermin dan bekas, dan pelanggan menggunakannya untuk interaksi; 4. Ruang nama dan cgroups melaksanakan pengasingan kontena dan batasan sumber; 5. Pelbagai mod rangkaian menyokong interkoneksi kontena. Hanya dengan memahami konsep -konsep teras ini, anda boleh menggunakan Docker dengan lebih baik.

Cara Melihat Log Gitlab Di Bawah Centos

Apr 14, 2025 pm 06:18 PM

Cara Melihat Log Gitlab Di Bawah Centos

Apr 14, 2025 pm 06:18 PM

Panduan Lengkap untuk Melihat Log Gitlab Di bawah Sistem CentOS Artikel ini akan membimbing anda bagaimana untuk melihat pelbagai log Gitlab dalam sistem CentOS, termasuk log utama, log pengecualian, dan log lain yang berkaitan. Sila ambil perhatian bahawa laluan fail log mungkin berbeza -beza bergantung pada versi GitLab dan kaedah pemasangan. Jika laluan berikut tidak wujud, sila semak fail Direktori Pemasangan dan Konfigurasi GitLab. 1. Lihat log Gitlab utama Gunakan arahan berikut untuk melihat fail log utama aplikasi GitLabRails: Perintah: Sudocat/var/Log/Gitlab/Gitlab-Rails/Production.log Perintah ini akan memaparkan produk

Bagaimana sokongan GPU untuk Pytorch di CentOS

Apr 14, 2025 pm 06:48 PM

Bagaimana sokongan GPU untuk Pytorch di CentOS

Apr 14, 2025 pm 06:48 PM

Membolehkan pecutan GPU pytorch pada sistem CentOS memerlukan pemasangan cuda, cudnn dan GPU versi pytorch. Langkah-langkah berikut akan membimbing anda melalui proses: Pemasangan CUDA dan CUDNN Tentukan keserasian versi CUDA: Gunakan perintah NVIDIA-SMI untuk melihat versi CUDA yang disokong oleh kad grafik NVIDIA anda. Sebagai contoh, kad grafik MX450 anda boleh menyokong CUDA11.1 atau lebih tinggi. Muat turun dan pasang Cudatoolkit: Lawati laman web rasmi Nvidiacudatoolkit dan muat turun dan pasang versi yang sepadan mengikut versi CUDA tertinggi yang disokong oleh kad grafik anda. Pasang Perpustakaan Cudnn: