Peranti teknologi

Peranti teknologi

AI

AI

Versi ringan kaedah latihan ChatGPT adalah sumber terbuka! Dibina di sekitar LLaMA dalam masa 3 hari sahaja, kelajuan latihan didakwa 15 kali lebih pantas daripada OpenAI

Versi ringan kaedah latihan ChatGPT adalah sumber terbuka! Dibina di sekitar LLaMA dalam masa 3 hari sahaja, kelajuan latihan didakwa 15 kali lebih pantas daripada OpenAI

Versi ringan kaedah latihan ChatGPT adalah sumber terbuka! Dibina di sekitar LLaMA dalam masa 3 hari sahaja, kelajuan latihan didakwa 15 kali lebih pantas daripada OpenAI

Versi ringan ChatGPT berdasarkan model Meta ada di sini?

Hanya tiga hari sejak Meta mengumumkan pelancaran LLaMA, dan kaedah latihan sumber terbuka yang mengubahnya menjadi ChatGPT telah muncul dalam industri, mendakwa bahawa kelajuan latihan adalah sehingga 15 kali lebih pantas daripada ChatGPT .

LLaMA ialah GPT-3 yang sangat pantas dan sangat kecil yang dilancarkan oleh Meta Bilangan parameter hanya 10% daripada yang terakhir, dan ia hanya memerlukan satu GPU untuk dijalankan.

Kaedah untuk mengubahnya menjadi ChatGPT dipanggil ChatLLaMA, yang dilatih berdasarkan RLHF (pembelajaran pengukuhan berdasarkan maklum balas manusia) dan dengan cepat menjadi topik hangat di Internet.

Jadi, versi sumber terbuka Meta untuk ChatGPT benar-benar akan datang?

Tunggu sebentar, perkara tidak semudah itu.

"Kaedah sumber terbuka" untuk melatih LLaMA ke dalam ChatGPT

Klik pada laman utama projek ChatLLaMA dan anda akan mendapati ia sebenarnya menggabungkan empat bahagian -

Kaedah DeepSpeed, RLHF , LLaMA dan set data yang dijana berdasarkan ejen LangChain.

Antaranya, DeepSpeed ialah perpustakaan pengoptimuman latihan pembelajaran dalam sumber terbuka, termasuk teknologi pengoptimuman sedia ada yang dipanggil Zero, yang digunakan untuk meningkatkan keupayaan latihan model besar Secara khusus, ia merujuk kepada membantu model meningkatkan latihan kelajuan, mengurangkan kos, meningkatkan ketersediaan model, dsb.

RLHF akan menggunakan model ganjaran untuk memperhalusi model pra-latihan. Model ganjaran mula-mula menggunakan berbilang model untuk menjana soalan dan jawapan, dan kemudian bergantung pada pengisihan manual bagi soalan dan jawapan supaya ia boleh belajar untuk menskor Kemudian, ia menjaringkan jawapan yang dijana oleh model berdasarkan pembelajaran ganjaran, dan meningkatkan keupayaan model melalui pembelajaran pengukuhan.

LangChain ialah perpustakaan pembangunan aplikasi model bahasa yang besar yang berharap dapat menyepadukan pelbagai model bahasa besar dan mencipta aplikasi praktikal digabungkan dengan sumber pengetahuan atau kuasa pengkomputeran lain. Ejen LangChain akan melepaskan keseluruhan proses pemikiran GPT-3 seperti rantaian pemikiran dan merekodkan operasi.

Pada masa ini anda akan mendapati bahawa perkara yang paling kritikal adalah masih berat model LLaMA. Dari mana ia datang?

Hei, pergi ke Meta dan mohon sendiri, ChatLLaMA tidak menyediakannya. (Walaupun Meta mendakwa LLaMA sumber terbuka, anda masih perlu memohon)

Jadi pada asasnya, ChatLLaMA bukanlah projek ChatGPT sumber terbuka, tetapi hanya kaedah latihan berdasarkan LLaMA Beberapa projek yang disepadukan dalam perpustakaannya pada asalnya adalah sumber terbuka.

Sebenarnya, ChatLLaMA tidak dibina oleh Meta, tetapi daripada syarikat AI permulaan bernama Nebuly AI.

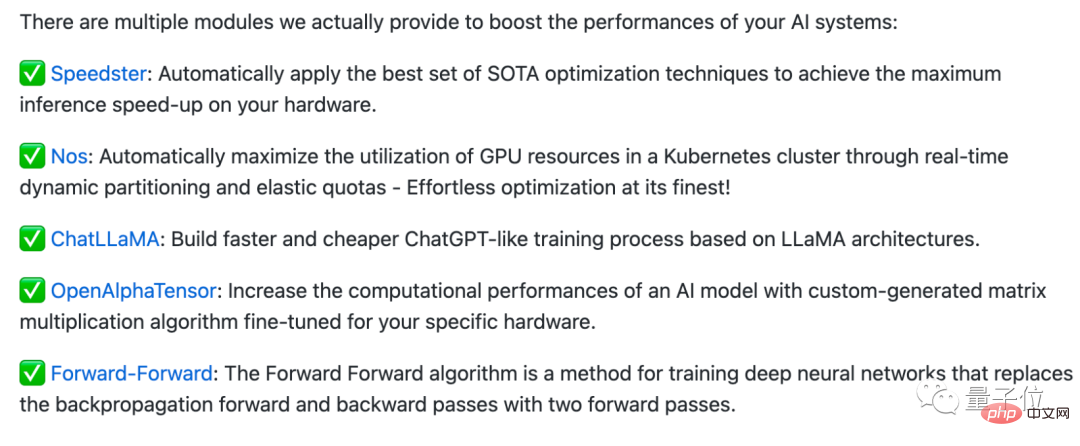

Nebuly AI telah membuat perpustakaan sumber terbuka yang dipanggil Nebullvm, yang menyepadukan satu siri modul pengoptimuman palam dan main untuk meningkatkan prestasi sistem AI.

Sebagai contoh, ini ialah beberapa modul yang disertakan dalam Nebullvm pada masa ini, termasuk OpenAlphaTensor berdasarkan algoritma AlphaTensor sumber terbuka DeepMind, modul pengoptimuman yang secara automatik mengesan perkakasan dan mempercepatkannya...

ChatLLaMA juga terdapat dalam siri modul ini, tetapi perlu diingatkan bahawa lesen sumber terbukanya tidak tersedia secara komersial.

Jadi, jika anda ingin menggunakan "ChatGPT yang dibangunkan sendiri domestik" secara langsung, ia mungkin tidak semudah itu (doge).

Setelah membaca projek ini, beberapa netizen berkata alangkah bagus jika seseorang benar-benar mendapat berat model (kod) LLaMA...

Tetapi Beberapa netizen juga menegaskan bahawa kenyataan "15 kali lebih cepat daripada kaedah latihan ChatGPT" adalah mengelirukan semata-mata:

Apa yang dipanggil 15 kali lebih cepat adalah hanya kerana model LLaMA itu sendiri sangat kecil dan malah boleh dijalankan pada satu GPU yang berjalan di atasnya, tetapi ia tidak sepatutnya kerana apa-apa yang dilakukan oleh projek ini, bukan?

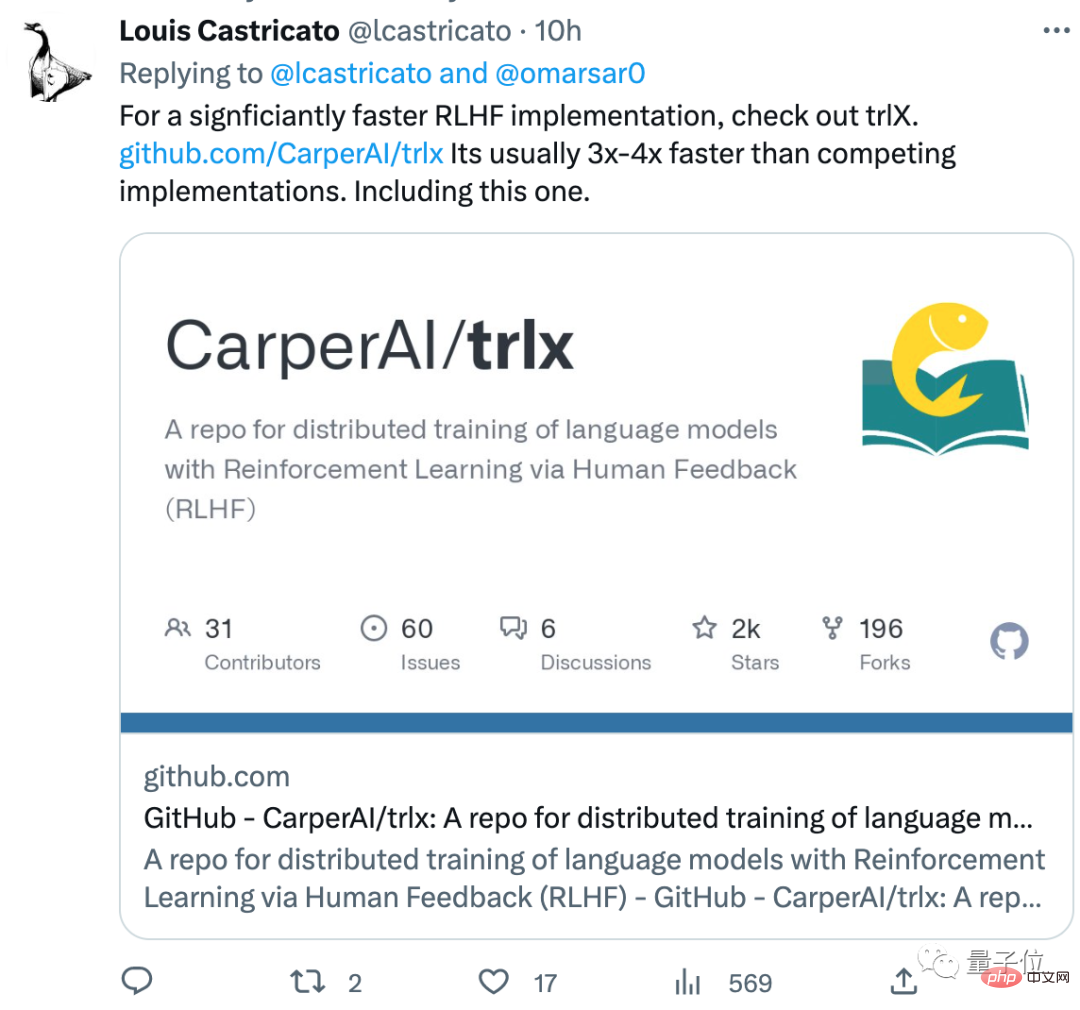

Netizen ini juga mengesyorkan kaedah latihan RLHF yang lebih baik daripada yang ada di perpustakaan, dipanggil trlx, dan kelajuan latihan lebih cepat daripada kaedah RLHF biasa . 3~4 kali:

Adakah anda mendapat kod untuk LLaMA? Apakah pendapat anda tentang kaedah latihan ini?

Alamat ChatLLaMA:https://www.php.cn/link/fed537780f3f29cc5d5f313bbda423c4

Pautan rujukan:https://www.php.cn/link/fe27f92b1e3f4997567807f38d567a35

Atas ialah kandungan terperinci Versi ringan kaedah latihan ChatGPT adalah sumber terbuka! Dibina di sekitar LLaMA dalam masa 3 hari sahaja, kelajuan latihan didakwa 15 kali lebih pantas daripada OpenAI. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1389

1389

52

52

Sumber terbuka! Di luar ZoeDepth! DepthFM: Anggaran kedalaman monokular yang cepat dan tepat!

Apr 03, 2024 pm 12:04 PM

Sumber terbuka! Di luar ZoeDepth! DepthFM: Anggaran kedalaman monokular yang cepat dan tepat!

Apr 03, 2024 pm 12:04 PM

0. Apakah fungsi artikel ini? Kami mencadangkan DepthFM: model anggaran kedalaman monokular generatif yang serba boleh dan pantas. Sebagai tambahan kepada tugas anggaran kedalaman tradisional, DepthFM juga menunjukkan keupayaan terkini dalam tugas hiliran seperti mengecat kedalaman. DepthFM cekap dan boleh mensintesis peta kedalaman dalam beberapa langkah inferens. Mari kita baca karya ini bersama-sama ~ 1. Tajuk maklumat kertas: DepthFM: FastMonocularDepthEstimationwithFlowMatching Pengarang: MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Apa yang perlu dilakukan jika kod skrin biru 0x0000001 berlaku

Feb 23, 2024 am 08:09 AM

Apa yang perlu dilakukan jika kod skrin biru 0x0000001 berlaku

Feb 23, 2024 am 08:09 AM

Apa yang perlu dilakukan dengan kod skrin biru 0x0000001 Ralat skrin biru adalah mekanisme amaran apabila terdapat masalah dengan sistem komputer atau perkakasan Kod 0x0000001 biasanya menunjukkan kegagalan perkakasan. Apabila pengguna tiba-tiba mengalami ralat skrin biru semasa menggunakan komputer mereka, mereka mungkin berasa panik dan rugi. Nasib baik, kebanyakan ralat skrin biru boleh diselesaikan dan ditangani dengan beberapa langkah mudah. Artikel ini akan memperkenalkan pembaca kepada beberapa kaedah untuk menyelesaikan kod ralat skrin biru 0x0000001. Pertama, apabila menghadapi ralat skrin biru, kita boleh cuba untuk memulakan semula

Hello, Atlas elektrik! Robot Boston Dynamics hidup semula, gerakan pelik 180 darjah menakutkan Musk

Apr 18, 2024 pm 07:58 PM

Hello, Atlas elektrik! Robot Boston Dynamics hidup semula, gerakan pelik 180 darjah menakutkan Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas secara rasmi memasuki era robot elektrik! Semalam, Atlas hidraulik hanya "menangis" menarik diri daripada peringkat sejarah Hari ini, Boston Dynamics mengumumkan bahawa Atlas elektrik sedang berfungsi. Nampaknya dalam bidang robot humanoid komersial, Boston Dynamics berazam untuk bersaing dengan Tesla. Selepas video baharu itu dikeluarkan, ia telah pun ditonton oleh lebih sejuta orang dalam masa sepuluh jam sahaja. Orang lama pergi dan peranan baru muncul. Ini adalah keperluan sejarah. Tidak dinafikan bahawa tahun ini adalah tahun letupan robot humanoid. Netizen mengulas: Kemajuan robot telah menjadikan majlis pembukaan tahun ini kelihatan seperti manusia, dan tahap kebebasan adalah jauh lebih besar daripada manusia Tetapi adakah ini benar-benar bukan filem seram? Pada permulaan video, Atlas berbaring dengan tenang di atas tanah, seolah-olah terlentang. Apa yang berikut adalah rahang-jatuh

Daya hidup kecerdasan super membangkitkan! Tetapi dengan kedatangan AI yang mengemas kini sendiri, ibu tidak perlu lagi bimbang tentang kesesakan data

Apr 29, 2024 pm 06:55 PM

Daya hidup kecerdasan super membangkitkan! Tetapi dengan kedatangan AI yang mengemas kini sendiri, ibu tidak perlu lagi bimbang tentang kesesakan data

Apr 29, 2024 pm 06:55 PM

Saya menangis hingga mati. Dunia sedang membina model besar. Data di Internet tidak mencukupi. Model latihan kelihatan seperti "The Hunger Games", dan penyelidik AI di seluruh dunia bimbang tentang cara memberi makan data ini kepada pemakan yang rakus. Masalah ini amat ketara dalam tugas berbilang modal. Pada masa mereka mengalami kerugian, pasukan pemula dari Jabatan Universiti Renmin China menggunakan model baharu mereka sendiri untuk menjadi yang pertama di China untuk menjadikan "suapan data yang dijana model itu sendiri" menjadi kenyataan. Selain itu, ia merupakan pendekatan serampang dua mata dari segi pemahaman dan sisi penjanaan Kedua-dua pihak boleh menjana data baharu berbilang modal yang berkualiti tinggi dan memberikan maklum balas data kepada model itu sendiri. Apakah model? Awaker 1.0, model berbilang modal besar yang baru sahaja muncul di Forum Zhongguancun. Siapa pasukan itu? Enjin Sophon. Diasaskan oleh Gao Yizhao, pelajar kedoktoran di Sekolah Kecerdasan Buatan Hillhouse Universiti Renmin.

Versi Kuaishou Sora 'Ke Ling' dibuka untuk ujian: menghasilkan video lebih 120-an, memahami fizik dengan lebih baik dan boleh memodelkan pergerakan kompleks dengan tepat

Jun 11, 2024 am 09:51 AM

Versi Kuaishou Sora 'Ke Ling' dibuka untuk ujian: menghasilkan video lebih 120-an, memahami fizik dengan lebih baik dan boleh memodelkan pergerakan kompleks dengan tepat

Jun 11, 2024 am 09:51 AM

Apa? Adakah Zootopia dibawa menjadi realiti oleh AI domestik? Didedahkan bersama-sama dengan video itu ialah model penjanaan video domestik berskala besar baharu yang dipanggil "Keling". Sora menggunakan laluan teknikal yang serupa dan menggabungkan beberapa inovasi teknologi yang dibangunkan sendiri untuk menghasilkan video yang bukan sahaja mempunyai pergerakan yang besar dan munasabah, tetapi juga mensimulasikan ciri-ciri dunia fizikal dan mempunyai keupayaan gabungan konsep dan imaginasi yang kuat. Mengikut data, Keling menyokong penjanaan video ultra panjang sehingga 2 minit pada 30fps, dengan resolusi sehingga 1080p dan menyokong berbilang nisbah aspek. Satu lagi perkara penting ialah Keling bukanlah demo atau demonstrasi hasil video yang dikeluarkan oleh makmal, tetapi aplikasi peringkat produk yang dilancarkan oleh Kuaishou, pemain terkemuka dalam bidang video pendek. Selain itu, tumpuan utama adalah untuk menjadi pragmatik, bukan untuk menulis cek kosong, dan pergi ke dalam talian sebaik sahaja ia dikeluarkan Model besar Ke Ling telah pun dikeluarkan di Kuaiying.

Tentera Udara A.S. mempamerkan jet pejuang AI pertamanya dengan profil tinggi! Menteri secara peribadi menjalankan pandu uji tanpa campur tangan semasa keseluruhan proses, dan 100,000 baris kod telah diuji selama 21 kali.

May 07, 2024 pm 05:00 PM

Tentera Udara A.S. mempamerkan jet pejuang AI pertamanya dengan profil tinggi! Menteri secara peribadi menjalankan pandu uji tanpa campur tangan semasa keseluruhan proses, dan 100,000 baris kod telah diuji selama 21 kali.

May 07, 2024 pm 05:00 PM

Baru-baru ini, bulatan tentera telah terharu dengan berita: jet pejuang tentera AS kini boleh melengkapkan pertempuran udara automatik sepenuhnya menggunakan AI. Ya, baru-baru ini, jet pejuang AI tentera AS telah didedahkan buat pertama kali, mendedahkan misterinya. Nama penuh pesawat pejuang ini ialah Variable Stability Simulator Test Aircraft (VISTA). Ia diterbangkan sendiri oleh Setiausaha Tentera Udara AS untuk mensimulasikan pertempuran udara satu lawan satu. Pada 2 Mei, Setiausaha Tentera Udara A.S. Frank Kendall berlepas menggunakan X-62AVISTA di Pangkalan Tentera Udara Edwards Ambil perhatian bahawa semasa penerbangan selama satu jam, semua tindakan penerbangan telah diselesaikan secara autonomi oleh AI! Kendall berkata - "Sejak beberapa dekad yang lalu, kami telah memikirkan tentang potensi tanpa had pertempuran udara-ke-udara autonomi, tetapi ia sentiasa kelihatan di luar jangkauan." Namun kini,

Program kod jauh universal GE pada mana-mana peranti

Mar 02, 2024 pm 01:58 PM

Program kod jauh universal GE pada mana-mana peranti

Mar 02, 2024 pm 01:58 PM

Jika anda perlu memprogramkan sebarang peranti dari jauh, artikel ini akan membantu anda. Kami akan berkongsi kod jauh universal GE teratas untuk pengaturcaraan sebarang peranti. Apakah alat kawalan jauh GE? GEUniversalRemote ialah alat kawalan jauh yang boleh digunakan untuk mengawal berbilang peranti seperti TV pintar, LG, Vizio, Sony, Blu-ray, DVD, DVR, Roku, AppleTV, pemain media penstriman dan banyak lagi. Alat kawalan jauh GEUniversal datang dalam pelbagai model dengan fungsi dan keupayaan yang berbeza. GEUniversalRemote boleh mengawal sehingga empat peranti. Kod Jauh Universal Teratas untuk Diprogramkan pada Mana-mana Peranti Alat kawalan jauh GE disertakan dengan set kod yang membolehkannya berfungsi dengan peranti yang berbeza. anda boleh

Dengan hanya $250, pengarah teknikal Hugging Face mengajar anda cara memperhalusi Llama 3

May 06, 2024 pm 03:52 PM

Dengan hanya $250, pengarah teknikal Hugging Face mengajar anda cara memperhalusi Llama 3

May 06, 2024 pm 03:52 PM

Model bahasa besar sumber terbuka yang biasa seperti Llama3 yang dilancarkan oleh model Meta, Mistral dan Mixtral yang dilancarkan oleh MistralAI, dan Jamba yang dilancarkan oleh AI21 Lab telah menjadi pesaing OpenAI. Dalam kebanyakan kes, pengguna perlu memperhalusi model sumber terbuka ini berdasarkan data mereka sendiri untuk melancarkan potensi model sepenuhnya. Tidak sukar untuk memperhalusi model bahasa besar (seperti Mistral) berbanding model kecil menggunakan Q-Learning pada GPU tunggal, tetapi penalaan halus yang cekap bagi model besar seperti Llama370b atau Mixtral kekal sebagai cabaran sehingga kini . Oleh itu, Philipp Sch, pengarah teknikal HuggingFace