Peranti teknologi

Peranti teknologi

AI

AI

Adakah ChatGPT benar-benar 'generalis'? Yang Di dan yang lain memberikannya ujian menyeluruh.

Adakah ChatGPT benar-benar 'generalis'? Yang Di dan yang lain memberikannya ujian menyeluruh.

Adakah ChatGPT benar-benar 'generalis'? Yang Di dan yang lain memberikannya ujian menyeluruh.

Pautan kertas: https://arxiv.org/pdf/2302.06476.pdf

Model bahasa berskala besar (LLM) telah terbukti mampu menyelesaikan pelbagai tugas pemprosesan bahasa semula jadi (NLP), dan untuk tugas hiliran yang diberikan, mereka tidak bergantung pada sebarang data latihan dan boleh mencapai penalaan model dengan bantuan gesaan yang sesuai. Keupayaan untuk melaksanakan tugas baharu atas arahan ini boleh dilihat sebagai langkah penting ke arah kecerdasan buatan am.

Walaupun LLM semasa mencapai prestasi yang baik dalam beberapa kes, ia masih terdedah kepada pelbagai ralat dalam pembelajaran sifar pukulan. Selain itu, format gesaan boleh memberi kesan yang besar. Contohnya, dengan menambahkan "Mari kita fikirkan langkah demi langkah" pada gesaan, prestasi model boleh diperbaiki dengan ketara. Had ini menggambarkan bahawa LLM semasa bukanlah sistem bahasa yang benar-benar universal.

Baru-baru ini, ChatGPT LLM yang dikeluarkan oleh OpenAI telah menarik perhatian besar dalam komuniti NLP. ChatGPT dicipta dengan melatih model siri GPT-3.5 melalui "Pembelajaran Pengukuhan dengan Maklum Balas Manusia (RLHF)". RLHF terutamanya terdiri daripada tiga langkah: menggunakan pembelajaran diselia untuk melatih model bahasa dan melatih model ganjaran berdasarkan keutamaan manusia dan menggunakan pembelajaran pengukuhan untuk mengoptimumkan model bahasa untuk model ganjaran; Dengan latihan RLHF, ChatGPT diperhatikan mempunyai keupayaan yang mengagumkan dalam pelbagai aspek, termasuk menjana respons berkualiti tinggi kepada input manusia, menolak soalan yang tidak sesuai dan membetulkan sendiri kesilapan sebelumnya berdasarkan perbualan seterusnya.

Walaupun ChatGPT menunjukkan keupayaan perbualan yang kuat, komuniti NLP masih tidak jelas sama ada ChatGPT mencapai keupayaan generalisasi sifar pukulan yang lebih baik berbanding LLM sedia ada. Untuk mengisi jurang penyelidikan ini, penyelidik secara sistematik mengkaji keupayaan pembelajaran sifar pukulan ChatGPT dengan menilainya pada sejumlah besar set data NLP yang meliputi 7 kategori tugasan perwakilan. Tugas-tugas ini termasuk penaakulan, inferens bahasa semula jadi, menjawab soalan (kefahaman membaca), dialog, rumusan, pengecaman entiti bernama, dan analisis sentimen. Dengan bantuan eksperimen yang meluas, penyelidik menyasarkan untuk menjawab soalan berikut:

- Adakah ChatGPT penyelesai tujuan umum untuk tugasan NLP? Apakah jenis tugas yang dilakukan oleh ChatGPT dengan baik?

- Jika ChatGPT ketinggalan berbanding model lain dalam beberapa tugasan, mengapa?

Untuk menjawab soalan-soalan ini, penulis membandingkan prestasi ChatGPT dan model GPT-3.5 (teks-davinci-003) yang terkini berdasarkan eksperimen. keputusan. Selain itu, mereka melaporkan hasil penalaan halus sifar, penalaan halus atau beberapa tangkapan hasil kerja terbaharu seperti FLAN, T0 dan PaLM.

Kesimpulan Utama

Pengarang menyatakan bahawa, setahu mereka, ini adalah kali pertama sesiapa telah mengulas tentang ChatGPT Keupayaan sifar pada pelbagai tugasan NLP dikaji, bertujuan untuk memberikan gambaran awal ChatGPT. Penemuan utama mereka adalah seperti berikut:

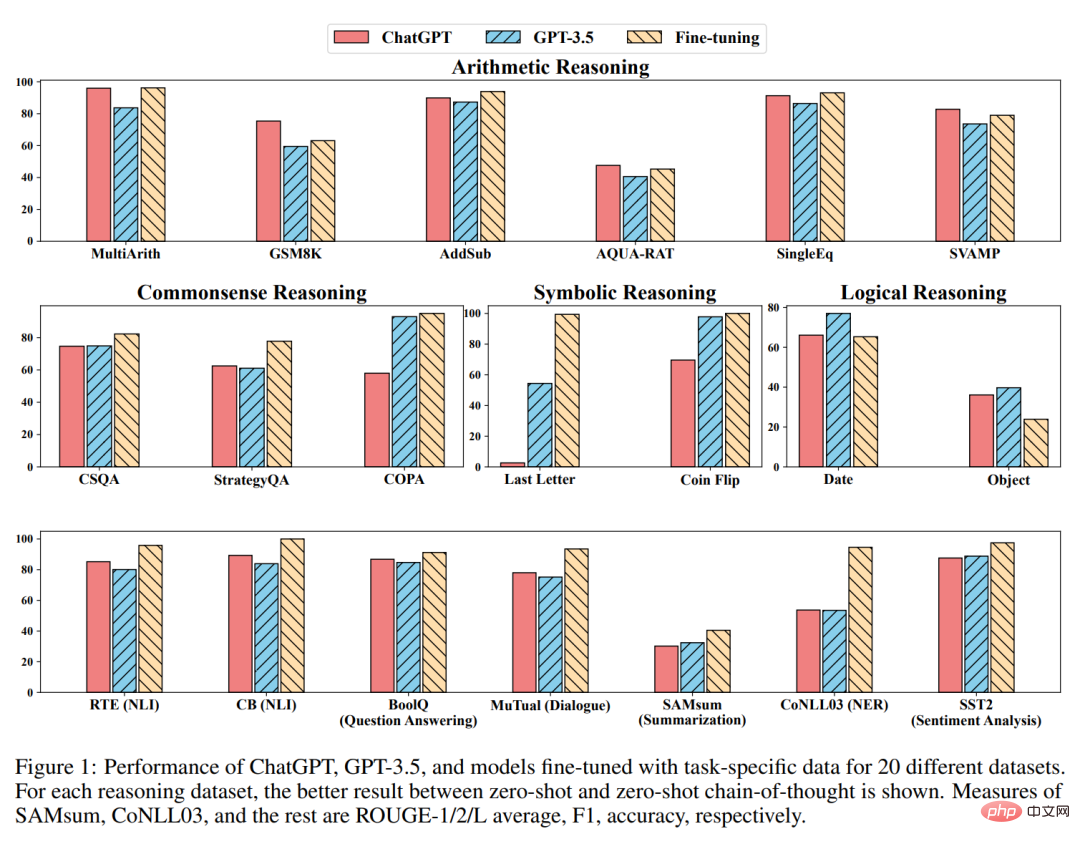

- Walaupun ChatGPT sebagai model generalis menunjukkan beberapa kebolehan untuk melaksanakan berbilang tugas, ia biasanya berprestasi lebih teruk daripada model yang diperhalusi untuk tugasan tertentu (lihat Rajah 1 dan Bahagian 4.3).

- Keupayaan penaakulan cemerlang ChatGPT telah disahkan secara eksperimen dalam tugasan penaakulan aritmetik (Bahagian 4.2.1). Walau bagaimanapun, ChatGPT secara amnya berprestasi lebih teruk daripada GPT-3.5 pada tugas penaakulan akal, simbolik dan logik, seperti yang boleh dilihat, sebagai contoh, dengan menjana respons yang tidak pasti (Bahagian 4.2.2).

- ChatGPT mengatasi GPT-3.5 dalam tugasan inferens bahasa semula jadi (Bahagian 4.2.3) dan tugasan soal jawab (pemahaman bacaan) (Bahagian 4.2.4) yang memihak kepada keupayaan penaakulan , seperti menentukan hubungan logik antara pasangan teks. Khususnya, ChatGPT lebih baik dalam memproses teks yang konsisten dengan fakta (iaitu, lebih baik dalam mengklasifikasikan implikasi daripada bukan implikasi).

- ChatGPT mengatasi GPT-3.5 dalam tugas perbualan (Bahagian 4.2.5).

- Dari segi tugasan ringkasan, ChatGPT menjana ringkasan yang lebih panjang dan berprestasi lebih teruk daripada GPT-3.5. Walau bagaimanapun, mengehadkan panjang ringkasan secara eksplisit dalam arahan sifar pukulan menjejaskan kualiti penghadaman, mengakibatkan prestasi berkurangan (Bahagian 4.2.6).

- Walaupun menunjukkan janji sebagai model umum, kedua-dua ChatGPT dan GPT-3.5 menghadapi cabaran pada tugas tertentu, seperti anotasi jujukan (Bahagian 4.2.7).

- Keupayaan analisis sentimen ChatGPT hampir dengan GPT-3.5 (Seksyen 4.2.8).

Kaedah

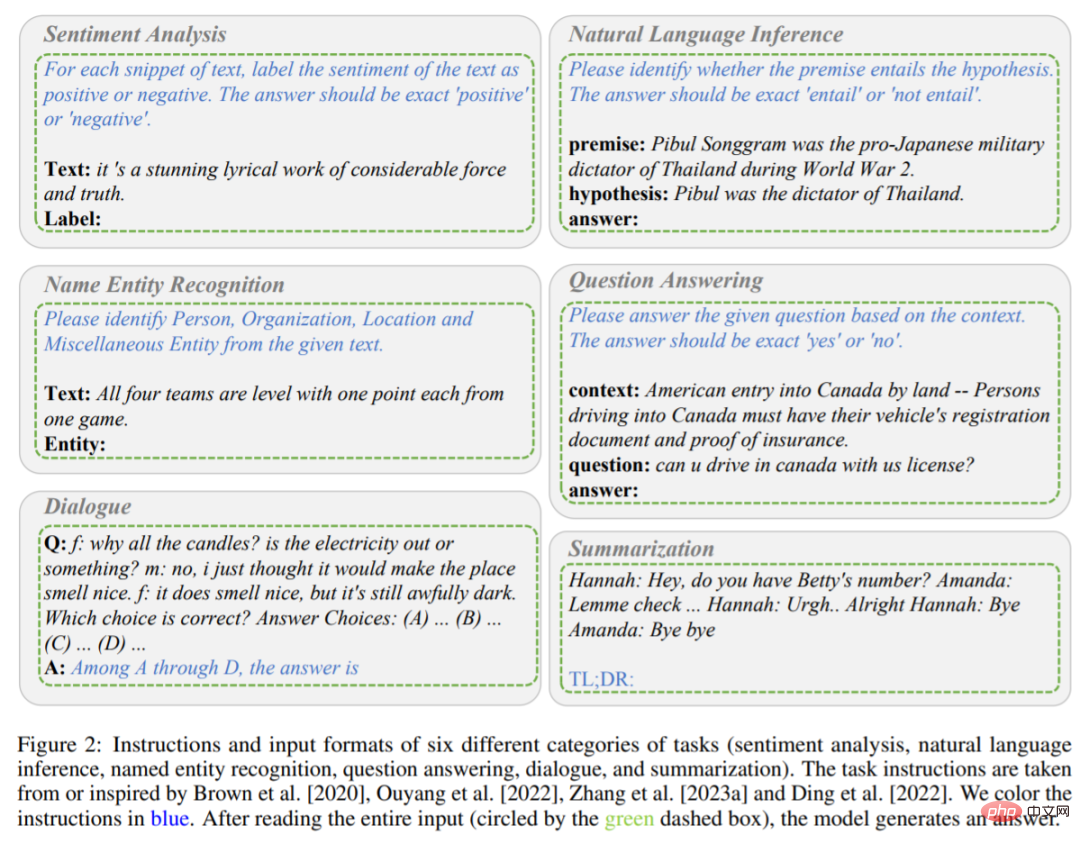

Seperti yang dinyatakan sebelum ini, kajian ini Ini kertas terutamanya membandingkan prestasi pembelajaran sifar pukulan ChatGPT dan GPT-3.5 (textdavinci-003) di bawah tugasan yang berbeza. Secara khusus, mereka mengambil arahan tugasan P dan menguji soalan X sebagai input, model diwakili oleh f, dan kemudian menjana teks sasaran Y = f (P, X) untuk menyelesaikan soalan ujian. Arahan dan format input untuk tugasan yang berbeza ditunjukkan dalam Rajah 2 dan 3.

Mengandungi enam tugasan (analisis sentimen, penaakulan bahasa semula jadi, pengecaman entiti bernama, soalan dan jawapan , dialog, dan ringkasan) arahan dan format input. Arahan adalah dalam fon biru.

Penerangan tugasan inferens.

Sebagai contoh, apabila model menjalankan tugas analisis sentimen, arahan tugasan P menandakan sentimen yang terkandung dalam teks sebagai positif atau negatif, dan jawapan output adalah Positif atau negatif. Apabila model membaca arahan P dan kandungan input X (kandungan itu adalah karya lirik yang menakjubkan dengan kuasa dan ketulenan yang besar), model itu dinilai dijangka menghasilkan Y positif.

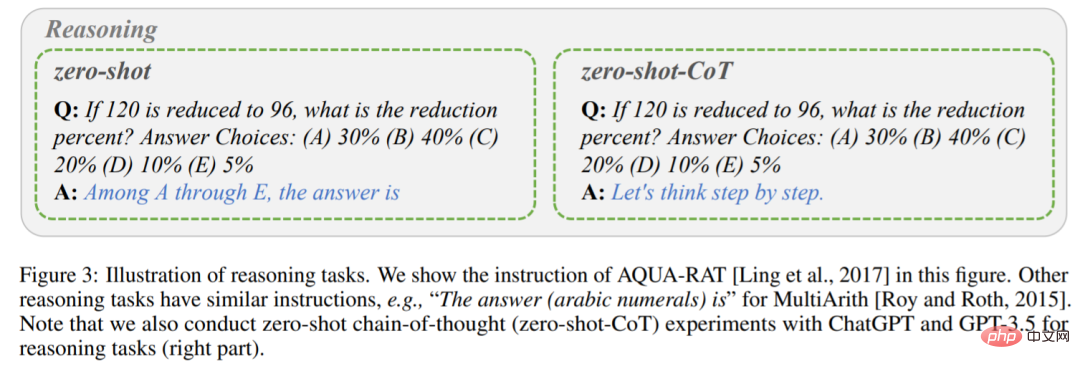

Berbeza daripada kaedah dorongan satu peringkat di atas, kajian ini menggunakan dorongan dua peringkat (yang dicadangkan oleh Kojima et al.) untuk melengkapkan zero-shot-CoT.

Peringkat pertama menerima pakai "Mari kita fikir langkah demi langkah", dan arahan P_1 mendorong prinsip asas R penjanaan model.

Peringkat kedua menggunakan prinsip asas R yang dijana dalam langkah pertama serta input asal X dan arahan P_1 sebagai input baharu untuk membimbing model menjana jawapan akhir.

diikuti dengan arahan baharu P_2 sebagai pernyataan pencetus untuk mengekstrak jawapan. Semua arahan tugas diambil daripada atau diilhamkan oleh penyelidikan Brown, Ouyang, Zhang, et al. Satu perkara terakhir yang perlu diambil perhatian ialah setiap kali anda membuat pertanyaan baharu kepada ChatGPT, anda perlu mengosongkan perbualan terlebih dahulu untuk mengelakkan kesan daripada contoh sebelumnya.

Eksperimen

Percubaan menilai ChatGPT dan GPT-3.5 pada 20 set data berbeza, meliputi 7 kategori tugasan.

Penaakulan Aritmetik

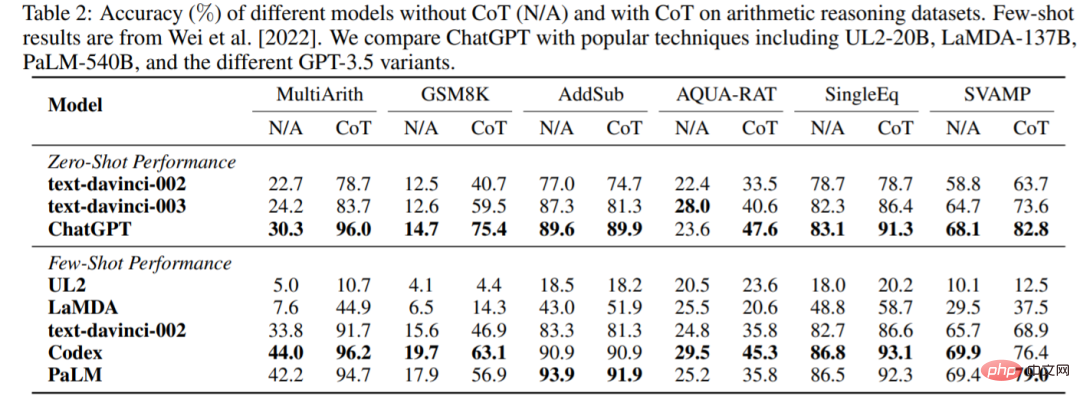

Ketepatan ChatGPT dan GPT-3.5 tanpa atau dengan CoT pada enam set data penaakulan aritmetik ditunjukkan dalam Jadual 2. Dalam eksperimen tanpa CoT, ChatGPT mengatasi GPT-3.5 pada 5 set data, menunjukkan keupayaan penaakulan aritmetiknya yang kukuh.

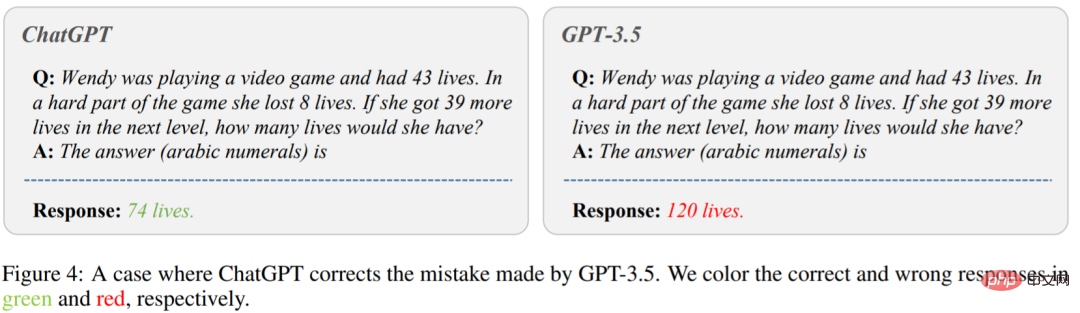

Rajah 4 menunjukkan kes di mana GPT-3.5 memberikan jawapan yang salah. Di sebelah kiri gambar, tanya "Wendy sedang bermain permainan video dan mempunyai 43 nyawa. Semasa sukar dalam permainan itu, dia kehilangan 8 nyawa. Jika dia mendapat 39 nyawa lagi di peringkat seterusnya, berapa banyak nyawa yang akan dia ada ?”ChatGPT memberikan jawapan yang betul. Walau bagaimanapun, GPT-3.5 menghasilkan jawapan yang salah. Dapat dilihat bahawa ChatGPT berprestasi jauh lebih baik daripada GPT-3.5 apabila menggunakan CoT.

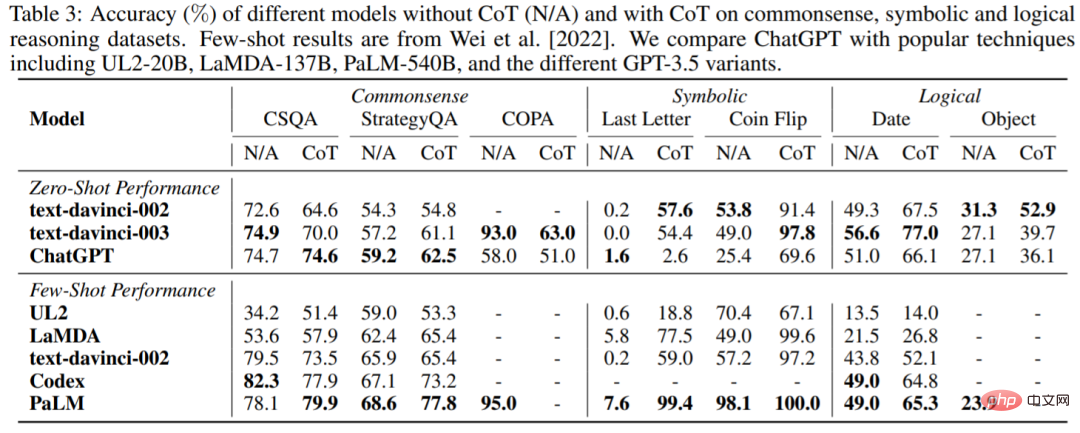

Akal budi, simbol dan penaakulan logik

Jadual 3 melaporkan ketepatan ChatGPT dan LLM popular mengenai set data penaakulan akal, simbolik dan logik. Pemerhatian berikut boleh dibuat: Pertama, menggunakan CoT mungkin tidak selalu memberikan prestasi yang lebih baik dalam tugas penaakulan akal, yang mungkin memerlukan pengetahuan latar belakang yang lebih terperinci. Kedua, tidak seperti penaakulan aritmetik, ChatGPT berprestasi lebih teruk daripada GPT-3.5 dalam banyak kes, menunjukkan bahawa GPT-3.5 mempunyai keupayaan sepadan yang lebih kuat.

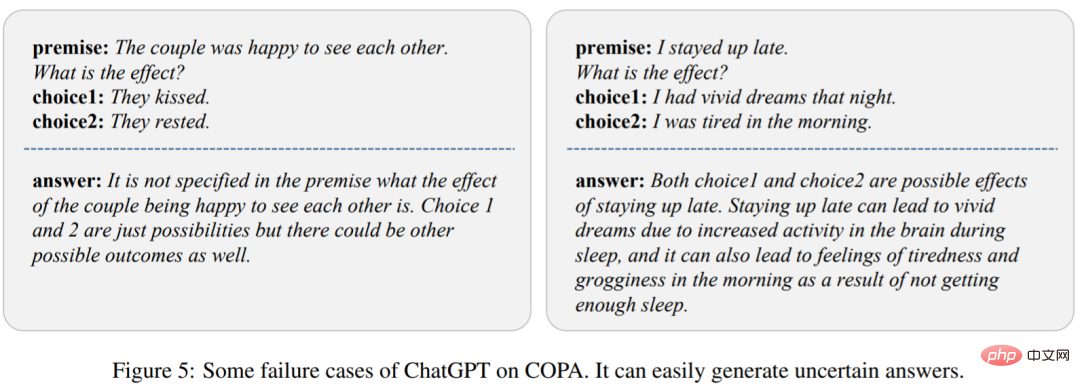

Untuk menganalisis sebab, kajian menunjukkan beberapa kes kegagalan ChatGPT dalam Rajah 5. Kami dapat melihat bahawa ChatGPT boleh menghasilkan respons yang tidak ditentukan dengan mudah, yang membawa kepada prestasi yang lemah.

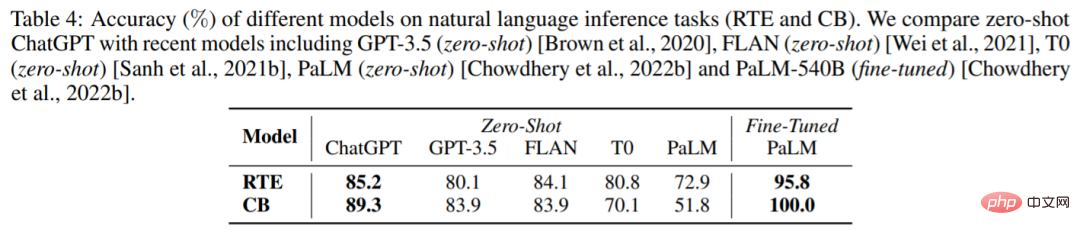

Penaakulan Bahasa Asli

Jadual 4 menunjukkan keputusan model berbeza pada dua tugas penaakulan bahasa semula jadi: RTE dan CB. Kita dapat melihat bahawa di bawah tetapan tangkapan sifar, ChatGPT boleh mencapai prestasi yang lebih baik daripada GPT-3.5, FLAN, T0 dan PaLM. Ini membuktikan bahawa ChatGPT mempunyai prestasi sifar pukulan yang lebih baik dalam tugas penaakulan NLP.

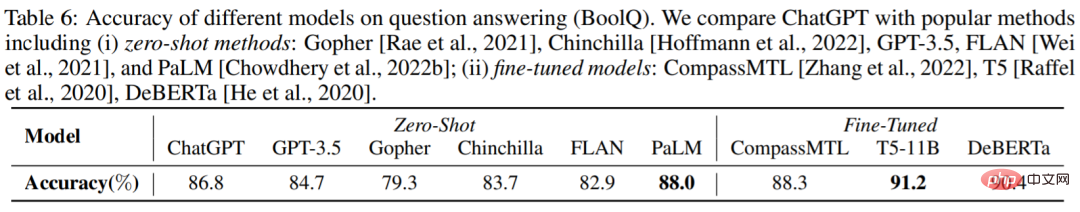

Soalan Jawab

Jadual 6 melaporkan ketepatan model yang berbeza pada set data BoolQ dan ChatGPT lebih baik daripada GPT-3.5. Ini menunjukkan bahawa ChatGPT boleh mengendalikan tugas penaakulan dengan lebih baik.

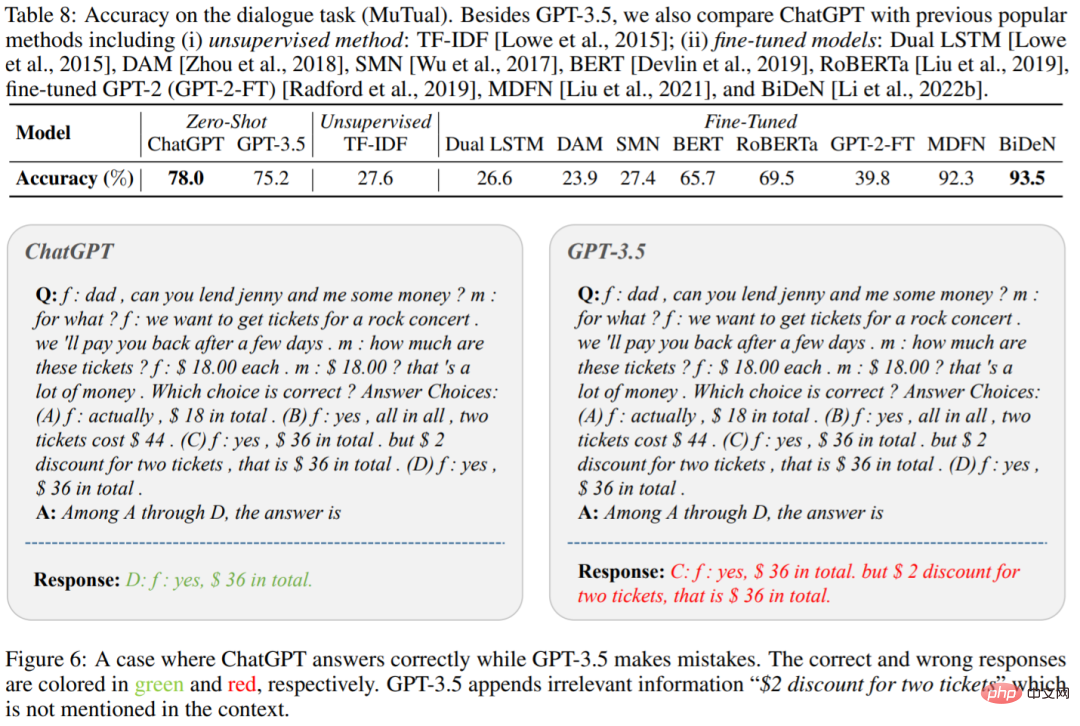

Dialog

Jadual 8 menunjukkan ketepatan ChatGPT dan GPT-3.5 pada set data MuTual (penaakulan perbualan berbilang pusingan). Seperti yang dijangkakan, ChatGPT mengatasi GPT-3.5 dengan ketara.

Rajah 6 ialah contoh khusus, kita dapat melihat bahawa ChatGPT boleh menaakul dengan lebih berkesan untuk konteks tertentu. Ini sekali lagi mengesahkan keupayaan penaakulan hebat ChatGPT.

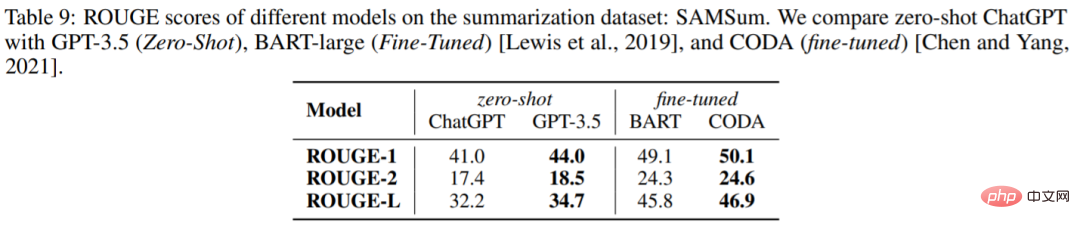

Jana Ringkasan

Jadual 9 melaporkan skor ROUGE ChatGPT dan GPT-3.5 pada set data SAMSum Secara mengejutkan, ChatGPT adalah lebih rendah daripada GPT-3.5 pada semua metrik.

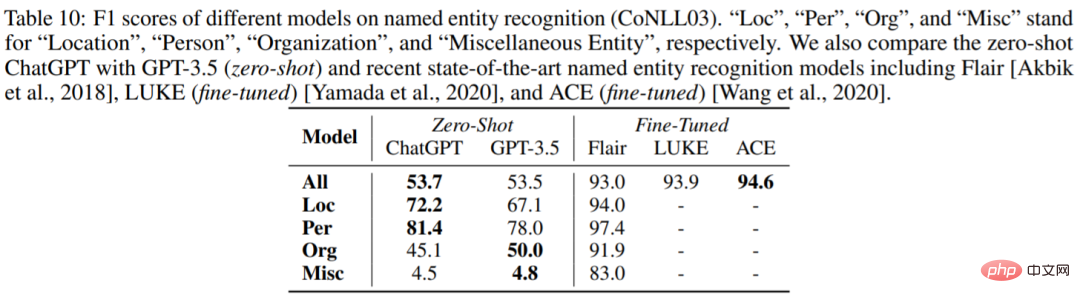

Pengiktirafan entiti bernama

Jadual 10 melaporkan prestasi sifar pukulan ChatGPT dan GPT-3.5 pada CoNLL03. Kita dapat melihat bahawa prestasi keseluruhan ChatGPT dan GPT-3.5 adalah sangat serupa.

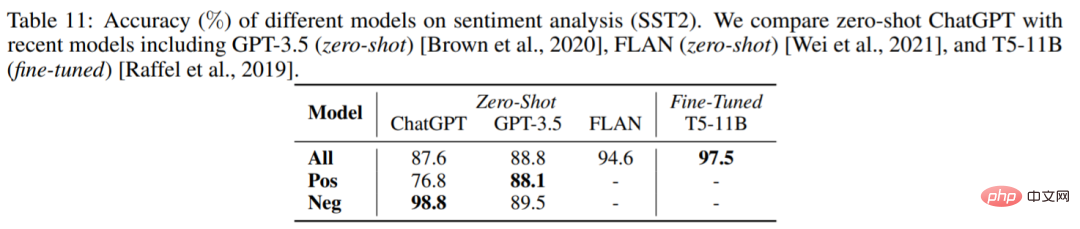

Analisis Sentimen

Jadual 11 membandingkan ketepatan model berbeza pada set data analisis sentimen SST2. Yang mengejutkan, ChatGPT berprestasi kira-kira 1% lebih teruk daripada GPT-3.5.

Untuk maklumat lanjut, sila rujuk kertas asal.

Atas ialah kandungan terperinci Adakah ChatGPT benar-benar 'generalis'? Yang Di dan yang lain memberikannya ujian menyeluruh.. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1377

1377

52

52

ChatGPT kini membenarkan pengguna percuma menjana imej dengan menggunakan DALL-E 3 dengan had harian

Aug 09, 2024 pm 09:37 PM

ChatGPT kini membenarkan pengguna percuma menjana imej dengan menggunakan DALL-E 3 dengan had harian

Aug 09, 2024 pm 09:37 PM

DALL-E 3 telah diperkenalkan secara rasmi pada September 2023 sebagai model yang jauh lebih baik daripada pendahulunya. Ia dianggap sebagai salah satu penjana imej AI terbaik setakat ini, mampu mencipta imej dengan perincian yang rumit. Walau bagaimanapun, semasa pelancaran, ia adalah tidak termasuk

Gabungan sempurna ChatGPT dan Python: mencipta chatbot perkhidmatan pelanggan yang pintar

Oct 27, 2023 pm 06:00 PM

Gabungan sempurna ChatGPT dan Python: mencipta chatbot perkhidmatan pelanggan yang pintar

Oct 27, 2023 pm 06:00 PM

Gabungan sempurna ChatGPT dan Python: Mencipta Perkhidmatan Pelanggan Pintar Chatbot Pengenalan: Dalam era maklumat hari ini, sistem perkhidmatan pelanggan pintar telah menjadi alat komunikasi yang penting antara perusahaan dan pelanggan. Untuk memberikan pengalaman perkhidmatan pelanggan yang lebih baik, banyak syarikat telah mula beralih kepada chatbots untuk menyelesaikan tugas seperti perundingan pelanggan dan menjawab soalan. Dalam artikel ini, kami akan memperkenalkan cara menggunakan bahasa ChatGPT dan Python model OpenAI yang berkuasa untuk mencipta bot sembang perkhidmatan pelanggan yang pintar untuk meningkatkan

Bagaimana untuk memasang chatgpt pada telefon bimbit

Mar 05, 2024 pm 02:31 PM

Bagaimana untuk memasang chatgpt pada telefon bimbit

Mar 05, 2024 pm 02:31 PM

Langkah pemasangan: 1. Muat turun perisian ChatGTP dari laman web rasmi ChatGTP atau kedai mudah alih 2. Selepas membukanya, dalam antara muka tetapan, pilih bahasa sebagai bahasa Cina 3. Dalam antara muka permainan, pilih permainan mesin manusia dan tetapkan Spektrum bahasa Cina; 4 Selepas memulakan, masukkan arahan dalam tetingkap sembang untuk berinteraksi dengan perisian.

Bagaimana untuk membangunkan chatbot pintar menggunakan ChatGPT dan Java

Oct 28, 2023 am 08:54 AM

Bagaimana untuk membangunkan chatbot pintar menggunakan ChatGPT dan Java

Oct 28, 2023 am 08:54 AM

Dalam artikel ini, kami akan memperkenalkan cara membangunkan chatbot pintar menggunakan ChatGPT dan Java, dan menyediakan beberapa contoh kod khusus. ChatGPT ialah versi terkini Generative Pre-training Transformer yang dibangunkan oleh OpenAI, teknologi kecerdasan buatan berasaskan rangkaian saraf yang boleh memahami bahasa semula jadi dan menjana teks seperti manusia. Menggunakan ChatGPT kami boleh membuat sembang adaptif dengan mudah

Bolehkah chatgpt digunakan di China?

Mar 05, 2024 pm 03:05 PM

Bolehkah chatgpt digunakan di China?

Mar 05, 2024 pm 03:05 PM

chatgpt boleh digunakan di China, tetapi tidak boleh didaftarkan, begitu juga di Hong Kong dan Macao Jika pengguna ingin mendaftar, mereka boleh menggunakan nombor telefon mudah alih asing untuk mendaftar. Perhatikan bahawa semasa proses pendaftaran, persekitaran rangkaian mesti ditukar IP asing.

Cara menggunakan ChatGPT dan Python untuk melaksanakan fungsi pengecaman niat pengguna

Oct 27, 2023 am 09:04 AM

Cara menggunakan ChatGPT dan Python untuk melaksanakan fungsi pengecaman niat pengguna

Oct 27, 2023 am 09:04 AM

Cara menggunakan ChatGPT dan Python untuk melaksanakan fungsi pengecaman niat pengguna Pengenalan: Dalam era digital hari ini, teknologi kecerdasan buatan secara beransur-ansur menjadi bahagian yang amat diperlukan dalam pelbagai bidang. Antaranya, pembangunan teknologi pemprosesan bahasa semula jadi (Natural Language Processing, NLP) membolehkan mesin memahami dan memproses bahasa manusia. ChatGPT (Chat-GeneratingPtrainedTransformer) ialah sejenis

Bagaimana untuk membina robot perkhidmatan pelanggan pintar menggunakan PHP ChatGPT

Oct 28, 2023 am 09:34 AM

Bagaimana untuk membina robot perkhidmatan pelanggan pintar menggunakan PHP ChatGPT

Oct 28, 2023 am 09:34 AM

Cara menggunakan ChatGPTPHP untuk membina robot perkhidmatan pelanggan yang pintar Pengenalan: Dengan perkembangan teknologi kecerdasan buatan, robot semakin digunakan dalam bidang perkhidmatan pelanggan. Menggunakan ChatGPTPHP untuk membina robot perkhidmatan pelanggan yang pintar boleh membantu syarikat menyediakan perkhidmatan pelanggan yang lebih cekap dan diperibadikan. Artikel ini akan memperkenalkan cara menggunakan ChatGPTPHP untuk membina robot perkhidmatan pelanggan yang pintar dan menyediakan contoh kod khusus. 1. Pasang ChatGPTPHP dan gunakan ChatGPTPHP untuk membina robot perkhidmatan pelanggan yang pintar.

Bagaimana untuk membangunkan pembantu suara berasaskan AI menggunakan ChatGPT dan Java

Oct 27, 2023 pm 06:09 PM

Bagaimana untuk membangunkan pembantu suara berasaskan AI menggunakan ChatGPT dan Java

Oct 27, 2023 pm 06:09 PM

Cara menggunakan ChatGPT dan Java untuk membangunkan pembantu suara berasaskan kecerdasan buatan Perkembangan pesat kecerdasan buatan (Pendek kata Artificial Intelligence, AI) telah memasuki pelbagai bidang, antaranya pembantu suara adalah salah satu aplikasi yang popular. Dalam artikel ini, kami akan memperkenalkan cara membangunkan pembantu suara berasaskan kecerdasan buatan menggunakan ChatGPT dan Java. ChatGPT ialah projek sumber terbuka untuk interaksi melalui bahasa semula jadi, dibangunkan oleh OpenAI, sebuah institusi penyelidikan AI.