Matlamat penting kecerdasan buatan adalah untuk membangunkan model dengan keupayaan generalisasi yang kuat. Dalam bidang pemprosesan bahasa semula jadi (NLP), model bahasa pra-latihan telah mencapai kemajuan yang ketara dalam hal ini. Model sedemikian selalunya diperhalusi untuk menyesuaikan diri dengan tugasan baharu.

Baru-baru ini, penyelidik daripada Google menganalisis pelbagai kaedah penalaan halus arahan, termasuk kesan sambungan pada penalaan halus arahan. Eksperimen menunjukkan bahawa penalaan halus arahan sememangnya boleh berskala dengan baik mengikut bilangan tugasan dan saiz model Model sehingga 540 bilion parameter boleh mendapat manfaat dengan ketara. Di samping itu, kajian ini juga menganalisis kesan penalaan halus terhadap keupayaan model untuk melakukan inferens, dan hasilnya sangat menarik.

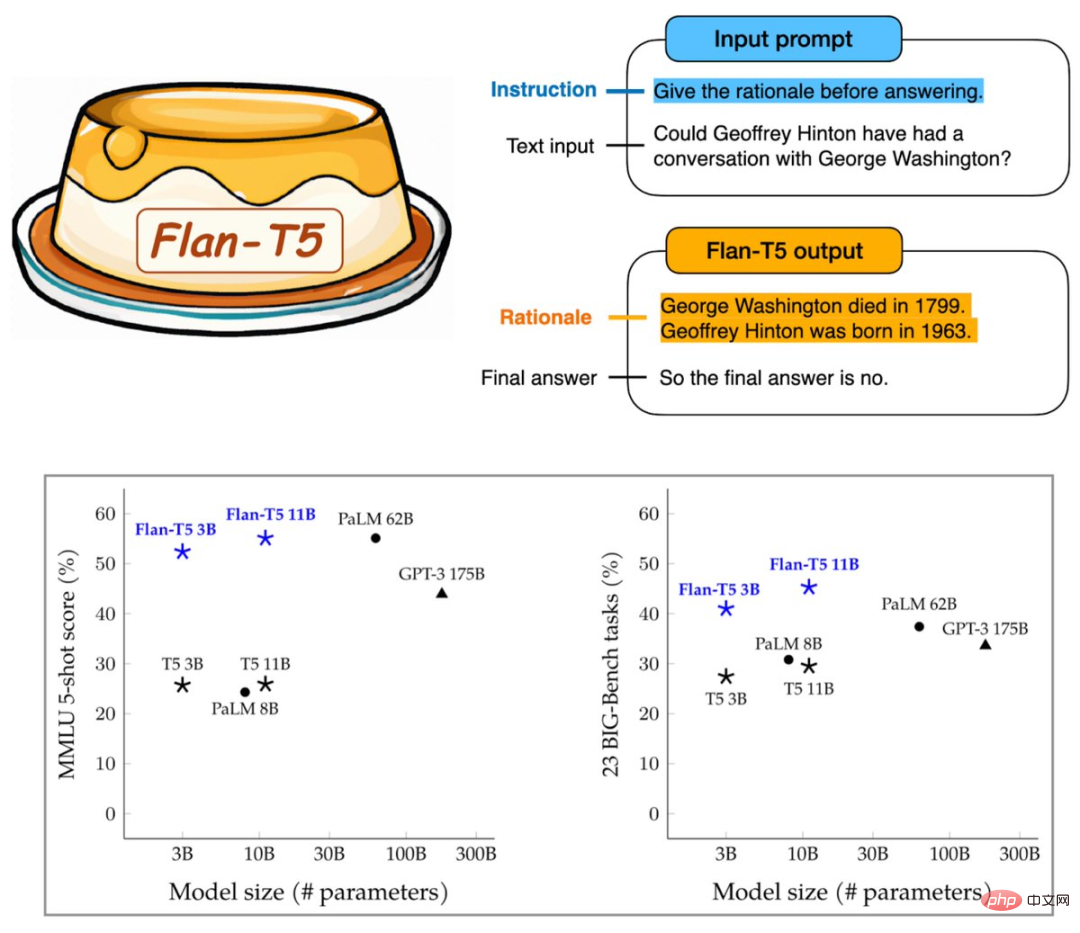

Flan-T5 yang terhasil mempunyai arahan yang diperhalusi untuk lebih daripada 1,800 tugasan bahasa, meningkatkan dengan ketara keupayaan penaakulan pantas dan berbilang langkah Ia boleh melebihi GPT- 3 daripada 175 bilion parameter.

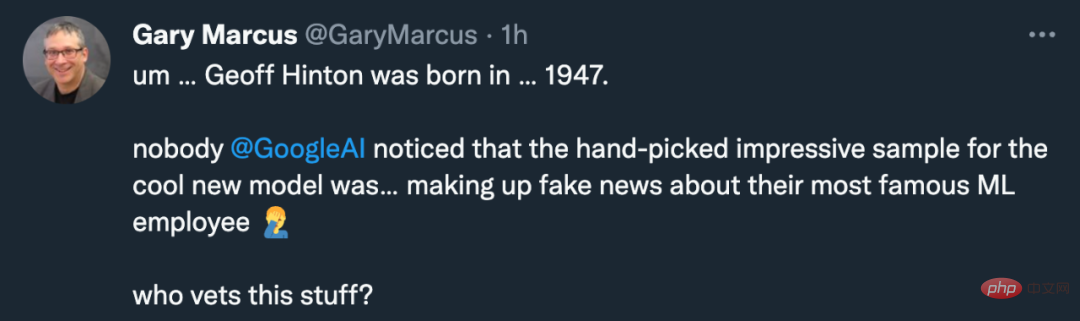

Nampaknya Google telah menemui cara lain untuk meningkatkan keupayaan model besar. Walau bagaimanapun, penyelidikan ini bukan sahaja mendapat sambutan daripada komuniti pembelajaran mesin, tetapi juga aduan Gary Marcus:

Model Google Mengapakah tarikh lahir saintis terkenal Google sendiri Geoffrey Hinton tersilap? Jelas sekali, dia seorang pemasa lama yang dilahirkan pada tahun 1947.

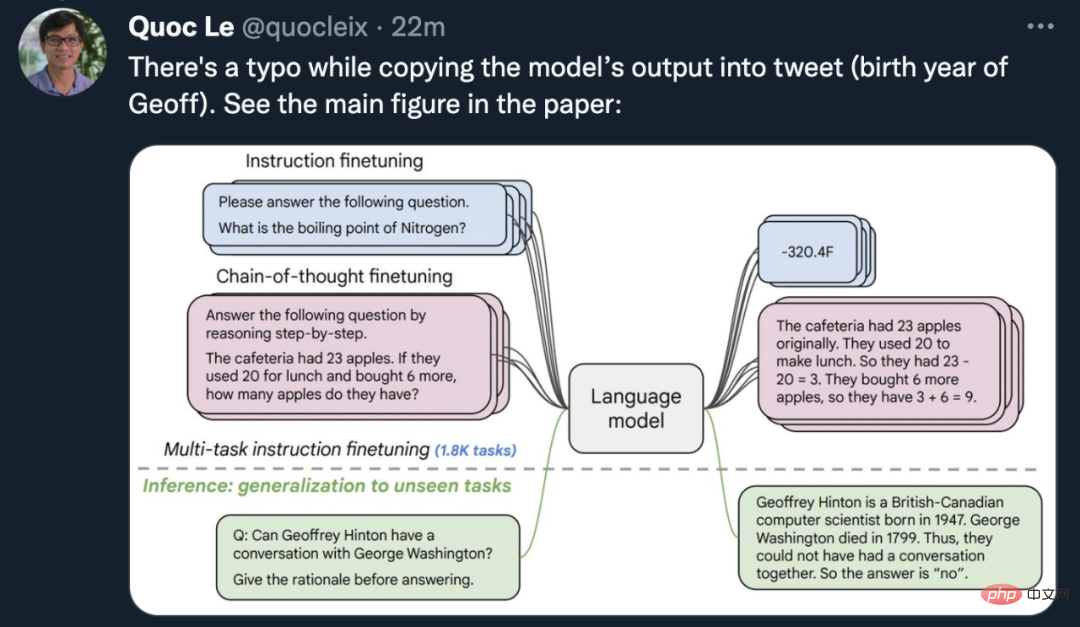

Quoc Le, ketua saintis Google Brain dan salah seorang pengarang kertas itu, segera keluar untuk membetulkan keadaan: gambar pekerja sementara itu salah , dan model Flan-T5 tidak disertakan dalam kertas saya salah tarikh lahir Geoff, dan ada gambar untuk membuktikannya.

By the way, sarjana AI terkenal yang lahir pada tahun 1963 ialah Jürgen Schmidhuber.

Memandangkan kesalahannya bukan model AI, mari lihat perubahan yang boleh dibawa oleh kaedah baharu Google kepada model pra-latihan.

Kertas: Menskalakan Model Bahasa Pengajaran-Diperhalusi

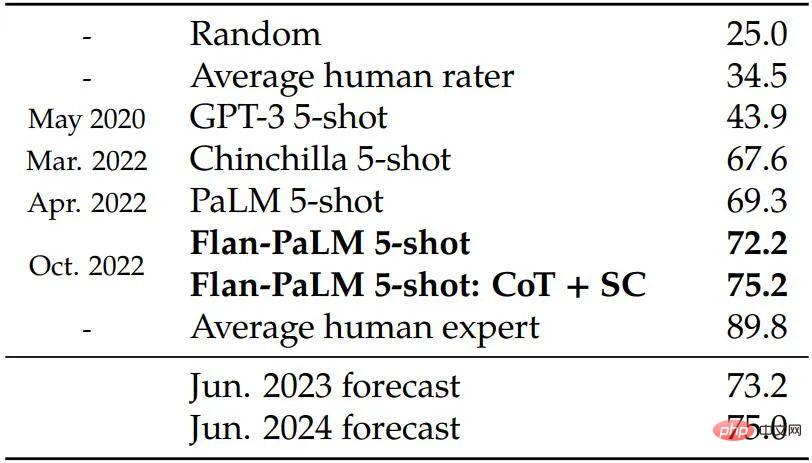

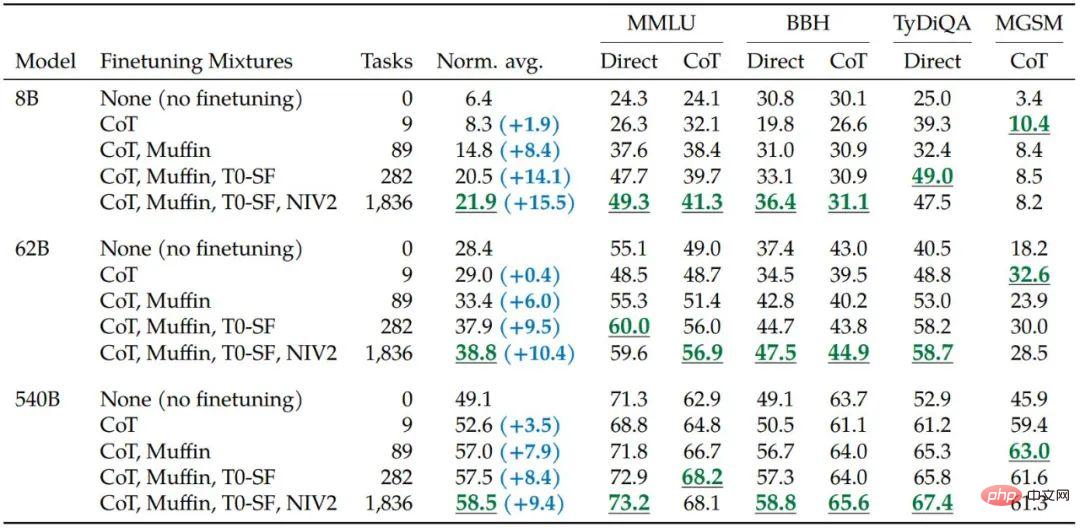

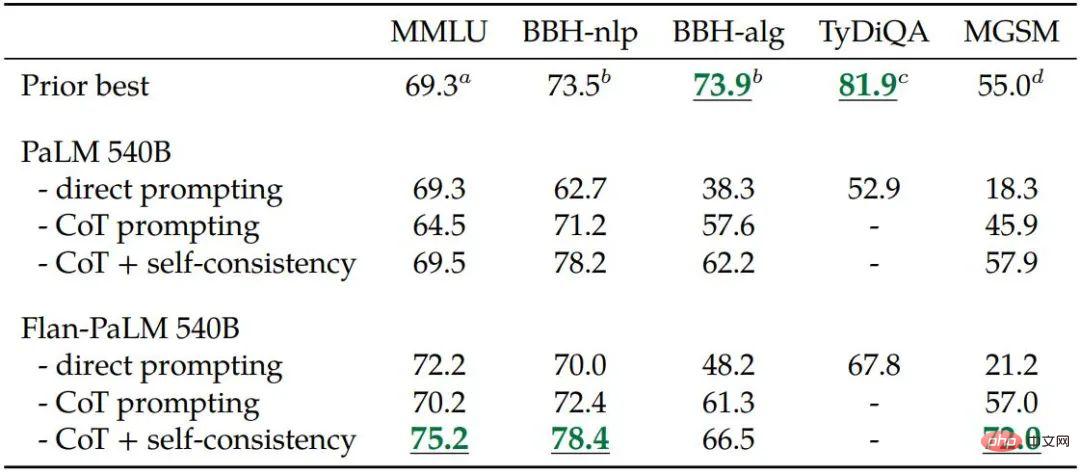

Kajian ini menggunakan parameter 540B model Untuk melatih Flan-PaLM, tingkatkan bilangan tugasan penalaan halus kepada lebih 1800 dan masukkan data Rantaian Pemikiran (CoT; Wei et al., 2022b). Flan-PaLM terlatih mengatasi prestasi PaLM dan mencapai SOTA baharu pada pelbagai penanda aras. Dari segi keupayaan penaakulan, Flan-PaLM dapat memanfaatkan CoT dan ketekalan diri (Wang et al., 2022c) untuk mencapai ketepatan 75.2% pada pemahaman bahasa berbilang tugas berskala besar (MMLU; Hendrycks et al., 2020) Kadar.

Tambahan pula, Flan-PaLM menunjukkan prestasi yang lebih baik daripada PaLM dalam satu set masalah generatif terbuka yang mencabar, dengan kebolehgunaan yang dipertingkatkan dengan ketara.

Secara keseluruhan, kajian Google ini menggambarkan cara khusus untuk menggunakan penalaan halus arahan untuk meningkatkan prestasi model.

Secara khususnya, penyelidikan ini tertumpu kepada beberapa aspek yang mempengaruhi penalaan halus pengajaran, termasuk: (1) memperluaskan bilangan tugas, (2) memperluaskan saiz model , dan (3) memperhalusi data rantaian pemikiran.

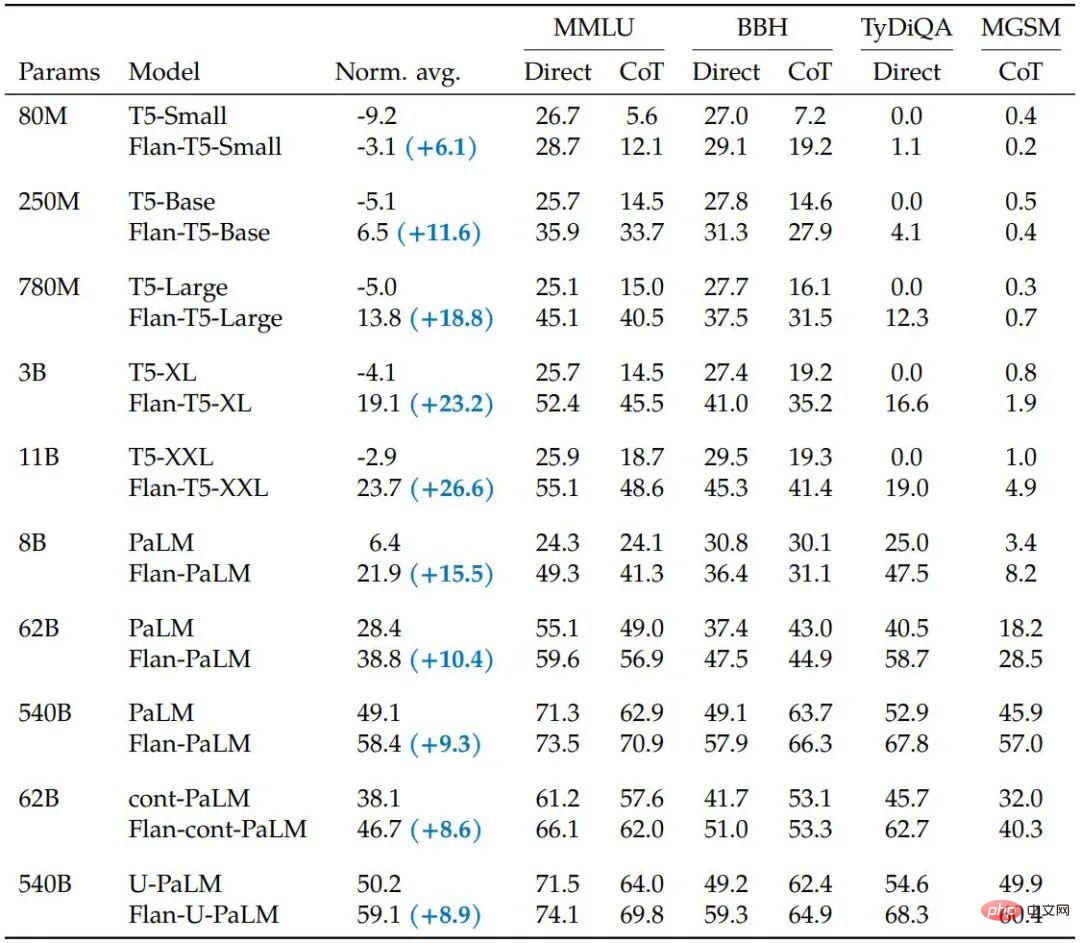

Kajian mendapati bahawa penalaan halus arahan dengan aspek di atas telah meningkatkan dengan ketara pelbagai kelas model (PaLM, T5, U-PaLM), tetapan gesaan (sifar tangkapan, beberapa tangkapan, CoT) dan penanda aras penilaian ( MMLU, BBH, TyDiQA, MGSM, generasi terbuka). Contohnya, Flan-PaLM 540B dengan penalaan halus arahan dengan ketara mengatasi prestasi PALM 540B pada 1.8K tugasan (+9.4% secara purata). Flan-PaLM 540B mencapai prestasi terkini pada beberapa penanda aras, seperti 75.2% pada lima MMLU.

Para penyelidik juga mendedahkan pusat pemeriksaan Flan-T5, yang mencapai prestasi beberapa pukulan yang kuat walaupun jika dibandingkan dengan model yang lebih besar seperti PaLM 62B. Secara keseluruhannya, penalaan halus arahan ialah pendekatan umum untuk meningkatkan prestasi dan kebolehgunaan model bahasa pra-latihan.

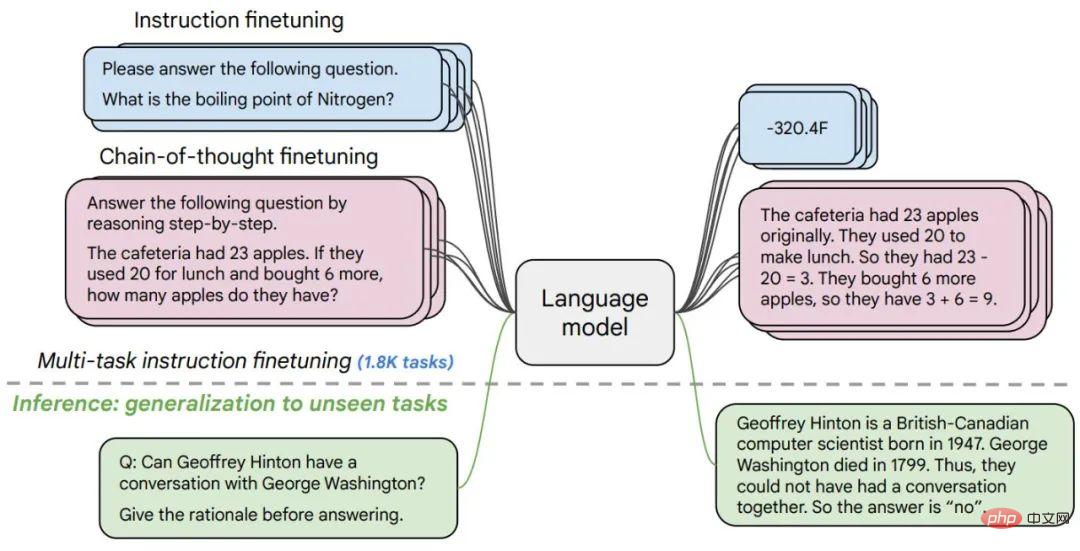

Rajah 1. Penyelidik telah memperhalusi pelbagai model bahasa dalam lebih daripada 1,800 tugasan sampel (sifar dan beberapa sampel) dan dengan/tanpa rantai pemikiran membolehkan generalisasi merentasi pelbagai senario penilaian.

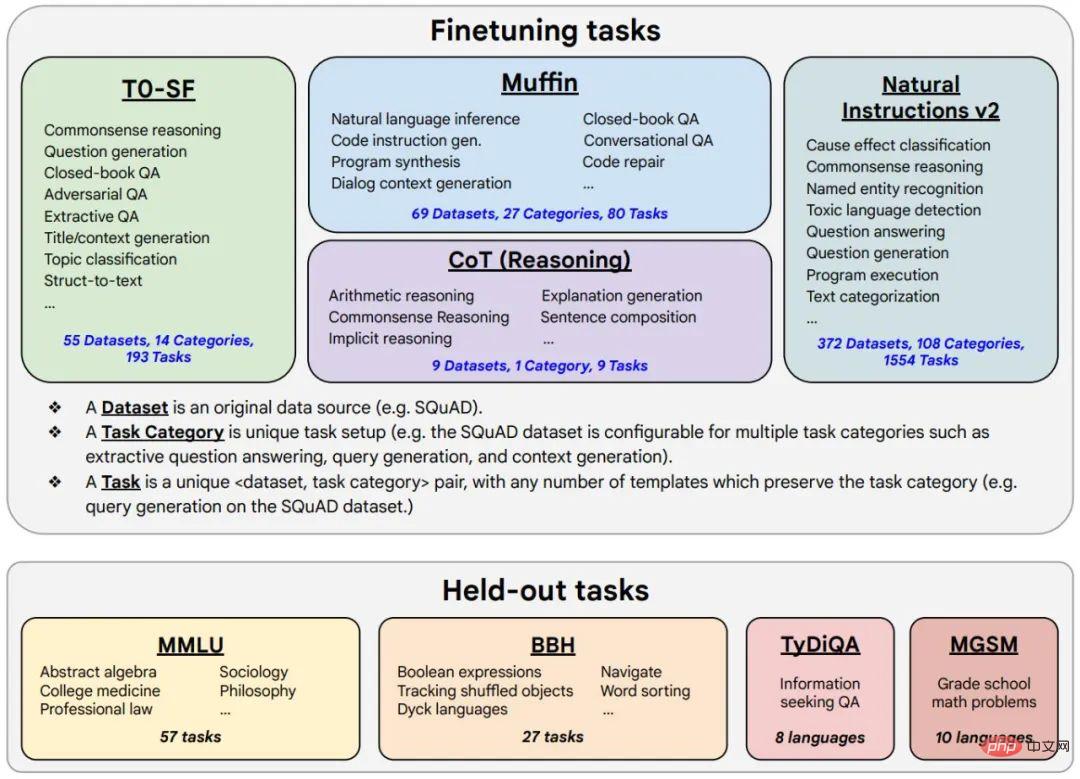

Rajah 2. Data penalaan halus merangkumi 473 set data, 146 kategori tugas dan sejumlah 1836 tugasan.

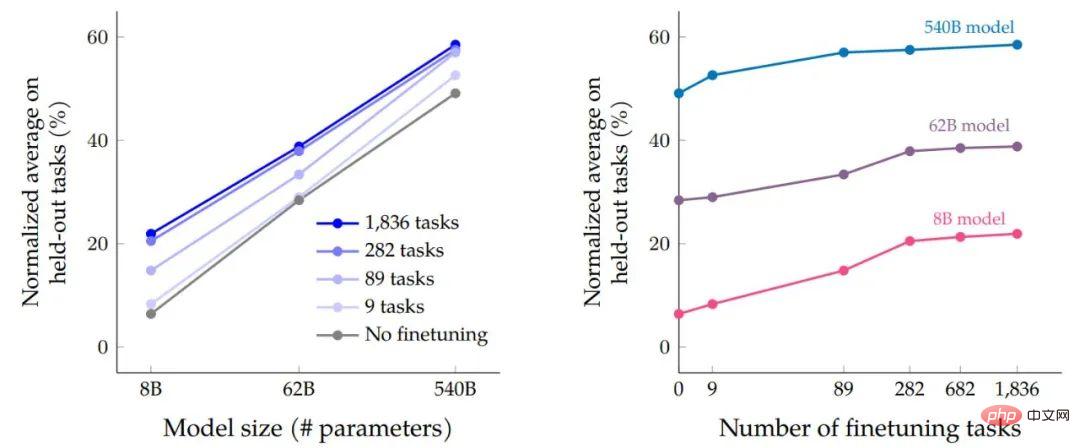

Selepas penalaan halus data dan proses penalaan halus program selesai, penyelidik membandingkan pengembangan skala berdasarkan prestasi saiz model pada pengaruh tugas. Pertama, untuk ketiga-tiga saiz model, penalaan halus arahan berbilang tugas menghasilkan peningkatan prestasi yang besar berbanding tanpa penalaan halus, dengan keuntungan antara 9.4% hingga 15.5%. Kedua, menambah bilangan tugas penalaan halus boleh meningkatkan prestasi.

Akhir sekali, kita dapat melihat bahawa meningkatkan saiz model mengikut susunan magnitud (8B → 62B atau 62B → 540B) dengan ketara meningkatkan prestasi kedua-dua penalaan halus dan tidak halus- model yang ditala.

Kesan penalaan halus arahan berbilang tugas pada ketepatan berbanding saiz model (bilangan parameter) dan pengembangan nombor dan skala tugas penalaan halus Pengaruh.

Meningkatkan bilangan tugas dalam data penalaan halus meningkatkan Flan-PaLM pada kebanyakan prestasi penanda aras penilaian.

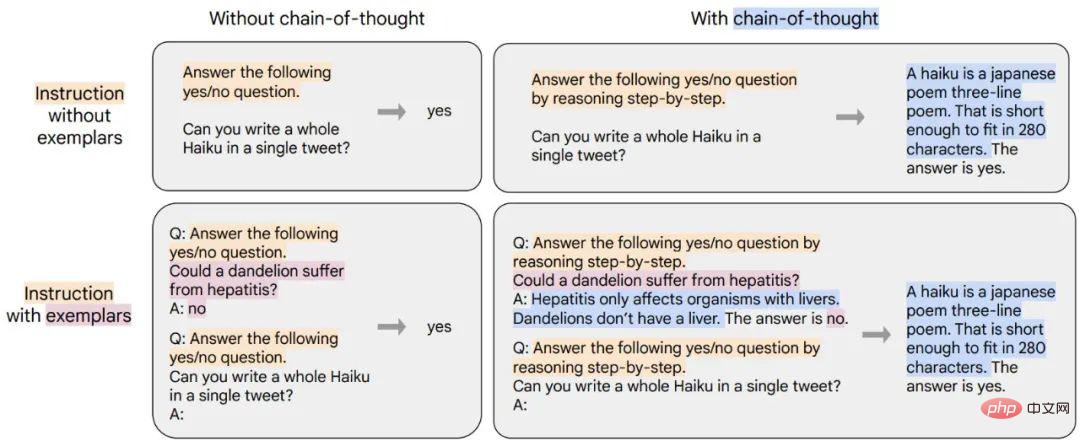

Penyelidik menunjukkan bahawa menyertakan sembilan set data yang dianotasi dengan Chains of Thoughts (CoT) dalam gabungan penalaan halus meningkatkan keupayaan inferens. Jadual di bawah menunjukkan bahawa keupayaan penggerak CoT Flan-PaLM mengatasi prestasi PaLM pada empat penanda aras penilaian yang dikekalkan.

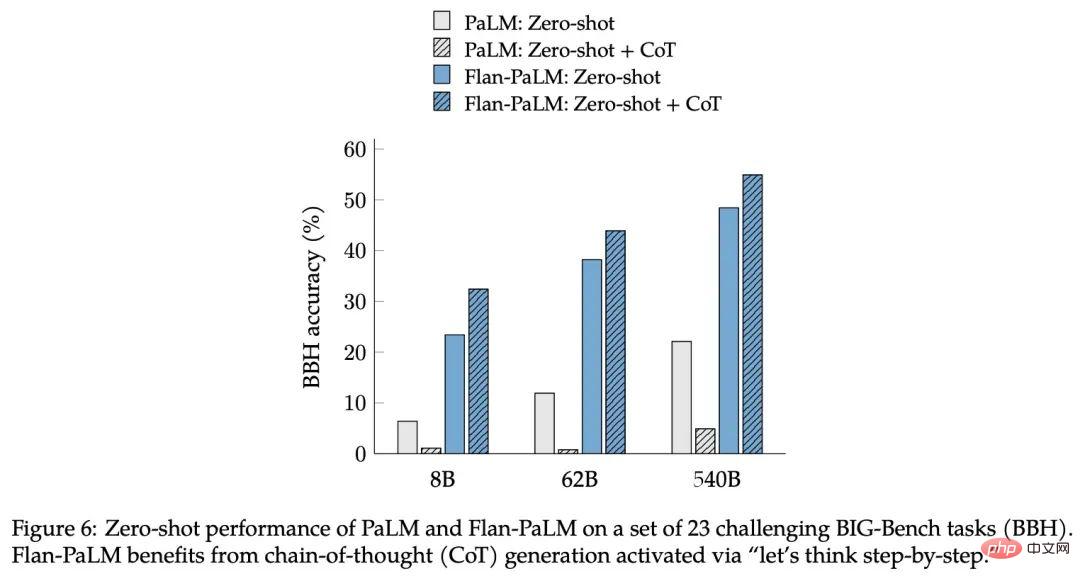

Kajian ini mendapati bahawa faedah lain daripada arahan penalaan halus untuk data CoT ialah ia boleh mencapai inferens pukulan sifar, dan model boleh digunakan tanpa menyasarkan CoT menjana keupayaan inferens sendiri dengan saiz sampel yang kecil, yang mungkin memerlukan penalaan kejuruteraan yang meluas untuk dilaksanakan dengan betul.

Rajah 6: PaLM dan Flan-PaLM pada satu set 23 tugasan BIG-Bench (BBH ) yang mencabar sifar- prestasi pukulan pada. Flan-PaLM memerlukan penjanaan Rantaian Pemikiran (CoT) yang diaktifkan oleh arahan "Mari kita fikir langkah demi langkah".

Untuk menunjukkan keluasan kaedah baharu, Google melatih T5, PaLM dan U-PaLM, meliputi julat saiz model daripada 80 juta hingga 540 bilion parameter, dan mendapati semua model boleh meningkatkan prestasi dengan ketara.

Jadual 5. Penalaan halus arahan (Flan) meningkatkan prestasi berbanding kaedah pra-latihan berterusan yang lain.

Selepas ujian, penalaan halus arahan meningkatkan prestasi purata ternormal semua jenis model dengan ketara, dan model T5 mendapat manfaat daripada penalaan halus arahan berbanding bukan- model yang ditala halus. Keputusan ini agak kukuh untuk beberapa penanda aras - contohnya, Flan-T5-XL mencapai skor MMLU sebanyak 47.6% dengan hanya 3 bilion parameter, mengatasi skor 43.9% GPT-3 dengan 175 bilion parameter.

Selain penanda aras NLP, model bahasa mampu menjana jawapan bentuk panjang kepada permintaan soalan terbuka. Dalam hal ini, penanda aras NLP standard dan metrik automatik yang digunakan untuk menilainya tidak mencukupi untuk mengukur keutamaan manusia. Para penyelidik menilai ini, mencipta set penilaian 190 contoh. Set penilaian terdiri daripada soalan yang dikemukakan kepada model secara sifar merentasi lima kategori mencabar yang terdiri daripada 20 soalan setiap satu: Kreativiti, Penaakulan Kontekstual, Penaakulan Kompleks, Perancangan dan Penjelasan.

Untuk 60 daripada contoh ini (daripada kategori penaakulan, perancangan dan penjelasan yang kompleks), kajian itu mencipta pautan dengan frasa pencetus rantai pemikiran (cth., “Mari kita fikirkan langkah demi langkah ”), sebagai penilaian lain sama ada penalaan halus dilakukan dengan tangkapan sifar didayakan pada CoT. Sebagai tambahan kepada 160 input sifar pukulan yang dinyatakan di atas, kajian ini juga termasuk 30 input untuk menguji keupayaan beberapa pukulan di mana model bahasa yang kuat tanpa penalaan halus pengajaran telah ditunjukkan untuk berprestasi baik.

Penyelidik percaya bahawa kedua-dua penalaan halus arahan dan pengembangan skala boleh terus meningkatkan prestasi model bahasa besar, dan penalaan halus adalah penting untuk keupayaan penaakulan dan juga boleh menyamaratakan keupayaan model. Dengan menggabungkan penalaan halus arahan dengan teknik penyesuaian model lain seperti UL2R, Google mencadangkan model Flan-U-PaLM terkuat dalam kerja ini.

Yang penting, penalaan halus arahan tidak meningkatkan kos pengiraan dengan ketara seperti pengembangan skala model Contohnya, untuk PaLM 540B, penalaan halus arahan hanya memerlukan 0.2% pengiraan pra-latihan. , tetapi ia boleh Meningkatkan purata ternormal merentas penanda aras penilaian sebanyak 9.4%. Model kecil yang menggunakan dorongan arahan kadangkala boleh mengatasi prestasi model yang lebih besar tanpa dorongan.

Atas sebab ini, penyelidik mengesyorkan penalaan halus arahan untuk hampir semua model bahasa pra-latihan.

Atas ialah kandungan terperinci 3 bilion mengatasi 175 bilion model baharu Google GPT-3 menyebabkan perbincangan hangat, tetapi ia membuat Hinton salah.. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Perbezaan antara k8s dan docker

Perbezaan antara k8s dan docker

Bagaimana untuk menukar devc++ kepada bahasa Cina

Bagaimana untuk menukar devc++ kepada bahasa Cina

Apakah hos maya php percuma di luar negara?

Apakah hos maya php percuma di luar negara?

Bagaimana untuk membeli dan menjual Bitcoin di China

Bagaimana untuk membeli dan menjual Bitcoin di China

suara qq

suara qq

busyboxv1.30.1 tidak boleh boot

busyboxv1.30.1 tidak boleh boot

Bagaimana untuk Bermula dengan Membeli Mata Wang Kripto

Bagaimana untuk Bermula dengan Membeli Mata Wang Kripto

Bagaimana untuk mengubah suai koordinat dalam matlab

Bagaimana untuk mengubah suai koordinat dalam matlab