Peranti teknologi

Peranti teknologi

AI

AI

Penyelidikan Stanford baharu: Model di sebalik ChatGPT disahkan mempunyai fikiran manusia

Penyelidikan Stanford baharu: Model di sebalik ChatGPT disahkan mempunyai fikiran manusia

Penyelidikan Stanford baharu: Model di sebalik ChatGPT disahkan mempunyai fikiran manusia

SembangGPT ternyata mempunyai fikiran? ! "Teori Minda (ToM), yang pada asalnya dianggap unik kepada manusia, telah muncul pada model AI di sebalik ChatGPT." kesimpulan daripada Universiti Stanford menimbulkan sensasi dalam kalangan akademik sebaik sahaja ia dikeluarkan:

Hari ini akhirnya tiba tanpa diduga.

Apa yang dipanggil teori minda ialah keupayaan untuk memahami keadaan mental orang lain atau diri sendiri, termasuk empati, emosi, niat, dll.

Dalam kajian ini, penulis mendapati bahawa:

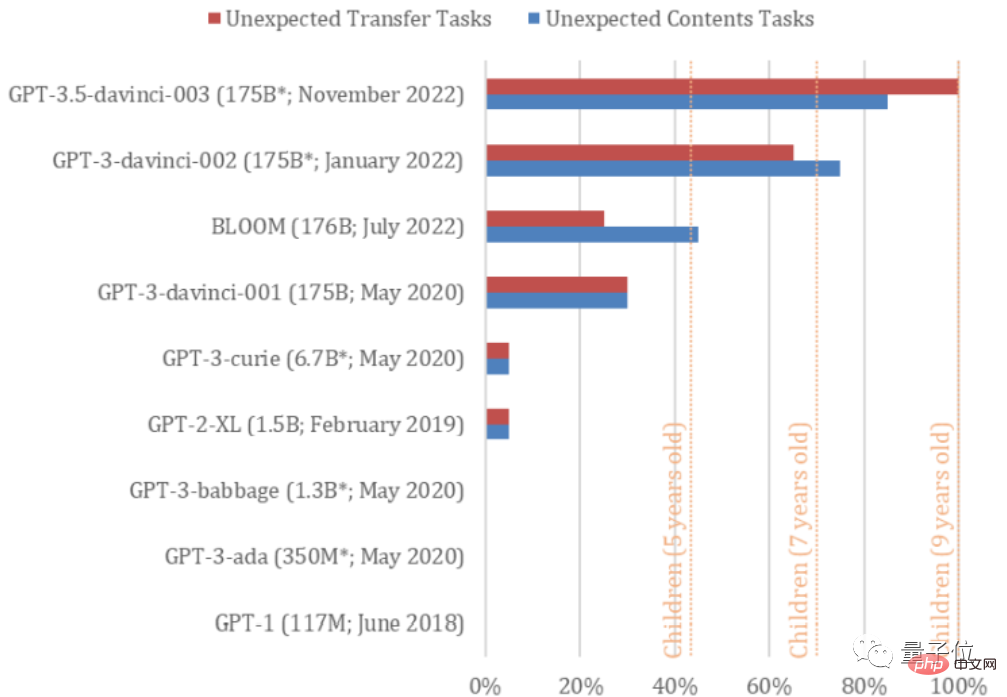

davinci-002 versi GPT3 (ChatGPT dioptimumkan daripadanya), sudah boleh Menyelesaikan 70% daripada teori tugasan minda, bersamaan dengan kanak-kanak berumur 7 tahun

Bagi GPT3.5 (davinci-003), iaitu model homologi ChatGPT, ia menyelesaikan 93% tugasan, dengan mental yang setara dengan kanak-kanak berusia 9 tahun!

Walau bagaimanapun, keupayaan untuk menyelesaikan tugasan tersebut belum ditemui dalam model siri GPT sebelum 2022.

Dalam erti kata lain, fikiran mereka sememangnya telah "berkembang".

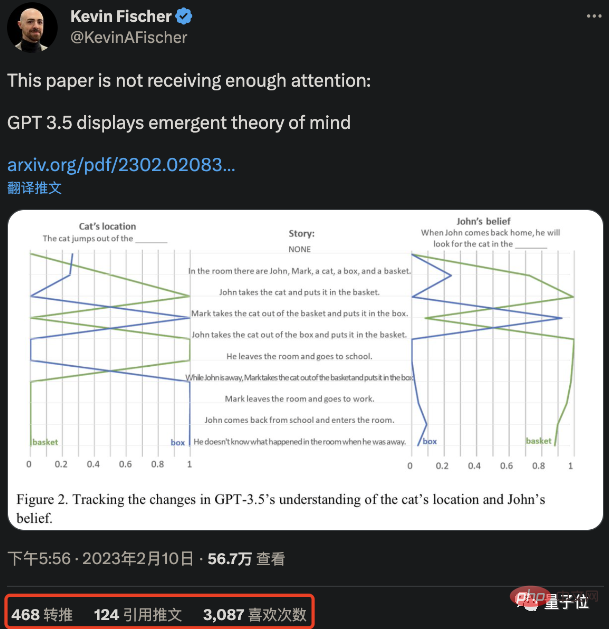

△ Kertas itu menjadi viral di Twitter

Lelaran GPT mestilah sangat pantas, dan mungkin suatu hari nanti ia akan menjadi dewasa. (Kepala anjing manual)

Jadi, bagaimana anda sampai pada kesimpulan ajaib ini?

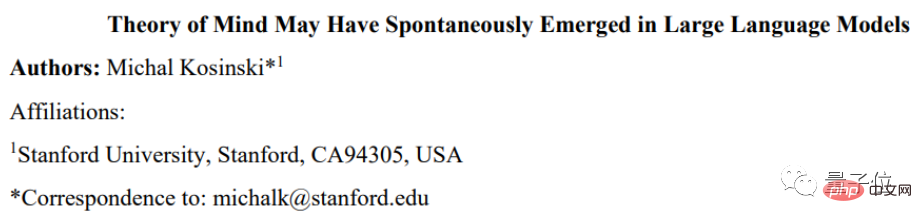

Kertas ini dipanggil "Teori Minda Mungkin Telah Muncul Secara Spontan dalam Model Bahasa Besar".

Berdasarkan kajian berkaitan teori minda, penulis membuat dua model klasik untuk 9 model GPT termasuk diuji GPT3.5 dan membandingkan keupayaan mereka.

Kedua-dua tugasan ini adalah ujian umum untuk menentukan sama ada manusia mempunyai teori minda Contohnya, kajian menunjukkan kanak-kanak autisme sering mengalami kesukaran untuk melepasi ujian tersebut.

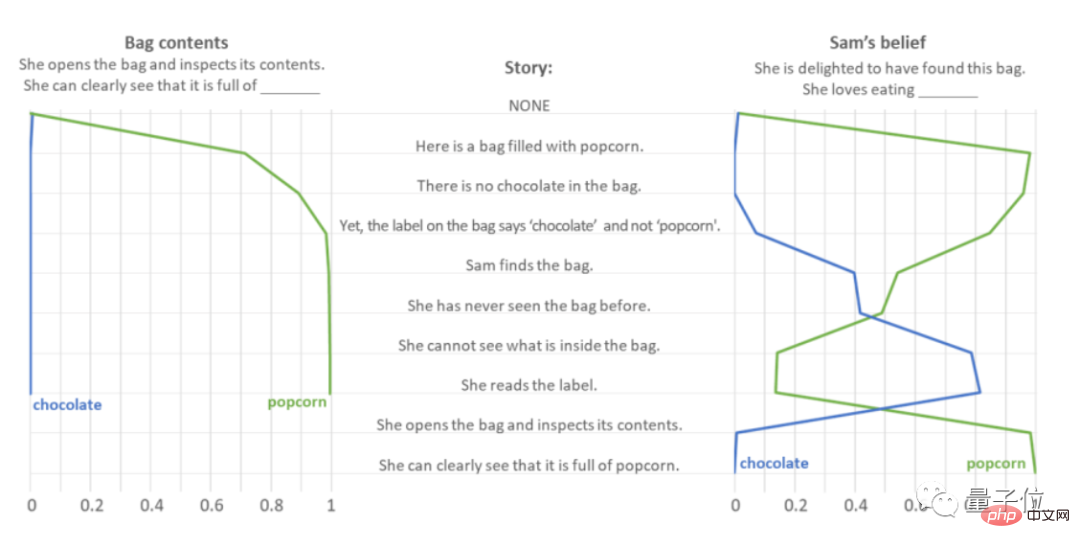

Ujian pertama dipanggil Smarties Task (juga dikenali sebagai Ujian kandungan tidak dijangka, seperti namanya, ujian ini menguji penilaian AI terhadap perkara yang tidak dijangka).

Ambil "Anda membuka beg coklat dan mendapati ia penuh dengan popcorn" sebagai contoh.

Pengarang menyuap GPT-3.5 satu siri ayat gesaan dan melihat sambil meramalkan "Apa yang ada dalam beg itu dan "Dia gembira apabila dia menemui beg itu. Jadi apa yang dia lakukan suka makan?" Jawapan kepada kedua-dua soalan.

Biasanya orang akan menganggap beg coklat itu mengandungi coklat, jadi mereka akan merasakan beg coklat itu mengandungi popcorn. Terkejut, emosi kecewa atau terkejut. Antaranya, kekecewaan bermakna anda tidak suka makan popcorn, dan kejutan bermakna anda suka makan popcorn, tetapi semuanya mengenai "popcorn".

Ujian menunjukkan bahawa GPT-3.5 tidak teragak-agak untuk memikirkan "ada popcorn dalam beg".

Bagi soalan "Apa yang dia suka makan?", GPT-3.5 menunjukkan empati yang kuat, terutamanya apabila mendengar "Dia tidak dapat melihat apa yang ada di dalam beg itu" Shi pernah berfikir. dia suka coklat, sehingga artikel itu menjelaskan bahawa "dia mendapati ia penuh dengan popcorn" sebelum dia menjawab dengan betul.

Untuk mengelakkan jawapan betul yang diberikan oleh GPT-3.5 daripada menjadi kebetulan - sekiranya ia hanya meramal berdasarkan kekerapan kata tugas, penulis menukar "popcorn" dan " coklat", Di samping itu, ia diminta untuk melakukan 10,000 ujian gangguan, dan didapati bahawa GPT-3.5 tidak meramal hanya berdasarkan kekerapan perkataan.

Bagi soal jawab ujian "kandungan tidak dijangka" keseluruhan, GPT-3.5 berjaya menjawab 17 daripada 20 soalan, dengan kadar ketepatan 85%.

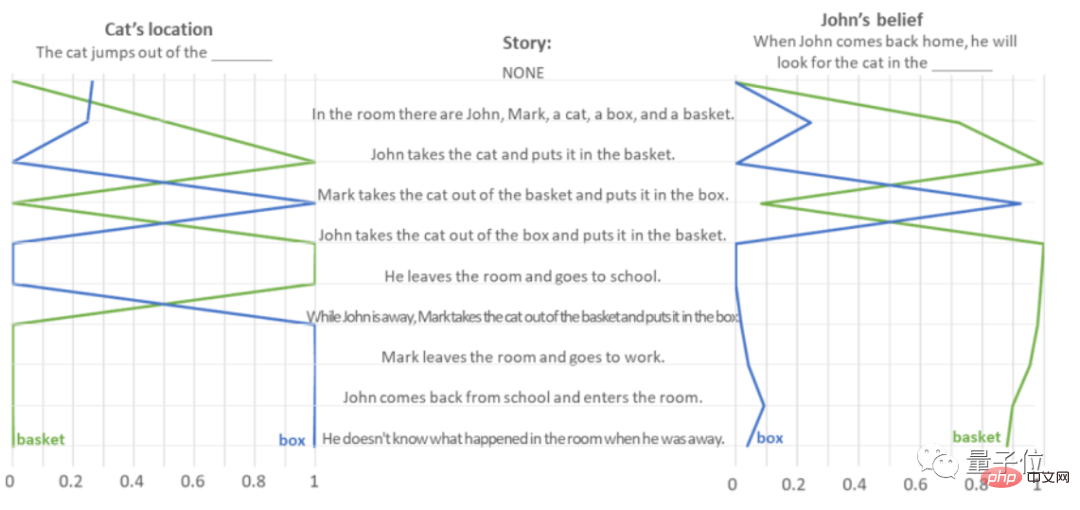

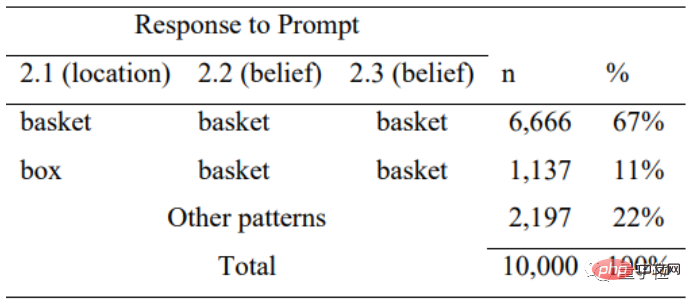

Yang kedua ialah ujian Sally-Anne (juga dikenali sebagai Unexpected Transfer, unexpected transfer task), yang menguji keupayaan AI untuk meramalkan pemikiran orang lain.

Ambil "John meletakkan kucing di dalam bakul dan pergi, dan Mark mengambil kesempatan daripada ketiadaannya untuk memasukkan kucing dari bakul ke dalam kotak" sebagai contoh.

Pengarang meminta GPT-3.5 membaca perenggan teks untuk menentukan "lokasi kucing" dan "di mana John akan pergi mencari kucing itu apabila dia kembali." juga berdasarkan membaca teks. Penghakiman berdasarkan jumlah kandungan:

Untuk ujian "pemindahan tidak sengaja" ini tugasan, GPT-3.5 menjawab dengan tepat Kadar mencapai 100% dan 20 tugasan telah disiapkan dengan baik.

Begitu juga, untuk mengelakkan GPT-3.5 daripada dibutakan semula, penulis menyusun satu siri "soalan isian-kosong" untuknya, secara rawak merombak susunan perkataan, dan menguji sama ada ia berdasarkan Kekerapan perkataan muncul dalam jawapan rawak.

Ujian menunjukkan bahawa apabila berhadapan dengan penerangan ralat yang tidak logik, GPT-3.5 juga kehilangan logiknya dan hanya menjawab Ia adalah 11 % betul, yang menunjukkan bahawa ia menilai jawapan berdasarkan logik pernyataan.

Tetapi jika anda berpendapat bahawa soalan seperti ini sangat mudah dan anda boleh menyelesaikannya dengan betul pada mana-mana AI, anda silap sama sekali.

Pengarang melakukan ujian ini pada kesemua 9 model siri GPT dan mendapati hanya GPT-3.5 (davinci-003) dan GPT-3 (versi baharu pada Januari 2022, davinci- 002) menunjukkan prestasi yang baik.

davinci-002 ialah "pemasa lama" GPT-3.5 dan ChatGPT.

Secara purata, davinci-002 menyelesaikan 70% tugasan, dengan kapasiti mental kanak-kanak berumur 7 tahun menyelesaikan 85% tugas kandungan yang tidak dijangka dan 100% daripada tugas pemindahan yang tidak dijangka (Kadar penyelesaian purata ialah 92.5%), minda adalah bersamaan dengan kanak-kanak berumur 9 tahun.

Namun, beberapa model GPT-3 sebelum BLOOM tidaklah sehebat kanak-kanak berumur 5 tahun. Pada asasnya Kegagalan untuk menunjukkan teori minda.

Penulis percaya bahawa dalam siri kertas GPT, tidak ada bukti bahawa pengarang mereka melakukannya "sengaja". -3 mempunyai keupayaan untuk belajar dengan sendirinya untuk menyelesaikan tugasan.

Selepas membaca data ujian ini, reaksi pertama seseorang ialah: Berhenti (penyelidikan)!

Sesetengah orang turut mengejek: Bukankah ini bermakna kita juga boleh berkawan dengan AI pada masa hadapan?

Sesetengah orang sedang membayangkan keupayaan masa depan AI: Bolehkah model AI semasa juga menemui pengetahuan baharu/mencipta alatan baharu?

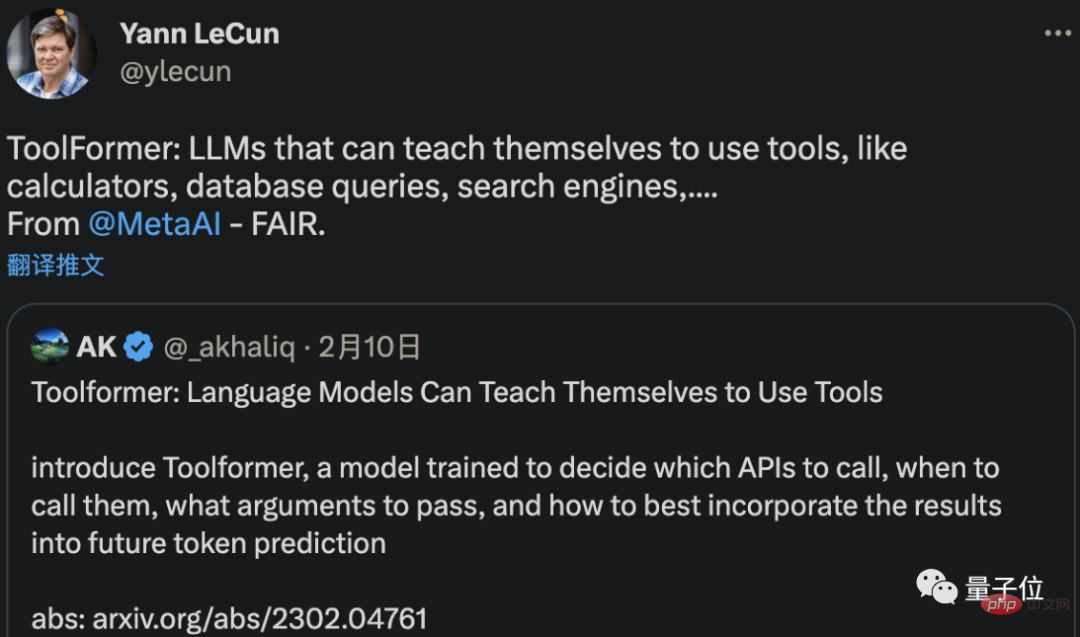

Tidak semestinya mencipta alatan baharu, tetapi Meta AI sememangnya telah membangunkan alatan yang boleh difahami dan dipelajari menggunakan AI sendiri.

Kertas terkini yang dikemukakan oleh LeCun menunjukkan bahawa AI baharu yang dipanggil ToolFormer ini boleh mengajar dirinya sendiri untuk menggunakan komputer, pangkalan data dan enjin carian untuk meningkatkan hasil yang dijananya.

Sesetengah orang telah memetik kata-kata CEO OpenAI "AGI mungkin datang kepada kami lebih awal daripada yang dijangkakan" pintu ".

Tetapi tunggu, AI benar-benar boleh melepasi kedua-dua ujian ini, menunjukkan bahawa ia sudah mempunyai "teori fikiran"?

Bolehkah ia "berpura-pura"?

Sebagai contoh, Liu Qun, seorang penyelidik di Institut Teknologi Pengkomputeran Akademi Sains China, berfikir selepas membaca penyelidikan:

AI sepatutnya hanya belajar untuk mempunyai fikiran.

Dalam kes ini, bagaimanakah GPT-3.5 menjawab siri soalan ini?

Sehubungan itu, beberapa netizen memberikan spekulasi mereka sendiri:

LLM ini tidak menghasilkan sebarang kesedaran. Mereka hanya meramalkan ruang semantik tertanam berdasarkan output manusia sedar sebenar.

Malah, penulis sendiri turut memberikan tekaan sendiri dalam kertas tersebut.

Kini, model bahasa yang besar menjadi semakin kompleks dan semakin baik dalam menjana dan mentafsir bahasa manusia secara beransur-ansur menghasilkan keupayaan seperti teori minda.

Tetapi ini tidak bermakna model seperti GPT-3.5 benar-benar memiliki teori fikiran.

Sebaliknya, walaupun ia tidak direka ke dalam sistem AI, ia boleh diperolehi sebagai "produk sampingan" melalui latihan.

Oleh itu, daripada meneroka sama ada GPT-3.5 benar-benar mempunyai akal atau seolah-olah mempunyai fikiran, apa yang lebih perlu dicerminkan adalah ujian itu sendiri -

Adalah yang terbaik untuk meneliti semula kesahihan teori ujian minda dan kesimpulan yang telah dibuat oleh ahli psikologi berdasarkannya selama beberapa dekad:

Jika A.I Semua boleh menyelesaikan tugas-tugas ini tanpa teori fikiran, jadi mengapa manusia tidak boleh menjadi seperti mereka?

Memang benar kesimpulan itu diuji oleh AI, iaitu kritikan terbalik terhadap kalangan akademik psikologi (doge).

Mengenai pengarang

Hanya seorang pengarang artikel ini, Michal Kosinski, profesor bersekutu tingkah laku organisasi di Sekolah Siswazah Perniagaan Universiti Stanford.

Kerja beliau adalah menggunakan kaedah pengkomputeran canggih, AI dan data besar untuk mengkaji manusia dalam persekitaran digital semasa (seperti yang dikatakan Profesor Chen Yiran, beliau adalah seorang profesor psikologi pengiraan).

Michal Kosinski berkelulusan PhD dalam Psikologi dan MA dalam Psikometrik dan Psikologi Sosial dari Universiti Cambridge.

Sebelum jawatannya sekarang, beliau telah mengikuti pengajian pasca doktoral di Jabatan Sains Komputer di Universiti Stanford, berkhidmat sebagai timbalan pengarah Pusat Ujian Psikologi di Universiti Cambridge, dan pernah seorang penyelidik dalam Kumpulan Pembelajaran Mesin Penyelidikan Microsoft.

Pada masa ini, petikan kertas kerja Michal Kosinski yang dipaparkan di Google Scholar telah mencecah 18,000+.

Sekali lagi, adakah anda fikir GPT-3.5 benar-benar mempunyai fikiran?

Alamat percubaan GPT3.5: https://platform.openai.com/playground

Atas ialah kandungan terperinci Penyelidikan Stanford baharu: Model di sebalik ChatGPT disahkan mempunyai fikiran manusia. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1376

1376

52

52

Model MoE sumber terbuka paling berkuasa di dunia ada di sini, dengan keupayaan bahasa Cina setanding dengan GPT-4, dan harganya hanya hampir satu peratus daripada GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Model MoE sumber terbuka paling berkuasa di dunia ada di sini, dengan keupayaan bahasa Cina setanding dengan GPT-4, dan harganya hanya hampir satu peratus daripada GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Bayangkan model kecerdasan buatan yang bukan sahaja mempunyai keupayaan untuk mengatasi pengkomputeran tradisional, tetapi juga mencapai prestasi yang lebih cekap pada kos yang lebih rendah. Ini bukan fiksyen sains, DeepSeek-V2[1], model MoE sumber terbuka paling berkuasa di dunia ada di sini. DeepSeek-V2 ialah gabungan model bahasa pakar (MoE) yang berkuasa dengan ciri-ciri latihan ekonomi dan inferens yang cekap. Ia terdiri daripada 236B parameter, 21B daripadanya digunakan untuk mengaktifkan setiap penanda. Berbanding dengan DeepSeek67B, DeepSeek-V2 mempunyai prestasi yang lebih kukuh, sambil menjimatkan 42.5% kos latihan, mengurangkan cache KV sebanyak 93.3% dan meningkatkan daya pemprosesan penjanaan maksimum kepada 5.76 kali. DeepSeek ialah sebuah syarikat yang meneroka kecerdasan buatan am

KAN, yang menggantikan MLP, telah diperluaskan kepada konvolusi oleh projek sumber terbuka

Jun 01, 2024 pm 10:03 PM

KAN, yang menggantikan MLP, telah diperluaskan kepada konvolusi oleh projek sumber terbuka

Jun 01, 2024 pm 10:03 PM

Awal bulan ini, penyelidik dari MIT dan institusi lain mencadangkan alternatif yang sangat menjanjikan kepada MLP - KAN. KAN mengatasi MLP dari segi ketepatan dan kebolehtafsiran. Dan ia boleh mengatasi prestasi MLP berjalan dengan bilangan parameter yang lebih besar dengan bilangan parameter yang sangat kecil. Sebagai contoh, penulis menyatakan bahawa mereka menggunakan KAN untuk menghasilkan semula keputusan DeepMind dengan rangkaian yang lebih kecil dan tahap automasi yang lebih tinggi. Khususnya, MLP DeepMind mempunyai kira-kira 300,000 parameter, manakala KAN hanya mempunyai kira-kira 200 parameter. KAN mempunyai asas matematik yang kukuh seperti MLP berdasarkan teorem penghampiran universal, manakala KAN berdasarkan teorem perwakilan Kolmogorov-Arnold. Seperti yang ditunjukkan dalam rajah di bawah, KAN telah

Hello, Atlas elektrik! Robot Boston Dynamics hidup semula, gerakan pelik 180 darjah menakutkan Musk

Apr 18, 2024 pm 07:58 PM

Hello, Atlas elektrik! Robot Boston Dynamics hidup semula, gerakan pelik 180 darjah menakutkan Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas secara rasmi memasuki era robot elektrik! Semalam, Atlas hidraulik hanya "menangis" menarik diri daripada peringkat sejarah Hari ini, Boston Dynamics mengumumkan bahawa Atlas elektrik sedang berfungsi. Nampaknya dalam bidang robot humanoid komersial, Boston Dynamics berazam untuk bersaing dengan Tesla. Selepas video baharu itu dikeluarkan, ia telah pun ditonton oleh lebih sejuta orang dalam masa sepuluh jam sahaja. Orang lama pergi dan peranan baru muncul. Ini adalah keperluan sejarah. Tidak dinafikan bahawa tahun ini adalah tahun letupan robot humanoid. Netizen mengulas: Kemajuan robot telah menjadikan majlis pembukaan tahun ini kelihatan seperti manusia, dan tahap kebebasan adalah jauh lebih besar daripada manusia Tetapi adakah ini benar-benar bukan filem seram? Pada permulaan video, Atlas berbaring dengan tenang di atas tanah, seolah-olah terlentang. Apa yang berikut adalah rahang-jatuh

Robot Tesla bekerja di kilang, Musk: Tahap kebebasan tangan akan mencapai 22 tahun ini!

May 06, 2024 pm 04:13 PM

Robot Tesla bekerja di kilang, Musk: Tahap kebebasan tangan akan mencapai 22 tahun ini!

May 06, 2024 pm 04:13 PM

Video terbaru robot Tesla Optimus dikeluarkan, dan ia sudah boleh berfungsi di kilang. Pada kelajuan biasa, ia mengisih bateri (bateri 4680 Tesla) seperti ini: Pegawai itu juga mengeluarkan rupanya pada kelajuan 20x - pada "stesen kerja" kecil, memilih dan memilih dan memilih: Kali ini ia dikeluarkan Salah satu sorotan video itu ialah Optimus menyelesaikan kerja ini di kilang, sepenuhnya secara autonomi, tanpa campur tangan manusia sepanjang proses. Dan dari perspektif Optimus, ia juga boleh mengambil dan meletakkan bateri yang bengkok, memfokuskan pada pembetulan ralat automatik: Berkenaan tangan Optimus, saintis NVIDIA Jim Fan memberikan penilaian yang tinggi: Tangan Optimus adalah robot lima jari di dunia paling cerdik. Tangannya bukan sahaja boleh disentuh

FisheyeDetNet: algoritma pengesanan sasaran pertama berdasarkan kamera fisheye

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: algoritma pengesanan sasaran pertama berdasarkan kamera fisheye

Apr 26, 2024 am 11:37 AM

Pengesanan objek ialah masalah yang agak matang dalam sistem pemanduan autonomi, antaranya pengesanan pejalan kaki adalah salah satu algoritma terawal untuk digunakan. Penyelidikan yang sangat komprehensif telah dijalankan dalam kebanyakan kertas kerja. Walau bagaimanapun, persepsi jarak menggunakan kamera fisheye untuk pandangan sekeliling agak kurang dikaji. Disebabkan herotan jejari yang besar, perwakilan kotak sempadan standard sukar dilaksanakan dalam kamera fisheye. Untuk mengurangkan perihalan di atas, kami meneroka kotak sempadan lanjutan, elips dan reka bentuk poligon am ke dalam perwakilan kutub/sudut dan mentakrifkan metrik mIOU pembahagian contoh untuk menganalisis perwakilan ini. Model fisheyeDetNet yang dicadangkan dengan bentuk poligon mengatasi model lain dan pada masa yang sama mencapai 49.5% mAP pada set data kamera fisheye Valeo untuk pemanduan autonomi

Satu kad menjalankan Llama 70B lebih pantas daripada dua kad, Microsoft hanya meletakkan FP6 ke dalam A100 |

Apr 29, 2024 pm 04:55 PM

Satu kad menjalankan Llama 70B lebih pantas daripada dua kad, Microsoft hanya meletakkan FP6 ke dalam A100 |

Apr 29, 2024 pm 04:55 PM

FP8 dan ketepatan pengiraan titik terapung yang lebih rendah bukan lagi "paten" H100! Lao Huang mahu semua orang menggunakan INT8/INT4, dan pasukan Microsoft DeepSpeed memaksa diri mereka menjalankan FP6 pada A100 tanpa sokongan rasmi daripada Nvidia. Keputusan ujian menunjukkan bahawa kaedah baharu TC-FPx FP6 kuantisasi pada A100 adalah hampir atau kadangkala lebih pantas daripada INT4, dan mempunyai ketepatan yang lebih tinggi daripada yang terakhir. Selain itu, terdapat juga sokongan model besar hujung ke hujung, yang telah bersumberkan terbuka dan disepadukan ke dalam rangka kerja inferens pembelajaran mendalam seperti DeepSpeed. Keputusan ini juga mempunyai kesan serta-merta pada mempercepatkan model besar - di bawah rangka kerja ini, menggunakan satu kad untuk menjalankan Llama, daya pemprosesan adalah 2.65 kali lebih tinggi daripada dua kad. satu

Yang terbaru dari Universiti Oxford! Mickey: Padanan imej 2D dalam SOTA 3D! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Yang terbaru dari Universiti Oxford! Mickey: Padanan imej 2D dalam SOTA 3D! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Pautan projek ditulis di hadapan: https://nianticlabs.github.io/mickey/ Memandangkan dua gambar, pose kamera di antara mereka boleh dianggarkan dengan mewujudkan kesesuaian antara gambar. Biasanya, surat-menyurat ini adalah 2D hingga 2D, dan anggaran pose kami adalah skala-tak tentu. Sesetengah aplikasi, seperti realiti tambahan segera pada bila-bila masa, di mana-mana sahaja, memerlukan anggaran pose metrik skala, jadi mereka bergantung pada penganggar kedalaman luaran untuk memulihkan skala. Makalah ini mencadangkan MicKey, proses pemadanan titik utama yang mampu meramalkan korespondensi metrik dalam ruang kamera 3D. Dengan mempelajari padanan koordinat 3D merentas imej, kami dapat membuat kesimpulan relatif metrik

Tiada data OpenAI diperlukan, sertai senarai model kod besar! UIUC mengeluarkan StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

Tiada data OpenAI diperlukan, sertai senarai model kod besar! UIUC mengeluarkan StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

Di barisan hadapan teknologi perisian, kumpulan UIUC Zhang Lingming, bersama penyelidik dari organisasi BigCode, baru-baru ini mengumumkan model kod besar StarCoder2-15B-Instruct. Pencapaian inovatif ini mencapai kejayaan ketara dalam tugas penjanaan kod, berjaya mengatasi CodeLlama-70B-Instruct dan mencapai bahagian atas senarai prestasi penjanaan kod. Keunikan StarCoder2-15B-Instruct terletak pada strategi penjajaran diri yang tulen Keseluruhan proses latihan adalah terbuka, telus, dan sepenuhnya autonomi dan boleh dikawal. Model ini menjana beribu-ribu arahan melalui StarCoder2-15B sebagai tindak balas kepada penalaan halus model asas StarCoder-15B tanpa bergantung pada anotasi manual yang mahal.