Peranti teknologi

Peranti teknologi

AI

AI

Jangan jadi pelukis yang buta huruf! Google mengubah suai 'Pengekod Teks' secara ajaib: operasi kecil membolehkan model penjanaan imej mempelajari 'ejaan'

Jangan jadi pelukis yang buta huruf! Google mengubah suai 'Pengekod Teks' secara ajaib: operasi kecil membolehkan model penjanaan imej mempelajari 'ejaan'

Jangan jadi pelukis yang buta huruf! Google mengubah suai 'Pengekod Teks' secara ajaib: operasi kecil membolehkan model penjanaan imej mempelajari 'ejaan'

Pada tahun lalu, dengan keluaran model penjanaan imej seperti DALL-E 2 dan Stable Diffusion, imej yang dijana oleh model teks ke imej telah mencapai hasil yang hebat dari segi resolusi, kualiti, kesetiaan teks, dsb. Ini telah membuat peningkatan yang besar, sangat menggalakkan pembangunan senario aplikasi hiliran, dan semua orang telah menjadi pelukis AI.

Walau bagaimanapun, penyelidikan berkaitan menunjukkan bahawa teknologi model generatif semasa masih mempunyai kelemahan utama: tiada cara untuk mempersembahkan teks visual yang boleh dipercayai dalam imej.

Hasil penyelidikan menunjukkan bahawa DALL-E 2 sangat tidak stabil dalam menjana aksara teks koheren dalam gambar, dan model Stable Diffusion yang baru dikeluarkan secara langsung "tidak dapat memaparkan" teks Boleh dibaca" ialah disenaraikan sebagai had yang diketahui.

Watak salah ejaan: (1) California: All Dreams Welcome, (2) Canada: For Glowing Hearts, (3) Colorado : It's Our Nature, (4) St. Louis: All Within Reach.

Baru-baru ini, Google Research mengeluarkan kertas baharu, cuba memahami dan meningkatkan kecekapan pemaparan imej model generasi. Keupayaan untuk kualiti teks visual.

Pautan kertas: https://arxiv.org/abs/2212.10562

Penyelidik percaya bahawa sebab utama model penjanaan teks-ke-imej semasa mempunyai kecacatan pemaparan teks ialah kekurangan ciri input peringkat aksara.

Untuk mengukur kesan ciri input ini dalam penjanaan model, artikel itu mereka bentuk satu siri eksperimen kawalan sama ada pengekod teks mengandungi ciri input teks (sedar aksara dan aksara- buta ) untuk perbandingan.

Penyelidik mendapati bahawa dalam bidang teks biasa, model yang menyedari watak mencapai peningkatan prestasi yang hebat pada tugasan ejaan baharu (WikiSpell).

Selepas memindahkan pengalaman ini ke domain visual, penyelidik melatih satu set model penjanaan imej. Keputusan eksperimen menunjukkan bahawa model sedar watak mengatasi buta aksara dalam siri tugasan pemaparan teks baharu (penanda aras DrawText).

Dan model yang menyedari watak telah mencapai tahap seni yang lebih tinggi dalam ejaan visual, ketepatannya pada perkataan yang tidak biasa masih sama walaupun latihan pada bilangan contoh yang jauh lebih kecil. 30 mata peratusan lebih tinggi daripada model pesaing.

Model Sedar AksaraModel bahasa boleh dibahagikan kepada model sedar aksara yang mempunyai akses terus kepada aksara yang membentuk input teks dan model buta aksaranya yang tidak mempunyai akses.

Banyak model bahasa saraf awal beroperasi secara langsung pada aksara tanpa menggunakan token berbilang aksara sebagai penanda.

Model kemudian secara beransur-ansur beralih kepada tokenisasi berasaskan perbendaharaan kata Sesetengah model seperti ELMo masih mengekalkan ciri-ciri watak, tetapi model lain seperti BERT melepaskan ciri-ciri watak yang lebih berkesan. latihan.

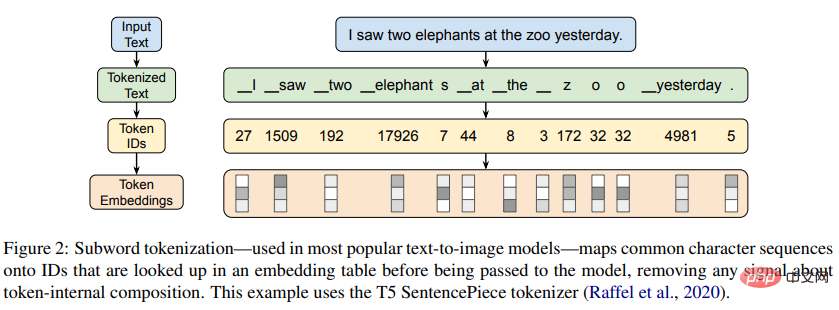

Pada masa ini, kebanyakan model bahasa yang digunakan secara meluas adalah buta aksara, bergantung pada algoritma pembahagian subkata terdorong data, seperti pengekodan pasangan bait (BPE) untuk menjana subkata sebagai a kosa kata.

Walaupun kaedah ini boleh kembali kepada perwakilan peringkat aksara untuk urutan yang tidak biasa, kaedah ini masih direka bentuk untuk memampatkan jujukan aksara biasa kepada unit yang tidak boleh dibahagikan.

Tujuan utama kertas kerja ini adalah untuk cuba memahami dan meningkatkan keupayaan model penjanaan imej untuk menghasilkan teks visual berkualiti tinggi.

Untuk tujuan ini, penyelidik mula-mula mengkaji keupayaan ejaan pengekod teks semasa secara berasingan Daripada hasil percubaan, boleh didapati bahawa walaupun pengekod teks buta aksara adalah popular, mereka tidak Menerima isyarat langsung tentang komposisi peringkat aksara input mereka, mengakibatkan kebolehan mengeja terhad.

Para penyelidik juga menguji keupayaan ejaan pengekod teks dengan pelbagai saiz, seni bina, perwakilan input, bahasa dan kaedah penalaan.

Kertas kerja ini merekodkan buat pertama kalinya keupayaan ajaib model buta aksara untuk mendorong pengetahuan ejaan yang kuat (ketepatan >99%) melalui pra-latihan rangkaian, tetapi keputusan eksperimen menunjukkan bahawa keupayaan ini Ia tidak digeneralisasikan dengan baik dalam bahasa selain bahasa Inggeris dan hanya boleh dicapai pada skala melebihi parameter 100B, jadi ia tidak boleh dilaksanakan untuk kebanyakan senario aplikasi.

Sebaliknya, pengekod teks sedar aksara membolehkan keupayaan ejaan yang berkuasa pada skala yang lebih kecil.

Dalam menggunakan penemuan ini pada senario penjanaan imej, para penyelidik melatih satu siri model teks-ke-imej yang sedar watak dan menunjukkan bahawa ia berprestasi baik pada teks sedia ada dan baharu Rendering dengan ketara mengatasi prestasi model buta watak dalam penilaian.

Tetapi untuk model tahap aksara tulen, walaupun prestasi pemaparan teks telah bertambah baik, untuk gesaan yang tidak melibatkan teks visual, penjajaran teks imej akan berkurangan.

Untuk mengurangkan masalah ini, penyelidik mencadangkan untuk menggabungkan perwakilan input peringkat watak dan peringkat token supaya prestasi terbaik dapat dicapai.

WikiSpell Benchmark

Memandangkan model generatif teks-ke-imej bergantung pada pengekod teks untuk menghasilkan perwakilan bagi penyahkodan, penyelidik mula-mula mengambil sampel beberapa perkataan daripada Wiktionary untuk mencipta We use penanda aras WikiSpell dan kemudian terokai keupayaan pengekod teks pada tugas penilaian ejaan teks sahaja berdasarkan set data ini.

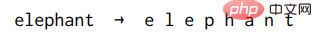

Untuk setiap contoh dalam WikiSpell, input kepada model ialah perkataan dan output yang dijangkakan ialah Its ejaan khusus (dihasilkan dengan memasukkan ruang antara setiap aksara Unicode).

Memandangkan artikel tersebut hanya berminat untuk mengkaji hubungan antara kekerapan sesuatu perkataan dan kebolehan mengeja model, pengkaji mengasaskan perkataan tersebut. pada mC4 Kekerapan kejadian dalam korpus membahagikan perkataan dalam Wiktionary kepada lima baldi tidak bertindih: 1% perkataan paling kerap, 1-10% perkataan paling kerap, 10-20% perkataan, 20-30% perkataan, dan 50% perkataan terendah (termasuk perkataan yang tidak pernah muncul dalam korpus).

Kemudian lukis 1000 perkataan secara sama rata daripada setiap baldi untuk mencipta set ujian (dan set pembangun yang serupa).

Akhirnya, set latihan 10,000 perkataan telah dibina dengan menggabungkan dua bahagian: 5,000 sampel seragam dari baldi 50% paling bawah (perkataan paling kurang biasa), dan 5,000 lagi sampel secara berkadaran dengan kekerapan mereka dalam mC4 (dengan itu berat sebelah separuh daripada latihan yang ditetapkan ke arah perkataan yang kerap).

Para penyelidik mengecualikan mana-mana perkataan yang dipilih ke dalam set pembangunan atau set ujian daripada set latihan, jadi keputusan penilaian sentiasa untuk perkataan yang dikecualikan.

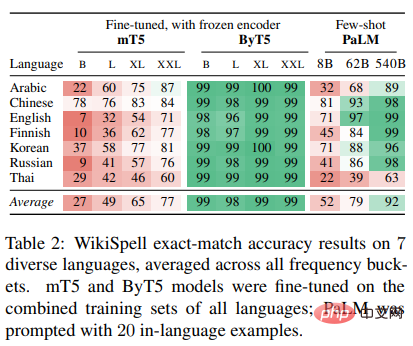

Selain bahasa Inggeris, penyelidik menilai enam bahasa lain (Arab, Cina, Finland, Korea, Rusia, Thai), dipilih untuk merangkumi model impak Untuk mempelajari pelbagai ciri keupayaan ejaan, proses pembinaan set data yang diterangkan di atas diulang untuk setiap penilaian bahasa.

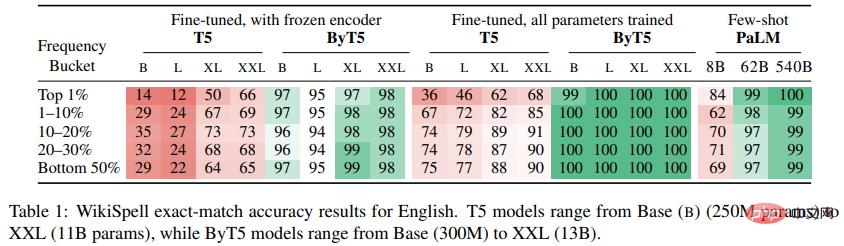

Eksperimen Penjanaan Teks

Penyelidik menggunakan penanda aras WikiSpell untuk menilai prestasi berbilang model teks sahaja yang telah terlatih pada skala berbeza, termasuk T5 (satu pada data Bahasa Inggeris model codec buta aksara yang telah dilatih mT5 (serupa dengan T5, tetapi dilatih terlebih dahulu pada lebih 100 bahasa ByT5 (versi mT5 yang menyedari watak yang beroperasi secara langsung pada urutan bait UTF-8) dan PaLM (a model penyahkodan yang lebih besar, terutamanya pra-latihan dalam bahasa Inggeris).

Dalam keputusan percubaan bahasa Inggeris tulen dan berbilang bahasa, boleh didapati bahawa model buta aksara T5 dan mT5 berprestasi lebih baik pada baldi yang mengandungi Top-1 % perkataan yang paling kerap.

Keputusan ini kelihatan berlawanan dengan intuitif kerana model biasanya menunjukkan prestasi terbaik pada contoh yang kerap muncul dalam data, tetapi disebabkan oleh cara perbendaharaan kata subkata dilatih, perkataan yang kerap muncul sering diwakili ialah token atom tunggal (atau sebilangan kecil token), dan begitu juga fakta bahawa 87% daripada perkataan dalam 1% baldi bahasa Inggeris teratas diwakili oleh perbendaharaan kata T5 sebagai token subkata.

Oleh itu, skor ketepatan ejaan yang rendah menunjukkan bahawa pengekod T5 tidak menyimpan maklumat ejaan yang mencukupi tentang subkata dalam perbendaharaan katanya.

Kedua, untuk model buta aksara, skala ialah faktor penting yang mempengaruhi keupayaan ejaan. Kedua-dua T5 dan mT5 secara beransur-ansur menjadi lebih baik dengan skala yang semakin meningkat, tetapi walaupun pada skala XXL, model ini tidak menunjukkan kebolehan ejaan yang sangat kuat.

Hanya apabila model buta aksara mencapai skala PaLM, anda mula melihat keupayaan ejaan yang hampir sempurna: model PaLM parameter 540B mencapai ini dalam semua tong frekuensi bahasa Inggeris> 99% ketepatan, walaupun ia hanya melihat 20 contoh dalam gesaan (manakala T5 menunjukkan 1000 contoh yang diperhalusi).

Walau bagaimanapun, prestasi PaLM lebih teruk pada bahasa lain, mungkin disebabkan oleh kurang data pralatihan untuk bahasa ini.

Percubaan pada ByT5 menunjukkan bahawa model yang menyedari watak mempamerkan keupayaan ejaan yang lebih berkuasa. Prestasi ByT5 pada saiz Base dan Large hanya ketinggalan sedikit di belakang XL dan XXL (walaupun masih sekurang-kurangnya dalam julat 90%), dan kekerapan sesuatu perkataan nampaknya tidak banyak memberi kesan kepada kebolehan mengeja ByT5.

Prestasi ejaan ByT5 jauh melebihi keputusan (m)T5, malah setanding dengan prestasi Bahasa Inggeris PaLM dengan 100 kali lebih banyak parameter, dan melebihi prestasi PaLM pada bahasa lain Prestasi .

Ia boleh dilihat bahawa pengekod ByT5 mengekalkan maklumat peringkat aksara yang banyak, dan maklumat ini boleh diambil daripada parameter beku ini mengikut keperluan tugas penyahkodan.

DrawText Benchmark

Daripada set data COCO yang dikeluarkan pada tahun 2014 kepada penanda aras DrawBench pada tahun 2022, cara menilai teks- Model kepada imej sentiasa menjadi penyelidikan penting topik.

Tetapi terdapat kekurangan kerja berkaitan dalam pemaparan teks dan penilaian ejaan.

Untuk tujuan ini, penyelidik mencadangkan penanda aras baharu, DrawText, yang direka bentuk untuk mengukur kualiti pemaparan teks secara menyeluruh bagi model teks-ke-imej.

Tanda aras DrawText terdiri daripada dua bahagian, mengukur dimensi berbeza keupayaan model:

1) Ejaan DrawText, Dinilai dengan terjemahan perkataan biasa bagi koleksi besar perkataan Inggeris;

Para penyelidik mengambil sampel 100 perkataan setiap satu daripada baldi kekerapan WikiSpell Bahasa Inggeris dan memasukkannya ke dalam templat standard untuk membina sejumlah 500 petua.

Untuk setiap gesaan, 4 imej diekstrak daripada model calon dan dinilai menggunakan penilaian manusia dan metrik berasaskan pengecaman aksara optik (OCR).

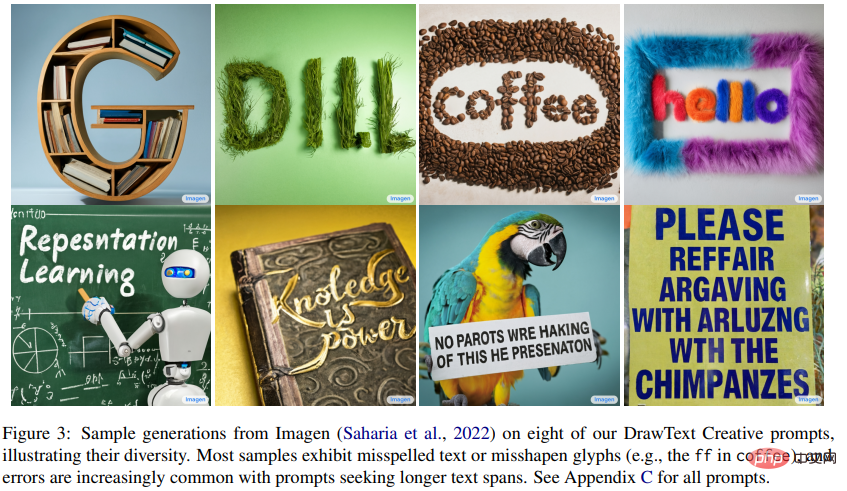

2) DrawText Creative, dinilai melalui pemaparan teks kesan visual.

Teks visual tidak terhad kepada adegan biasa seperti papan tanda jalan, teks boleh muncul dalam pelbagai bentuk, seperti menconteng, melukis, mengukir, arca, dsb.

Jika model penjanaan imej menyokong pemaparan teks yang fleksibel dan tepat, ini akan membolehkan pereka bentuk menggunakan model ini untuk membangunkan fon kreatif, logo, reka letak dan banyak lagi.

Untuk menguji keupayaan model penjanaan imej untuk menyokong kes penggunaan ini, para penyelidik bekerjasama dengan pereka grafik profesional untuk membina 175 gesaan berbeza yang memerlukan teks dipaparkan dalam pelbagai gaya dan tetapan kreatif.

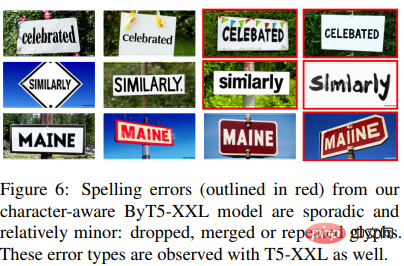

Banyak isyarat di luar kemampuan model semasa, dengan model terkini yang mempamerkan perkataan yang salah ejaan, digugurkan atau berulang.

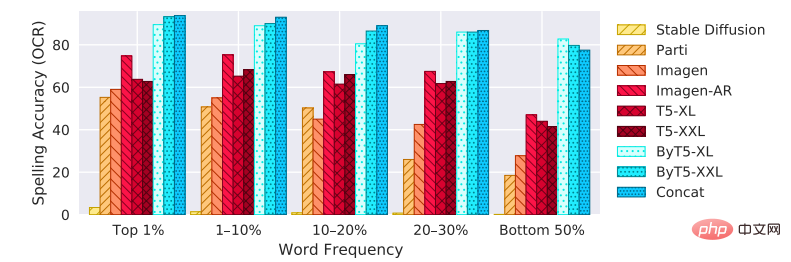

Eksperimen penjanaan imej

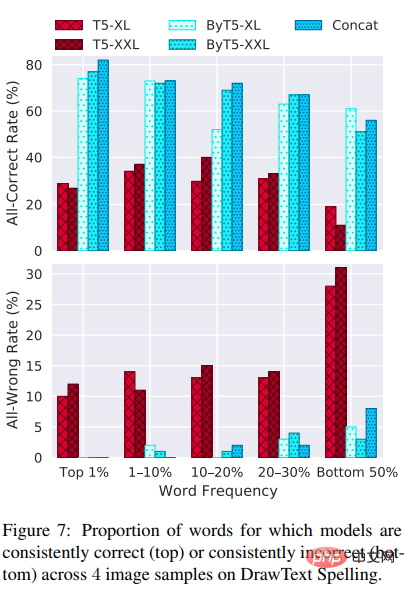

Keputusan eksperimen menunjukkan bahawa antara sembilan model penjanaan imej yang digunakan untuk perbandingan, model sedar watak ( ByT5 dan Concat) mengatasi model lain tanpa mengira saiz model, terutamanya pada perkataan yang tidak biasa.

Imagen-AR menunjukkan faedah untuk mengelakkan pemangkasan, dan walaupun mengambil masa latihan 6.6 kali lebih lama, ia masih berprestasi lebih teruk daripada model yang menyedari watak .

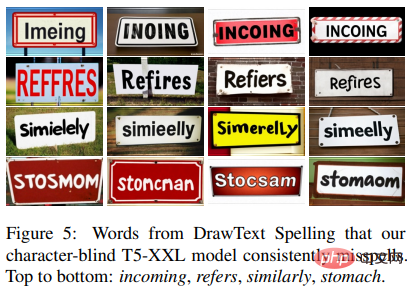

Satu lagi perbezaan yang jelas antara model ialah sama ada mereka secara konsisten salah mengeja perkataan tertentu merentas berbilang sampel.

Dapat dilihat dalam keputusan eksperimen bahawa tidak kira berapa banyak sampel yang diambil, model T5 mempunyai banyak perkataan yang salah ejaan, yang mana penyelidik percaya menunjukkan bahawa teks Pengetahuan aksara tiada dalam pengekod.

Sebaliknya, model ByT5 pada asasnya hanya mempunyai ralat sporadis.

Boleh dikira dengan mengukur kadar model konsisten betul (4/4) atau konsisten salah (0/4) merentas semua empat sampel imej Pemerhatian ini.

Kontras yang ketara dapat dilihat, terutamanya pada perkataan biasa (1%), iaitu model ByT5 tidak pernah membuat kesilapan secara konsisten, Dan model T5 secara konsisten membuat kesilapan pada 10% atau lebih perkataan.

Atas ialah kandungan terperinci Jangan jadi pelukis yang buta huruf! Google mengubah suai 'Pengekod Teks' secara ajaib: operasi kecil membolehkan model penjanaan imej mempelajari 'ejaan'. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1376

1376

52

52

Cara Mengulas DeepSeek

Feb 19, 2025 pm 05:42 PM

Cara Mengulas DeepSeek

Feb 19, 2025 pm 05:42 PM

DeepSeek adalah alat pengambilan maklumat yang kuat. .

Cara Mencari DeepSeek

Feb 19, 2025 pm 05:39 PM

Cara Mencari DeepSeek

Feb 19, 2025 pm 05:39 PM

DeepSeek adalah enjin carian proprietari yang hanya mencari dalam pangkalan data atau sistem tertentu, lebih cepat dan lebih tepat. Apabila menggunakannya, pengguna dinasihatkan untuk membaca dokumen itu, cuba strategi carian yang berbeza, dapatkan bantuan dan maklum balas mengenai pengalaman pengguna untuk memanfaatkan kelebihan mereka.

Sesame Open Door Exchange Web Pautan Pautan Gerbang Perdagangan Laman Web Pendaftaran Terkini

Feb 28, 2025 am 11:06 AM

Sesame Open Door Exchange Web Pautan Pautan Gerbang Perdagangan Laman Web Pendaftaran Terkini

Feb 28, 2025 am 11:06 AM

Artikel ini memperkenalkan proses pendaftaran versi web Web Open Exchange (GATE.IO) dan aplikasi Perdagangan Gate secara terperinci. Sama ada pendaftaran web atau pendaftaran aplikasi, anda perlu melawat laman web rasmi atau App Store untuk memuat turun aplikasi tulen, kemudian isi nama pengguna, kata laluan, e -mel, nombor telefon bimbit dan maklumat lain, dan lengkap e -mel atau pengesahan telefon bimbit.

Mengapa pautan Bybit Exchange tidak dimuat turun dan dipasang secara langsung?

Feb 21, 2025 pm 10:57 PM

Mengapa pautan Bybit Exchange tidak dimuat turun dan dipasang secara langsung?

Feb 21, 2025 pm 10:57 PM

Mengapa pautan Bybit Exchange tidak dimuat turun dan dipasang secara langsung? Bybit adalah pertukaran cryptocurrency yang menyediakan perkhidmatan perdagangan kepada pengguna. Aplikasi mudah alih Exchange tidak boleh dimuat turun terus melalui AppStore atau GooglePlay untuk sebab -sebab berikut: 1. Aplikasi pertukaran cryptocurrency sering tidak memenuhi keperluan ini kerana ia melibatkan perkhidmatan kewangan dan memerlukan peraturan dan standard keselamatan tertentu. 2. Undang -undang dan Peraturan Pematuhan di banyak negara, aktiviti yang berkaitan dengan urus niaga cryptocurrency dikawal atau terhad. Untuk mematuhi peraturan ini, aplikasi bybit hanya boleh digunakan melalui laman web rasmi atau saluran yang diberi kuasa lain

Platform Perdagangan Pintu Terbuka Sesame Muat turun Versi Mudah Alih Platform Perdagangan Platform Perdagangan Alamat Muat Turun

Feb 28, 2025 am 10:51 AM

Platform Perdagangan Pintu Terbuka Sesame Muat turun Versi Mudah Alih Platform Perdagangan Platform Perdagangan Alamat Muat Turun

Feb 28, 2025 am 10:51 AM

Adalah penting untuk memilih saluran rasmi untuk memuat turun aplikasi dan memastikan keselamatan akaun anda.

Top 10 Disyorkan untuk App Perdagangan Aset Digital Crypto (2025 Global Ranking)

Mar 18, 2025 pm 12:15 PM

Top 10 Disyorkan untuk App Perdagangan Aset Digital Crypto (2025 Global Ranking)

Mar 18, 2025 pm 12:15 PM

Artikel ini mencadangkan sepuluh platform perdagangan cryptocurrency teratas yang memberi perhatian kepada, termasuk Binance, OKX, Gate.io, Bitflyer, Kucoin, Bybit, Coinbase Pro, Kraken, BYDFI dan Xbit yang desentralisasi. Platform ini mempunyai kelebihan mereka sendiri dari segi kuantiti mata wang transaksi, jenis urus niaga, keselamatan, pematuhan, dan ciri khas. Memilih platform yang sesuai memerlukan pertimbangan yang komprehensif berdasarkan pengalaman perdagangan anda sendiri, toleransi risiko dan keutamaan pelaburan. Semoga artikel ini membantu anda mencari saman terbaik untuk diri sendiri

Portal Log Masuk Versi Rasmi Binance Binance

Feb 21, 2025 pm 05:42 PM

Portal Log Masuk Versi Rasmi Binance Binance

Feb 21, 2025 pm 05:42 PM

Untuk mengakses versi Login Laman Web Binance yang terkini, ikuti langkah mudah ini. Pergi ke laman web rasmi dan klik butang "Login" di sudut kanan atas. Pilih kaedah log masuk anda yang sedia ada. Masukkan nombor mudah alih berdaftar atau e -mel dan kata laluan anda dan pengesahan lengkap (seperti kod pengesahan mudah alih atau Google Authenticator). Selepas pengesahan yang berjaya, anda boleh mengakses Portal Log masuk laman web rasmi Binance.

WEB OPEN DOOR EXCHANGE WEB PAGE LOGIN VERSI VERSI UNTUK GATEIO Laman Web Rasmi Pintu Masuk

Mar 04, 2025 pm 11:48 PM

WEB OPEN DOOR EXCHANGE WEB PAGE LOGIN VERSI VERSI UNTUK GATEIO Laman Web Rasmi Pintu Masuk

Mar 04, 2025 pm 11:48 PM

Pengenalan terperinci kepada operasi log masuk versi Web Open Exchange, termasuk langkah masuk dan proses pemulihan kata laluan.