Peranti teknologi

Peranti teknologi

AI

AI

Multimodaliti bersatu semula! Meta mengeluarkan algoritma penyeliaan sendiri data2vec 2.0: kecekapan latihan meningkat sehingga 16 kali ganda!

Multimodaliti bersatu semula! Meta mengeluarkan algoritma penyeliaan sendiri data2vec 2.0: kecekapan latihan meningkat sehingga 16 kali ganda!

Multimodaliti bersatu semula! Meta mengeluarkan algoritma penyeliaan sendiri data2vec 2.0: kecekapan latihan meningkat sehingga 16 kali ganda!

Kebanyakan kejayaan dalam bidang kecerdasan buatan sejak beberapa tahun kebelakangan ini telah didorong oleh pembelajaran penyeliaan kendiri, seperti MLM (Model Bahasa Bertopeng) yang dicadangkan dalam BERT, yang meramalkan semula beberapa perkataan dalam teks dengan menutupnya , membenarkan data teks besar yang tidak berlabel digunakan untuk melatih model, dan sejak itu telah membuka era baharu model pra-latihan berskala besar. Walau bagaimanapun, algoritma pembelajaran yang diselia sendiri juga mempunyai had yang jelas Ia biasanya hanya sesuai untuk data dalam satu modaliti (seperti imej, teks, pertuturan, dll.), dan memerlukan banyak kuasa pengkomputeran untuk belajar daripada data besar-besaran. Sebaliknya, manusia belajar dengan ketara lebih cekap daripada model AI semasa dan boleh belajar daripada pelbagai jenis data.

Pada Januari 2022, Meta AI mengeluarkan data2vec rangka kerja pembelajaran penyeliaan kendiri , menyepadukan tiga data modal (suara, visual dan teks) melalui rangka kerja, terdapat trend menyatukan pelbagai mod. Baru-baru ini Meta AI dikeluarkan data2cec versi 2.0 , terutamanya meningkatkan generasi sebelumnya dari segi prestasi: dengan ketepatan yang sama, kelajuan latihan adalah sehingga 16 kali lebih tinggi daripada algoritma lain!

Pautan kertas:https://ai.facebook.com/research/publications/epembelajaran-pengawasan-sendiri-cekap-dengan-perwakilan-sasaran-kontekstual-untuk-penglihatan-pertuturan-dan-bahasa

Pautan kod:https://github.com/faceboo kresearch/fairseq/tree/main/examples/data2vec

data2vec 1.0

Pada masa ini Secara umumnya, kebanyakan model pembelajaran mesin masih berdasarkan model pembelajaran yang diselia, yang memerlukan anotasi khusus untuk melabelkan data sasaran Walau bagaimanapun, untuk beberapa tugas (seperti beribu-ribu bahasa manusia di bumi), adalah perlu untuk mengumpul anotasi . Data tidak tersedia.

Sebaliknya, pembelajaran penyeliaan kendiri tidak perlu memberitahu model apa yang betul dan salah, tetapi membenarkan mesin belajar imej dengan memerhati dunia, struktur pertuturan dan teks. Hasil penyelidikan berkaitan telah menggalakkan pertuturan (cth., wave2vec 2.0), penglihatan komputer (cth., autoenkoder bertopeng), dan pemprosesan bahasa semula jadi (cth., BERT) dan bidang lain.

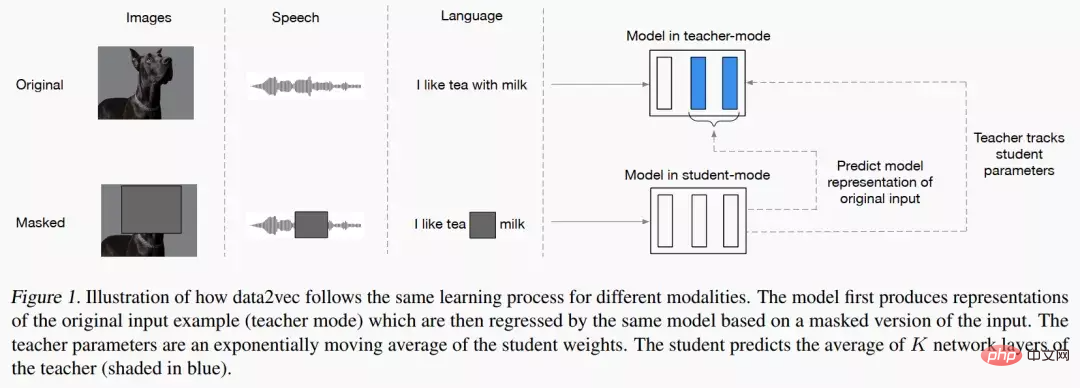

Idea utama data2vec adalah untuk membina rangkaian guru dahulu dan mula-mula mengira perwakilan sasaran daripada imej, teks atau ucapan . Data kemudiannya ditutup untuk mengaburkan bahagian input, dan proses diulang dengan rangkaian pelajar untuk meramalkan perwakilan yang diperoleh oleh model guru.

Dengan kata lain, model pelajar hanya boleh meramalkan perwakilan "data input lengkap" sambil menerima "maklumat input tidak lengkap". Untuk memastikan ketekalan kedua-dua model, parameter kedua-dua model dikongsi, tetapi parameter model Guru akan dikemas kini dengan lebih cepat pada peringkat awal latihan. Dari segi keputusan percubaan, data2vec telah meningkatkan prestasi dengan ketara berbanding model garis dasar dalam pertuturan, penglihatan, teks dan tugasan lain.

data2vec 2.0

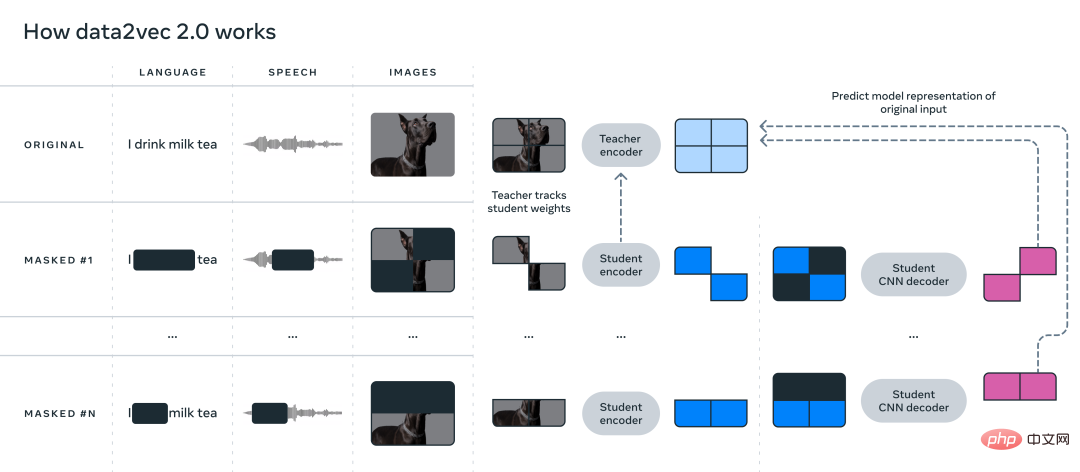

data2vec mencadangkan umum rangka kerja pembelajaran penyeliaan kendiri menyatukan pembelajaran tiga data modal: pertuturan, penglihatan dan bahasa Perkara utama yang diselesaikan oleh data2vec2.0 ialah membina model penyeliaan sendiri memerlukan sejumlah besar kuasa pengkomputeran GPU untuk melengkapkan latihan. Sama seperti algoritma data2vec asal, data2vec 2.0 meramalkan perwakilan kontekstual bagi data atau lapisan rangkaian saraf, dan bukannya meramalkan piksel dalam imej, perkataan dalam segmen teks atau pertuturan.

Tidak seperti algoritma biasa yang lain, apa yang dipanggil perwakilan sasaran ini adalah kontekstual, yang bermaksud bahawa algoritma perlu Keseluruhan contoh latihan diambil kira.

Sebagai contoh, model mempelajari perwakilan perkataan bank berdasarkan keseluruhan ayat yang mengandungi bank, menjadikannya lebih mudah untuk menyimpulkan maksud perkataan yang betul, seperti membezakan sama ada ia secara khusus merujuk kepada "institusi kewangan" atau "tanah di tepi sungai." Para penyelidik percaya bahawa matlamat kontekstual akan memudahkan tugas pembelajaran yang lebih kaya dan membolehkan data2vec 2.0 belajar lebih cepat daripada algoritma lain.

data2vec 2.0 meningkatkan kecekapan algoritma data2vec asal dalam tiga cara berikut:

1 Bina perwakilan sasaran untuk contoh latihan tertentu dan gunakan semula perwakilan pada versi bertopeng. Dalam versi bertopeng, bahagian contoh latihan yang berlainan disembunyikan secara rawak. Perwakilan yang dipelajari oleh kedua-dua versi kemudiannya dimasukkan ke dalam model pelajar, yang meramalkan perwakilan sasaran kontekstual yang sama untuk versi topeng yang berbeza, dengan berkesan melunaskan usaha pengiraan yang diperlukan untuk mencipta perwakilan sasaran.

2 Sama seperti pengekod auto bertopeng (MAE), rangkaian pengekod dalam model pelajar tidak berfungsi Bahagian kosong bagi contoh latihan (dikosongkan). Dalam eksperimen imej, kira-kira 80% bahagian kosong, menghasilkan penjimatan kitaran pengiraan yang ketara.

3 Model penyahkod yang lebih berkesan digunakan, yang tidak lagi bergantung pada rangkaian Transformer, tetapi bergantung pada berbilang lapisan. Rangkaian konvolusi.

Bahagian Eksperimen

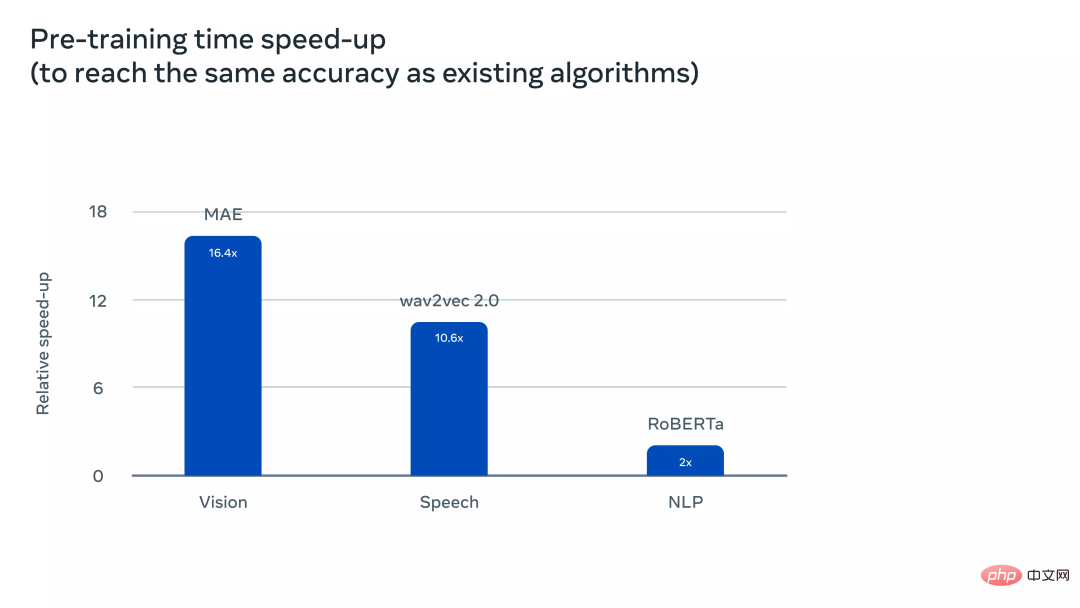

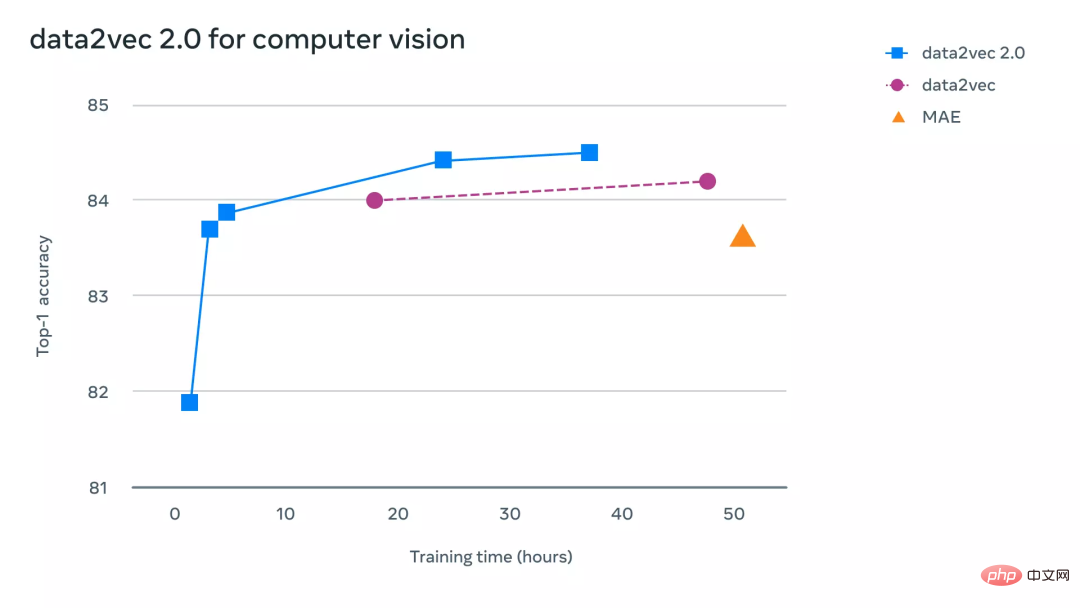

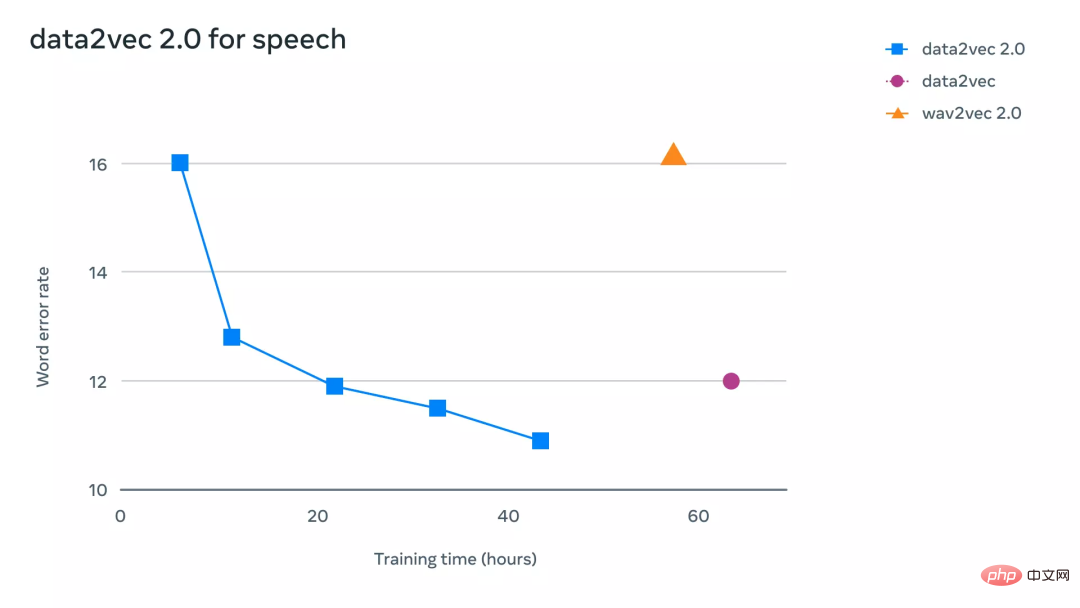

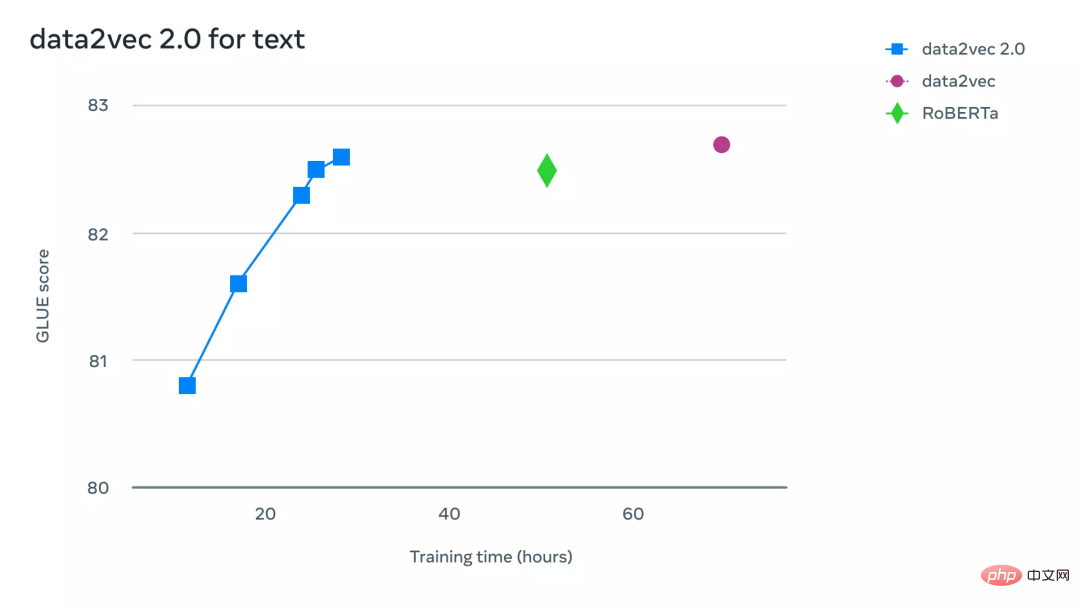

Untuk memahami dengan lebih intuitif betapa lebih cekap data2vec 2.0 berbanding data2vec dan algoritma lain yang serupa, penyelidik dalam Computer Vision Eksperimen yang meluas dijalankan pada penanda aras yang berkaitan dengan , pertuturan dan tugasan teks. Dalam percubaan, ketepatan akhir dan masa yang diperlukan untuk pra-latihan model telah dipertimbangkan terutamanya Persekitaran eksperimen semuanya pada perkakasan yang sama (model GPU, kuantiti, dll.) untuk mengukur kelajuan berjalan algoritma.

Mengenai tugas penglihatan komputer, para penyelidik menilai data2vec 2.0 pada tanda aras klasifikasi imej ImageNet-1K standard, set data dari mana model boleh mempelajari Imej perwakilan. Keputusan eksperimen menunjukkan bahawa data2vec 2.0 boleh menyamai ketepatan pengekod auto bertopeng (MAE), tetapi 16 kali lebih pantas.

Jika anda terus memberikan algoritma data2vec 2.0 lebih masa berjalan, ia boleh mencapai ketepatan yang lebih tinggi dan masih lebih pantas daripada MAE.

Mengenai tugas pertuturan, penyelidik mengujinya pada penanda aras pengecaman pertuturan LibriLanguage, dan ia lebih daripada 11 kali lebih tepat daripada wave2vec 2.0.

Untuk tugasan pemprosesan bahasa semula jadi, penyelidik menilai data2vec 2.0 pada penanda aras General Language Understanding Evaluation (GLUE), yang memerlukan hanya separuh masa latihan. boleh mencapai ketepatan yang sama seperti RoBERTa, pelaksanaan semula BERT.

Atas ialah kandungan terperinci Multimodaliti bersatu semula! Meta mengeluarkan algoritma penyeliaan sendiri data2vec 2.0: kecekapan latihan meningkat sehingga 16 kali ganda!. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1382

1382

52

52

Petua Konfigurasi Firewall Pelayan Mel Debian

Apr 13, 2025 am 11:42 AM

Petua Konfigurasi Firewall Pelayan Mel Debian

Apr 13, 2025 am 11:42 AM

Mengkonfigurasi firewall pelayan Mail Debian adalah langkah penting dalam memastikan keselamatan pelayan. Berikut adalah beberapa kaedah konfigurasi firewall yang biasa digunakan, termasuk penggunaan iptables dan firewalld. Gunakan iptables untuk mengkonfigurasi firewall untuk memasang iptables (jika belum dipasang): sudoapt-getupdateudoapt-getinstalliplesview peraturan iptables semasa: konfigurasi sudoiptable-l

Kaedah pemasangan sijil SSL Server Server Debian

Apr 13, 2025 am 11:39 AM

Kaedah pemasangan sijil SSL Server Server Debian

Apr 13, 2025 am 11:39 AM

Langkah -langkah untuk memasang sijil SSL pada pelayan mel Debian adalah seperti berikut: 1. Pasang OpenSSL Toolkit terlebih dahulu, pastikan bahawa OpenSSL Toolkit telah dipasang pada sistem anda. Jika tidak dipasang, anda boleh menggunakan arahan berikut untuk memasang: sudoapt-getupdateudoapt-getinstallopenssl2. Menjana permintaan kunci dan sijil peribadi seterusnya, gunakan OpenSSL untuk menjana kunci peribadi RSA 2048-bit dan permintaan sijil (CSR): Membuka

Baris arahan shutdown centos

Apr 14, 2025 pm 09:12 PM

Baris arahan shutdown centos

Apr 14, 2025 pm 09:12 PM

Perintah shutdown CentOS adalah penutupan, dan sintaks adalah tutup [pilihan] [maklumat]. Pilihan termasuk: -h menghentikan sistem dengan segera; -P mematikan kuasa selepas penutupan; -r mulakan semula; -T Waktu Menunggu. Masa boleh ditentukan sebagai segera (sekarang), minit (minit), atau masa tertentu (HH: mm). Maklumat tambahan boleh dipaparkan dalam mesej sistem.

Sony mengesahkan kemungkinan menggunakan GPU khas di PS5 Pro untuk membangunkan AI dengan AMD

Apr 13, 2025 pm 11:45 PM

Sony mengesahkan kemungkinan menggunakan GPU khas di PS5 Pro untuk membangunkan AI dengan AMD

Apr 13, 2025 pm 11:45 PM

Mark Cerny, Ketua Arkitek SonyinterActiveEntainment (SIE, Sony Interactive Entertainment), telah mengeluarkan lebih banyak butiran perkakasan dari PlayStation5Pro hos generasi akan datang (PS5Pro), termasuk GPU seni bina AMDRDNA2.x yang dinamakan, dan Kod Arsitektur AMDRDNA2.x yang dinamakan. Tumpuan peningkatan prestasi PS5Pro masih pada tiga tiang, termasuk GPU yang lebih kuat, jejak sinar maju dan fungsi resolusi super PSSR yang berkuasa AI. GPU mengamalkan seni bina AmdrDNA2 yang disesuaikan, yang Sony menamakan RDNA2.x, dan ia mempunyai beberapa seni bina RDNA3.

Apakah kaedah sandaran untuk gitlab di centos

Apr 14, 2025 pm 05:33 PM

Apakah kaedah sandaran untuk gitlab di centos

Apr 14, 2025 pm 05:33 PM

Dasar sandaran dan pemulihan Gitlab di bawah sistem CentOS untuk memastikan keselamatan data dan pemulihan, Gitlab pada CentOS menyediakan pelbagai kaedah sandaran. Artikel ini akan memperkenalkan beberapa kaedah sandaran biasa, parameter konfigurasi dan proses pemulihan secara terperinci untuk membantu anda menubuhkan strategi sandaran dan pemulihan GitLab lengkap. 1. Backup Manual Gunakan Gitlab-Rakegitlab: Backup: Buat Perintah untuk Melaksanakan Backup Manual. Perintah ini menyokong maklumat utama seperti repositori Gitlab, pangkalan data, pengguna, kumpulan pengguna, kunci, dan kebenaran. Fail sandaran lalai disimpan dalam direktori/var/opt/gitlab/sandaran. Anda boleh mengubah suai /etc /gitlab

Apakah kaedah penalaan prestasi zookeeper di CentOS

Apr 14, 2025 pm 03:18 PM

Apakah kaedah penalaan prestasi zookeeper di CentOS

Apr 14, 2025 pm 03:18 PM

Penalaan prestasi zookeeper pada centOs boleh bermula dari pelbagai aspek, termasuk konfigurasi perkakasan, pengoptimuman sistem operasi, pelarasan parameter konfigurasi, pemantauan dan penyelenggaraan, dan lain -lain. Memori yang cukup: memperuntukkan sumber memori yang cukup untuk zookeeper untuk mengelakkan cakera kerap membaca dan menulis. CPU multi-teras: Gunakan CPU multi-teras untuk memastikan bahawa zookeeper dapat memprosesnya selari.

Cara Memeriksa Konfigurasi HDFS CentOS

Apr 14, 2025 pm 07:21 PM

Cara Memeriksa Konfigurasi HDFS CentOS

Apr 14, 2025 pm 07:21 PM

Panduan Lengkap untuk Memeriksa Konfigurasi HDFS Dalam Sistem CentOS Artikel ini akan membimbing anda bagaimana untuk memeriksa konfigurasi dan menjalankan status HDFS secara berkesan pada sistem CentOS. Langkah -langkah berikut akan membantu anda memahami sepenuhnya persediaan dan operasi HDFS. Sahkan Pembolehubah Alam Sekitar Hadoop: Pertama, pastikan pembolehubah persekitaran Hadoop ditetapkan dengan betul. Di terminal, laksanakan arahan berikut untuk mengesahkan bahawa Hadoop dipasang dan dikonfigurasi dengan betul: Hadoopversion Semak fail konfigurasi HDFS: Fail konfigurasi teras HDFS terletak di/etc/hadoop/conf/direktori, di mana core-site.xml dan hdfs-site.xml adalah kritikal. gunakan

Akhirnya berubah! Fungsi carian Microsoft Windows akan membawa kemas kini baru

Apr 13, 2025 pm 11:42 PM

Akhirnya berubah! Fungsi carian Microsoft Windows akan membawa kemas kini baru

Apr 13, 2025 pm 11:42 PM

Penambahbaikan Microsoft ke fungsi carian Windows telah diuji pada beberapa saluran Windows Insider di EU. Sebelum ini, fungsi carian Windows bersepadu dikritik oleh pengguna dan mempunyai pengalaman yang buruk. Kemas kini ini membahagikan fungsi carian ke dalam dua bahagian: carian tempatan dan carian web berasaskan Bing untuk meningkatkan pengalaman pengguna. Versi baru antara muka carian melakukan carian fail tempatan secara lalai. Jika anda perlu mencari dalam talian, anda perlu mengklik tab "Microsoft Bingwebsearch" untuk menukar. Selepas bertukar, bar carian akan memaparkan "Microsoft Bingwebsearch:", di mana pengguna boleh memasukkan kata kunci. Langkah ini berkesan mengelakkan pencampuran hasil carian tempatan dengan hasil carian Bing