Peranti teknologi

Peranti teknologi

AI

AI

Pengeluaran GPT4 akan datang adalah setanding dengan otak manusia, dan ramai pemimpin industri tidak boleh duduk diam!

Pengeluaran GPT4 akan datang adalah setanding dengan otak manusia, dan ramai pemimpin industri tidak boleh duduk diam!

Pengeluaran GPT4 akan datang adalah setanding dengan otak manusia, dan ramai pemimpin industri tidak boleh duduk diam!

Pengarang |. Xu Jiecheng

Penilai |. Jika anda mempunyai kuasa besar memenangi 5 juta tiket loteri setiap hari, maka jika anda menyimpan semua wang tanpa makan atau minum, anda masih perlu hidup kira-kira 5,500 tahun untuk menjimatkan 100 trilion kekayaan. Walau bagaimanapun, 100 trilion yang saya ingin bercakap dengan anda hari ini tidak berada di belakang unit yang diidamkan seperti "RMB" dan "Dollor". 100 trilion di sini merujuk kepada bilangan parameter yang dimiliki oleh OpenAI, sebuah syarikat penyelidikan kecerdasan buatan yang diasaskan bersama oleh banyak taikun teknologi Silicon Valley, yang akan mengeluarkan generasi keempat Transformer-GPT-4 generatif pra-latihan.

Untuk memudahkan semua orang memahami data ini dengan lebih intuitif, kita boleh menggunakan otak manusia untuk membandingkan dengan GPT-4. Dalam keadaan biasa, otak manusia normal mempunyai kira-kira 80-100 bilion neuron dan kira-kira 100 trilion sinaps. Neuron dan sinaps ini secara langsung mengawal hampir semua pemikiran, pertimbangan dan tingkah laku seseorang dalam seratus tahun kehidupan, dan GPT-4 mempunyai parameter sebanyak sinaps dalam otak manusia. Jadi, apakah potensi rangkaian saraf yang padat berskala besar. Apakah kejutan yang akan dibawa oleh kemunculan GPT-4 kepada kita? Adakah kita benar-benar mempunyai keupayaan untuk mencipta otak manusia?

Sebelum meneroka soalan-soalan menarik ini, sebaiknya kita memahami dahulu sejarah pembangunan beberapa "pendahulu" GPT-4.

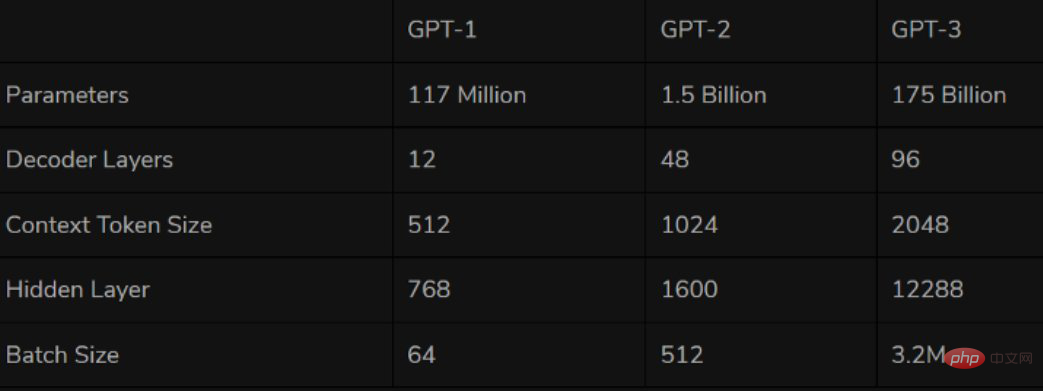

1 GPT: Tiada lagi, tetapi filem blockbuster

Model siri GPT pertama GPT-1 dilahirkan pada 2018, iaitu kami. Tahun pertama model pra-latihan NLP yang sering dikatakan. Sebagai model pra-latihan pertama berdasarkan Transformer, GPT-1 menggunakan dua peringkat pra-latihan + FineTuning, menggunakan penyahkod Transformer sebagai pengekstrak ciri Ia mempunyai sejumlah 12 lapisan yang disusun dengan 110 juta parameter Peringkat pra-latihan menggunakan "Model Bahasa" tunggal sebagai tugas latihan.

Dari segi prestasi, GPT-1 mempunyai keupayaan generalisasi tertentu dan boleh digunakan dalam tugas NLP yang tidak berkaitan dengan tugas penyeliaan. Tugasan yang biasa digunakan termasuk:

Penaakulan bahasa semula jadi: tentukan hubungan antara dua ayat (pembendungan, percanggahan, berkecuali)- Soal jawab dan penaakulan akal : masukkan artikel Dan beberapa jawapan, ketepatan jawapan output

- Pengecaman persamaan semantik: Tentukan sama ada semantik dua ayat berkaitan

- Klasifikasi: Tentukan kategori mana teks input ditentukan

Sumber imej: Twitter

Dari segi prestasi, kekuatan hebat OpenAI nampaknya benar-benar membawa beberapa keajaiban. Di samping keupayaan pemahamannya, GPT-2 buat pertama kalinya menunjukkan bakat yang kuat dalam generasi: membaca ringkasan, berbual, meneruskan penulisan, membuat cerita, malah menjana berita palsu, e-mel pancingan data atau berpura-pura menjadi orang lain dalam talian adalah semuanya. angin sepoi-sepoi. Selepas "menjadi lebih besar", GPT-2 telah menunjukkan satu siri keupayaan universal dan berkuasa, dan mencapai prestasi terbaik pada masa itu dalam pelbagai tugas pemodelan bahasa tertentu. Tidak hairanlah OpenAI berkata pada masa itu bahawa "GPT-2 terlalu berbahaya untuk dikeluarkan."

GPT-3 sekali lagi telah membuktikan visi OpenAI Disebabkan prestasi GPT-3 yang lebih kukuh dan lebih banyak parameter, ia mengandungi lebih banyak teks topik, yang jelas lebih baik daripada GPT-2 generasi sebelumnya. Sebagai rangkaian saraf padat terbesar yang ada pada masa ini, GPT-3 boleh menukar perihalan halaman web kepada kod yang sepadan, meniru naratif manusia, mencipta puisi tersuai, menjana skrip permainan, dan juga meniru ahli falsafah yang telah meninggal dunia-meramalkan makna sebenar kehidupan. Dan GPT-3 tidak memerlukan penalaan halus, ia hanya memerlukan beberapa sampel jenis output (sedikit pembelajaran) untuk menangani masalah tatabahasa yang sukar. Boleh dikatakan GPT-3 nampaknya telah memuaskan semua imaginasi kami untuk pakar bahasa.

2 Lulus ujian Turing secara komprehensif dan menurunkan ambang untuk pembelajaran dan penggunaan komersial

Bercakap mengenai perkara ini, saya percaya semua orang akan mempunyai soalan yang sama - GPT-3 sudah sangat Sekarang kerana ia berkuasa, apa lagi yang boleh kita nantikan dalam GPT-4?

Seperti yang kita semua tahu, cara teras untuk menguji kecerdasan sistem AI ialah ujian Turing Apabila kita masih tidak dapat menggunakan piawaian boleh diukur secara saintifik untuk mentakrifkan konsep kecerdasan manusia , Ujian Turing pada masa ini merupakan salah satu daripada beberapa kaedah ujian yang boleh dilaksanakan yang boleh menentukan sama ada pihak lain mempunyai kecerdasan manusia. Untuk menggunakan peribahasa: Jika sesuatu kelihatan seperti itik, berjalan seperti itik, dan cuak seperti itik, maka ia adalah itik. Oleh itu, jika sistem AI berjaya melepasi ujian Turing, bermakna sistem tersebut mempunyai pemikiran manusia dan mungkin menggantikan manusia dalam beberapa aspek. Menurut laporan media IT Korea, sejak pertengahan November, industri telah melaporkan bahawa GPT-4 telah lulus sepenuhnya ujian Turing. Eksekutif syarikat Vodier AI Korea Selatan Nam Se-dong berkata dalam temu bual baru-baru ini dengan "Berita Ekonomi" Korea Selatan: "Walaupun berita bahawa GPT-4 lulus ujian Turing belum disahkan secara rasmi, berita itu sepatutnya boleh dipercayai

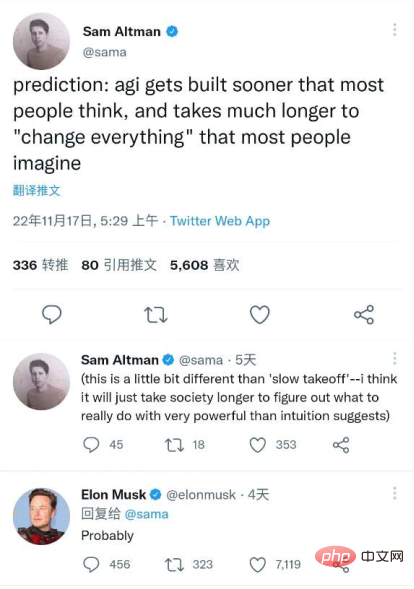

Sam Altman, seorang juruteknik dan Ketua Pegawai Eksekutif OpenAI semasa, juga nampaknya mengesahkan maklumat ini di Twitternya. Altman tweet pada 10 November, meniru baris klasik daripada watak "Star Wars" Darth Vader: "Jangan berbangga dengan panik teknologi yang anda cipta ini. Keupayaan untuk lulus Ujian Turing adalah dalam 'asal'. tiada apa yang boleh anda lakukan dalam menghadapi kekerasan."

Sumber imej: Twitter

Seorang eksekutif syarikat permulaan AI menganalisis bahawa “Jika GPT- 4 benar-benar lulus ujian Turing dengan sempurna, jadi impaknya cukup untuk menyebabkan 'kepanikan teknologi' di dunia AI, jadi Altman menggunakan watak Darth Vader untuk mengumumkan maklumat ini."

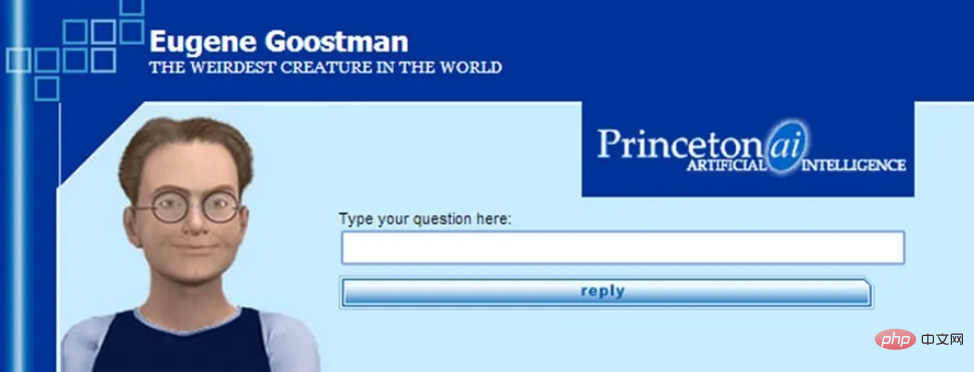

Jika GPT-4 lulus ujian Turing tanpa sebarang sekatan, ia sememangnya akan mencipta sejarah. Walaupun beberapa model AI sebelum ini mendakwa lulus ujian Turing, mereka tidak pernah diiktiraf sebulat suara oleh industri AI. Ini kerana piawaian dan peraturan ujian Turing tidak jelas, jadi banyak model bijak mengeksploitasi beberapa "bintik buta" dalam ujian. Model AI "Eugene" yang dilancarkan oleh University of Reading di UK pada tahun 2014 adalah contoh biasa Pada masa itu, University of Reading mendakwa kepada hakim bahawa model itu adalah seorang budak lelaki Ukraine berusia 13 tahun, jadi. apabila algoritma tidak dapat memberikan jawapan yang baik Pada masa itu, juri percaya bahawa ini adalah kerana subjek ujian adalah kanak-kanak asing.

Sumber imej: Internet

Walaupun ujian Turing bukanlah titik rujukan mutlak untuk teknologi AI , Tetapi sebagai ujian teknologi AI tertua dan paling terkenal setakat ini, Ujian Turing masih mempunyai kepentingan simbolik yang besar. Jika GPT-4 benar-benar secara rasmi dan pasti lulus ujian Turing, maka kemungkinan besar ia akan mencipta pencapaian terbesar dalam industri AI setakat ini.

Selain itu, tidak seperti GPT-3, GPT-4 kemungkinan besar akan menjadi lebih daripada sekadar model bahasa. Ilya Sutskever, ketua saintis OpenAI, pernah membayangkan perkara ini dalam artikel berkaitan multi-modalnya - "Teks itu sendiri boleh menyatakan banyak maklumat tentang dunia, tetapi ia tidak lengkap, kerana kita juga hidup dalam dunia visual." Oleh itu, sesetengah pakar dalam industri percaya bahawa GPT-4 akan berbilang modal dan boleh menerima input audio, teks, imej dan juga video, dan meramalkan bahawa set data audio Whisper OpenAI akan digunakan untuk mencipta data teks GPT-4. Ini juga bermakna GPT-4 tidak lagi mempunyai sebarang had dalam menerima dan memproses maklumat luaran.

Sebab industri memberi perhatian kepada GPT-4 berkemungkinan besar kerana ambang komersil sebenar GPT-4 akan lebih rendah daripada GPT-3 tradisional. Perusahaan yang sebelum ini tidak dapat menggunakan teknologi berkaitan kerana kos yang besar dan sebab infrastruktur juga dijangka menggunakan GPT-4. GPT-4 kini berada di peringkat akhir penyenaraian dan akan dikeluarkan antara Disember tahun ini dan Februari tahun depan. Alberto Garcia, seorang penganalisis di Cambridge AI Research, menerbitkan blog dan meramalkan: "GPT-4 akan lebih menumpukan pada pengoptimuman pemprosesan data, jadi kos pembelajaran GPT-4 dijangka lebih rendah daripada GPT-3. Kos pembelajaran setiap episod GPT-4 Ia mungkin akan dikurangkan daripada berjuta-juta dolar untuk GPT-3 kepada kira-kira $1 juta."

3. Laluan yang berbeza membawa kepada matlamat yang sama: simulasi otak manusia mungkin datang lebih cepat

Jika semua maklumat di atas adalah benar, maka kita boleh meramalkan pada masa ini bahawa dengan keluaran GPT-4, tahun depan Bidang penyelidikan pembelajaran mendalam akan membawa kepada gelombang baharu sebilangan besar robot perkhidmatan sembang yang lebih maju, lebih semula jadi dan identitinya hampir mustahil untuk dibezakan mungkin akan muncul dalam; pelbagai industri; atas dasar ini, terdapat juga lebih banyak robot perkhidmatan sembang peringkat tinggi yang dihasilkan daripada perniagaan tradisional yang berbeza dengan kecerdasan kognitif untuk kali pertama;

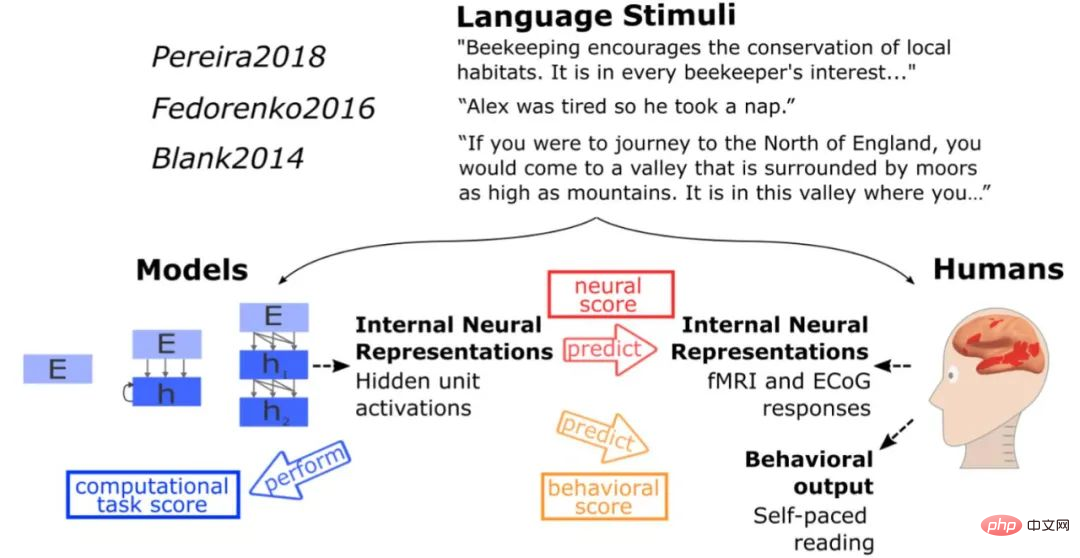

Mari kita kembali kepada isu mencipta atau mensimulasikan otak manusia yang disebutkan pada mulanya. Menurut kajian oleh MIT, walaupun rangkaian saraf dalam GPT-3 tidak cuba meniru secara langsung otak manusia, kaedah pemprosesan bahasa yang dibentangkan oleh GPT-3 mempunyai persamaan tertentu dengan penyelesaian yang diperoleh semasa evolusi otak manusia. apabila rangsangan yang sama seperti ujian otak manusia dimasukkan ke dalam model, model memperoleh jenis pengaktifan yang sama seperti otak manusia, dan dalam lebih daripada 40 ujian model bahasa, GPT-3 membuat kesimpulan yang hampir sempurna Fungsinya memang serupa dengan pusat pemprosesan bahasa otak manusia. Dalam hal ini, Daniel Yamins, penolong profesor psikologi dan sains komputer di Universiti Stanford, juga berkata: "Rangkaian kecerdasan buatan tidak secara langsung meniru otak, tetapi ia akhirnya kelihatan seperti otak. Ini dalam erti kata yang menunjukkan bahawa terdapat jurang antara kecerdasan buatan dan alam semula jadi nampaknya terdapat beberapa evolusi konvergen yang berlaku.

Sumber: Internet

Ia dapat dilihat walaupun model siri GPT tidak menggunakan secara langsung biru Idea reka bentuk Projek Otak adalah untuk mensimulasikan struktur otak, tetapi kesan yang ditunjukkannya nampaknya lebih dekat dengan jangkaan kami berbanding Projek Otak Biru. Oleh itu, jika hala tuju penyelidikan ini benar-benar boleh dilaksanakan dan GPT-4 boleh mencapai kejayaan lompat ke hadapan dalam beberapa aspek berdasarkan GPT-3, maka kita akan selangkah lebih dekat dengan matlamat untuk mensimulasikan beberapa fungsi otak manusia.

Akhir sekali, saya ingin mengakhiri dengan petikan daripada jawatan CEO OpenAI Sam Altman baru-baru ini di Twitter, yang turut diiktiraf oleh “Silicon Valley Iron Man” Elon Musk—— "General artificial kecerdasan akan diwujudkan lebih cepat daripada yang kebanyakan orang bayangkan, dan ia akan 'mengubah' semua yang kebanyakan orang bayangkan dalam jangka masa yang panjang."

Sumber imej: Twitter

Pautan rujukan:

https:// /dzone.com/articles/what-can-you-do-with-the-openai-gpt-3-language-mod

https://analyticsindiamag.com/gpt-4-is-almost- di sini-dan-ia-nampak-lebih baik-daripada-apa-apa-apa-apa-apa-apa-apa-apa-apa-apa-apa-apa pun/

https://analyticsindiamag.com/openais-whisper-might-hold-the-key-to-gpt4/

Atas ialah kandungan terperinci Pengeluaran GPT4 akan datang adalah setanding dengan otak manusia, dan ramai pemimpin industri tidak boleh duduk diam!. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1377

1377

52

52

Ciri baharu dalam PHP versi 5.4: Cara menggunakan parameter pembayang jenis boleh panggil untuk menerima fungsi atau kaedah boleh panggil

Jul 29, 2023 pm 09:19 PM

Ciri baharu dalam PHP versi 5.4: Cara menggunakan parameter pembayang jenis boleh panggil untuk menerima fungsi atau kaedah boleh panggil

Jul 29, 2023 pm 09:19 PM

Ciri baharu versi PHP5.4: Cara menggunakan parameter pembayang jenis boleh panggil untuk menerima fungsi atau kaedah boleh panggil Pengenalan: Versi PHP5.4 memperkenalkan ciri baharu yang sangat mudah - anda boleh menggunakan parameter pembayang jenis boleh panggil untuk menerima fungsi atau kaedah boleh panggil . Ciri baharu ini membenarkan fungsi dan kaedah untuk menentukan secara langsung parameter boleh panggil yang sepadan tanpa semakan dan penukaran tambahan. Dalam artikel ini, kami akan memperkenalkan penggunaan pembayang jenis boleh panggil dan memberikan beberapa contoh kod,

Apakah maksud parameter produk?

Jul 05, 2023 am 11:13 AM

Apakah maksud parameter produk?

Jul 05, 2023 am 11:13 AM

Parameter produk merujuk kepada maksud atribut produk. Sebagai contoh, parameter pakaian termasuk jenama, bahan, model, saiz, gaya, fabrik, kumpulan yang berkenaan, warna, dsb. parameter makanan termasuk jenama, berat, bahan, nombor lesen kesihatan, parameter perkakas rumah yang berkenaan; termasuk jenama, saiz, warna, tempat asal, voltan yang berkenaan, isyarat, antara muka dan kuasa, dsb.

senarai penilaian parameter i9-12900H

Feb 23, 2024 am 09:25 AM

senarai penilaian parameter i9-12900H

Feb 23, 2024 am 09:25 AM

i9-12900H ialah pemproses 14-teras Seni bina dan teknologi yang digunakan semuanya baharu, dan rangkaiannya juga sangat tinggi. Kerja keseluruhannya sangat baik, dan beberapa parameter telah dipertingkatkan terutamanya dan boleh membawa pengalaman yang sangat baik . Semakan penilaian parameter i9-12900H: 1. i9-12900H ialah pemproses 14 teras, yang mengguna pakai seni bina q1 dan teknologi proses 24576kb, dan telah dinaik taraf kepada 20 utas. 2. Kekerapan CPU maksimum ialah 1.80 ghz, yang bergantung terutamanya pada beban kerja. 3. Berbanding dengan harga, ia sangat sesuai Nisbah harga-prestasi adalah sangat baik, dan ia sangat sesuai untuk sesetengah rakan kongsi yang memerlukan penggunaan biasa. penilaian parameter i9-12900H dan markah larian prestasi

Amaran PHP: Penyelesaian kepada in_array() menjangkakan parameter

Jun 22, 2023 pm 11:52 PM

Amaran PHP: Penyelesaian kepada in_array() menjangkakan parameter

Jun 22, 2023 pm 11:52 PM

Semasa proses pembangunan, kami mungkin menghadapi mesej ralat sedemikian: PHPWarning: in_array()expectsparameter. Mesej ralat ini akan muncul apabila menggunakan fungsi in_array() Ia mungkin disebabkan oleh hantaran parameter fungsi yang salah. Mari kita lihat penyelesaian kepada mesej ralat ini. Pertama, anda perlu menjelaskan peranan fungsi in_array(): semak sama ada nilai wujud dalam tatasusunan. Prototaip fungsi ini ialah: in_a

Pemeriksaan keselamatan jenis parameter fungsi C++

Apr 19, 2024 pm 12:00 PM

Pemeriksaan keselamatan jenis parameter fungsi C++

Apr 19, 2024 pm 12:00 PM

Pemeriksaan keselamatan jenis parameter C++ memastikan bahawa fungsi hanya menerima nilai jenis yang dijangkakan melalui semakan masa kompilasi, semakan masa jalan dan penegasan statik, menghalang tingkah laku yang tidak dijangka dan ranap program: Pemeriksaan jenis masa kompilasi: Pengkompil menyemak keserasian jenis. Semakan jenis masa jalan: Gunakan dynamic_cast untuk menyemak keserasian jenis dan buang pengecualian jika tiada padanan. Penegasan statik: Tegaskan keadaan jenis pada masa penyusunan.

Program C++ untuk mencari nilai fungsi sinus hiperbolik songsang mengambil nilai yang diberikan sebagai hujah

Sep 17, 2023 am 10:49 AM

Program C++ untuk mencari nilai fungsi sinus hiperbolik songsang mengambil nilai yang diberikan sebagai hujah

Sep 17, 2023 am 10:49 AM

Fungsi hiperbola ditakrifkan menggunakan hiperbola dan bukannya bulatan dan bersamaan dengan fungsi trigonometri biasa. Ia mengembalikan parameter nisbah dalam fungsi sinus hiperbolik dari sudut yang dibekalkan dalam radian. Tetapi lakukan sebaliknya, atau dengan kata lain. Jika kita ingin mengira sudut daripada sinus hiperbolik, kita memerlukan operasi trigonometri hiperbolik songsang seperti operasi sinus songsang hiperbolik. Kursus ini akan menunjukkan cara menggunakan fungsi sinus songsang hiperbolik (asinh) dalam C++ untuk mengira sudut menggunakan nilai sinus hiperbolik dalam radian. Operasi arcsine hiperbolik mengikut formula berikut -$$\mathrm{sinh^{-1}x\:=\:In(x\:+\:\sqrt{x^2\:+\:1})}, Di mana\:In\:is\:logaritma asli\:(log_e\:k)

Tidak bolehkah model bahasa dengan 10 bilion parameter dijalankan? Seorang doktor Cina dari MIT mencadangkan kuantifikasi SmoothQuant, yang mengurangkan keperluan memori sebanyak separuh dan meningkatkan kelajuan sebanyak 1.56 kali!

Apr 13, 2023 am 09:31 AM

Tidak bolehkah model bahasa dengan 10 bilion parameter dijalankan? Seorang doktor Cina dari MIT mencadangkan kuantifikasi SmoothQuant, yang mengurangkan keperluan memori sebanyak separuh dan meningkatkan kelajuan sebanyak 1.56 kali!

Apr 13, 2023 am 09:31 AM

Walaupun model bahasa berskala besar (LLM) mempunyai prestasi yang kukuh, bilangan parameter boleh mencecah ratusan bilion dengan mudah, dan permintaan untuk peralatan dan memori pengkomputeran adalah sangat besar sehingga syarikat biasa tidak mampu membelinya. Kuantisasi ialah operasi mampatan biasa yang mengorbankan beberapa prestasi model sebagai pertukaran untuk kelajuan inferens yang lebih pantas dan keperluan memori yang kurang dengan mengurangkan ketepatan berat model (seperti 32 bit hingga 8 bit). Tetapi untuk LLM yang mempunyai lebih daripada 100 bilion parameter, kaedah pemampatan sedia ada tidak dapat mengekalkan ketepatan model, dan juga tidak boleh berjalan dengan cekap pada perkakasan. Baru-baru ini, penyelidik dari MIT dan NVIDIA bersama-sama mencadangkan pengkuantitian pasca latihan (GPQ) tujuan umum.

Ringkasan penalaan hiperparameter pembelajaran mesin (PySpark ML)

Apr 08, 2023 pm 07:21 PM

Ringkasan penalaan hiperparameter pembelajaran mesin (PySpark ML)

Apr 08, 2023 pm 07:21 PM

Tugas penting dalam ML ialah pemilihan model, atau menggunakan data untuk mencari model atau parameter terbaik untuk tugasan tertentu. Ini juga dipanggil penalaan. Anda boleh menala satu penganggar, seperti LogisticRegression, atau keseluruhan saluran paip yang merangkumi berbilang algoritma, pencirian dan langkah lain. Pengguna boleh menala keseluruhan Saluran Paip sekaligus, dan bukannya menala setiap elemen dalam Talian Paip secara individu. Tugas penting dalam ML ialah pemilihan model, atau menggunakan data untuk mencari model atau parameter terbaik untuk tugasan tertentu. Ini juga dipanggil penalaan. Satu Penganggar (seperti LogisticRegression) boleh ditala, atau