Peranti teknologi

Peranti teknologi

AI

AI

Latihan mesin tunggal 20 bilion parameter model besar: Cerebras memecahkan rekod baharu

Latihan mesin tunggal 20 bilion parameter model besar: Cerebras memecahkan rekod baharu

Latihan mesin tunggal 20 bilion parameter model besar: Cerebras memecahkan rekod baharu

Minggu ini, syarikat permulaan cip Cerebras mengumumkan pencapaian baharu: melatih model kecerdasan buatan NLP (pemprosesan bahasa semula jadi) dengan lebih daripada 10 bilion parameter dalam satu peranti pengkomputeran.

Jumlah model AI yang dilatih oleh Cerebras mencapai 20 bilion parameter yang belum pernah berlaku sebelum ini, semuanya tanpa menskalakan beban kerja merentas berbilang pemecut. Kerja ini sudah cukup untuk memenuhi model penjanaan AI teks-ke-imej yang paling popular di Internet - model besar 12 bilion parameter OpenAI DALL-E.

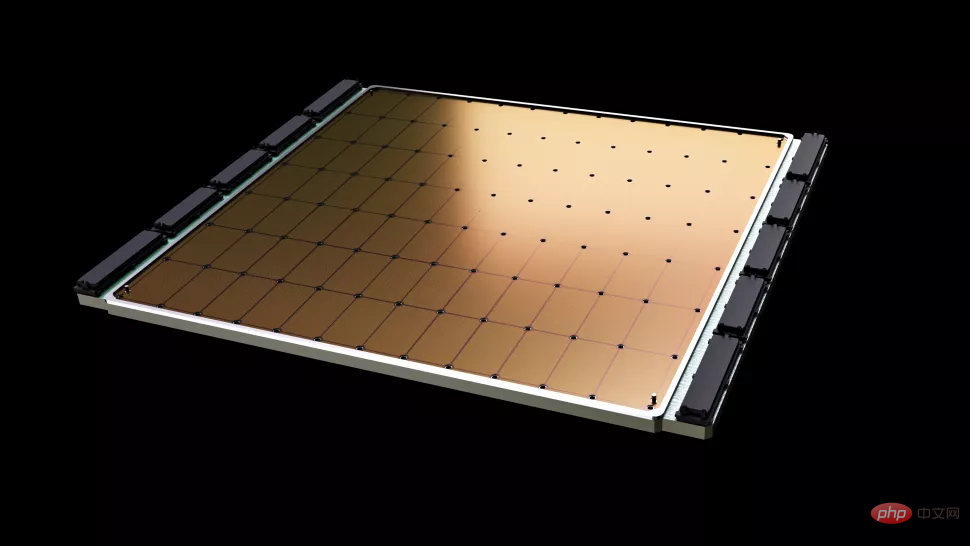

Perkara yang paling penting tentang tugas baharu Cerebras ialah keperluan infrastruktur dan kerumitan perisian yang dikurangkan. Cip yang disediakan oleh syarikat ini, Wafer Scale Engine-2 (WSE2), adalah, seperti namanya, terukir pada satu keseluruhan wafer proses 7nm TSMC Kawasan ini biasanya cukup besar untuk menampung ratusan cip arus perdana - dengan mengejutkan 2.6 trilion transistor , 850,000 teras pengkomputeran AI dan cache bersepadu 40 GB, dan penggunaan kuasa selepas pembungkusan adalah setinggi 15kW.

Enjin Skala Wafer-2 hampir dengan saiz wafer dan lebih besar daripada iPad.

Walaupun mesin tunggal Cerebras serupa dengan superkomputer dari segi saiz, model NLP yang mengekalkan sehingga 20 bilion parameter dalam satu cip masih berkurangan dengan ketara kos latihan untuk beribu-ribu GPU, dan perkakasan dan keperluan penskalaan yang berkaitan, sambil menghapuskan kesukaran teknikal pembahagian model di kalangan mereka. Yang terakhir ialah "salah satu aspek beban kerja NLP yang paling menyakitkan" dan kadangkala "mengambil masa berbulan-bulan untuk disiapkan," kata Cerebras.

Ini ialah masalah tersuai yang unik bukan sahaja untuk setiap rangkaian saraf yang sedang diproses, tetapi juga kepada spesifikasi setiap GPU dan rangkaian yang menghubungkannya bersama - Elemen ini mesti ditetapkan lebih awal sebelum sesi latihan pertama dan tidak mudah alih merentas sistem.

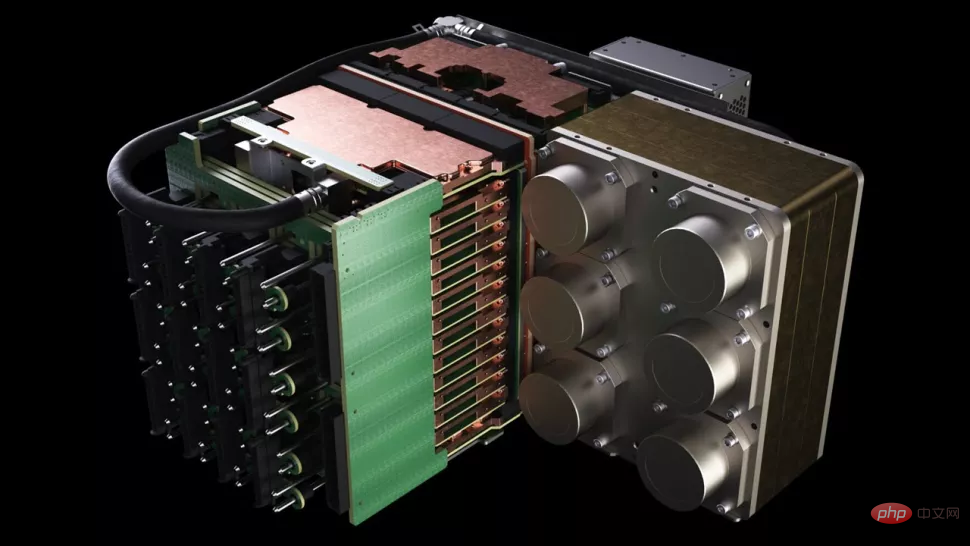

Cerebras’ CS-2 ialah gugusan superkomputer mandiri yang merangkumi cip Wafer Scale Engine-2, semua kuasa Bersekutu, memori, dan subsistem penyimpanan.

Apakah anggaran bilangan parameter 20 bilion? Dalam bidang kecerdasan buatan, model pra-latihan berskala besar adalah hala tuju yang pelbagai syarikat dan institusi teknologi sedang berusaha keras untuk dibangunkan baru-baru ini OpenAI's GPT-3 adalah model NLP yang boleh menulis keseluruhan artikel dan melakukan perkara yang cukup menipu pembaca manusia dan terjemahan matematik dengan 175 bilion parameter yang mengejutkan. DeepMind's Gopher, yang dilancarkan akhir tahun lalu, meningkatkan bilangan rekod parameter kepada 280 bilion.

Baru-baru ini, Google Brain malah mengumumkan bahawa ia telah melatih model dengan lebih satu trilion parameter, Switch Transformer.

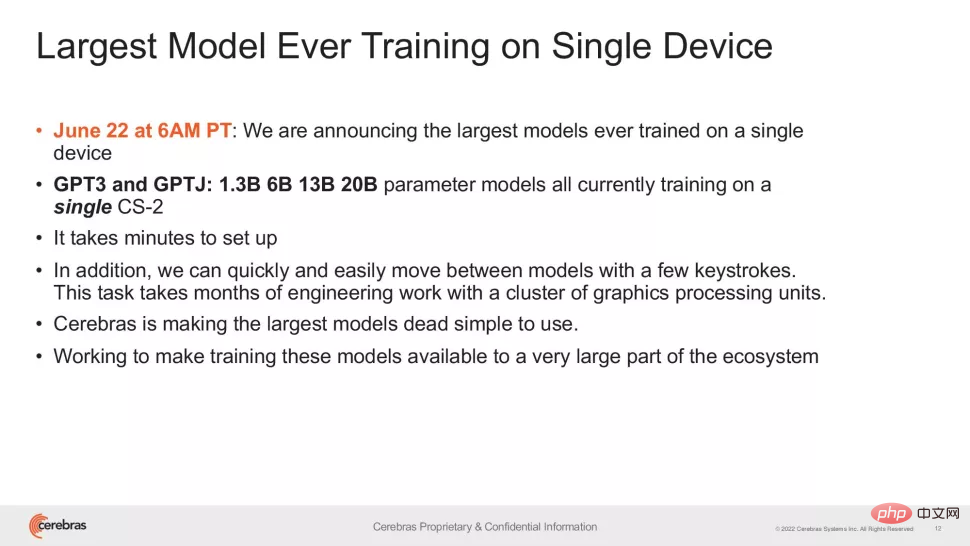

"Dalam bidang NLP, model yang lebih besar telah menunjukkan prestasi yang lebih baik. Tetapi secara tradisinya, hanya segelintir syarikat yang mempunyai sumber dan kepakaran untuk menguraikan model besar ini. kerja keras untuk mengedarkannya ke ratusan atau ribuan unit pemprosesan grafik," kata Andrew Feldman, Ketua Pegawai Eksekutif dan pengasas bersama Cerebras. "Oleh itu, terdapat sangat sedikit syarikat yang boleh melatih model NLP yang besar - ia terlalu mahal, memakan masa dan tidak tersedia untuk seluruh industri." ambang aplikasi model GPT-3XL 1.3B, GPT-J 6B, GPT-3 13B dan GPT-NeoX 20B, membolehkan keseluruhan ekosistem AI membina model besar dalam beberapa minit dan melatih pada sistem CS-2 tunggal mereka.

Walau bagaimanapun, sama seperti kelajuan jam CPU perdana, bilangan parameter hanyalah sebahagian daripada persamaan untuk prestasi model besar penunjuk. Baru-baru ini, beberapa penyelidikan telah mencapai hasil yang lebih baik pada premis pengurangan parameter, seperti Chinchilla yang dicadangkan oleh DeepMind pada April tahun ini, yang mengatasi GPT-3 dan Gopher dalam kes konvensional dengan hanya 70 bilion parameter.

Matlamat penyelidikan jenis ini sudah tentu bekerja lebih bijak, bukan bekerja lebih keras. Jadi pencapaian Cerebras adalah lebih penting daripada apa yang orang mula-mula lihat - penyelidikan ini memberi kita keyakinan bahawa tahap pembuatan cip semasa boleh menyesuaikan diri dengan model yang semakin kompleks, dan syarikat itu berkata bahawa sistem dengan cip khas sebagai teras mempunyai sokongan " Keupayaan model dengan ratusan bilion atau bahkan trilion parameter.

Pertumbuhan pesat dalam bilangan parameter boleh dilatih pada satu cip bergantung pada teknologi Penstriman Berat Cerebras. Teknologi ini memisahkan pengiraan dan jejak ingatan, membolehkan memori berskala pada sebarang skala berdasarkan bilangan parameter yang berkembang pesat dalam beban kerja AI. Ini mengurangkan masa persediaan dari bulan ke minit dan membolehkan pertukaran antara model seperti GPT-J dan GPT-Neo. Seperti kata penyelidik: "Ia hanya memerlukan beberapa ketukan kekunci." kecerdasan buatan Ini adalah era baru kecerdasan yang menarik Ia memberikan organisasi yang tidak boleh membelanjakan berpuluh juta dolar cara yang mudah dan murah untuk bersaing dalam model besar, "kata Dan Olds, ketua pegawai penyelidik di Intersect360 Research. "Kami menantikan aplikasi dan penemuan baharu daripada pelanggan CS-2 sambil mereka melatih model peringkat GPT-3 dan GPT-J pada set data besar-besaran."

Atas ialah kandungan terperinci Latihan mesin tunggal 20 bilion parameter model besar: Cerebras memecahkan rekod baharu. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1386

1386

52

52

Bytedance Cutting melancarkan keahlian super SVIP: 499 yuan untuk langganan tahunan berterusan, menyediakan pelbagai fungsi AI

Jun 28, 2024 am 03:51 AM

Bytedance Cutting melancarkan keahlian super SVIP: 499 yuan untuk langganan tahunan berterusan, menyediakan pelbagai fungsi AI

Jun 28, 2024 am 03:51 AM

Laman web ini melaporkan pada 27 Jun bahawa Jianying ialah perisian penyuntingan video yang dibangunkan oleh FaceMeng Technology, anak syarikat ByteDance Ia bergantung pada platform Douyin dan pada asasnya menghasilkan kandungan video pendek untuk pengguna platform tersebut Windows , MacOS dan sistem pengendalian lain. Jianying secara rasmi mengumumkan peningkatan sistem keahliannya dan melancarkan SVIP baharu, yang merangkumi pelbagai teknologi hitam AI, seperti terjemahan pintar, penonjolan pintar, pembungkusan pintar, sintesis manusia digital, dsb. Dari segi harga, yuran bulanan untuk keratan SVIP ialah 79 yuan, yuran tahunan ialah 599 yuan (nota di laman web ini: bersamaan dengan 49.9 yuan sebulan), langganan bulanan berterusan ialah 59 yuan sebulan, dan langganan tahunan berterusan ialah 499 yuan setahun (bersamaan dengan 41.6 yuan sebulan) . Di samping itu, pegawai yang dipotong juga menyatakan bahawa untuk meningkatkan pengalaman pengguna, mereka yang telah melanggan VIP asal

Pembantu pengekodan AI yang ditambah konteks menggunakan Rag dan Sem-Rag

Jun 10, 2024 am 11:08 AM

Pembantu pengekodan AI yang ditambah konteks menggunakan Rag dan Sem-Rag

Jun 10, 2024 am 11:08 AM

Tingkatkan produktiviti, kecekapan dan ketepatan pembangun dengan menggabungkan penjanaan dipertingkatkan semula dan memori semantik ke dalam pembantu pengekodan AI. Diterjemah daripada EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG, pengarang JanakiramMSV. Walaupun pembantu pengaturcaraan AI asas secara semulajadi membantu, mereka sering gagal memberikan cadangan kod yang paling relevan dan betul kerana mereka bergantung pada pemahaman umum bahasa perisian dan corak penulisan perisian yang paling biasa. Kod yang dijana oleh pembantu pengekodan ini sesuai untuk menyelesaikan masalah yang mereka bertanggungjawab untuk menyelesaikannya, tetapi selalunya tidak mematuhi piawaian pengekodan, konvensyen dan gaya pasukan individu. Ini selalunya menghasilkan cadangan yang perlu diubah suai atau diperhalusi agar kod itu diterima ke dalam aplikasi

Bolehkah penalaan halus benar-benar membolehkan LLM mempelajari perkara baharu: memperkenalkan pengetahuan baharu boleh menjadikan model menghasilkan lebih banyak halusinasi

Jun 11, 2024 pm 03:57 PM

Bolehkah penalaan halus benar-benar membolehkan LLM mempelajari perkara baharu: memperkenalkan pengetahuan baharu boleh menjadikan model menghasilkan lebih banyak halusinasi

Jun 11, 2024 pm 03:57 PM

Model Bahasa Besar (LLM) dilatih pada pangkalan data teks yang besar, di mana mereka memperoleh sejumlah besar pengetahuan dunia sebenar. Pengetahuan ini dibenamkan ke dalam parameter mereka dan kemudiannya boleh digunakan apabila diperlukan. Pengetahuan tentang model ini "diperbaharui" pada akhir latihan. Pada akhir pra-latihan, model sebenarnya berhenti belajar. Selaraskan atau perhalusi model untuk mempelajari cara memanfaatkan pengetahuan ini dan bertindak balas dengan lebih semula jadi kepada soalan pengguna. Tetapi kadangkala pengetahuan model tidak mencukupi, dan walaupun model boleh mengakses kandungan luaran melalui RAG, ia dianggap berfaedah untuk menyesuaikan model kepada domain baharu melalui penalaan halus. Penalaan halus ini dilakukan menggunakan input daripada anotasi manusia atau ciptaan LLM lain, di mana model menemui pengetahuan dunia sebenar tambahan dan menyepadukannya

Tujuh Soalan Temuduga Teknikal GenAI & LLM yang Cool

Jun 07, 2024 am 10:06 AM

Tujuh Soalan Temuduga Teknikal GenAI & LLM yang Cool

Jun 07, 2024 am 10:06 AM

Untuk mengetahui lebih lanjut tentang AIGC, sila layari: 51CTOAI.x Komuniti https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou berbeza daripada bank soalan tradisional yang boleh dilihat di mana-mana sahaja di Internet memerlukan pemikiran di luar kotak. Model Bahasa Besar (LLM) semakin penting dalam bidang sains data, kecerdasan buatan generatif (GenAI) dan kecerdasan buatan. Algoritma kompleks ini meningkatkan kemahiran manusia dan memacu kecekapan dan inovasi dalam banyak industri, menjadi kunci kepada syarikat untuk kekal berdaya saing. LLM mempunyai pelbagai aplikasi Ia boleh digunakan dalam bidang seperti pemprosesan bahasa semula jadi, penjanaan teks, pengecaman pertuturan dan sistem pengesyoran. Dengan belajar daripada sejumlah besar data, LLM dapat menjana teks

Versi Kuaishou Sora 'Ke Ling' dibuka untuk ujian: menghasilkan video lebih 120-an, memahami fizik dengan lebih baik dan boleh memodelkan pergerakan kompleks dengan tepat

Jun 11, 2024 am 09:51 AM

Versi Kuaishou Sora 'Ke Ling' dibuka untuk ujian: menghasilkan video lebih 120-an, memahami fizik dengan lebih baik dan boleh memodelkan pergerakan kompleks dengan tepat

Jun 11, 2024 am 09:51 AM

Apa? Adakah Zootopia dibawa menjadi realiti oleh AI domestik? Didedahkan bersama-sama dengan video itu ialah model penjanaan video domestik berskala besar baharu yang dipanggil "Keling". Sora menggunakan laluan teknikal yang serupa dan menggabungkan beberapa inovasi teknologi yang dibangunkan sendiri untuk menghasilkan video yang bukan sahaja mempunyai pergerakan yang besar dan munasabah, tetapi juga mensimulasikan ciri-ciri dunia fizikal dan mempunyai keupayaan gabungan konsep dan imaginasi yang kuat. Mengikut data, Keling menyokong penjanaan video ultra panjang sehingga 2 minit pada 30fps, dengan resolusi sehingga 1080p dan menyokong berbilang nisbah aspek. Satu lagi perkara penting ialah Keling bukanlah demo atau demonstrasi hasil video yang dikeluarkan oleh makmal, tetapi aplikasi peringkat produk yang dilancarkan oleh Kuaishou, pemain terkemuka dalam bidang video pendek. Selain itu, tumpuan utama adalah untuk menjadi pragmatik, bukan untuk menulis cek kosong, dan pergi ke dalam talian sebaik sahaja ia dikeluarkan Model besar Ke Ling telah pun dikeluarkan di Kuaiying.

Lima sekolah pembelajaran mesin yang anda tidak tahu

Jun 05, 2024 pm 08:51 PM

Lima sekolah pembelajaran mesin yang anda tidak tahu

Jun 05, 2024 pm 08:51 PM

Pembelajaran mesin ialah cabang penting kecerdasan buatan yang memberikan komputer keupayaan untuk belajar daripada data dan meningkatkan keupayaan mereka tanpa diprogramkan secara eksplisit. Pembelajaran mesin mempunyai pelbagai aplikasi dalam pelbagai bidang, daripada pengecaman imej dan pemprosesan bahasa semula jadi kepada sistem pengesyoran dan pengesanan penipuan, dan ia mengubah cara hidup kita. Terdapat banyak kaedah dan teori yang berbeza dalam bidang pembelajaran mesin, antaranya lima kaedah yang paling berpengaruh dipanggil "Lima Sekolah Pembelajaran Mesin". Lima sekolah utama ialah sekolah simbolik, sekolah sambungan, sekolah evolusi, sekolah Bayesian dan sekolah analogi. 1. Simbolisme, juga dikenali sebagai simbolisme, menekankan penggunaan simbol untuk penaakulan logik dan ekspresi pengetahuan. Aliran pemikiran ini percaya bahawa pembelajaran adalah proses penolakan terbalik, melalui sedia ada

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Editor |ScienceAI Question Answering (QA) set data memainkan peranan penting dalam mempromosikan penyelidikan pemprosesan bahasa semula jadi (NLP). Set data QA berkualiti tinggi bukan sahaja boleh digunakan untuk memperhalusi model, tetapi juga menilai dengan berkesan keupayaan model bahasa besar (LLM), terutamanya keupayaan untuk memahami dan menaakul tentang pengetahuan saintifik. Walaupun pada masa ini terdapat banyak set data QA saintifik yang meliputi bidang perubatan, kimia, biologi dan bidang lain, set data ini masih mempunyai beberapa kekurangan. Pertama, borang data adalah agak mudah, kebanyakannya adalah soalan aneka pilihan. Ia mudah dinilai, tetapi mengehadkan julat pemilihan jawapan model dan tidak dapat menguji sepenuhnya keupayaan model untuk menjawab soalan saintifik. Sebaliknya, Soal Jawab terbuka

Pemula AI secara kolektif menukar pekerjaan kepada OpenAI, dan pasukan keselamatan berkumpul semula selepas Ilya pergi!

Jun 08, 2024 pm 01:00 PM

Pemula AI secara kolektif menukar pekerjaan kepada OpenAI, dan pasukan keselamatan berkumpul semula selepas Ilya pergi!

Jun 08, 2024 pm 01:00 PM

Minggu lalu, di tengah gelombang peletakan jawatan dalaman dan kritikan luar, OpenAI dibelenggu oleh masalah dalaman dan luaran: - Pelanggaran kakak balu itu mencetuskan perbincangan hangat global - Pekerja menandatangani "fasal tuan" didedahkan satu demi satu - Netizen menyenaraikan " Ultraman " tujuh dosa maut" ” Pembasmi khabar angin: Menurut maklumat dan dokumen bocor yang diperolehi oleh Vox, kepimpinan kanan OpenAI, termasuk Altman, sangat mengetahui peruntukan pemulihan ekuiti ini dan menandatanganinya. Di samping itu, terdapat isu serius dan mendesak yang dihadapi oleh OpenAI - keselamatan AI. Pemergian lima pekerja berkaitan keselamatan baru-baru ini, termasuk dua pekerjanya yang paling terkemuka, dan pembubaran pasukan "Penjajaran Super" sekali lagi meletakkan isu keselamatan OpenAI dalam perhatian. Majalah Fortune melaporkan bahawa OpenA