Ciri jarang dan ciri padat

Dalam pembelajaran mesin, ciri merujuk kepada atribut atau ciri yang boleh diukur dan boleh diukur bagi objek, orang atau fenomena. Ciri boleh dibahagikan secara kasar kepada dua kategori: ciri jarang dan ciri padat.

Ciri Jarang

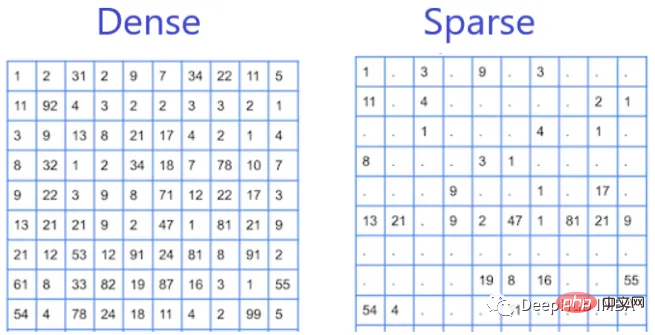

Ciri Jarang ialah ciri yang muncul secara tidak berterusan dalam set data dan mempunyai kebanyakan nilainya sebagai sifar. Contoh ciri yang jarang termasuk kehadiran atau ketiadaan perkataan tertentu dalam dokumen teks atau kejadian item tertentu dalam set data transaksi. Ia dipanggil ciri jarang kerana ia mempunyai beberapa nilai bukan sifar dalam set data dan kebanyakan nilai adalah sifar.

Ciri jarang adalah biasa dalam pemprosesan bahasa semula jadi (NLP) dan sistem pengesyor, di mana data sering diwakili sebagai matriks jarang. Bekerja dengan ciri yang jarang boleh menjadi lebih mencabar kerana ia selalunya mempunyai banyak nilai sifar atau hampir sifar, yang menjadikannya mahal dari segi pengiraan dan melambatkan proses latihan. Ciri jarang berkesan apabila ruang ciri besar dan kebanyakan ciri tidak relevan atau berlebihan. Ciri jarang dalam kes ini membantu mengurangkan dimensi data, membolehkan latihan dan inferens yang lebih pantas dan cekap.

Ciri Padat

Ciri padat ialah ciri yang muncul secara kerap atau kerap dalam set data dan kebanyakan nilai bukan sifar. Contoh ciri padat termasuk umur, jantina dan pendapatan individu dalam set data demografi. Ia dipanggil ciri padat kerana ia mempunyai banyak nilai bukan sifar dalam set data.

Ciri padat adalah perkara biasa dalam pengecaman imej dan pertuturan, di mana data sering diwakili sebagai vektor padat. Ciri padat biasanya lebih mudah dikendalikan kerana ia mempunyai ketumpatan nilai bukan sifar yang lebih tinggi, dan kebanyakan algoritma pembelajaran mesin direka bentuk untuk mengendalikan vektor ciri padat. Ciri padat mungkin lebih sesuai apabila ruang ciri agak kecil dan setiap ciri penting untuk tugas yang sedang dijalankan.

Perbezaan

Perbezaan antara ciri jarang dan ciri padat terletak pada pengagihan nilainya dalam set data. Ciri jarang mempunyai sedikit nilai bukan sifar, manakala ciri padat mempunyai banyak nilai bukan sifar. Perbezaan dalam pengedaran ini mempunyai implikasi untuk algoritma pembelajaran mesin kerana algoritma mungkin menunjukkan prestasi yang berbeza pada ciri jarang berbanding dengan ciri padat.

Pemilihan Algoritma

Sekarang kita mengetahui jenis ciri set data yang diberikan, algoritma manakah yang harus kita gunakan jika set data mengandungi ciri jarang atau jika set data mengandungi ciri padat?

Sesetengah algoritma lebih sesuai untuk data yang jarang, manakala yang lain lebih sesuai untuk data padat.

- Untuk data yang jarang, algoritma popular termasuk regresi logistik, mesin vektor sokongan (SVM) dan pepohon keputusan.

- Untuk data padat, algoritma popular termasuk rangkaian saraf, seperti rangkaian suapan hadapan dan rangkaian saraf konvolusi.

Tetapi harus diingat bahawa pilihan algoritma bergantung bukan sahaja pada kesederhanaan atau ketumpatan data, tetapi juga pada saiz set data, jenis ciri, kerumitan masalah dan lain-lain Pastikan anda Mencuba algoritma yang berbeza dan membandingkan prestasinya pada masalah tertentu.

Atas ialah kandungan terperinci Ciri jarang dan ciri padat. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1377

1377

52

52

Artikel ini akan membawa anda memahami SHAP: penjelasan model untuk pembelajaran mesin

Jun 01, 2024 am 10:58 AM

Artikel ini akan membawa anda memahami SHAP: penjelasan model untuk pembelajaran mesin

Jun 01, 2024 am 10:58 AM

Dalam bidang pembelajaran mesin dan sains data, kebolehtafsiran model sentiasa menjadi tumpuan penyelidik dan pengamal. Dengan aplikasi meluas model yang kompleks seperti kaedah pembelajaran mendalam dan ensemble, memahami proses membuat keputusan model menjadi sangat penting. AI|XAI yang boleh dijelaskan membantu membina kepercayaan dan keyakinan dalam model pembelajaran mesin dengan meningkatkan ketelusan model. Meningkatkan ketelusan model boleh dicapai melalui kaedah seperti penggunaan meluas pelbagai model yang kompleks, serta proses membuat keputusan yang digunakan untuk menerangkan model. Kaedah ini termasuk analisis kepentingan ciri, anggaran selang ramalan model, algoritma kebolehtafsiran tempatan, dsb. Analisis kepentingan ciri boleh menerangkan proses membuat keputusan model dengan menilai tahap pengaruh model ke atas ciri input. Anggaran selang ramalan model

Melaksanakan Algoritma Pembelajaran Mesin dalam C++: Cabaran dan Penyelesaian Biasa

Jun 03, 2024 pm 01:25 PM

Melaksanakan Algoritma Pembelajaran Mesin dalam C++: Cabaran dan Penyelesaian Biasa

Jun 03, 2024 pm 01:25 PM

Cabaran biasa yang dihadapi oleh algoritma pembelajaran mesin dalam C++ termasuk pengurusan memori, multi-threading, pengoptimuman prestasi dan kebolehselenggaraan. Penyelesaian termasuk menggunakan penunjuk pintar, perpustakaan benang moden, arahan SIMD dan perpustakaan pihak ketiga, serta mengikuti garis panduan gaya pengekodan dan menggunakan alat automasi. Kes praktikal menunjukkan cara menggunakan perpustakaan Eigen untuk melaksanakan algoritma regresi linear, mengurus memori dengan berkesan dan menggunakan operasi matriks berprestasi tinggi.

AI yang boleh dijelaskan: Menerangkan model AI/ML yang kompleks

Jun 03, 2024 pm 10:08 PM

AI yang boleh dijelaskan: Menerangkan model AI/ML yang kompleks

Jun 03, 2024 pm 10:08 PM

Penterjemah |. Disemak oleh Li Rui |. Chonglou Model kecerdasan buatan (AI) dan pembelajaran mesin (ML) semakin kompleks hari ini, dan output yang dihasilkan oleh model ini adalah kotak hitam – tidak dapat dijelaskan kepada pihak berkepentingan. AI Boleh Dijelaskan (XAI) bertujuan untuk menyelesaikan masalah ini dengan membolehkan pihak berkepentingan memahami cara model ini berfungsi, memastikan mereka memahami cara model ini sebenarnya membuat keputusan, dan memastikan ketelusan dalam sistem AI, Amanah dan akauntabiliti untuk menyelesaikan masalah ini. Artikel ini meneroka pelbagai teknik kecerdasan buatan (XAI) yang boleh dijelaskan untuk menggambarkan prinsip asasnya. Beberapa sebab mengapa AI boleh dijelaskan adalah penting Kepercayaan dan ketelusan: Untuk sistem AI diterima secara meluas dan dipercayai, pengguna perlu memahami cara keputusan dibuat

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Editor |ScienceAI Question Answering (QA) set data memainkan peranan penting dalam mempromosikan penyelidikan pemprosesan bahasa semula jadi (NLP). Set data QA berkualiti tinggi bukan sahaja boleh digunakan untuk memperhalusi model, tetapi juga menilai dengan berkesan keupayaan model bahasa besar (LLM), terutamanya keupayaan untuk memahami dan menaakul tentang pengetahuan saintifik. Walaupun pada masa ini terdapat banyak set data QA saintifik yang meliputi bidang perubatan, kimia, biologi dan bidang lain, set data ini masih mempunyai beberapa kekurangan. Pertama, borang data adalah agak mudah, kebanyakannya adalah soalan aneka pilihan. Ia mudah dinilai, tetapi mengehadkan julat pemilihan jawapan model dan tidak dapat menguji sepenuhnya keupayaan model untuk menjawab soalan saintifik. Sebaliknya, Soal Jawab terbuka

Algoritma pengesanan yang dipertingkatkan: untuk pengesanan sasaran dalam imej penderiaan jauh optik resolusi tinggi

Jun 06, 2024 pm 12:33 PM

Algoritma pengesanan yang dipertingkatkan: untuk pengesanan sasaran dalam imej penderiaan jauh optik resolusi tinggi

Jun 06, 2024 pm 12:33 PM

01Garis prospek Pada masa ini, sukar untuk mencapai keseimbangan yang sesuai antara kecekapan pengesanan dan hasil pengesanan. Kami telah membangunkan algoritma YOLOv5 yang dipertingkatkan untuk pengesanan sasaran dalam imej penderiaan jauh optik resolusi tinggi, menggunakan piramid ciri berbilang lapisan, strategi kepala pengesanan berbilang dan modul perhatian hibrid untuk meningkatkan kesan rangkaian pengesanan sasaran dalam imej penderiaan jauh optik. Menurut set data SIMD, peta algoritma baharu adalah 2.2% lebih baik daripada YOLOv5 dan 8.48% lebih baik daripada YOLOX, mencapai keseimbangan yang lebih baik antara hasil pengesanan dan kelajuan. 02 Latar Belakang & Motivasi Dengan perkembangan pesat teknologi penderiaan jauh, imej penderiaan jauh optik resolusi tinggi telah digunakan untuk menggambarkan banyak objek di permukaan bumi, termasuk pesawat, kereta, bangunan, dll. Pengesanan objek dalam tafsiran imej penderiaan jauh

Adakah Flash Attention stabil? Meta dan Harvard mendapati bahawa sisihan berat model mereka berubah-ubah mengikut urutan magnitud

May 30, 2024 pm 01:24 PM

Adakah Flash Attention stabil? Meta dan Harvard mendapati bahawa sisihan berat model mereka berubah-ubah mengikut urutan magnitud

May 30, 2024 pm 01:24 PM

MetaFAIR bekerjasama dengan Harvard untuk menyediakan rangka kerja penyelidikan baharu untuk mengoptimumkan bias data yang dijana apabila pembelajaran mesin berskala besar dilakukan. Adalah diketahui bahawa latihan model bahasa besar sering mengambil masa berbulan-bulan dan menggunakan ratusan atau bahkan ribuan GPU. Mengambil model LLaMA270B sebagai contoh, latihannya memerlukan sejumlah 1,720,320 jam GPU. Melatih model besar memberikan cabaran sistemik yang unik disebabkan oleh skala dan kerumitan beban kerja ini. Baru-baru ini, banyak institusi telah melaporkan ketidakstabilan dalam proses latihan apabila melatih model AI generatif SOTA Mereka biasanya muncul dalam bentuk lonjakan kerugian Contohnya, model PaLM Google mengalami sehingga 20 lonjakan kerugian semasa proses latihan. Bias berangka adalah punca ketidaktepatan latihan ini,

Lima sekolah pembelajaran mesin yang anda tidak tahu

Jun 05, 2024 pm 08:51 PM

Lima sekolah pembelajaran mesin yang anda tidak tahu

Jun 05, 2024 pm 08:51 PM

Pembelajaran mesin ialah cabang penting kecerdasan buatan yang memberikan komputer keupayaan untuk belajar daripada data dan meningkatkan keupayaan mereka tanpa diprogramkan secara eksplisit. Pembelajaran mesin mempunyai pelbagai aplikasi dalam pelbagai bidang, daripada pengecaman imej dan pemprosesan bahasa semula jadi kepada sistem pengesyoran dan pengesanan penipuan, dan ia mengubah cara hidup kita. Terdapat banyak kaedah dan teori yang berbeza dalam bidang pembelajaran mesin, antaranya lima kaedah yang paling berpengaruh dipanggil "Lima Sekolah Pembelajaran Mesin". Lima sekolah utama ialah sekolah simbolik, sekolah sambungan, sekolah evolusi, sekolah Bayesian dan sekolah analogi. 1. Simbolisme, juga dikenali sebagai simbolisme, menekankan penggunaan simbol untuk penaakulan logik dan ekspresi pengetahuan. Aliran pemikiran ini percaya bahawa pembelajaran adalah proses penolakan terbalik, melalui sedia ada

Pembelajaran Mesin dalam C++: Panduan untuk Melaksanakan Algoritma Pembelajaran Mesin Biasa dalam C++

Jun 03, 2024 pm 07:33 PM

Pembelajaran Mesin dalam C++: Panduan untuk Melaksanakan Algoritma Pembelajaran Mesin Biasa dalam C++

Jun 03, 2024 pm 07:33 PM

Dalam C++, pelaksanaan algoritma pembelajaran mesin termasuk: Regresi linear: digunakan untuk meramalkan pembolehubah berterusan Langkah-langkah termasuk memuatkan data, mengira berat dan berat sebelah, mengemas kini parameter dan ramalan. Regresi logistik: digunakan untuk meramalkan pembolehubah diskret Proses ini serupa dengan regresi linear, tetapi menggunakan fungsi sigmoid untuk ramalan. Mesin Vektor Sokongan: Algoritma klasifikasi dan regresi yang berkuasa yang melibatkan pengkomputeran vektor sokongan dan label ramalan.