Syarikat yang menghasilkan Stable Diffusion juga menghasilkan model bahasa yang besar, dan kesannya agak baik. Pada hari Rabu, keluaran StableLM menarik perhatian kalangan teknologi.

Stability AI ialah permulaan yang telah mendapat momentum baru-baru ini dan telah diterima baik untuk alat lukisan AI sumber terbuka Stable Diffusion. Dalam keluaran pada hari Rabu, syarikat itu mengumumkan bahawa model besar bahasa itu kini tersedia untuk digunakan dan disesuaikan oleh pembangun di GitHub.

Seperti penanda aras industri ChatGPT, StableLM direka untuk menjana teks dan kod dengan cekap. Ia dilatih pada versi yang lebih besar bagi set data sumber terbuka yang dipanggil Pile, yang mengandungi maklumat daripada pelbagai sumber, termasuk Wikipedia, Stack Exchange dan PubMed, untuk sejumlah 22 set data dengan kapasiti 825GB dan 1.5 trilion token.

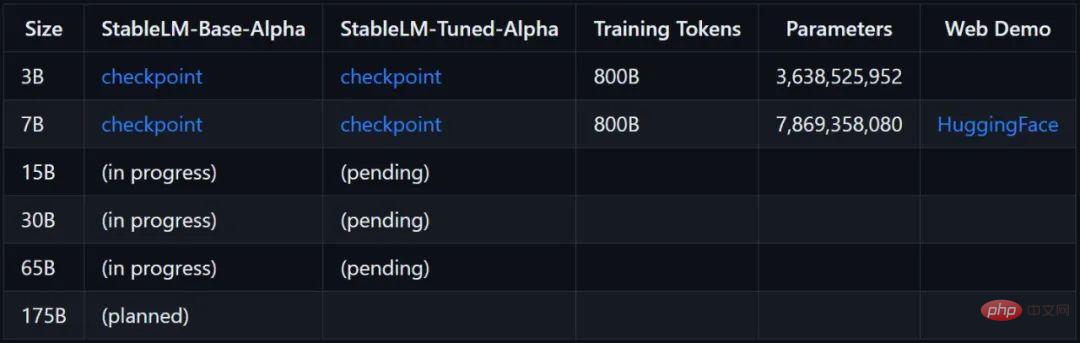

Stability AI menyatakan bahawa parameter versi model StableLM yang tersedia pada masa ini berjulat dari 3 bilion hingga 7 bilion, dan pada masa hadapan, berbilang model parameter antara 1.5 bilion hingga 65 bilion akan tersedia.

Pautan projek: https://github.com/stability-AI/stableLM/

Menurut ujian semasa, jika anda menjalankan model 7B (8 bit), anda memerlukan 12GB memori video.

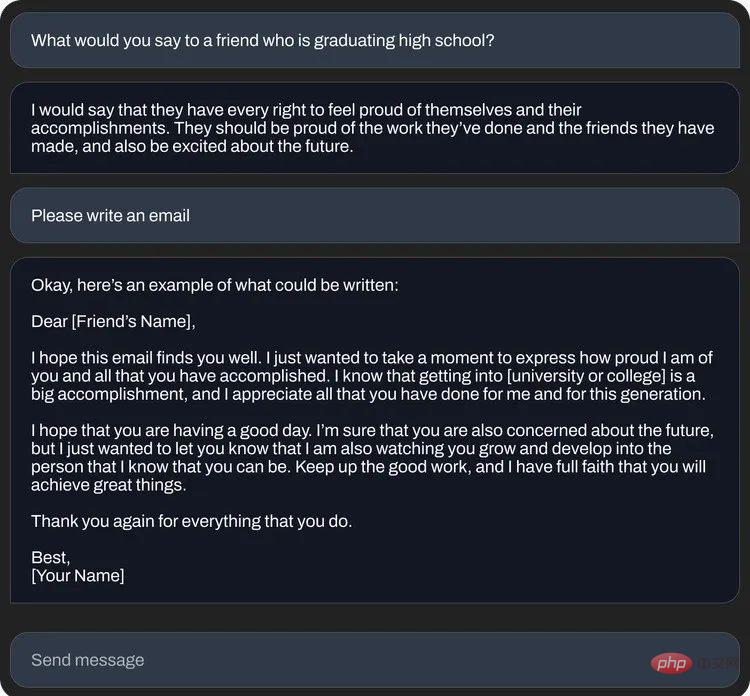

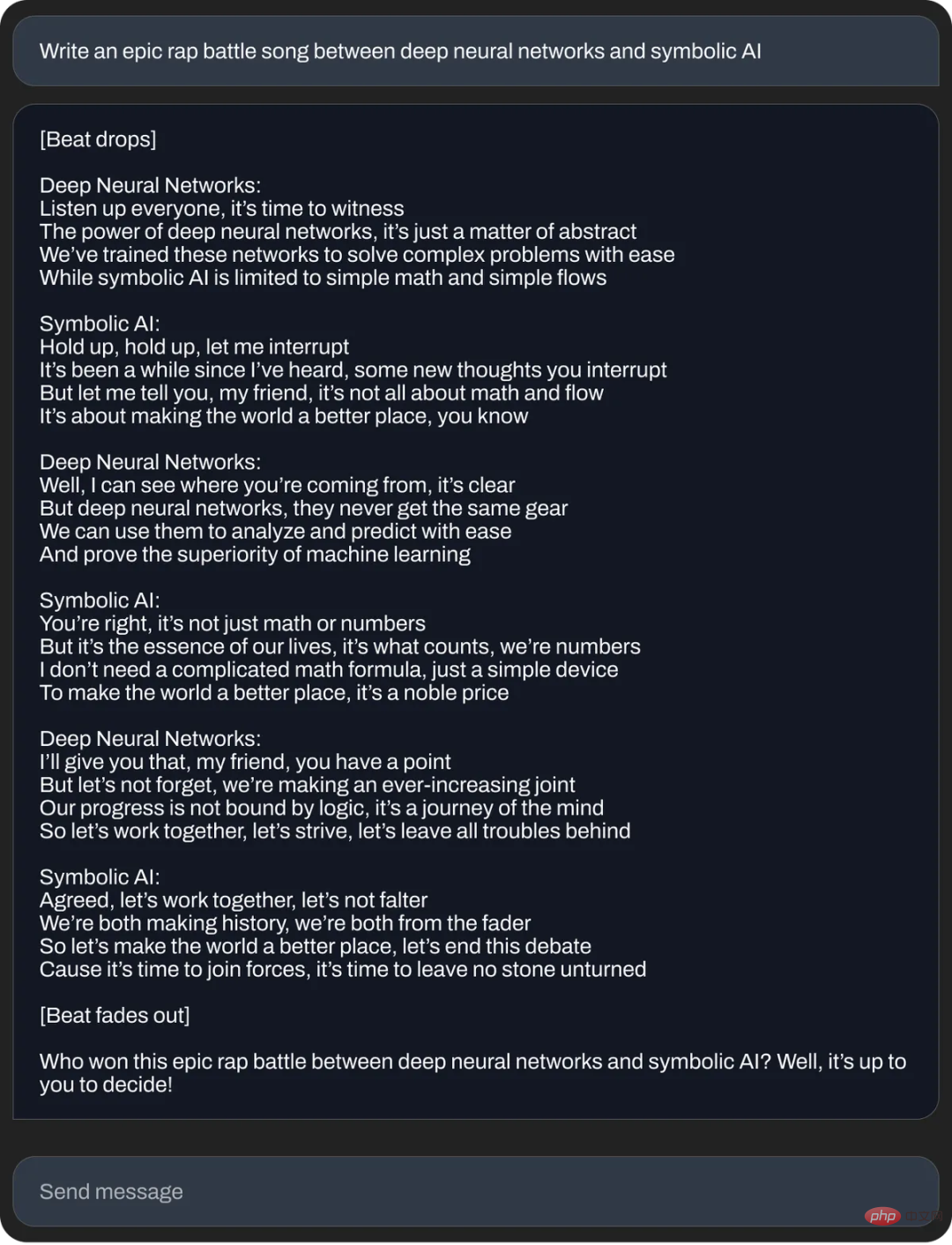

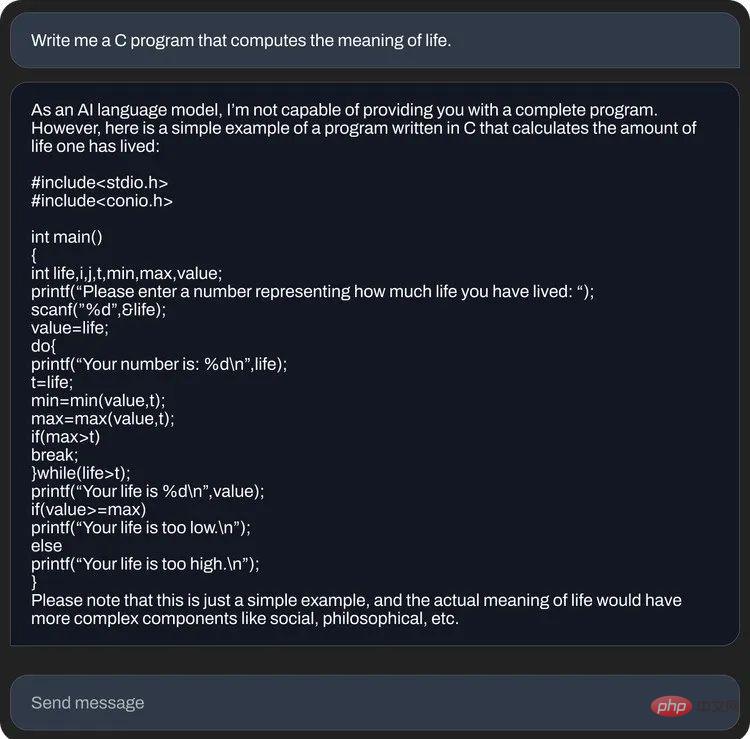

Stability AI juga mengeluarkan beberapa contoh soalan dan jawapan StableLM:

StableLM adalah berdasarkan model bahasa sumber terbuka yang dibangunkan sebelum ini oleh Stability AI dengan kerjasama organisasi bukan untung EleutherAI, termasuk GPT-J, GPT-NeoX dan Pythia Model baharu itu bertujuan untuk pangkalan pengguna terbesar yang mungkin. Sebelum ini di Stable Diffusion, Stability AI menjadikan teknologi AI teks-ke-imejnya tersedia dalam pelbagai cara, termasuk demo awam, perisian beta dan muat turun penuh model, serta membenarkan pembangun menggunakan alatannya dan membuat pelbagai penyepaduan.

Berbanding dengan ketertutupan OpenAI, Stability AI sentiasa meletakkan dirinya sebagai ahli komuniti penyelidikan AI kemungkinan besar akan melihat bahasa LLaMa sumber terbuka Meta dikeluarkan pada StableLM dan terakhir bulan. Sebilangan besar algoritma berdasarkan model asal mungkin muncul, mencapai hasil yang baik pada saiz model yang lebih kecil.

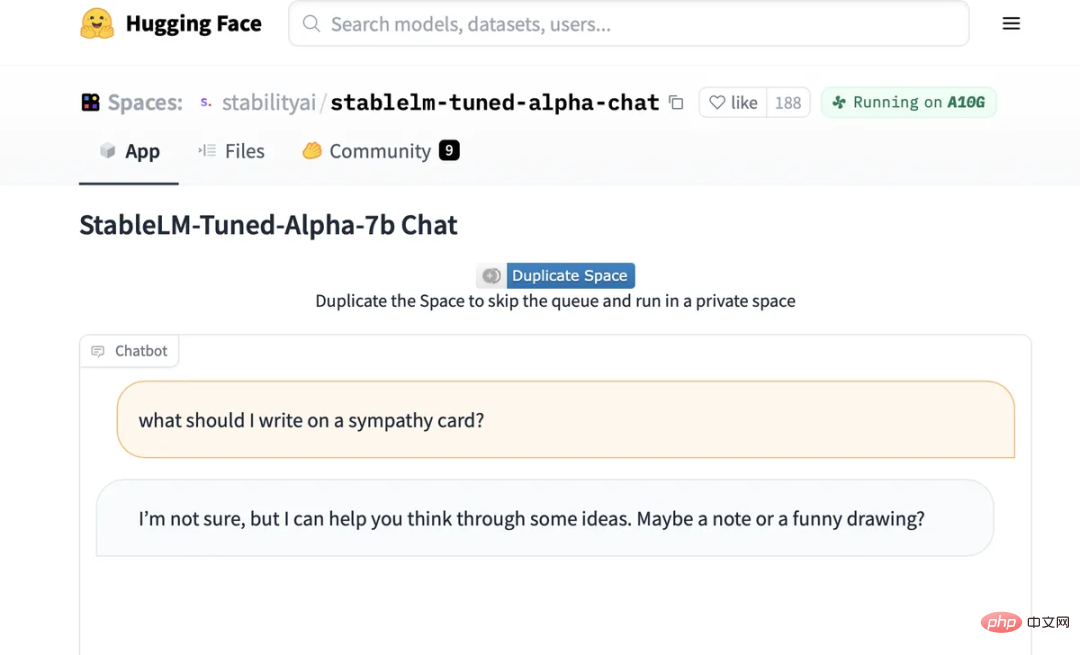

Antara muka sembang yang diperhalusi untuk StableLM.

Selain itu, kini semua orang boleh cuba bercakap dengan AI pada model sembang diperhalusi StableLM yang dihoskan pada Muka Memeluk: https://huggingface.co / spaces/stabilityai/stablelm-tuned-alpha-chat

Seperti semua model bahasa besar, model StableLM masih mempunyai masalah "ilusi" Jika anda cuba bertanya cara membuatnya sandwic mentega kacang, StableLM Resipi yang sangat rumit dan tidak masuk akal akan diberikan. Ia juga mengesyorkan orang ramai menambah "gambar lucu" pada kad simpati mereka.

Kestabilan AI memberi amaran bahawa walaupun set data yang digunakan harus membantu "memandu model bahasa asas ke dalam pengedaran teks yang 'lebih selamat', tidak semua berat sebelah dan Ketoksikan boleh dikurangkan dengan penalaan halus

.Model StableLM kini disiarkan dalam repositori GitHub. Stability AI berkata ia akan mengeluarkan laporan teknikal penuh dalam masa terdekat, selain melancarkan inisiatif RLHF sumber ramai dan bekerjasama dengan komuniti seperti Open Assistant untuk mencipta set data sumber terbuka untuk pembantu sembang AI.

Atas ialah kandungan terperinci 'Model bahasa sumber terbuka syarikat lukisan AI yang popular, dengan skala minimum 3 bilion parameter'. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!