Peranti teknologi

Peranti teknologi

AI

AI

Dolly 2.0, model besar ChatGPT sumber terbuka pertama di dunia, boleh diubah suai sesuka hati untuk kegunaan komersil

Dolly 2.0, model besar ChatGPT sumber terbuka pertama di dunia, boleh diubah suai sesuka hati untuk kegunaan komersil

Dolly 2.0, model besar ChatGPT sumber terbuka pertama di dunia, boleh diubah suai sesuka hati untuk kegunaan komersil

Seperti yang kita semua tahu, OpenAI tidak Terbuka apabila ia berkaitan dengan ChatGPT Model siri alpaca yang bersumberkan terbuka daripada Meta juga "terhad kepada aplikasi penyelidikan akademik" kerana isu seperti set data untuk pintasan Apabila ia datang kepada kaedah menyekat, ini datang model besar yang memfokuskan pada sumber terbuka 100%.

Pada 12 April, Databricks mengeluarkan Dolly 2.0, yang merupakan satu lagi versi baharu model bahasa besar (LLM) seperti ChatGPT interaktiviti manusia (mengikut arahan) yang dikeluarkan dua minggu lalu.

Databricks berkata Dolly 2.0 ialah sumber terbuka pertama industri, LLM yang mematuhi arahan, diperhalusi pada set data yang telus dan tersedia secara bebas yang juga sumber terbuka boleh digunakan untuk tujuan komersial . Ini bermakna Dolly 2.0 boleh digunakan untuk membina aplikasi komersial tanpa membayar akses API atau berkongsi data dengan pihak ketiga.

- Pautan projek: https://huggingface.co/databricks/dolly-v2-12b

- Dataset: https://github.com/databrickslabs/dolly/tree/master/data

Menurut Ketua Pegawai Eksekutif Databricks Ali Ghodsi, sementara terdapat model besar lain yang boleh digunakan untuk tujuan komersial, "mereka tidak bercakap dengan anda seperti Dolly 2.0 Dan berdasarkan model Dolly 2.0, pengguna boleh mengubah suai dan menambah baik data latihan , kerana ia tersedia secara percuma di bawah lesen sumber terbuka. Jadi anda boleh membuat Dolly versi anda sendiri.

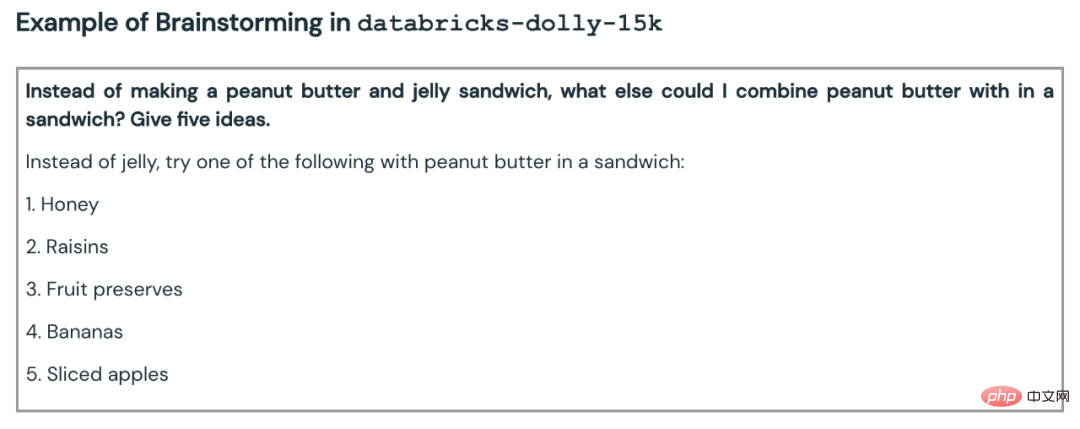

Databricks turut mengeluarkan set data yang Dolly 2.0 telah diperhalusi, dipanggil databricks-dolly-15k. Ini adalah korpus lebih daripada 15,000 rekod yang dijana oleh beribu-ribu pekerja Databricks Databricks memanggilnya "sumber terbuka pertama, korpus arahan yang dijana manusia, yang direka khusus untuk membolehkan bahasa besar menunjukkan interaktiviti ajaib ChatGPT" ”

Bagaimana Dolly 2.0 dilahirkanDalam dua bulan lalu, industri dan akademia telah mengikuti OpenAI dan mencadangkan gelombang alat seperti ChatGPT yang mengikut arahan , versi ini dianggap sumber terbuka oleh banyak definisi (atau menawarkan beberapa tahap keterbukaan atau akses terhad). Antaranya, LLaMA Meta telah menarik perhatian paling ramai, yang telah membawa kepada sejumlah besar model yang dipertingkatkan lagi, seperti Alpaca, Koala, Vicuna dan Databricks' Dolly 1.0.

Tetapi sebaliknya, kebanyakan model "terbuka" ini berada di bawah "sekatan industri" kerana mereka dilatih mengenai set data dengan istilah yang direka untuk mengehadkan penggunaan komersial - Contohnya, 52,000 set data soal jawab daripada projek StanfordAlpaca telah dilatih mengenai output OpenAI's ChatGPT. Dan syarat penggunaan OpenAI termasuk peraturan bahawa anda tidak boleh menggunakan perkhidmatan OpenAI untuk bersaing dengan mereka.

Databricks telah memikirkan cara untuk menyelesaikan masalah ini: Dolly 2.0 yang baru dicadangkan ialah model bahasa 12 bilion parameter berdasarkan siri model EleutherAI pythia sumber terbuka, khususnya menyasarkan arahan sumber terbuka kecil rekod corpora Ditala halus (databricks-dolly-15k), set data ini dijana oleh pekerja Databricks dan dilesenkan di bawah syarat yang membenarkan penggunaan, pengubahsuaian dan sambungan untuk sebarang tujuan, termasuk aplikasi akademik atau komersial.

Setakat ini, model yang dilatih mengenai keluaran ChatGPT berada dalam kawasan kelabu yang sah. "Seluruh komuniti telah berjingkat-jingkat mengelilingi masalah ini, dan semua orang mengeluarkan model ini, tetapi tiada satu pun daripada mereka tersedia secara komersial," kata Ghodsi. "Itulah sebabnya kami sangat teruja."

"Semua orang mahu menjadi lebih besar, tetapi kami sebenarnya berminat dengan perkara yang lebih kecil," kata Ghodsi mengenai Dolly berskala kecil. "Kedua, kami telah meneliti semua jawapan dan ia adalah berkualiti tinggi." kecerdasan buatan kepada Orang ramai menyertai dan menghasilkan alternatif lain. Dia menjelaskan bahawa sekatan ke atas penggunaan komersial merupakan halangan besar untuk diatasi: "Kami teruja sekarang kerana kami akhirnya menemui jalan untuk mengatasinya. Saya jamin anda akan melihat orang menggunakan 15,000 masalah ini ke dunia nyata. Setiap model di sana ialah, mereka akan melihat berapa banyak model ini tiba-tiba menjadi sedikit ajaib dan anda boleh berinteraksi dengan mereka."

Set Data Gosok Tangan

Untuk memuat turun pemberat bagi model Dolly 2.0, cuma lawati halaman Muka Peluk Databricks dan lawati repo Dolly databricks-labs untuk memuat turun set databricks-dolly-15k .

Set data "databricks-dolly-15k" mengandungi 15,000 pasangan gesaan/balas berkualiti tinggi yang dihasilkan manusia, oleh lebih 5,000 pekerja Databricks pada 2023 Ditulis pada bulan Mac dan April, direka khusus untuk menyediakan arahan untuk menala model bahasa besar. Rakaman latihan ini adalah semula jadi, ekspresif dan direka bentuk untuk mewakili pelbagai tingkah laku, daripada sumbang saran dan penjanaan kandungan kepada pengekstrakan dan rumusan maklumat.

Mengikut syarat lesen set data ini (Creative Commons Attribution-ShareAlike 3.0 Unported License), sesiapa sahaja boleh menggunakan, mengubah suai atau melanjutkan set data ini untuk sebarang tujuan, termasuk aplikasi komersial.

Pada masa ini, set data ini ialah set data arahan sumber terbuka pertama yang dijana oleh manusia .

Mengapa mencipta set data sedemikian? Pasukan itu juga menjelaskan mengapa dalam catatan blog.

Langkah penting dalam mencipta Dolly 1.0, atau mana-mana arahan yang mengikuti LLM, ialah melatih model pada set data pasangan arahan dan balasan. Dolly 1.0 berharga $30 untuk melatih dan menggunakan set data yang dicipta oleh pasukan Alpaca di Stanford University menggunakan API OpenAI.

Selepas Dolly 1.0 dikeluarkan, ramai yang meminta untuk mencubanya, dan beberapa pengguna juga ingin menggunakan model ini secara komersial.

Tetapi set data latihan mengandungi output ChatGPT, dan seperti yang ditunjukkan oleh pasukan Stanford, syarat perkhidmatan cuba menghalang sesiapa daripada mencipta model yang bersaing dengan OpenAI.

Sebelum ini, semua model pematuhan arahan yang terkenal (Alpaca, Koala, GPT4All, Vicuna) tertakluk pada sekatan ini: penggunaan komersial adalah dilarang. Untuk menyelesaikan masalah ini, pasukan Dolly mula mencari cara untuk mencipta set data baharu tanpa sekatan ke atas penggunaan komersial.

Secara khusus, pasukan mengetahui daripada kertas penyelidikan yang diterbitkan oleh OpenAI bahawa model InstructGPT asal telah dilatih pada set data yang terdiri daripada 13,000 demonstrasi tingkah laku mengikut arahan. Diilhamkan oleh ini, mereka berusaha untuk melihat sama ada mereka boleh mencapai keputusan yang sama, diketuai oleh pekerja Databricks.

Ternyata, menghasilkan 13,000 soalan dan jawapan adalah lebih sukar daripada yang dibayangkan. Kerana setiap jawapan mestilah asli dan tidak boleh disalin daripada ChatGPT atau mana-mana di web, jika tidak, ia akan "mencemarkan" set data. Tetapi Databricks mempunyai lebih daripada 5,000 pekerja, dan mereka sangat berminat dengan LLM. Oleh itu, pasukan itu menjalankan percubaan penyumberan ramai yang mencipta set data berkualiti tinggi daripada apa yang dibuat oleh 40 anotasi untuk OpenAI.

Sudah tentu, kerja ini memakan masa dan intensif tenaga kerja untuk memotivasikan semua orang, pasukan telah mengadakan pertandingan, dan 20 pencatat teratas akan menerima hadiah kejutan. Pada masa yang sama, mereka turut menyenaraikan 7 tugasan yang sangat khusus:

- Soalan Jawab Terbuka: Contohnya, "Mengapa orang suka filem komedi atau "Apakah ibu negara Perancis?" bantuan diperlukan Pengetahuan tentang seluruh dunia;

- Soalan dan jawapan tertutup: Soalan ini boleh dijawab menggunakan hanya satu perenggan maklumat daripada rujukan. Sebagai contoh, memandangkan perenggan Wikipedia tentang atom, seseorang mungkin bertanya: "Apakah nisbah proton kepada neutron dalam nukleus?"; daripada perenggan, seperti berat atau ukuran;

- meringkaskan maklumat di Wikipedia: Untuk ini, annotator disediakan dengan petikan dari Wikipedia dan diminta untuk menyaringnya menjadi ringkasan ringkas; 🎜>

- Sumbangsaran: Tugas ini memerlukan idea terbuka , dan menyenaraikan kemungkinan pilihan yang berkaitan. Contohnya "Apakah aktiviti yang menyeronokkan yang boleh saya lakukan bersama rakan saya pada hujung minggu ini?";

- Kategori: Dalam tugasan ini, pencatat diminta membuat pertimbangan tentang keahlian kategori (mis., sama ada item dalam senarai adalah haiwan, mineral, atau sayur-sayuran), atau menilai atribut petikan pendek, seperti sentimen ulasan filem; puisi atau Surat cinta dan banyak lagi.

- Berikut ialah beberapa contoh:

Pada mulanya, pasukan itu ragu-ragu tentang mencapai 10,000 keputusan. Tetapi dengan permainan papan pendahulu setiap malam, ia berjaya mencapai 15,000 keputusan dalam satu minggu.

Selepas set data dibuat dengan cepat, pasukan mula mempertimbangkan aplikasi komersial.

Mereka mahu membuat model sumber terbuka yang boleh digunakan secara komersial. Walaupun databricks-dolly-15k jauh lebih kecil daripada Alpaca (set data yang Dolly 1.0 dilatih), model Dolly 2.0 berdasarkan EleutherAI pythia-12b mempamerkan arahan yang berkualiti tinggi mengikut tingkah laku.

Jika difikirkan semula, ini tidak menghairankan. Lagipun, banyak set data penalaan arahan yang dikeluarkan dalam beberapa bulan kebelakangan ini mengandungi data sintetik, yang selalunya mengandungi halusinasi dan ralat fakta.

databricks-dolly-15k, sebaliknya, dijana oleh profesional, berkualiti tinggi dan mengandungi jawapan berbentuk panjang untuk kebanyakan tugas.

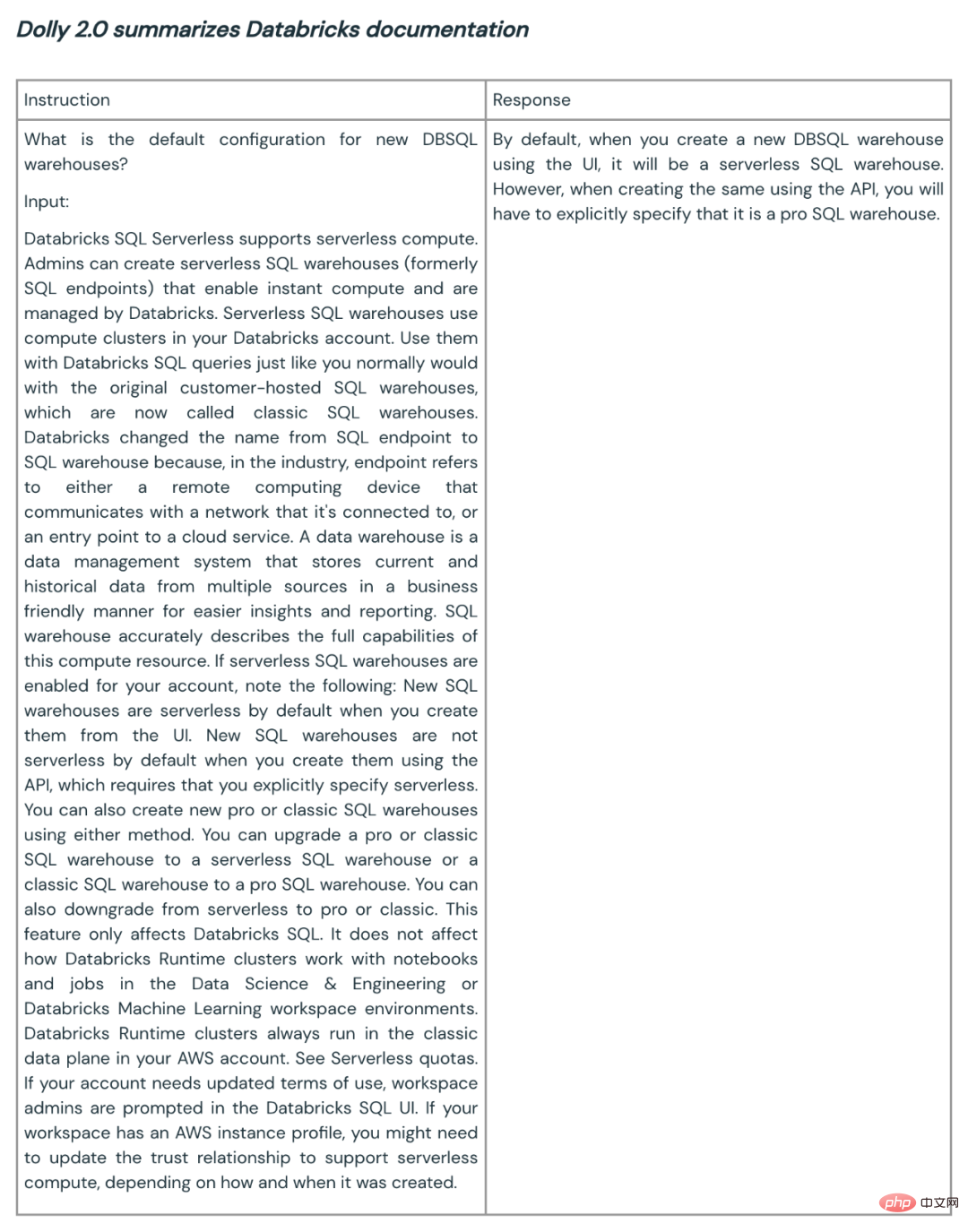

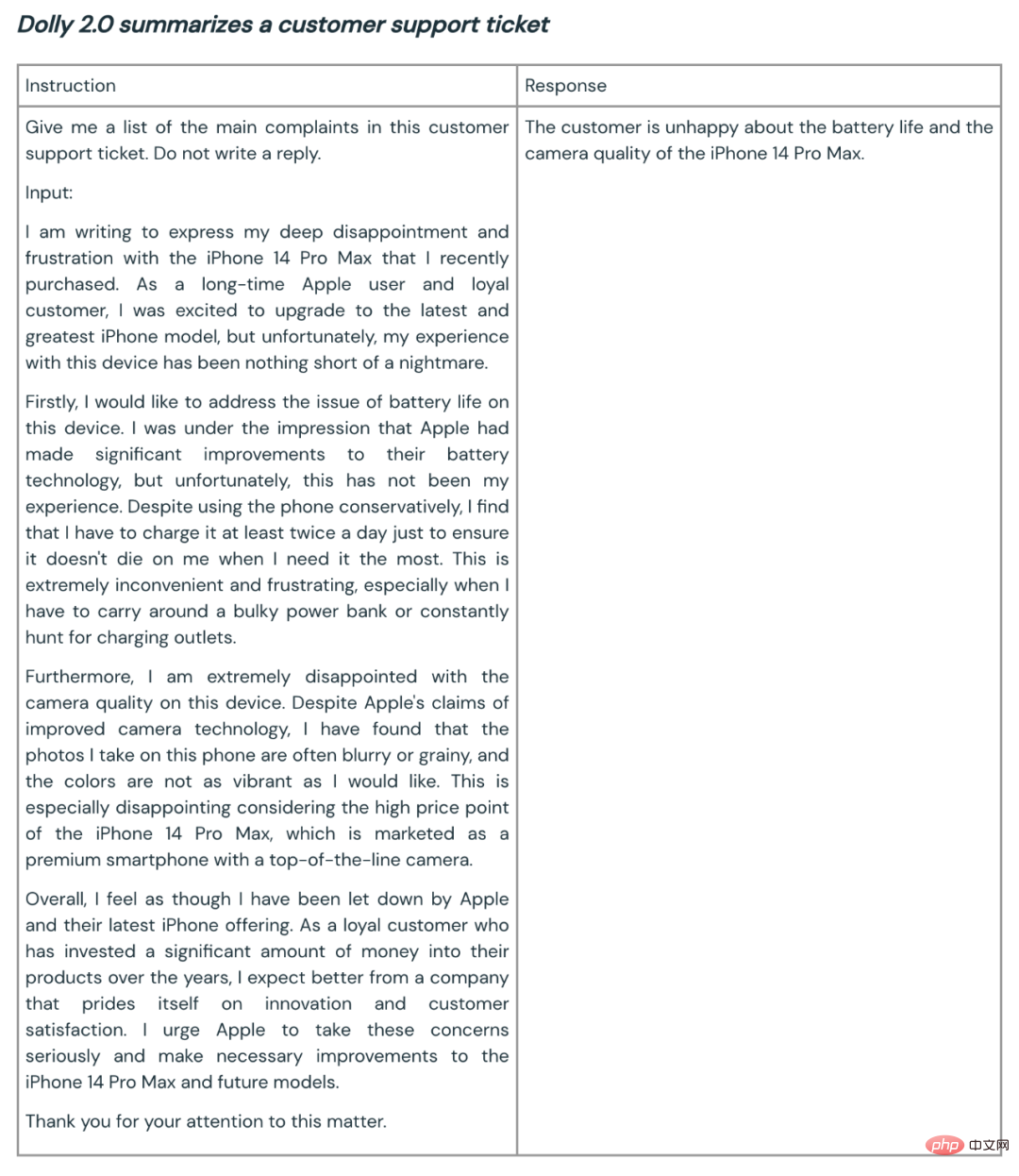

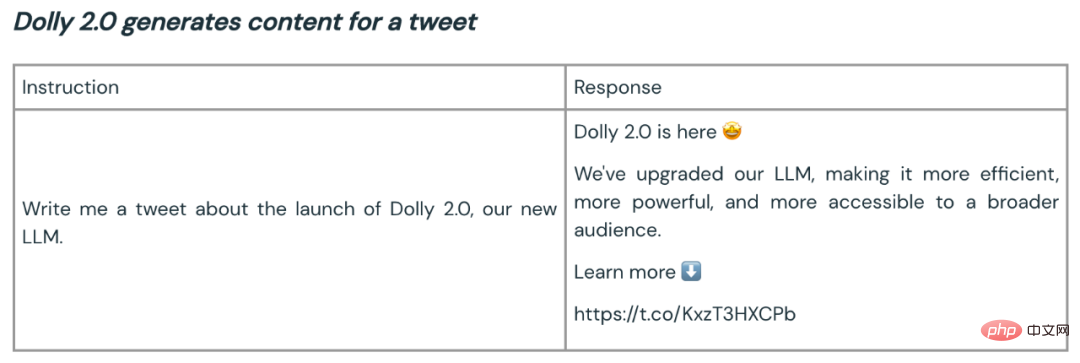

Berikut ialah beberapa contoh Dolly 2.0 yang digunakan untuk ringkasan dan penjanaan kandungan:

Berdasarkan maklum balas awal pelanggan, pasukan Dolly berkata keupayaan seperti ini boleh digunakan secara meluas di seluruh perusahaan. Kerana banyak syarikat ingin mempunyai model mereka sendiri untuk mencipta model berkualiti tinggi untuk aplikasi domain khusus mereka sendiri, dan bukannya menyerahkan data sensitif mereka kepada pihak ketiga.

Berdasarkan maklum balas awal pelanggan, pasukan Dolly berkata keupayaan seperti ini boleh digunakan secara meluas di seluruh perusahaan. Kerana banyak syarikat ingin mempunyai model mereka sendiri untuk mencipta model berkualiti tinggi untuk aplikasi domain khusus mereka sendiri, dan bukannya menyerahkan data sensitif mereka kepada pihak ketiga.

Atas ialah kandungan terperinci Dolly 2.0, model besar ChatGPT sumber terbuka pertama di dunia, boleh diubah suai sesuka hati untuk kegunaan komersil. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

Sepuluh alat anotasi teks percuma sumber terbuka yang disyorkan

Mar 26, 2024 pm 08:20 PM

Sepuluh alat anotasi teks percuma sumber terbuka yang disyorkan

Mar 26, 2024 pm 08:20 PM

Anotasi teks ialah kerja label atau teg yang sepadan dengan kandungan tertentu dalam teks. Tujuan utamanya adalah untuk memberikan maklumat tambahan kepada teks untuk analisis dan pemprosesan yang lebih mendalam, terutamanya dalam bidang kecerdasan buatan. Anotasi teks adalah penting untuk tugas pembelajaran mesin yang diawasi dalam aplikasi kecerdasan buatan. Ia digunakan untuk melatih model AI untuk membantu memahami maklumat teks bahasa semula jadi dengan lebih tepat dan meningkatkan prestasi tugasan seperti klasifikasi teks, analisis sentimen dan terjemahan bahasa. Melalui anotasi teks, kami boleh mengajar model AI untuk mengenali entiti dalam teks, memahami konteks dan membuat ramalan yang tepat apabila data baharu yang serupa muncul. Artikel ini terutamanya mengesyorkan beberapa alat anotasi teks sumber terbuka yang lebih baik. 1.LabelStudiohttps://github.com/Hu

15 alat anotasi imej percuma sumber terbuka disyorkan

Mar 28, 2024 pm 01:21 PM

15 alat anotasi imej percuma sumber terbuka disyorkan

Mar 28, 2024 pm 01:21 PM

Anotasi imej ialah proses mengaitkan label atau maklumat deskriptif dengan imej untuk memberi makna dan penjelasan yang lebih mendalam kepada kandungan imej. Proses ini penting untuk pembelajaran mesin, yang membantu melatih model penglihatan untuk mengenal pasti elemen individu dalam imej dengan lebih tepat. Dengan menambahkan anotasi pada imej, komputer boleh memahami semantik dan konteks di sebalik imej, dengan itu meningkatkan keupayaan untuk memahami dan menganalisis kandungan imej. Anotasi imej mempunyai pelbagai aplikasi, meliputi banyak bidang, seperti penglihatan komputer, pemprosesan bahasa semula jadi dan model penglihatan graf Ia mempunyai pelbagai aplikasi, seperti membantu kenderaan dalam mengenal pasti halangan di jalan raya, dan membantu dalam proses. pengesanan dan diagnosis penyakit melalui pengecaman imej perubatan. Artikel ini terutamanya mengesyorkan beberapa alat anotasi imej sumber terbuka dan percuma yang lebih baik. 1.Makesen

Disyorkan: Projek pengesanan dan pengecaman muka sumber terbuka JS yang sangat baik

Apr 03, 2024 am 11:55 AM

Disyorkan: Projek pengesanan dan pengecaman muka sumber terbuka JS yang sangat baik

Apr 03, 2024 am 11:55 AM

Teknologi pengesanan dan pengecaman muka adalah teknologi yang agak matang dan digunakan secara meluas. Pada masa ini, bahasa aplikasi Internet yang paling banyak digunakan ialah JS Melaksanakan pengesanan muka dan pengecaman pada bahagian hadapan Web mempunyai kelebihan dan kekurangan berbanding dengan pengecaman muka bahagian belakang. Kelebihan termasuk mengurangkan interaksi rangkaian dan pengecaman masa nyata, yang sangat memendekkan masa menunggu pengguna dan meningkatkan pengalaman pengguna termasuk: terhad oleh saiz model, ketepatannya juga terhad. Bagaimana untuk menggunakan js untuk melaksanakan pengesanan muka di web? Untuk melaksanakan pengecaman muka di Web, anda perlu biasa dengan bahasa dan teknologi pengaturcaraan yang berkaitan, seperti JavaScript, HTML, CSS, WebRTC, dll. Pada masa yang sama, anda juga perlu menguasai visi komputer yang berkaitan dan teknologi kecerdasan buatan. Perlu diingat bahawa kerana reka bentuk bahagian Web

Kod sumber 25 ejen AI kini terbuka, diilhamkan oleh 'Bandar Maya' dan 'Westworld' Stanford

Aug 11, 2023 pm 06:49 PM

Kod sumber 25 ejen AI kini terbuka, diilhamkan oleh 'Bandar Maya' dan 'Westworld' Stanford

Aug 11, 2023 pm 06:49 PM

Khalayak yang biasa dengan "Westworld" tahu bahawa rancangan ini terletak di taman tema dewasa berteknologi tinggi yang besar di dunia masa hadapan Robot mempunyai keupayaan tingkah laku yang serupa dengan manusia, dan boleh mengingati apa yang mereka lihat dan dengar, serta mengulangi jalan cerita teras. Setiap hari, robot ini akan ditetapkan semula dan dikembalikan kepada keadaan asalnya Selepas keluaran kertas kerja Stanford "Generative Agents: Interactive Simulacra of Human Behavior", senario ini tidak lagi terhad kepada filem dan siri TV telah berjaya menghasilkan semula ini tempat kejadian di "Bandar Maya" Smallville 》Alamat kertas peta gambaran keseluruhan: https://arxiv.org/pdf/2304.03442v1.pdf

Dokumen berbilang modal Alibaba 7B memahami model besar memenangi SOTA baharu

Apr 02, 2024 am 11:31 AM

Dokumen berbilang modal Alibaba 7B memahami model besar memenangi SOTA baharu

Apr 02, 2024 am 11:31 AM

SOTA baharu untuk keupayaan memahami dokumen multimodal! Pasukan Alibaba mPLUG mengeluarkan kerja sumber terbuka terkini mPLUG-DocOwl1.5, yang mencadangkan satu siri penyelesaian untuk menangani empat cabaran utama pengecaman teks imej resolusi tinggi, pemahaman struktur dokumen am, arahan mengikut dan pengenalan pengetahuan luaran. Tanpa berlengah lagi, mari kita lihat kesannya dahulu. Pengecaman satu klik dan penukaran carta dengan struktur kompleks ke dalam format Markdown: Carta gaya berbeza tersedia: Pengecaman dan kedudukan teks yang lebih terperinci juga boleh dikendalikan dengan mudah: Penjelasan terperinci tentang pemahaman dokumen juga boleh diberikan: Anda tahu, "Pemahaman Dokumen " pada masa ini Senario penting untuk pelaksanaan model bahasa yang besar. Terdapat banyak produk di pasaran untuk membantu pembacaan dokumen. Sesetengah daripada mereka menggunakan sistem OCR untuk pengecaman teks dan bekerjasama dengan LLM untuk pemprosesan teks.

Satu kad menjalankan Llama 70B lebih pantas daripada dua kad, Microsoft hanya meletakkan FP6 ke dalam A100 |

Apr 29, 2024 pm 04:55 PM

Satu kad menjalankan Llama 70B lebih pantas daripada dua kad, Microsoft hanya meletakkan FP6 ke dalam A100 |

Apr 29, 2024 pm 04:55 PM

FP8 dan ketepatan pengiraan titik terapung yang lebih rendah bukan lagi "paten" H100! Lao Huang mahu semua orang menggunakan INT8/INT4, dan pasukan Microsoft DeepSpeed memaksa diri mereka menjalankan FP6 pada A100 tanpa sokongan rasmi daripada Nvidia. Keputusan ujian menunjukkan bahawa kaedah baharu TC-FPx FP6 kuantisasi pada A100 adalah hampir atau kadangkala lebih pantas daripada INT4, dan mempunyai ketepatan yang lebih tinggi daripada yang terakhir. Selain itu, terdapat juga sokongan model besar hujung ke hujung, yang telah bersumberkan terbuka dan disepadukan ke dalam rangka kerja inferens pembelajaran mendalam seperti DeepSpeed. Keputusan ini juga mempunyai kesan serta-merta pada mempercepatkan model besar - di bawah rangka kerja ini, menggunakan satu kad untuk menjalankan Llama, daya pemprosesan adalah 2.65 kali lebih tinggi daripada dua kad. satu

1.3ms mengambil masa 1.3ms! Seni bina rangkaian neural mudah alih sumber terbuka terbaru Tsinghua RepViT

Mar 11, 2024 pm 12:07 PM

1.3ms mengambil masa 1.3ms! Seni bina rangkaian neural mudah alih sumber terbuka terbaru Tsinghua RepViT

Mar 11, 2024 pm 12:07 PM

Alamat kertas: https://arxiv.org/abs/2307.09283 Alamat kod: https://github.com/THU-MIG/RepViTRepViT berprestasi baik dalam seni bina ViT mudah alih dan menunjukkan kelebihan yang ketara. Seterusnya, kami meneroka sumbangan kajian ini. Disebutkan dalam artikel bahawa ViT ringan biasanya berprestasi lebih baik daripada CNN ringan pada tugas visual, terutamanya disebabkan oleh modul perhatian diri berbilang kepala (MSHA) mereka yang membolehkan model mempelajari perwakilan global. Walau bagaimanapun, perbezaan seni bina antara ViT ringan dan CNN ringan belum dikaji sepenuhnya. Dalam kajian ini, penulis menyepadukan ViT ringan ke dalam yang berkesan

Baru dikeluarkan! Model sumber terbuka untuk menghasilkan imej gaya anime dengan satu klik

Apr 08, 2024 pm 06:01 PM

Baru dikeluarkan! Model sumber terbuka untuk menghasilkan imej gaya anime dengan satu klik

Apr 08, 2024 pm 06:01 PM

Izinkan saya memperkenalkan kepada anda projek sumber terbuka AIGC terkini-AnimagineXL3.1. Projek ini adalah lelaran terkini model teks-ke-imej bertema anime, yang bertujuan untuk menyediakan pengguna pengalaman penjanaan imej anime yang lebih optimum dan berkuasa. Dalam AnimagineXL3.1, pasukan pembangunan menumpukan pada mengoptimumkan beberapa aspek utama untuk memastikan model mencapai tahap prestasi dan kefungsian yang baharu. Pertama, mereka mengembangkan data latihan untuk memasukkan bukan sahaja data watak permainan daripada versi sebelumnya, tetapi juga data daripada banyak siri anime terkenal lain ke dalam set latihan. Langkah ini memperkayakan pangkalan pengetahuan model, membolehkannya memahami pelbagai gaya dan watak anime dengan lebih lengkap. AnimagineXL3.1 memperkenalkan set teg khas dan estetika baharu