Peranti teknologi

Peranti teknologi

AI

AI

Set data penanda aras pengisihan perenggan Cina yang dikeluarkan: berdasarkan 300,000 pertanyaan sebenar dan 2 juta perenggan Internet.

Set data penanda aras pengisihan perenggan Cina yang dikeluarkan: berdasarkan 300,000 pertanyaan sebenar dan 2 juta perenggan Internet.

Set data penanda aras pengisihan perenggan Cina yang dikeluarkan: berdasarkan 300,000 pertanyaan sebenar dan 2 juta perenggan Internet.

Isih perenggan ialah topik yang sangat penting dan mencabar dalam bidang pencarian maklumat, dan telah mendapat perhatian meluas daripada ahli akademik dan industri. Keberkesanan model pemeringkatan perenggan boleh meningkatkan kepuasan pengguna enjin carian dan membantu aplikasi berkaitan pencarian maklumat seperti sistem soal jawab, pemahaman bacaan, dsb. Dalam konteks ini, beberapa set data penanda aras seperti MS-MARCO, DuReader_retrieval, dsb. telah dibina untuk menyokong kerja penyelidikan yang berkaitan pada pengisihan perenggan. Walau bagaimanapun, kebanyakan set data yang biasa digunakan memfokuskan pada adegan bahasa Inggeris Untuk adegan bahasa Cina, set data sedia ada mempunyai had dalam skala data, anotasi pengguna yang terperinci dan penyelesaian kepada masalah contoh negatif palsu. Dalam konteks ini, kami membina set data penanda aras kedudukan perenggan bahasa Cina baharu berdasarkan log carian sebenar: T2Kedudukan.

T2Kedudukan terdiri daripada lebih daripada 300,000 pertanyaan sebenar dan 2 juta perenggan Internet, dan termasuk maklumat yang diberikan oleh juru anotasi profesional Tahap 4 denda -anotasi korelasi berbutir. Data semasa dan beberapa model asas telah diterbitkan di Github, dan kerja penyelidikan yang berkaitan telah diterima oleh SIGIR 2023 sebagai kertas Sumber.

- Maklumat kertas: Xiaohui Xie, Qian Dong, Bingning Wang, Feiyang Lv , Ting Yao, Weinan Gan, Zhijing Wu, Xiangsheng Li, Haitao Li, Yiqun Liu dan Jin Ma Kedudukan T2: Penanda Aras Cina berskala besar 2023.

- . Alamat kertas: https://arxiv.org/abs/2304.03679

- Alamat Github: https://github.com/THUIR/T2Ranking

Latar belakang dan kerja berkaitan

Matlamat tugas pemeringkatan perenggan adalah untuk mengingat dan mengisih koleksi perenggan berskala besar berdasarkan pertanyaan yang diberikan Penggal perenggan calon, dapatkan senarai perenggan mengikut urutan dari perkaitan tinggi ke rendah. Pengisihan perenggan secara amnya terdiri daripada dua peringkat: ingat kembali perenggan dan penyusunan semula perenggan.

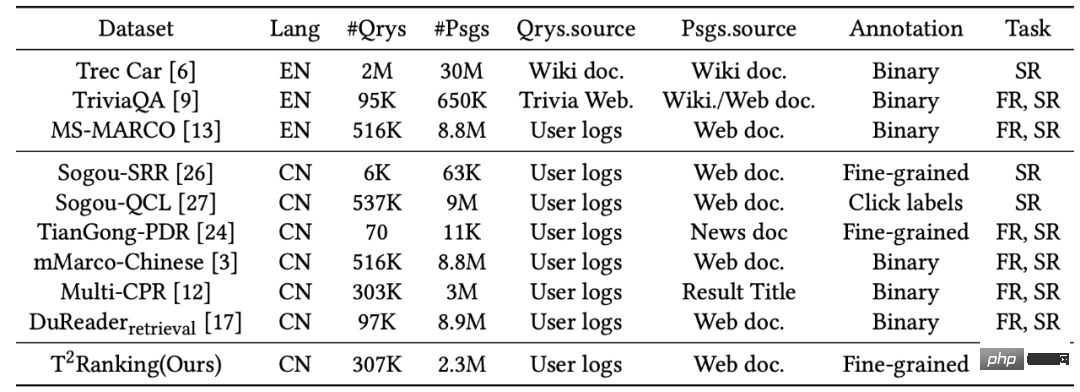

Untuk menyokong tugas pengisihan perenggan, beberapa set data dibina untuk latihan dan menguji algoritma pengisihan perenggan. Kebanyakan set data yang digunakan secara meluas memfokuskan pada adegan bahasa Inggeris Sebagai contoh, set data yang paling biasa digunakan ialah set data MS-MARCO, yang mengandungi lebih daripada 500,000 istilah pertanyaan dan lebih daripada 8 juta perenggan Setiap istilah pertanyaan mempunyai atribut soalan. Untuk setiap istilah pertanyaan, pasukan keluaran data MS-MARCO merekrut pencatat untuk memberikan jawapan standard Berdasarkan sama ada perenggan tertentu mengandungi jawapan standard yang disediakan secara manual, ia dinilai sama ada perenggan ini berkaitan dengan istilah pertanyaan.

Dalam senario Cina, terdapat juga beberapa set data yang dibina untuk menyokong tugas pengisihan perenggan. Sebagai contoh, mMarco-Chinese ialah versi terjemahan bahasa Cina bagi set data MS-MARCO dan set data DuReader_retrieval menggunakan paradigma yang sama seperti MS-MARCO untuk menjana label perenggan, iaitu, korelasi pasangan perkataan-perenggan pertanyaan ialah diberikan daripada jawapan standard yang disediakan oleh manusia. Model Multi-CPR mengandungi data perolehan perenggan daripada tiga domain berbeza (e-dagang, video hiburan dan perubatan). Berdasarkan data log carian Sogou, set data seperti Sogou-SRR, Sogou-QCL dan Tiangong-PDR juga telah dicadangkan.

Rajah 1: Statistik set data yang biasa digunakan dalam tugas pengisihan perenggan

Walaupun set data sedia ada telah menggalakkan pembangunan aplikasi pengisihan perenggan, kami juga perlu memberi perhatian kepada beberapa batasan:

1) Set data ini tidak besar -skala Label atau perkaitan tidak dianotasi secara manual, terutamanya dalam senario Cina. Sogou-SRR dan Tiangong-PDR hanya mengandungi sejumlah kecil data pertanyaan. Walaupun mMarco-Chinese dan Sogou-QCL lebih besar dalam skala, yang pertama adalah berdasarkan terjemahan mesin dan yang terakhir menggunakan label perkaitan sebagai data klik pengguna. Baru-baru ini, dua set data yang agak besar, Multi-CPR dan DuReader_retrieval, telah dibina dan dikeluarkan.

2) Set data sedia ada kekurangan maklumat anotasi korelasi yang terperinci. Kebanyakan set data menggunakan anotasi korelasi binari (berbutir kasar), iaitu, berkaitan atau tidak relevan. Kerja sedia ada telah menunjukkan bahawa maklumat anotasi korelasi yang terperinci boleh membantu melombong perhubungan antara entiti yang berbeza dan membina algoritma kedudukan yang lebih tepat. Kemudian terdapat set data sedia ada yang tidak menyediakan atau hanya menyediakan sejumlah kecil anotasi berbutir halus berbilang peringkat. Sebagai contoh, Sogou-SRR atau Tiangong-PDR hanya memberikan anotasi halus tidak lebih daripada 100,000.

3) Masalah contoh negatif palsu menjejaskan ketepatan penilaian. Set data sedia ada dipengaruhi oleh masalah contoh negatif palsu, di mana sejumlah besar dokumen berkaitan ditandakan sebagai tidak berkaitan. Masalah ini disebabkan oleh bilangan anotasi manual yang kecil dalam data berskala besar, yang akan menjejaskan ketepatan penilaian dengan ketara. Contohnya, dalam Multi-CPR, hanya satu perenggan akan ditandakan sebagai relevan untuk setiap istilah pertanyaan, manakala yang lain akan ditandakan sebagai tidak berkaitan. DuReader_retrieval cuba untuk mengurangkan masalah negatif palsu dengan membenarkan anotasi memeriksa secara manual dan menganotasi semula set perenggan teratas.

Untuk menyokong model pemeringkatan perenggan yang lebih baik untuk latihan dan penilaian berkualiti tinggi, kami membina dan mengeluarkan set data penanda aras perolehan perenggan bahasa Cina baharu - T2Kedudukan .

Proses pembinaan set data

Proses pembinaan set data termasuk pensampelan perkataan pertanyaan, ingatan semula dokumen, pengekstrakan perenggan dan anotasi perkaitan yang terperinci. Pada masa yang sama, kami juga telah mereka bentuk pelbagai kaedah untuk meningkatkan kualiti set data, termasuk menggunakan kaedah segmentasi perenggan berasaskan model dan kaedah penduaan perenggan berasaskan kluster untuk memastikan integriti semantik dan kepelbagaian perenggan, dan menggunakan pembelajaran aktif- anotasi berasaskan Kaedah untuk meningkatkan kecekapan dan kualiti anotasi, dsb.

1) Proses keseluruhan

- Persampelan perkataan pertanyaan: Kami mengambil sampel daripada log carian carian Sogou enjin Kata pertanyaan yang dikemukakan oleh pengguna sebenar telah dijadikan sampel, dan set kata pertanyaan awal diperoleh selepas penyahduplikasian dan normalisasi. Seterusnya, kami menggunakan algoritma analisis niat untuk mengalih keluar pertanyaan lucah, pertanyaan bukan soalan, pertanyaan aplikasi sumber dan pertanyaan yang mungkin mengandungi maklumat pengguna, memastikan set data pertanyaan akhir hanya mengandungi pertanyaan berkualiti tinggi dengan atribut soalan.

- Pengingat semula dokumen: Berdasarkan syarat pertanyaan sampel, kami telah menarik balik set calon dokumen daripada berbilang enjin carian arus perdana seperti Sogou, Baidu dan Google, menyepadukan sepenuhnya pengindeksan dan Keupayaan untuk mengisih dokumen. Oleh kerana enjin carian ini dapat merangkumi bahagian data Internet yang berbeza dan mengembalikan hasil dokumen yang pelbagai, mereka boleh meningkatkan kesempurnaan set calon dokumen dan mengurangkan masalah negatif palsu pada tahap tertentu.

- Pengestrakan perenggan: Langkah pengekstrakan perenggan melibatkan pembahagian perenggan dan penduaan. Daripada menggunakan kaedah heuristik untuk membahagikan perenggan dalam dokumen (seperti menentukan permulaan dan penghujung perenggan secara konvensional melalui pemisah baris), kami melatih model semantik perenggan untuk melaksanakan pembahagian perenggan untuk memastikan integriti semantik setiap perenggan sebanyak mungkin. Selain itu, kami juga memperkenalkan teknologi berasaskan kluster untuk meningkatkan kecekapan anotasi dan memastikan kepelbagaian perenggan beranotasi Teknologi ini boleh mengalih keluar perenggan yang sangat serupa dengan berkesan.

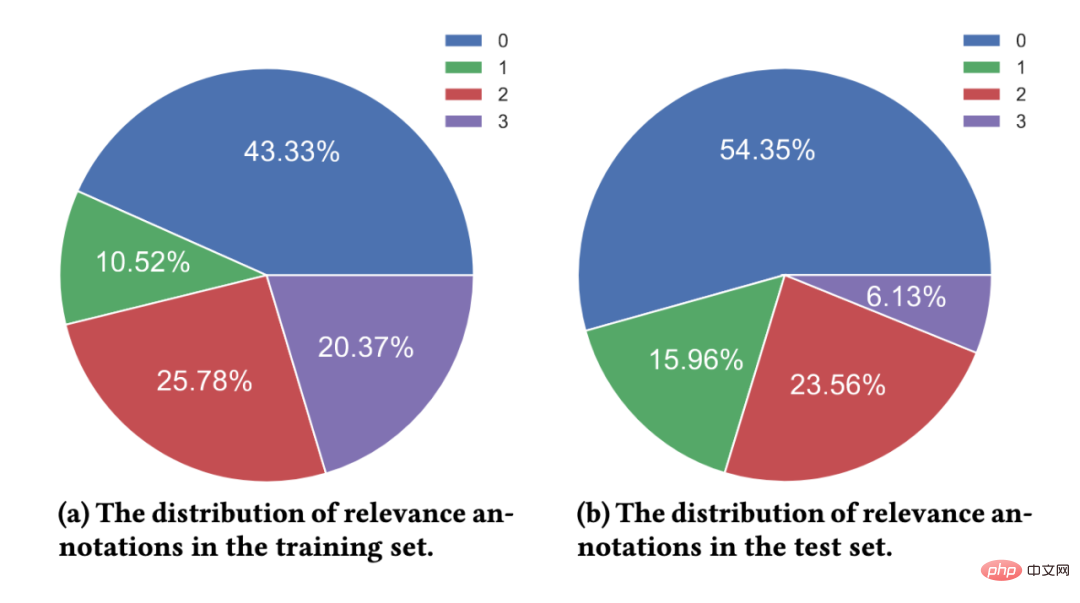

- Anotasi korelasi berbutir halus: Anotasi yang diupah adalah pakar dalam mencari tugas anotasi yang berkaitan dan telah terlibat dalam kerja anotasi untuk masa yang lama. Untuk setiap pasangan perenggan pertanyaan, sekurang-kurangnya 3 anotasi memberikan anotasi. Jika hasil anotasi bagi tiga anotasi tidak konsisten, kami akan memperkenalkan anotasi tambahan untuk anotasi Jika keputusan empat anotasi tidak konsisten, kami cenderung untuk berfikir bahawa pasangan kata-perenggan pertanyaan adalah terlalu kabur, berkualiti rendah dan tidak konsisten dapat menentukan maklumat yang diperlukan, dengan itu mengecualikan pasangan istilah-perenggan pertanyaan daripada set data. Kami menentukan label perkaitan akhir dengan undian majoriti. Garis panduan anotasi perkaitan 4 peringkat yang kami pakai adalah konsisten dengan penanda aras TREC.

- Tahap 0: Istilah pertanyaan sama sekali tidak berkaitan dengan kandungan perenggan

- Tahap 1: Kandungan perenggan berkaitan dengan istilah pertanyaan, tetapi tidak sepadan dengan keperluan maklumat bagi istilah pertanyaan

- Tahap 2: Kandungan perenggan berkaitan dengan istilah pertanyaan dan boleh memenuhi sebahagian keperluan maklumat istilah pertanyaan

- Tahap 3: Kandungan perenggan dapat memenuhi sepenuhnya keperluan maklumat syarat pertanyaan dan mengandungi jawapan yang tepat.

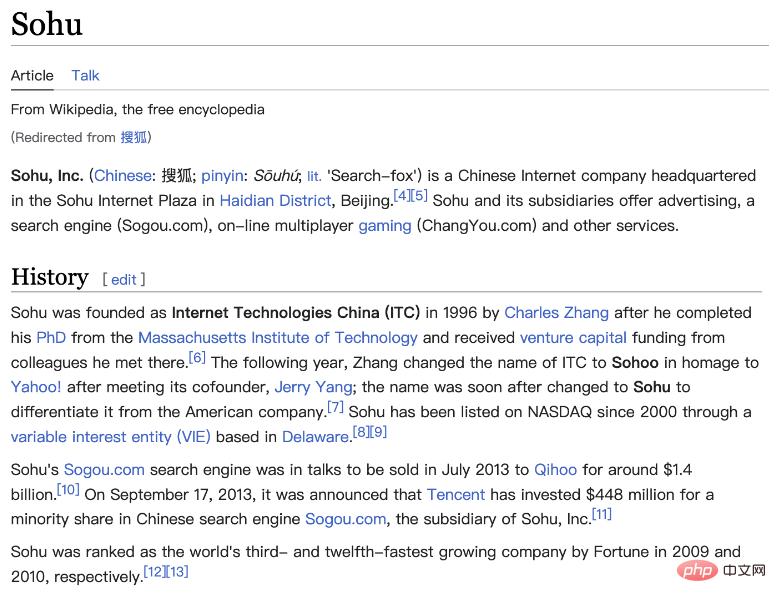

Rajah 2: Contoh halaman Wikipedia. Dokumen yang dibentangkan mengandungi perenggan yang jelas.

2) Kaedah pembahagian perenggan berasaskan model

Dalam set data sedia ada, Perenggan biasanya dipisahkan daripada dokumen berdasarkan perenggan semula jadi (pemutus baris) atau dengan tingkap gelongsor panjang tetap. Walau bagaimanapun, kedua-dua kaedah boleh mengakibatkan perenggan yang tidak lengkap secara semantik atau terlalu panjang dan mengandungi berbilang topik berbeza. Dalam kerja ini, kami menggunakan kaedah pembahagian perenggan berasaskan model Secara khusus, kami menggunakan Ensiklopedia Sogou, Ensiklopedia Baidu dan Wikipedia Bahasa Cina sebagai data latihan, kerana struktur bahagian dokumen ini agak jelas, dan perenggan semula jadi juga diperolehi. definisi yang lebih baik. Kami melatih model pembahagian untuk menentukan sama ada perkataan tertentu perlu menjadi titik pembahagian. Kami menggunakan idea tugas pelabelan urutan dan menggunakan perkataan terakhir setiap segmen semula jadi sebagai contoh positif untuk melatih model.

3) Kaedah deduplikasi perenggan berasaskan pengelompokan

Menganotasi perenggan yang sangat serupa adalah berlebihan dan tidak bermakna untuk perenggan model kedudukan, perolehan maklumat yang dibawa oleh kandungan perenggan yang sangat serupa adalah terhad, jadi kami mereka bentuk kaedah penyahduplikasi perenggan berasaskan kluster untuk meningkatkan kecekapan anotasi. Khususnya, kami menggunakan Ward, algoritma pengelompokan hierarki, untuk melaksanakan pengelompokan tanpa diawasi bagi dokumen serupa. Perenggan dalam kelas yang sama dianggap sangat serupa, dan kami mencuba satu perenggan daripada setiap kelas untuk anotasi perkaitan. Perlu diingatkan bahawa kami hanya melakukan operasi ini pada set latihan Untuk set ujian, kami akan menganotasi sepenuhnya semua perenggan yang diekstrak untuk mengurangkan kesan contoh negatif palsu.

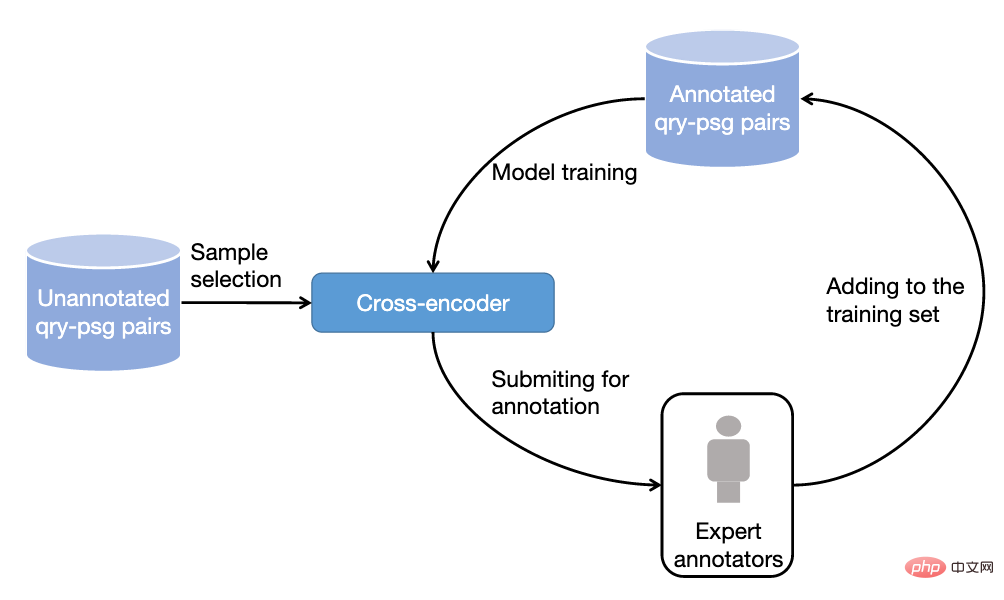

Rajah 3: Proses anotasi pensampelan berdasarkan pembelajaran aktif

4) Kaedah pensampelan dan anotasi data berdasarkan pembelajaran aktif

Dalam amalan, kami mendapati bahawa tidak semua sampel latihan boleh dipertingkatkan lagi Prestasi daripada model ranking. Untuk sampel latihan yang boleh diramalkan dengan tepat oleh model, bantuan latihan untuk model seterusnya adalah terhad. Oleh itu, kami meminjam idea pembelajaran aktif untuk membolehkan model memilih sampel latihan yang lebih bermaklumat untuk anotasi selanjutnya. Khususnya, kami mula-mula melatih model penyusunan semula perkataan-perenggan berdasarkan rangka kerja pengekod silang berdasarkan data latihan sedia ada Kemudian kami menggunakan model ini untuk meramalkan data lain dan mengalih keluar skor keyakinan yang berlebihan (kandungan maklumat) dan juga skor keyakinan rendah (data bising), jelaskan lagi perenggan yang disimpan, dan ulangi proses ini.

Statistik Set Data

T2Kedudukan terdiri daripada lebih 300,000 pertanyaan sebenar dan 2 juta perenggan Internet. Antaranya, set latihan mengandungi kira-kira 250,000 perkataan pertanyaan, dan set ujian mengandungi kira-kira 50,000 perkataan pertanyaan. Istilah pertanyaan boleh mencapai sehingga 40 aksara, dengan purata panjang sekitar 11 aksara. Pada masa yang sama, perkataan pertanyaan dalam set data meliputi berbilang medan, termasuk perubatan, pendidikan, e-dagang, dll. Kami juga mengira skor kepelbagaian (ILS) perkataan pertanyaan Berbanding dengan set data sedia ada, kepelbagaian pertanyaan kami adalah lebih tinggi. Lebih daripada 2.3 juta perenggan telah dijadikan sampel daripada 1.75 juta dokumen, dan setiap dokumen dibahagikan kepada 1.3 perenggan secara purata. Dalam set latihan, purata 6.25 perenggan bagi setiap istilah pertanyaan dianotasi secara manual, manakala dalam set ujian, purata 15.75 perenggan bagi setiap istilah pertanyaan dianotasi secara manual.

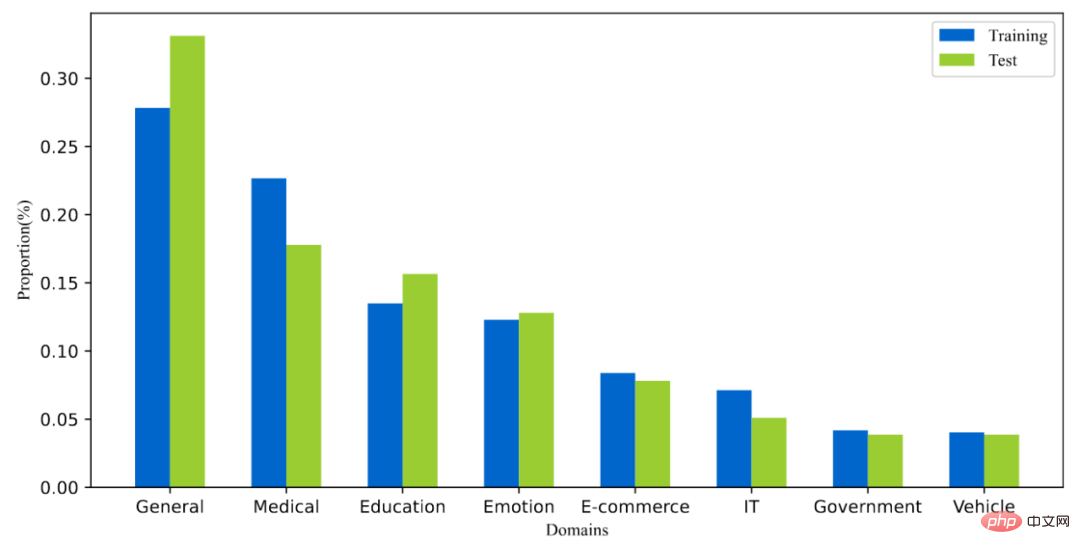

Rajah 4: Taburan domain perkataan pertanyaan dalam set data

Rajah 5: Taburan anotasi korelasi

Hasil eksperimen model yang biasa digunakan

Kami menguji prestasi beberapa model kedudukan perenggan yang biasa digunakan pada set data yang diperolehi Kami juga menilai kaedah sedia ada dalam ingatan perenggan dan penekanan perenggan kedua-dua peringkat pengisihan.

1) Percubaan ingat semula perenggan

Model ingat semula perenggan sedia ada boleh dibahagikan secara kasar kepada model ingat semula jarang dan padat ingat model.

- Model penarikan semula jarang memfokuskan pada isyarat padanan tepat untuk mereka bentuk fungsi pemarkahan perkaitan Sebagai contoh, BM25 ialah model penanda aras yang paling mewakili.

- Model penarikan semula padat menggunakan rangkaian saraf dalam untuk mempelajari vektor padat dimensi rendah untuk mewakili perkataan dan perenggan pertanyaan.

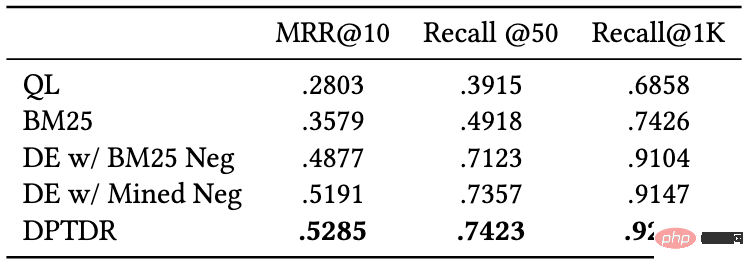

Kami menguji prestasi model penarikan balik berikut:

- QL (kemungkinan pertanyaan): QL ialah wakil A model bahasa statistik yang menilai perkaitan berdasarkan kebarangkalian perenggan menjana istilah pertanyaan tertentu.

- BM25: model penanda aras ingat jarang yang biasa digunakan.

- DE w/ BM25 Neg: Model DPR, struktur pengekod dwi-menara (Dual-Encoder), model ini ialah penarikan semula perenggan pertama yang menggunakan model bahasa pra-latihan sebagai tulang belakang Model rangka kerja.

- DE w/Mined Neg: Struktur Dwi Pengekod, yang meningkatkan prestasi model DPR dengan mengingat kembali contoh negatif keras daripada korpus penuh.

- DPTDR: Model penarikan semula perenggan pertama menggunakan penalaan segera.

Antara model ini, QL dan BM25 ialah model panggil semula jarang, dan model lain ialah model ingat semula padat. Kami menggunakan penunjuk biasa seperti MRR dan Recall untuk menilai prestasi model ini Keputusan percubaan ditunjukkan dalam jadual berikut:

Rajah 6: Prestasi Perenggan model panggil balik pada set ujian

Daripada keputusan eksperimen, dapat dilihat bahawa berbanding dengan model ranking jarang tradisional, perolehan padat model telah mencapai prestasi yang lebih baik. Pada masa yang sama, pengenalan contoh sukar-ke-negatif juga membantu untuk meningkatkan prestasi model. Perlu dinyatakan bahawa prestasi penarikan semula model eksperimen ini pada set data kami adalah lebih teruk daripada set data lain Sebagai contoh, Recall@50 BM25 pada set data kami ialah 0.492, manakala dalam MS-Marco dan Dureader_retrieval Di atas ialah 0.601 dan 0.700. . Ini mungkin disebabkan oleh fakta bahawa kami mempunyai lebih banyak perenggan yang telah diberi anotasi secara manual Dalam set ujian, kami mempunyai purata 4.74 dokumen yang berkaitan bagi setiap istilah pertanyaan, yang menjadikan tugas penarikan semula lebih mencabar dan mengurangkan negatif palsu pada tahap tertentu. masalah . Ini juga menunjukkan bahawa T2Ranking ialah set data penanda aras yang mencabar dan mempunyai ruang besar untuk penambahbaikan untuk model penarikan semula masa hadapan.

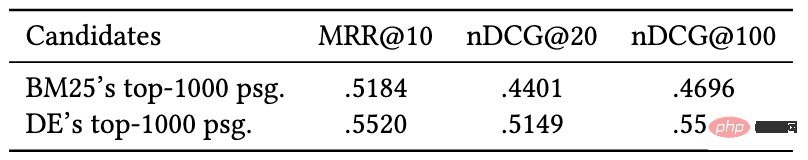

2) Percubaan penyusunan semula perenggan

Berbanding dengan peringkat ingat semula perenggan, peringkat penyusunan semula perlu dipertimbangkan Saiz perenggan adalah kecil, jadi kebanyakan kaedah cenderung menggunakan pengekod interaktif (Cross-Encoder) sebagai rangka kerja model Dalam kerja ini, kami menguji prestasi model pengekod interaktif pada tugas penyusunan semula perenggan indeks penilaian, keputusan eksperimen adalah seperti berikut:

Rajah 7: Pengekod interaktif pada tugas menyusun semula perenggan Prestasi

Hasil eksperimen menunjukkan penyusunan semula berdasarkan perenggan yang dipanggil semula oleh Dual-Encoder adalah lebih berkesan daripada penyusunan semula berdasarkan perenggan yang dipanggil semula oleh BM25 Ia boleh mencapai hasil yang lebih baik , yang konsisten dengan kesimpulan eksperimen kerja sedia ada. Sama seperti eksperimen penarikan balik, prestasi model penarafan semula pada set data kami adalah lebih teruk daripada set data lain, yang mungkin disebabkan oleh anotasi terperinci dan kepelbagaian kata pertanyaan yang lebih tinggi bagi set data kami, dan seterusnya Ia menggambarkan set data kami. adalah mencabar dan boleh mencerminkan prestasi model dengan lebih tepat.

Pengenalan kepada pasukan pelepas set data

Set data dikeluarkan bersama oleh Kumpulan Penyelidikan Pencarian Maklumat (THUIR) Jabatan Sains Komputer Universiti Tsinghua dan Pusat Teknologi Carian Pelayar QQ pasukan Tencent telah diluluskan oleh Universiti Tsinghua Tian Disokong oleh Institut Pengkomputeran Kecerdasan Buatan. Kumpulan penyelidikan THUIR memberi tumpuan kepada penyelidikan mengenai kaedah carian dan pengesyoran, dan telah mencapai keputusan tipikal dalam pemodelan tingkah laku pengguna dan kaedah pembelajaran yang boleh dijelaskan termasuk Anugerah Kertas Terbaik WSDM2022, Anugerah Pencalonan Kertas Terbaik SIGIR2020 dan Anugerah Kertas Terbaik CIKM2018 telah memenangi beberapa anugerah akademik termasuk 2020 Persatuan Maklumat Cina "Anugerah Sains dan Teknologi Pemprosesan Maklumat Cina Qian Weichang" hadiah pertama. Pasukan Pusat Teknologi Carian Pelayar QQ ialah pasukan yang bertanggungjawab untuk penyelidikan dan pembangunan teknologi carian dalam platform maklumat dan talian perkhidmatan PCG Tencent Bergantung pada ekosistem kandungan Tencent dan memacu inovasi produk melalui penyelidikan pengguna, ia menyediakan pengguna dengan grafik, maklumat, novel, panjang. dan video pendek, perkhidmatan, dsb. Keperluan maklumat orientasi dipenuhi.

Atas ialah kandungan terperinci Set data penanda aras pengisihan perenggan Cina yang dikeluarkan: berdasarkan 300,000 pertanyaan sebenar dan 2 juta perenggan Internet.. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

Gunakan ddrescue untuk memulihkan data pada Linux

Mar 20, 2024 pm 01:37 PM

Gunakan ddrescue untuk memulihkan data pada Linux

Mar 20, 2024 pm 01:37 PM

DDREASE ialah alat untuk memulihkan data daripada fail atau peranti sekat seperti cakera keras, SSD, cakera RAM, CD, DVD dan peranti storan USB. Ia menyalin data dari satu peranti blok ke peranti lain, meninggalkan blok data yang rosak dan hanya memindahkan blok data yang baik. ddreasue ialah alat pemulihan yang berkuasa yang automatik sepenuhnya kerana ia tidak memerlukan sebarang gangguan semasa operasi pemulihan. Selain itu, terima kasih kepada fail peta ddasue, ia boleh dihentikan dan disambung semula pada bila-bila masa. Ciri-ciri utama lain DDREASE adalah seperti berikut: Ia tidak menimpa data yang dipulihkan tetapi mengisi jurang sekiranya pemulihan berulang. Walau bagaimanapun, ia boleh dipotong jika alat itu diarahkan untuk melakukannya secara eksplisit. Pulihkan data daripada berbilang fail atau blok kepada satu

Sumber terbuka! Di luar ZoeDepth! DepthFM: Anggaran kedalaman monokular yang cepat dan tepat!

Apr 03, 2024 pm 12:04 PM

Sumber terbuka! Di luar ZoeDepth! DepthFM: Anggaran kedalaman monokular yang cepat dan tepat!

Apr 03, 2024 pm 12:04 PM

0. Apakah fungsi artikel ini? Kami mencadangkan DepthFM: model anggaran kedalaman monokular generatif yang serba boleh dan pantas. Sebagai tambahan kepada tugas anggaran kedalaman tradisional, DepthFM juga menunjukkan keupayaan terkini dalam tugas hiliran seperti mengecat kedalaman. DepthFM cekap dan boleh mensintesis peta kedalaman dalam beberapa langkah inferens. Mari kita baca karya ini bersama-sama ~ 1. Tajuk maklumat kertas: DepthFM: FastMonocularDepthEstimationwithFlowMatching Pengarang: MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Cara menggunakan fungsi penapis Excel dengan berbilang syarat

Feb 26, 2024 am 10:19 AM

Cara menggunakan fungsi penapis Excel dengan berbilang syarat

Feb 26, 2024 am 10:19 AM

Jika anda perlu tahu cara menggunakan penapisan dengan berbilang kriteria dalam Excel, tutorial berikut akan membimbing anda melalui langkah-langkah untuk memastikan anda boleh menapis dan mengisih data anda dengan berkesan. Fungsi penapisan Excel sangat berkuasa dan boleh membantu anda mengekstrak maklumat yang anda perlukan daripada sejumlah besar data. Fungsi ini boleh menapis data mengikut syarat yang anda tetapkan dan memaparkan hanya bahagian yang memenuhi syarat, menjadikan pengurusan data lebih cekap. Dengan menggunakan fungsi penapis, anda boleh mencari data sasaran dengan cepat, menjimatkan masa dalam mencari dan menyusun data. Fungsi ini bukan sahaja boleh digunakan pada senarai data ringkas, tetapi juga boleh ditapis berdasarkan berbilang syarat untuk membantu anda mencari maklumat yang anda perlukan dengan lebih tepat. Secara keseluruhan, fungsi penapisan Excel adalah sangat berguna

Google gembira: prestasi JAX mengatasi Pytorch dan TensorFlow! Ia mungkin menjadi pilihan terpantas untuk latihan inferens GPU

Apr 01, 2024 pm 07:46 PM

Google gembira: prestasi JAX mengatasi Pytorch dan TensorFlow! Ia mungkin menjadi pilihan terpantas untuk latihan inferens GPU

Apr 01, 2024 pm 07:46 PM

Prestasi JAX, yang dipromosikan oleh Google, telah mengatasi Pytorch dan TensorFlow dalam ujian penanda aras baru-baru ini, menduduki tempat pertama dalam 7 penunjuk. Dan ujian tidak dilakukan pada TPU dengan prestasi JAX terbaik. Walaupun dalam kalangan pembangun, Pytorch masih lebih popular daripada Tensorflow. Tetapi pada masa hadapan, mungkin lebih banyak model besar akan dilatih dan dijalankan berdasarkan platform JAX. Model Baru-baru ini, pasukan Keras menanda aras tiga hujung belakang (TensorFlow, JAX, PyTorch) dengan pelaksanaan PyTorch asli dan Keras2 dengan TensorFlow. Pertama, mereka memilih satu set arus perdana

Kelajuan Internet Data Selular Perlahan pada iPhone: Pembetulan

May 03, 2024 pm 09:01 PM

Kelajuan Internet Data Selular Perlahan pada iPhone: Pembetulan

May 03, 2024 pm 09:01 PM

Menghadapi ketinggalan, sambungan data mudah alih perlahan pada iPhone? Biasanya, kekuatan internet selular pada telefon anda bergantung pada beberapa faktor seperti rantau, jenis rangkaian selular, jenis perayauan, dsb. Terdapat beberapa perkara yang boleh anda lakukan untuk mendapatkan sambungan Internet selular yang lebih pantas dan boleh dipercayai. Betulkan 1 – Paksa Mulakan Semula iPhone Kadangkala, paksa memulakan semula peranti anda hanya menetapkan semula banyak perkara, termasuk sambungan selular. Langkah 1 – Hanya tekan kekunci naikkan kelantangan sekali dan lepaskan. Seterusnya, tekan kekunci Turun Kelantangan dan lepaskannya semula. Langkah 2 - Bahagian seterusnya proses adalah untuk menahan butang di sebelah kanan. Biarkan iPhone selesai dimulakan semula. Dayakan data selular dan semak kelajuan rangkaian. Semak semula Betulkan 2 – Tukar mod data Walaupun 5G menawarkan kelajuan rangkaian yang lebih baik, ia berfungsi lebih baik apabila isyarat lemah

Daya hidup kecerdasan super membangkitkan! Tetapi dengan kedatangan AI yang mengemas kini sendiri, ibu tidak perlu lagi bimbang tentang kesesakan data

Apr 29, 2024 pm 06:55 PM

Daya hidup kecerdasan super membangkitkan! Tetapi dengan kedatangan AI yang mengemas kini sendiri, ibu tidak perlu lagi bimbang tentang kesesakan data

Apr 29, 2024 pm 06:55 PM

Saya menangis hingga mati. Dunia sedang membina model besar. Data di Internet tidak mencukupi. Model latihan kelihatan seperti "The Hunger Games", dan penyelidik AI di seluruh dunia bimbang tentang cara memberi makan data ini kepada pemakan yang rakus. Masalah ini amat ketara dalam tugas berbilang modal. Pada masa mereka mengalami kerugian, pasukan pemula dari Jabatan Universiti Renmin China menggunakan model baharu mereka sendiri untuk menjadi yang pertama di China untuk menjadikan "suapan data yang dijana model itu sendiri" menjadi kenyataan. Selain itu, ia merupakan pendekatan serampang dua mata dari segi pemahaman dan sisi penjanaan Kedua-dua pihak boleh menjana data baharu berbilang modal yang berkualiti tinggi dan memberikan maklum balas data kepada model itu sendiri. Apakah model? Awaker 1.0, model berbilang modal besar yang baru sahaja muncul di Forum Zhongguancun. Siapa pasukan itu? Enjin Sophon. Diasaskan oleh Gao Yizhao, pelajar kedoktoran di Sekolah Kecerdasan Buatan Hillhouse Universiti Renmin.

Robot Tesla bekerja di kilang, Musk: Tahap kebebasan tangan akan mencapai 22 tahun ini!

May 06, 2024 pm 04:13 PM

Robot Tesla bekerja di kilang, Musk: Tahap kebebasan tangan akan mencapai 22 tahun ini!

May 06, 2024 pm 04:13 PM

Video terbaru robot Tesla Optimus dikeluarkan, dan ia sudah boleh berfungsi di kilang. Pada kelajuan biasa, ia mengisih bateri (bateri 4680 Tesla) seperti ini: Pegawai itu juga mengeluarkan rupanya pada kelajuan 20x - pada "stesen kerja" kecil, memilih dan memilih dan memilih: Kali ini ia dikeluarkan Salah satu sorotan video itu ialah Optimus menyelesaikan kerja ini di kilang, sepenuhnya secara autonomi, tanpa campur tangan manusia sepanjang proses. Dan dari perspektif Optimus, ia juga boleh mengambil dan meletakkan bateri yang bengkok, memfokuskan pada pembetulan ralat automatik: Berkenaan tangan Optimus, saintis NVIDIA Jim Fan memberikan penilaian yang tinggi: Tangan Optimus adalah robot lima jari di dunia paling cerdik. Tangannya bukan sahaja boleh disentuh

Robot pertama yang menyelesaikan tugas manusia secara autonomi muncul, dengan lima jari fleksibel dan kelajuan manusia luar biasa, dan model besar menyokong latihan angkasa maya

Mar 11, 2024 pm 12:10 PM

Robot pertama yang menyelesaikan tugas manusia secara autonomi muncul, dengan lima jari fleksibel dan kelajuan manusia luar biasa, dan model besar menyokong latihan angkasa maya

Mar 11, 2024 pm 12:10 PM

Minggu ini, FigureAI, sebuah syarikat robotik yang dilaburkan oleh OpenAI, Microsoft, Bezos, dan Nvidia, mengumumkan bahawa ia telah menerima hampir $700 juta dalam pembiayaan dan merancang untuk membangunkan robot humanoid yang boleh berjalan secara bebas dalam tahun hadapan. Dan Optimus Prime Tesla telah berulang kali menerima berita baik. Tiada siapa yang meragui bahawa tahun ini akan menjadi tahun apabila robot humanoid meletup. SanctuaryAI, sebuah syarikat robotik yang berpangkalan di Kanada, baru-baru ini mengeluarkan robot humanoid baharu, Phoenix. Pegawai mendakwa bahawa ia boleh menyelesaikan banyak tugas secara autonomi pada kelajuan yang sama seperti manusia. Pheonix, robot pertama di dunia yang boleh menyelesaikan tugas secara autonomi pada kelajuan manusia, boleh mencengkam, menggerakkan dan meletakkan setiap objek secara elegan di sisi kiri dan kanannya dengan perlahan. Ia boleh mengenal pasti objek secara autonomi