Artikel ini diterbitkan semula daripada Lei Feng.com Jika anda perlu mencetak semula, sila pergi ke tapak web rasmi Lei Feng.com untuk memohon kebenaran.

Cerebras, sebuah syarikat yang terkenal kerana mencipta cip pemecut terbesar di dunia CS-2 Wafer Scale Engine, mengumumkan semalam bahawa mereka telah mengambil langkah penting dalam menggunakan "teras gergasi" untuk latihan kecerdasan buatan. Syarikat itu telah melatih model AI NLP (pemprosesan bahasa semula jadi) terbesar di dunia pada satu cip.

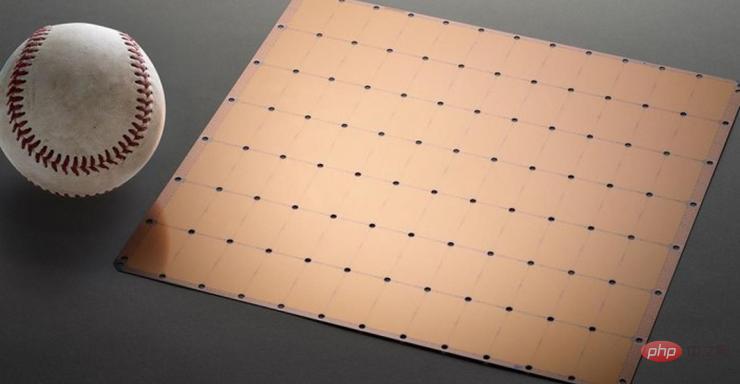

Model ini mempunyai 2 bilion parameter dan dilatih pada cip CS-2. Cip pemecut terbesar di dunia menggunakan proses 7nm dan terukir daripada wafer persegi. Ia beratus kali lebih besar daripada cip arus perdana dan mempunyai kuasa 15KW. Ia menyepadukan 2.6 trilion transistor 7nm, pakej 850,000 teras dan 40GB memori.

Rajah 1 Cip Enjin Skala Wafer CS-2

Pembangunan model NLP merupakan bidang penting dalam kecerdasan buatan. Menggunakan model NLP, kecerdasan buatan boleh "memahami" maksud teks dan mengambil tindakan yang sepadan. Model DALL.E OpenAI ialah model NLP biasa. Model ini boleh menukar input maklumat teks oleh pengguna kepada output imej.

Contohnya, apabila pengguna memasuki "kerusi berlengan berbentuk alpukat", AI secara automatik akan menjana beberapa imej yang sepadan dengan ayat ini.

Gambar: Gambar "kerusi berlengan berbentuk alpukat" yang dijana oleh AI selepas menerima maklumat

Lebih daripada sekadar Selain itu, model ini juga boleh membolehkan AI memahami pengetahuan yang kompleks seperti spesies, geometri dan era sejarah.

Tetapi bukan mudah untuk mencapai semua ini Pembangunan tradisional model NLP mempunyai kos kuasa pengkomputeran yang sangat tinggi dan ambang teknikal.

Malah, jika kita hanya membincangkan nombor, 2 bilion parameter model yang dibangunkan oleh Cerebras kelihatan agak biasa-biasa sahaja berbanding dengan rakan sebayanya.

Model DALL.E yang dinyatakan sebelum ini mempunyai 12 bilion parameter, dan model terbesar pada masa ini ialah Gopher, yang dilancarkan oleh DeepMind pada penghujung tahun lepas, dengan 280 bilion parameter.

Tetapi selain daripada jumlah yang mengejutkan, NLP yang dibangunkan oleh Cerebras mempunyai kejayaan besar: ia mengurangkan kesukaran membangunkan model NLP.

Menurut proses tradisional, membangunkan model NLP memerlukan pembangun membahagikan model NLP yang besar kepada beberapa bahagian berfungsi dan menyebarkan beban kerja mereka merentasi ratusan atau ribuan unit pemprosesan grafik.

Beribu-ribu unit pemprosesan grafik bermakna kos yang besar untuk pengeluar.

Kesukaran teknikal juga menyebabkan pengilang sengsara.

Model penghirisan ialah masalah tersuai, spesifikasi setiap rangkaian saraf, setiap GPU dan rangkaian yang menghubungkan (atau menyambung) mereka bersama-sama adalah unik dan tidak mudah alih merentas sistem.

Pengilang mesti mempertimbangkan semua faktor ini dengan jelas sebelum latihan pertama.

Kerja ini sangat kompleks dan kadangkala mengambil masa berbulan-bulan untuk disiapkan.

Cerebras berkata ini adalah "salah satu aspek yang paling menyakitkan" dalam latihan model NLP. Hanya segelintir syarikat yang mempunyai sumber dan kepakaran yang diperlukan untuk membangunkan NLP. Bagi syarikat lain dalam industri AI, latihan NLP terlalu mahal, memakan masa dan tidak tersedia.

Tetapi jika satu cip boleh menyokong model dengan 2 bilion parameter, ini bermakna tidak perlu menggunakan GPU besar-besaran untuk menyebarkan beban kerja melatih model. Ini boleh menjimatkan beribu-ribu kos latihan GPU dan keperluan perkakasan serta penskalaan yang berkaitan. Ia juga menyelamatkan vendor daripada terpaksa melalui kesakitan menghiris model dan mengagihkan beban kerja mereka merentasi ribuan GPU.

Serebral bukan sahaja taksub dengan nombor Untuk menilai kualiti model, bilangan parameter bukanlah satu-satunya kriteria.

Daripada mengharapkan "kerja keras" model yang dilahirkan pada "teras gergasi", Cerebras berharap model itu akan menjadi "pintar".

Sebab mengapa Cerebras telah dapat mencapai pertumbuhan eksplosif dalam bilangan parameter adalah kerana ia menggunakan teknologi aliran berwajaran. Teknologi ini memisahkan jejak pengiraan dan memori dan membolehkan memori dikembangkan menjadi cukup besar untuk menyimpan sebarang bilangan parameter yang meningkatkan beban kerja AI.

Terima kasih kepada kejayaan ini, masa untuk menyediakan model telah dikurangkan dari beberapa bulan kepada beberapa minit. Dan pembangun boleh bertukar antara model seperti GPT-J dan GPT-Neo dengan "hanya beberapa ketukan kekunci." Ini menjadikan pembangunan NLP lebih mudah.

Ini telah membawa perubahan baharu dalam bidang NLP.

Ketika Dan Olds, Ketua Pegawai Penyelidik Intersect360 Research, mengulas tentang pencapaian Cerebras: “Keupayaan Cerebras untuk membawa model bahasa yang besar kepada orang ramai dengan cara yang kos efektif dan mudah diakses membuka masa depan yang menarik untuk kecerdasan buatan ”

Atas ialah kandungan terperinci Cip AI terbesar di dunia memecahkan rekod latihan peranti tunggal model besar, Cerebras mahu 'membunuh' GPU. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!