Risiko Menggunakan Chatbots Dikuasakan AI dalam Perusahaan

Sejak ChatGPT dilancarkan secara rasmi pada November 2022, berjuta-juta pengguna telah melimpah ruah. Disebabkan keupayaan penjanaan bahasa seperti manusia yang sangat baik, bakat perisian pengaturcaraan, dan keupayaan analisis teks sepantas kilat, ChatGPT dengan cepat telah menjadi alat pilihan untuk pembangun, penyelidik dan pengguna harian.

Seperti mana-mana teknologi yang mengganggu, sistem AI generatif seperti ChatGPT juga mempunyai potensi risiko. Khususnya, pemain utama dalam industri teknologi, agensi perisikan negara, dan agensi kerajaan lain telah mengeluarkan amaran tentang memberi maklumat sensitif ke dalam sistem kecerdasan buatan seperti ChatGPT.

Kebimbangan tentang risiko keselamatan ChatGPT berpunca daripada kemungkinan bahawa maklumat akhirnya boleh bocor ke domain awam melalui ChatGPT, sama ada melalui kelemahan keselamatan atau penggunaan kandungan yang dijana pengguna untuk "melatih" chatbot.

Sebagai tindak balas kepada kebimbangan ini, syarikat teknologi mengambil tindakan untuk mengurangkan risiko keselamatan yang dikaitkan dengan model bahasa besar (LLM) dan AI perbualan (CAI). Sesetengah perniagaan telah memilih untuk melumpuhkan ChatGPT sepenuhnya, sementara yang lain memberi amaran kepada pekerja mereka tentang bahaya memasukkan data sulit ke dalam model sedemikian.

ChatGPT: AI terbuka yang menakutkan?

ChatGPT dipacu AI telah menjadi alat popular untuk perusahaan mengoptimumkan operasi dan memudahkan tugas yang rumit. Walau bagaimanapun, peristiwa baru-baru ini telah menyerlahkan potensi bahaya berkongsi maklumat sulit melalui platform.

Lebih membimbangkan, tiga insiden kebocoran data sensitif melalui ChatGPT telah dilaporkan dalam masa kurang daripada sebulan. Media Korea Selatan melaporkan bahawa pekerja di pembuat telefon pintar kilang semikonduktor utama Samsung memasukkan maklumat sulit, termasuk kod sumber yang sangat sensitif yang digunakan untuk menyelesaikan ralat pengaturcaraan, ke dalam chatbot kecerdasan buatan, mencetuskan kontroversi.

Kod sumber ialah salah satu rahsia yang paling dijaga rapi bagi mana-mana syarikat teknologi, kerana ia merupakan blok asas bagi mana-mana perisian atau sistem pengendalian. Dan kini, rahsia perniagaan yang begitu berharga secara tidak sengaja telah jatuh ke tangan OpenAI.

Menurut orang yang biasa dengan perkara itu, Samsung pada masa ini telah mengehadkan akses pekerjanya kepada ChatGPT.

Konglomerat Fortune 500 yang lain, termasuk Amazon, Walmart dan JPMorgan, telah mengalami situasi yang sama di mana pekerja secara tidak sengaja memasukkan data sensitif ke dalam chatbots.

Terdapat laporan sebelum ini mengenai pekerja Amazon menggunakan ChatGPT untuk mendapatkan maklumat pelanggan sulit, mendorong gergasi teknologi itu untuk mengehadkan penggunaan alat dengan cepat dan memberi amaran tegas kepada pekerja supaya tidak memasukkan sebarang data sensitif ke dalam alat tersebut.

Model “Tidak Sempurna”: asas pengetahuan kurang kecerdasan

Mathieu Fortier, pengarah pembelajaran mesin di Coveo, platform pengalaman digital dipacu AI, berkata berbilang LLM seperti GPT-4 dan LLaMA wujud Tidak sempurna, dan memberi amaran bahawa walaupun mereka cemerlang dalam pemahaman bahasa, model ini tidak mempunyai keupayaan untuk mengenali ketepatan, undang-undang yang tidak berubah, realiti fizikal dan aspek bukan linguistik yang lain.

Walaupun LLM membina asas pengetahuan intrinsik yang luas daripada data latihan, mereka tidak mempunyai konsep kebenaran atau ketepatan fakta yang jelas. Selain itu, mereka terdedah kepada pelanggaran keselamatan dan serangan pengekstrakan data, serta cenderung untuk menyimpang daripada respons yang dijangkakan atau mempamerkan ciri "psikotik" - nama teknikalnya ialah "halusinasi".

Fortier menyerlahkan risiko tinggi yang dihadapi oleh perniagaan. Akibatnya boleh menjejaskan kepercayaan pelanggan dengan teruk dan menyebabkan kerosakan yang tidak boleh diperbaiki kepada reputasi jenama, yang membawa kepada masalah undang-undang dan kewangan yang ketara.

Mengikuti jejak langkah gergasi teknologi lain, cabang teknologi gergasi runcit itu, teknologi Walmart Global, telah mengambil langkah untuk mengurangkan risiko pelanggaran data. Dalam memo dalaman kepada pekerja, syarikat mengarahkan pekerja untuk menyekat ChatGPT serta-merta selepas mengesan aktiviti mencurigakan yang boleh menjejaskan data korporat dan keselamatan.

Jurucakap Walmart berkata semasa peruncit mencipta chatbot sendiri berdasarkan keupayaan GPT-4, ia telah melaksanakan beberapa langkah untuk melindungi data pekerja dan pelanggan daripada penyebaran alat AI Generatif ChatGPT dan lain-lain.

Jurucakap itu berkata, "Kebanyakan teknologi baharu membawa faedah baharu, tetapi juga risiko baharu. Oleh itu, kami akan menilai teknologi baharu ini dan menyediakan panduan penggunaan untuk pekerja kami untuk Melindungi data pelanggan kami adalah perkara biasa, ahli, dan pekerja dengan memanfaatkan teknologi sedia ada, seperti Open AI, dan membina lapisan di atasnya untuk berkomunikasi dengan peruncit dengan lebih berkesan, membolehkan kami membangunkan pengalaman pelanggan baharu dan meningkatkan keupayaan sedia ada.”

Selain itu, syarikat lain seperti Verizon dan Accenture juga telah mengambil langkah untuk mengehadkan penggunaan ChatGPT, dengan Verizon mengarahkan pekerjanya untuk mengehadkan chatbots kepada tugas yang tidak sensitif, dan kawalan Accenture yang lebih ketat telah dilaksanakan untuk memastikan pematuhan terhadap peraturan privasi data .

Cara ChatGPT menggunakan data sesi

Lebih membimbangkan, ChatGPT mengekalkan data input pengguna untuk terus melatih model, menimbulkan kebimbangan bahawa maklumat sensitif mungkin terdedah melalui pelanggaran data atau masalah insiden keselamatan lain.

OpenAI, syarikat di sebalik model kecerdasan buatan generatif yang popular ChatGPT dan DALL-E, baru-baru ini melaksanakan dasar baharu untuk meningkatkan privasi dan keselamatan data pengguna.

Mulai 1 Mac tahun ini, pengguna API mesti secara jelas memilih untuk berkongsi data mereka untuk melatih atau menambah baik model OpenAI.

Sebaliknya, untuk perkhidmatan bukan API seperti ChatGPT dan DALL-E, pengguna mesti menarik diri jika mereka tidak mahu data mereka digunakan oleh OpenAI.

OpenAI menyatakan dalam blog yang dikemas kini baru-baru ini, “Apabila anda menggunakan perkhidmatan pengguna bukan API kami ChatGPT atau DALL-E, kami mungkin menggunakan data yang anda berikan untuk menambah baik model kami Dengan kami Berkongsi data anda bukan sahaja membantu model kami menjadi lebih tepat dan menyelesaikan masalah khusus anda dengan lebih baik, ia juga membantu meningkatkan keupayaan dan keselamatan keseluruhan mereka... Anda boleh mengisi ID Organisasi dan alamat e-mel anda yang dikaitkan dengan pemilik akaun untuk meminta menarik diri daripada penggunaan data untuk menambah baik perkhidmatan bukan API kami."

Kenyataan ini dibuat sebagai tindak balas kepada kebimbangan mengenai risiko yang diterangkan di atas dan sensitiviti pengendalian syarikat terhadap perkara ini. Maklumat dikeluarkan dengan berhati-hati. Kerajaan Itali baru-baru ini menyertai pergaduhan itu, melarang penggunaan ChatGPT di seluruh negara, memetik kebimbangan mengenai privasi dan keselamatan data.

OpenAI mengatakan ia mengalih keluar sebarang maklumat yang boleh dikenal pasti secara peribadi daripada data yang digunakan untuk menambah baik model kecerdasan buatannya dan hanya menggunakan sampel kecil data daripada setiap pelanggan untuk tujuan ini.

Amaran Kerajaan

Agensi perisikan Ibu Pejabat Komunikasi Kerajaan UK (GCHQ), melalui Pusat Keselamatan Siber Nasional (NCSC), telah mengeluarkan laporan mengenai batasan dan risiko Model Bahasa Besar (LLM) seperti amaran ChatGPT. Walaupun model ini telah dipuji kerana keupayaan pemprosesan bahasa semula jadi yang mengagumkan, NCSC memberi amaran bahawa ia tidak sempurna dan mungkin mengandungi kelemahan yang serius.

Menurut NCSC, LLM boleh menjana fakta yang salah atau "ilusi", seperti yang ditunjukkan oleh demonstrasi pertama bot sembang Google Bard. Mereka juga boleh memaparkan berat sebelah dan mudah tertipu, terutamanya apabila menjawab soalan utama. Selain itu, model ini memerlukan sumber pengkomputeran yang luas dan sejumlah besar data untuk dilatih dari awal, dan model ini terdedah kepada serangan suntikan dan penciptaan kandungan toksik.

Coveo's Fortier berkata, "LLM menjana respons kepada gesaan berdasarkan persamaan sedia ada gesaan dengan pengetahuan dalaman Walau bagaimanapun, memandangkan mereka tidak mempunyai 'peraturan keras' dalaman atau keupayaan Inferens, mereka tidak boleh 100% berjaya dalam. mematuhi kekangan untuk tidak mendedahkan maklumat sensitif Walaupun terdapat usaha untuk mengurangkan penjanaan maklumat sensitif, jika LLM menggunakan data ini untuk latihan, satu-satunya penyelesaian adalah untuk tidak menggunakan bahan sensitif untuk melatih model ini memberikan mereka maklumat sensitif dalam gesaan, kerana kebanyakan perkhidmatan pada masa ini menyimpan maklumat ini dalam log mereka ”

Amalan Terbaik Keselamatan dan Etika AI Generatif

Memandangkan perniagaan terus menggunakan kecerdasan buatan dan teknologi baru muncul yang lain, memastikan langkah keselamatan yang sesuai untuk melindungi data sensitif dan mencegah pendedahan maklumat sulit secara tidak sengaja akan menjadi kritikal.

Tindakan yang diambil oleh syarikat-syarikat ini menyerlahkan kepentingan untuk terus berwaspada apabila menggunakan model bahasa kecerdasan buatan seperti ChatGPT. Walaupun alat ini boleh meningkatkan kecekapan dan produktiviti dengan banyak, ia boleh menimbulkan risiko yang ketara jika digunakan secara tidak betul.

Peter Relan, pengerusi permulaan kecerdasan buatan perbualan Got it AI, mencadangkan bahawa "pendekatan terbaik adalah untuk menggabungkan setiap perkembangan baharu dalam penambahbaikan asal model bahasa ke dalam seni bina yang dipacu strategi perusahaan. Seni bina menggabungkan a model bahasa dengan pra-dan pasca-pemproses untuk menjaga, memperhalusinya untuk data khusus perusahaan, dan kemudian menggunakannya secara setempat Jika tidak, model bahasa asal kadangkala terlalu berkuasa "

Prasanna Arikala, CTO platform AI perbualan yang disokong Nvidia Kore.ai, berkata bahawa pada masa hadapan, adalah perlu bagi syarikat untuk menyekat akses LLM kepada maklumat sensitif dan peribadi untuk mengelakkan pelanggaran.

Arikala menyatakan bahawa “melaksanakan kawalan akses yang ketat, seperti pengesahan berbilang faktor, dan menyulitkan data sensitif, boleh membantu mengurangkan risiko ini Selain itu, audit keselamatan dan penilaian kerentanan yang kerap diperlukan untuk mengenal pasti dan Menghapuskan potensi kelemahan. . LLM ialah alat yang berharga jika digunakan dengan betul, tetapi amat penting bagi syarikat untuk mengambil langkah berjaga-jaga yang diperlukan untuk melindungi data sensitif dan mengekalkan kepercayaan pelanggan dan pihak berkepentingan ”

Bagaimana peraturan ini akan berkembang masih perlu dilihat , tetapi perniagaan mesti sentiasa berwaspada untuk terus berada di hadapan. Walaupun AI generatif membawa potensi manfaat, ia juga membawa tanggungjawab dan cabaran baharu, dan industri teknologi perlu bekerjasama dengan penggubal dasar untuk memastikan teknologi ini dibangunkan dan dilaksanakan dengan cara yang bertanggungjawab dan beretika.

Atas ialah kandungan terperinci Risiko Menggunakan Chatbots Dikuasakan AI dalam Perusahaan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1359

1359

52

52

ChatGPT kini membenarkan pengguna percuma menjana imej dengan menggunakan DALL-E 3 dengan had harian

Aug 09, 2024 pm 09:37 PM

ChatGPT kini membenarkan pengguna percuma menjana imej dengan menggunakan DALL-E 3 dengan had harian

Aug 09, 2024 pm 09:37 PM

DALL-E 3 telah diperkenalkan secara rasmi pada September 2023 sebagai model yang jauh lebih baik daripada pendahulunya. Ia dianggap sebagai salah satu penjana imej AI terbaik setakat ini, mampu mencipta imej dengan perincian yang rumit. Walau bagaimanapun, semasa pelancaran, ia adalah tidak termasuk

Gabungan sempurna ChatGPT dan Python: mencipta chatbot perkhidmatan pelanggan yang pintar

Oct 27, 2023 pm 06:00 PM

Gabungan sempurna ChatGPT dan Python: mencipta chatbot perkhidmatan pelanggan yang pintar

Oct 27, 2023 pm 06:00 PM

Gabungan sempurna ChatGPT dan Python: Mencipta Perkhidmatan Pelanggan Pintar Chatbot Pengenalan: Dalam era maklumat hari ini, sistem perkhidmatan pelanggan pintar telah menjadi alat komunikasi yang penting antara perusahaan dan pelanggan. Untuk memberikan pengalaman perkhidmatan pelanggan yang lebih baik, banyak syarikat telah mula beralih kepada chatbots untuk menyelesaikan tugas seperti perundingan pelanggan dan menjawab soalan. Dalam artikel ini, kami akan memperkenalkan cara menggunakan bahasa ChatGPT dan Python model OpenAI yang berkuasa untuk mencipta bot sembang perkhidmatan pelanggan yang pintar untuk meningkatkan

Bagaimana untuk memasang chatgpt pada telefon bimbit

Mar 05, 2024 pm 02:31 PM

Bagaimana untuk memasang chatgpt pada telefon bimbit

Mar 05, 2024 pm 02:31 PM

Langkah pemasangan: 1. Muat turun perisian ChatGTP dari laman web rasmi ChatGTP atau kedai mudah alih 2. Selepas membukanya, dalam antara muka tetapan, pilih bahasa sebagai bahasa Cina 3. Dalam antara muka permainan, pilih permainan mesin manusia dan tetapkan Spektrum bahasa Cina; 4 Selepas memulakan, masukkan arahan dalam tetingkap sembang untuk berinteraksi dengan perisian.

Bagaimana untuk membangunkan chatbot pintar menggunakan ChatGPT dan Java

Oct 28, 2023 am 08:54 AM

Bagaimana untuk membangunkan chatbot pintar menggunakan ChatGPT dan Java

Oct 28, 2023 am 08:54 AM

Dalam artikel ini, kami akan memperkenalkan cara membangunkan chatbot pintar menggunakan ChatGPT dan Java, dan menyediakan beberapa contoh kod khusus. ChatGPT ialah versi terkini Generative Pre-training Transformer yang dibangunkan oleh OpenAI, teknologi kecerdasan buatan berasaskan rangkaian saraf yang boleh memahami bahasa semula jadi dan menjana teks seperti manusia. Menggunakan ChatGPT kami boleh membuat sembang adaptif dengan mudah

Bolehkah chatgpt digunakan di China?

Mar 05, 2024 pm 03:05 PM

Bolehkah chatgpt digunakan di China?

Mar 05, 2024 pm 03:05 PM

chatgpt boleh digunakan di China, tetapi tidak boleh didaftarkan, begitu juga di Hong Kong dan Macao Jika pengguna ingin mendaftar, mereka boleh menggunakan nombor telefon mudah alih asing untuk mendaftar. Perhatikan bahawa semasa proses pendaftaran, persekitaran rangkaian mesti ditukar IP asing.

Bagaimana untuk membina robot perkhidmatan pelanggan pintar menggunakan PHP ChatGPT

Oct 28, 2023 am 09:34 AM

Bagaimana untuk membina robot perkhidmatan pelanggan pintar menggunakan PHP ChatGPT

Oct 28, 2023 am 09:34 AM

Cara menggunakan ChatGPTPHP untuk membina robot perkhidmatan pelanggan yang pintar Pengenalan: Dengan perkembangan teknologi kecerdasan buatan, robot semakin digunakan dalam bidang perkhidmatan pelanggan. Menggunakan ChatGPTPHP untuk membina robot perkhidmatan pelanggan yang pintar boleh membantu syarikat menyediakan perkhidmatan pelanggan yang lebih cekap dan diperibadikan. Artikel ini akan memperkenalkan cara menggunakan ChatGPTPHP untuk membina robot perkhidmatan pelanggan yang pintar dan menyediakan contoh kod khusus. 1. Pasang ChatGPTPHP dan gunakan ChatGPTPHP untuk membina robot perkhidmatan pelanggan yang pintar.

Cara menggunakan ChatGPT dan Python untuk melaksanakan fungsi pengecaman niat pengguna

Oct 27, 2023 am 09:04 AM

Cara menggunakan ChatGPT dan Python untuk melaksanakan fungsi pengecaman niat pengguna

Oct 27, 2023 am 09:04 AM

Cara menggunakan ChatGPT dan Python untuk melaksanakan fungsi pengecaman niat pengguna Pengenalan: Dalam era digital hari ini, teknologi kecerdasan buatan secara beransur-ansur menjadi bahagian yang amat diperlukan dalam pelbagai bidang. Antaranya, pembangunan teknologi pemprosesan bahasa semula jadi (Natural Language Processing, NLP) membolehkan mesin memahami dan memproses bahasa manusia. ChatGPT (Chat-GeneratingPtrainedTransformer) ialah sejenis

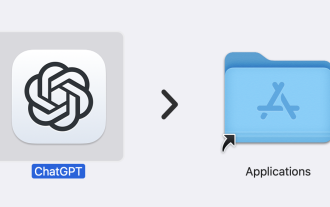

ChatGPT kini tersedia untuk macOS dengan keluaran apl khusus

Jun 27, 2024 am 10:05 AM

ChatGPT kini tersedia untuk macOS dengan keluaran apl khusus

Jun 27, 2024 am 10:05 AM

Aplikasi ChatGPT Mac Buka AI kini tersedia untuk semua orang, telah dihadkan kepada mereka yang mempunyai langganan ChatGPT Plus sahaja untuk beberapa bulan lepas. Apl ini dipasang sama seperti mana-mana apl Mac asli yang lain, selagi anda mempunyai Apple S yang terkini