Peranti teknologi

Peranti teknologi

AI

AI

Terokai teknologi model besar dalam era pasca-GPT 3.0 dan bergerak ke arah merealisasikan masa depan AGI

Terokai teknologi model besar dalam era pasca-GPT 3.0 dan bergerak ke arah merealisasikan masa depan AGI

Terokai teknologi model besar dalam era pasca-GPT 3.0 dan bergerak ke arah merealisasikan masa depan AGI

ChatGPT mengejutkan atau menyedarkan ramai orang selepas kemunculannya. Kejutan itu adalah kerana saya tidak menjangkakan bahawa Model Bahasa Besar (LLM) boleh menjadi seberkesan ini; kebangkitan itu adalah kesedaran secara tiba-tiba bahawa pemahaman kita tentang LLM dan falsafah pembangunannya jauh daripada idea yang paling maju di dunia. Saya tergolong dalam kumpulan yang sama-sama terkejut dan tersedar, dan saya juga orang Cina tipikal yang pandai muhasabah diri, maka mereka mula bermuhasabah, dan artikel ini adalah hasil renungan.

Sejujurnya, dari segi teknologi berkaitan model LLM domestik, pada masa ini, jurang antara teknologi paling canggih dan teknologi domestik semakin melebar. Saya berpendapat isu kepimpinan teknologi atau jurang teknologi harus dilihat secara dinamik dari perspektif pembangunan. Dalam tempoh satu hingga dua tahun selepas kemunculan Bert, sebenarnya, teknologi domestik yang mengejar di kawasan ini masih sangat pantas, dan beberapa model penambahbaikan yang baik juga dicadangkan untuk melebarkan jurang harus selepas keluaran GPT 3.0 , iaitu pada tahun 2020 Sekitar pertengahan tahun. Pada masa itu, hanya segelintir orang yang sedar bahawa GPT 3.0 bukan sekadar teknologi khusus, tetapi sebenarnya merangkumi konsep pembangunan ke mana LLM harus pergi. Sejak itu, jurang itu semakin melebar, dan ChatGPT hanyalah akibat semula jadi daripada perbezaan falsafah pembangunan ini. Oleh itu, saya secara peribadi berpendapat, Mengetepikan faktor sama ada anda mempunyai sumber kewangan untuk membina LLM yang sangat besar, dari perspektif teknikal sahaja, jurang terutamanya datang dari pemahaman LLM dan konsep pembangunan ke mana hendak pergi pada masa hadapan.

China semakin ketinggalan dengan teknologi asing Ini adalah fakta, dan mustahil untuk tidak mengakuinya. Sebentar tadi, ramai orang di Internet bimbang bahawa AI domestik kini berada dalam "peringkat kritikal untuk bertahan hidup." Tidakkah anda nampak, adakah OpenAI satu-satunya syarikat di dunia yang mempunyai visi berpandangan ke hadapan? Termasuk Google, sebenarnya, pemahaman mereka tentang konsep pembangunan LLM jelas berada di belakang OpenAI. Realitinya ialah OpenAI telah menunjukkan prestasi yang terlalu baik dan meninggalkan semua orang, bukan hanya di dalam negara.Saya berpendapat OpenAI mendahului Google dan DeepMind di luar negara dari segi konsep dan teknologi berkaitan untuk LLM kira-kira setengah tahun hingga setahun, dan kira-kira dua tahun mendahului China. Mengenai LLM, saya merasakan bahawa pihak Google sepatutnya berada di tempat kedua yang paling mencerminkan visi teknikal Google ialah PaLM dan Pathways telah dilancarkan antara Februari dan April 2022. Dalam tempoh yang sama, OpenAI telah dilancarkan. Ia adalah InstructGPT Dari sini anda boleh melihat jurang antara Google dan OpenAI Mengenai mengapa saya mengatakan ini, anda mungkin boleh memahaminya selepas membaca teks di belakang saya. Fokus DeepMind sebelum ini adalah untuk mengukuhkan pembelajaran untuk menakluki permainan dan AI untuk sains Ia sebenarnya memasuki LLM sangat lambat Ia sepatutnya mula memberi perhatian kepada arah ini dalam tempoh 21 tahun, dan ia sedang mengejar. Apatah lagi Meta, tumpuannya belum tertumpu pada LLM, dan kini terasa seperti cuba mengejar. Ini masih kumpulan institusi yang melakukan yang terbaik pada masa ini Jika ini berlaku, apatah lagi yang domestik? Saya rasa boleh dimaafkan. Bagi falsafah OpenAI mengenai LLM, saya akan bercakap tentang pemahaman saya di bahagian terakhir artikel ini.

Artikel ini meringkaskan teknologi LLM arus perdana sejak kemunculan GPT 3.0 Anda boleh merujuk kepada arus perdana teknologi sebelum ini "PTM menunggang angin dan ombak, tafsiran mendalam tentang kemajuan model pra-latihan."

Saya percaya bahawa selepas membaca kedua-dua artikel ini, anda boleh memahami konteks teknikal bidang LLM, konsep pembangunan berbeza yang telah muncul dalam proses pembangunan teknologi LLM, dan juga kemungkinan trend pembangunan masa depan Mempunyai pemahaman yang lebih jelas. Sudah tentu, kandungan yang disebutkan di banyak tempat adalah pendapat peribadi saya dan sangat subjektif Ralat dan peninggalan tidak dapat dielakkan, jadi sila rujuk dengan berhati-hati.Artikel ini cuba menjawab beberapa soalan berikut:

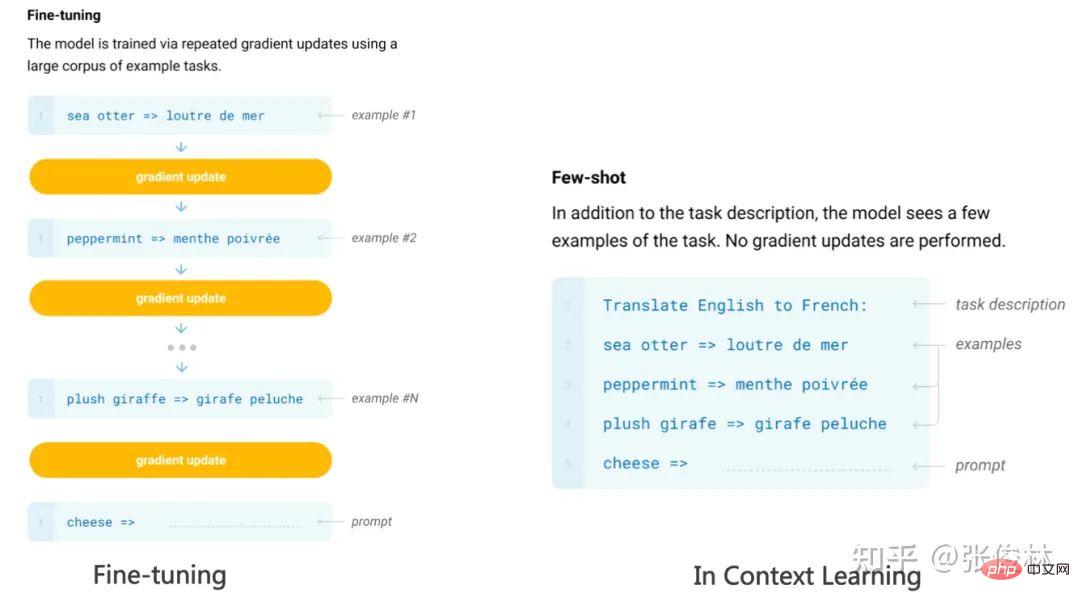

Adakah ChatGPT telah membawa anjakan paradigma penyelidikan dalam bidang NLP dan juga AI? Jika ya, apakah kesannya? Apakah yang LLM pelajari daripada sejumlah besar data? Bagaimanakah LLM mengakses pengetahuan ini? Apabila skala LLM meningkat secara beransur-ansur, apakah kesannya? Apakah Pembelajaran Dalam Konteks Mengapa ia merupakan teknologi yang misteri? Apakah hubungannya dengan Instruct? Adakah LLM mempunyai keupayaan penaakulan? Bagaimanakah Thought Chain CoT berfungsi? Tunggu, saya percaya anda akan mendapat jawapan kepada soalan-soalan ini selepas membacanya.