Peranti teknologi

Peranti teknologi

AI

AI

DeepMind berkata: Model AI perlu menurunkan berat badan, dan autoregresi menjadi trend utama

DeepMind berkata: Model AI perlu menurunkan berat badan, dan autoregresi menjadi trend utama

DeepMind berkata: Model AI perlu menurunkan berat badan, dan autoregresi menjadi trend utama

Program perhatian autoregresif dengan Transformer sebagai teras sentiasa sukar untuk mengatasi kesukaran skala. Untuk tujuan ini, DeepMind/Google baru-baru ini telah menubuhkan projek baharu untuk mencadangkan cara yang baik untuk membantu program sebegini dengan berkesan melangsingkan badan.

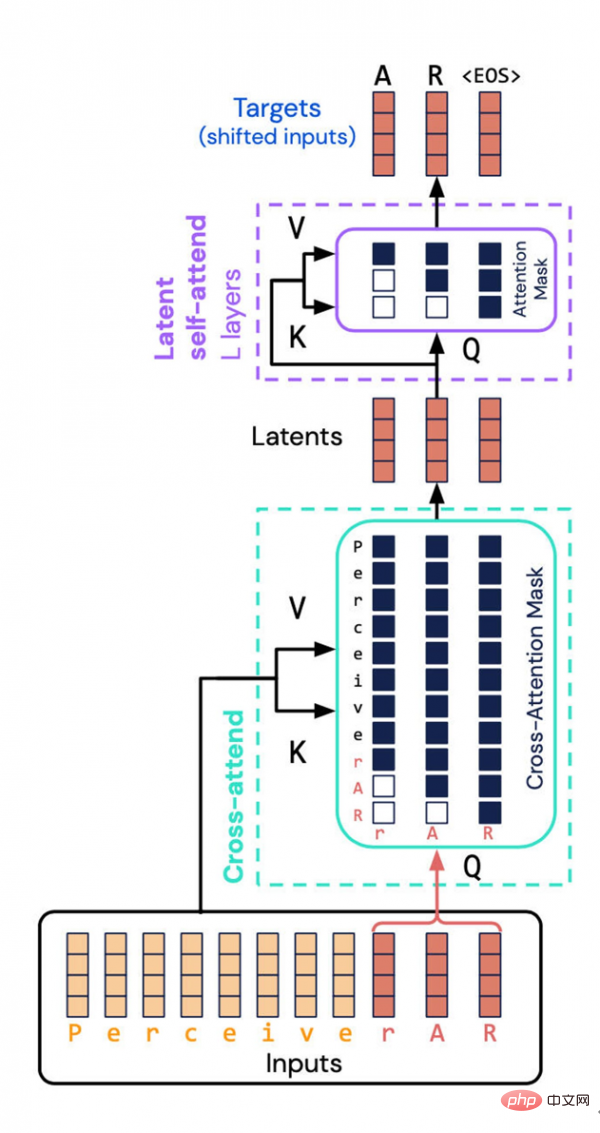

Seni bina Perceiver AR yang dicipta oleh DeepMind dan Google Brain mengelakkan tugasan intensif sumber - mengira gabungan sifat input dan output ke dalam ruang terpendam. Sebaliknya, mereka memperkenalkan "penyamaran sebab" ke dalam ruang terpendam, dengan itu mencapai susunan autoregresif Transformer biasa.

Salah satu trend pembangunan yang paling mengagumkan dalam bidang kecerdasan buatan/pembelajaran mendalam ialah saiz model semakin besar dan besar. Pakar dalam bidang ini mengatakan bahawa memandangkan skala sering dikaitkan secara langsung dengan prestasi, gelombang pengembangan volum ini berkemungkinan berterusan.

Walau bagaimanapun, skala projek semakin besar dan lebih besar, dan sumber yang digunakan secara semula jadi meningkat, yang menyebabkan pembelajaran mendalam menimbulkan isu sosial dan etika baharu. Dilema ini telah menarik perhatian jurnal saintifik arus perdana seperti Nature.

Disebabkan ini, kita mungkin perlu kembali kepada perkataan lama "kecekapan" - program AI Adakah terdapat sebarang ruang untuk peningkatan kecekapan selanjutnya?

Para saintis dari jabatan DeepMind dan Google Brain baru-baru ini telah mengubah suai rangkaian neural Perceiver yang mereka lancarkan tahun lepas, dengan harapan dapat meningkatkan kecekapannya dalam menggunakan sumber pengkomputeran.

Program baharu ini dinamakan Perceiver AR. AR di sini berasal daripada "autoregressive", yang juga merupakan satu lagi hala tuju pembangunan program pembelajaran yang semakin mendalam hari ini. Autoregression ialah teknik yang membolehkan mesin menggunakan output sebagai input baru kepada program Ia adalah operasi rekursif, dengan itu membentuk peta perhatian di mana pelbagai elemen berkaitan antara satu sama lain.

Transformer rangkaian saraf popular yang dilancarkan oleh Google pada 2017 juga mempunyai ciri autoregresif ini. Malah, GPT-3 kemudian dan versi pertama Perceiver meneruskan laluan teknikal autoregresif.

Sebelum Perceiver AR, Perceiver IO, yang dilancarkan pada bulan Mac tahun ini, merupakan versi kedua Perceiver.

Inovasi asal Perceiver adalah menggunakan Transformer dan membuat pelarasan supaya ia boleh menyerap pelbagai input secara fleksibel, termasuk teks, bunyi dan imej, dengan itu melepaskan diri daripada pergantungan pada jenis input tertentu. Ini membolehkan penyelidik membangunkan rangkaian saraf menggunakan pelbagai jenis input.

Sebagai ahli aliran zaman, Perceiver, seperti projek model lain, telah mula menggunakan mekanisme perhatian autoregresif untuk mencampurkan mod input yang berbeza dan domain tugas yang berbeza. Kes penggunaan sedemikian juga termasuk Laluan Google, Gato DeepMind dan data2vec Meta.

Pada bulan Mac tahun ini, Andrew Jaegle, pencipta versi pertama Perceiver, dan pasukan rakan sekerjanya mengeluarkan versi "IO". Versi baharu ini mempertingkatkan jenis output yang disokong oleh Perceiver, membolehkan sejumlah besar output yang mengandungi pelbagai struktur, termasuk bahasa teks, medan aliran optik, urutan audio-visual dan juga set simbol yang tidak tertib, dsb. Perceiver IO malah boleh menjana arahan pengendalian dalam permainan "StarCraft 2".

Dalam kertas terbaharu ini, Perceiver AR telah dapat melaksanakan pemodelan autoregresif am untuk konteks yang panjang. Tetapi semasa penyelidikan, Jaegle dan pasukannya juga menghadapi cabaran baharu: cara menskalakan model apabila menangani pelbagai tugas input dan output berbilang modal.

Masalahnya ialah kualiti autoregresif Transformer, dan mana-mana program yang sama membina peta perhatian input-ke-output, memerlukan saiz pengedaran besar-besaran sehingga ratusan ribu elemen.

Ini adalah kelemahan mematikan mekanisme perhatian. Lebih tepat lagi, segala-galanya perlu diberi perhatian untuk membina taburan kebarangkalian peta perhatian.

Seperti yang disebutkan oleh Jaegle dan pasukannya dalam kertas kerja, memandangkan bilangan perkara yang perlu dibandingkan antara satu sama lain meningkat dalam input, penggunaan sumber pengkomputeran model akan menjadi semakin dibesar-besarkan:

Semacam ini Terdapat konflik antara struktur konteks yang panjang dan sifat pengiraan Transformers. Transformer berulang kali melakukan operasi perhatian sendiri pada input, yang menyebabkan keperluan pengiraan berkembang secara kuadratik dengan panjang input dan secara linear dengan kedalaman model. Lebih banyak data input, lebih banyak teg input sepadan dengan kandungan data yang diperhatikan, corak dalam data input menjadi lebih halus dan kompleks, dan lapisan yang lebih dalam mesti digunakan untuk memodelkan corak yang dijana. Disebabkan kuasa pengkomputeran yang terhad, pengguna Transformer terpaksa sama ada memotong input model (menghalang pemerhatian corak yang lebih jauh) atau mengehadkan kedalaman model (dengan itu menafikannya daripada keupayaan ekspresif untuk memodelkan corak yang kompleks).

Malah, versi pertama Perceiver juga cuba meningkatkan kecekapan Transformers: ia tidak melakukan perhatian secara langsung, tetapi melakukan perhatian terhadap potensi perwakilan input. Dengan cara ini, keperluan kuasa pengkomputeran untuk memproses tatasusunan input yang besar boleh "(dipisahkan) daripada keperluan kuasa pengkomputeran yang sepadan dengan rangkaian dalam yang besar."

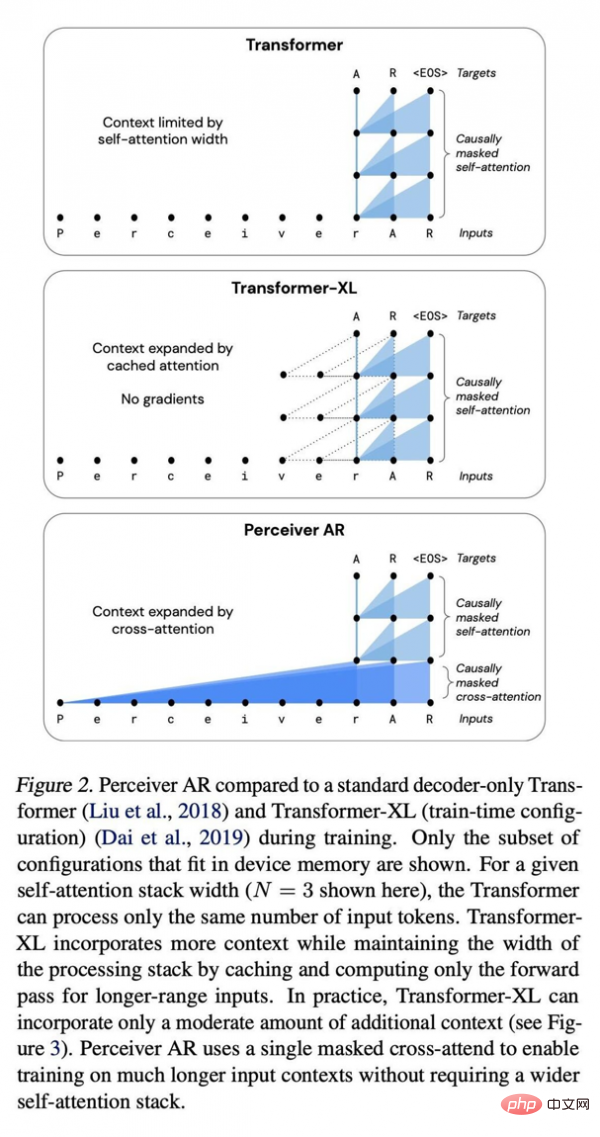

Perbandingan antara Perceiver AR, rangkaian dalam Transformer standard dan Transformer XL yang dipertingkatkan.

Di bahagian terpendam, perwakilan input dimampatkan, menjadikannya enjin perhatian yang lebih cekap. Dengan cara ini, "dengan rangkaian dalam, kebanyakan pengiraan sebenarnya berlaku pada timbunan perhatian kendiri," dan bukannya perlu beroperasi pada input yang tidak terkira banyaknya.

Tetapi cabaran masih wujud, kerana perwakilan asas tidak mempunyai konsep susunan, jadi Perceiver tidak boleh menjana output seperti Transformer. Tertib adalah penting dalam autoregresi, dan setiap output hendaklah hasil daripada input sebelum ia, bukan produk selepasnya.

Tetapi memandangkan setiap model terpendam memberi perhatian kepada semua input tanpa mengira lokasinya, "untuk penjanaan autoregresif yang memerlukan setiap output model mesti bergantung hanya pada input sebelumnya," tulis para penyelidik, Perceiver tidak akan digunakan secara langsung . "

Bagi Perceiver AR, pasukan penyelidik melangkah lebih jauh dan memasukkan urutan ke dalam Perceiver untuk mendayakan regresi automatik.

Kuncinya di sini ialah melakukan apa yang dipanggil "penyelidikan sebab-sebab" pada input dan perwakilan terpendam. Pada bahagian input, pelekat sebab melakukan "perhatian silang", manakala pada bahagian perwakilan asas ia memaksa program untuk memberi perhatian hanya kepada perkara yang datang sebelum simbol tertentu. Kaedah ini memulihkan arahan Transformer dan masih boleh mengurangkan jumlah pengiraan dengan ketara.

Hasilnya ialah Perceiver AR boleh mencapai hasil pemodelan yang setanding dengan Transformer berdasarkan lebih banyak input, tetapi dengan prestasi yang lebih baik.

Mereka menulis, "Perceiver AR dapat mengenal pasti dan mempelajari corak konteks panjang yang mempunyai sekurang-kurangnya 100k token dalam tugas replikasi sintetik sebagai perbandingan, Transformer mempunyai had keras sebanyak 2048 token, Semakin banyak token." , semakin lama konteksnya dan semakin kompleks output program.

Berbanding dengan seni bina Transformer dan Transformer-XL yang menggunakan penyahkod tulen secara meluas, Perceiver AR adalah lebih cekap dan secara fleksibel boleh menukar sumber pengkomputeran sebenar yang digunakan semasa ujian mengikut belanjawan sasaran.

Makalah itu menulis bahawa dalam keadaan perhatian yang sama, masa jam dinding untuk mengira Perceiver AR adalah jauh lebih pendek, dan ia boleh menyerap lebih banyak konteks (iaitu lebih banyak simbol input) dengan belanjawan kuasa pengkomputeran yang sama:

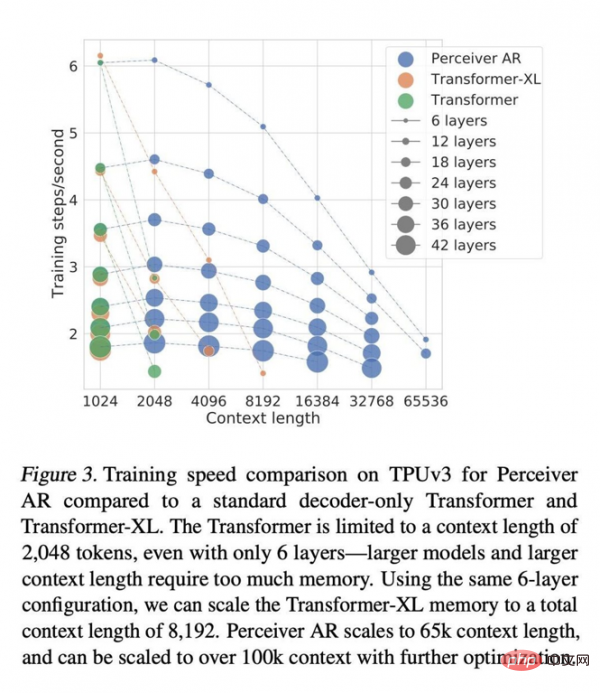

Panjang konteks Transformer dihadkan kepada 2048 token, yang bersamaan dengan hanya menyokong 6 lapisan - kerana model yang lebih besar dan konteks yang lebih panjang memerlukan jumlah memori yang besar. Menggunakan konfigurasi 6 lapisan yang sama, kami boleh memanjangkan jumlah panjang konteks memori Transformer-XL kepada 8192 token. Perceiver AR boleh memanjangkan panjang konteks kepada 65k penanda, dan dengan pengoptimuman lanjut, ia dijangka melebihi 100k.

Semua ini menjadikan pengkomputeran lebih fleksibel: “Kami dapat mengawal jumlah pengiraan yang dihasilkan oleh model tertentu semasa ujian dengan lebih baik, membolehkan kami mencapai keseimbangan yang stabil antara kelajuan dan prestasi ."

Jaegle dan rakan sekerja juga menulis bahawa pendekatan ini berfungsi untuk sebarang jenis input dan tidak terhad kepada simbol perkataan. Contohnya piksel dalam imej boleh disokong:

Proses yang sama berfungsi untuk sebarang input yang boleh diisih, selagi teknik penyamaran sebab-musabab digunakan. Sebagai contoh, saluran RGB sesuatu imej boleh diisih mengikut tertib imbasan raster dengan menyahkod saluran warna R, G dan B bagi setiap piksel dalam turutan, mengikut tertib atau tidak tertib.

Pengarang menemui potensi besar dalam Perceiver dan menulis dalam kertas kerja, "Perceiver AR ialah calon yang ideal untuk model autoregresif tujuan am konteks panjang

Tetapi jika anda ingin mengejar Untuk kecekapan pengiraan yang lebih tinggi, satu lagi faktor ketidakstabilan tambahan perlu ditangani. Penulis menunjukkan bahawa komuniti penyelidikan juga baru-baru ini cuba mengurangkan keperluan pengiraan perhatian autoregresif melalui "sparsity" (iaitu, proses mengehadkan kepentingan yang diberikan kepada beberapa elemen input).

Dalam masa jam dinding yang sama, Perceiver AR dapat menjalankan lebih banyak daripada input dengan bilangan lapisan yang sama simbol, atau memendekkan dengan ketara masa pengiraan dengan bilangan larian simbol input yang sama. Penulis percaya bahawa fleksibiliti yang sangat baik ini boleh membawa kepada kaedah peningkatan kecekapan umum untuk rangkaian besar.

Tetapi sparsity juga mempunyai kekurangannya yang tersendiri, yang utama ialah ianya terlalu kaku. Kertas itu menulis, "Kelemahan menggunakan kaedah sparsity ialah sparsity ini mesti dicipta melalui pelarasan manual atau kaedah heuristik. Heuristik ini selalunya hanya terpakai untuk bidang tertentu dan selalunya sukar untuk disesuaikan dengan OpenAI dan NVIDIA pada 2019 The Sparse Transformer dikeluarkan pada 2017 adalah projek sparsity.

Mereka menjelaskan, "Sebaliknya, kerja kami tidak memerlukan penciptaan manual corak jarang pada lapisan perhatian, sebaliknya membenarkan rangkaian untuk belajar secara autonomi input konteks panjang yang memerlukan lebih perhatian dan perlu melaluinya. Rangkaian menyebarkan. "

Kertas itu juga menambah bahawa "operasi tumpuan silang awal mengurangkan bilangan kedudukan dalam urutan dan boleh dianggap sebagai satu bentuk pembelajaran yang jarang"

Dalam hal ini Cara ini sendiri yang dipelajari dengan cara ini mungkin menjadi satu lagi alat yang berkuasa dalam kit alat model pembelajaran mendalam dalam beberapa tahun akan datang.

Atas ialah kandungan terperinci DeepMind berkata: Model AI perlu menurunkan berat badan, dan autoregresi menjadi trend utama. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1382

1382

52

52

Baris arahan shutdown centos

Apr 14, 2025 pm 09:12 PM

Baris arahan shutdown centos

Apr 14, 2025 pm 09:12 PM

Perintah shutdown CentOS adalah penutupan, dan sintaks adalah tutup [pilihan] [maklumat]. Pilihan termasuk: -h menghentikan sistem dengan segera; -P mematikan kuasa selepas penutupan; -r mulakan semula; -T Waktu Menunggu. Masa boleh ditentukan sebagai segera (sekarang), minit (minit), atau masa tertentu (HH: mm). Maklumat tambahan boleh dipaparkan dalam mesej sistem.

Apakah kaedah sandaran untuk gitlab di centos

Apr 14, 2025 pm 05:33 PM

Apakah kaedah sandaran untuk gitlab di centos

Apr 14, 2025 pm 05:33 PM

Dasar sandaran dan pemulihan Gitlab di bawah sistem CentOS untuk memastikan keselamatan data dan pemulihan, Gitlab pada CentOS menyediakan pelbagai kaedah sandaran. Artikel ini akan memperkenalkan beberapa kaedah sandaran biasa, parameter konfigurasi dan proses pemulihan secara terperinci untuk membantu anda menubuhkan strategi sandaran dan pemulihan GitLab lengkap. 1. Backup Manual Gunakan Gitlab-Rakegitlab: Backup: Buat Perintah untuk Melaksanakan Backup Manual. Perintah ini menyokong maklumat utama seperti repositori Gitlab, pangkalan data, pengguna, kumpulan pengguna, kunci, dan kebenaran. Fail sandaran lalai disimpan dalam direktori/var/opt/gitlab/sandaran. Anda boleh mengubah suai /etc /gitlab

Cara Memeriksa Konfigurasi HDFS CentOS

Apr 14, 2025 pm 07:21 PM

Cara Memeriksa Konfigurasi HDFS CentOS

Apr 14, 2025 pm 07:21 PM

Panduan Lengkap untuk Memeriksa Konfigurasi HDFS Dalam Sistem CentOS Artikel ini akan membimbing anda bagaimana untuk memeriksa konfigurasi dan menjalankan status HDFS secara berkesan pada sistem CentOS. Langkah -langkah berikut akan membantu anda memahami sepenuhnya persediaan dan operasi HDFS. Sahkan Pembolehubah Alam Sekitar Hadoop: Pertama, pastikan pembolehubah persekitaran Hadoop ditetapkan dengan betul. Di terminal, laksanakan arahan berikut untuk mengesahkan bahawa Hadoop dipasang dan dikonfigurasi dengan betul: Hadoopversion Semak fail konfigurasi HDFS: Fail konfigurasi teras HDFS terletak di/etc/hadoop/conf/direktori, di mana core-site.xml dan hdfs-site.xml adalah kritikal. gunakan

Apakah kaedah penalaan prestasi zookeeper di CentOS

Apr 14, 2025 pm 03:18 PM

Apakah kaedah penalaan prestasi zookeeper di CentOS

Apr 14, 2025 pm 03:18 PM

Penalaan prestasi zookeeper pada centOs boleh bermula dari pelbagai aspek, termasuk konfigurasi perkakasan, pengoptimuman sistem operasi, pelarasan parameter konfigurasi, pemantauan dan penyelenggaraan, dan lain -lain. Memori yang cukup: memperuntukkan sumber memori yang cukup untuk zookeeper untuk mengelakkan cakera kerap membaca dan menulis. CPU multi-teras: Gunakan CPU multi-teras untuk memastikan bahawa zookeeper dapat memprosesnya selari.

Bagaimana sokongan GPU untuk Pytorch di CentOS

Apr 14, 2025 pm 06:48 PM

Bagaimana sokongan GPU untuk Pytorch di CentOS

Apr 14, 2025 pm 06:48 PM

Membolehkan pecutan GPU pytorch pada sistem CentOS memerlukan pemasangan cuda, cudnn dan GPU versi pytorch. Langkah-langkah berikut akan membimbing anda melalui proses: Pemasangan CUDA dan CUDNN Tentukan keserasian versi CUDA: Gunakan perintah NVIDIA-SMI untuk melihat versi CUDA yang disokong oleh kad grafik NVIDIA anda. Sebagai contoh, kad grafik MX450 anda boleh menyokong CUDA11.1 atau lebih tinggi. Muat turun dan pasang Cudatoolkit: Lawati laman web rasmi Nvidiacudatoolkit dan muat turun dan pasang versi yang sepadan mengikut versi CUDA tertinggi yang disokong oleh kad grafik anda. Pasang Perpustakaan Cudnn:

Penjelasan terperinci mengenai Prinsip Docker

Apr 14, 2025 pm 11:57 PM

Penjelasan terperinci mengenai Prinsip Docker

Apr 14, 2025 pm 11:57 PM

Docker menggunakan ciri -ciri kernel Linux untuk menyediakan persekitaran berjalan yang cekap dan terpencil. Prinsip kerjanya adalah seperti berikut: 1. Cermin digunakan sebagai templat baca sahaja, yang mengandungi semua yang anda perlukan untuk menjalankan aplikasi; 2. Sistem Fail Kesatuan (Unionfs) menyusun pelbagai sistem fail, hanya menyimpan perbezaan, menjimatkan ruang dan mempercepatkan; 3. Daemon menguruskan cermin dan bekas, dan pelanggan menggunakannya untuk interaksi; 4. Ruang nama dan cgroups melaksanakan pengasingan kontena dan batasan sumber; 5. Pelbagai mod rangkaian menyokong interkoneksi kontena. Hanya dengan memahami konsep -konsep teras ini, anda boleh menggunakan Docker dengan lebih baik.

CentOS memasang MySQL

Apr 14, 2025 pm 08:09 PM

CentOS memasang MySQL

Apr 14, 2025 pm 08:09 PM

Memasang MySQL pada CentOS melibatkan langkah -langkah berikut: Menambah sumber MySQL YUM yang sesuai. Jalankan YUM Pasang Perintah MySQL-Server untuk memasang pelayan MySQL. Gunakan perintah mysql_secure_installation untuk membuat tetapan keselamatan, seperti menetapkan kata laluan pengguna root. Sesuaikan fail konfigurasi MySQL seperti yang diperlukan. Tune parameter MySQL dan mengoptimumkan pangkalan data untuk prestasi.

CentOS8 memulakan semula SSH

Apr 14, 2025 pm 09:00 PM

CentOS8 memulakan semula SSH

Apr 14, 2025 pm 09:00 PM

Perintah untuk memulakan semula perkhidmatan SSH ialah: Sistem Restart SSHD. Langkah -langkah terperinci: 1. Akses terminal dan sambungkan ke pelayan; 2. Masukkan arahan: SistemCtl Restart SSHD; 3. Sahkan Status Perkhidmatan: Status Sistem SSHD.