Peranti teknologi

Peranti teknologi

AI

AI

Bacaan Kelajuan Kuantum Benar: Menembusi had GPT-4 yang hanya boleh memahami 50 halaman teks pada satu masa, penyelidikan baharu berkembang kepada berjuta-juta token

Bacaan Kelajuan Kuantum Benar: Menembusi had GPT-4 yang hanya boleh memahami 50 halaman teks pada satu masa, penyelidikan baharu berkembang kepada berjuta-juta token

Bacaan Kelajuan Kuantum Benar: Menembusi had GPT-4 yang hanya boleh memahami 50 halaman teks pada satu masa, penyelidikan baharu berkembang kepada berjuta-juta token

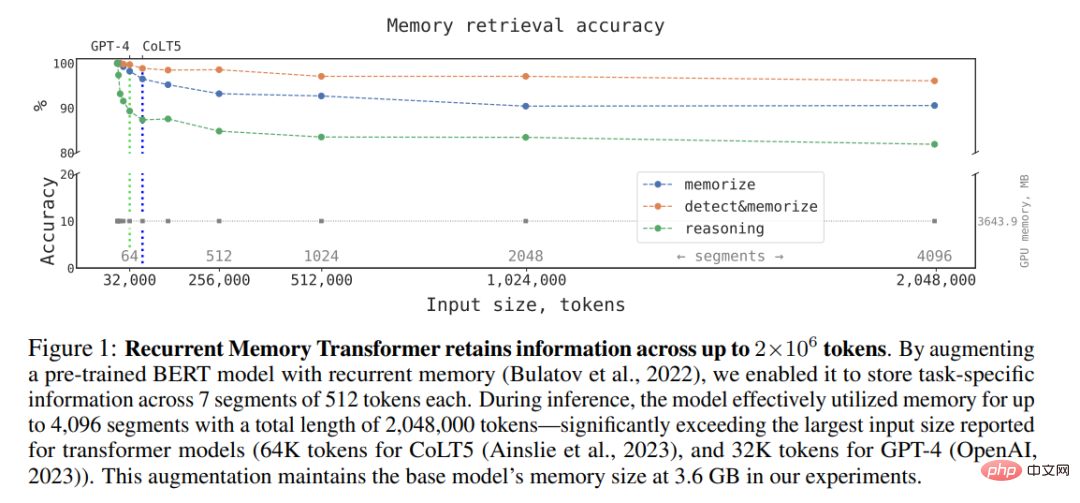

Lebih sebulan yang lalu, GPT-4 OpenAI telah dikeluarkan. Selain pelbagai demonstrasi visual yang sangat baik, ia juga melaksanakan kemas kini penting: ia boleh mengendalikan token konteks yang panjangnya 8k secara lalai, tetapi boleh sehingga 32K (kira-kira 50 halaman teks). Ini bermakna apabila bertanya soalan kepada GPT-4, kita boleh memasukkan teks yang lebih panjang daripada sebelumnya. Ini sangat meluaskan senario aplikasi GPT-4 dan boleh mengendalikan perbualan panjang, teks panjang serta carian dan analisis fail dengan lebih baik.

Walau bagaimanapun, rekod ini telah dipecahkan dengan cepat: CoLT5 daripada Google Research mengembangkan panjang token konteks yang boleh dikendalikan oleh model kepada 64k .

Penerobosan sedemikian bukanlah mudah, kerana model yang menggunakan seni bina Transformer ini semuanya menghadapi masalah: Transformer memproses dokumen panjang secara pengiraan sangat mahal, kerana kos perhatian meningkat dengan input Panjangnya berkembang secara kuadratik, menjadikannya semakin sukar untuk menggunakan model besar pada input yang lebih panjang.

Walaupun begitu, penyelidik masih membuat penemuan ke arah ini. Beberapa hari yang lalu, kajian daripada timbunan teknologi AI perbualan sumber terbuka DeepPavlov dan institusi lain menunjukkan bahawa: Dengan menggunakan seni bina yang dipanggil Recurrent Memory Transformer (RMT), mereka boleh meningkatkan panjang konteks berkesan BERT model. kepada 2 juta token (kira-kira bersamaan dengan 3,200 halaman teks mengikut kaedah pengiraan OpenAI), sambil mengekalkan ketepatan perolehan memori yang tinggi (Nota: Recurrent Memory Transformer telah dicadangkan oleh Aydar Bulatov et al. dalam kertas di kaedah NeurIPS 2022) . Kaedah baharu ini membolehkan penyimpanan dan pemprosesan maklumat tempatan dan global, dan aliran maklumat antara segmen jujukan input melalui penggunaan berulang.

Penulis menyatakan bahawa dengan menggunakan kaedah berasaskan token mudah yang diperkenalkan oleh Bulatov et al Mekanisme memori Memory Transformer, mereka boleh menggabungkan RMT dengan model Transformer terlatih seperti BERT, dan menggunakan GPU Nvidia GTX 1080Ti untuk melaksanakan perhatian penuh dan operasi ketepatan penuh pada jujukan lebih daripada 1 juta token.

Alamat kertas: https://arxiv.org/pdf/2304.11062.pdf

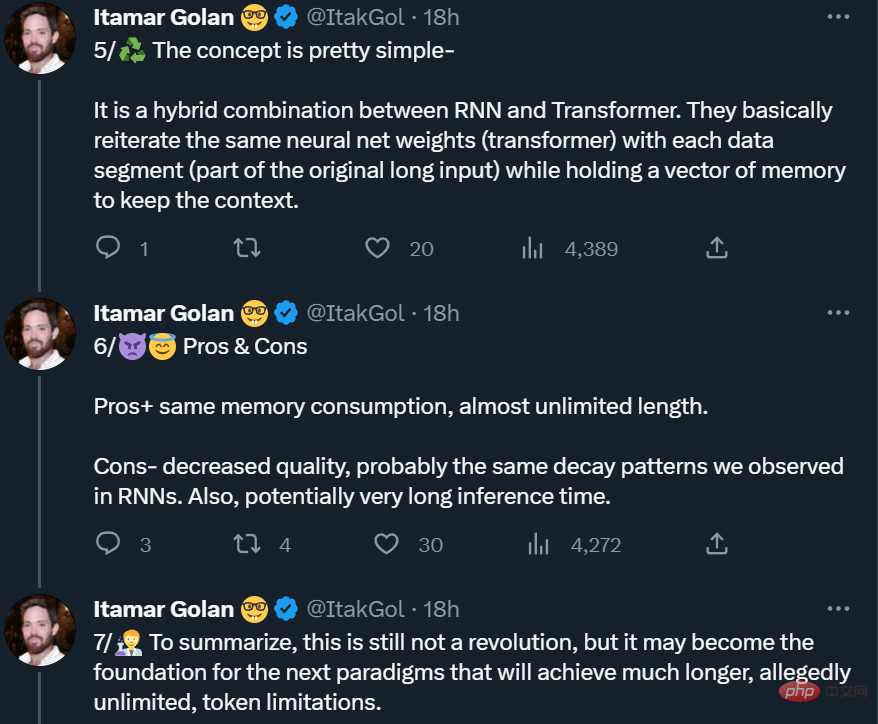

Namun, sesetengah orang telah mengingatkan bahawa ini bukan "makan tengah hari percuma" sebenar. daripada. Oleh itu, ia belum lagi revolusi, tetapi ia mungkin menjadi asas kepada paradigma seterusnya (token mungkin panjang tidak terhingga).

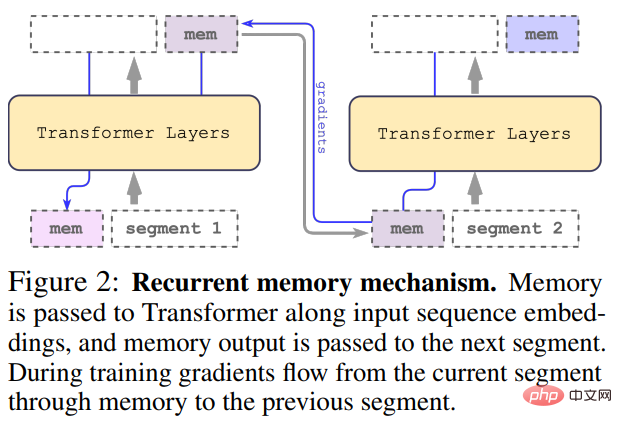

Recurrent Memory Transformer

Kajian ini mengamalkan kaedah Recurrent Memory Transformer yang dicadangkan oleh Bulatov et al. pada 2022 (RMT) dan tukar kepada kaedah pasang dan main Mekanisme utama adalah seperti yang ditunjukkan dalam rajah di bawah:

Input panjang dibahagikan kepada berbilang segmen dan vektor memori ditambahkan sebelum pembenaman dan diproses segmen pertama bersama-sama dengan token segmen. Untuk model pengekod tulen seperti BERT, memori hanya ditambah sekali pada permulaan segmen, tidak seperti (Bulatov et al., 2022), di mana model penyahkod tulen membahagikan memori kepada bahagian baca dan tulis. Untuk langkah masa τ dan segmen

, gelung dilaksanakan seperti berikut:

Di mana, N ialah bilangan lapisan Transformer. Selepas penyebaran ke hadapan,

mengandungi token ingatan yang dikemas kini bagi segmen τ.

Segmen jujukan input diproses mengikut tertib. Untuk mendayakan sambungan berulang, kajian menghantar output token memori daripada segmen semasa ke input segmen seterusnya:

Kedua-dua memori dan gelung dalam RMT hanya berdasarkan token memori global. Ini membolehkan Transformer tulang belakang kekal tidak berubah, menjadikan keupayaan peningkatan memori RMT serasi dengan mana-mana model Transformer.

Kecekapan pengiraan

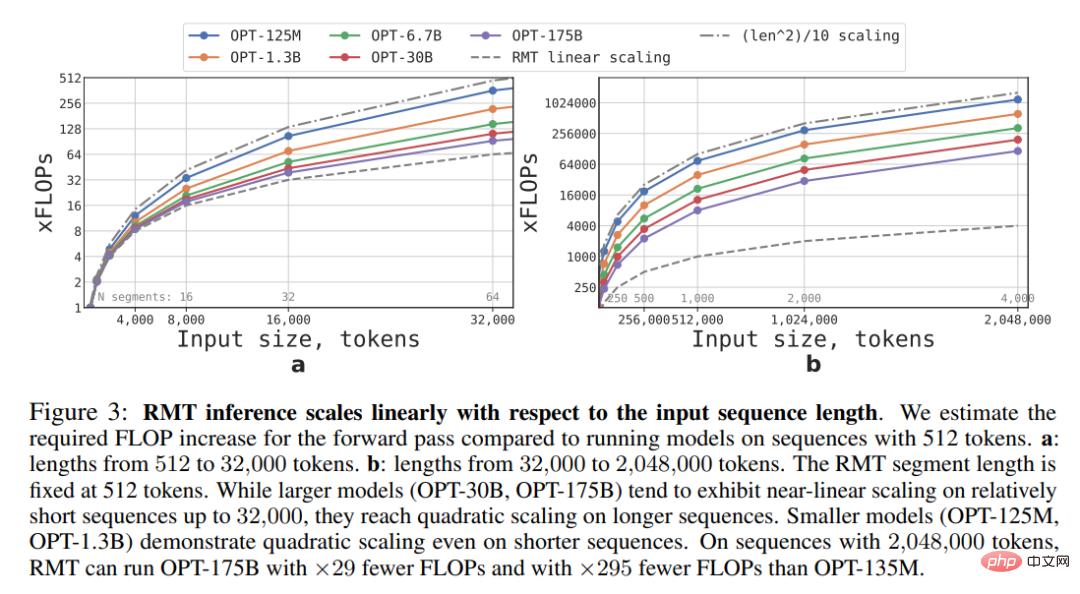

Kajian ini menganggarkan FLOP yang diperlukan untuk model RMT dan Transformer dengan saiz dan panjang jujukan yang berbeza.

Seperti yang ditunjukkan dalam Rajah 3 di bawah, jika panjang segmen ditetapkan, RMT boleh menskala secara linear untuk sebarang saiz model. Kajian ini mencapai penskalaan linear dengan membahagikan jujukan input kepada segmen dan mengira matriks perhatian lengkap hanya dalam sempadan segmen.

Disebabkan beban pengiraan yang berat pada lapisan FFN, model Transformer yang lebih besar cenderung mempamerkan penskalaan kuadratik yang lebih perlahan dengan panjang jujukan. Walau bagaimanapun, untuk jujukan yang sangat panjang lebih besar daripada 32000, ia kembali kepada pengembangan kuadratik. Untuk jujukan dengan lebih daripada satu segmen (> 512 dalam kajian ini), RMT memerlukan lebih sedikit FLOP daripada model akiklik dan boleh mengurangkan bilangan FLOP sehingga 295 kali. RMT memberikan pengurangan relatif yang lebih besar dalam FLOP untuk model yang lebih kecil, tetapi pengurangan 29x dalam FLOP untuk model OPT-175B adalah ketara dari segi mutlak.

Tugas Ingatan

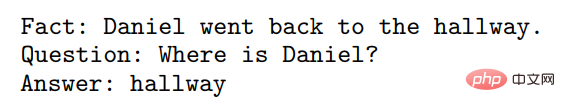

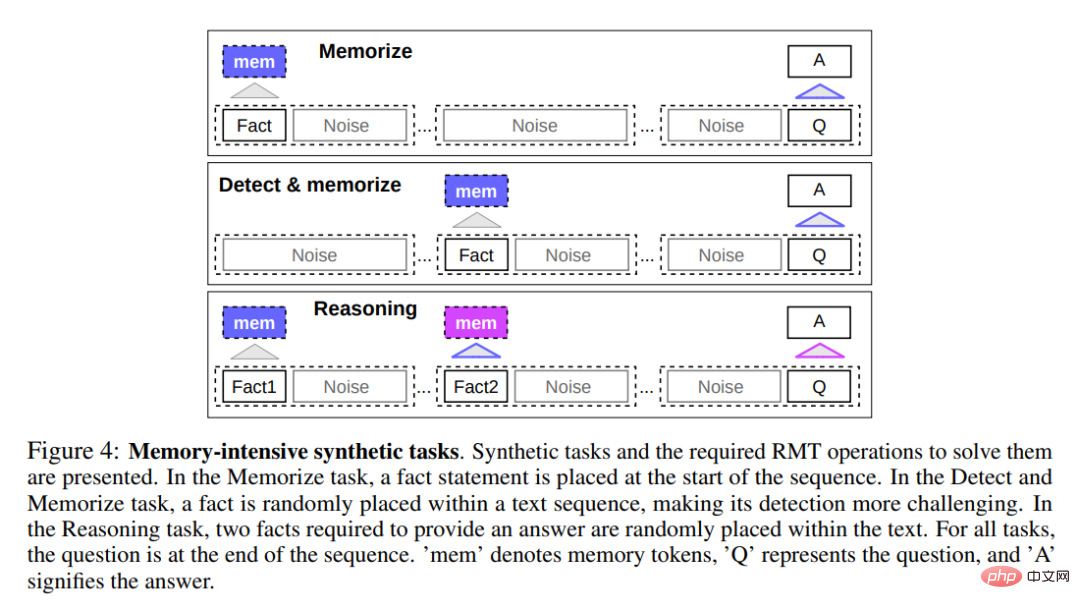

Untuk menguji keupayaan ingatan, kajian itu membina set data sintetik yang memerlukan hafalan fakta mudah dan penaakulan asas. Input tugasan terdiri daripada satu atau lebih fakta dan soalan yang hanya boleh dijawab menggunakan semua fakta. Untuk meningkatkan kesukaran tugasan, kajian juga menambah teks bahasa semula jadi yang tidak berkaitan dengan soalan atau jawapan untuk bertindak sebagai bunyi bising, jadi model ditugaskan untuk memisahkan fakta daripada teks yang tidak berkaitan dan menggunakan fakta untuk menjawab soalan.

Memori fakta

Item pertama tugasnya adalah untuk menguji keupayaan RMT untuk menulis dan menyimpan maklumat dalam ingatan untuk jangka masa yang lama, seperti yang ditunjukkan di bahagian atas Rajah 4 di bawah. Dalam kes yang paling mudah, fakta cenderung berada di awal input, dan soalan sentiasa di penghujung. Jumlah teks yang tidak berkaitan antara soalan dan jawapan secara beransur-ansur meningkat ke tahap di mana keseluruhan input tidak sesuai dengan input model tunggal.

Pengesanan fakta dan ingatan

Pengesanan fakta meningkatkan kesukaran tugasan dengan mengalihkan fakta ke kedudukan rawak dalam input, seperti yang ditunjukkan di tengah-tengah Rajah 4 di atas. Ini memerlukan model untuk terlebih dahulu membezakan fakta daripada teks yang tidak berkaitan, menulis fakta ke dalam ingatan, dan kemudian menggunakannya untuk menjawab soalan pada akhir.

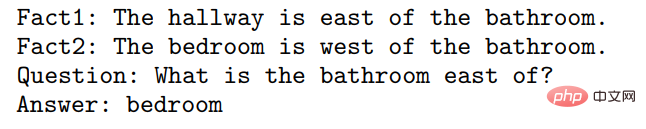

Menggunakan fakta yang dihafal untuk menaakul

Satu lagi operasi ingatan ialah menaakul menggunakan fakta yang dihafal dan konteks semasa. Untuk menilai fungsi ini, penyelidik menggunakan tugas yang lebih kompleks di mana dua fakta dijana dan diletakkan dalam urutan input, seperti yang ditunjukkan di bahagian bawah Rajah 4 di atas. Soalan yang ditanya pada akhir urutan diterangkan sedemikian rupa sehingga fakta sewenang-wenangnya mesti digunakan untuk menjawab soalan dengan betul.

Hasil eksperimen

Para penyelidik menggunakan 4 hingga 8 GPU NVIDIA 1080ti untuk melatih dan menilai model . Untuk urutan yang lebih panjang, mereka menggunakan NVIDIA A100 40GB tunggal untuk mempercepatkan penilaian.

Pembelajaran Kursus

Para penyelidik mendapati bahawa menggunakan pelan latihan boleh meningkatkan ketepatan dan kestabilan penyelesaian dengan ketara seks. Pada mulanya, RMT dilatih pada versi tugasan yang lebih pendek dan meningkatkan panjang tugasan dengan menambah segmen lain apabila latihan berkumpul. Proses pembelajaran kursus diteruskan sehingga panjang input yang diperlukan dicapai.

Dalam percubaan, penyelidik mula-mula memulakan dengan urutan yang sesuai untuk satu segmen. Saiz segmen sebenar ialah 499, tetapi disebabkan oleh 3 token khas BERT dan 10 ruang letak memori yang dikekalkan daripada input model, saiznya ialah 512. Mereka ambil perhatian bahawa selepas latihan mengenai tugas yang lebih pendek, RMT lebih mudah untuk menyelesaikan versi tugasan yang lebih panjang, terima kasih kepada fakta bahawa ia menggunakan lebih sedikit langkah latihan untuk menumpu kepada penyelesaian yang sempurna.

Keupayaan ekstrapolasi

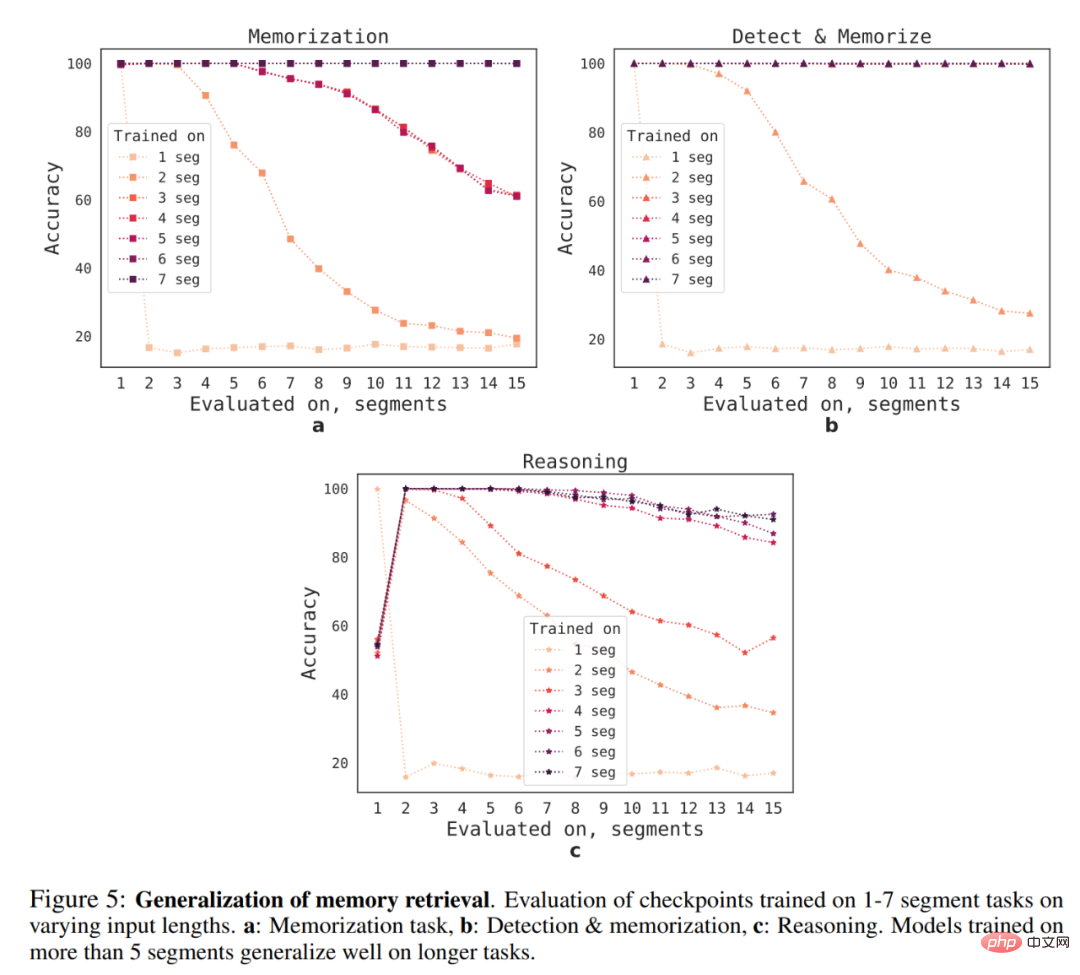

Apakah keupayaan generalisasi RMT kepada panjang jujukan yang berbeza? Untuk menjawab soalan ini, penyelidik menilai model yang dilatih pada bilangan segmen yang berbeza untuk menyelesaikan tugas yang lebih panjang, seperti yang ditunjukkan dalam Rajah 5 di bawah.

Mereka memerhatikan bahawa model cenderung menunjukkan prestasi yang lebih baik pada tugasan yang lebih pendek, dengan satu-satunya pengecualian ialah tugas inferens segmen tunggal, yang menjadi Sangat sukar untuk diselesaikan. Satu penjelasan yang mungkin ialah kerana saiz tugasan melebihi satu segmen, model tidak lagi "menjangkakan" masalah dalam segmen pertama, mengakibatkan penurunan kualiti.

Menariknya, keupayaan RMT untuk membuat generalisasi kepada urutan yang lebih panjang juga muncul apabila bilangan segmen latihan meningkat. Selepas latihan pada 5 atau lebih segmen, RMT boleh membuat generalisasi hampir sempurna kepada tugasan dua kali lebih lama.

Untuk menguji batasan generalisasi, penyelidik meningkatkan saiz tugas pengesahan kepada 4096 segmen atau 2,043,904 token (seperti ditunjukkan dalam Rajah 1 di atas), RMT pada jujukan yang begitu panjang Dilakukan menghairankan dengan baik. Tugas pengesanan dan ingatan adalah yang paling mudah, dan tugas inferens adalah yang paling kompleks.

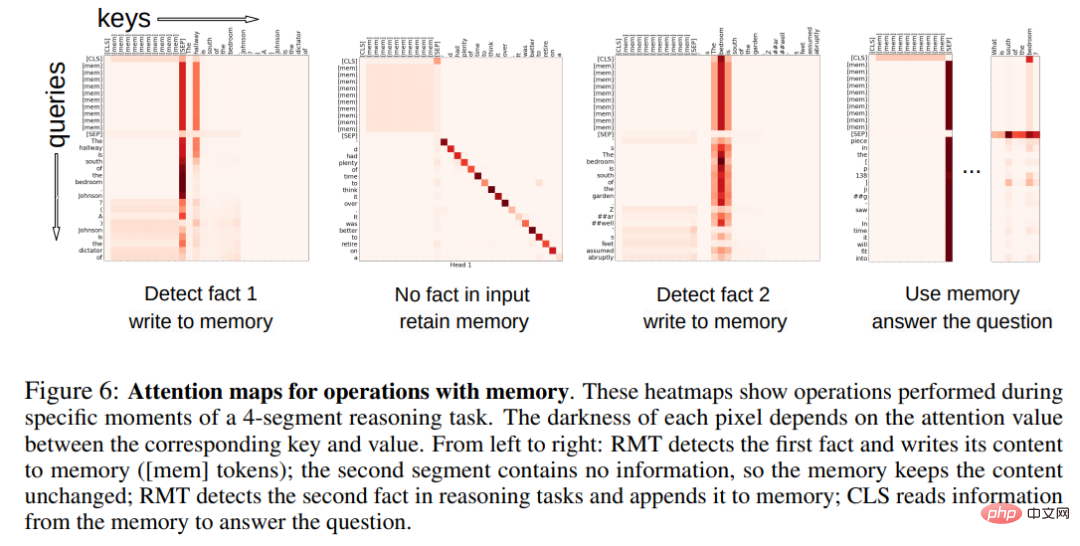

Corak perhatian operasi ingatan

Dalam Rajah 6 di bawah, dengan meneliti perhatian RMT pada segmen tertentu, penyelidik memerhatikan bahawa operasi ingatan sepadan dengan perhatian khusus model. Tambahan pula, prestasi ekstrapolasi yang tinggi pada jujukan yang sangat panjang dalam Bahagian 5.2 menunjukkan keberkesanan operasi ingatan yang dipelajari, walaupun digunakan beribu-ribu kali.

Sila rujuk kertas asal untuk butiran lanjut teknikal dan eksperimen.

Atas ialah kandungan terperinci Bacaan Kelajuan Kuantum Benar: Menembusi had GPT-4 yang hanya boleh memahami 50 halaman teks pada satu masa, penyelidikan baharu berkembang kepada berjuta-juta token. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

Ramalan Harga Worldcoin (WLD) 2025-2031: Adakah WLD akan mencapai $ 4 menjelang 2031?

Apr 21, 2025 pm 02:42 PM

Ramalan Harga Worldcoin (WLD) 2025-2031: Adakah WLD akan mencapai $ 4 menjelang 2031?

Apr 21, 2025 pm 02:42 PM

Worldcoin (WLD) menonjol dalam pasaran cryptocurrency dengan mekanisme pengesahan biometrik dan perlindungan privasi yang unik, menarik perhatian banyak pelabur. WLD telah melakukan yang luar biasa di kalangan altcoin dengan teknologi inovatifnya, terutamanya dalam kombinasi dengan teknologi kecerdasan buatan terbuka. Tetapi bagaimanakah aset digital akan berkelakuan dalam beberapa tahun akan datang? Mari kita meramalkan harga masa depan WLD bersama -sama. Ramalan harga WLD 2025 dijangka mencapai pertumbuhan yang signifikan di WLD pada tahun 2025. Analisis pasaran menunjukkan bahawa harga WLD purata boleh mencapai $ 1.31, dengan maksimum $ 1.36. Walau bagaimanapun, dalam pasaran beruang, harga mungkin jatuh ke sekitar $ 0.55. Harapan pertumbuhan ini disebabkan terutamanya oleh WorldCoin2.

Apakah yang dimaksudkan dengan transaksi rantaian rantaian? Apakah urus niaga salib?

Apr 21, 2025 pm 11:39 PM

Apakah yang dimaksudkan dengan transaksi rantaian rantaian? Apakah urus niaga salib?

Apr 21, 2025 pm 11:39 PM

Pertukaran yang menyokong urus niaga rantaian: 1. Binance, 2. Uniswap, 3 Sushiswap, 4. Kewangan Curve, 5. Thorchain, 6. 1 inci Pertukaran, 7.

'Black Monday Sell' adalah hari yang sukar untuk industri cryptocurrency

Apr 21, 2025 pm 02:48 PM

'Black Monday Sell' adalah hari yang sukar untuk industri cryptocurrency

Apr 21, 2025 pm 02:48 PM

Jatuh di pasaran cryptocurrency telah menyebabkan panik di kalangan pelabur, dan Dogecoin (Doge) telah menjadi salah satu kawasan terkena paling sukar. Harganya jatuh dengan ketara, dan jumlah nilai kunci kewangan yang terdesentralisasi (DEFI) (TVL) juga menyaksikan penurunan yang ketara. Gelombang jualan "Black Monday" menyapu pasaran cryptocurrency, dan Dogecoin adalah yang pertama dipukul. Defitvlnya jatuh ke tahap 2023, dan harga mata wang jatuh 23.78% pada bulan lalu. Defitvl Dogecoin jatuh ke tahap rendah $ 2.72 juta, terutamanya disebabkan oleh penurunan 26.37% dalam indeks nilai SOSO. Platform defi utama lain, seperti DAO dan Thorchain yang membosankan, TVL juga menurun sebanyak 24.04% dan 20.

Cara Memenangi Ganjaran Airdrop Kernel pada Strategi Proses Penuh Binance

Apr 21, 2025 pm 01:03 PM

Cara Memenangi Ganjaran Airdrop Kernel pada Strategi Proses Penuh Binance

Apr 21, 2025 pm 01:03 PM

Dalam dunia kriptografi yang ramai, peluang baru selalu muncul. Pada masa ini, aktiviti udara Kerneldao (kernel) menarik banyak perhatian dan menarik perhatian banyak pelabur. Jadi, apakah asalnya projek ini? Apakah faedah yang boleh diperoleh oleh pemegang BNB? Jangan risau, perkara berikut akan mendedahkannya satu demi satu untuk anda.

Mengapa kenaikan atau kejatuhan harga mata wang maya? Mengapa kenaikan atau kejatuhan harga mata wang maya?

Apr 21, 2025 am 08:57 AM

Mengapa kenaikan atau kejatuhan harga mata wang maya? Mengapa kenaikan atau kejatuhan harga mata wang maya?

Apr 21, 2025 am 08:57 AM

Faktor kenaikan harga mata wang maya termasuk: 1. Peningkatan permintaan pasaran, 2. Menurunkan bekalan, 3. Berita positif yang dirangsang, 4. Sentimen pasaran optimis, 5. Persekitaran makroekonomi; Faktor penurunan termasuk: 1. Mengurangkan permintaan pasaran, 2. Peningkatan bekalan, 3.

Platform Perdagangan Web3 Ranking_Web3 Global Exchanges Top Ten Ringkasan

Apr 21, 2025 am 10:45 AM

Platform Perdagangan Web3 Ranking_Web3 Global Exchanges Top Ten Ringkasan

Apr 21, 2025 am 10:45 AM

Binance adalah tuan rumah ekosistem perdagangan aset digital global, dan ciri -cirinya termasuk: 1. Jumlah dagangan harian purata melebihi $ 150 bilion, menyokong 500 pasangan perdagangan, yang meliputi 98% mata wang arus perdana; 2. Matriks inovasi meliputi pasaran Derivatif, susun atur Web3 dan sistem pendidikan; 3. Kelebihan teknikal adalah enjin yang sepadan dengan milisaat, dengan jumlah pemprosesan puncak sebanyak 1.4 juta transaksi sesaat; 4. Kemajuan pematuhan memegang lesen 15 negara dan menetapkan entiti yang mematuhi di Eropah dan Amerika Syarikat.

Aavenomics adalah cadangan untuk mengubah suai token protokol AAVE dan memperkenalkan pembelian semula token, yang telah mencapai bilangan kuorum orang.

Apr 21, 2025 pm 06:24 PM

Aavenomics adalah cadangan untuk mengubah suai token protokol AAVE dan memperkenalkan pembelian semula token, yang telah mencapai bilangan kuorum orang.

Apr 21, 2025 pm 06:24 PM

Aavenomics adalah cadangan untuk mengubah token protokol AAVE dan memperkenalkan repos token, yang telah melaksanakan kuorum untuk Aavedao. Marc Zeller, pengasas Rantaian Projek AAVE (ACI), mengumumkan ini pada X, dengan menyatakan bahawa ia menandakan era baru untuk perjanjian itu. Marc Zeller, pengasas Inisiatif Rantaian AAVE (ACI), mengumumkan pada X bahawa cadangan aavenomik termasuk mengubah token protokol AAVE dan memperkenalkan repos token, telah mencapai kuorum untuk Aavedao. Menurut Zeller, ini menandakan era baru untuk perjanjian itu. Ahli -ahli Aavedao mengundi untuk menyokong cadangan itu, yang 100 seminggu pada hari Rabu

Kedudukan pertukaran leverage dalam lingkaran mata wang Cadangan terkini sepuluh pertukaran leverage dalam lingkaran mata wang

Apr 21, 2025 pm 11:24 PM

Kedudukan pertukaran leverage dalam lingkaran mata wang Cadangan terkini sepuluh pertukaran leverage dalam lingkaran mata wang

Apr 21, 2025 pm 11:24 PM

Platform yang mempunyai prestasi cemerlang dalam perdagangan, keselamatan dan pengalaman pengguna yang dimanfaatkan pada tahun 2025 adalah: 1. Okx, sesuai untuk peniaga frekuensi tinggi, menyediakan sehingga 100 kali leverage; 2. Binance, sesuai untuk peniaga berbilang mata wang di seluruh dunia, memberikan 125 kali leverage tinggi; 3. Gate.io, sesuai untuk pemain derivatif profesional, menyediakan 100 kali leverage; 4. Bitget, sesuai untuk orang baru dan peniaga sosial, menyediakan sehingga 100 kali leverage; 5. Kraken, sesuai untuk pelabur mantap, menyediakan 5 kali leverage; 6. Bybit, sesuai untuk penjelajah altcoin, menyediakan 20 kali leverage; 7. Kucoin, sesuai untuk peniaga kos rendah, menyediakan 10 kali leverage; 8. Bitfinex, sesuai untuk bermain senior