Peranti teknologi

Peranti teknologi

AI

AI

Ia hanya mengambil masa 3 saat untuk mencuri suara anda! Microsoft mengeluarkan model sintesis pertuturan VALL-E: Netizen menyatakan bahawa ambang untuk 'penipuan telefon' telah diturunkan semula

Ia hanya mengambil masa 3 saat untuk mencuri suara anda! Microsoft mengeluarkan model sintesis pertuturan VALL-E: Netizen menyatakan bahawa ambang untuk 'penipuan telefon' telah diturunkan semula

Ia hanya mengambil masa 3 saat untuk mencuri suara anda! Microsoft mengeluarkan model sintesis pertuturan VALL-E: Netizen menyatakan bahawa ambang untuk 'penipuan telefon' telah diturunkan semula

Biar ChatGPT membantu anda menulis skrip dan Stable Diffusion menjana ilustrasi Adakah anda memerlukan pelakon suara untuk membuat video? Ia akan datang!

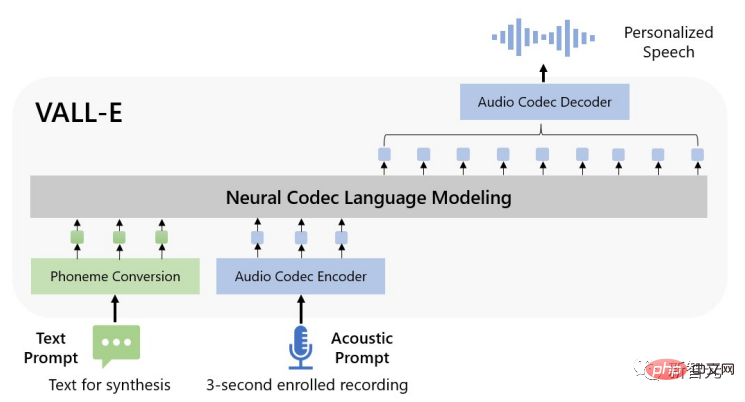

Baru-baru ini, penyelidik dari Microsoft mengeluarkan model text-to-speech (TTS) baharu VALL-E, yang hanya perlu menyediakan tiga saat sampel audio untuk mensimulasikan input suara manusia, dan Audio yang sepadan disintesis berdasarkan teks input, dan nada emosi penceramah juga boleh dikekalkan.

Pautan kertas: https://www.php.cn/link/402cac3dacf2ef35050ca72743ae6ca7

Pautan projek: https://valle-demo.github. io/

Pautan kod: https://github.com/microsoft/unilm

Mari kita lihat kesannya dahulu: Katakan anda mempunyai rakaman 3 saat.

audio diversity_speaker: 00:0000:03

Kemudian hanya masukkan teks "Kerana kami tidak memerlukannya untuk mendapatkan ucapan yang disintesis."

diversity_s1 Audio: 00:0000:01

Walaupun menggunakan benih rawak yang berbeza, sintesis pertuturan yang diperibadikan boleh dilakukan.

diversity_s2 Audio: 00:0000:02

VALL-E juga boleh mengekalkan bunyi ambien pembesar suara, seperti memasukkan suara ini.

audio env_speaker: 00:0000:03

Kemudian menurut teks "Saya rasa ia seperti anda tahu um lebih mudah juga.", anda boleh mengeluarkan ucapan yang disintesis sambil mengekalkan bunyi ambien .

env_vall_e Audio: 00:0000:02

Dan VALL-E juga boleh mengekalkan emosi pembesar suara, seperti memasukkan suara marah.

anger_pt Audio: 00:0000:03

Berdasarkan teks "Kita kena kurangkan bilangan beg plastik.", anda juga boleh meluahkan emosi marah.

anger_ours Audio: 00:0000:02

Terdapat banyak lagi contoh di tapak web projek.

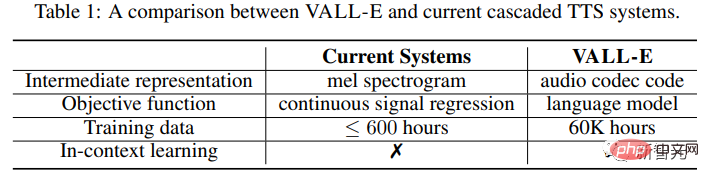

Dari segi metodologi, penyelidik melatih model bahasa VALL-E daripada pengekodan diskret yang diekstrak daripada model codec audio neural luar biasa, dan menganggap TTS sebagai tugas pemodelan bahasa bersyarat dan bukannya regresi isyarat berterusan.

Dalam peringkat pra-latihan, data latihan TTS yang diterima oleh VALL-E mencapai 60,000 jam pertuturan bahasa Inggeris, iaitu ratusan kali lebih besar daripada data yang digunakan oleh sistem sedia ada.

Selain itu, VALL-E juga telah menunjukkan keupayaan pembelajaran dalam konteks Ia boleh mensintesis pertuturan diperibadikan berkualiti tinggi dengan hanya menggunakan rakaman pendaftaran 3 saat pembesar suara yang tidak kelihatan sebagai gesaan bunyi.

Hasil eksperimen menunjukkan bahawa VALL-E dengan ketara mengatasi sistem TTS tangkapan sifar tercanggih dari segi keaslian pertuturan dan persamaan pembesar suara, dan juga boleh mengekalkan emosi pembesar suara dan akustik bunyi isyarat dalam persekitaran sintesis.

Sintesis pertuturan tangkapan sifar

Dalam dekad yang lalu, sintesis pertuturan telah membuat penemuan besar melalui pembangunan rangkaian saraf dan pemodelan hujung ke hujung.

Tetapi sistem text-to-speech (TTS) lata semasa biasanya menggunakan saluran paip dengan model akustik dan vocoder yang menggunakan spektrogram mel sebagai perwakilan perantaraan.

Walaupun sesetengah sistem TTS berprestasi tinggi boleh mensintesis pertuturan berkualiti tinggi daripada pembesar suara tunggal atau berbilang, ia masih memerlukan data bersih berkualiti tinggi daripada studio rakaman, yang tidak boleh dicapai dengan data berskala besar yang dikikis daripada Internet memenuhi keperluan data dan akan membawa kepada kemerosotan prestasi model.

Disebabkan jumlah data latihan yang agak kecil, sistem TTS semasa masih menghadapi masalah keupayaan generalisasi yang lemah.

Di bawah tetapan tugasan sifar, untuk pembesar suara yang belum muncul dalam data latihan, persamaan dan keaslian pertuturan akan menurun dengan mendadak.

Untuk menyelesaikan masalah TTS tangkapan sifar, kerja sedia ada biasanya menggunakan kaedah seperti penyesuaian pembesar suara dan pengekodan pembesar suara, yang memerlukan penalaan halus tambahan dan ciri reka bentuk yang kompleks , atau kerja struktur yang berat.

Daripada mereka bentuk rangkaian yang kompleks dan khusus untuk masalah ini, memandangkan kejayaan mereka dalam sintesis teks, para penyelidik percaya penyelesaian muktamad adalah untuk melatih model dengan sebanyak mungkin data yang pelbagai.

Model VALL-E

Dalam bidang sintesis teks, data tidak berlabel berskala besar daripada Internet dimasukkan terus ke dalam model Apabila jumlah data latihan meningkat, prestasi model adalah juga sentiasa bertambah baik.

Penyelidik memindahkan idea ini ke bidang sintesis pertuturan Model VALL-E ialah rangka kerja TTS pertama berdasarkan model bahasa, menggunakan data pertuturan yang besar, pelbagai dan berbilang penutur.

Untuk mensintesis pertuturan yang diperibadikan, model VALL-E menghasilkan token akustik yang sepadan berdasarkan token akustik dan gesaan fonem bagi rakaman 3 saat yang didaftarkan boleh mengehadkan penceramah dan maklumat kandungan.

Akhir sekali, token akustik yang dijana digunakan untuk mensintesis bentuk gelombang akhir dengan codec neural yang sepadan.

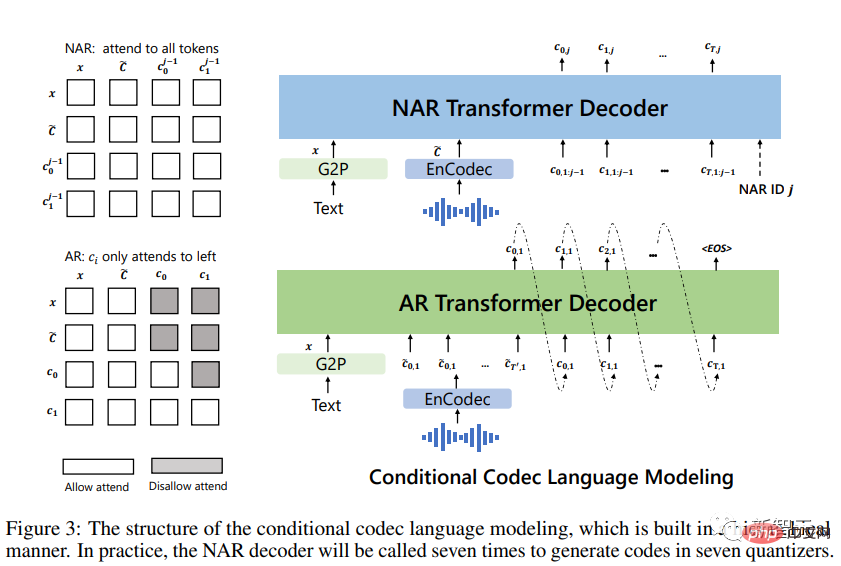

Token akustik diskret daripada model codec audio membolehkan TTS dianggap sebagai pemodelan bahasa codec bersyarat, jadi beberapa teknik model besar berasaskan petunjuk lanjutan (seperti GPT) boleh digunakan dalam tugasan TTS On.

Token akustik juga boleh menggunakan strategi pensampelan yang berbeza semasa proses inferens untuk menghasilkan hasil sintesis yang pelbagai dalam TTS.

Para penyelidik melatih VALL-E menggunakan set data LibriLight, yang terdiri daripada 60,000 jam pertuturan bahasa Inggeris dengan lebih daripada 7,000 pembesar suara unik. Data mentah adalah audio sahaja, jadi hanya model pengecaman pertuturan digunakan untuk menjana transkrip.

Berbanding dengan set data latihan TTS sebelumnya seperti LibriTTS, set data baharu yang disediakan dalam kertas kerja mengandungi lebih banyak pertuturan bising dan transkripsi yang tidak tepat, tetapi menyediakan pembesar suara dan daftar yang berbeza (prosodi ).

Para penyelidik percaya bahawa kaedah yang dicadangkan dalam artikel itu adalah teguh kepada bunyi bising dan boleh menggunakan data besar untuk mencapai umum yang baik.

Perlu diambil perhatian bahawa sistem TTS sedia ada sentiasa menggunakan berpuluh-puluh jam data pembesar suara satu bahasa atau ratusan jam data pembesar suara berbilang bahasa untuk latihan Lebih daripada ratusan kali lebih kecil daripada VALL-E.

Ringkasnya, VALL-E ialah kaedah model bahasa serba baharu untuk TTS, yang menggunakan pengekodan audio dan kod penyahkodan sebagai perwakilan perantaraan dan menggunakan sejumlah besar data berbeza untuk memberikan model keupayaan pembelajaran kontekstual yang berkuasa.

Penaakulan: Pembelajaran Dalam Konteks melalui Prompting

Pembelajaran dalam konteks ialah keupayaan menakjubkan model bahasa berasaskan teks yang boleh meramalkan label Input yang tidak kelihatan tanpa memerlukan kemas kini parameter tambahan.

Untuk TTS, jika model boleh mensintesis pertuturan berkualiti tinggi untuk pembesar suara ghaib tanpa penalaan halus, maka model tersebut dianggap mempunyai keupayaan pembelajaran kontekstual.

Walau bagaimanapun, sistem TTS sedia ada tidak mempunyai keupayaan pembelajaran dalam konteks yang kukuh kerana ia sama ada memerlukan penalaan halus tambahan atau mengalami degradasi yang ketara untuk pembesar suara yang tidak kelihatan.

Gesaan diperlukan untuk model bahasa mencapai pembelajaran konteks dalam situasi sifar pukulan.

Gesaan dan penaakulan yang direka oleh penyelidik adalah seperti berikut:

Mula-mula tukar teks ke dalam urutan fonem dan mengekodkan rakaman yang didaftarkan ke dalam matriks akustik untuk membentuk isyarat fonem dan isyarat akustik, kedua-duanya Digunakan dalam model AR dan NAR.

Untuk model AR, gunakan penyahkodan berasaskan pensampelan bersyarat pada pembayang, kerana carian pancaran boleh menyebabkan LM memasuki gelung tak terhingga di samping itu, kaedah berasaskan pensampelan boleh meningkatkan kepelbagaian output dengan ketara.

Untuk model NAR, gunakan penyahkodan tamak untuk memilih token dengan kebarangkalian tertinggi.

Akhir sekali, codec saraf digunakan untuk menjana bentuk gelombang yang dikondisikan pada lapan jujukan pengekodan.

Isyarat akustik mungkin tidak semestinya mempunyai hubungan semantik dengan pertuturan yang akan disintesis, jadi ia boleh dibahagikan kepada dua kes:

VALL-E: Matlamat utama adalah untuk penutur ghaib Menjana kandungan yang diberikan.

Input model ini ialah ayat teks, ucapan yang didaftarkan dan transkripsi yang sepadan dengannya. Tambahkan fonem transkripsi pertuturan yang didaftarkan sebagai isyarat fonem pada urutan fonem ayat yang diberikan, dan gunakan token akustik peringkat pertama pertuturan yang didaftarkan sebagai awalan akustik. Dengan isyarat fonem dan awalan akustik, VALL-E menjana token akustik untuk teks tertentu, mengklonkan suara pembesar suara.

VALL-E-continual: Menggunakan keseluruhan transkrip dan 3 saat pertama ujaran sebagai isyarat fonemik dan akustik, dan meminta model menjana kandungan berterusan.

Proses penaakulan adalah sama seperti menetapkan VALL-E, kecuali pertuturan yang didaftarkan dan pertuturan yang dijana adalah berterusan secara semantik.

Bahagian Eksperimen

Para penyelidik menilai VALL-E pada set data LibriSpeech dan VCTK, di mana semua pembesar suara yang diuji tidak muncul dalam korpus latihan.

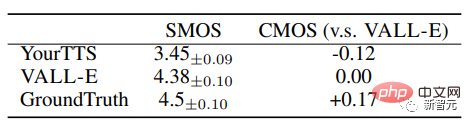

VALL-E dengan ketara mengatasi sistem TTS tangkapan sifar tercanggih dari segi keaslian pertuturan dan persamaan pembesar suara, dengan Skor Pilihan Purata Perbandingan (CMOS) sebanyak +0.12 pada LibriSpeech dan persamaan +0.93 Darjah Min Skor Pilihan (SMOS).

VALL-E juga melepasi sistem garis dasar dengan peningkatan prestasi +0.11 SMOS dan +0.23 CMOS pada VCTK, malah mencapai skor +0.04CMOS berbanding kebenaran asas, Tunjukkan bahawa pada VCTK, ucapan yang disintesis daripada pembesar suara ghaib adalah semula jadi seperti rakaman manusia.

Tambahan pula, analisis kualitatif menunjukkan bahawa VALL-E mampu mensintesis output yang berbeza dengan 2 teks yang sama dan pembesar suara sasaran, yang mungkin memanfaatkan pseudo-data untuk tugasan pengecaman pertuturan yang dibuat.

Ia juga boleh didapati dalam eksperimen bahawa VALL-E boleh mengekalkan persekitaran bunyi (seperti gema) dan emosi yang didorong oleh bunyi (seperti kemarahan, dll.).

Risiko keselamatan

Jika teknologi berkuasa disalahgunakan, ia boleh menyebabkan kemudaratan kepada masyarakat Contohnya, ambang untuk penipuan telefon telah diturunkan semula!

Disebabkan potensi VALL-E untuk melakukan kerosakan dan penipuan, Microsoft tidak membuka kod atau antara muka VALL-E untuk ujian.

Sesetengah netizen berkongsi: Jika anda menghubungi pentadbir sistem, rakam beberapa perkataan yang mereka sebut "Hello", dan kemudian sintesis semula suara berdasarkan ayat ini "Hello, saya pentadbir sistem. "Suara saya ialah pengecam unik dan boleh disahkan dengan selamat "Saya selalu fikir ini adalah mustahil. Anda tidak dapat menyelesaikan tugas ini dengan begitu sedikit data. Sekarang nampaknya saya mungkin salah...

Dalam Pernyataan Etika akhir projek, penyelidik menyatakan bahawa "eksperimen dalam artikel ini adalah berdasarkan pengguna model sebagai penceramah sasaran dan diperolehi Dilakukan di bawah andaian persetujuan penceramah bagaimanapun, apabila model digeneralisasikan kepada pembesar suara yang tidak kelihatan, bahagian yang berkaitan harus disertakan dengan model penyuntingan pertuturan, termasuk protokol untuk memastikan bahawa penceramah bersetuju untuk melakukan pengubahsuaian dan sistem untuk mengesan pertuturan yang diedit. . "

Pengarang juga menyatakan dalam makalah bahawa memandangkan VALL-E boleh mensintesis pertuturan yang mengekalkan identiti penceramah, ia mungkin membawa potensi risiko penyalahgunaan model , Seperti memalsukan pengecaman suara atau meniru pembesar suara tertentu.

Untuk mengurangkan risiko ini, model pengesanan boleh dibina untuk membezakan sama ada klip audio disintesis oleh VALL-E. Semasa kami mengembangkan lagi model ini, kami juga akan mengamalkan prinsip AI Microsoft.

Rujukan:

https://www.php.cn/link/402cac3dacf2ef35050ca72743ae6ca7

Atas ialah kandungan terperinci Ia hanya mengambil masa 3 saat untuk mencuri suara anda! Microsoft mengeluarkan model sintesis pertuturan VALL-E: Netizen menyatakan bahawa ambang untuk 'penipuan telefon' telah diturunkan semula. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1377

1377

52

52

Alamat masuk versi antarabangsa Microsoft bing (pintu masuk enjin carian bing)

Mar 14, 2024 pm 01:37 PM

Alamat masuk versi antarabangsa Microsoft bing (pintu masuk enjin carian bing)

Mar 14, 2024 pm 01:37 PM

Bing ialah enjin carian dalam talian yang dilancarkan oleh Microsoft Fungsi carian sangat berkuasa dan mempunyai dua pintu masuk: versi domestik dan versi antarabangsa. Di manakah pintu masuk ke dua versi ini? Bagaimana untuk mengakses versi antarabangsa? Mari kita lihat butiran di bawah. Pintu masuk laman web versi Cina Bing: https://cn.bing.com/ Pintu masuk laman web versi antarabangsa Bing: https://global.bing.com/ Bagaimana untuk mengakses versi antarabangsa Bing? 1. Mula-mula masukkan URL untuk membuka Bing: https://www.bing.com/ 2. Anda boleh melihat bahawa terdapat pilihan untuk versi domestik dan antarabangsa Kami hanya perlu memilih versi antarabangsa dan masukkan kata kunci.

Mengapa saya tidak dapat mendengar bunyi pada WeChat Voice? Apakah yang perlu saya lakukan jika saya tidak dapat mendengar bunyi pada WeChat Voice?

Mar 13, 2024 pm 02:31 PM

Mengapa saya tidak dapat mendengar bunyi pada WeChat Voice? Apakah yang perlu saya lakukan jika saya tidak dapat mendengar bunyi pada WeChat Voice?

Mar 13, 2024 pm 02:31 PM

Mengapa saya tidak dapat mendengar bunyi pada WeChat Voice? WeChat ialah alat komunikasi yang sangat diperlukan dalam kehidupan seharian kita. Ramai pengguna menghadapi masalah semasa penggunaan Contohnya, tidak dapat mendengar bunyi dalam suara WeChat. Jadi apa yang perlu dilakukan? Biarkan tapak ini memberi pengguna pengenalan terperinci tentang perkara yang perlu dilakukan jika mereka tidak dapat mendengar bunyi dalam suara WeChat. Apakah yang perlu saya lakukan jika saya tidak dapat mendengar bunyi dalam suara WeChat 1. Bunyi yang ditetapkan oleh sistem telefon mudah alih adalah agak rendah atau dalam keadaan senyap Dalam kes ini, anda boleh meningkatkan kelantangan atau mematikan mod senyap . 2. Fungsi pembesar suara WeChat juga mungkin tidak dihidupkan. Buka "Tetapan" dan pilih pilihan "Sembang". 3. Selepas mengklik pilihan "Sembang".

Pop timbul skrin penuh Microsoft menggesa pengguna Windows 10 untuk menyegerakan dan menaik taraf kepada Windows 11

Jun 06, 2024 am 11:35 AM

Pop timbul skrin penuh Microsoft menggesa pengguna Windows 10 untuk menyegerakan dan menaik taraf kepada Windows 11

Jun 06, 2024 am 11:35 AM

Menurut berita pada 3 Jun, Microsoft sedang aktif menghantar pemberitahuan skrin penuh kepada semua pengguna Windows 10 untuk menggalakkan mereka menaik taraf kepada sistem pengendalian Windows 11. Langkah ini melibatkan peranti yang konfigurasi perkakasannya tidak menyokong sistem baharu. Sejak 2015, Windows 10 telah menduduki hampir 70% bahagian pasaran, dengan kukuh mengukuhkan penguasaannya sebagai sistem pengendalian Windows. Walau bagaimanapun, bahagian pasaran jauh melebihi bahagian pasaran 82%, dan bahagian pasaran jauh melebihi Windows 11, yang akan dikeluarkan pada 2021. Walaupun Windows 11 telah dilancarkan selama hampir tiga tahun, penembusan pasarannya masih perlahan. Microsoft telah mengumumkan bahawa ia akan menamatkan sokongan teknikal untuk Windows 10 selepas 14 Oktober 2025 untuk memberi tumpuan lebih kepada

Microsoft mengeluarkan kemas kini kumulatif Win11 Ogos: meningkatkan keselamatan, mengoptimumkan skrin kunci, dsb.

Aug 14, 2024 am 10:39 AM

Microsoft mengeluarkan kemas kini kumulatif Win11 Ogos: meningkatkan keselamatan, mengoptimumkan skrin kunci, dsb.

Aug 14, 2024 am 10:39 AM

Menurut berita dari tapak ini pada 14 Ogos, semasa hari acara August Patch Tuesday hari ini, Microsoft mengeluarkan kemas kini kumulatif untuk sistem Windows 11, termasuk kemas kini KB5041585 untuk 22H2 dan 23H2, dan kemas kini KB5041592 untuk 21H2. Selepas peralatan yang disebutkan di atas dipasang dengan kemas kini kumulatif Ogos, perubahan nombor versi yang dilampirkan pada tapak ini adalah seperti berikut: Selepas pemasangan peralatan 21H2, nombor versi meningkat kepada Build22000.314722H2 Selepas pemasangan peralatan, nombor versi meningkat kepada Build22621.403723H2 Selepas pemasangan peralatan, nombor versi meningkat kepada Build22631.4037 Kandungan utama kemas kini KB5041585 untuk Windows 1121H2 adalah seperti berikut: Penambahbaikan.

Peningkatan Microsoft Edge: Fungsi penjimatan kata laluan automatik diharamkan? ! Pengguna terkejut!

Apr 19, 2024 am 08:13 AM

Peningkatan Microsoft Edge: Fungsi penjimatan kata laluan automatik diharamkan? ! Pengguna terkejut!

Apr 19, 2024 am 08:13 AM

Berita pada 18 April: Baru-baru ini, beberapa pengguna pelayar Microsoft Edge menggunakan saluran Canary melaporkan bahawa selepas menaik taraf kepada versi terkini, mereka mendapati bahawa pilihan untuk menyimpan kata laluan secara automatik telah dilumpuhkan. Selepas penyiasatan, didapati bahawa ini adalah pelarasan kecil selepas naik taraf penyemak imbas, bukannya pembatalan fungsi. Sebelum menggunakan penyemak imbas Edge untuk mengakses laman web, pengguna melaporkan bahawa penyemak imbas akan muncul tetingkap bertanya sama ada mereka mahu menyimpan kata laluan log masuk untuk tapak web tersebut. Selepas memilih untuk menyimpan, Edge secara automatik akan mengisi akaun dan kata laluan yang disimpan apabila anda log masuk seterusnya, memberikan pengguna kemudahan yang hebat. Tetapi kemas kini terkini menyerupai tweak, menukar tetapan lalai. Pengguna perlu memilih untuk menyimpan kata laluan dan kemudian menghidupkan pengisian automatik akaun yang disimpan dan kata laluan dalam tetapan.

Fungsi Microsoft Win11 untuk memampatkan fail 7z dan TAR telah diturunkan daripada versi 24H2 kepada 23H2/22H2

Apr 28, 2024 am 09:19 AM

Fungsi Microsoft Win11 untuk memampatkan fail 7z dan TAR telah diturunkan daripada versi 24H2 kepada 23H2/22H2

Apr 28, 2024 am 09:19 AM

Menurut berita dari laman web ini pada 27 April, Microsoft mengeluarkan kemas kini versi pratonton Windows 11 Build 26100 ke saluran Canary dan Dev awal bulan ini, yang dijangka menjadi calon versi RTM bagi kemas kini Windows 1124H2. Perubahan utama dalam versi baharu ialah peneroka fail, penyepaduan Copilot, penyuntingan metadata fail PNG, penciptaan fail termampat TAR dan 7z, dsb. @PhantomOfEarth mendapati bahawa Microsoft telah menurunkan beberapa fungsi versi 24H2 (Germanium) kepada versi 23H2/22H2 (Nikel), seperti mencipta fail mampat TAR dan 7z. Seperti yang ditunjukkan dalam rajah, Windows 11 akan menyokong penciptaan asli TAR

Kemas kini pelayar Microsoft Edge: Menambah fungsi 'zum dalam imej' untuk meningkatkan pengalaman pengguna

Mar 21, 2024 pm 01:40 PM

Kemas kini pelayar Microsoft Edge: Menambah fungsi 'zum dalam imej' untuk meningkatkan pengalaman pengguna

Mar 21, 2024 pm 01:40 PM

Menurut berita pada 21 Mac, Microsoft baru-baru ini mengemas kini pelayar Microsoft Edge dan menambah fungsi "besarkan imej" praktikal. Kini, apabila menggunakan pelayar Edge, pengguna boleh mencari ciri baharu ini dengan mudah dalam menu pop timbul dengan hanya mengklik kanan pada imej. Apa yang lebih mudah ialah pengguna juga boleh menuding kursor pada imej dan kemudian klik dua kali kekunci Ctrl untuk menggunakan fungsi mengezum masuk dengan cepat pada imej. Mengikut pemahaman editor, pelayar Microsoft Edge yang baru dikeluarkan telah diuji untuk ciri-ciri baru dalam saluran Canary. Versi pelayar yang stabil juga secara rasminya telah melancarkan fungsi "besarkan imej" praktikal, memberikan pengguna pengalaman menyemak imbas imej yang lebih mudah. Media sains dan teknologi asing turut memberi perhatian kepada perkara ini

Microsoft merancang untuk menghapuskan NTLM secara berperingkat dalam Windows 11 pada separuh kedua 2024 dan beralih sepenuhnya kepada pengesahan Kerberos

Jun 09, 2024 pm 04:17 PM

Microsoft merancang untuk menghapuskan NTLM secara berperingkat dalam Windows 11 pada separuh kedua 2024 dan beralih sepenuhnya kepada pengesahan Kerberos

Jun 09, 2024 pm 04:17 PM

Pada separuh kedua 2024, Blog Keselamatan Microsoft rasmi menerbitkan mesej sebagai respons kepada panggilan daripada komuniti keselamatan. Syarikat itu merancang untuk menghapuskan protokol pengesahan Pengurus NTLAN (NTLM) dalam Windows 11, dikeluarkan pada separuh kedua 2024, untuk meningkatkan keselamatan. Menurut penjelasan sebelum ini, Microsoft telah pun membuat langkah serupa sebelum ini. Pada 12 Oktober tahun lepas, Microsoft mencadangkan pelan peralihan dalam siaran akhbar rasmi yang bertujuan untuk menghapuskan kaedah pengesahan NTLM secara berperingkat dan mendorong lebih banyak perusahaan dan pengguna beralih kepada Kerberos. Untuk membantu perusahaan yang mungkin mengalami masalah dengan aplikasi dan perkhidmatan berwayar tegar selepas mematikan pengesahan NTLM, Microsoft menyediakan IAKerb dan