Peranti teknologi

Peranti teknologi

AI

AI

Pembangunan AI Bersatu: Google OpenXLA ialah sumber terbuka dan menyepadukan semua rangka kerja dan cip AI

Pembangunan AI Bersatu: Google OpenXLA ialah sumber terbuka dan menyepadukan semua rangka kerja dan cip AI

Pembangunan AI Bersatu: Google OpenXLA ialah sumber terbuka dan menyepadukan semua rangka kerja dan cip AI

Pada acara Google Cloud Next 2022 pada Oktober tahun lalu, projek OpenXLA muncul secara rasmi Google bekerjasama dengan rangka kerja AI sumber terbuka yang dipromosikan oleh syarikat teknologi termasuk Alibaba, AMD, Arm, Amazon, Intel, Nvidia dan lain-lain. syarikat teknologi komited untuk menyatukan rangka kerja pembelajaran mesin yang berbeza untuk membolehkan pembangun pembelajaran mesin memilih rangka kerja dan perkakasan secara proaktif.

Pada hari Rabu, Google mengumumkan bahawa projek OpenXLA secara rasminya adalah sumber terbuka.

Pautan projek: https://github.com/openxla/xla

Dengan mencipta pengkompil pembelajaran mesin bersatu yang berfungsi dengan pelbagai rangka kerja pembelajaran mesin dan platform perkakasan, OpenXLA boleh mempercepatkan penghantaran aplikasi pembelajaran mesin dan menyediakan kemudahalihan kod yang lebih besar. Ini merupakan projek penting untuk penyelidikan dan aplikasi AI, dan Jeff Dean turut mempromosikannya di rangkaian sosial.

Hari ini, pembangunan dan penggunaan pembelajaran mesin mengalami infrastruktur berpecah-belah yang boleh terjejas oleh rangka kerja, Berbeza mengikut perkakasan dan penggunaan kes. Pengasingan ini mengehadkan kelajuan pembangun boleh bekerja dan mewujudkan halangan kepada kemudahalihan model, kecekapan dan pengeluaran.

Pada 8 Mac, Google dan yang lain telah mengambil langkah besar ke arah mengalih keluar halangan ini dengan pembukaan projek OpenXLA, yang merangkumi repositori XLA, StableHLO dan IREE.

OpenXLA ialah ekosistem pengkompil ML sumber terbuka yang dibangunkan bersama oleh pemimpin industri pembelajaran AI/mesin Penyumbang termasuk Alibaba, AWS, AMD, Apple, Arm, Cerebras, Google, Graphcore, Hugging Face , Intel, Meta dan Nvidia. Ia membolehkan pembangun menyusun dan mengoptimumkan model daripada semua rangka kerja pembelajaran mesin terkemuka untuk latihan yang cekap dan berkhidmat pada pelbagai perkakasan. Pembangun yang menggunakan OpenXLA boleh melihat peningkatan yang ketara dalam masa latihan, pemprosesan, kependaman perkhidmatan, dan akhirnya mengeluarkan dan mengira kos.

Cabaran yang dihadapi kemudahan teknologi pembelajaran mesin

Ketika teknologi AI memasuki peringkat praktikal, pasukan pembangunan dalam banyak industri menggunakan pembelajaran mesin untuk menangani cabaran dunia sebenar ramalan dan pencegahan penyakit, pengalaman pembelajaran yang diperibadikan, dan penerokaan fizik lubang hitam.

Dengan bilangan parameter model yang berkembang pesat dan jumlah pengiraan yang diperlukan untuk model pembelajaran mendalam meningkat dua kali ganda setiap enam bulan, pembangun mencari prestasi maksimum dan penggunaan infrastruktur mereka . Sebilangan besar pasukan memanfaatkan pelbagai model perkakasan, daripada ASIC khusus pembelajaran mesin yang cekap tenaga di pusat data kepada pemproses kelebihan AI yang memberikan masa tindak balas yang lebih pantas. Sehubungan itu, untuk meningkatkan kecekapan, peranti perkakasan ini menggunakan algoritma dan perpustakaan perisian yang disesuaikan dan unik.

Tetapi sebaliknya, jika tiada pengkompil universal untuk menghubungkan peranti perkakasan yang berbeza kepada pelbagai rangka kerja yang digunakan hari ini (seperti TensorFlow, PyTorch), orang ramai perlu memasukkan banyak usaha untuk Menjalankan pembelajaran mesin dengan cekap. Dalam amalan, pembangun mesti mengoptimumkan operasi model secara manual untuk setiap sasaran perkakasan. Ini bermakna menggunakan perpustakaan perisian tersuai atau menulis kod khusus peranti memerlukan kepakaran domain.

Ini adalah satu paradoks, menggunakan teknologi proprietari untuk kecekapan hanya menghasilkan laluan terdiam, tidak boleh digeneralisasikan merentas rangka kerja dan perkakasan yang mengakibatkan kos penyelenggaraan yang tinggi dan seterusnya mengunci vendor, memperlahankan kemajuan pembangunan pembelajaran mesin.

Penyelesaian dan Matlamat

Projek OpenXLA menyediakan pengkompil ML tercanggih yang merentasi kerumitan infrastruktur ML. Teras terasnya ialah prestasi, kebolehskalaan, mudah alih, fleksibiliti dan kemudahan penggunaan. Dengan OpenXLA, kami berhasrat untuk merealisasikan potensi AI yang lebih besar dalam dunia nyata dengan mempercepatkan pembangunan dan penyampaian AI.

OpenXLA bertujuan untuk:

- Membolehkan pembangun menyusun dan mengoptimumkan mana-mana model dengan mudah dalam rangka kerja pilihan mereka untuk pelbagai perkakasan dengan API pengkompil bersatu yang berfungsi dengan mana-mana rangka kerja dan dipalamkan ke bahagian belakang dan pengoptimuman peranti khusus.

- Menyediakan prestasi peneraju industri untuk model semasa dan baru muncul, dan juga boleh ditingkatkan kepada berbilang hos dan pemecut untuk memenuhi kekangan penggunaan kelebihan dan mempromosikan kepada seni bina model baharu pada masa hadapan.

- Membina platform pengkompil pembelajaran mesin berlapis dan berskala yang menyediakan pembangun dengan komponen berasaskan MLIR yang boleh dikonfigurasikan semula untuk kes penggunaan unik mereka untuk proses penyusunan tersuai perkakasan.

Komuniti Pemimpin AI/ML

Cabaran yang kita hadapi hari ini dalam infrastruktur pembelajaran mesin adalah sangat besar dan tiada satu organisasi boleh melakukannya sendiri secara berkesan menangani cabaran ini . Komuniti OpenXLA menghimpunkan pembangun dan peneraju industri yang beroperasi pada tahap tindanan AI yang berbeza—daripada rangka kerja kepada penyusun, masa jalan dan cip—dan oleh itu amat sesuai untuk menangani pemecahan yang kita lihat dalam ruang ML.

Sebagai projek sumber terbuka, OpenXLA mematuhi prinsip berikut:

- Status yang sama: Individu melakukan perkara yang sama tanpa mengira gabungan. sesuatu sumbangan. Pemimpin teknikal adalah mereka yang menyumbang paling banyak masa dan tenaga.

- Budaya Hormat-menghormati: Semua ahli diharap untuk menegakkan nilai projek dan tatakelakuan, tanpa mengira kedudukan mereka dalam komuniti.

- Tadbir urus yang berskala dan cekap: Pasukan kecil membuat keputusan berdasarkan konsensus, dengan laluan naik taraf yang jelas tetapi jarang digunakan.

- Ketelusan: Semua keputusan dan rasional harus dapat dilihat dengan jelas kepada orang ramai.

Ekosistem OpenXLA: Prestasi, Skala dan Mudah Alih

OpenXLA menghilangkan halangan untuk pembangun pembelajaran mesin dengan rantai alat modular yang menjadikannya tersedia secara universal Antara muka pengkompil ialah disokong oleh semua rangka kerja terkemuka, memanfaatkan perwakilan model piawai mudah alih dan menyediakan penyusun khusus domain dengan pengoptimuman khusus sasaran dan khusus perkakasan yang berkuasa. Rantaian alat termasuk XLA, StableHLO dan IREE, yang semuanya memanfaatkan MLIR: infrastruktur pengkompil yang membolehkan model pembelajaran mesin diwakili, dioptimumkan dan dilaksanakan secara konsisten pada perkakasan.

Sorotan Utama OpenXLA

Skop Kes Penggunaan Pembelajaran Mesin

Penggunaan OpenXLA semasa menjangkau julat kes penggunaan ML, termasuk latihan penuh model seperti DeepMind's AlphaFold, GPT2 dan Swin Transformer di Alibaba Cloud, serta pelbagai mod di Amazon.com Latihan LLM. Pelanggan seperti Waymo memanfaatkan OpenXLA untuk inferens masa nyata dalam kenderaan. Selain itu, OpenXLA digunakan untuk mengoptimumkan perkhidmatan Stable Diffusion pada mesin tempatan yang dilengkapi dengan AMD RDNA™ 3.

Prestasi terbaik, di luar kotak

OpenXLA menghapuskan keperluan untuk pembangun menulis kod khusus peranti, Anda boleh mempercepatkan prestasi model dengan mudah. Ia menampilkan keupayaan pengoptimuman model keseluruhan, termasuk memudahkan ungkapan algebra, mengoptimumkan susun atur data dalam memori, dan menambah baik penjadualan untuk mengurangkan penggunaan memori puncak dan overhed komunikasi. Gabungan operator lanjutan dan penjanaan kernel membantu meningkatkan penggunaan peranti dan mengurangkan keperluan lebar jalur memori.

Menskalakan beban kerja dengan mudah

Membangunkan algoritma penyejajaran yang cekap memakan masa dan memerlukan kepakaran. Dengan ciri seperti GSPMD, pembangun hanya perlu menganotasi subset tensor utama, yang kemudiannya boleh digunakan oleh pengkompil untuk menjana pengiraan selari secara automatik. Ini menghapuskan usaha penting yang diperlukan untuk membahagi dan menyelaraskan model dengan cekap merentas berbilang hos perkakasan dan pemecut.

Kemudahalihan dan Pilihan

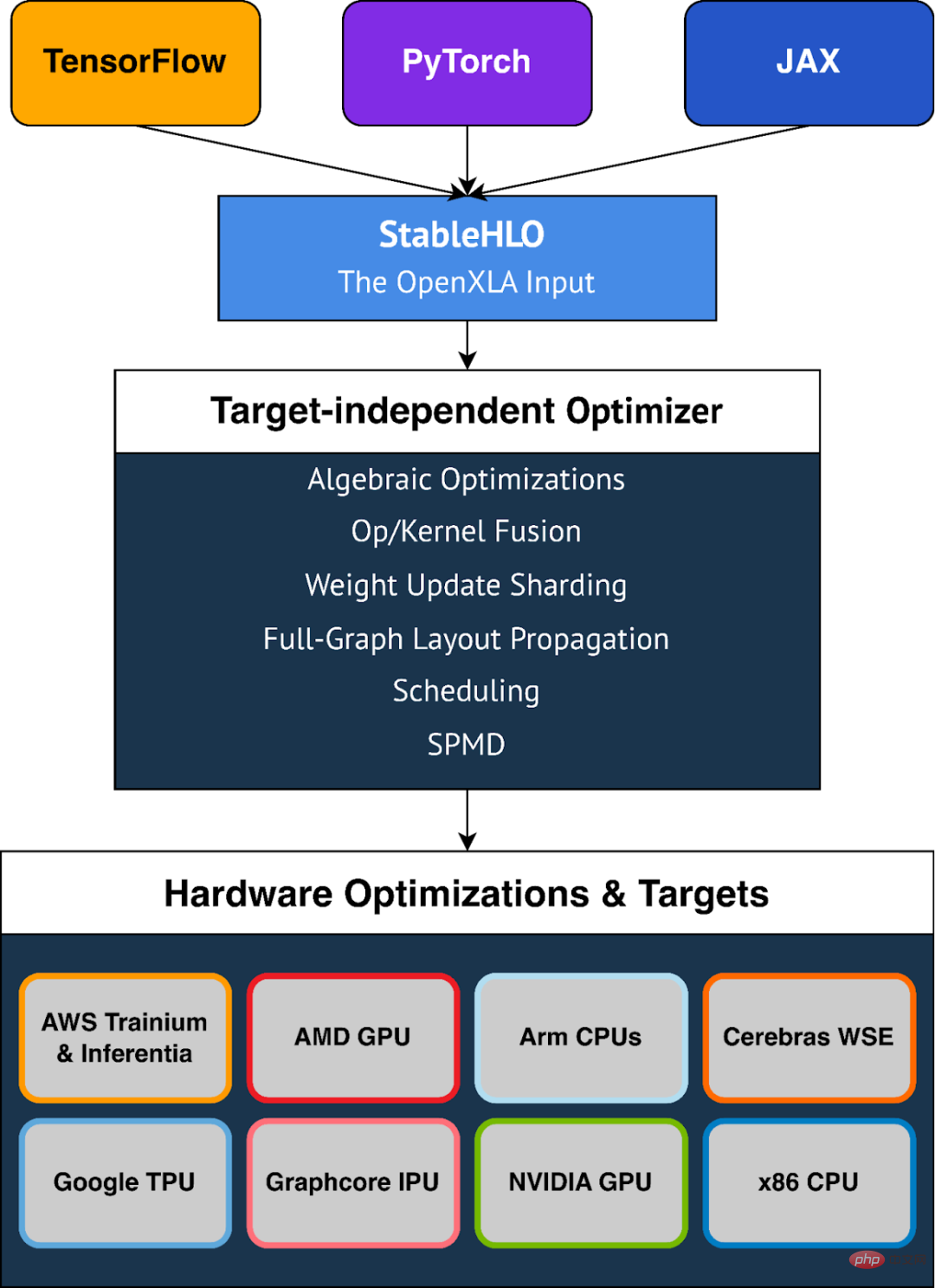

OpenXLA menyediakan sokongan luar kotak untuk pelbagai peranti perkakasan, Termasuk GPU AMD dan NVIDIA, CPU x86 dan seni bina Arm, dan pemecut ML seperti Google TPU, AWS Trainium dan Inferentia, IPU Graphcore, Enjin Skala Wafer Cerebras dan banyak lagi. OpenXLA juga menyokong TensorFlow, PyTorch, dan JAX melalui StableHLO, lapisan mudah alih yang digunakan sebagai format input untuk OpenXLA.

Fleksibiliti

OpenXLA menyediakan pengguna dengan fleksibiliti untuk melaraskan hotspot model secara manual. Mekanisme pelanjutan seperti panggilan tersuai membolehkan pengguna menulis primitif pembelajaran mendalam dalam CUDA, HIP, SYCL, Triton dan bahasa kernel lain untuk memanfaatkan sepenuhnya ciri perkakasan.

StableHLO

StableHLO ialah lapisan mudah alih antara rangka kerja ML dan penyusun ML dan merupakan sokongan Satu set tinggi -operasi tahap (HLO) untuk dinamik, pengkuantitian, dan jarang. Selain itu, ia boleh disirikan kepada kod bait MLIR untuk memberikan jaminan keserasian. Semua rangka kerja ML utama (JAX, PyTorch, TensorFlow) boleh menghasilkan StableHLO. Pada tahun 2023, Google merancang untuk bekerjasama rapat dengan pasukan PyTorch untuk mencapai penyepaduan dengan PyTorch versi 2.0.

Atas ialah kandungan terperinci Pembangunan AI Bersatu: Google OpenXLA ialah sumber terbuka dan menyepadukan semua rangka kerja dan cip AI. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

Apakah yang dimaksudkan dengan transaksi rantaian rantaian? Apakah urus niaga salib?

Apr 21, 2025 pm 11:39 PM

Apakah yang dimaksudkan dengan transaksi rantaian rantaian? Apakah urus niaga salib?

Apr 21, 2025 pm 11:39 PM

Pertukaran yang menyokong urus niaga rantaian: 1. Binance, 2. Uniswap, 3 Sushiswap, 4. Kewangan Curve, 5. Thorchain, 6. 1 inci Pertukaran, 7.

Platform Perdagangan Web3 Ranking_Web3 Global Exchanges Top Ten Ringkasan

Apr 21, 2025 am 10:45 AM

Platform Perdagangan Web3 Ranking_Web3 Global Exchanges Top Ten Ringkasan

Apr 21, 2025 am 10:45 AM

Binance adalah tuan rumah ekosistem perdagangan aset digital global, dan ciri -cirinya termasuk: 1. Jumlah dagangan harian purata melebihi $ 150 bilion, menyokong 500 pasangan perdagangan, yang meliputi 98% mata wang arus perdana; 2. Matriks inovasi meliputi pasaran Derivatif, susun atur Web3 dan sistem pendidikan; 3. Kelebihan teknikal adalah enjin yang sepadan dengan milisaat, dengan jumlah pemprosesan puncak sebanyak 1.4 juta transaksi sesaat; 4. Kemajuan pematuhan memegang lesen 15 negara dan menetapkan entiti yang mematuhi di Eropah dan Amerika Syarikat.

Ramalan Harga Worldcoin (WLD) 2025-2031: Adakah WLD akan mencapai $ 4 menjelang 2031?

Apr 21, 2025 pm 02:42 PM

Ramalan Harga Worldcoin (WLD) 2025-2031: Adakah WLD akan mencapai $ 4 menjelang 2031?

Apr 21, 2025 pm 02:42 PM

Worldcoin (WLD) menonjol dalam pasaran cryptocurrency dengan mekanisme pengesahan biometrik dan perlindungan privasi yang unik, menarik perhatian banyak pelabur. WLD telah melakukan yang luar biasa di kalangan altcoin dengan teknologi inovatifnya, terutamanya dalam kombinasi dengan teknologi kecerdasan buatan terbuka. Tetapi bagaimanakah aset digital akan berkelakuan dalam beberapa tahun akan datang? Mari kita meramalkan harga masa depan WLD bersama -sama. Ramalan harga WLD 2025 dijangka mencapai pertumbuhan yang signifikan di WLD pada tahun 2025. Analisis pasaran menunjukkan bahawa harga WLD purata boleh mencapai $ 1.31, dengan maksimum $ 1.36. Walau bagaimanapun, dalam pasaran beruang, harga mungkin jatuh ke sekitar $ 0.55. Harapan pertumbuhan ini disebabkan terutamanya oleh WorldCoin2.

'Black Monday Sell' adalah hari yang sukar untuk industri cryptocurrency

Apr 21, 2025 pm 02:48 PM

'Black Monday Sell' adalah hari yang sukar untuk industri cryptocurrency

Apr 21, 2025 pm 02:48 PM

Jatuh di pasaran cryptocurrency telah menyebabkan panik di kalangan pelabur, dan Dogecoin (Doge) telah menjadi salah satu kawasan terkena paling sukar. Harganya jatuh dengan ketara, dan jumlah nilai kunci kewangan yang terdesentralisasi (DEFI) (TVL) juga menyaksikan penurunan yang ketara. Gelombang jualan "Black Monday" menyapu pasaran cryptocurrency, dan Dogecoin adalah yang pertama dipukul. Defitvlnya jatuh ke tahap 2023, dan harga mata wang jatuh 23.78% pada bulan lalu. Defitvl Dogecoin jatuh ke tahap rendah $ 2.72 juta, terutamanya disebabkan oleh penurunan 26.37% dalam indeks nilai SOSO. Platform defi utama lain, seperti DAO dan Thorchain yang membosankan, TVL juga menurun sebanyak 24.04% dan 20.

Kedudukan pertukaran leverage dalam lingkaran mata wang Cadangan terkini sepuluh pertukaran leverage dalam lingkaran mata wang

Apr 21, 2025 pm 11:24 PM

Kedudukan pertukaran leverage dalam lingkaran mata wang Cadangan terkini sepuluh pertukaran leverage dalam lingkaran mata wang

Apr 21, 2025 pm 11:24 PM

Platform yang mempunyai prestasi cemerlang dalam perdagangan, keselamatan dan pengalaman pengguna yang dimanfaatkan pada tahun 2025 adalah: 1. Okx, sesuai untuk peniaga frekuensi tinggi, menyediakan sehingga 100 kali leverage; 2. Binance, sesuai untuk peniaga berbilang mata wang di seluruh dunia, memberikan 125 kali leverage tinggi; 3. Gate.io, sesuai untuk pemain derivatif profesional, menyediakan 100 kali leverage; 4. Bitget, sesuai untuk orang baru dan peniaga sosial, menyediakan sehingga 100 kali leverage; 5. Kraken, sesuai untuk pelabur mantap, menyediakan 5 kali leverage; 6. Bybit, sesuai untuk penjelajah altcoin, menyediakan 20 kali leverage; 7. Kucoin, sesuai untuk peniaga kos rendah, menyediakan 10 kali leverage; 8. Bitfinex, sesuai untuk bermain senior

Mengapa kenaikan atau kejatuhan harga mata wang maya? Mengapa kenaikan atau kejatuhan harga mata wang maya?

Apr 21, 2025 am 08:57 AM

Mengapa kenaikan atau kejatuhan harga mata wang maya? Mengapa kenaikan atau kejatuhan harga mata wang maya?

Apr 21, 2025 am 08:57 AM

Faktor kenaikan harga mata wang maya termasuk: 1. Peningkatan permintaan pasaran, 2. Menurunkan bekalan, 3. Berita positif yang dirangsang, 4. Sentimen pasaran optimis, 5. Persekitaran makroekonomi; Faktor penurunan termasuk: 1. Mengurangkan permintaan pasaran, 2. Peningkatan bekalan, 3.

Cara Memenangi Ganjaran Airdrop Kernel pada Strategi Proses Penuh Binance

Apr 21, 2025 pm 01:03 PM

Cara Memenangi Ganjaran Airdrop Kernel pada Strategi Proses Penuh Binance

Apr 21, 2025 pm 01:03 PM

Dalam dunia kriptografi yang ramai, peluang baru selalu muncul. Pada masa ini, aktiviti udara Kerneldao (kernel) menarik banyak perhatian dan menarik perhatian banyak pelabur. Jadi, apakah asalnya projek ini? Apakah faedah yang boleh diperoleh oleh pemegang BNB? Jangan risau, perkara berikut akan mendedahkannya satu demi satu untuk anda.

Aavenomics adalah cadangan untuk mengubah suai token protokol AAVE dan memperkenalkan pembelian semula token, yang telah mencapai bilangan kuorum orang.

Apr 21, 2025 pm 06:24 PM

Aavenomics adalah cadangan untuk mengubah suai token protokol AAVE dan memperkenalkan pembelian semula token, yang telah mencapai bilangan kuorum orang.

Apr 21, 2025 pm 06:24 PM

Aavenomics adalah cadangan untuk mengubah token protokol AAVE dan memperkenalkan repos token, yang telah melaksanakan kuorum untuk Aavedao. Marc Zeller, pengasas Rantaian Projek AAVE (ACI), mengumumkan ini pada X, dengan menyatakan bahawa ia menandakan era baru untuk perjanjian itu. Marc Zeller, pengasas Inisiatif Rantaian AAVE (ACI), mengumumkan pada X bahawa cadangan aavenomik termasuk mengubah token protokol AAVE dan memperkenalkan repos token, telah mencapai kuorum untuk Aavedao. Menurut Zeller, ini menandakan era baru untuk perjanjian itu. Ahli -ahli Aavedao mengundi untuk menyokong cadangan itu, yang 100 seminggu pada hari Rabu