Pengecaman Imej: Rangkaian Neural Konvolusi

Artikel ini dicetak semula daripada akaun awam WeChat "Hidup dalam Era Maklumat" Pengarang hidup dalam era maklumat. Untuk mencetak semula artikel ini, sila hubungi akaun awam Living in the Information Age.

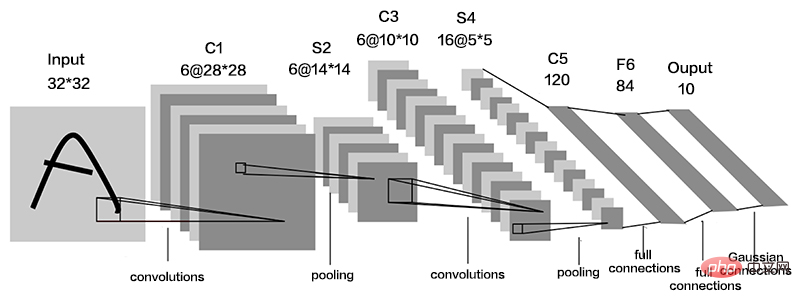

Rangkaian Neural Konvolusi (CNN) ialah rangkaian suapan hadapan dalam khas, yang secara amnya merangkumi lapisan input data, lapisan konvolusi, lapisan pengaktifan dan lapisan pensampelan bawah dan sepenuhnya lapisan bersambung.

Lapisan konvolusi ialah unit penting dalam rangkaian neural konvolusi Ia terdiri daripada satu siri penapisan data Intipati kernel lilitan ialah proses superposisi linear jumlah wajaran kawasan setempat imej dan berat isirong lilitan. Imej I digunakan sebagai input, dan kernel lilitan dua dimensi K digunakan untuk lilitan Proses lilitan boleh dinyatakan sebagai:

Antaranya, I(i,j) ialah nilai imej pada kedudukan (i,j), dan S(i,j) ialah peta ciri yang diperoleh selepas operasi lilitan.

Operasi lilitan pengaktifan adalah linear dan hanya boleh melakukan pemetaan linear, dengan keupayaan ekspresi terhad. Oleh itu, untuk menangani masalah pemetaan tak linear, adalah perlu untuk memperkenalkan fungsi pengaktifan tak linear. Untuk menangani masalah bukan linear yang berbeza, fungsi pengaktifan yang diperkenalkan juga berbeza Fungsi yang biasa digunakan ialah sigmoid, tanh, relu, dsb.

Ungkapan fungsi Sigmoid ialah:

Ungkapan fungsi Tanh ialah:

Ungkapan fungsi Relu formula ialah:

Lapisan pensampelan turun juga dipanggil lapisan pengumpulan, dan biasanya diletakkan selepas beberapa lapisan konvolusi mengurangkan saiz imej ciri. Fungsi pengumpulan menggunakan ciri statistik keseluruhan output jiran pada kedudukan tertentu untuk menggantikan output rangkaian pada kedudukan itu. Secara amnya, lapisan pengumpulan mempunyai tiga fungsi: Pertama, ia mengurangkan dimensi ciri Operasi pengumpulan adalah setara dengan proses pengekstrakan ciri lain, yang boleh mengalih keluar maklumat berlebihan dan mengurangkan volum pemprosesan data lapisan seterusnya. Yang kedua adalah untuk mengelakkan overfitting, dan operasi pengumpulan memperoleh maklumat yang lebih abstrak dan meningkatkan generalisasi. Yang ketiga adalah untuk mengekalkan invarian ciri, dan operasi pengumpulan mengekalkan ciri yang paling penting.

Lapisan yang bersambung sepenuhnya biasanya diletakkan pada penghujung rangkaian neural konvolusi, dan semua neuron antara lapisan mempunyai sambungan berwajaran. Tujuannya adalah untuk memetakan semua ciri yang dipelajari dalam rangkaian ke ruang label sampel untuk membuat pertimbangan kategori. Fungsi Softmax biasanya digunakan dalam lapisan terakhir rangkaian saraf sebagai output pengelas Setiap nilai output oleh fungsi softmax berjulat antara (0, 1).

Terdapat beberapa model CNN klasik dan cekap, seperti: VGGNet, ResNet, AlexNet, dll., yang telah digunakan secara meluas dalam bidang pengecaman imej.

Atas ialah kandungan terperinci Pengecaman Imej: Rangkaian Neural Konvolusi. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1658

1658

14

14

1415

1415

52

52

1309

1309

25

25

1257

1257

29

29

1231

1231

24

24

Asas, sempadan dan aplikasi GNN

Apr 11, 2023 pm 11:40 PM

Asas, sempadan dan aplikasi GNN

Apr 11, 2023 pm 11:40 PM

Rangkaian saraf graf (GNN) telah mencapai kemajuan yang pesat dan luar biasa dalam beberapa tahun kebelakangan ini. Rangkaian saraf graf, juga dikenali sebagai pembelajaran dalam graf, pembelajaran perwakilan graf (pembelajaran perwakilan graf) atau pembelajaran dalam geometri, ialah topik penyelidikan yang paling pesat berkembang dalam bidang pembelajaran mesin, terutamanya pembelajaran mendalam. Tajuk perkongsian ini ialah "Asas, Sempadan dan Aplikasi GNN", yang terutamanya memperkenalkan kandungan umum buku komprehensif "Asas, Sempadan dan Aplikasi Rangkaian Neural Graf" yang disusun oleh sarjana Wu Lingfei, Cui Peng, Pei Jian dan Zhao Liang. 1. Pengenalan kepada rangkaian neural graf 1. Mengapa mengkaji graf? Graf ialah bahasa universal untuk menerangkan dan memodelkan sistem yang kompleks. Graf itu sendiri tidak rumit, ia terutamanya terdiri daripada tepi dan nod. Kita boleh menggunakan nod untuk mewakili mana-mana objek yang ingin kita modelkan, dan tepi untuk mewakili dua

YOLO adalah abadi! YOLOv9 dikeluarkan: prestasi dan kelajuan SOTA~

Feb 26, 2024 am 11:31 AM

YOLO adalah abadi! YOLOv9 dikeluarkan: prestasi dan kelajuan SOTA~

Feb 26, 2024 am 11:31 AM

Kaedah pembelajaran mendalam hari ini memberi tumpuan kepada mereka bentuk fungsi objektif yang paling sesuai supaya keputusan ramalan model paling hampir dengan situasi sebenar. Pada masa yang sama, seni bina yang sesuai mesti direka bentuk untuk mendapatkan maklumat yang mencukupi untuk ramalan. Kaedah sedia ada mengabaikan fakta bahawa apabila data input mengalami pengekstrakan ciri lapisan demi lapisan dan transformasi spatial, sejumlah besar maklumat akan hilang. Artikel ini akan menyelidiki isu penting apabila menghantar data melalui rangkaian dalam, iaitu kesesakan maklumat dan fungsi boleh balik. Berdasarkan ini, konsep maklumat kecerunan boleh atur cara (PGI) dicadangkan untuk menghadapi pelbagai perubahan yang diperlukan oleh rangkaian dalam untuk mencapai pelbagai objektif. PGI boleh menyediakan maklumat input lengkap untuk tugas sasaran untuk mengira fungsi objektif, dengan itu mendapatkan maklumat kecerunan yang boleh dipercayai untuk mengemas kini berat rangkaian. Di samping itu, rangka kerja rangkaian ringan baharu direka bentuk

Gambaran keseluruhan tiga seni bina cip arus perdana untuk pemanduan autonomi dalam satu artikel

Apr 12, 2023 pm 12:07 PM

Gambaran keseluruhan tiga seni bina cip arus perdana untuk pemanduan autonomi dalam satu artikel

Apr 12, 2023 pm 12:07 PM

Cip AI arus perdana semasa terutamanya dibahagikan kepada tiga kategori: GPU, FPGA dan ASIC. Kedua-dua GPU dan FPGA adalah seni bina cip yang agak matang pada peringkat awal dan merupakan cip kegunaan umum. ASIC ialah cip yang disesuaikan untuk senario AI tertentu. Industri telah mengesahkan bahawa CPU tidak sesuai untuk pengkomputeran AI, tetapi ia juga penting dalam aplikasi AI. Seni Bina Penyelesaian GPU Perbandingan antara GPU dan CPU CPU mengikut seni bina von Neumann, terasnya ialah penyimpanan atur cara/data dan pelaksanaan bersiri. Oleh itu, seni bina CPU memerlukan sejumlah besar ruang untuk meletakkan unit storan (Cache) dan unit kawalan (Control) Sebaliknya, unit pengkomputeran (ALU) hanya menduduki sebahagian kecil, jadi CPU berfungsi secara besar-besaran. pengkomputeran selari.

'Pemilik Bilibili UP berjaya mencipta rangkaian neural berasaskan batu merah pertama di dunia, yang menyebabkan sensasi di media sosial dan dipuji oleh Yann LeCun.'

May 07, 2023 pm 10:58 PM

'Pemilik Bilibili UP berjaya mencipta rangkaian neural berasaskan batu merah pertama di dunia, yang menyebabkan sensasi di media sosial dan dipuji oleh Yann LeCun.'

May 07, 2023 pm 10:58 PM

Dalam Minecraft, batu merah adalah item yang sangat penting. Ia adalah bahan unik dalam permainan Suis, obor batu merah, dan blok batu merah boleh memberikan tenaga seperti elektrik kepada wayar atau objek. Litar Redstone boleh digunakan untuk membina struktur untuk anda mengawal atau mengaktifkan jentera lain Ia sendiri boleh direka bentuk untuk bertindak balas kepada pengaktifan manual oleh pemain, atau mereka boleh mengeluarkan isyarat berulang kali atau bertindak balas kepada perubahan yang disebabkan oleh bukan pemain, seperti pergerakan makhluk. dan item Jatuh, pertumbuhan tumbuhan, siang dan malam, dan banyak lagi. Oleh itu, dalam dunia saya, redstone boleh mengawal pelbagai jenis jentera, daripada jentera ringkas seperti pintu automatik, suis lampu dan bekalan kuasa strob, kepada lif besar, ladang automatik, platform permainan kecil dan juga komputer binaan dalam permainan . Baru-baru ini, stesen B UP utama @

1.3ms mengambil masa 1.3ms! Seni bina rangkaian neural mudah alih sumber terbuka terbaru Tsinghua RepViT

Mar 11, 2024 pm 12:07 PM

1.3ms mengambil masa 1.3ms! Seni bina rangkaian neural mudah alih sumber terbuka terbaru Tsinghua RepViT

Mar 11, 2024 pm 12:07 PM

Alamat kertas: https://arxiv.org/abs/2307.09283 Alamat kod: https://github.com/THU-MIG/RepViTRepViT berprestasi baik dalam seni bina ViT mudah alih dan menunjukkan kelebihan yang ketara. Seterusnya, kami meneroka sumbangan kajian ini. Disebutkan dalam artikel bahawa ViT ringan biasanya berprestasi lebih baik daripada CNN ringan pada tugas visual, terutamanya disebabkan oleh modul perhatian diri berbilang kepala (MSHA) mereka yang membolehkan model mempelajari perwakilan global. Walau bagaimanapun, perbezaan seni bina antara ViT ringan dan CNN ringan belum dikaji sepenuhnya. Dalam kajian ini, penulis menyepadukan ViT ringan ke dalam yang berkesan

Berbilang laluan, berbilang domain, merangkumi semua! Google AI mengeluarkan model am pembelajaran berbilang domain MDL

May 28, 2023 pm 02:12 PM

Berbilang laluan, berbilang domain, merangkumi semua! Google AI mengeluarkan model am pembelajaran berbilang domain MDL

May 28, 2023 pm 02:12 PM

Model pembelajaran mendalam untuk tugas penglihatan (seperti klasifikasi imej) biasanya dilatih hujung ke hujung dengan data daripada domain visual tunggal (seperti imej semula jadi atau imej yang dijana komputer). Secara amnya, aplikasi yang menyelesaikan tugas penglihatan untuk berbilang domain perlu membina berbilang model untuk setiap domain yang berasingan dan melatihnya secara berasingan Data tidak dikongsi antara domain yang berbeza, setiap model akan mengendalikan data input tertentu. Walaupun ia berorientasikan kepada bidang yang berbeza, beberapa ciri lapisan awal antara model ini adalah serupa, jadi latihan bersama model ini adalah lebih cekap. Ini mengurangkan kependaman dan penggunaan kuasa, dan mengurangkan kos memori untuk menyimpan setiap parameter model Pendekatan ini dipanggil pembelajaran berbilang domain (MDL). Selain itu, model MDL juga boleh mengatasi prestasi tunggal

Drone yang boleh menahan angin kencang? Caltech menggunakan data penerbangan selama 12 minit untuk mengajar dron terbang mengikut angin

Apr 09, 2023 pm 11:51 PM

Drone yang boleh menahan angin kencang? Caltech menggunakan data penerbangan selama 12 minit untuk mengajar dron terbang mengikut angin

Apr 09, 2023 pm 11:51 PM

Apabila angin cukup kuat untuk meniup payung, drone itu stabil, seperti ini: Terbang dalam angin adalah sebahagian daripada terbang di udara Dari tahap yang besar, apabila juruterbang mendaratkan pesawat, kelajuan angin mungkin Membawa cabaran kepada mereka; pada tahap yang lebih kecil, angin kencang juga boleh menjejaskan penerbangan dron. Pada masa ini, dron sama ada diterbangkan dalam keadaan terkawal, tanpa angin, atau dikendalikan oleh manusia menggunakan alat kawalan jauh. Dron dikawal oleh penyelidik untuk terbang dalam formasi di langit terbuka, tetapi penerbangan ini biasanya dijalankan dalam keadaan dan persekitaran yang ideal. Walau bagaimanapun, agar dron melakukan tugasan yang perlu tetapi rutin secara autonomi, seperti menghantar pakej, ia mesti dapat menyesuaikan diri dengan keadaan angin dalam masa nyata. Untuk menjadikan dron lebih mudah dikendalikan apabila terbang mengikut angin, pasukan jurutera dari Caltech

Amalan algoritma pembelajaran kontrastif di Zhuanzhuan

Apr 11, 2023 pm 09:25 PM

Amalan algoritma pembelajaran kontrastif di Zhuanzhuan

Apr 11, 2023 pm 09:25 PM

1 Apakah pembelajaran kontrastif 1.1 Definisi pembelajaran kontrastif 1.2 Prinsip pembelajaran kontrastif 1.3 Algoritma pembelajaran kontrastif klasik siri 2 Aplikasi pembelajaran kontrastif 3 Amalan pembelajaran kontrastif di Zhuanzhuan 3.1 Amalan CL dalam ingatan yang disyorkan 3.2 Perancangan masa depan CL dalam Apa Zhuanzhuan 1 ialah Pembelajaran Kontrastif 1.1 Definisi Pembelajaran Kontrastif Pembelajaran Kontrastif (CL) ialah hala tuju penyelidikan yang popular dalam bidang AI sejak beberapa tahun kebelakangan ini, menarik perhatian ramai sarjana penyelidikan, malah telah diumumkan oleh Bengio di ICLR 2020. Dia dan LeCun dan orang besar lain menamakannya sebagai masa depan AI, dan kemudian melancarkan NIPS, ACL,