Pengeluaran ChatGPT telah menggerakkan seluruh bidang AI, dan syarikat teknologi utama, syarikat permulaan dan pasukan universiti mengikutinya. Baru-baru ini, Heart of the Machine telah melaporkan hasil penyelidikan banyak syarikat permulaan dan pasukan universiti.

Semalam, satu lagi model dialog AI domestik berskala besar membuat penampilan sulungnya: ChatGLM, AI spektrum pintar syarikat yang berubah daripada pencapaian teknologi Tsinghua dan berdasarkan model asas GLM-130B 100 bilion , kini dibuka untuk jemputan Ujian dalaman.

Perlu dinyatakan bahawa Zhipu AI juga telah menggunakan sumber terbuka model dialog dwibahasa Cina-Inggeris ChatGLM-6B, yang menyokong inferens pada satu kad grafik gred pengguna.

Tapak web aplikasi beta dalaman: chatglm.cn

Difahamkan bahawa peningkatan keupayaan versi semasa model ChatGLM terutamanya datang daripada model asas 100 bilion unik GLM-130B. Ia adalah seni bina yang berbeza daripada BERT, GPT-3 dan T5 Ia adalah model pra-latihan autoregresif yang mengandungi fungsi berbilang objektif.

Pada Ogos 2022, Universiti Tsinghua bersama-sama melancarkan model padat dwibahasa Cina-Inggeris GLM-130B dengan 130 bilion parameter kepada komuniti penyelidikan dan industri Model ini mempunyai beberapa ciri unik Kelebihan:

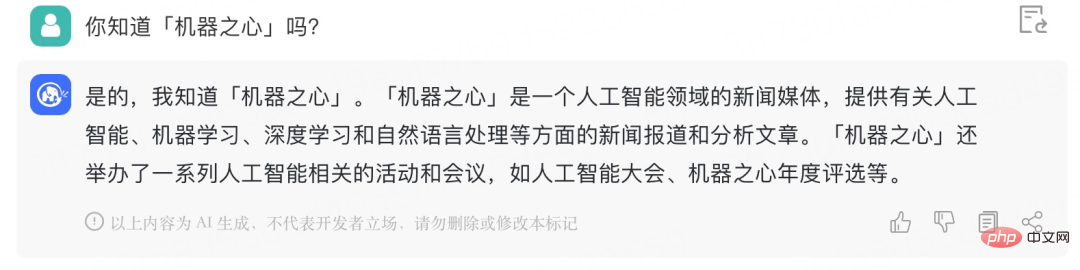

Heart of the Machine telah memperoleh kod jemputan untuk beta tertutup Berikut ialah perbualan ringkas dengan ChatGLM Kesannya adalah seperti berikut:

Ia boleh memahami maksud sebenar "station CP":

Ia boleh memahami maksud sebenar "station CP":

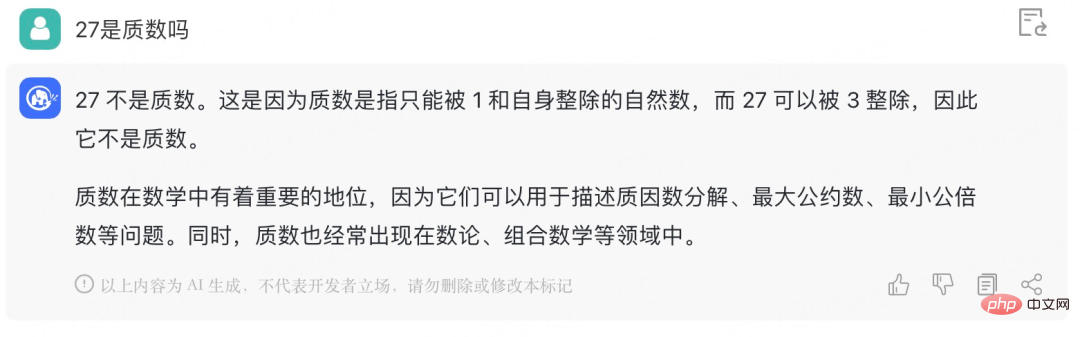

Beri ChatGLM masalah matematik untuk dicuba:

Sejak dia mempelajari persamaan linear dua pembolehubah, masalah asas "ayam dan arnab dalam sangkar yang sama" seperti ini boleh tidak lagi menyusahkan dia:

Sejak dia mempelajari persamaan linear dua pembolehubah, masalah asas "ayam dan arnab dalam sangkar yang sama" seperti ini boleh tidak lagi menyusahkan dia:

ChatGLM-6B ialah model bahasa perbualan sumber terbuka yang menyokong soalan dan jawapan dwibahasa Cina-Inggeris dan dioptimumkan untuk bahasa Cina. Model ini berdasarkan seni bina General Language Model (GLM) dan mempunyai 6.2 bilion parameter. Digabungkan dengan teknologi pengkuantitian model, pengguna boleh menggunakannya secara tempatan pada kad grafik gred pengguna (minimum 6GB memori video diperlukan pada tahap pengkuantitian INT4). ChatGLM-6B menggunakan teknologi yang sama seperti ChatGLM dan dioptimumkan untuk Soal Jawab dan dialog Cina. Selepas latihan dwibahasa dalam bahasa Cina dan Inggeris dengan kira-kira pengecam 1T, ditambah dengan penalaan halus yang diselia, layan diri maklum balas, pembelajaran pengukuhan maklum balas manusia dan teknologi lain, 6.2 bilion parameter ChatGLM-6B, walaupun tidak sebesar model 100 bilion, telah banyak mengurangkan kos inferens dan bertambah baik Ia telah meningkatkan kecekapan dan sudah boleh menjana jawapan yang agak konsisten dengan pilihan manusia.

Alamat sumber terbuka model: https://github.com/THUDM/ChatGLM-6B

Khususnya , ChatGLM-6B mempunyai ciri-ciri berikut:

Namun, disebabkan kapasiti model ChatGLM-6B yang kecil, sudah pasti terdapat beberapa batasan dan kekurangan, termasuk:

Pasukan GLM menyatakan bahawa ChatGLM masih jauh di belakang penyelidikan dan produk model besar antarabangsa pada masa hadapan, ia akan terus membangunkan dan versi terkini ChatGLM sumber terbuka dan model yang berkaitan. Pasukan GLM juga mengalu-alukan semua orang untuk memuat turun ChatGLM-6B dan menjalankan penyelidikan dan pembangunan aplikasi (bukan komersial) berdasarkannya.

Atas ialah kandungan terperinci ChatGLM, model dialog asas Gigabit berasaskan Tsinghua, telah melancarkan ujian dalaman dan merupakan versi kad tunggal sumber terbuka model tersebut.. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Bagaimana untuk menyambungkan php ke pangkalan data mssql

Bagaimana untuk menyambungkan php ke pangkalan data mssql

Apakah alat pembangunan asp?

Apakah alat pembangunan asp?

wordpress seo

wordpress seo

Maksimumkan halaman web

Maksimumkan halaman web

Apakah ciri baharu Hongmeng 3.0?

Apakah ciri baharu Hongmeng 3.0?

Apa yang perlu dilakukan jika sistem pemasangan tidak dapat mencari cakera keras

Apa yang perlu dilakukan jika sistem pemasangan tidak dapat mencari cakera keras

langkah perlindungan keselamatan pelayan cdn

langkah perlindungan keselamatan pelayan cdn

Bagaimana untuk mengintegrasikan idea dengan Tomcat

Bagaimana untuk mengintegrasikan idea dengan Tomcat