Peranti teknologi

Peranti teknologi

AI

AI

Media AS mendedahkan set data latihan model besar: sesetengah kandungan agak 'kotor'

Media AS mendedahkan set data latihan model besar: sesetengah kandungan agak 'kotor'

Media AS mendedahkan set data latihan model besar: sesetengah kandungan agak 'kotor'

Berita pada 20 April, chatbot kecerdasan buatan telah menjadi semakin popular sejak empat bulan lalu, dan mereka dapat menyelesaikan pelbagai tugas, seperti menulis kertas akademik yang kompleks dan menjalankan penyelidikan Dialog yang sengit dan kebolehan yang menakjubkan.

Chatbots tidak berfikir seperti manusia, malah mereka tidak tahu apa yang mereka bincangkan. Mereka boleh meniru pertuturan manusia kerana kecerdasan buatan yang mendorong mereka telah menyerap sejumlah besar teks, kebanyakannya dikikis daripada internet.

Teks ini ialah sumber maklumat utama AI tentang dunia semasa pembinaannya, dan ia boleh memberi kesan yang mendalam terhadap cara AI bertindak balas. Jika kecerdasan buatan mencapai keputusan cemerlang dalam peperiksaan kehakiman, ini mungkin kerana data latihannya mengandungi beribu-ribu maklumat LSAT (Ujian Kemasukan Sekolah Undang-undang, Ujian Kemasukan Sekolah Undang-undang Amerika).

Syarikat teknologi sentiasa berahsia tentang maklumat yang mereka berikan kepada kecerdasan buatan. Jadi The Washington Post menetapkan untuk menganalisis salah satu set data penting ini, mendedahkan jenis tapak web proprietari, peribadi dan sering menyinggung perasaan yang digunakan untuk melatih AI.

Untuk meneroka susunan dalaman data latihan AI, Washington Post bekerjasama dengan penyelidik dari Allen Institute for Artificial Intelligence untuk menganalisis set data C4 Google. Set data ini ialah petikan besar lebih daripada 15 juta tapak web, yang kandungannya digunakan untuk melatih banyak AI berprofil tinggi berbahasa Inggeris, seperti T5 Google dan LLaMA Facebook. OpenAI tidak mendedahkan jenis set data yang mereka gunakan untuk melatih model yang menyokong chatbot ChatGPT.

Dalam tinjauan ini, penyelidik menggunakan data daripada syarikat analitik web Similarweb untuk mengklasifikasikan tapak web. Kira-kira satu pertiga daripada tapak ini tidak boleh diklasifikasikan dan dikecualikan, terutamanya kerana ia tidak lagi wujud di Internet. Para penyelidik kemudian meletakkan baki 10 juta tapak web berdasarkan bilangan "token" yang muncul pada setiap tapak web dalam set data. Token ialah sekeping kecil maklumat pemprosesan teks, biasanya perkataan atau frasa, digunakan untuk melatih model AI.

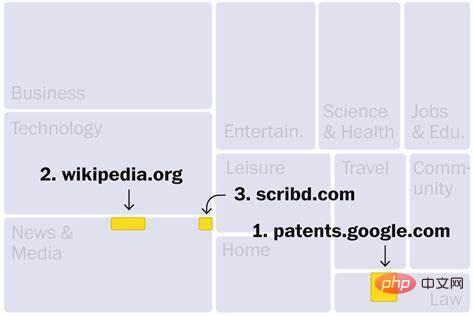

Dari Wikipedia ke WoWhead

Tapak web dalam set data C4 terutamanya daripada industri seperti berita, hiburan, pembangunan perisian, perubatan dan penciptaan kandungan. Ini boleh menjelaskan mengapa medan ini mungkin diancam oleh gelombang baru kecerdasan buatan. Tiga tapak web teratas ialah: yang pertama ialah Carian Paten Google, yang mengandungi teks paten yang diterbitkan di seluruh dunia dan yang ketiga ialah Scribd, perpustakaan digital yang hanya menerima langganan berbayar; Selain itu, tapak web berpangkat tinggi lain termasuk Perpustakaan pasaran e-buku cetak rompak (No. 190), yang telah ditutup oleh Jabatan Kehakiman A.S. kerana aktiviti haram. Selain itu, terdapat sekurang-kurangnya 27 laman web dalam set data yang telah dikenal pasti oleh kerajaan AS sebagai pasaran produk cetak rompak dan tiruan.

Terdapat juga beberapa tapak teratas yang ditampilkan, seperti wowhead (No. 181), forum untuk pemain World of Warcraft dan tapak web yang diasaskan oleh Arianna Huffington untuk membantu memerangi keletihan Tapak Web ThriveGlobal (No. 175). . Selain itu, terdapat sekurang-kurangnya 10 tapak web yang menjual tempat pembuangan sampah, termasuk dumpsteroid (No. 183), tetapi nampaknya tidak lagi boleh diakses.

Walaupun kebanyakan tapak web selamat, sesetengah tapak web mempunyai isu privasi yang serius. Sebagai contoh, dua tapak web disenaraikan dalam senarai 100 teratas salinan pangkalan data pendaftaran pemilih negeri yang dihoskan secara persendirian. Walaupun data pengundi adalah umum, model ini mungkin menggunakan maklumat peribadi ini dengan cara yang tidak diketahui.

Tapak web industri dan komersil menduduki kategori terbesar (mengandungi 16% daripada token kategori). Di bahagian atas senarai ialah The Motley Fool (No. 13), yang memberikan nasihat pelaburan. Seterusnya ialah Kickstarter (No. 25), sebuah laman web yang membolehkan pengguna mengumpulkan projek kreatif. Patreon, yang mempunyai kedudukan lebih rendah di No. 2,398, membantu pencipta mengutip yuran bulanan daripada pelanggan untuk kandungan eksklusif.

Walau bagaimanapun, Kickstarter dan Patreon mungkin membenarkan AI mengakses idea artis dan salinan pemasaran, menimbulkan kebimbangan bahawa AI mungkin menyalin karya ini apabila memberikan cadangan kepada pengguna. Artis, yang pada masa ini tidak menerima sebarang pampasan apabila kerja mereka disertakan dalam data latihan AI, telah memfailkan tuntutan pelanggaran terhadap penjana teks-ke-imej Stable Diffusion, MidJourney dan DeviantArt.

Menurut analisis Washington Post ini, lebih banyak cabaran undang-undang mungkin akan datang: Terdapat lebih daripada 200 juta kejadian simbol hak cipta (menunjukkan karya yang didaftarkan sebagai harta intelek) dalam set data C4.

Tapak web teknikal ialah kategori kedua terbesar, menyumbang 15% daripada token kategori. Ini termasuk banyak platform yang membantu orang ramai membina tapak web, seperti Google Sites (No. 85), yang mempunyai halaman yang merangkumi segala-galanya daripada kelab judo di Reading, England, hingga ke tadika di New Jersey.

Set data C4 juga mengandungi lebih daripada 500,000 blog peribadi, menyumbang 3.8% daripada kandungan terperingkat. Platform penerbitan Medium menduduki tempat ke-46 dan merupakan tapak web teknologi kelima terbesar, dengan puluhan ribu blog di bawah nama domainnya. Selain itu, terdapat blog yang ditulis pada platform seperti WordPress, Tumblr, Blogpot, dan Live Journal.

Blog ini terdiri daripada profesional kepada peribadi, seperti blog yang dipanggil "Grumpy Rumblings" yang dikarang bersama oleh dua ahli akademik tanpa nama, yang salah seorang daripada mereka baru-baru ini menulis tentang cara pasangan mereka kehilangan pekerjaannya Bagaimana ia mempengaruhi cukai pasangan . Selain itu, terdapat beberapa blog popular yang memfokuskan pada permainan main peranan secara langsung dalam set data C4.

Kandungan rangkaian sosial seperti Facebook dan Twitter (yang dianggap teras web moden) disekat daripada merangkak, yang bermaksud kebanyakan set data yang digunakan untuk melatih kecerdasan buatan tidak dapat mengaksesnya. Gergasi teknologi seperti Facebook dan Google menggunakan sejumlah besar data perbualan, tetapi mereka belum tahu cara menggunakan maklumat pengguna peribadi untuk melatih model kecerdasan buatan untuk kegunaan dalaman atau untuk dijual sebagai produk.

Tapak berita dan media telah menduduki tempat ketiga merentas semua kategori, dan separuh daripada sepuluh tapak teratas ialah saluran berita: The New York Times menduduki tempat keempat, Los Angeles Times menduduki tempat keenam, dan laman web Guardian Newspaper menduduki tempat ketujuh, Laman web Forbes menduduki tempat kelapan, laman web Huffington Post menduduki tempat kesembilan, dan laman web Washington Post menduduki tempat ke-11. Seperti artis dan pencipta, beberapa organisasi berita telah mengkritik syarikat teknologi kerana menggunakan kandungan mereka tanpa kebenaran atau pampasan.

Pada masa yang sama, "Washington Post" juga mendapati bahawa beberapa media berada pada kedudukan rendah dalam penarafan kredibiliti bebas NewsGuard: seperti RT Rusia (65), laman web berita paling kanan breitbart (No. 159) dan laman web anti-imigresen vdare (No. 993) dengan kaitan dengan ketuanan kulit putih.

Chatbots telah terbukti berkongsi maklumat yang salah. Data latihan yang tidak boleh dipercayai boleh menyebabkan mereka menyebarkan berat sebelah dan mempromosikan maklumat salah tanpa pengguna dapat mengesannya ke sumber asal mereka.

Tapak web komuniti menyumbang kira-kira 5% daripada kandungan terperingkat, terutamanya laman web keagamaan.

Ikan apa yang tiada dalam penapis?

Seperti kebanyakan syarikat, Google menapis dan menyaring data sebelum menyalurkannya kepada AI. Selain mengalih keluar teks yang tidak bermakna dan berulang, syarikat itu juga menggunakan "senarai perkataan buruk" sumber terbuka yang merangkumi 402 istilah bahasa Inggeris dan emoji. Syarikat sering menggunakan set data berkualiti tinggi untuk memperhalusi model untuk menyekat kandungan yang tidak mahu dilihat oleh pengguna.

Walaupun senarai sedemikian bertujuan untuk mengehadkan model daripada terdedah kepada penghinaan kaum dan kandungan yang tidak sesuai semasa dilatih, banyak perkara membuatnya melepasi penapis. The Washington Post menemui ratusan laman web lucah dan lebih daripada 72,000 contoh "Nazi" dalam senarai perkataan yang dilarang.

Sementara itu, The Washington Post mendapati bahawa penapis gagal mengalih keluar beberapa kandungan yang mengganggu, termasuk tapak ketuanan putih, tapak anti-trans dan tapak yang terkenal kerana menganjurkan kempen gangguan terhadap individu Papan mesej tanpa nama 4chan. Kajian itu juga mendedahkan laman web yang mempromosikan teori konspirasi.

Adakah tapak web anda digunakan untuk melatih AI?

Mengikis web mungkin kedengaran seperti menyalin keseluruhan Internet, tetapi ia sebenarnya hanya mengumpulkan syot kilat, contoh halaman web pada masa tertentu. Dataset C4 pada asalnya dicipta oleh organisasi bukan untung CommonCrawl untuk merangkak kandungan web pada April 2019 dan merupakan sumber popular untuk latihan model kecerdasan buatan. CommonCrawl berkata organisasi itu cuba mengutamakan laman web yang paling penting dan bereputasi tetapi tidak cuba mengelak kandungan berlesen atau dilindungi hak cipta.

The Washington Post percaya bahawa adalah penting untuk membentangkan kandungan data yang lengkap dalam model kecerdasan buatan yang berpotensi untuk mengurus banyak aspek kehidupan moden manusia. Walau bagaimanapun, banyak tapak web dalam set data ini mengandungi bahasa yang sangat menyinggung perasaan, dan walaupun model dilatih untuk menutup perkataan ini, kandungan yang tidak menyenangkan mungkin masih ada.

Pakar mengatakan bahawa walaupun set data C4 adalah besar, model bahasa yang besar mungkin menggunakan set data yang lebih besar. Sebagai contoh, OpenAI mengeluarkan data latihan GPT-3 pada tahun 2020, yang mempunyai 40 kali ganda jumlah data yang dikikis web dalam C4. Data latihan GPT-3 termasuk semua Wikipedia Bahasa Inggeris, koleksi novel percuma oleh pengarang yang tidak diterbitkan yang kerap digunakan oleh syarikat teknologi besar, dan kompilasi teks terpaut yang dinilai tinggi oleh pengguna Reddit.

Pakar mengatakan banyak syarikat tidak merekodkan kandungan data latihan mereka (walaupun secara dalaman) kerana takut mengetahui maklumat yang boleh dikenal pasti secara peribadi, bahan berhak cipta dan data lain yang telah dicuri tanpa kebenaran. Memandangkan syarikat menyerlahkan cabaran untuk menerangkan cara chatbots membuat keputusan, ini adalah kawasan di mana eksekutif perlu memberikan jawapan yang telus.

Atas ialah kandungan terperinci Media AS mendedahkan set data latihan model besar: sesetengah kandungan agak 'kotor'. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

Video Face Swap

Tukar muka dalam mana-mana video dengan mudah menggunakan alat tukar muka AI percuma kami!

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1667

1667

14

14

1426

1426

52

52

1328

1328

25

25

1273

1273

29

29

1255

1255

24

24

Bytedance Cutting melancarkan keahlian super SVIP: 499 yuan untuk langganan tahunan berterusan, menyediakan pelbagai fungsi AI

Jun 28, 2024 am 03:51 AM

Bytedance Cutting melancarkan keahlian super SVIP: 499 yuan untuk langganan tahunan berterusan, menyediakan pelbagai fungsi AI

Jun 28, 2024 am 03:51 AM

Laman web ini melaporkan pada 27 Jun bahawa Jianying ialah perisian penyuntingan video yang dibangunkan oleh FaceMeng Technology, anak syarikat ByteDance Ia bergantung pada platform Douyin dan pada asasnya menghasilkan kandungan video pendek untuk pengguna platform tersebut Windows , MacOS dan sistem pengendalian lain. Jianying secara rasmi mengumumkan peningkatan sistem keahliannya dan melancarkan SVIP baharu, yang merangkumi pelbagai teknologi hitam AI, seperti terjemahan pintar, penonjolan pintar, pembungkusan pintar, sintesis manusia digital, dsb. Dari segi harga, yuran bulanan untuk keratan SVIP ialah 79 yuan, yuran tahunan ialah 599 yuan (nota di laman web ini: bersamaan dengan 49.9 yuan sebulan), langganan bulanan berterusan ialah 59 yuan sebulan, dan langganan tahunan berterusan ialah 499 yuan setahun (bersamaan dengan 41.6 yuan sebulan) . Di samping itu, pegawai yang dipotong juga menyatakan bahawa untuk meningkatkan pengalaman pengguna, mereka yang telah melanggan VIP asal

Pembantu pengekodan AI yang ditambah konteks menggunakan Rag dan Sem-Rag

Jun 10, 2024 am 11:08 AM

Pembantu pengekodan AI yang ditambah konteks menggunakan Rag dan Sem-Rag

Jun 10, 2024 am 11:08 AM

Tingkatkan produktiviti, kecekapan dan ketepatan pembangun dengan menggabungkan penjanaan dipertingkatkan semula dan memori semantik ke dalam pembantu pengekodan AI. Diterjemah daripada EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG, pengarang JanakiramMSV. Walaupun pembantu pengaturcaraan AI asas secara semulajadi membantu, mereka sering gagal memberikan cadangan kod yang paling relevan dan betul kerana mereka bergantung pada pemahaman umum bahasa perisian dan corak penulisan perisian yang paling biasa. Kod yang dijana oleh pembantu pengekodan ini sesuai untuk menyelesaikan masalah yang mereka bertanggungjawab untuk menyelesaikannya, tetapi selalunya tidak mematuhi piawaian pengekodan, konvensyen dan gaya pasukan individu. Ini selalunya menghasilkan cadangan yang perlu diubah suai atau diperhalusi agar kod itu diterima ke dalam aplikasi

Tujuh Soalan Temuduga Teknikal GenAI & LLM yang Cool

Jun 07, 2024 am 10:06 AM

Tujuh Soalan Temuduga Teknikal GenAI & LLM yang Cool

Jun 07, 2024 am 10:06 AM

Untuk mengetahui lebih lanjut tentang AIGC, sila layari: 51CTOAI.x Komuniti https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou berbeza daripada bank soalan tradisional yang boleh dilihat di mana-mana sahaja di Internet memerlukan pemikiran di luar kotak. Model Bahasa Besar (LLM) semakin penting dalam bidang sains data, kecerdasan buatan generatif (GenAI) dan kecerdasan buatan. Algoritma kompleks ini meningkatkan kemahiran manusia dan memacu kecekapan dan inovasi dalam banyak industri, menjadi kunci kepada syarikat untuk kekal berdaya saing. LLM mempunyai pelbagai aplikasi Ia boleh digunakan dalam bidang seperti pemprosesan bahasa semula jadi, penjanaan teks, pengecaman pertuturan dan sistem pengesyoran. Dengan belajar daripada sejumlah besar data, LLM dapat menjana teks

Bolehkah penalaan halus benar-benar membolehkan LLM mempelajari perkara baharu: memperkenalkan pengetahuan baharu boleh menjadikan model menghasilkan lebih banyak halusinasi

Jun 11, 2024 pm 03:57 PM

Bolehkah penalaan halus benar-benar membolehkan LLM mempelajari perkara baharu: memperkenalkan pengetahuan baharu boleh menjadikan model menghasilkan lebih banyak halusinasi

Jun 11, 2024 pm 03:57 PM

Model Bahasa Besar (LLM) dilatih pada pangkalan data teks yang besar, di mana mereka memperoleh sejumlah besar pengetahuan dunia sebenar. Pengetahuan ini dibenamkan ke dalam parameter mereka dan kemudiannya boleh digunakan apabila diperlukan. Pengetahuan tentang model ini "diperbaharui" pada akhir latihan. Pada akhir pra-latihan, model sebenarnya berhenti belajar. Selaraskan atau perhalusi model untuk mempelajari cara memanfaatkan pengetahuan ini dan bertindak balas dengan lebih semula jadi kepada soalan pengguna. Tetapi kadangkala pengetahuan model tidak mencukupi, dan walaupun model boleh mengakses kandungan luaran melalui RAG, ia dianggap berfaedah untuk menyesuaikan model kepada domain baharu melalui penalaan halus. Penalaan halus ini dilakukan menggunakan input daripada anotasi manusia atau ciptaan LLM lain, di mana model menemui pengetahuan dunia sebenar tambahan dan menyepadukannya

Lima sekolah pembelajaran mesin yang anda tidak tahu

Jun 05, 2024 pm 08:51 PM

Lima sekolah pembelajaran mesin yang anda tidak tahu

Jun 05, 2024 pm 08:51 PM

Pembelajaran mesin ialah cabang penting kecerdasan buatan yang memberikan komputer keupayaan untuk belajar daripada data dan meningkatkan keupayaan mereka tanpa diprogramkan secara eksplisit. Pembelajaran mesin mempunyai pelbagai aplikasi dalam pelbagai bidang, daripada pengecaman imej dan pemprosesan bahasa semula jadi kepada sistem pengesyoran dan pengesanan penipuan, dan ia mengubah cara hidup kita. Terdapat banyak kaedah dan teori yang berbeza dalam bidang pembelajaran mesin, antaranya lima kaedah yang paling berpengaruh dipanggil "Lima Sekolah Pembelajaran Mesin". Lima sekolah utama ialah sekolah simbolik, sekolah sambungan, sekolah evolusi, sekolah Bayesian dan sekolah analogi. 1. Simbolisme, juga dikenali sebagai simbolisme, menekankan penggunaan simbol untuk penaakulan logik dan ekspresi pengetahuan. Aliran pemikiran ini percaya bahawa pembelajaran adalah proses penolakan terbalik, melalui sedia ada

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Untuk menyediakan tanda aras dan sistem penilaian menjawab soalan saintifik dan kompleks baharu untuk model besar, UNSW, Argonne, University of Chicago dan institusi lain bersama-sama melancarkan rangka kerja SciQAG

Jul 25, 2024 am 06:42 AM

Editor |ScienceAI Question Answering (QA) set data memainkan peranan penting dalam mempromosikan penyelidikan pemprosesan bahasa semula jadi (NLP). Set data QA berkualiti tinggi bukan sahaja boleh digunakan untuk memperhalusi model, tetapi juga menilai dengan berkesan keupayaan model bahasa besar (LLM), terutamanya keupayaan untuk memahami dan menaakul tentang pengetahuan saintifik. Walaupun pada masa ini terdapat banyak set data QA saintifik yang meliputi bidang perubatan, kimia, biologi dan bidang lain, set data ini masih mempunyai beberapa kekurangan. Pertama, borang data adalah agak mudah, kebanyakannya adalah soalan aneka pilihan. Ia mudah dinilai, tetapi mengehadkan julat pemilihan jawapan model dan tidak dapat menguji sepenuhnya keupayaan model untuk menjawab soalan saintifik. Sebaliknya, Soal Jawab terbuka

SK Hynix akan memaparkan produk berkaitan AI baharu pada 6 Ogos: HBM3E 12 lapisan, NAND 321 tinggi, dsb.

Aug 01, 2024 pm 09:40 PM

SK Hynix akan memaparkan produk berkaitan AI baharu pada 6 Ogos: HBM3E 12 lapisan, NAND 321 tinggi, dsb.

Aug 01, 2024 pm 09:40 PM

Menurut berita dari laman web ini pada 1 Ogos, SK Hynix mengeluarkan catatan blog hari ini (1 Ogos), mengumumkan bahawa ia akan menghadiri Global Semiconductor Memory Summit FMS2024 yang akan diadakan di Santa Clara, California, Amerika Syarikat dari 6 hingga 8 Ogos, mempamerkan banyak produk penjanaan teknologi baru. Pengenalan kepada Sidang Kemuncak Memori dan Penyimpanan Masa Depan (FutureMemoryandStorage), dahulunya Sidang Kemuncak Memori Flash (FlashMemorySummit) terutamanya untuk pembekal NAND, dalam konteks peningkatan perhatian kepada teknologi kecerdasan buatan, tahun ini dinamakan semula sebagai Sidang Kemuncak Memori dan Penyimpanan Masa Depan (FutureMemoryandStorage) kepada jemput vendor DRAM dan storan serta ramai lagi pemain. Produk baharu SK hynix dilancarkan tahun lepas

Prestasi SOTA, kaedah AI ramalan pertalian protein-ligan pelbagai mod Xiamen, menggabungkan maklumat permukaan molekul buat kali pertama

Jul 17, 2024 pm 06:37 PM

Prestasi SOTA, kaedah AI ramalan pertalian protein-ligan pelbagai mod Xiamen, menggabungkan maklumat permukaan molekul buat kali pertama

Jul 17, 2024 pm 06:37 PM

Editor |. KX Dalam bidang penyelidikan dan pembangunan ubat, meramalkan pertalian pengikatan protein dan ligan dengan tepat dan berkesan adalah penting untuk pemeriksaan dan pengoptimuman ubat. Walau bagaimanapun, kajian semasa tidak mengambil kira peranan penting maklumat permukaan molekul dalam interaksi protein-ligan. Berdasarkan ini, penyelidik dari Universiti Xiamen mencadangkan rangka kerja pengekstrakan ciri berbilang mod (MFE) novel, yang buat pertama kalinya menggabungkan maklumat mengenai permukaan protein, struktur dan jujukan 3D, dan menggunakan mekanisme perhatian silang untuk membandingkan ciri modaliti yang berbeza penjajaran. Keputusan eksperimen menunjukkan bahawa kaedah ini mencapai prestasi terkini dalam meramalkan pertalian mengikat protein-ligan. Tambahan pula, kajian ablasi menunjukkan keberkesanan dan keperluan maklumat permukaan protein dan penjajaran ciri multimodal dalam rangka kerja ini. Penyelidikan berkaitan bermula dengan "S