pembangunan bahagian belakang

pembangunan bahagian belakang

Tutorial Python

Tutorial Python

Cara menggunakan Jieba untuk statistik kekerapan perkataan dan pengekstrakan kata kunci dalam Python

Cara menggunakan Jieba untuk statistik kekerapan perkataan dan pengekstrakan kata kunci dalam Python

Cara menggunakan Jieba untuk statistik kekerapan perkataan dan pengekstrakan kata kunci dalam Python

1 Statistik kekerapan perkataan

1.1 Statistik kekerapan perkataan ringkas

1 Import pustaka jieba dan tentukan teks

import jieba text = "Python是一种高级编程语言,广泛应用于人工智能、数据分析、Web开发等领域。"

2 >

words = jieba.cut(text)

, yang boleh digunakan untuk menggelungkan semua perkataan. wordsfor3. Kira kekerapan perkataan

word_count = {}

for word in words:

if len(word) > 1:

word_count[word] = word_count.get(word, 0) + 1Langkah ini adalah untuk merentasi semua perkataan, mengira bilangan kemunculan setiap perkataan dan menyimpannya ke kamus

. Apabila mengira kekerapan perkataan, pengoptimuman boleh dilakukan dengan mengalih keluar perkataan henti Di sini, perkataan dengan panjang kurang daripada 2 ditapis sahaja.word_count4. Output hasil

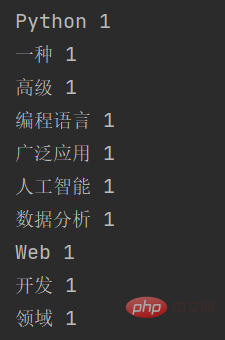

for word, count in word_count.items():

print(word, count) 1.2 Tambah perkataan henti

1.2 Tambah perkataan henti

Untuk mengira kekerapan perkataan dengan lebih tepat, kita boleh mengira kekerapan perkataan dalam statistik kekerapan perkataan Tambah perkataan henti untuk mengalih keluar beberapa perkataan biasa tetapi tidak bermakna. Langkah-langkah khusus adalah seperti berikut:

Tentukan senarai perkataan henti

import jieba # 停用词列表 stopwords = ['是', '一种', '等']

Sahkan teks dan tapis perkataan henti

text = "Python是一种高级编程语言,广泛应用于人工智能、数据分析、Web开发等领域。" words = jieba.cut(text) words_filtered = [word for word in words if word not in stopwords and len(word) > 1]

Kira kekerapan perkataan dan keluarkan hasilnya

word_count = {}

for word in words_filtered:

word_count[word] = word_count.get(word, 0) + 1

for word, count in word_count.items():

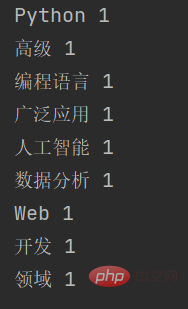

print(word, count)Selepas menambah perkataan henti, hasil output ialah:

Seperti yang anda lihat, perkataan yang dilumpuhkan

Seperti yang anda lihat, perkataan yang dilumpuhkan

一种2 Pengekstrakan Kata Kunci

2.1 Prinsip Pengekstrakan Kata Kunci

Berbeza daripada statistik kekerapan perkataan yang hanya mengira perkataan, prinsip pengekstrakan kata kunci jieba adalah berdasarkan TF-IDF ( Kekerapan Istilah- Kekerapan Dokumen Songsang) algoritma. Algoritma TF-IDF ialah kaedah pengekstrakan ciri teks yang biasa digunakan yang boleh mengukur kepentingan sesuatu perkataan dalam teks.

Secara khusus, algoritma TF-IDF mengandungi dua bahagian:

- Kekerapan Jangka: merujuk kepada bilangan kali perkataan muncul dalam teks, biasanya menggunakan statistik Mudah perwakilan nilai, seperti kekerapan perkataan, kekerapan perkataan bigram, dsb. Kekerapan perkataan mencerminkan kepentingan sesuatu perkataan dalam teks, tetapi mengabaikan kelaziman perkataan dalam keseluruhan korpus.

- Kekerapan Dokumen Songsang: merujuk kepada songsangan kekerapan perkataan yang muncul dalam semua dokumen, dan digunakan untuk mengukur kelaziman sesuatu perkataan. Semakin besar kekerapan dokumen songsang, semakin biasa sesuatu perkataan dan semakin rendah kepentingannya, semakin kecil kekerapan dokumen songsang, semakin unik perkataan itu dan semakin tinggi kepentingannya;

- Algoritma TF-IDF mengira kepentingan setiap perkataan dalam teks dengan mempertimbangkan secara menyeluruh kekerapan perkataan dan kekerapan dokumen songsang untuk mengekstrak kata kunci. Dalam jieba, pelaksanaan khusus pengekstrakan kata kunci termasuk langkah berikut:

- Lakukan pembahagian perkataan pada teks dan dapatkan hasil pembahagian perkataan.

- Hitung bilangan kali setiap perkataan muncul dalam teks dan hitung kekerapan perkataan.

- Hitung bilangan kali setiap perkataan muncul dalam semua dokumen dan hitung kekerapan dokumen songsang.

- Memandangkan kekerapan perkataan dan kekerapan dokumen songsang, kira nilai TF-IDF bagi setiap perkataan dalam teks.

- Isih nilai TF-IDF dan pilih perkataan dengan markah tertinggi sebagai kata kunci.

Contohnya: F (Kekerapan Jangka) merujuk kepada kekerapan perkataan tertentu muncul dalam dokumen. Formula pengiraan adalah seperti berikut: T F = (bilangan kali perkataan muncul dalam dokumen) / (jumlah bilangan perkataan dalam dokumen)

2.2 Kod pengekstrakan kata kunci

Sebagai contoh, dalam dokumen yang mengandungi 100 perkataan, perkataan tertentu muncul 10 kali , maka TF perkataan ialah

10 / 100 = 0.1

IDF (Kekerapan Dokumen Songsang) merujuk kepada timbal balik bilangan dokumen di mana perkataan tertentu muncul dalam koleksi dokumen. Formula pengiraan adalah seperti berikut:

I D F = log (jumlah bilangan dokumen dalam koleksi dokumen / bilangan dokumen yang mengandungi perkataan)

Sebagai contoh, dalam koleksi dokumen yang mengandungi 1,000 dokumen, perkataan tertentu muncul dalam 100 documents , maka IDF perkataan ialah l o g ( 1000 / 100 ) = 1.0

TFIDF ialah hasil darab TF dan IDF Formula pengiraan adalah seperti berikut:

T F I D F = T F ∗ 🎜>

Perlu diingatkan bahawa algoritma TF-IDF hanya mempertimbangkan kemunculan perkataan dalam teks dan mengabaikan korelasi antara perkataan. Oleh itu, dalam beberapa senario aplikasi tertentu, kaedah pengekstrakan ciri teks lain perlu digunakan, seperti vektor perkataan, model topik, dsb.

import jieba.analyse

# 待提取关键字的文本

text = "Python是一种高级编程语言,广泛应用于人工智能、数据分析、Web开发等领域。"

# 使用jieba提取关键字

keywords = jieba.analyse.extract_tags(text, topK=5, withWeight=True)

# 输出关键字和对应的权重

for keyword, weight in keywords:

print(keyword, weight)Dalam contoh ini, kami mula-mula mengimport modul

dan kemudian menentukan teksuntuk diekstrak. Seterusnya, kami menggunakan fungsi

untuk mengekstrak kata kunci, dengan parameter menunjukkan bilangan kata kunci yang akan diekstrak dan parameter jieba.analyse menunjukkan sama ada untuk mengembalikan nilai berat kata kunci. Akhir sekali, kami mengulangi senarai kata kunci dan mengeluarkan setiap kata kunci dan nilai berat yang sepadan. textHasil keluaran fungsi ini ialah: jieba.analyse.extract_tags()topKwithWeight

Seperti yang anda lihat, jieba mengekstrak beberapa kata kunci dalam teks input berdasarkan algoritma TF-IDF dan mengembalikan nilai berat setiap kata kunci.

Atas ialah kandungan terperinci Cara menggunakan Jieba untuk statistik kekerapan perkataan dan pengekstrakan kata kunci dalam Python. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1386

1386

52

52

PHP dan Python: Contoh dan perbandingan kod

Apr 15, 2025 am 12:07 AM

PHP dan Python: Contoh dan perbandingan kod

Apr 15, 2025 am 12:07 AM

PHP dan Python mempunyai kelebihan dan kekurangan mereka sendiri, dan pilihannya bergantung kepada keperluan projek dan keutamaan peribadi. 1.PHP sesuai untuk pembangunan pesat dan penyelenggaraan aplikasi web berskala besar. 2. Python menguasai bidang sains data dan pembelajaran mesin.

Python vs JavaScript: Komuniti, Perpustakaan, dan Sumber

Apr 15, 2025 am 12:16 AM

Python vs JavaScript: Komuniti, Perpustakaan, dan Sumber

Apr 15, 2025 am 12:16 AM

Python dan JavaScript mempunyai kelebihan dan kekurangan mereka sendiri dari segi komuniti, perpustakaan dan sumber. 1) Komuniti Python mesra dan sesuai untuk pemula, tetapi sumber pembangunan depan tidak kaya dengan JavaScript. 2) Python berkuasa dalam bidang sains data dan perpustakaan pembelajaran mesin, sementara JavaScript lebih baik dalam perpustakaan pembangunan dan kerangka pembangunan depan. 3) Kedua -duanya mempunyai sumber pembelajaran yang kaya, tetapi Python sesuai untuk memulakan dengan dokumen rasmi, sementara JavaScript lebih baik dengan MDNWebDocs. Pilihan harus berdasarkan keperluan projek dan kepentingan peribadi.

Penjelasan terperinci mengenai Prinsip Docker

Apr 14, 2025 pm 11:57 PM

Penjelasan terperinci mengenai Prinsip Docker

Apr 14, 2025 pm 11:57 PM

Docker menggunakan ciri -ciri kernel Linux untuk menyediakan persekitaran berjalan yang cekap dan terpencil. Prinsip kerjanya adalah seperti berikut: 1. Cermin digunakan sebagai templat baca sahaja, yang mengandungi semua yang anda perlukan untuk menjalankan aplikasi; 2. Sistem Fail Kesatuan (Unionfs) menyusun pelbagai sistem fail, hanya menyimpan perbezaan, menjimatkan ruang dan mempercepatkan; 3. Daemon menguruskan cermin dan bekas, dan pelanggan menggunakannya untuk interaksi; 4. Ruang nama dan cgroups melaksanakan pengasingan kontena dan batasan sumber; 5. Pelbagai mod rangkaian menyokong interkoneksi kontena. Hanya dengan memahami konsep -konsep teras ini, anda boleh menggunakan Docker dengan lebih baik.

Cara menjalankan program di terminal vscode

Apr 15, 2025 pm 06:42 PM

Cara menjalankan program di terminal vscode

Apr 15, 2025 pm 06:42 PM

Dalam kod VS, anda boleh menjalankan program di terminal melalui langkah -langkah berikut: Sediakan kod dan buka terminal bersepadu untuk memastikan bahawa direktori kod selaras dengan direktori kerja terminal. Pilih arahan Run mengikut bahasa pengaturcaraan (seperti python python your_file_name.py) untuk memeriksa sama ada ia berjalan dengan jayanya dan menyelesaikan kesilapan. Gunakan debugger untuk meningkatkan kecekapan debug.

Bolehkah kod studio visual digunakan dalam python

Apr 15, 2025 pm 08:18 PM

Bolehkah kod studio visual digunakan dalam python

Apr 15, 2025 pm 08:18 PM

Kod VS boleh digunakan untuk menulis Python dan menyediakan banyak ciri yang menjadikannya alat yang ideal untuk membangunkan aplikasi python. Ia membolehkan pengguna untuk: memasang sambungan python untuk mendapatkan fungsi seperti penyempurnaan kod, penonjolan sintaks, dan debugging. Gunakan debugger untuk mengesan kod langkah demi langkah, cari dan selesaikan kesilapan. Mengintegrasikan Git untuk Kawalan Versi. Gunakan alat pemformatan kod untuk mengekalkan konsistensi kod. Gunakan alat linting untuk melihat masalah yang berpotensi lebih awal.

Python: Automasi, skrip, dan pengurusan tugas

Apr 16, 2025 am 12:14 AM

Python: Automasi, skrip, dan pengurusan tugas

Apr 16, 2025 am 12:14 AM

Python cemerlang dalam automasi, skrip, dan pengurusan tugas. 1) Automasi: Sandaran fail direalisasikan melalui perpustakaan standard seperti OS dan Shutil. 2) Penulisan Skrip: Gunakan Perpustakaan Psutil untuk memantau sumber sistem. 3) Pengurusan Tugas: Gunakan perpustakaan jadual untuk menjadualkan tugas. Kemudahan penggunaan Python dan sokongan perpustakaan yang kaya menjadikannya alat pilihan di kawasan ini.

Boleh kod vs dijalankan di Windows 8

Apr 15, 2025 pm 07:24 PM

Boleh kod vs dijalankan di Windows 8

Apr 15, 2025 pm 07:24 PM

Kod VS boleh dijalankan pada Windows 8, tetapi pengalaman mungkin tidak hebat. Mula -mula pastikan sistem telah dikemas kini ke patch terkini, kemudian muat turun pakej pemasangan kod VS yang sepadan dengan seni bina sistem dan pasangnya seperti yang diminta. Selepas pemasangan, sedar bahawa beberapa sambungan mungkin tidak sesuai dengan Windows 8 dan perlu mencari sambungan alternatif atau menggunakan sistem Windows yang lebih baru dalam mesin maya. Pasang sambungan yang diperlukan untuk memeriksa sama ada ia berfungsi dengan betul. Walaupun kod VS boleh dilaksanakan pada Windows 8, disyorkan untuk menaik taraf ke sistem Windows yang lebih baru untuk pengalaman dan keselamatan pembangunan yang lebih baik.

Adakah sambungan vscode berniat jahat?

Apr 15, 2025 pm 07:57 PM

Adakah sambungan vscode berniat jahat?

Apr 15, 2025 pm 07:57 PM

Sambungan kod VS menimbulkan risiko yang berniat jahat, seperti menyembunyikan kod jahat, mengeksploitasi kelemahan, dan melancap sebagai sambungan yang sah. Kaedah untuk mengenal pasti sambungan yang berniat jahat termasuk: memeriksa penerbit, membaca komen, memeriksa kod, dan memasang dengan berhati -hati. Langkah -langkah keselamatan juga termasuk: kesedaran keselamatan, tabiat yang baik, kemas kini tetap dan perisian antivirus.