Peranti teknologi

Peranti teknologi

AI

AI

PhD Pembelajaran Mesin Penn: Bagaimanakah saya menulis kertas terkemuka dari awal?

PhD Pembelajaran Mesin Penn: Bagaimanakah saya menulis kertas terkemuka dari awal?

PhD Pembelajaran Mesin Penn: Bagaimanakah saya menulis kertas terkemuka dari awal?

Saya baru-baru ini menyiapkan kertas kerja yang sangat memuaskan. Bukan sahaja keseluruhan proses itu menyeronokkan dan tidak dapat dilupakan, ia juga benar-benar mencapai "impak akademik dan keluaran industri." Saya percaya artikel ini akan mengubah paradigma pembelajaran mendalam privasi pembezaan (DP).

Oleh kerana pengalaman ini terlalu "kebetulan" (prosesnya penuh dengan kebetulan dan kesimpulannya sangat bijak), saya ingin berkongsi dengan rakan sekelas saya pemerhatian saya -- > idea -->Bukti empirikal-->Teori-->Proses lengkap eksperimen berskala besar. Saya akan cuba memastikan artikel ini ringan dan tidak melibatkan terlalu banyak butiran teknikal.

Alamat kertas: arxiv.org/abs/2206.07136

Dengan Susunan pembentangan dalam kertas adalah berbeza. Kertas kadang-kadang sengaja meletakkan kesimpulan pada permulaan untuk menarik pembaca, atau memperkenalkan teorem yang dipermudahkan terlebih dahulu dan meletakkan teorem lengkap dalam lampiran Dalam artikel ini, saya ingin menulis pengalaman saya secara kronologi perintah (iaitu, akaun yang sedang berjalan ), sebagai contoh, tuliskan lencongan yang telah anda ambil dan situasi yang tidak dijangka semasa penyelidikan, untuk rujukan oleh pelajar yang baru memulakan jalan penyelidikan saintifik.

1. Bacaan Kesusasteraan

Asal usul perkara itu adalah kertas daripada Stanford, yang kini telah direkodkan dalam ICLR:

Alamat kertas: https://arxiv.org/abs/2110.05679

Artikel ditulis dengan sangat baik , dan terdapat tiga perkara ringkasan Sumbangan utama:

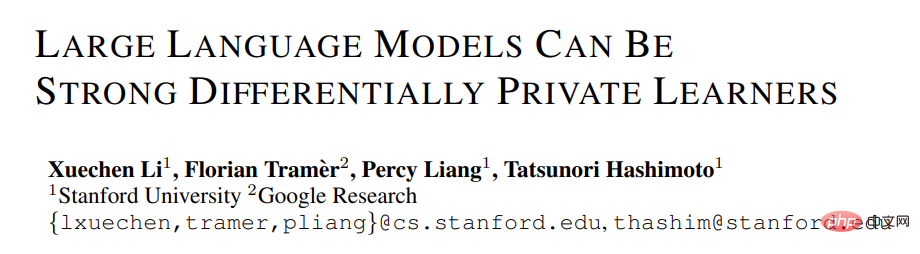

1 Dalam tugasan NLP, ketepatan model DP adalah sangat tinggi, yang menggalakkan penerapan privasi dalam model bahasa. (Sebaliknya, DP dalam CV akan menyebabkan kemerosotan ketepatan yang sangat besar. Contohnya, CIFAR10 pada masa ini hanya mempunyai ketepatan 80% tanpa pra-latihan di bawah had DP, tetapi boleh mencapai 95% dengan mudah tanpa mengambil kira DP; ketepatan DP terbaik ImageNet di masa adalah kurang daripada 50%. )

2. Sebagai contoh, peningkatan prestasi GPT2 daripada 400 juta parameter kepada 800 juta parameter adalah jelas, dan ia juga telah mencapai banyak SOTA. (Tetapi dalam sistem CV dan pengesyoran, dalam banyak kes prestasi model yang lebih besar akan menjadi sangat lemah, malah hampir dengan tekaan rawak. Contohnya, ketepatan terbaik DP CIFAR10 sebelum ini diperoleh oleh CNN empat lapisan, bukan ResNet.)

Semakin besar model DP, semakin baik prestasi dalam tugasan NLP [Xuechen et al 2021]

3 Hiperparameter untuk mendapatkan SOTA pada pelbagai tugas adalah konsisten: ambang keratan perlu ditetapkan cukup kecil dan kadar pembelajaran perlu lebih besar. (Semua artikel sebelum ini adalah untuk melaraskan ambang keratan bagi setiap tugasan, yang memakan masa dan intensif buruh. Tidak pernah ada ambang keratan=0.1 seperti ini yang menjalankan semua tugasan dan prestasinya sangat baik.)

Ringkasan di atas adalah apa yang saya fahami sejurus selepas membaca makalah tersebut. Ini bergantung pada pengumpulan bacaan jangka panjang dan tahap keupayaan generalisasi yang tinggi untuk mengaitkan dan membandingkan dengan cepat.

Sebenarnya, ramai pelajar sukar untuk mula menulis artikel kerana mereka hanya boleh melihat kandungan satu artikel dan tidak boleh membentuk rangkaian atau membuat persatuan dengan titik pengetahuan dalam keseluruhan bidang. . Di satu pihak, pelajar yang baru bermula tidak cukup membaca dan belum menguasai mata pengetahuan yang mencukupi. Ini terutama berlaku kepada pelajar yang telah lama mengambil projek daripada guru dan tidak mengusulkan secara bebas. Sebaliknya, walaupun jumlah bacaan mencukupi, ia tidak dirumuskan dari semasa ke semasa, menyebabkan maklumat tidak dipadatkan menjadi ilmu atau ilmu tidak bersambung.

Berikut adalah latar belakang pengetahuan DP deep learning saya akan melangkau takrifan DP buat masa ini dan ia tidak akan menjejaskan pembacaan.

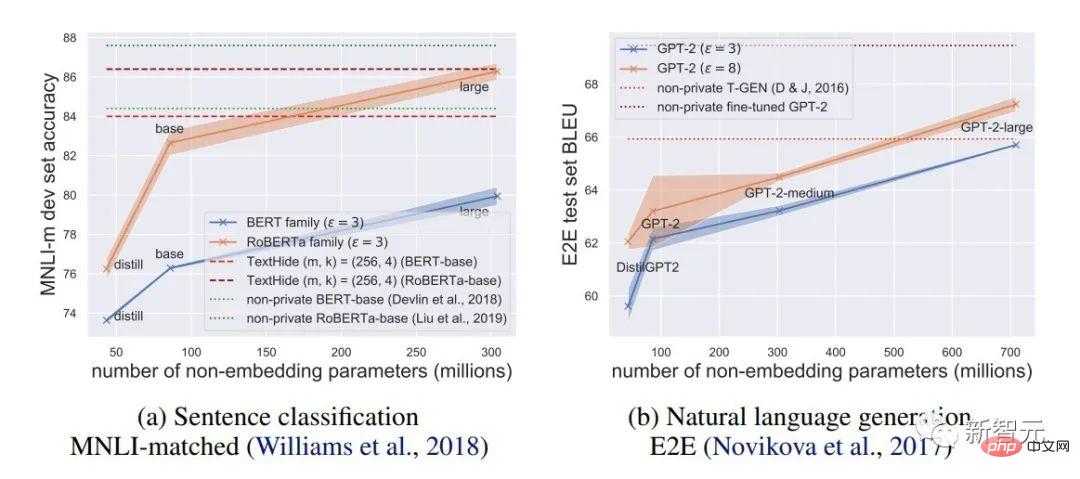

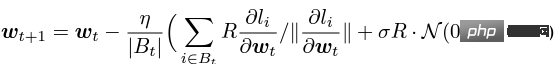

Apa yang dipanggil pembelajaran mendalam DP dari sudut pandangan algoritma sebenarnya bermaksud melakukan dua langkah tambahan: keratan kecerunan setiap sampel dan penambahan hingar Gaussian, selagi anda memproses kecerunan mengikut ini dua langkah (Kecerunan yang diproses dipanggil kecerunan peribadi). Anda kemudiannya boleh menggunakan pengoptimum mengikut kehendak anda, termasuk SGD/Adam.

Mengenai bagaimana peribadi algoritma akhir, ia adalah soalan dalam subbidang lain, yang dipanggil teori perakaunan privasi. Bidang ini agak matang dan memerlukan asas teori yang kukuh Memandangkan artikel ini memfokuskan pada pengoptimuman, ia tidak akan disebut di sini.

g_i ialah kecerunan titik data (kecerunan setiap sampel), R ialah ambang keratan dan sigma ialah pengganda hingar.

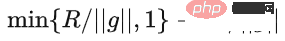

Klip dipanggil fungsi keratan, sama seperti keratan kecerunan biasa Jika kecerunan lebih panjang daripada R, ia akan dipotong kepada R, dan jika ia kurang daripada R, ia tidak akan. bergerak.

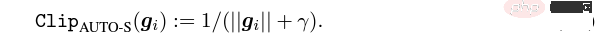

Sebagai contoh, versi DP SGD digunakan dalam semua kertas semasa dan merupakan kerja perintis pembelajaran mendalam privasi (Abadi, Martin, et al. "Pembelajaran mendalam dengan privasi berbeza. ") fungsi keratan, juga dikenali sebagai keratan Abadi:  .

.

Tetapi ini sama sekali tidak perlu mengikut prinsip pertama dan bermula dari teori perakaunan privasi, sebenarnya, fungsi keratan hanya perlu memenuhi bahawa modulus Clip(g_i)*g_i ialah. kurang daripada atau sama dengan R. Itu sahaja. Dalam erti kata lain, keratan Abadi hanyalah satu fungsi yang memenuhi syarat ini, tetapi ia bukanlah satu-satunya.

2. Titik masuk

Sebuah artikel mempunyai banyak titik terang, tetapi tidak semuanya boleh digunakan oleh saya. Saya perlu menilai sumbangan terbesar saya keperluan dan kepakaran sendiri Apa itu.

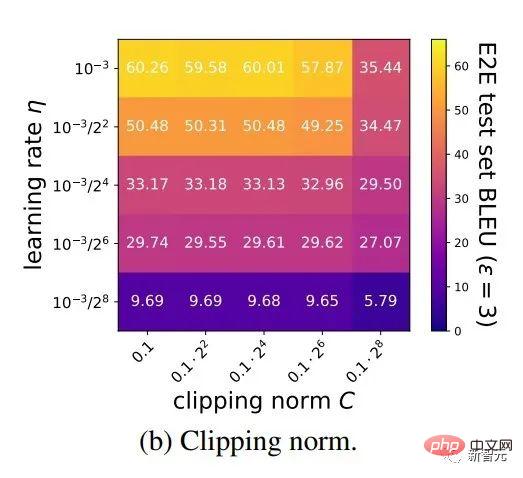

Dua sumbangan pertama artikel ini sebenarnya sangat empirikal dan sukar untuk digali. Sumbangan terakhir adalah sangat menarik. Saya dengan teliti melihat kajian ablasi hiperparameter dan mendapati satu perkara yang penulis asal tidak dapati: apabila ambang keratan cukup kecil, sebenarnya, ambang keratan (iaitu, norma keratan C , dalam formula di atas dan R ialah pembolehubah) tidak mempunyai kesan.

Membujur, C=0.1, 0.4, 1.6 tidak mempunyai perbezaan dengan DP-Adam [Xuechen et al. 2021].

Ini membangkitkan minat saya, dan saya merasakan bahawa mesti ada beberapa prinsip di sebaliknya. Jadi saya tulis tangan DP-Adam yang mereka biasa nampak sebabnya, sebenarnya, ia sangat mudah:

Jika R cukup kecil, keratan sebenarnya setara Untuk normalisasi! Dengan hanya menggantikan kecerunan persendirian (1.1), R boleh diekstrak masing-masing daripada bahagian keratan dan bahagian bunyi:

Dan bentuk Adam membuat R Ia akan muncul dalam saiz langkah kecerunan dan penyesuaian pada masa yang sama Setelah pengangka dan penyebut dibatalkan, R akan hilang, dan idea itu akan ada!

Kedua-dua m dan v bergantung pada kecerunan, dan menggantikannya dengan kecerunan peribadi menghasilkan DP-AdamW.

Hanya penggantian mudah yang membuktikan teorem pertama saya: dalam DP-AdamW, ambang keratan yang cukup kecil adalah bersamaan antara satu sama lain, tidak perlu Laraskan parameter.

Tidak syak lagi ini adalah pemerhatian yang ringkas dan menarik, tetapi ia tidak cukup masuk akal, jadi saya perlu memikirkan kegunaan praktikal pemerhatian ini.

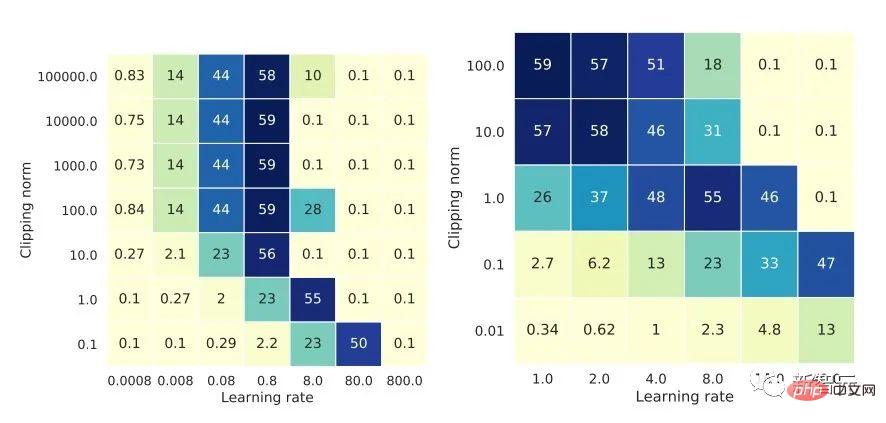

Malah, ini bermakna latihan DP mengurangkan kerja pelarasan parameter mengikut urutan magnitud: dengan mengandaikan bahawa kadar pembelajaran dan R diselaraskan kepada 5 nilai setiap satu (seperti yang ditunjukkan di atas), kemudian 25 kombinasi mesti diuji untuk mencari hiperparameter optimum. Kini anda hanya perlu melaraskan kadar pembelajaran dalam 5 kemungkinan, dan kecekapan pelarasan parameter telah dipertingkatkan beberapa kali Ini adalah isu titik kesakitan yang sangat berharga untuk industri.

Ideanya cukup tinggi, matematiknya cukup ringkas, dan idea yang bagus telah mula terbentuk.

3. Peluasan mudah

Jika ia hanya ditetapkan untuk Adam/AdamW, batasan kerja ini masih terlalu besar, jadi saya cepat mengembangkannya kepada AdamW dan pengoptimum penyesuaian lain, seperti AdaGrad. Malah, untuk semua pengoptimum penyesuaian, dapat dibuktikan bahawa ambang keratan akan diimbangi, jadi tidak perlu melaraskan parameter, yang sangat meningkatkan kekayaan teorem.

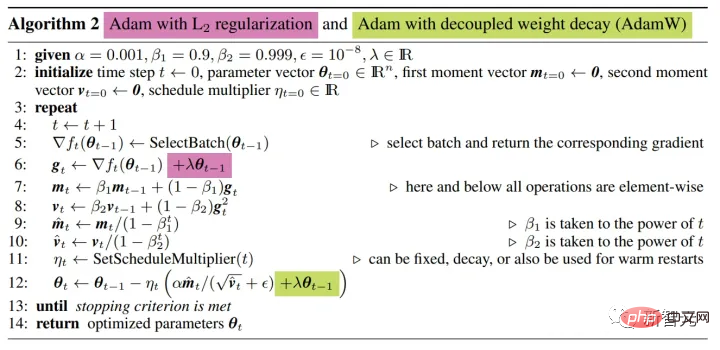

Ada satu lagi butiran kecil yang menarik di sini. Seperti yang kita semua tahu, Adam dengan pereputan berat adalah berbeza daripada AdamW yang terakhir menggunakan pereputan berat yang dipisahkan Pada perbezaan ini, ICLR telah diterbitkan

. Adam ada dua cara untuk menambah pereputan berat badan.

Perbezaan ini juga wujud dalam pengoptimum DP. Perkara yang sama berlaku untuk Adam Jika pereputan berat yang dipisahkan digunakan, penskalaan R tidak menjejaskan saiz pereputan berat.

4 Sesuatu yang lain

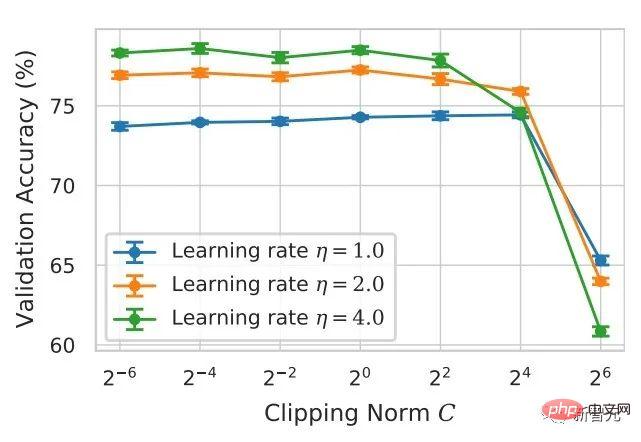

Pelajar pintar mungkin mendapati bahawa saya terus menekankan pengoptimuman penyesuaian Mengapa saya tidak bercakap tentang SGD? menulis teori DP adaptive optimizer, Google segera menerbitkan artikel tentang DP-SGD yang digunakan dalam CV dan juga melakukan kajian ablasi Walau bagaimanapun, peraturannya berbeza sama sekali daripada yang terdapat dalam Adam, yang menyebabkan saya mempunyai Kesan pepenjuru.

Untuk DP-SGD dan apabila R cukup kecil, peningkatan lr sebanyak 10 kali adalah sama dengan peningkatan R sebanyak 10 kali ganda [https: // arxiv.org/abs/2201.12328].

Saya sangat teruja apabila melihat artikel ini, kerana ia adalah kertas lain yang membuktikan keberkesanan ambang keratan kecil.

Dalam dunia saintifik, selalunya terdapat corak tersembunyi di sebalik kebetulan yang berturut-turut.

Penggantian mudah menunjukkan bahawa SGD lebih mudah untuk dianalisis daripada Adam (1.3) boleh dianggarkan sebagai:

Jelas sekali R boleh dicadangkan sekali lagi, dan digabungkan dengan kadar pembelajaran, secara teorinya membuktikan pemerhatian Google.

「Secara khusus, apabila norma keratan dikurangkan k kali, kadar pembelajaran perlu ditingkatkan k kali untuk mengekalkan ketepatan yang sama.」

Sayang sekali Google hanya melihat fenomena dan tidak naik ke peringkat teori. Terdapat juga kebetulan di sini, iaitu, mereka melukis kajian ablasi dua skala pada masa yang sama dalam gambar di atas. Hanya skala kiri boleh melihat garis pepenjuru.

Memandangkan tiada saiz langkah penyesuaian, SGD tidak mengabaikan R seperti Adam, tetapi menganggap R sebagai sebahagian daripada kadar pembelajaran, jadi tidak perlu melaraskannya secara berasingan. kadar pembelajaran diselaraskan bersama-sama dengan parameter.

Kemudian lanjutkan teori SGD kepada momentum, dan semua pengoptimum yang disokong oleh Pytorch telah dianalisis.

5. Dari gerak hati kepada ketegasanAda titik inovatif, tetapi keratan Abadi adalah normalisasi anggaran dan tidak boleh disamakan, jadi tidak ada cara Menganalisis secara konklusif penumpuan.

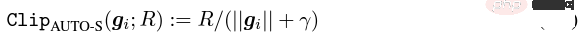

Mengikut prinsip Doraemon Iron Man Corps, saya secara langsung menamakan normalisasi sebagai fungsi kecerunan setiap sampel yang baharu, yang menggantikan keratan Abadi yang telah digunakan di seluruh bidang selama 6 tahun Ini adalah milik saya titik inovasi kedua.

Selepas bukti tadi, keratan baru sama sekali tidak memerlukan R, jadi ia dipanggil keratan automatik (AUTO-V; V untuk vanila).

Memandangkan bentuk berbeza daripada keratan Abadi, ketepatannya akan berbeza, dan keratan saya mungkin mempunyai kelemahan.

Jadi saya perlu menulis kod untuk menguji kaedah baharu saya, yang hanya memerlukan menukar satu baris kod (lagipun, ia hanya  ).

).

Sebenarnya, terdapat terutamanya tiga fungsi keratan dalam arah keratan kecerunan setiap sampel DP Selain keratan Abadi, kedua-duanya dicadangkan oleh saya, satu ialah keratan global, dan satu lagi ialah Ini adalah keratan automatik. Dalam kerja saya sebelum ini, saya sudah tahu cara menukar keratan di pelbagai perpustakaan popular saya meletakkan kaedah pengubahsuaian di lampiran di akhir artikel.

Selepas ujian saya, saya mendapati bahawa dalam artikel Stanford, semasa keseluruhan proses latihan GPT2, semua lelaran dan semua kecerunan setiap sampel telah dipotong. Dalam erti kata lain, sekurang-kurangnya dalam eksperimen ini, keratan Abadi adalah setara sepenuhnya dengan keratan automatik. Walaupun percubaan kemudiannya kalah kepada SOTA, ini telah menunjukkan bahawa kaedah baharu saya mempunyai nilai yang mencukupi: fungsi keratan yang tidak perlu melaraskan ambang keratan, dan kadangkala ketepatan tidak akan dikorbankan.

6. Kembali kepada pemikiran abstrak

Artikel Stanford mempunyai dua jenis utama eksperimen model bahasa, satu ialah tugas generatif di mana GPT2 adalah model, dan satu lagi adalah RoBERTa ialah tugas pengelasan model. Walaupun keratan automatik adalah setara dengan keratan Abadi pada tugas penjanaan, ketepatan pada tugas pengelasan sentiasa beberapa mata lebih teruk.

Disebabkan tabiat akademik saya sendiri, saya tidak akan menukar set data pada masa ini dan kemudian memilih percubaan dominan kami untuk diterbitkan, apatah lagi menambah helah (seperti peningkatan data dan diubah suai secara ajaib model, dsb.). Saya berharap dalam perbandingan yang benar-benar adil, saya hanya boleh membandingkan keratan kecerunan setiap sampel dan mencapai kesan bebas lembapan terbaik yang mungkin.

Malah, dalam perbincangan dengan rakan usaha sama, kami mendapati bahawa normalisasi tulen dan keratan Abadi membuang sepenuhnya maklumat saiz kecerunan, iaitu, untuk keratan automatik, tanpa mengira kecerunan asal adalah sebesar R selepas keratan, dan Abadi mengekalkan maklumat saiz untuk kecerunan yang lebih kecil daripada R.

Berdasarkan idea ini, kami membuat perubahan kecil tetapi sangat bijak, dipanggil keratan AUTO-S (S bermaksud stabil)

Berdasarkan ini algoritma , atau hanya menukar satu baris, jalankan semula kod Stanford, dan anda akan mendapat SOTA enam set data NLP.

Berdasarkan ini algoritma , atau hanya menukar satu baris, jalankan semula kod Stanford, dan anda akan mendapat SOTA enam set data NLP.

7. Buat algoritma umum

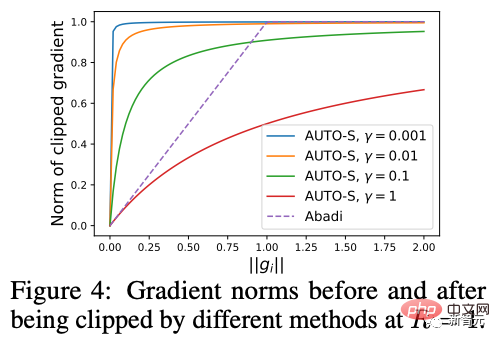

Satu batasan artikel Stanford ialah ia hanya memfokuskan pada NLP, dan sungguh kebetulan: dua bulan selepas Google menolak DP SOTA ImageNet, DeepMind, anak syarikat Google, mengeluarkan artikel tentang bagaimana DP bersinar dalam CV, secara langsung meningkatkan ketepatan ImageNet daripada 48% kepada 84%!

Alamat kertas: https://arxiv.org/abs/2204.13650

Dalam artikel ini, saya mula-mula melihat pilihan pengoptimum dan ambang keratan sehingga saya beralih kepada gambar ini dalam lampiran:

SOTA DP-SGD pada ImageNet juga memerlukan ambang keratan cukup kecil.

Masih ambang keratan kecil berfungsi dengan baik! Dengan tiga artikel berkualiti tinggi yang menyokong keratan automatik, saya sudah mempunyai motivasi yang kuat, dan saya semakin yakin bahawa kerja saya akan menjadi cemerlang.

Kebetulan, artikel oleh DeepMind ini juga merupakan percubaan murni tanpa teori, yang juga menyebabkan mereka hampir menyedari bahawa mereka secara teorinya tidak memerlukan R. Malah, mereka benar-benar rapat. Saya menghasilkan idea saya, malah mereka telah mendapati bahawa R boleh diekstrak dan disepadukan dengan kadar pembelajaran (pelajar yang berminat boleh melihat formula mereka (2) dan (3)). Tetapi inersia keratan Abadi terlalu hebat... Walaupun mereka mengetahui peraturan, mereka tidak pergi lebih jauh.

DeepMind juga mendapati bahawa ambang keratan kecil berfungsi paling baik, tetapi tidak memahami sebabnya.

Diilhamkan oleh kerja baharu ini, saya mula melakukan eksperimen CV supaya algoritma saya boleh digunakan oleh semua penyelidik DP, bukannya membangunkan satu set kaedah untuk NLP , CV melakukan set lain.

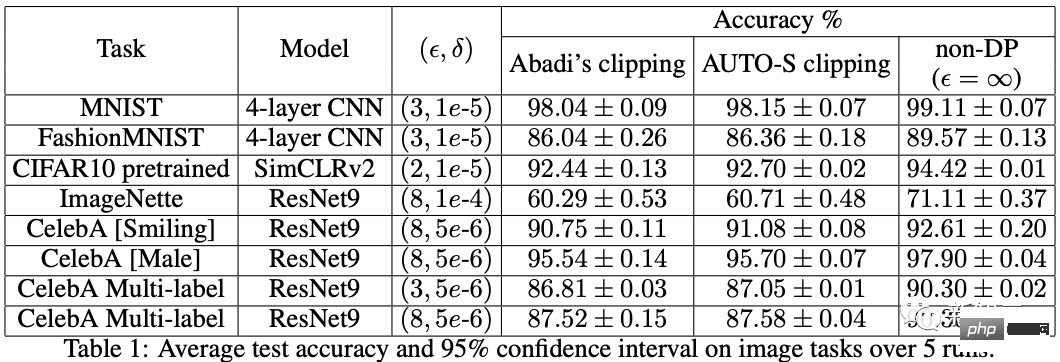

Algoritma yang baik harus bersifat universal dan mudah digunakan Fakta juga telah membuktikan bahawa keratan automatik juga boleh mencapai SOTA pada set data CV.

8 Teori sebagai tulang dan eksperimen sebagai sayap

Melihat semua kertas di atas, SOTA telah meningkat dengan ketara dan mencapai kejuruteraan. keputusan Ia penuh, tetapi teorinya kosong sepenuhnya.

Apabila saya menyelesaikan semua eksperimen, sumbangan kerja ini telah melebihi keperluan persidangan teratas: Saya secara empirik akan menggunakan ambang keratan kecil untuk menjana DP-SGD dan Impak parameter daripada DP-Adam sangat dipermudahkan; fungsi keratan baharu dicadangkan tanpa mengorbankan kecekapan pengiraan, privasi, dan tanpa pelarasan parameter γ kecil membaiki kerosakan pada maklumat saiz kecerunan yang disebabkan oleh keratan dan penormalan Abadi yang mencukupi telah mencapai SOTA ketepatan.

Saya masih belum berpuas hati. Pengoptimum tanpa sokongan teori masih tidak dapat memberikan sumbangan yang besar kepada pembelajaran mendalam. Terdapat berpuluh-puluh pengoptimum baharu yang dicadangkan setiap tahun, dan kesemuanya dibuang pada tahun kedua. Masih terdapat hanya beberapa yang disokong secara rasmi oleh Pytorch dan sebenarnya digunakan oleh industri.

Atas sebab ini, saya dan rakan usaha sama menghabiskan dua bulan tambahan untuk melakukan analisis penumpuan DP-SGD automatik Proses ini sukar tetapi bukti akhir dipermudahkan secara melampau. Kesimpulannya juga sangat mudah: kesan saiz kelompok, kadar pembelajaran, saiz model, saiz sampel dan pembolehubah lain pada penumpuan dinyatakan secara kuantitatif, dan ia konsisten dengan semua tingkah laku latihan DP yang diketahui.

Khususnya, kami membuktikan bahawa walaupun DP-SGD bertumpu lebih perlahan daripada SGD standard, apabila lelaran cenderung kepada infiniti, kelajuan penumpuan ialah tertib magnitud. Ini memberikan keyakinan dalam pengiraan privasi: model DP menumpu, walaupun lewat.

9. Rempuhan kereta...

Akhirnya, artikel yang saya tulis selama 7 bulan ini telah pun selesai. NeurIPS menyerahkan kertas kerja pada bulan Mei, dan pengubahsuaian dalaman telah diselesaikan pada 14 Jun dan dikeluarkan kepada arXiv Hasilnya, pada 27 Jun, saya melihat bahawa Microsoft Research Asia (MSRA) menerbitkan artikel yang bertembung dengan keratan yang dicadangkan betul-betul sama dengan keratan automatik kami:

Sama seperti AUTO-S kami.

Melihat dengan teliti, bukti penumpuan pun hampir sama. Dan kedua-dua kumpulan kita tidak mempunyai persimpangan Boleh dikatakan bahawa satu kebetulan telah lahir di Lautan Pasifik.

Izinkan saya bercakap secara ringkas tentang perbezaan antara kedua-dua artikel: artikel lain adalah lebih teori, seperti analisis tambahan penumpuan Abadi DP-SGD (saya hanya membuktikan keratan automatik, itulah artikel mereka DP-NSGD, mungkin saya tidak tahu bagaimana untuk menyesuaikan DP-SGD juga agak berbeza; mewujudkan keratan Abadi secara eksplisit dan Hubungan kesetaraan normalisasi, seperti Teorem 1 dan 2, menerangkan mengapa R boleh digunakan tanpa pelarasan parameter.

Memandangkan kami bekerja pada masa yang sama, saya sangat gembira kerana terdapat orang yang bersetuju antara satu sama lain dan boleh saling melengkapi dan bersama-sama mempromosikan algoritma ini, supaya seluruh komuniti boleh percaya dengan keputusan ini dan mendapat manfaat daripadanya secepat mungkin. Sudah tentu, dengan mementingkan diri sendiri, saya juga mengingatkan diri saya bahawa artikel seterusnya akan dipercepatkan!

10 Ringkasan

Mengimbas kembali proses kreatif artikel ini, dari titik permulaan, kemahiran asas mesti menjadi prasyarat, dan satu lagi prasyarat penting ialah saya. sentiasa mengingatinya. Titik kesakitan untuk menyesuaikan parameter. Musim kemarau yang panjang, jadi membaca artikel yang betul boleh membantu anda mencari nektar. Bagi proses, terasnya terletak pada tabiat pemerhatian berteori secara matematik Dalam kerja ini, keupayaan untuk melaksanakan kod bukanlah yang paling penting. Saya akan menulis lajur lain yang memfokuskan pada kerja pengekodan teras tegar yang lain. Nasib baik, anda tidak takut terlambat untuk makan yang enak, jadi teruskan!

Atas ialah kandungan terperinci PhD Pembelajaran Mesin Penn: Bagaimanakah saya menulis kertas terkemuka dari awal?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1374

1374

52

52

Kaedah apa yang digunakan untuk menukar rentetan ke dalam objek dalam vue.js?

Apr 07, 2025 pm 09:39 PM

Kaedah apa yang digunakan untuk menukar rentetan ke dalam objek dalam vue.js?

Apr 07, 2025 pm 09:39 PM

Apabila menukar rentetan ke objek dalam vue.js, json.parse () lebih disukai untuk rentetan json standard. Untuk rentetan JSON yang tidak standard, rentetan boleh diproses dengan menggunakan ungkapan biasa dan mengurangkan kaedah mengikut format atau url yang dikodkan. Pilih kaedah yang sesuai mengikut format rentetan dan perhatikan isu keselamatan dan pengekodan untuk mengelakkan pepijat.

Vue dan Element-UI Cascade Drop-Down Box V-Model Binding

Apr 07, 2025 pm 08:06 PM

Vue dan Element-UI Cascade Drop-Down Box V-Model Binding

Apr 07, 2025 pm 08:06 PM

Vue dan Element-UI cascaded drop-down boxes v-model mengikat titik pit biasa: V-model mengikat array yang mewakili nilai yang dipilih pada setiap peringkat kotak pemilihan cascaded, bukan rentetan; Nilai awal pilihan terpilih mestilah array kosong, tidak batal atau tidak jelas; Pemuatan data dinamik memerlukan penggunaan kemahiran pengaturcaraan tak segerak untuk mengendalikan kemas kini data secara tidak segerak; Untuk set data yang besar, teknik pengoptimuman prestasi seperti menatal maya dan pemuatan malas harus dipertimbangkan.

Vue.js Bagaimana untuk menukar pelbagai jenis rentetan ke dalam pelbagai objek?

Apr 07, 2025 pm 09:36 PM

Vue.js Bagaimana untuk menukar pelbagai jenis rentetan ke dalam pelbagai objek?

Apr 07, 2025 pm 09:36 PM

Ringkasan: Terdapat kaedah berikut untuk menukar array rentetan vue.js ke dalam tatasusunan objek: Kaedah asas: Gunakan fungsi peta yang sesuai dengan data yang diformat biasa. Permainan lanjutan: Menggunakan ungkapan biasa boleh mengendalikan format yang kompleks, tetapi mereka perlu ditulis dengan teliti dan dipertimbangkan. Pengoptimuman Prestasi: Memandangkan banyak data, operasi tak segerak atau perpustakaan pemprosesan data yang cekap boleh digunakan. Amalan Terbaik: Gaya Kod Jelas, Gunakan nama dan komen pembolehubah yang bermakna untuk memastikan kod ringkas.

Cara menetapkan masa tamat vue axios

Apr 07, 2025 pm 10:03 PM

Cara menetapkan masa tamat vue axios

Apr 07, 2025 pm 10:03 PM

Untuk menetapkan masa untuk Vue Axios, kita boleh membuat contoh Axios dan menentukan pilihan masa tamat: dalam tetapan global: vue.prototype. $ Axios = axios.create ({timeout: 5000}); Dalam satu permintaan: ini. $ axios.get ('/api/pengguna', {timeout: 10000}).

Geospatial Laravel: Pengoptimuman peta interaktif dan sejumlah besar data

Apr 08, 2025 pm 12:24 PM

Geospatial Laravel: Pengoptimuman peta interaktif dan sejumlah besar data

Apr 08, 2025 pm 12:24 PM

Cecair memproses 7 juta rekod dan membuat peta interaktif dengan teknologi geospatial. Artikel ini meneroka cara memproses lebih dari 7 juta rekod menggunakan Laravel dan MySQL dan mengubahnya menjadi visualisasi peta interaktif. Keperluan Projek Cabaran Awal: Ekstrak Wawasan berharga menggunakan 7 juta rekod dalam pangkalan data MySQL. Ramai orang mula -mula mempertimbangkan bahasa pengaturcaraan, tetapi mengabaikan pangkalan data itu sendiri: Bolehkah ia memenuhi keperluan? Adakah penghijrahan data atau pelarasan struktur diperlukan? Bolehkah MySQL menahan beban data yang besar? Analisis awal: Penapis utama dan sifat perlu dikenalpasti. Selepas analisis, didapati bahawa hanya beberapa atribut yang berkaitan dengan penyelesaiannya. Kami mengesahkan kemungkinan penapis dan menetapkan beberapa sekatan untuk mengoptimumkan carian. Carian Peta Berdasarkan Bandar

Jurutera Backend Senior Remote (Platform) memerlukan kalangan

Apr 08, 2025 pm 12:27 PM

Jurutera Backend Senior Remote (Platform) memerlukan kalangan

Apr 08, 2025 pm 12:27 PM

Jurutera Backend Senior Remote Company Kekosongan Syarikat: Lokasi Lokasi: Jauh Pejabat Jauh Jenis: Gaji sepenuh masa: $ 130,000- $ 140,000 Penerangan Pekerjaan Mengambil bahagian dalam penyelidikan dan pembangunan aplikasi mudah alih Circle dan ciri-ciri berkaitan API awam yang meliputi keseluruhan kitaran hayat pembangunan perisian. Tanggungjawab utama kerja pembangunan secara bebas berdasarkan rubyonrails dan bekerjasama dengan pasukan react/redux/relay front-end. Membina fungsi teras dan penambahbaikan untuk aplikasi web dan bekerjasama rapat dengan pereka dan kepimpinan sepanjang proses reka bentuk berfungsi. Menggalakkan proses pembangunan positif dan mengutamakan kelajuan lelaran. Memerlukan lebih daripada 6 tahun backend aplikasi web kompleks

Cara menyelesaikan MySQL tidak dapat dimulakan

Apr 08, 2025 pm 02:21 PM

Cara menyelesaikan MySQL tidak dapat dimulakan

Apr 08, 2025 pm 02:21 PM

Terdapat banyak sebab mengapa permulaan MySQL gagal, dan ia boleh didiagnosis dengan memeriksa log ralat. Penyebab umum termasuk konflik pelabuhan (periksa penghunian pelabuhan dan ubah suai konfigurasi), isu kebenaran (periksa keizinan pengguna yang menjalankan perkhidmatan), ralat fail konfigurasi (periksa tetapan parameter), rasuah direktori data (memulihkan data atau membina semula ruang meja), isu ruang jadual InnoDB (semak fail ibdata1) Apabila menyelesaikan masalah, anda harus menganalisisnya berdasarkan log ralat, cari punca utama masalah, dan mengembangkan tabiat sandaran data secara teratur untuk mencegah dan menyelesaikan masalah.

Cara Menggunakan MySQL Selepas Pemasangan

Apr 08, 2025 am 11:48 AM

Cara Menggunakan MySQL Selepas Pemasangan

Apr 08, 2025 am 11:48 AM

Artikel ini memperkenalkan operasi pangkalan data MySQL. Pertama, anda perlu memasang klien MySQL, seperti MySqlworkbench atau Command Line Client. 1. Gunakan perintah MySQL-Uroot-P untuk menyambung ke pelayan dan log masuk dengan kata laluan akaun root; 2. Gunakan CreateTatabase untuk membuat pangkalan data, dan gunakan Pilih pangkalan data; 3. Gunakan createtable untuk membuat jadual, menentukan medan dan jenis data; 4. Gunakan InsertInto untuk memasukkan data, data pertanyaan, kemas kini data dengan kemas kini, dan padam data dengan padam. Hanya dengan menguasai langkah -langkah ini, belajar menangani masalah biasa dan mengoptimumkan prestasi pangkalan data anda boleh menggunakan MySQL dengan cekap.