Peranti teknologi

Peranti teknologi

AI

AI

Meta mengeluarkan sumber terbuka model besar pelbagai guna untuk membantu bergerak selangkah lebih dekat kepada penyatuan visual

Meta mengeluarkan sumber terbuka model besar pelbagai guna untuk membantu bergerak selangkah lebih dekat kepada penyatuan visual

Meta mengeluarkan sumber terbuka model besar pelbagai guna untuk membantu bergerak selangkah lebih dekat kepada penyatuan visual

Selepas sumber terbuka model SAM yang "membahagikan segala-galanya", Meta semakin jauh menuju ke "model asas visual".

Kali ini, mereka menggunakan sumber terbuka satu set model yang dipanggil DINOv2. Model ini boleh menghasilkan perwakilan visual berprestasi tinggi yang boleh digunakan untuk tugas hiliran seperti pengelasan, pembahagian, pengambilan imej dan anggaran kedalaman tanpa penalaan halus.

Set model ini mempunyai ciri-ciri berikut:

- Latihan menggunakan pendekatan penyeliaan sendiri tanpa memerlukan sejumlah besar data berlabel

- boleh digunakan sebagai tulang belakang hampir semua CV; tugasan, tiada penalaan halus diperlukan, Seperti klasifikasi imej, pembahagian, pengambilan imej dan anggaran kedalaman; memahami maklumat tempatan dengan lebih baik; CLIP dan OpenCLIP pada pelbagai tugas.

- Pautan kertas: https://arxiv.org/pdf/2304.07193.pdf

Pautan projek: https://dinov2.metademolab.com/

- Gambaran Keseluruhan Kertas Pembelajaran perwakilan pra-latihan neutral tugasan telah menjadi standard dalam pemprosesan bahasa semula jadi. Anda boleh menggunakan ciri ini "seadanya" (tiada penalaan halus diperlukan), dan ciri tersebut menunjukkan prestasi yang lebih baik pada tugas hiliran berbanding model khusus tugas. Kejayaan ini disebabkan oleh pra-latihan pada sejumlah besar teks mentah menggunakan objektif tambahan, seperti pemodelan bahasa atau vektor perkataan, yang tidak memerlukan pengawasan.

- Memandangkan anjakan paradigma ini berlaku dalam bidang NLP, diharapkan model "asas" yang serupa akan muncul dalam penglihatan komputer. Model ini harus menjana ciri visual yang berfungsi "di luar kotak" pada sebarang tugas, sama ada pada tahap imej (cth. klasifikasi imej) atau tahap piksel (cth. segmentasi).

Alternatif kepada pra-latihan berpandukan teks ialah pembelajaran penyeliaan kendiri, di mana ciri dipelajari daripada imej sahaja. Kaedah ini secara konsepnya lebih dekat dengan tugas bahagian hadapan seperti pemodelan bahasa, dan boleh menangkap maklumat pada tahap imej dan piksel. Walau bagaimanapun, walaupun potensi mereka untuk mempelajari ciri umum, kebanyakan penambahbaikan dalam pembelajaran penyeliaan kendiri telah dicapai dalam konteks pra-latihan pada dataset kecil yang diperhalusi ImageNet1k. Terdapat beberapa usaha oleh sesetengah penyelidik untuk melanjutkan kaedah ini melangkaui ImageNet-1k, tetapi mereka memfokuskan pada set data tidak ditapis, yang sering mengakibatkan kemerosotan yang ketara dalam kualiti prestasi. Ini disebabkan oleh kekurangan kawalan ke atas kualiti dan kepelbagaian data, yang penting untuk menghasilkan keputusan yang baik.

Dalam kerja ini, penyelidik meneroka sama ada pembelajaran penyeliaan kendiri adalah mungkin untuk mempelajari ciri visual umum jika dilatih terlebih dahulu pada sejumlah besar data yang diperhalusi. Mereka menyemak semula kaedah diskriminatif yang diselia sendiri yang mempelajari ciri pada tahap imej dan tampung, seperti iBOT, dan mempertimbangkan semula beberapa pilihan reka bentuk mereka di bawah set data yang lebih besar. Kebanyakan sumbangan teknikal kami disesuaikan untuk menstabilkan dan mempercepatkan pembelajaran diskriminatif penyeliaan kendiri apabila menskalakan model dan saiz data. Penambahbaikan ini menjadikan kaedah mereka lebih kurang 2x lebih pantas dan memerlukan 1/3 kurang memori daripada kaedah diskriminatif seliaan sendiri yang serupa, membolehkan mereka memanfaatkan latihan yang lebih panjang dan saiz kelompok yang lebih besar.

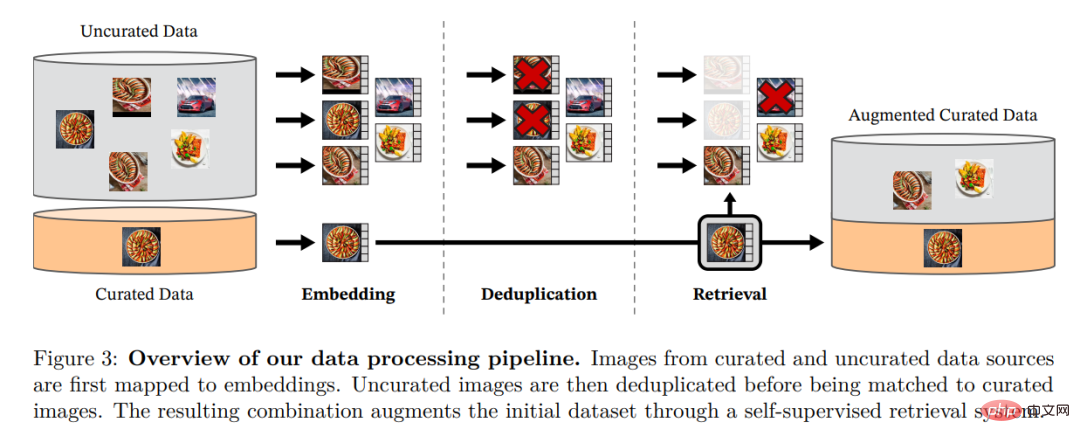

Mengenai data pra-latihan, mereka membina saluran paip automatik untuk menapis dan mengimbangi semula set data daripada koleksi besar imej yang tidak ditapis. Ini diilhamkan oleh saluran paip yang digunakan dalam NLP, di mana persamaan data digunakan dan bukannya metadata luaran, dan anotasi manual tidak diperlukan. Kesukaran utama semasa memproses imej adalah untuk mengimbangi semula konsep dan mengelakkan pemasangan berlebihan dalam beberapa mod dominan. Dalam kerja ini, kaedah pengelompokan naif dapat menyelesaikan masalah ini dengan baik, dan penyelidik mengumpul korpus kecil tetapi pelbagai yang terdiri daripada imej 142M untuk mengesahkan kaedah mereka.

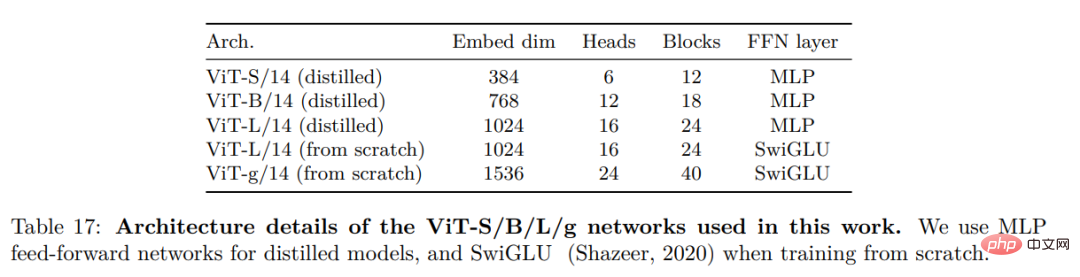

Akhir sekali, penyelidik menyediakan pelbagai model penglihatan pra-latihan, dipanggil DINOv2, dilatih pada data mereka menggunakan seni bina Transformer visual (ViT) yang berbeza. Mereka mengeluarkan semua model dan kod untuk melatih semula DINOv2 pada sebarang data. Apabila dilanjutkan, mereka mengesahkan kualiti DINOv2 pada pelbagai penanda aras penglihatan komputer pada tahap imej dan piksel, seperti yang ditunjukkan dalam Rajah 2. Kami menyimpulkan bahawa pra-latihan yang diselia sendiri sahaja adalah calon yang baik untuk mempelajari ciri-ciri beku yang boleh dipindah milik, setanding dengan model penyeliaan lemah yang tersedia secara awam terbaik.

Pemprosesan Data

Penyelidik mengumpulkan LVD mereka yang diperhalusi dengan mendapatkan semula imej daripada sejumlah besar data tidak ditapis yang hampir dengan data dalam berbilang set data yang diperhalusi -142M. Dalam kertas kerja mereka, mereka menerangkan komponen utama dalam saluran paip data, termasuk sumber data yang dipilih susun/tidak ditapis, langkah penyahduplikasi imej dan sistem perolehan semula. Keseluruhan saluran paip tidak memerlukan sebarang metadata atau teks dan memproses imej secara langsung, seperti yang ditunjukkan dalam Rajah 3. Pembaca dirujuk kepada Lampiran A untuk butiran lanjut mengenai metodologi model.

Rajah 3: Gambaran keseluruhan saluran paip untuk pemprosesan data. Imej daripada sumber data yang diperhalusi dan tidak diperhalusi pertama kali dipetakan kepada pembenaman. Imej yang tidak diperhalusi kemudiannya dinyahduplikasi sebelum dipadankan dengan imej standard. Gabungan yang terhasil memperkayakan lagi set data awal melalui sistem perolehan yang diselia sendiri.

Pralatihan penyeliaan diri yang diskriminatif

Para penyelidik mempelajari ciri-ciri mereka melalui pendekatan penyeliaan kendiri yang diskriminatif yang boleh dilihat gabungan kerugian DINO dan iBOT, berpusat di sekitar SwAV. Mereka juga menambah penyelaras untuk menyebarkan ciri dan fasa latihan resolusi tinggi ringkas.

Pelaksanaan yang cekap

Mereka mempertimbangkan beberapa penambahbaikan untuk melatih model pada skala yang lebih besar. Model ini dilatih pada GPU A100 menggunakan PyTorch 2.0, dan kod itu juga boleh digunakan dengan model terlatih untuk pengekstrakan ciri. Butiran model adalah di Lampiran Jadual 17. Pada perkakasan yang sama, kod DINOv2 hanya menggunakan 1/3 daripada memori dan berjalan 2 kali lebih pantas daripada pelaksanaan iBOT.

Hasil eksperimen

Dalam bahagian ini, penyelidik akan memperkenalkan model baharu dalam banyak pemahaman imej Penilaian empirikal ke atas tugasan. Mereka menilai perwakilan imej global dan tempatan, termasuk pengecaman peringkat kategori dan contoh, pembahagian semantik, ramalan kedalaman monokular dan pengecaman tindakan.

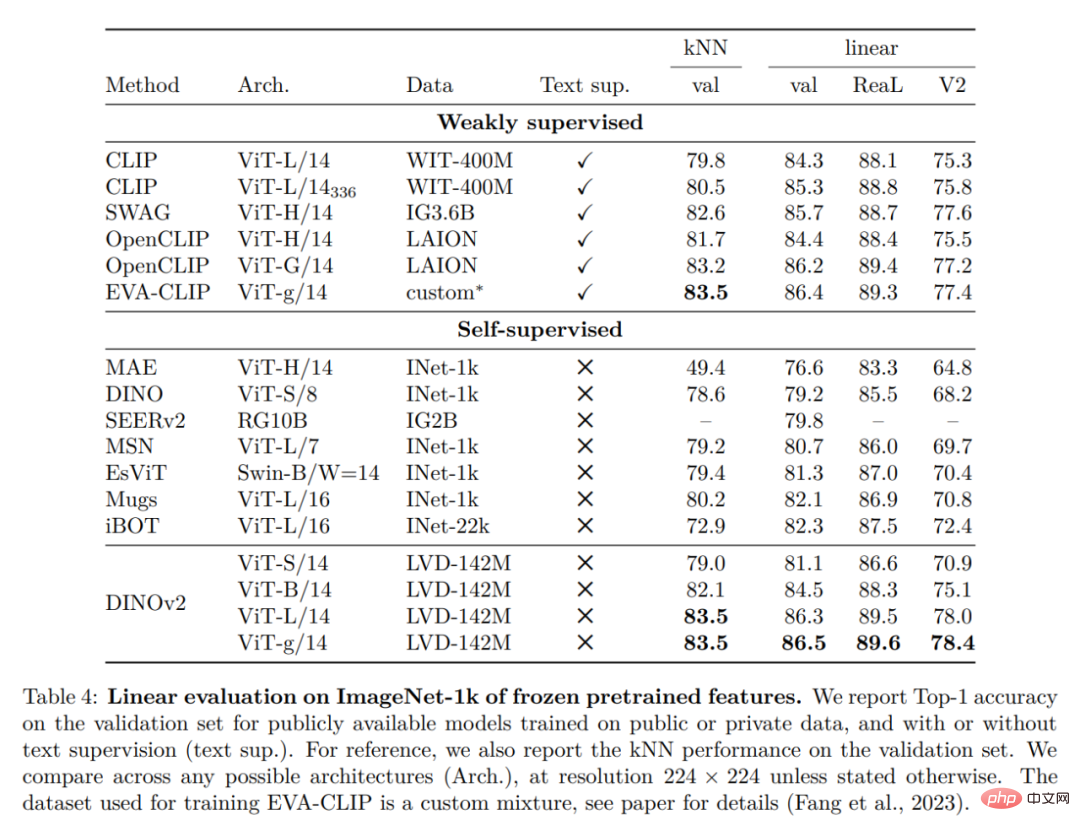

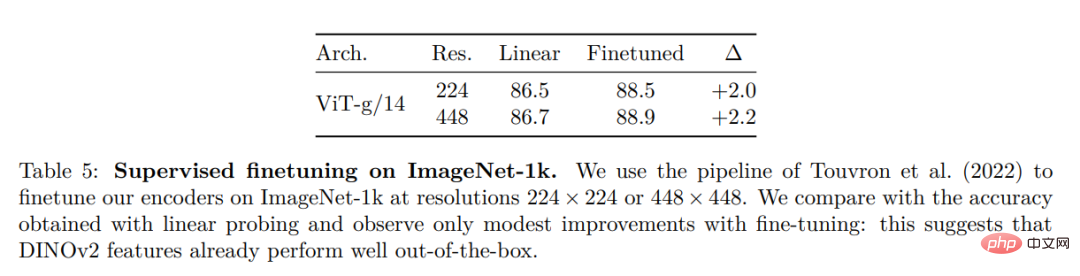

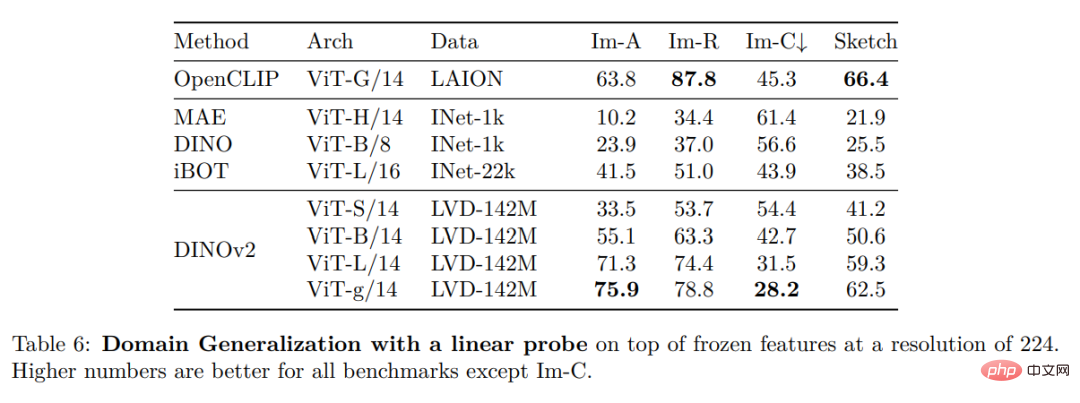

Klasifikasi ImageNet

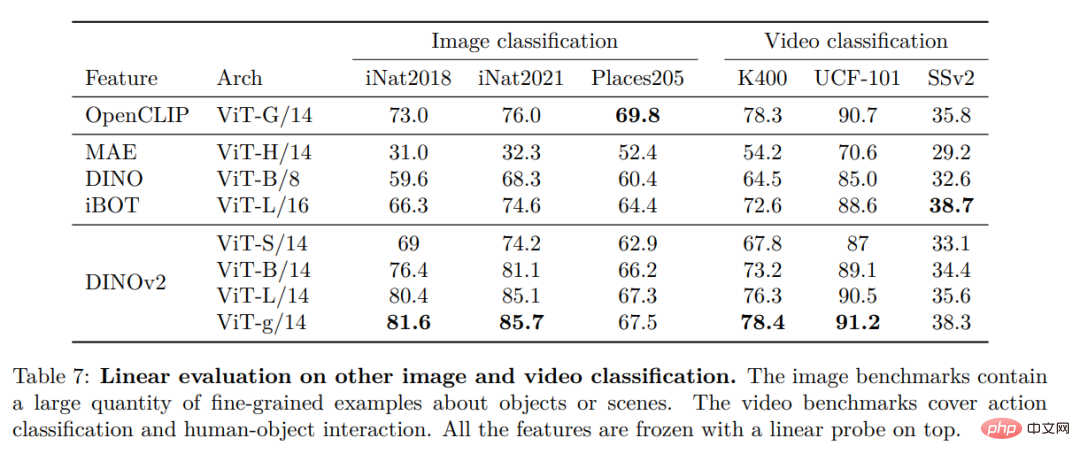

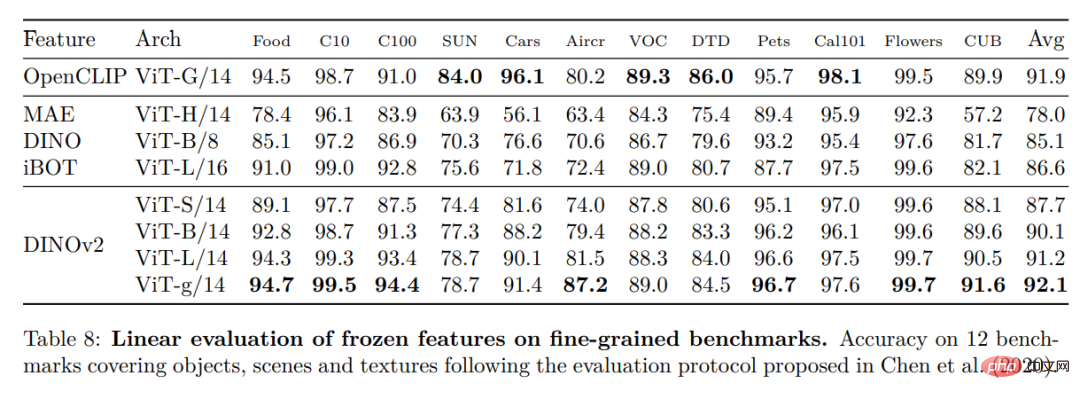

Tanda Aras Klasifikasi Imej dan Video Lain

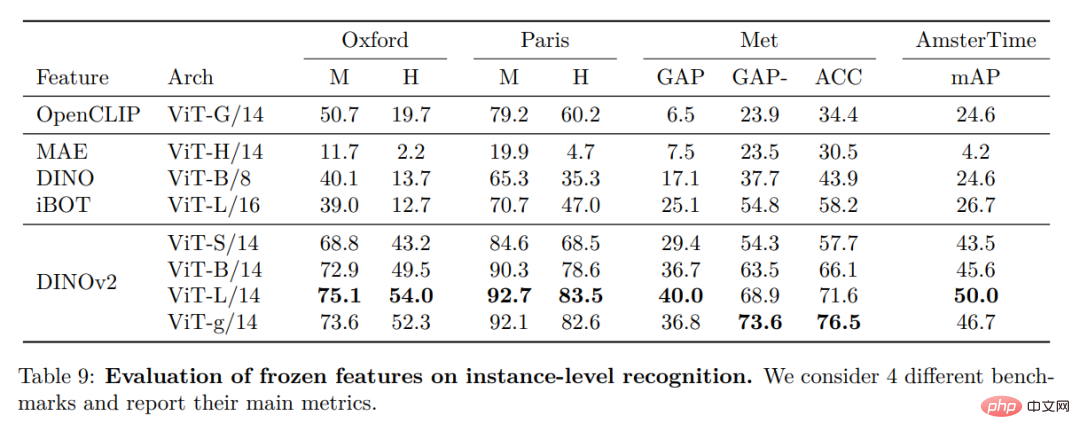

Pengenalan contoh

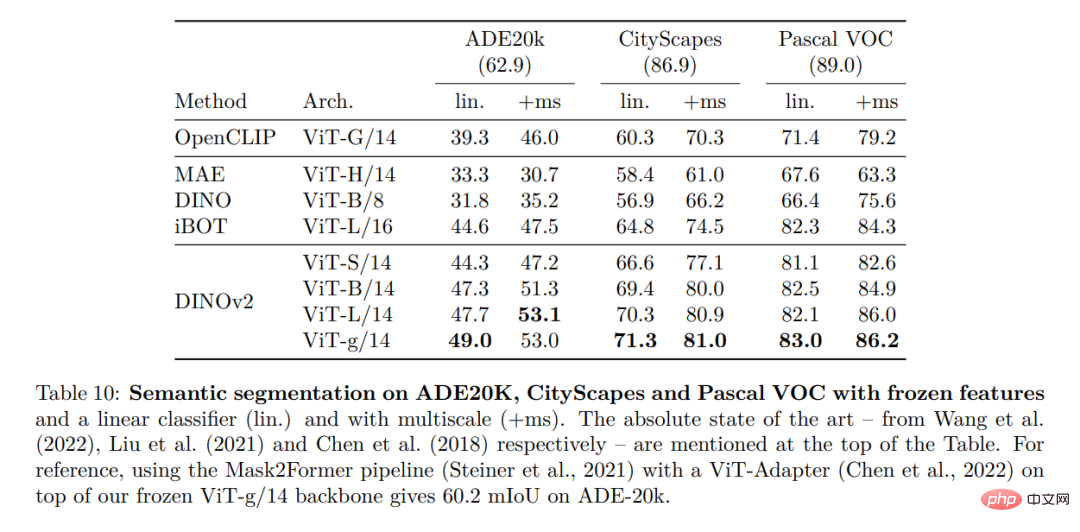

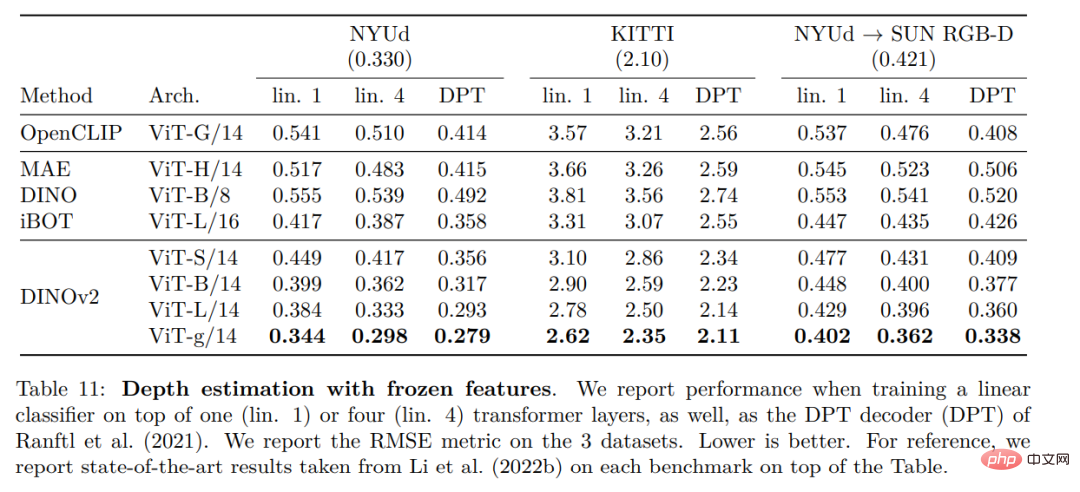

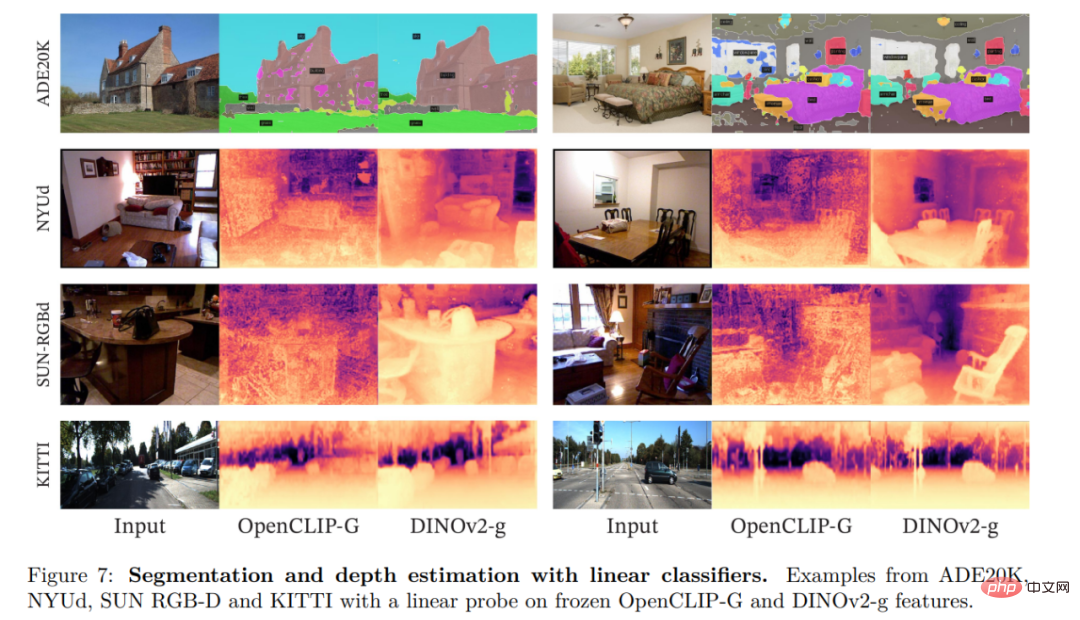

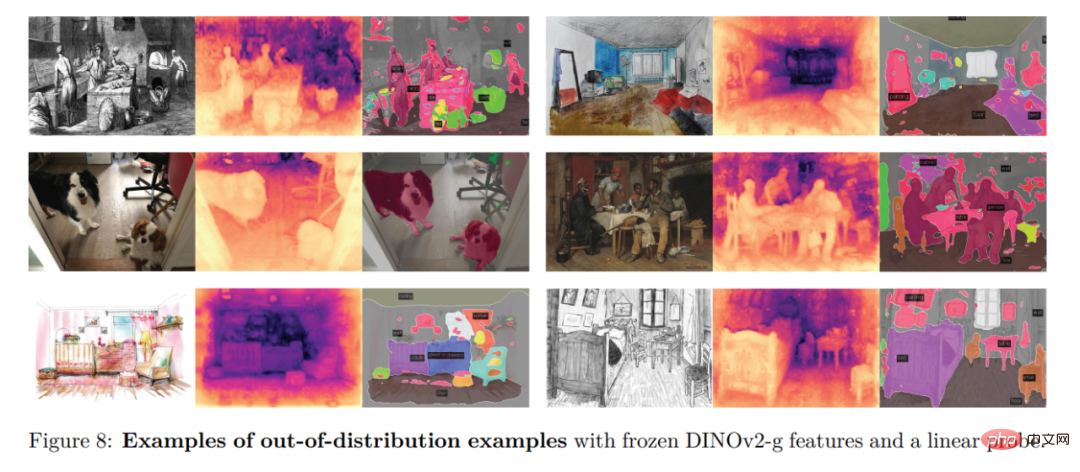

Tugas pengecaman padat

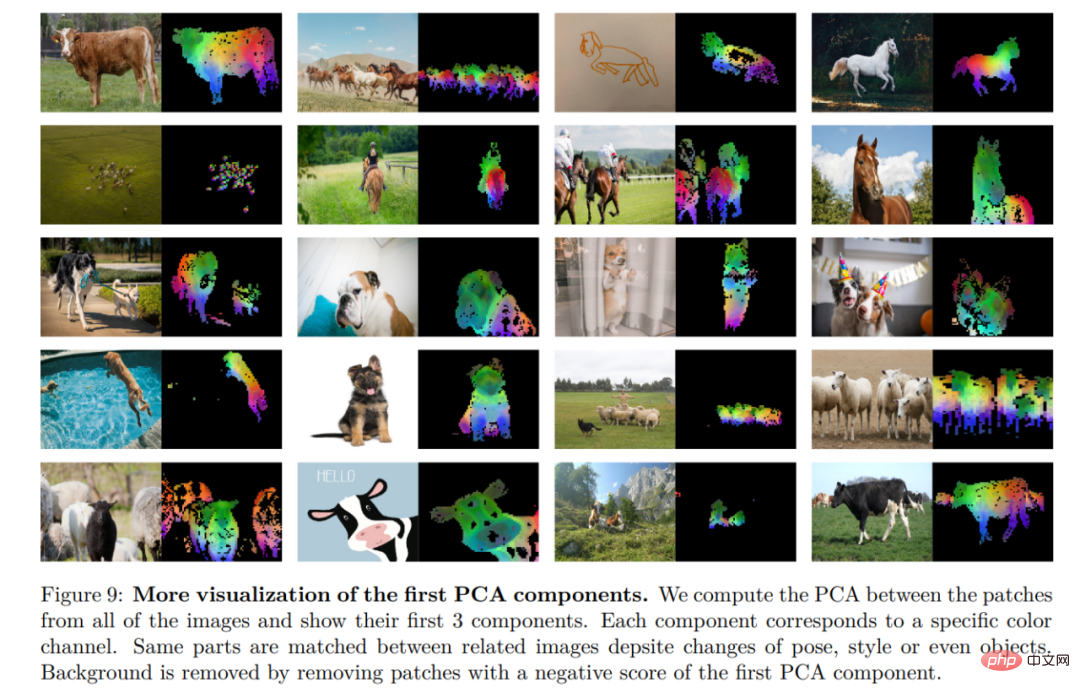

Hasil kualitatif

Atas ialah kandungan terperinci Meta mengeluarkan sumber terbuka model besar pelbagai guna untuk membantu bergerak selangkah lebih dekat kepada penyatuan visual. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1377

1377

52

52

Bagaimana untuk menyelesaikan misi koridor seram dalam Simulator Kambing 3

Feb 25, 2024 pm 03:40 PM

Bagaimana untuk menyelesaikan misi koridor seram dalam Simulator Kambing 3

Feb 25, 2024 pm 03:40 PM

Koridor Keganasan ialah misi dalam Simulator Kambing 3. Bagaimanakah anda boleh menyelesaikan misi ini dengan kaedah pelepasan terperinci dan proses yang sepadan, dan dapat menyelesaikan cabaran yang sepadan dalam misi ini Panduan untuk mempelajari maklumat berkaitan. Simulator Kambing 3 Panduan Koridor Keganasan 1. Mula-mula, pemain perlu pergi ke Silent Hill di sudut kiri atas peta. 2. Di sini anda boleh melihat sebuah rumah dengan tulisan RESTSTOP di atas bumbung Pemain perlu mengendalikan kambing untuk memasuki rumah ini. 3. Selepas masuk ke dalam bilik, kami mula-mula pergi terus ke hadapan, dan kemudian belok kanan. Ada pintu di hujung sini, dan kami terus masuk dari sini. 4. Selepas masuk, kita juga perlu berjalan ke hadapan dan kemudian belok ke kanan apabila sampai ke pintu di sini, pintu akan ditutup dan kita perlu berpatah balik.

Bagaimana untuk melepasi misi Imperial Tomb dalam Goat Simulator 3

Mar 11, 2024 pm 01:10 PM

Bagaimana untuk melepasi misi Imperial Tomb dalam Goat Simulator 3

Mar 11, 2024 pm 01:10 PM

Simulator Kambing 3 ialah permainan dengan permainan simulasi klasik, membolehkan pemain mengalami sepenuhnya keseronokan simulasi aksi kasual Permainan ini juga mempunyai banyak tugas khas yang menarik Antaranya, tugas Makam Imperial Kambing memerlukan pemain mencari menara loceng. Sesetengah pemain tidak pasti bagaimana untuk mengendalikan tiga jam pada masa yang sama Berikut adalah panduan untuk misi Makam dalam Simulator Kambing 3 Panduan untuk misi Makam dalam Simulator Kambing 3 adalah untuk membunyikan loceng mengikut tertib. Perluasan langkah terperinci 1. Mula-mula, pemain perlu membuka peta dan pergi ke Tanah Perkuburan Wuqiu. 2. Kemudian naik ke menara loceng akan ada tiga loceng di dalam. 3. Kemudian, mengikut urutan daripada terbesar kepada terkecil, ikut kebiasaan 222312312. 4. Selepas selesai mengetuk, anda boleh menyelesaikan misi dan membuka pintu untuk mendapatkan lightsaber.

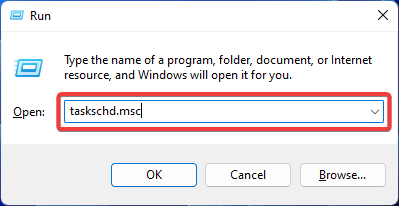

Betulkan: Operator menolak ralat permintaan dalam Windows Task Scheduler

Aug 01, 2023 pm 08:43 PM

Betulkan: Operator menolak ralat permintaan dalam Windows Task Scheduler

Aug 01, 2023 pm 08:43 PM

Untuk mengautomasikan tugas dan mengurus berbilang sistem, perisian perancangan tugas ialah alat yang berharga dalam senjata anda, terutamanya sebagai pentadbir sistem. Penjadual Tugas Windows melakukan tugas dengan sempurna, tetapi baru-baru ini ramai orang telah melaporkan ralat permintaan yang ditolak oleh operator. Masalah ini wujud dalam semua lelaran sistem pengendalian, dan walaupun ia telah dilaporkan dan dilindungi secara meluas, tiada penyelesaian yang berkesan. Teruskan membaca untuk mengetahui perkara yang mungkin berkesan untuk orang lain! Apakah permintaan dalam Penjadual Tugas 0x800710e0 yang dinafikan oleh pengendali atau pentadbir? Penjadual Tugas membolehkan mengautomasikan pelbagai tugas dan aplikasi tanpa input pengguna. Anda boleh menggunakannya untuk menjadualkan dan mengatur aplikasi tertentu, mengkonfigurasi pemberitahuan automatik, membantu menghantar mesej dan banyak lagi. ia

Bagaimana untuk melakukan misi menyelamat Steve dalam Goat Simulator 3

Feb 25, 2024 pm 03:34 PM

Bagaimana untuk melakukan misi menyelamat Steve dalam Goat Simulator 3

Feb 25, 2024 pm 03:34 PM

Rescue Steve ialah tugas unik dalam Goat Simulator 3. Apakah sebenarnya yang perlu dilakukan untuk menyelesaikannya? Tugas ini agak mudah, tetapi kami perlu berhati-hati agar tidak salah faham maksudnya. Di sini kami akan membawa anda untuk menyelamatkan Steve dalam Goat Simulator 3 Panduan tugas dapat menyelesaikan tugasan yang berkaitan dengan lebih baik. Simulator Kambing 3 Menyelamatkan Steve Strategi Misi 1. Mula-mula datang ke mata air panas di sudut kanan bawah peta. 2. Selepas tiba di kolam air panas, anda boleh mencetuskan tugas untuk menyelamatkan Steve. 3. Perhatikan bahawa terdapat seorang lelaki di kolam air panas Walaupun namanya Steve, dia bukan sasaran misi ini. 4. Cari ikan bernama Steve di kolam air panas ini dan bawa ia ke darat untuk menyelesaikan tugasan ini.

Di manakah saya boleh mencari tugas kumpulan peminat Douyin? Adakah kelab peminat Douyin akan kehilangan tahap?

Mar 07, 2024 pm 05:25 PM

Di manakah saya boleh mencari tugas kumpulan peminat Douyin? Adakah kelab peminat Douyin akan kehilangan tahap?

Mar 07, 2024 pm 05:25 PM

Sebagai salah satu platform media sosial yang paling popular pada masa ini, TikTok telah menarik sejumlah besar pengguna untuk mengambil bahagian. Di Douyin, terdapat banyak tugas kumpulan peminat yang pengguna boleh selesaikan untuk mendapatkan ganjaran dan faedah tertentu. Jadi, di manakah saya boleh mencari tugas kelab peminat Douyin? 1. Di manakah saya boleh mencari tugas kelab peminat Douyin? Untuk mencari tugas kumpulan peminat Douyin, anda perlu melawati laman utama peribadi Douyin. Pada halaman utama, anda akan melihat pilihan yang dipanggil "Kelab Peminat." Klik pilihan ini dan anda boleh menyemak imbas kumpulan peminat yang telah anda sertai dan tugasan yang berkaitan. Dalam lajur tugas kelab peminat, anda akan melihat pelbagai jenis tugasan, seperti suka, ulasan, perkongsian, pemajuan, dsb. Setiap tugasan mempunyai ganjaran dan keperluan yang sepadan Secara umumnya, selepas menyelesaikan tugasan, anda akan menerima sejumlah syiling emas atau mata pengalaman.

Di luar ORB-SLAM3! SL-SLAM: Adegan bertekstur lemah ringan, kegelisahan teruk dan lemah semuanya dikendalikan

May 30, 2024 am 09:35 AM

Di luar ORB-SLAM3! SL-SLAM: Adegan bertekstur lemah ringan, kegelisahan teruk dan lemah semuanya dikendalikan

May 30, 2024 am 09:35 AM

Ditulis sebelum ini, hari ini kita membincangkan bagaimana teknologi pembelajaran mendalam boleh meningkatkan prestasi SLAM berasaskan penglihatan (penyetempatan dan pemetaan serentak) dalam persekitaran yang kompleks. Dengan menggabungkan kaedah pengekstrakan ciri dalam dan pemadanan kedalaman, di sini kami memperkenalkan sistem SLAM visual hibrid serba boleh yang direka untuk meningkatkan penyesuaian dalam senario yang mencabar seperti keadaan cahaya malap, pencahayaan dinamik, kawasan bertekstur lemah dan seks yang teruk. Sistem kami menyokong berbilang mod, termasuk konfigurasi monokular, stereo, monokular-inersia dan stereo-inersia lanjutan. Selain itu, ia juga menganalisis cara menggabungkan SLAM visual dengan kaedah pembelajaran mendalam untuk memberi inspirasi kepada penyelidikan lain. Melalui percubaan yang meluas pada set data awam dan data sampel sendiri, kami menunjukkan keunggulan SL-SLAM dari segi ketepatan kedudukan dan keteguhan penjejakan.

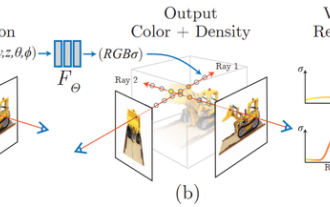

Apakah itu NeRF? Adakah pembinaan semula 3D berasaskan NeRF berasaskan voxel?

Oct 16, 2023 am 11:33 AM

Apakah itu NeRF? Adakah pembinaan semula 3D berasaskan NeRF berasaskan voxel?

Oct 16, 2023 am 11:33 AM

1 Pengenalan Medan Sinaran Neural (NeRF) adalah paradigma yang agak baharu dalam bidang pembelajaran mendalam dan penglihatan komputer. Teknologi ini telah diperkenalkan dalam kertas kerja ECCV2020 "NeRF: Mewakili Pemandangan sebagai Medan Sinaran Neural untuk Sintesis Pandangan" (yang memenangi Anugerah Kertas Terbaik) dan sejak itu telah menjadi sangat popular, dengan hampir 800 petikan sehingga kini [1]. Pendekatan ini menandakan perubahan besar dalam cara tradisional pembelajaran mesin memproses data 3D. Perwakilan pemandangan medan sinaran saraf dan proses pemaparan yang boleh dibezakan: imej komposit dengan mensampel koordinat 5D (kedudukan dan arah tontonan) sepanjang sinar kamera menyuapkan kedudukan ini ke dalam MLP untuk menghasilkan ketumpatan warna dan isipadu dan menggabungkan nilai ini menggunakan imej teknik pemaparan volumetrik; ; fungsi rendering boleh dibezakan, jadi ia boleh diluluskan

Analisis Masa Pentagon Warrior! Universiti Tsinghua mencadangkan TimesNet: terkemuka dalam ramalan, pengisian, pengelasan dan pengesanan

Apr 11, 2023 pm 07:34 PM

Analisis Masa Pentagon Warrior! Universiti Tsinghua mencadangkan TimesNet: terkemuka dalam ramalan, pengisian, pengelasan dan pengesanan

Apr 11, 2023 pm 07:34 PM

Mencapai kepelbagaian tugas ialah isu teras dalam penyelidikan model asas pembelajaran mendalam, dan juga merupakan salah satu fokus utama dalam hala tuju terkini model besar. Walau bagaimanapun, dalam bidang siri masa, pelbagai jenis tugasan analisis sangat berbeza-beza, termasuk tugas ramalan yang memerlukan tugas pemodelan dan pengelasan yang terperinci yang memerlukan pengekstrakan maklumat semantik peringkat tinggi. Bagaimana untuk membina model asas mendalam bersatu untuk menyelesaikan pelbagai tugas analisis masa dengan cekap masih belum diwujudkan. Untuk tujuan ini, pasukan dari Sekolah Perisian Universiti Tsinghua menjalankan penyelidikan mengenai isu asas pemodelan perubahan masa dan cadangan TimesNet, model asas pemasaan tugasan universal yang telah diterima oleh ICLR 2023. Senarai pengarang: Wu Haixu*, Hu Tengge*, Liu Yong*, Zhou Hang, Wang Jianmin, Long Mingsheng Pautan: https://ope