Hari ini, bulatan AI dilanda "perolehan" yang mengejutkan.

Rajah dalam "Perhatian Adalah Semua Keperluan Anda", kerja asas NLP Google Brain dan pencetus seni bina Transformer, didapati oleh netizen sebagai tidak konsisten dengan kod tersebut.

Alamat kertas: https://arxiv.org/abs/1706.03762

Sejak dilancarkan pada 2017, Transformer telah menjadi raja asas dalam bidang AI. Malah dalang sebenar di sebalik ChatGPT yang popular adalah dia.

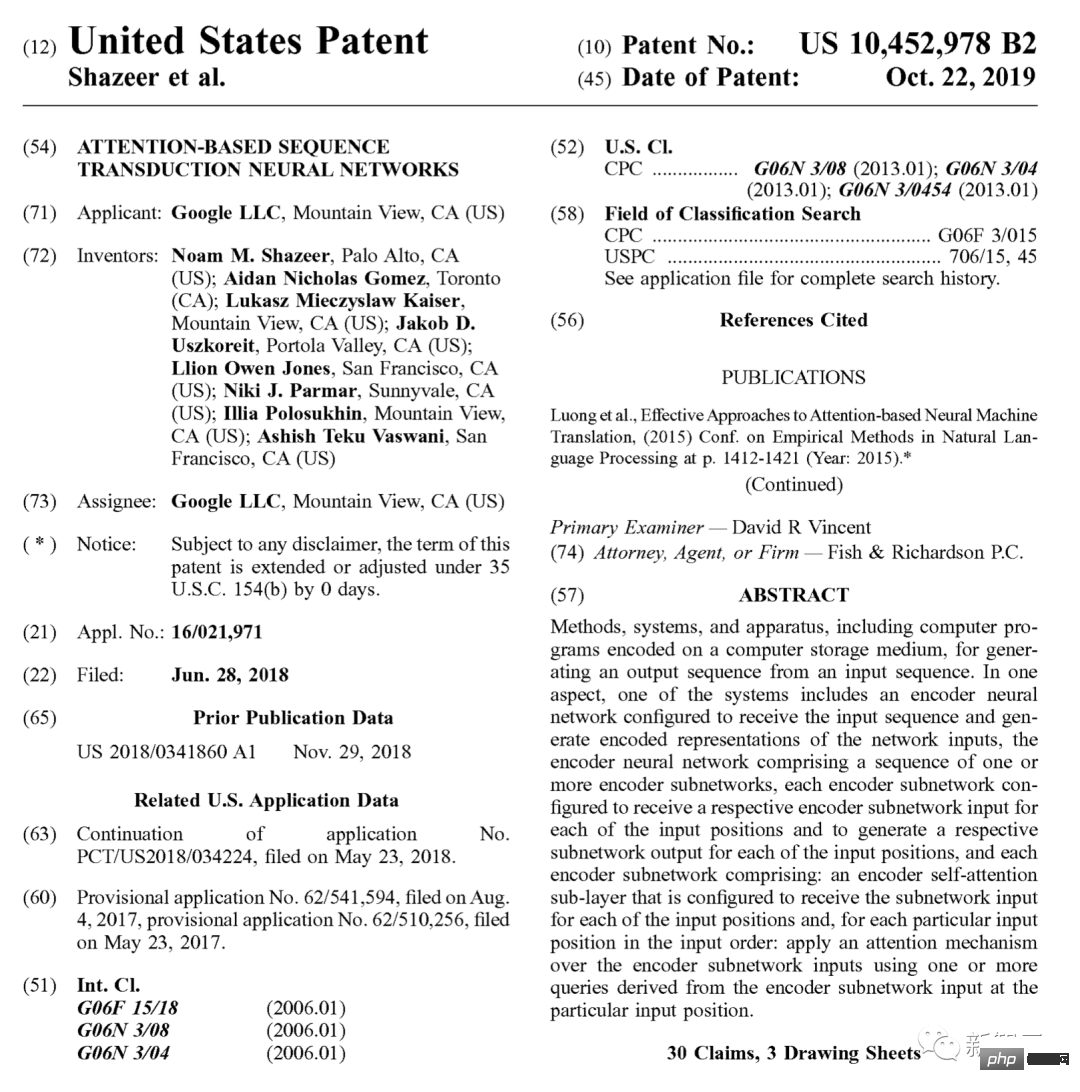

Pada tahun 2019, Google turut memohon paten khusus untuknya.

Menjejak kembali ke asal, semua jenis GPT (Generative Pre-trained Transformer) yang muncul sekarang semuanya berasal daripada artikel ini 17 tahun tesis.

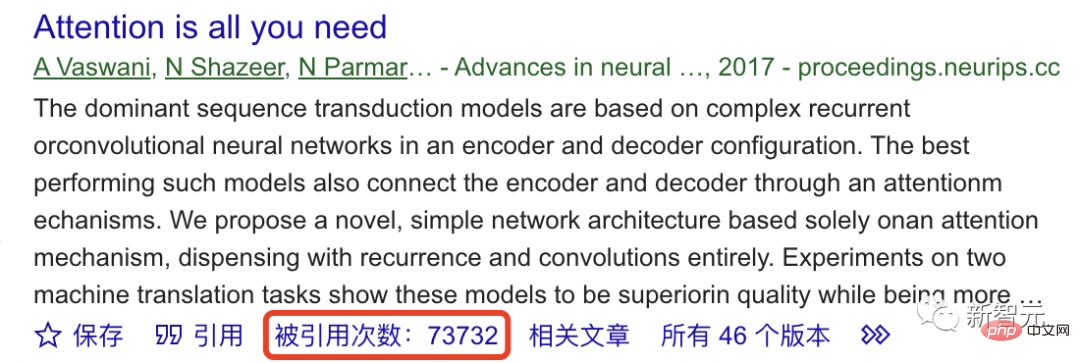

Menurut Google Scholar, setakat ini, karya asas ini telah disebut lebih daripada 70,000 kali.

Jadi, asas ChatGPT tidak stabil?

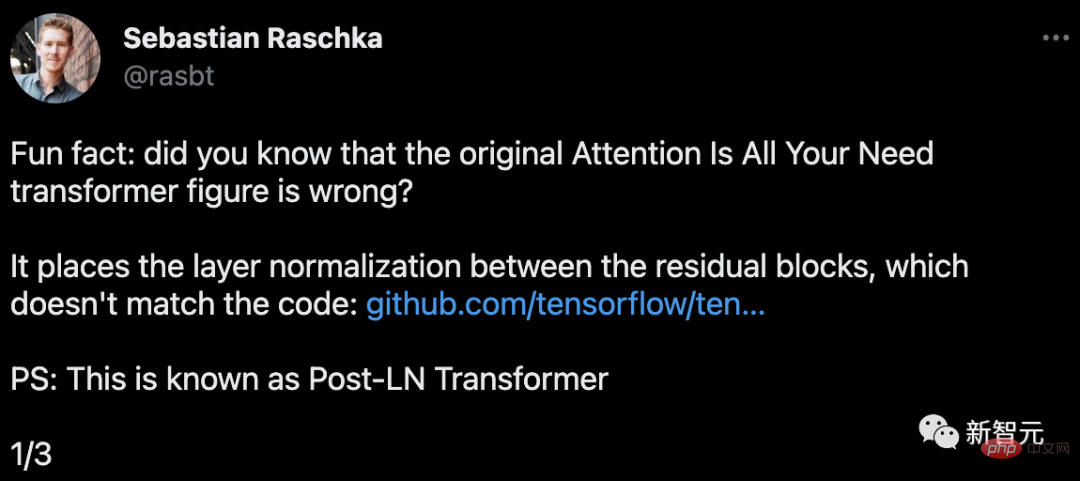

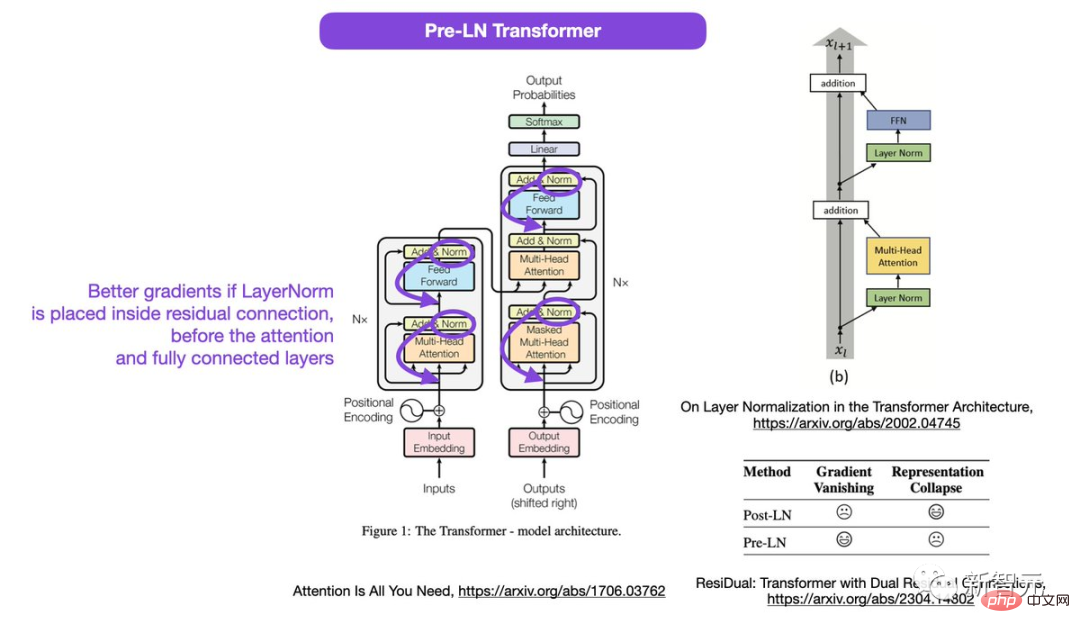

Sebastian Raschka, pengasas Lightning AI dan penyelidik pembelajaran mesin, mendapati bahawa gambar rajah Transformer dalam kertas ini adalah salah.

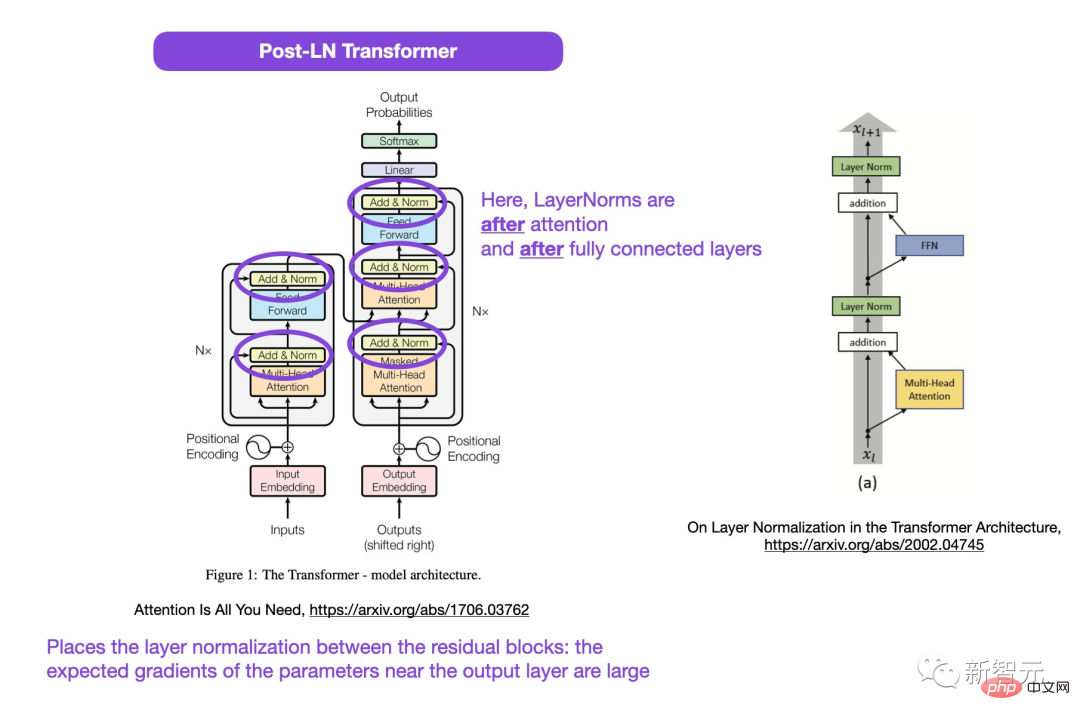

Kawasan yang dibulatkan dalam gambar, LayerNorms adalah selepas perhatian dan lapisan bersambung sepenuhnya. Meletakkan normalisasi lapisan antara blok sisa menghasilkan kecerunan yang dijangkakan besar untuk parameter berhampiran lapisan keluaran.

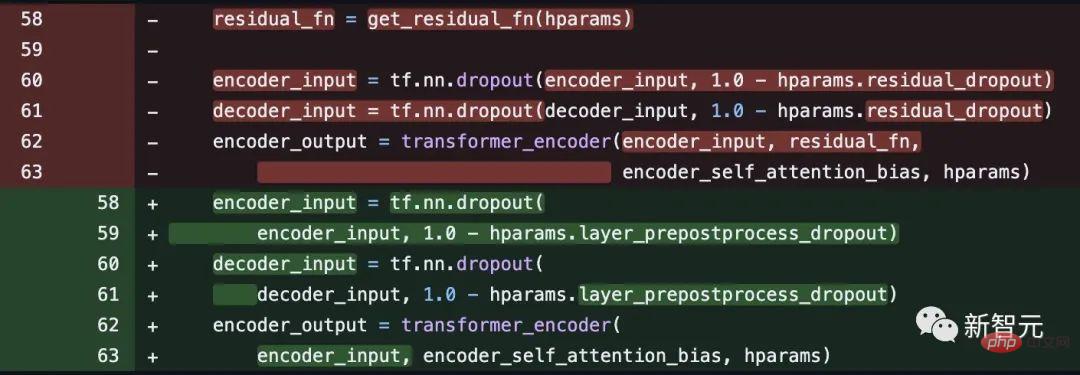

Selain itu, ini tidak konsisten dengan kod.

Alamat kod: https: //github.com/tensorflow/tensor2tensor/commit/f5c9b17e617ea9179b7d84d36b1e8162cb369f25#diff-76e2b94ef16871bdbf46bf04dfe7f1847baf7f1847baf7f1847b7f18477f7f18b7c8f7c8f7f7c

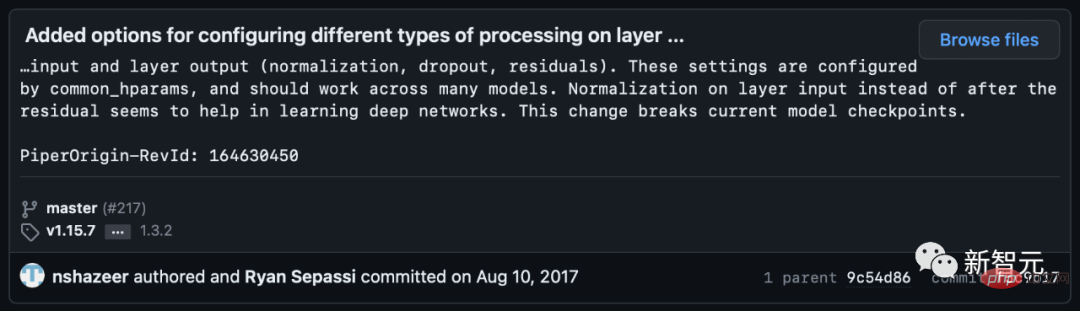

Namun, beberapa netizen menegaskan bahawa Noam Shazeer membetulkan kod itu beberapa minggu kemudian.

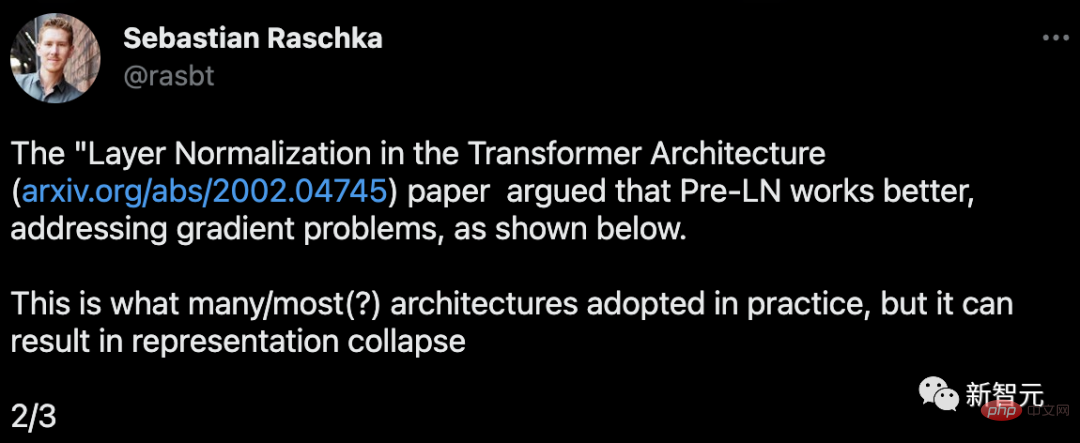

Kemudian, Sebastian berkata bahawa dalam kertas Normalisasi Lapisan dalam Seni Bina Transformer, Pra-LN berprestasi lebih baik, masalah Kecerunan boleh diselesaikan.

Inilah yang dilakukan oleh kebanyakan atau kebanyakan seni bina dalam amalan, tetapi ia boleh menyebabkan perwakilan runtuh.

Kecerunan yang lebih baik akan dicapai jika normalisasi lapisan diletakkan dalam sambungan baki sebelum perhatian dan lapisan bersambung sepenuhnya.

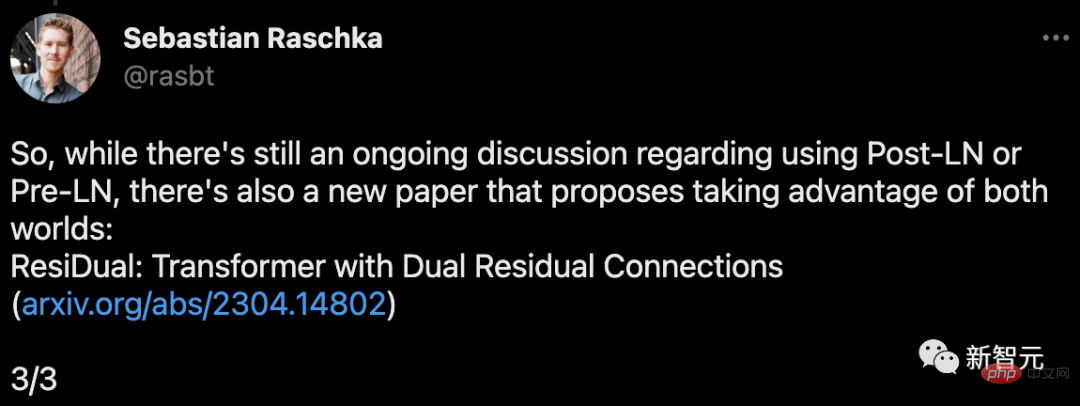

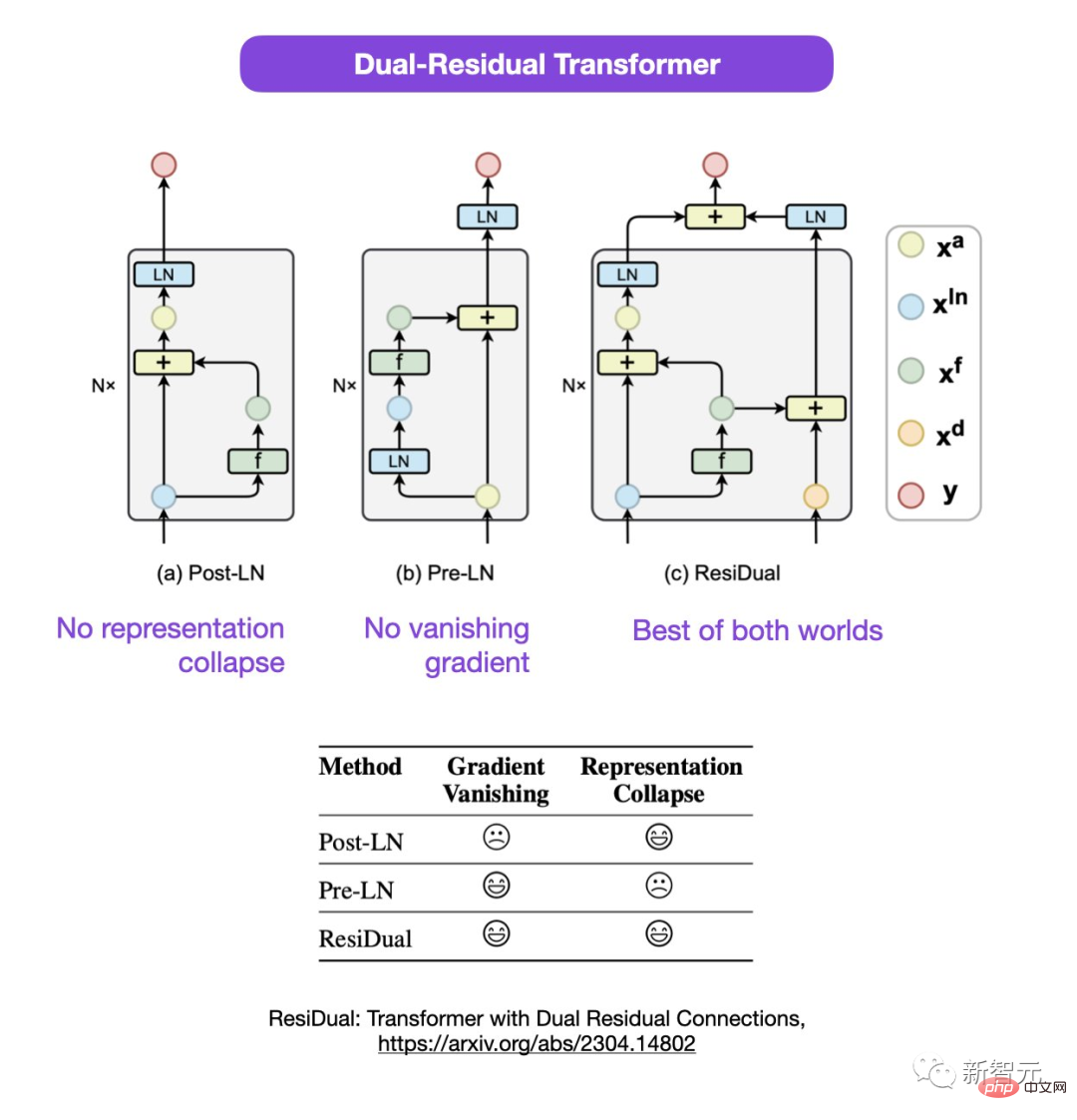

Sebastian menegaskan bahawa walaupun perbincangan mengenai penggunaan Post-LN atau Pra-LN masih diteruskan, terdapat juga kertas baharu yang mencadangkan untuk menggabungkan kedua-duanya.

Alamat kertas: https://arxiv.org/abs/2304.14802

Dalam Transformer baki dua kali ini, masalah keruntuhan perwakilan dan kehilangan kecerunan diselesaikan.

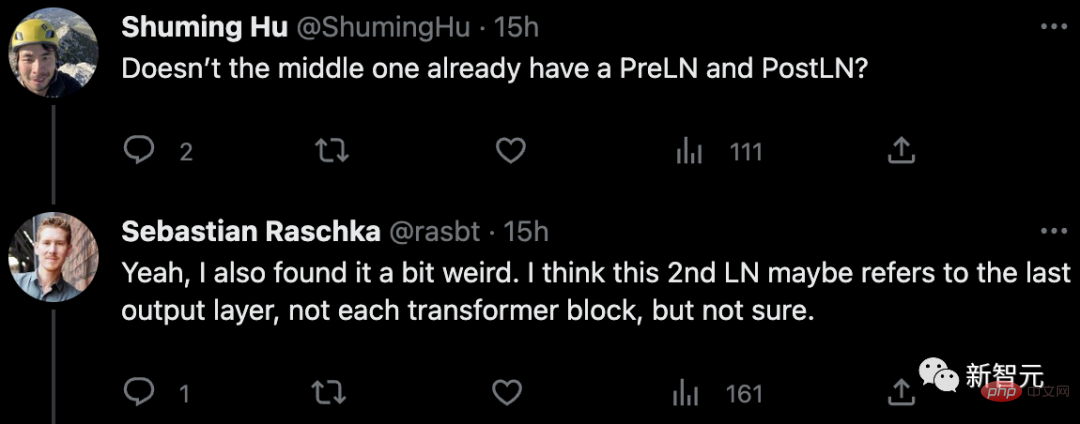

Mengenai perkara yang meragukan dalam akhbar itu, beberapa netizen menegaskan: Bukankah sudah ada sesuatu di tengah-tengah Adakah anda telah mempelajari PreLN dan PostLN?

Sebastian menjawab dia berasa agak pelik juga. Mungkin LN ke-2 merujuk kepada lapisan keluaran terakhir dan bukannya setiap blok pengubah, tetapi dia juga tidak pasti tentang itu.

Sesetengah netizen berkata: "Kami sering menemui kertas yang tidak sepadan dengan kod atau keputusan. Kebanyakannya adalah kerana untuk Salah, tetapi kadang-kadang ia membuat orang tertanya-tanya kertas ini sudah lama beredar. >

Sebastian berkata untuk bersikap adil, kod asal adalah konsisten dengan gambar, tetapi mereka mengubah suai versi kod pada 2017 tetapi tidak mengemas kini gambar. Jadi, ini mengelirukan.

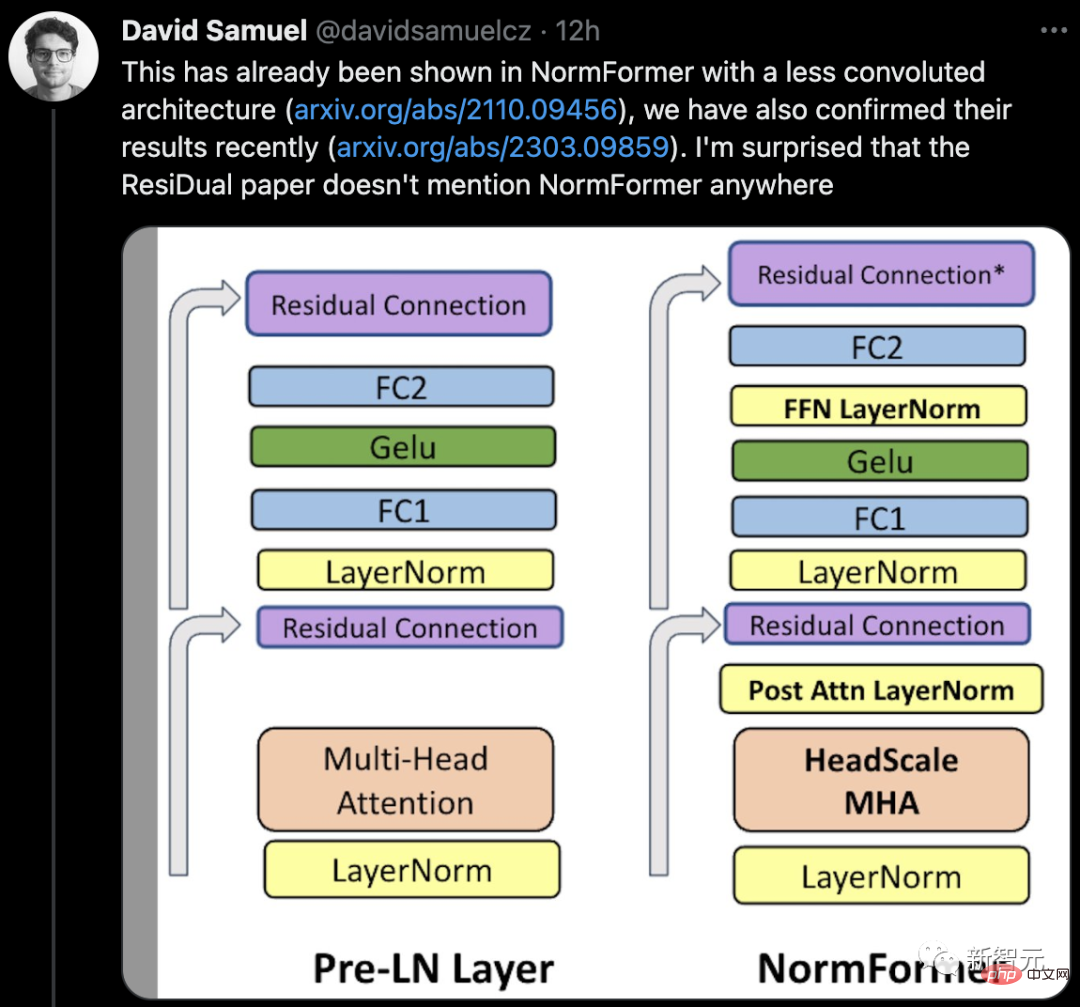

Sesetengah netizen berkata bahawa sudah ada kertas kerja yang menunjukkan seni bina yang kurang kompleks dalam NormFormer, dan pasukannya Keputusan mereka juga baru-baru ini disahkan. Kertas ResiDual tidak menyebut NormFormer di mana-mana, yang mengejutkan.

Pada masa yang sama, netizen terus muncul di ruangan komen mengesahkan LN yang digunakan dalam Transformers adalah berbeza dengan kaedah yang digunakan dalam CNN.

Jadi, kertas itu memang ada kelemahan, Atau kejadian sendiri?

Mari kita tunggu dan lihat apa yang berlaku seterusnya.

Atas ialah kandungan terperinci Kertas perintis Transformer mengejutkan? Gambar itu tidak konsisten dengan kod, dan pepijat misteri membuatkan saya bodoh. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!