Cara menggunakan modul python beautifulsoup4

1. Tambahan pengetahuan asas BeautifulSoup4

BeautifulSoup4 ialah pustaka penghuraian python, terutamanya digunakan untuk menghuraikan HTML dan XML akan terdapat lebih banyak penghuraian HTML dalam sistem pengetahuan perangkak,

Perintah pemasangan untuk perpustakaan ini adalah seperti berikut:

pip install beautifulsoup4

BeautifulSoup Apabila parsing data, anda perlu bergantung pada parser pihak ketiga. kelebihan mereka adalah seperti berikut:

: Python mempunyai perpustakaan standard terbina dalam dan mempunyai toleransi kesalahan yang kuat;

python 标准库 html.parser: Ia pantas dan mempunyai toleransi kesalahan yang kuat;Seterusnya, gunakan kod HTML tersuai untuk menunjukkan penggunaan asas pustaka

lxml 解析器Kod ujian adalah seperti berikut:<html> <head> <title>测试bs4模块脚本</title> </head> <body> <h2 id="橡皮擦的爬虫课">橡皮擦的爬虫课</h2> <p>用一段自定义的 HTML 代码来演示</p> </body> </html>Salin selepas log masukGunakan - untuk. hanya Operasi termasuk menginstant objek BS, mengeluarkan label halaman, dsb.

from bs4 import BeautifulSoup text_str = """<html> <head> <title>测试bs4模块脚本</title> </head> <body> <h2 id="橡皮擦的爬虫课">橡皮擦的爬虫课</h2> <p>用1段自定义的 HTML 代码来演示</p> <p>用2段自定义的 HTML 代码来演示</p> </body> </html> """ # 实例化 Beautiful Soup 对象 soup = BeautifulSoup(text_str, "html.parser") # 上述是将字符串格式化为 Beautiful Soup 对象,你可以从一个文件进行格式化 # soup = BeautifulSoup(open('test.html')) print(soup) # 输入网页标题 title 标签 print(soup.title) # 输入网页 head 标签 print(soup.head) # 测试输入段落标签 p print(soup.p) # 默认获取第一个

Salin selepas log masukhtml5libKami boleh terus memanggil tag halaman web melalui objek BeautifulSoup Terdapat masalah di sini Memanggil tag melalui objek BS hanya boleh mendapatkan tag di tempat pertama, hanya satu tag, jika anda ingin mendapatkan lebih banyak kandungan, sila teruskan membaca.

Selepas mempelajari ini, kita perlu memahami 4 objek terbina dalam dalam BeautifulSoup: beautifulsoup4

BeautifulSoup

: objek asas, keseluruhan Objek HTML, Secara amnya, ia boleh dilihat sebagai objek Tag; p

: teg rentetan dalaman;

BeautifulSoup: objek anotasi, yang jarang digunakan dalam perangkak.TagKod berikut menunjukkan kepada anda senario di mana objek ini muncul Beri perhatian kepada ulasan yang berkaitan dalam kod:- <. 🎜>Untuk

Tag objek

danNavigableStringmempunyai dua atribut penting, iaitu from bs4 import BeautifulSoup text_str = """<html> <head> <title>测试bs4模块脚本</title> </head> <body> <h2 id="橡皮擦的爬虫课">橡皮擦的爬虫课</h2> <p>用1段自定义的 HTML 代码来演示</p> <p>用2段自定义的 HTML 代码来演示</p> <a href="http://www.csdn.net" rel="external nofollow" rel="external nofollow" >CSDN 网站</a> </body> </html> """ # 实例化 Beautiful Soup 对象 soup = BeautifulSoup(text_str, "html.parser") print(soup.name) # [document] print(soup.title.name) # 获取标签名 title print(soup.html.body.a) # 可以通过标签层级获取下层标签 print(soup.body.a) # html 作为一个特殊的根标签,可以省略 print(soup.p.a) # 无法获取到 a 标签 print(soup.a.attrs) # 获取属性

Salin selepas log masukCommentKod di atas menunjukkan penggunaan mendapatkan atribut dan atribut , di mana atribut

from bs4 import BeautifulSoup text_str = """<html> <head> <title>测试bs4模块脚本</title> </head> <body> <h2 id="橡皮擦的爬虫课">橡皮擦的爬虫课</h2> <p>用1段自定义的 HTML 代码来演示</p> <p>用2段自定义的 HTML 代码来演示</p> </body> </html> """ # 实例化 Beautiful Soup 对象 soup = BeautifulSoup(text_str, "html.parser") # 上述是将字符串格式化为 Beautiful Soup 对象,你可以从一个文件进行格式化 # soup = BeautifulSoup(open('test.html')) print(soup) print(type(soup)) # <class 'bs4.BeautifulSoup'> # 输入网页标题 title 标签 print(soup.title) print(type(soup.title)) # <class 'bs4.element.Tag'> print(type(soup.title.string)) # <class 'bs4.element.NavigableString'> # 输入网页 head 标签 print(soup.head)

Dapatkan nilai atribut teg Dalam BeautifulSoup, anda juga boleh menggunakan kaedah berikut:

print(soup.a["href"])

print(soup.a.get("href"))Dapatkan objek Selepas mendapat teg halaman web. , anda perlu mendapatkan tag Kandungan dijana melalui kod berikut. print(soup.a.string)

nameSelain itu, anda juga boleh menggunakan atribut attrs dan kaedah untuk mendapatkan kandungan tag.

print(soup.a.string) print(soup.a.text) print(soup.a.get_text())

juga boleh mendapatkan semua teks dalam tag, hanya gunakan name dan attrs. attrs

print(list(soup.body.strings)) # 获取到空格或者换行 print(list(soup.body.stripped_strings)) # 去除空格或者换行

Pemilih teg/nod lanjutan untuk melintasi pepohon dokumen

Nod anak langsungNavigableStringElemen anak langsung objek teg (Tag), anda boleh menggunakan atribut

diperolehi. text

from bs4 import BeautifulSoup

text_str = """<html>

<head>

<title>测试bs4模块脚本</title>

</head>

<body>

<div id="content">

<h2 id="橡皮擦的爬虫课-span-最棒-span">橡皮擦的爬虫课<span>最棒</span></h2>

<p>用1段自定义的 HTML 代码来演示</p>

<p>用2段自定义的 HTML 代码来演示</p>

<a href="http://www.csdn.net" rel="external nofollow" rel="external nofollow" >CSDN 网站</a>

</div>

<ul class="nav">

<li>首页</li>

<li>博客</li>

<li>专栏课程</li>

</ul>

</body>

</html>

"""

# 实例化 Beautiful Soup 对象

soup = BeautifulSoup(text_str, "html.parser")

# contents 属性获取节点的直接子节点,以列表的形式返回内容

print(soup.div.contents) # 返回列表

# children 属性获取的也是节点的直接子节点,以生成器的类型返回

print(soup.div.children) # 返回 <list_iterator object at 0x00000111EE9B6340>get_text() Sila ambil perhatian bahawa kedua-dua atribut di atas memperoleh nod anak langsung , seperti teg keturunan strings dalam teg stripped_strings dan tidak akan diperoleh secara berasingan.

Jika anda ingin mendapatkan semua teg, gunakan atribut , yang mengembalikan penjana dan semua teg termasuk teks dalam teg akan diambil secara berasingan.

print(list(soup.div.descendants))

contentschildren dan

h2span,

, descendants: masing-masing mewakili nod adik beradik seterusnya, semua nod adik beradik di bawah, nod adik beradik sebelumnya dan semua nod adik beradik di atas. Memandangkan aksara baris baharu juga merupakan nod, jadi apabila menggunakan atribut ini, perhatikan aksara baris baharu; >: ini Beberapa atribut masing-masing mewakili nod sebelumnya atau nod seterusnya Ambil perhatian bahawa ia bukan hierarki, tetapi untuk semua nod, sebagai contoh, dalam kod di atas, nod seterusnya bagi nod

Ya

.parentparentsFungsi berkaitan carian pepohon dokumen- Fungsi pertama yang perlu dipelajari ialah fungsi

dan prototaip

next_siblingadalah seperti berikut :next_siblingsprevious_siblingfind_all(name,attrs,recursive,text,limit=None,**kwargs)

Salin selepas log masukprevious_siblings - : Parameter ini ialah nama tag teg Contohnya,

adalah untuk mencari semua rentetan nama teg dan ungkapan biasa boleh diterima Rumus dan senarai;

attrs:传入的属性,该参数可以字典的形式传入,例如attrs={'class': 'nav'},返回的结果是 tag 类型的列表;

上述两个参数的用法示例如下:

print(soup.find_all('li')) # 获取所有的 li

print(soup.find_all(attrs={'class': 'nav'})) # 传入 attrs 属性

print(soup.find_all(re.compile("p"))) # 传递正则,实测效果不理想

print(soup.find_all(['a','p'])) # 传递列表recursive:调用find_all ()方法时,BeautifulSoup 会检索当前 tag 的所有子孙节点,如果只想搜索 tag 的直接子节点,可以使用参数recursive=False,测试代码如下:

print(soup.body.div.find_all(['a','p'],recursive=False)) # 传递列表

text:可以检索文档中的文本字符串内容,与name参数的可选值一样,text参数接受标签名字符串、正则表达式、 列表;

print(soup.find_all(text='首页')) # ['首页']

print(soup.find_all(text=re.compile("^首"))) # ['首页']

print(soup.find_all(text=["首页",re.compile('课')])) # ['橡皮擦的爬虫课', '首页', '专栏课程']limit:可以用来限制返回结果的数量;kwargs:如果一个指定名字的参数不是搜索内置的参数名,搜索时会把该参数当作 tag 的属性来搜索。这里要按class属性搜索,因为class是 python 的保留字,需要写作class_,按class_查找时,只要一个 CSS 类名满足即可,如需多个 CSS 名称,填写顺序需要与标签一致。

print(soup.find_all(class_ = 'nav')) print(soup.find_all(class_ = 'nav li'))

还需要注意网页节点中,有些属性在搜索中不能作为kwargs参数使用,比如html5 中的 data-*属性,需要通过attrs参数进行匹配。

与

find_all()方法用户基本一致的其它方法清单如下:

find():函数原型find( name , attrs , recursive , text , **kwargs ),返回一个匹配元素;find_parents(),find_parent():函数原型find_parent(self, name=None, attrs={}, **kwargs),返回当前节点的父级节点;find_next_siblings(),find_next_sibling():函数原型find_next_sibling(self, name=None, attrs={}, text=None, **kwargs),返回当前节点的下一兄弟节点;find_previous_siblings(),find_previous_sibling():同上,返回当前的节点的上一兄弟节点;find_all_next(),find_next(),find_all_previous () ,find_previous ():函数原型find_all_next(self, name=None, attrs={}, text=None, limit=None, **kwargs),检索当前节点的后代节点。

CSS 选择器 该小节的知识点与pyquery有点撞车,核心使用select()方法即可实现,返回数据是列表元组。

通过标签名查找,

soup.select("title");通过类名查找,

soup.select(".nav");通过 id 名查找,

soup.select("#content");通过组合查找,

soup.select("div#content");通过属性查找,

soup.select("div[id='content'"),soup.select("a[href]");

在通过属性查找时,还有一些技巧可以使用,例如:

^=:可以获取以 XX 开头的节点:

print(soup.select('ul[class^="na"]'))

*=:获取属性包含指定字符的节点:

print(soup.select('ul[class*="li"]'))

二、爬虫案例

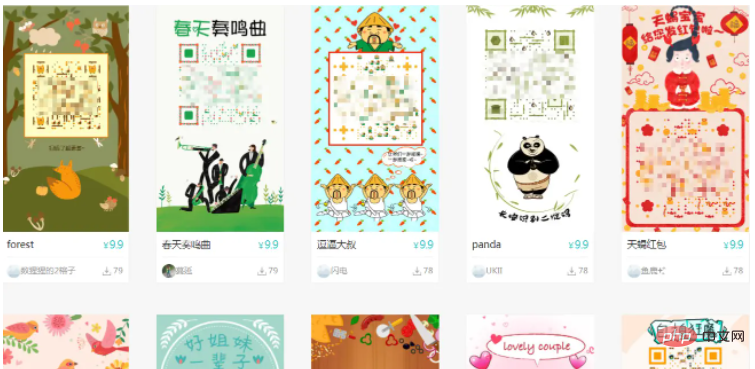

BeautifulSoup 的基础知识掌握之后,在进行爬虫案例的编写,就非常简单了,本次要采集的目标网站 ,该目标网站有大量的艺术二维码,可以供设计大哥做参考。

下述应用到了 BeautifulSoup 模块的标签检索与属性检索,完整代码如下:

from bs4 import BeautifulSoup

import requests

import logging

logging.basicConfig(level=logging.NOTSET)

def get_html(url, headers) -> None:

try:

res = requests.get(url=url, headers=headers, timeout=3)

except Exception as e:

logging.debug("采集异常", e)

if res is not None:

html_str = res.text

soup = BeautifulSoup(html_str, "html.parser")

imgs = soup.find_all(attrs={'class': 'lazy'})

print("获取到的数据量是", len(imgs))

datas = []

for item in imgs:

name = item.get('alt')

src = item["src"]

logging.info(f"{name},{src}")

# 获取拼接数据

datas.append((name, src))

save(datas, headers)

def save(datas, headers) -> None:

if datas is not None:

for item in datas:

try:

# 抓取图片

res = requests.get(url=item[1], headers=headers, timeout=5)

except Exception as e:

logging.debug(e)

if res is not None:

img_data = res.content

with open("./imgs/{}.jpg".format(item[0]), "wb+") as f:

f.write(img_data)

else:

return None

if __name__ == '__main__':

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/93.0.4577.82 Safari/537.36"

}

url_format = "http://www.9thws.com/#p{}"

urls = [url_format.format(i) for i in range(1, 2)]

get_html(urls[0], headers)本次代码测试输出采用的 logging 模块实现,效果如下图所示。 测试仅采集了 1 页数据,如需扩大采集范围,只需要修改 main 函数内页码规则即可。 ==代码编写过程中,发现数据请求是类型是 POST,数据返回格式是 JSON,所以本案例仅作为 BeautifulSoup 的上手案例吧==

Atas ialah kandungan terperinci Cara menggunakan modul python beautifulsoup4. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

Notepad++7.3.1

Editor kod yang mudah digunakan dan percuma

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa

Dreamweaver CS6

Alat pembangunan web visual

SublimeText3 versi Mac

Perisian penyuntingan kod peringkat Tuhan (SublimeText3)

Topik panas

1377

1377

52

52

Adakah Mysql perlu membayar

Apr 08, 2025 pm 05:36 PM

Adakah Mysql perlu membayar

Apr 08, 2025 pm 05:36 PM

MySQL mempunyai versi komuniti percuma dan versi perusahaan berbayar. Versi komuniti boleh digunakan dan diubahsuai secara percuma, tetapi sokongannya terhad dan sesuai untuk aplikasi dengan keperluan kestabilan yang rendah dan keupayaan teknikal yang kuat. Edisi Enterprise menyediakan sokongan komersil yang komprehensif untuk aplikasi yang memerlukan pangkalan data yang stabil, boleh dipercayai, berprestasi tinggi dan bersedia membayar sokongan. Faktor yang dipertimbangkan apabila memilih versi termasuk kritikal aplikasi, belanjawan, dan kemahiran teknikal. Tidak ada pilihan yang sempurna, hanya pilihan yang paling sesuai, dan anda perlu memilih dengan teliti mengikut keadaan tertentu.

Cara Menggunakan MySQL Selepas Pemasangan

Apr 08, 2025 am 11:48 AM

Cara Menggunakan MySQL Selepas Pemasangan

Apr 08, 2025 am 11:48 AM

Artikel ini memperkenalkan operasi pangkalan data MySQL. Pertama, anda perlu memasang klien MySQL, seperti MySqlworkbench atau Command Line Client. 1. Gunakan perintah MySQL-Uroot-P untuk menyambung ke pelayan dan log masuk dengan kata laluan akaun root; 2. Gunakan CreateTatabase untuk membuat pangkalan data, dan gunakan Pilih pangkalan data; 3. Gunakan createtable untuk membuat jadual, menentukan medan dan jenis data; 4. Gunakan InsertInto untuk memasukkan data, data pertanyaan, kemas kini data dengan kemas kini, dan padam data dengan padam. Hanya dengan menguasai langkah -langkah ini, belajar menangani masalah biasa dan mengoptimumkan prestasi pangkalan data anda boleh menggunakan MySQL dengan cekap.

Mysql tidak dapat dipasang setelah memuat turun

Apr 08, 2025 am 11:24 AM

Mysql tidak dapat dipasang setelah memuat turun

Apr 08, 2025 am 11:24 AM

Sebab utama kegagalan pemasangan MySQL adalah: 1. Isu kebenaran, anda perlu menjalankan sebagai pentadbir atau menggunakan perintah sudo; 2. Ketergantungan hilang, dan anda perlu memasang pakej pembangunan yang relevan; 3. Konflik pelabuhan, anda perlu menutup program yang menduduki port 3306 atau mengubah suai fail konfigurasi; 4. Pakej pemasangan adalah korup, anda perlu memuat turun dan mengesahkan integriti; 5. Pembolehubah persekitaran dikonfigurasikan dengan salah, dan pembolehubah persekitaran mesti dikonfigurasi dengan betul mengikut sistem operasi. Selesaikan masalah ini dan periksa dengan teliti setiap langkah untuk berjaya memasang MySQL.

Fail muat turun MySQL rosak dan tidak boleh dipasang. Penyelesaian pembaikan

Apr 08, 2025 am 11:21 AM

Fail muat turun MySQL rosak dan tidak boleh dipasang. Penyelesaian pembaikan

Apr 08, 2025 am 11:21 AM

Fail muat turun mysql adalah korup, apa yang perlu saya lakukan? Malangnya, jika anda memuat turun MySQL, anda boleh menghadapi rasuah fail. Ia benar -benar tidak mudah hari ini! Artikel ini akan bercakap tentang cara menyelesaikan masalah ini supaya semua orang dapat mengelakkan lencongan. Selepas membacanya, anda bukan sahaja boleh membaiki pakej pemasangan MySQL yang rosak, tetapi juga mempunyai pemahaman yang lebih mendalam tentang proses muat turun dan pemasangan untuk mengelakkan terjebak pada masa akan datang. Mari kita bercakap tentang mengapa memuat turun fail rosak. Terdapat banyak sebab untuk ini. Masalah rangkaian adalah pelakunya. Gangguan dalam proses muat turun dan ketidakstabilan dalam rangkaian boleh menyebabkan rasuah fail. Terdapat juga masalah dengan sumber muat turun itu sendiri. Fail pelayan itu sendiri rosak, dan sudah tentu ia juga dipecahkan jika anda memuat turunnya. Di samping itu, pengimbasan "ghairah" yang berlebihan beberapa perisian antivirus juga boleh menyebabkan rasuah fail. Masalah Diagnostik: Tentukan sama ada fail itu benar -benar korup

Adakah mysql memerlukan internet

Apr 08, 2025 pm 02:18 PM

Adakah mysql memerlukan internet

Apr 08, 2025 pm 02:18 PM

MySQL boleh berjalan tanpa sambungan rangkaian untuk penyimpanan dan pengurusan data asas. Walau bagaimanapun, sambungan rangkaian diperlukan untuk interaksi dengan sistem lain, akses jauh, atau menggunakan ciri -ciri canggih seperti replikasi dan clustering. Di samping itu, langkah -langkah keselamatan (seperti firewall), pengoptimuman prestasi (pilih sambungan rangkaian yang betul), dan sandaran data adalah penting untuk menyambung ke Internet.

Bagaimana untuk mengoptimumkan prestasi MySQL untuk aplikasi beban tinggi?

Apr 08, 2025 pm 06:03 PM

Bagaimana untuk mengoptimumkan prestasi MySQL untuk aplikasi beban tinggi?

Apr 08, 2025 pm 06:03 PM

Panduan Pengoptimuman Prestasi Pangkalan Data MySQL Dalam aplikasi yang berintensifkan sumber, pangkalan data MySQL memainkan peranan penting dan bertanggungjawab untuk menguruskan urus niaga besar-besaran. Walau bagaimanapun, apabila skala aplikasi berkembang, kemunculan prestasi pangkalan data sering menjadi kekangan. Artikel ini akan meneroka satu siri strategi pengoptimuman prestasi MySQL yang berkesan untuk memastikan aplikasi anda tetap cekap dan responsif di bawah beban tinggi. Kami akan menggabungkan kes-kes sebenar untuk menerangkan teknologi utama yang mendalam seperti pengindeksan, pengoptimuman pertanyaan, reka bentuk pangkalan data dan caching. 1. Reka bentuk seni bina pangkalan data dan seni bina pangkalan data yang dioptimumkan adalah asas pengoptimuman prestasi MySQL. Berikut adalah beberapa prinsip teras: Memilih jenis data yang betul dan memilih jenis data terkecil yang memenuhi keperluan bukan sahaja dapat menjimatkan ruang penyimpanan, tetapi juga meningkatkan kelajuan pemprosesan data.

Penyelesaian kepada perkhidmatan yang tidak dapat dimulakan selepas pemasangan MySQL

Apr 08, 2025 am 11:18 AM

Penyelesaian kepada perkhidmatan yang tidak dapat dimulakan selepas pemasangan MySQL

Apr 08, 2025 am 11:18 AM

MySQL enggan memulakan? Jangan panik, mari kita periksa! Ramai kawan mendapati bahawa perkhidmatan itu tidak dapat dimulakan selepas memasang MySQL, dan mereka sangat cemas! Jangan risau, artikel ini akan membawa anda untuk menangani dengan tenang dan mengetahui dalang di belakangnya! Selepas membacanya, anda bukan sahaja dapat menyelesaikan masalah ini, tetapi juga meningkatkan pemahaman anda tentang perkhidmatan MySQL dan idea anda untuk masalah penyelesaian masalah, dan menjadi pentadbir pangkalan data yang lebih kuat! Perkhidmatan MySQL gagal bermula, dan terdapat banyak sebab, mulai dari kesilapan konfigurasi mudah kepada masalah sistem yang kompleks. Mari kita mulakan dengan aspek yang paling biasa. Pengetahuan asas: Penerangan ringkas mengenai proses permulaan perkhidmatan MySQL Startup. Ringkasnya, sistem operasi memuatkan fail yang berkaitan dengan MySQL dan kemudian memulakan daemon MySQL. Ini melibatkan konfigurasi

Cara mengoptimumkan prestasi pangkalan data selepas pemasangan MySQL

Apr 08, 2025 am 11:36 AM

Cara mengoptimumkan prestasi pangkalan data selepas pemasangan MySQL

Apr 08, 2025 am 11:36 AM

Pengoptimuman prestasi MySQL perlu bermula dari tiga aspek: konfigurasi pemasangan, pengindeksan dan pengoptimuman pertanyaan, pemantauan dan penalaan. 1. Selepas pemasangan, anda perlu menyesuaikan fail my.cnf mengikut konfigurasi pelayan, seperti parameter innodb_buffer_pool_size, dan tutup query_cache_size; 2. Buat indeks yang sesuai untuk mengelakkan indeks yang berlebihan, dan mengoptimumkan pernyataan pertanyaan, seperti menggunakan perintah menjelaskan untuk menganalisis pelan pelaksanaan; 3. Gunakan alat pemantauan MySQL sendiri (ShowProcessList, ShowStatus) untuk memantau kesihatan pangkalan data, dan kerap membuat semula dan mengatur pangkalan data. Hanya dengan terus mengoptimumkan langkah -langkah ini, prestasi pangkalan data MySQL diperbaiki.